Egendefinert OpenAI LLM

Lås opp kraften i egendefinerte språkmodeller med komponenten Egendefinert OpenAI LLM i FlowHunt. Integrer sømløst dine egne OpenAI-kompatible modeller – inklud...

OpenAI Whisper er et åpen kildekode ASR-system som nøyaktig konverterer tale til tekst på 99 språk, og støtter transkripsjon, oversettelse og språkgjenkjenning for robust AI-automatisering.

OpenAI Whisper kan betraktes som både en modell og et system, avhengig av konteksten.

Whispers primærfunksjon er å transkribere tale til tekst. Den utmerker seg i:

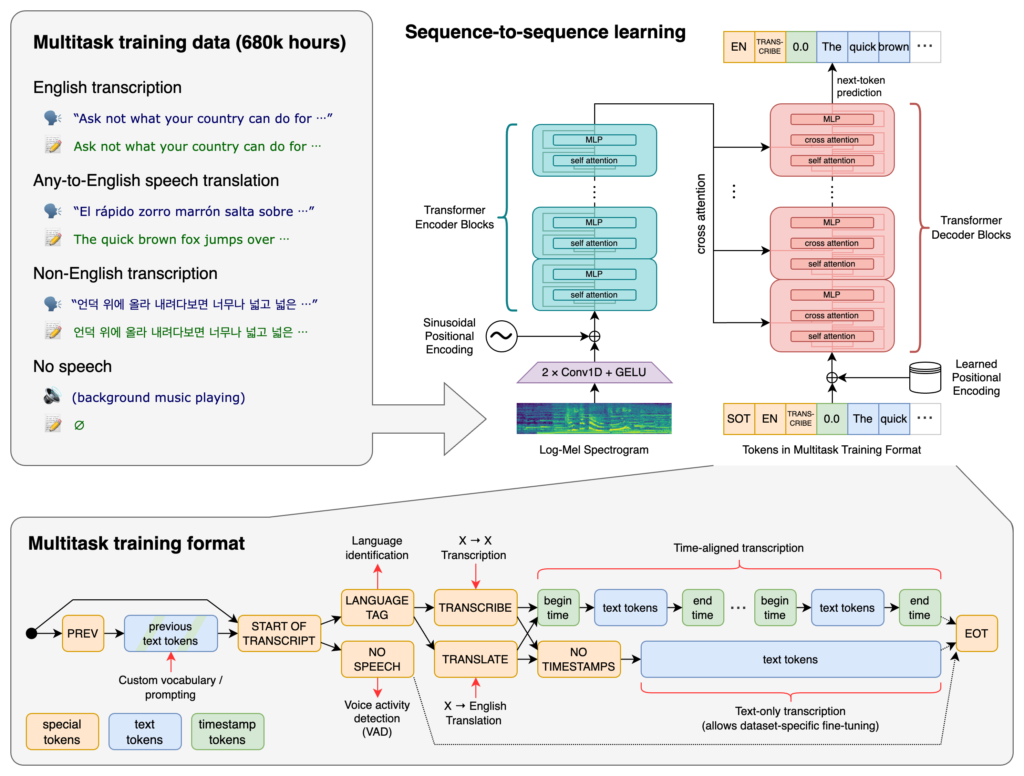

I kjernen av Whisper ligger Transformer-arkitekturen, spesielt en encoder-decoder-modell. Transformere er nevrale nettverk som utmerker seg i å behandle sekvensielle data og forstå kontekst over lange sekvenser. Introdusert i artikkelen “Attention is All You Need” i 2017, har transformere blitt grunnleggende i mange NLP-oppgaver.

Whispers prosess innebærer:

Whisper ble trent på et enormt datasett med 680 000 timer veiledet data samlet fra nettet. Dette inkluderer:

Med dekning av 99 språk utmerker Whisper seg i å håndtere ulike språklige innspill. Denne flerspråklige kapasiteten gjør den egnet for globale applikasjoner og tjenester rettet mot internasjonale brukere.

Trent på omfattende veiledet data, oppnår Whisper høy nøyaktighet i transkripsjonsoppgaver. Robustheten mot forskjellige aksenter, dialekter og bakgrunnsstøy gjør den pålitelig i ulike virkelige scenarioer.

Utover transkripsjon kan Whisper utføre:

Utgitt som åpen kildekode gir Whisper utviklere mulighet til å:

Ved å integrere Whisper i chatboter og AI-assistenter kan utviklere gjøre det mulig å:

Whisper er implementert som et Python-bibliotek, noe som gir sømløs integrasjon i Python-baserte prosjekter. Å bruke Whisper i Python innebærer å sette opp riktig miljø, installere nødvendige avhengigheter og bruke bibliotekets funksjoner til å transkribere eller oversette lydfiler.

Før du bruker Whisper, må du forberede utviklingsmiljøet ved å installere Python, PyTorch, FFmpeg og selve Whisper-biblioteket.

Hvis du ikke har Python installert, last det ned fra offisiell nettside. For å installere PyTorch, bruk pip:

pip install torch

Alternativt, besøk PyTorch-nettsiden for spesifikke instruksjoner basert på operativsystem og Python-versjon.

Whisper krever FFmpeg for å behandle lydfiler. Installer FFmpeg med riktig pakkebehandler for ditt operativsystem.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (med Homebrew):

brew install ffmpeg

Windows (med Chocolatey):

choco install ffmpeg

Installer Whisper Python-pakken med pip:

pip install -U openai-whisper

For å installere siste versjon direkte fra GitHub-repositoriet:

pip install git+https://github.com/openai/whisper.git

Sørg for at utviklermodus er aktivert:

Whisper tilbyr flere modeller som varierer i størrelse og kapasitet. Modellene går fra tiny til large, hver med ulik balanse mellom hastighet og nøyaktighet.

| Størrelse | Parametere | Kun engelsk-modell | Flerspråklig modell | Krevd VRAM | Relativ hastighet |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Optimalisert for engelsk transkripsjon og gir bedre ytelse for engelske lydfiler.Etter å ha satt opp miljøet og installert de nødvendige komponentene, kan du ta i bruk Whisper i Python-prosjektene dine.

Begynn med å importere Whisper-biblioteket og laste inn en modell:

import whisper

# Last inn ønsket modell

model = whisper.load_model("base")

Bytt ut "base" med modellnavnet som passer til din applikasjon.

Whisper tilbyr en enkel transcribe-funksjon for å konvertere lydfiler til tekst.

Eksempel: Transkribere en engelsk lydfil

# Transkriber lydfilen

result = model.transcribe("path/to/english_audio.mp3")

# Skriv ut transkripsjonen

print(result["text"])

model.transcribe(): Behandler lydfilen og gir ut en ordbok med transkripsjon og annen metadata.result["text"]: Henter ut den transkriberte teksten fra resultatet.Whisper kan oversette lyd fra ulike språk til engelsk.

Eksempel: Oversette spansk lyd til engelsk

# Transkriber og oversett spansk lyd til engelsk

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Skriv ut oversatt tekst

print(result["text"])

task="translate": Instruerer modellen til å oversette lyden til engelsk istedenfor å bare transkribere.Selv om Whisper automatisk kan oppdage språket, kan det å spesifisere det forbedre nøyaktigheten og hastigheten.

Eksempel: Transkribere fransk lyd

# Transkriber fransk lyd ved å angi språk

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Skriv ut transkripsjonen

print(result["text"])

Whisper kan identifisere hvilket språk som snakkes i en lydfil med detect_language-metoden.

Eksempel: Språkgjenkjenning

# Last inn og forhåndsbehandle lyd

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Konverter til log-Mel spektrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Oppdag språk

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Laster inn lydfilen.whisper.pad_or_trim(): Tilpasser lydlengden til modellens krav.whisper.log_mel_spectrogram(): Konverterer lyd til formatet modellen forventer.model.detect_language(): Returnerer sannsynligheter for hvert språk og identifiserer det mest sannsynlige språket.For mer kontroll over transkripsjonsprosessen kan du bruke lavnivå-funksjoner og tilpasse dekodingsalternativer.

decode-funksjonendecode-funksjonen lar deg angi alternativer som språk, oppgave og om tidsstempler skal inkluderes.

Eksempel: Egendefinerte dekodingsalternativer

# Sett dekodingsalternativer

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Dekod lyden

result = whisper.decode(model, mel, options)

# Skriv ut gjenkjent tekst

print(result.text)

Du kan integrere Whisper for å transkribere direktelyd fra mikrofonen.

Eksempel: Transkribere direkte mikrofoninput

import whisper

import sounddevice as sd

# Last inn modellen

model = whisper.load_model("base")

# Ta opp lyd fra mikrofonen

duration = 5 # sekunder

fs = 16000 # Samplingsfrekvens

print("Opptak...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper er et avansert, automatisk talegjenkjenningssystem (ASR) utviklet av OpenAI, designet for å transkribere talespråk til skriftlig tekst ved hjelp av dyp læring. Det støtter 99 språk og utmerker seg i transkripsjon, oversettelse og språkgjenkjenning.

Whisper bruker en transformer-basert encoder-decoder-arkitektur, prosesserer lyd til log-Mel spektrogrammer, og gir ut tekst via en språkmodell. Det ble trent på 680 000 timer med flerspråklig, multitask-data for høy nøyaktighet og robusthet.

Whisper støtter flerspråklig talegjenkjenning, taleoversettelse, automatisk språkgjenkjenning, robusthet mot aksenter og støy, og gir åpen kildekode-tilgang for tilpasning og integrasjon.

Maskinvarekravene avhenger av modellstørrelsen: mindre modeller som 'tiny' krever ~1GB VRAM, mens den største krever ~10GB. Whisper kjører raskere på GPU-er, men kan fungere på CPU-er med lengre behandlingstid.

Ja, Whisper er implementert som et Python-bibliotek og kan installeres via pip. Det gjør det enkelt å integrere i Python-prosjekter for taletranskripsjon, oversettelse og sanntids taleapplikasjoner.

Vanlige brukstilfeller inkluderer automatisert møtetranskripsjon, taleaktiverte chatboter, direkte oversettelse, tilgjengelighetsverktøy (teksting og hjelpemidler), kundesentra-automatisering og taleaktiverte automatiseringssystemer.

Ja, alternativer inkluderer åpen kildekode-motorer som Mozilla DeepSpeech, Kaldi, Wav2vec, og kommersielle API-er som Google Cloud Speech-to-Text, Microsoft Azure AI Speech og AWS Transcribe.

Ja, OpenAI Whisper er åpen kildekode, som gjør at utviklere kan tilpasse, finjustere og integrere det i egne produkter og tjenester uten lisensieringsbegrensninger.

Integrer avanserte tale-til-tekst-funksjoner i dine applikasjoner, automatiser arbeidsflyter og forbedre brukeropplevelsen med OpenAI Whisper og FlowHunt.

Lås opp kraften i egendefinerte språkmodeller med komponenten Egendefinert OpenAI LLM i FlowHunt. Integrer sømløst dine egne OpenAI-kompatible modeller – inklud...

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert modeller fra OpenAI. Her er hvordan du bruker ChatGPT i dine AI-verktøy og chatboter.

Finn ut mer om Opus-modellen til Claude av Anthropic. Oppdag dens styrker og svakheter, og hvordan den sammenlignes med andre modeller.