mcp-local-rag MCP Server

mcp-local-rag MCP Server muliggjør personvernsvennlig, lokal Retrieval-Augmented Generation (RAG) nettsøk for LLM-er. Den lar AI-assistenter få tilgang til, ind...

mcp-local-rag MCP Server muliggjør personvernsvennlig, lokal Retrieval-Augmented Generation (RAG) nettsøk for LLM-er. Den lar AI-assistenter få tilgang til, ind...

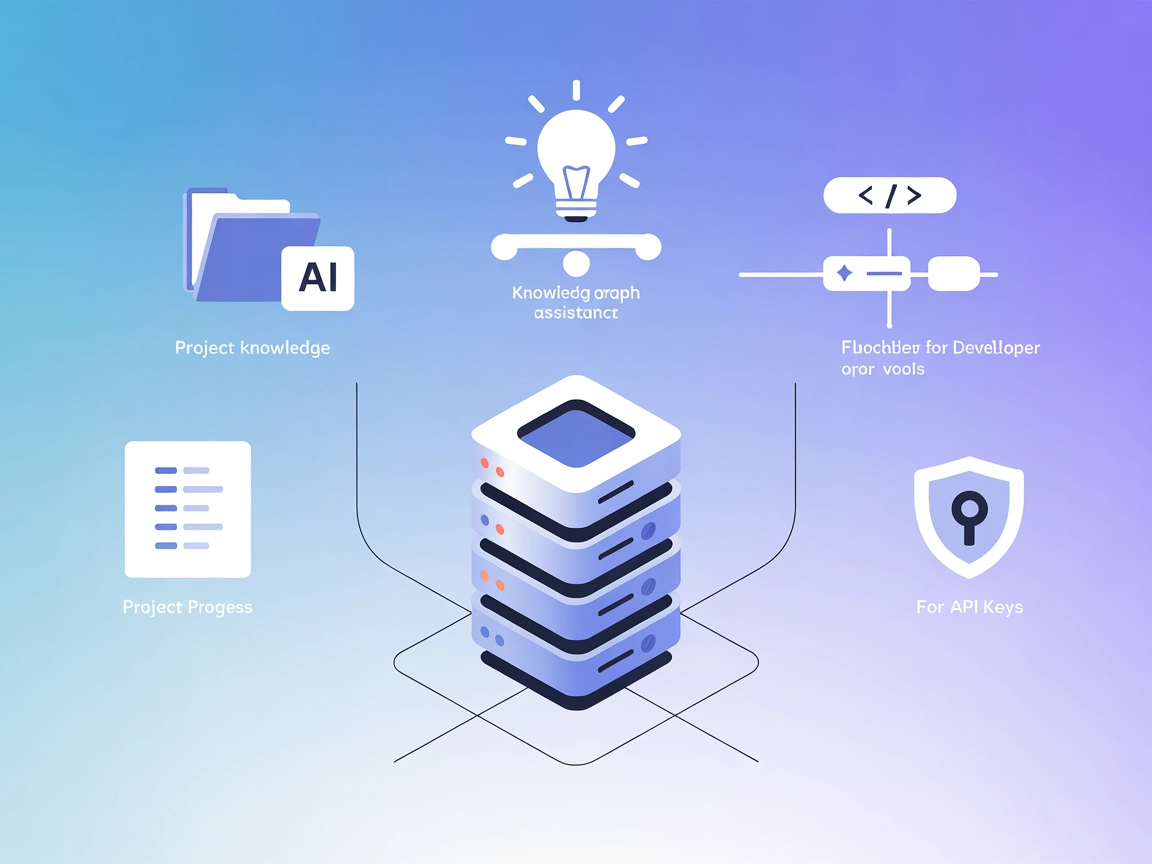

Context Portal (ConPort) er en minnebank MCP-server som styrker AI-assistenter og utviklerverktøy ved å håndtere strukturert prosjektkontekst, muliggjør Retriev...

Integrer FlowHunt med Pinecone vektordatabaser ved hjelp av Pinecone MCP-serveren. Aktiver semantisk søk, Retrieval-Augmented Generation (RAG) og effektiv dokum...

RAG Nettleser MCP Server gir AI-assistenter og LLM-er mulighet til å utføre sanntidssøk på nettet og trekke ut innhold, noe som muliggjør retrieval-augmented ge...

Agentset MCP-server er en åpen kildekodeplattform som muliggjør Retrieval-Augmented Generation (RAG) med agentiske egenskaper, slik at KI-assistenter kan koble ...

Inkeep MCP Server kobler AI-assistenter og utviklerverktøy til oppdatert produktdokumentasjon administrert i Inkeep, og muliggjør direkte, sikker og effektiv he...

Den mcp-rag-local MCP-serveren gir AI-assistenter semantisk minne, slik at de kan lagre og hente tekstutdrag basert på mening, ikke bare nøkkelord. Den bruker O...

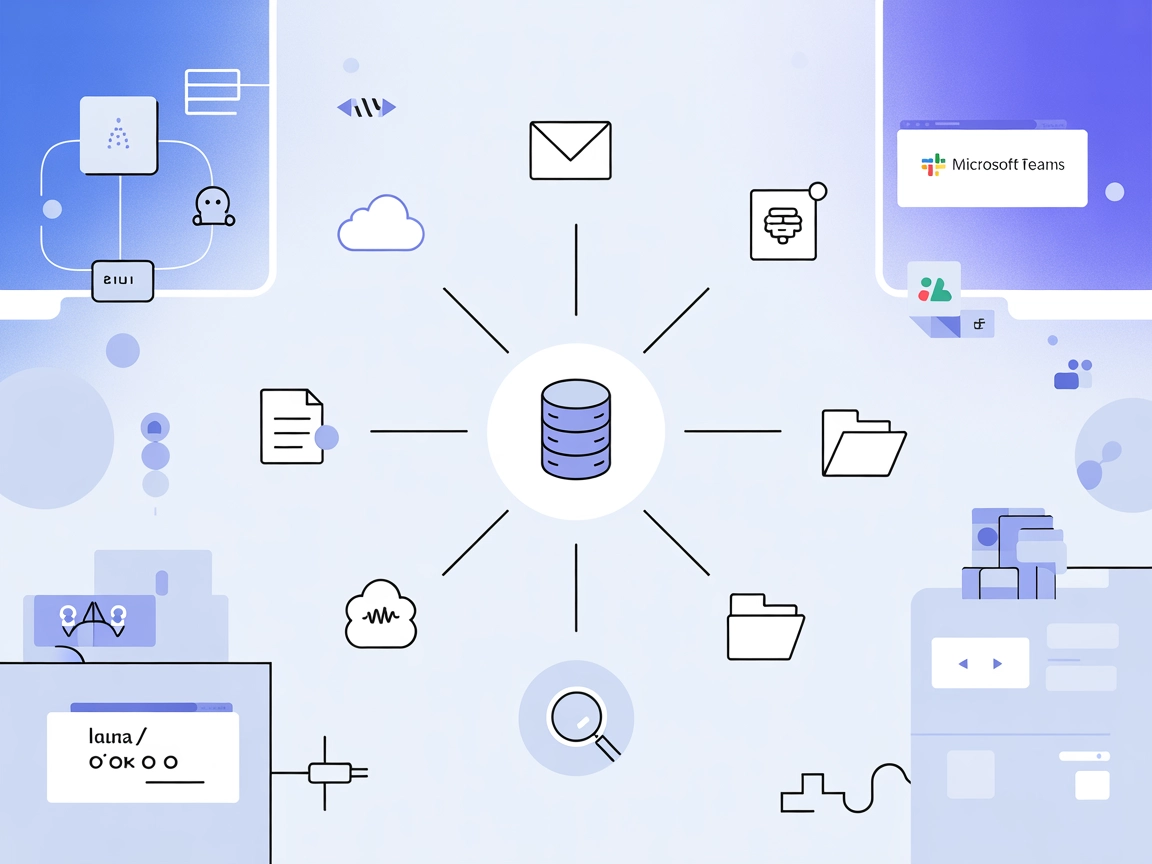

Graphlit MCP Server kobler FlowHunt og andre MCP-klienter til en samlet kunnskapsplattform, og muliggjør sømløs innhenting, aggregering og gjenfinning av dokume...

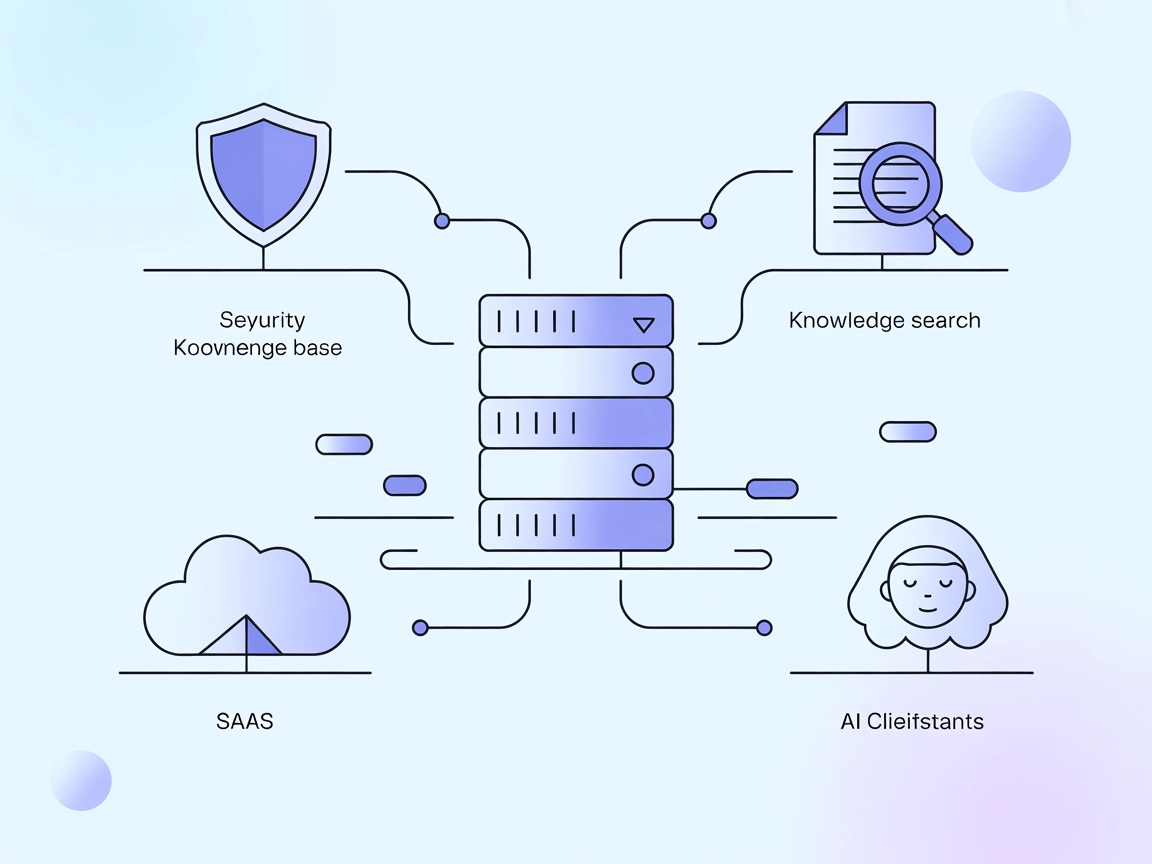

Vectara MCP Server er en åpen kildekode-bro mellom AI-assistenter og Vectaras Trusted RAG-plattform, som muliggjør sikker, effektiv Retrieval-Augmented Generati...

Cache Augmented Generation (CAG) er en ny tilnærming for å forbedre store språkmodeller (LLM) ved å forhåndslaste kunnskap som forhåndsberegnede nøkkel-verdi-ca...

Dokument-omrangering er prosessen med å omorganisere hentede dokumenter basert på hvor relevante de er for en brukers søk, slik at søkeresultater forbedres ved ...

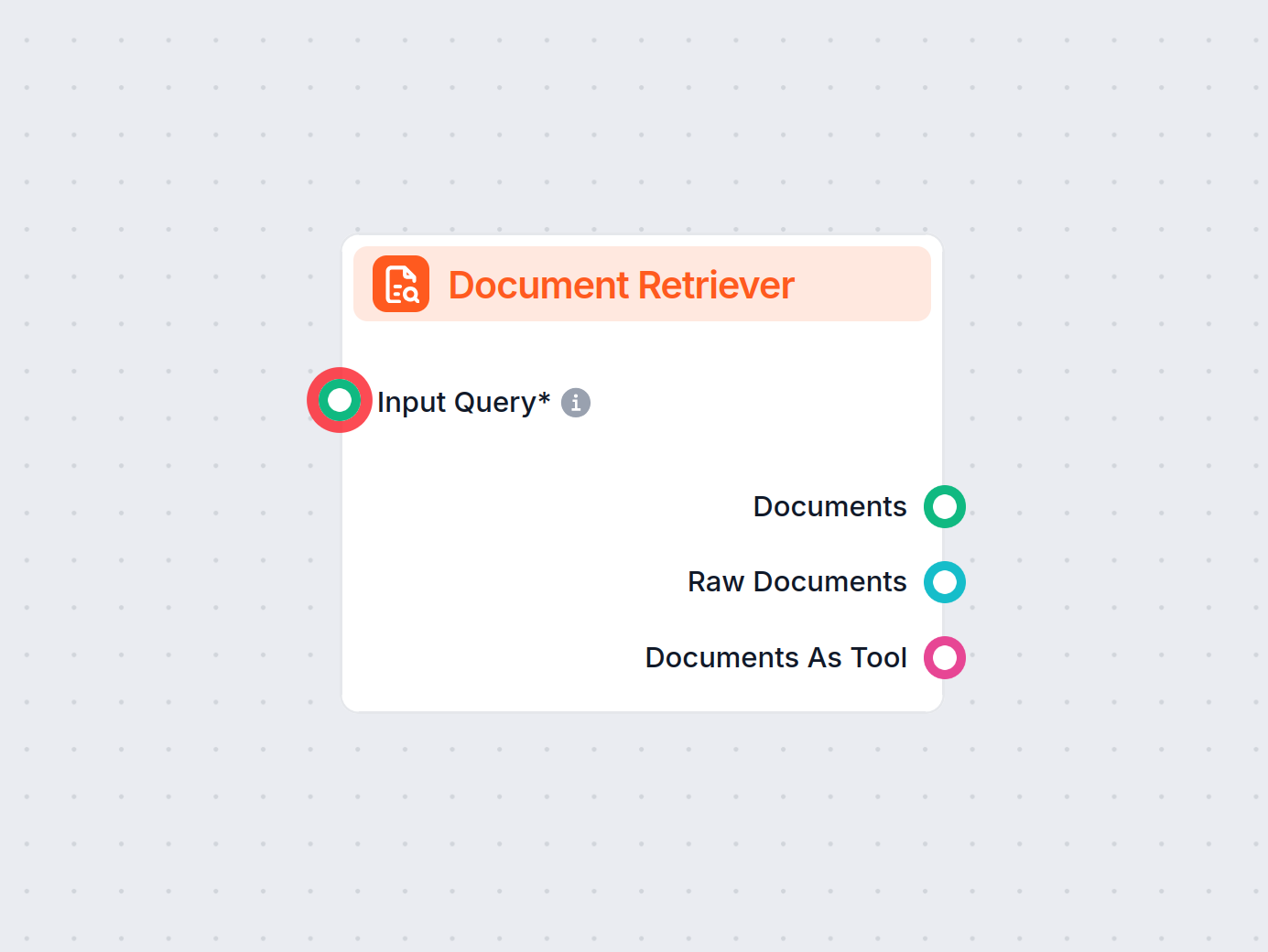

FlowHunts Dokumentinnhenter forbedrer AI-nøyaktigheten ved å koble generative modeller til dine egne oppdaterte dokumenter og nettadresser, og sikrer pålitelige...

Dokumentvurdering i Retrieval-Augmented Generation (RAG) er prosessen med å evaluere og rangere dokumenter basert på deres relevans og kvalitet som svar på en f...

Øk AI-nøyaktigheten med RIG! Lær hvordan du lager chatboter som faktasjekker svar ved å bruke både egne og generelle datakilder, for pålitelige svar med kilder....

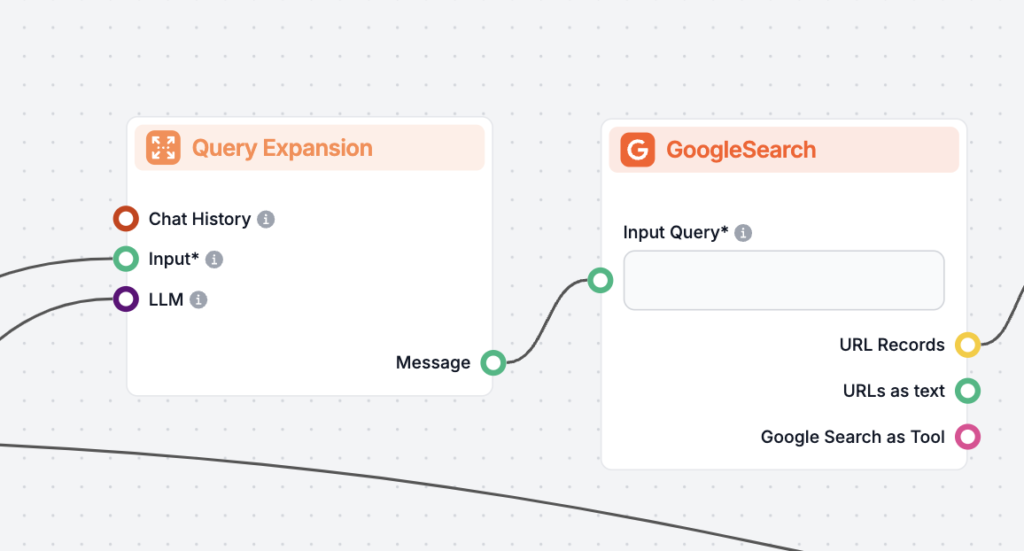

Forespørselsekspansjon er prosessen med å forbedre en brukers opprinnelige forespørsel ved å legge til termer eller kontekst, noe som forbedrer dokumentgjenfinn...

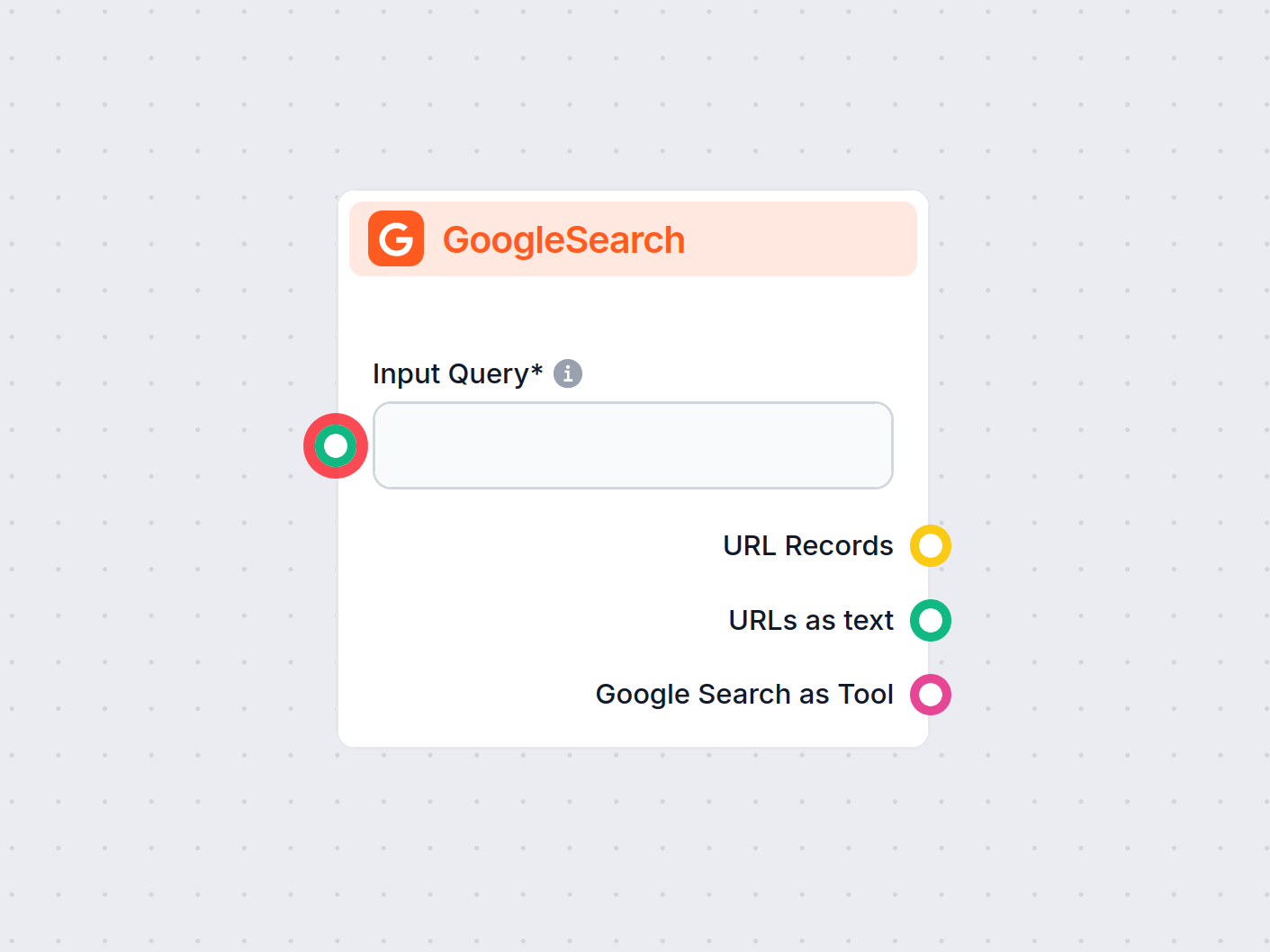

FlowHunts GoogleSearch-komponent forbedrer chatbotens nøyaktighet ved å bruke Retrieval-Augmented Generation (RAG) for å få tilgang til oppdatert kunnskap fra G...

Oppdag de viktigste forskjellene mellom Retrieval-Augmented Generation (RAG) og Cache-Augmented Generation (CAG) innen AI. Lær hvordan RAG henter sanntidsinform...

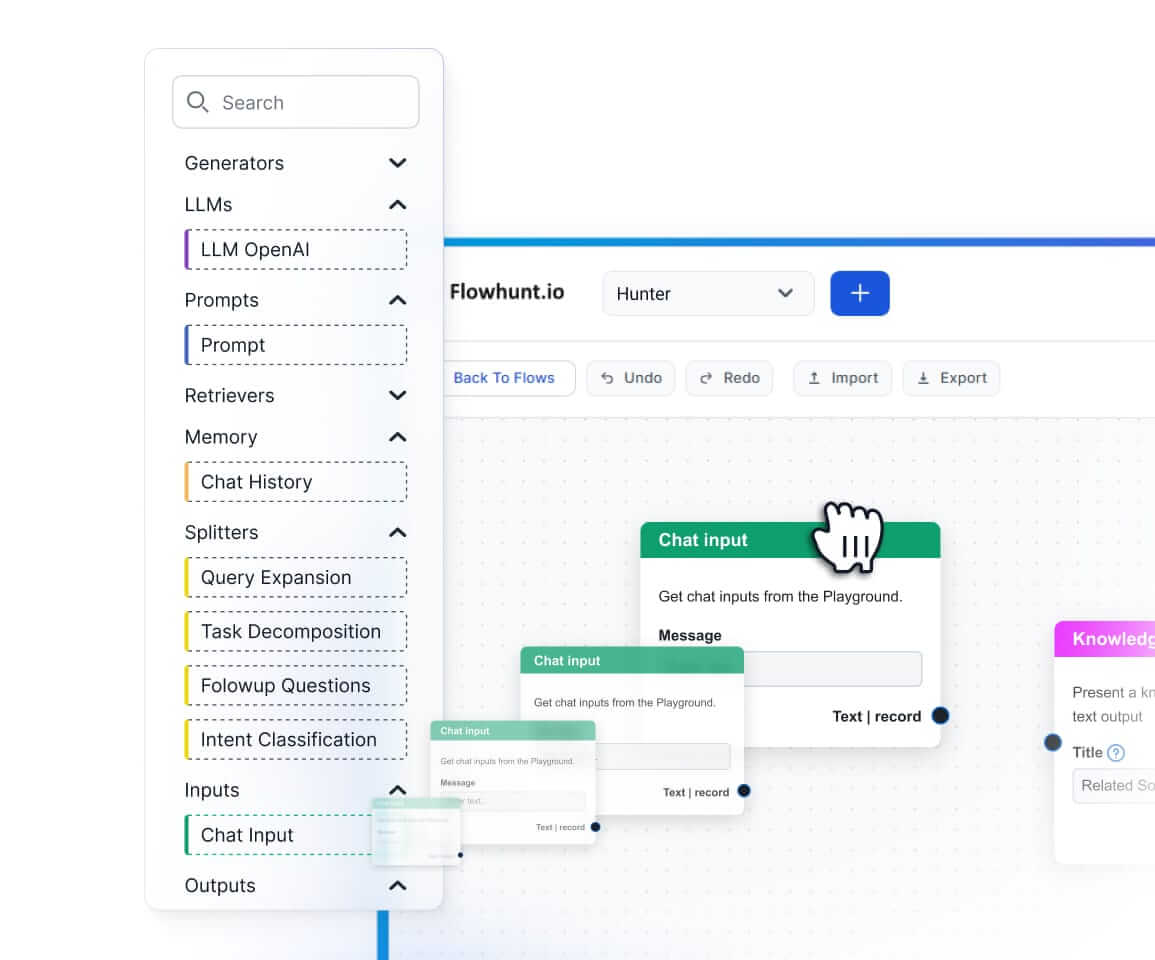

Oppdag hva en hentingsrørledning er for chatboter, dens komponenter, bruksområder, og hvordan Retrieval-Augmented Generation (RAG) og eksterne datakilder muligg...

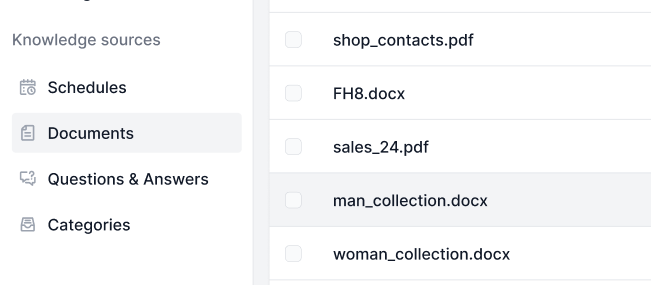

Kunnskapskilder gjør det enkelt å lære opp AI-en etter dine behov. Oppdag alle måtene du kan koble kunnskap til FlowHunt på. Koble enkelt til nettsider, dokumen...

LazyGraphRAG er en innovativ tilnærming til Retrieval-Augmented Generation (RAG), som optimaliserer effektivitet og reduserer kostnader i AI-drevet datauthentin...

Utforsk hvordan OpenAI O1s avanserte resonneringsevner og forsterkningslæring overgår GPT4o i RAG-nøyaktighet, med benchmark-tester og kostnadsanalyse.

Retrieval Augmented Generation (RAG) er et avansert AI-rammeverk som kombinerer tradisjonelle informasjonshentingssystemer med generative store språkmodeller (L...

Spørsmål og svar med Retrieval-Augmented Generation (RAG) kombinerer informasjonsinnhenting og naturlig språk-generering for å forbedre store språkmodeller (LLM...