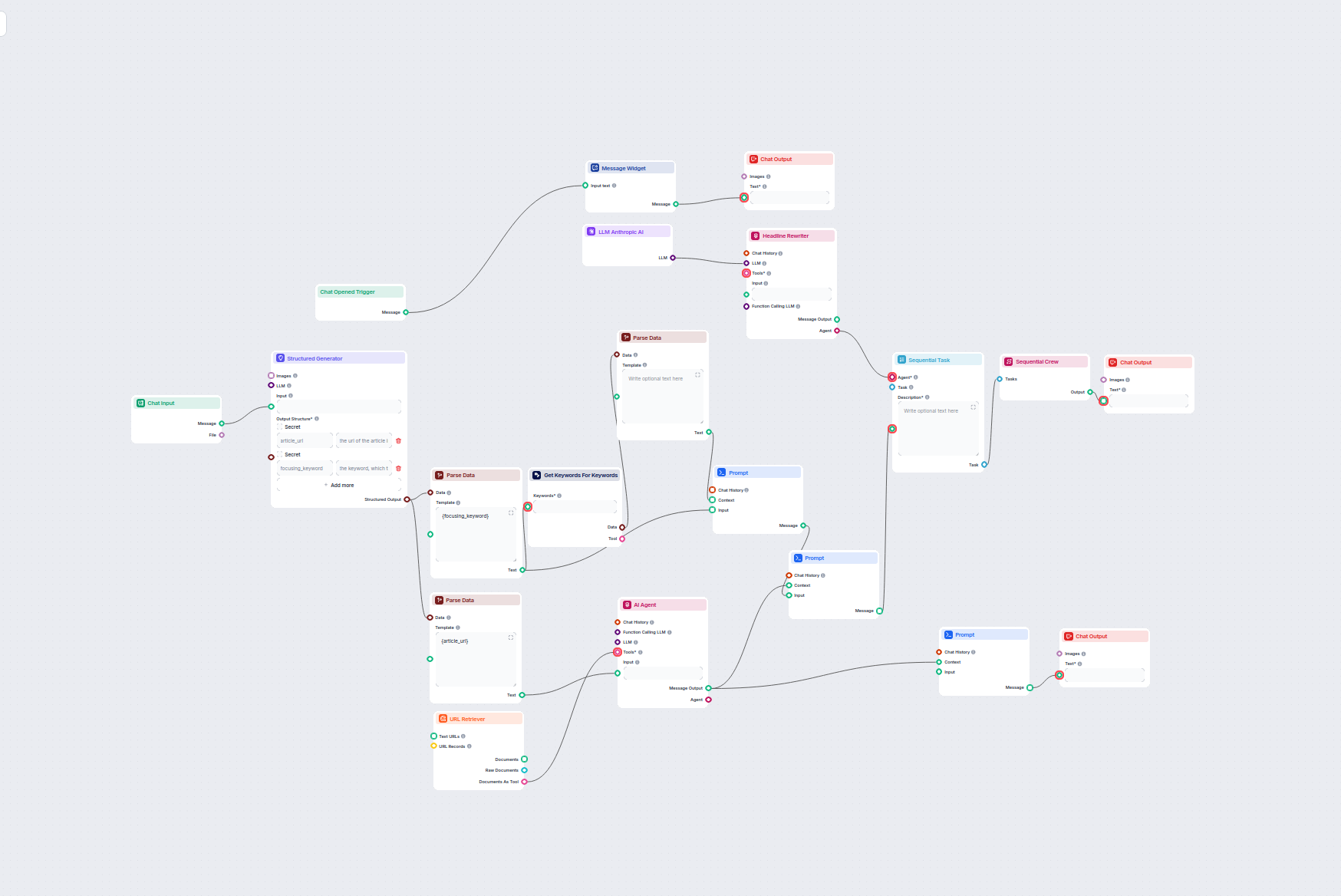

AI Blog Headline & Keyword Optimizer

Ten workflow oparty na AI znajduje najlepsze słowa kluczowe SEO dla Twojego artykułu na blogu i automatycznie przepisuje nagłówki, aby kierować je na te słowa k...

Połącz modele Claude firmy Anthropic z panelem FlowHunt, aby uzyskać elastyczne generowanie tekstu AI i rozwiązania chatbotowe z kontrolą nad tokenami, temperaturą i wyborem modelu.

Opis komponentu

Different tasks call for different models, and FlowHunt is committed to giving you the best of AI without the need to sign up for countless subscriptions. Instead, you get dozens of text and image generator models in a single dashboard. The LLM type of components houses text generation and their diverse applications in AI, content creation, and automation.") models grouped by provider, allowing you to swap AI models on the fly.

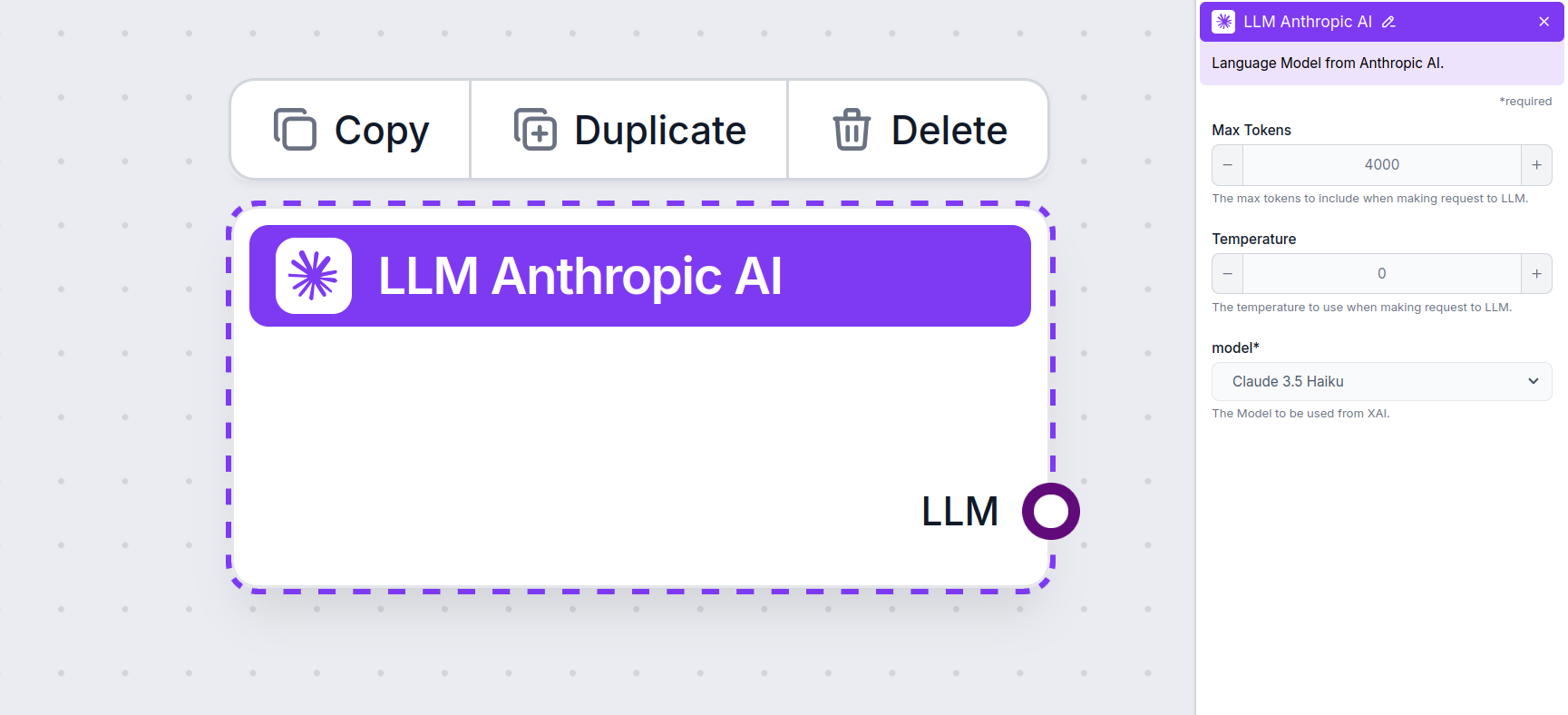

The LLM Anthropic AI component connects the Claude family of models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Anthropic. We currently support all the latest models from the Claude family:

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

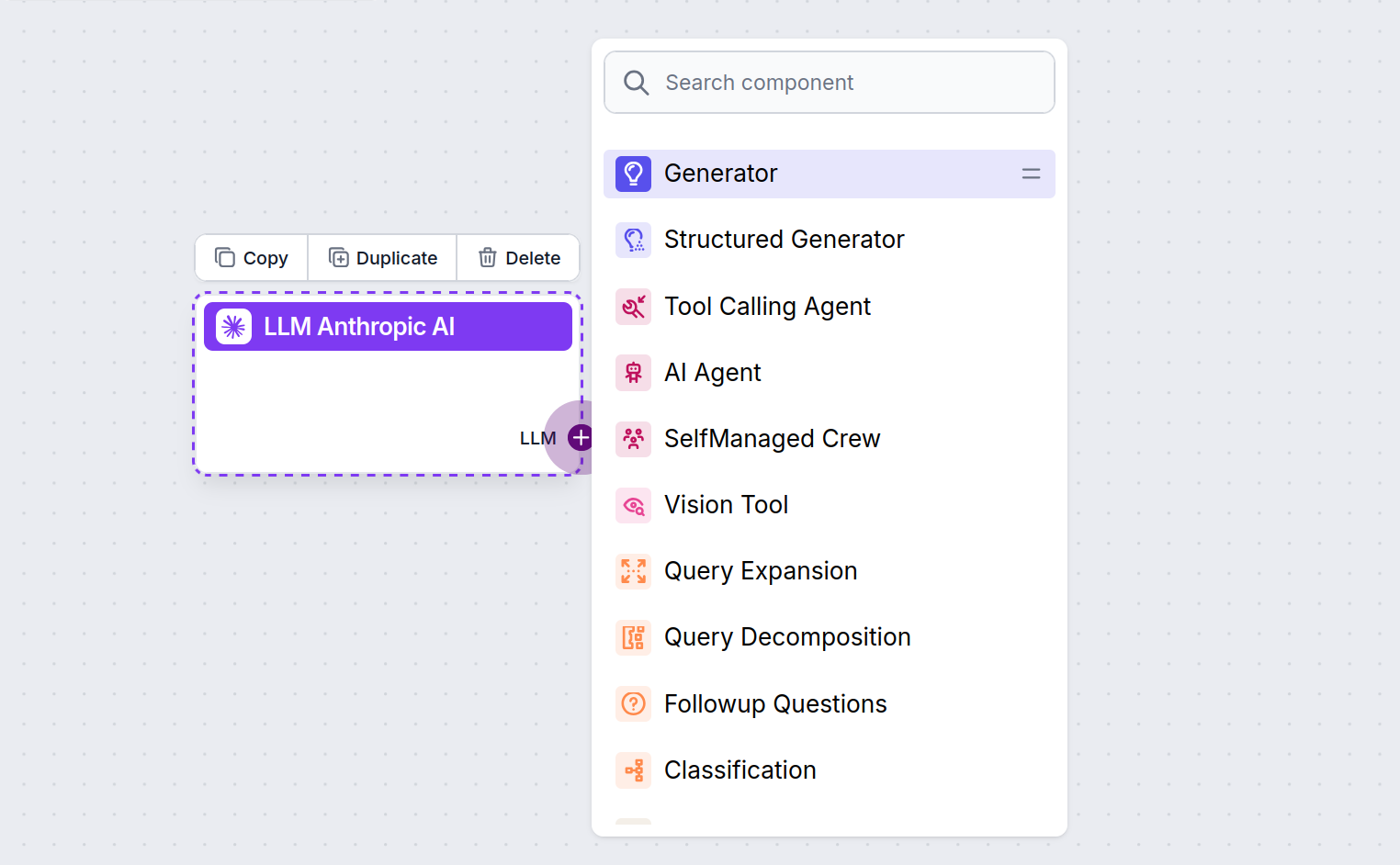

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

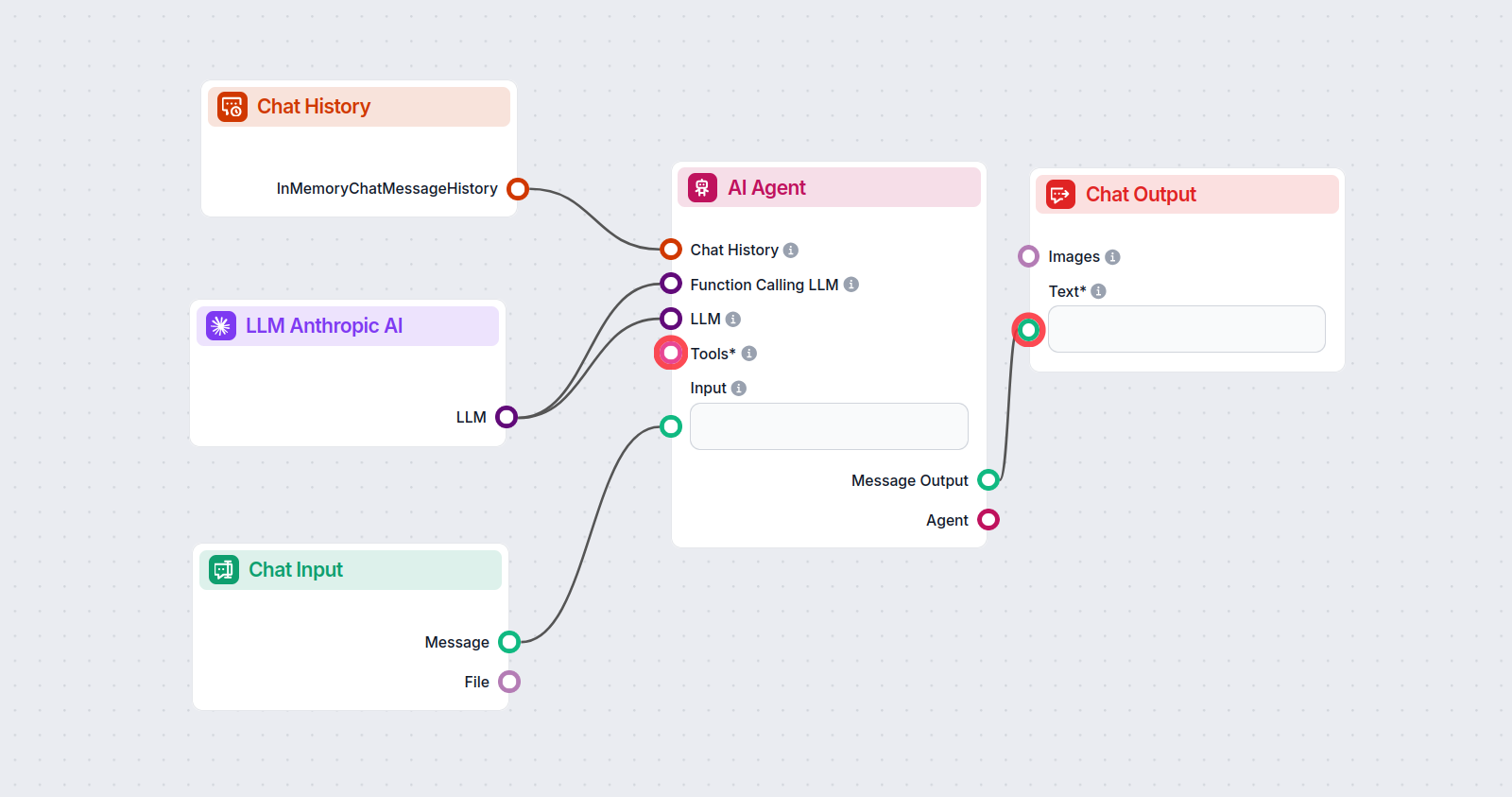

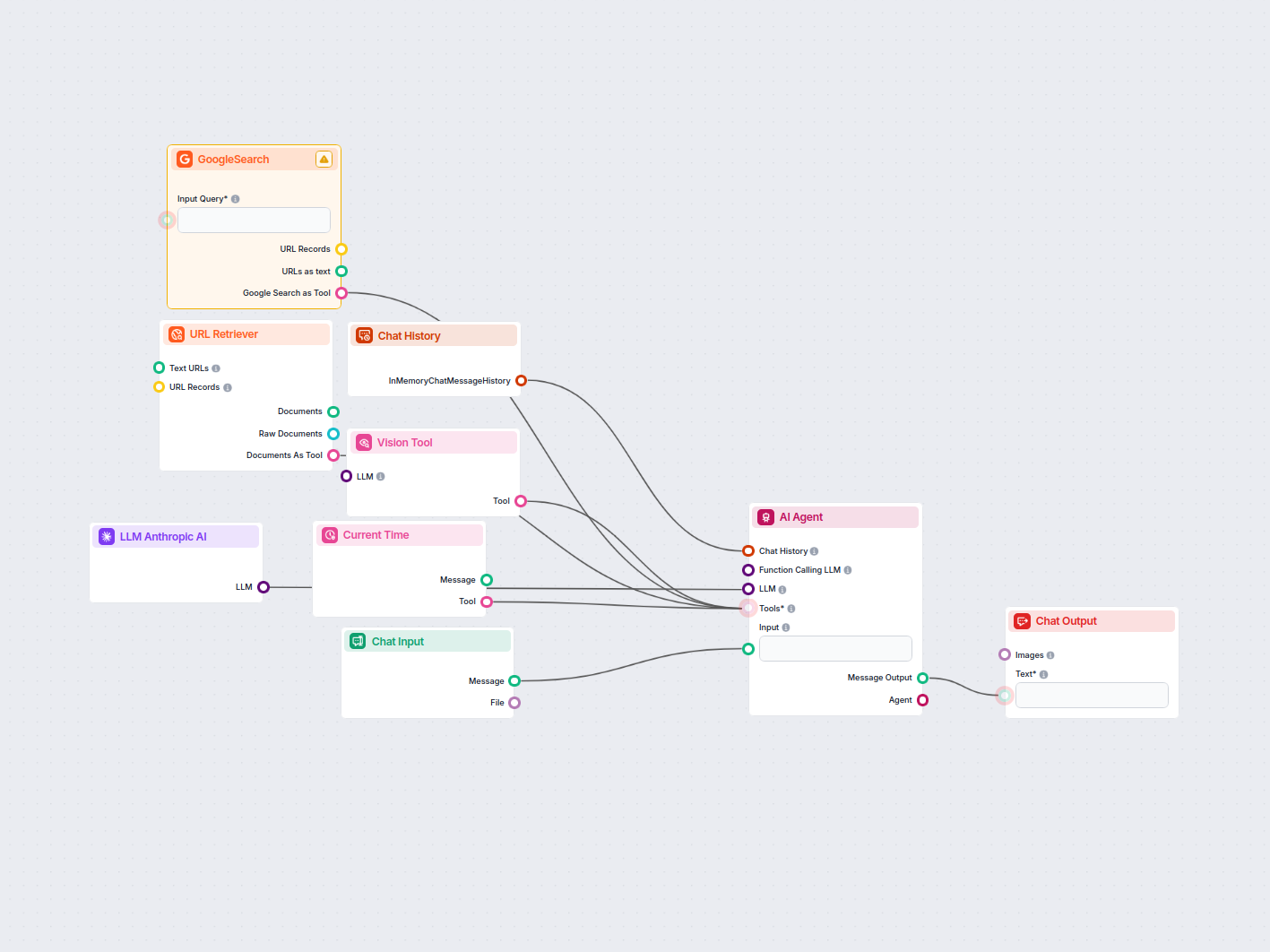

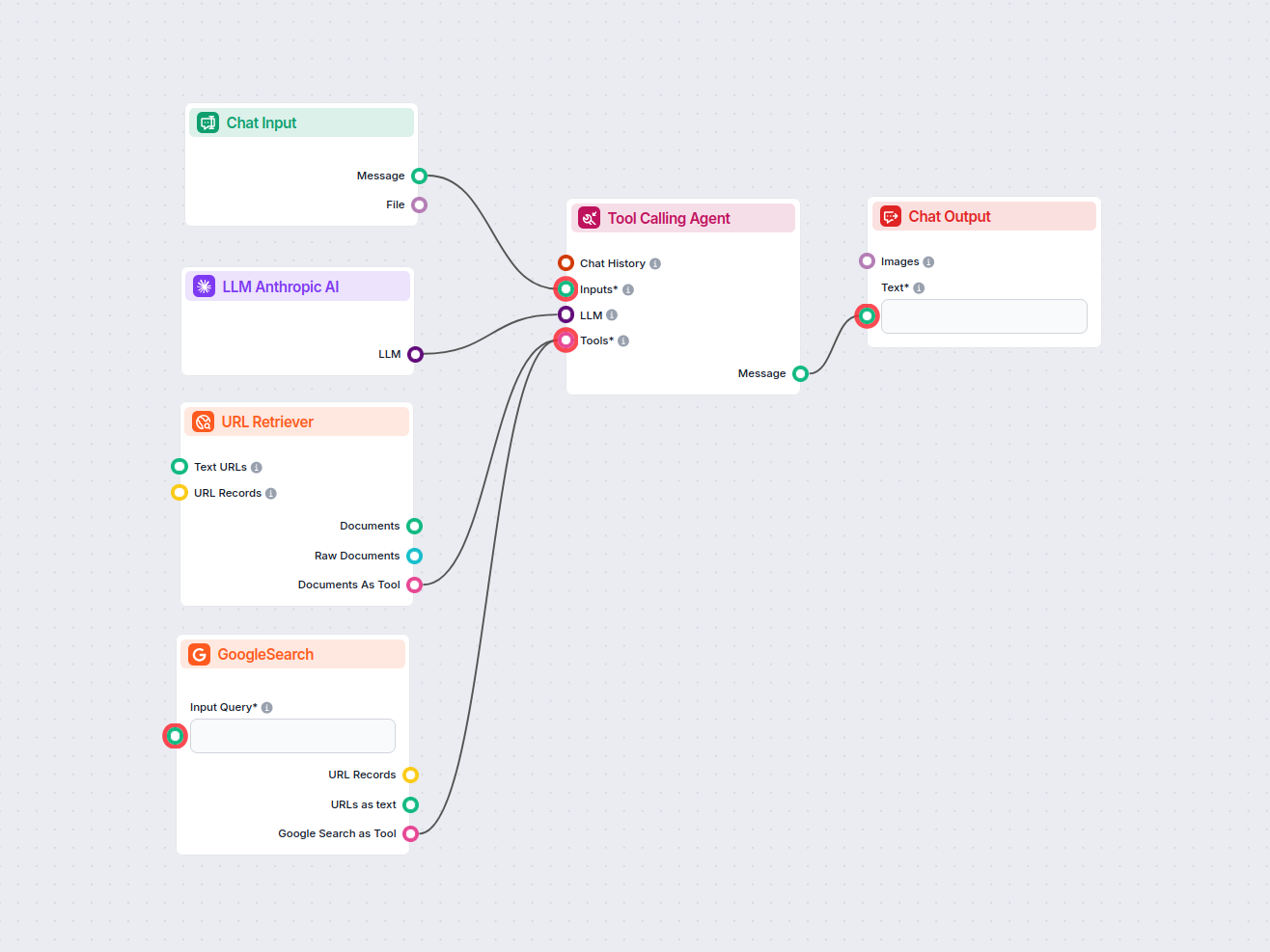

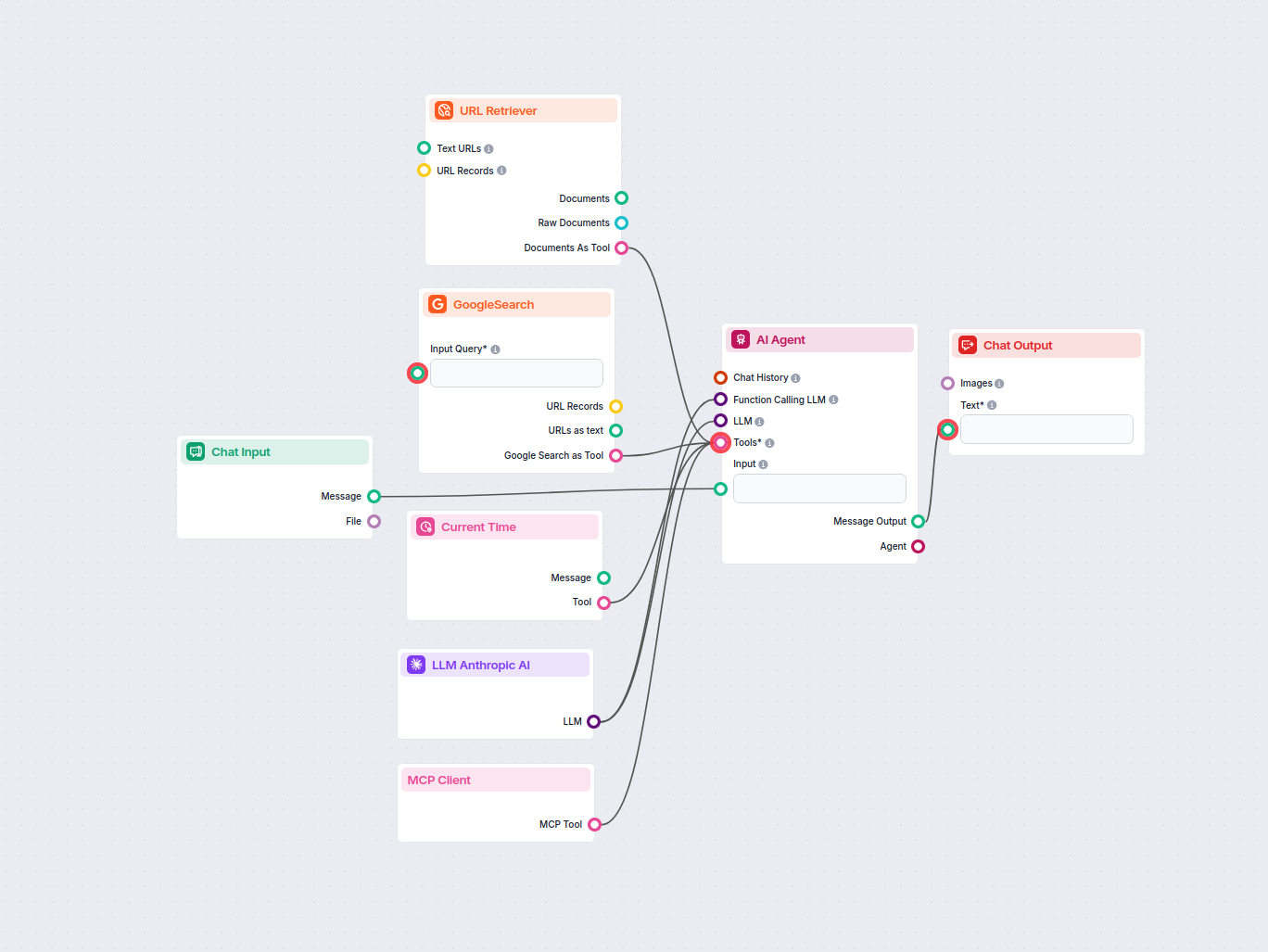

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Anthropic’s Claude 3.5 Sonnet to generate responses. You can think of it as a basic Anthropic chatbot.

This simple Chatbot Flow includes:

Aby pomóc Ci szybko zacząć, przygotowaliśmy kilka przykładowych szablonów przepływu, które pokazują, jak efektywnie używać komponentu LLM Anthropic AI. Te szablony prezentują różne przypadki użycia i najlepsze praktyki, ułatwiając zrozumienie i implementację komponentu w Twoich własnych projektach.

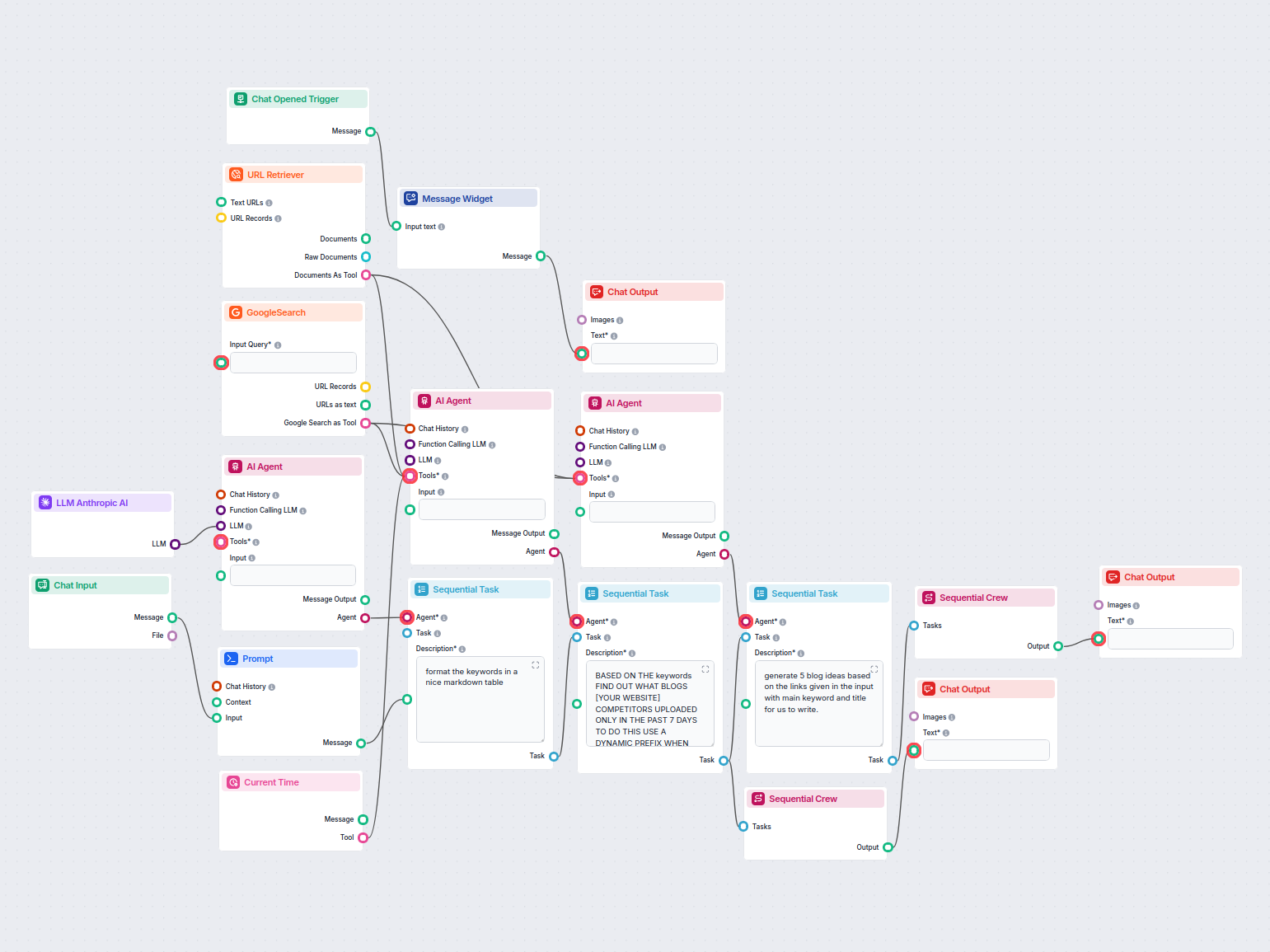

Ten workflow oparty na AI znajduje najlepsze słowa kluczowe SEO dla Twojego artykułu na blogu i automatycznie przepisuje nagłówki, aby kierować je na te słowa k...

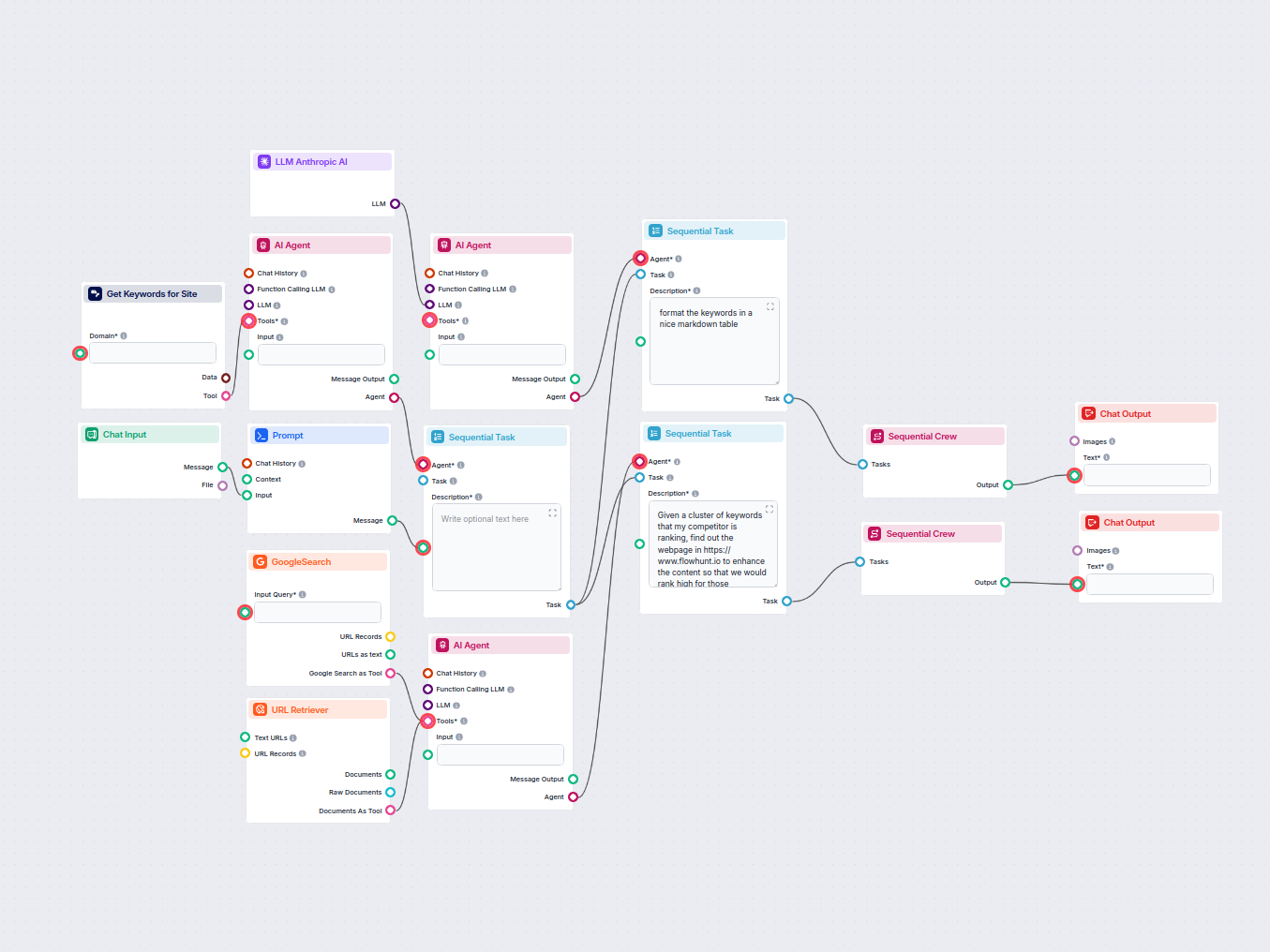

Automatycznie analizuj stronę główną konkurenta, aby odkryć jego najwyżej pozycjonowane słowa kluczowe, zbierz dane o słowach kluczowych z Google i otrzymaj pra...

Automatycznie analizuj najlepiej pozycjonowane blogi konkurencji z ostatniego tygodnia i generuj nowe pomysły na bloga dla swojej strony internetowej. Ten przep...

Ten przepływ pracy automatyzuje badanie rynku reklam LinkedIn poprzez identyfikację czołowych konkurentów dla wybranego słowa kluczowego, analizę ich treści rek...

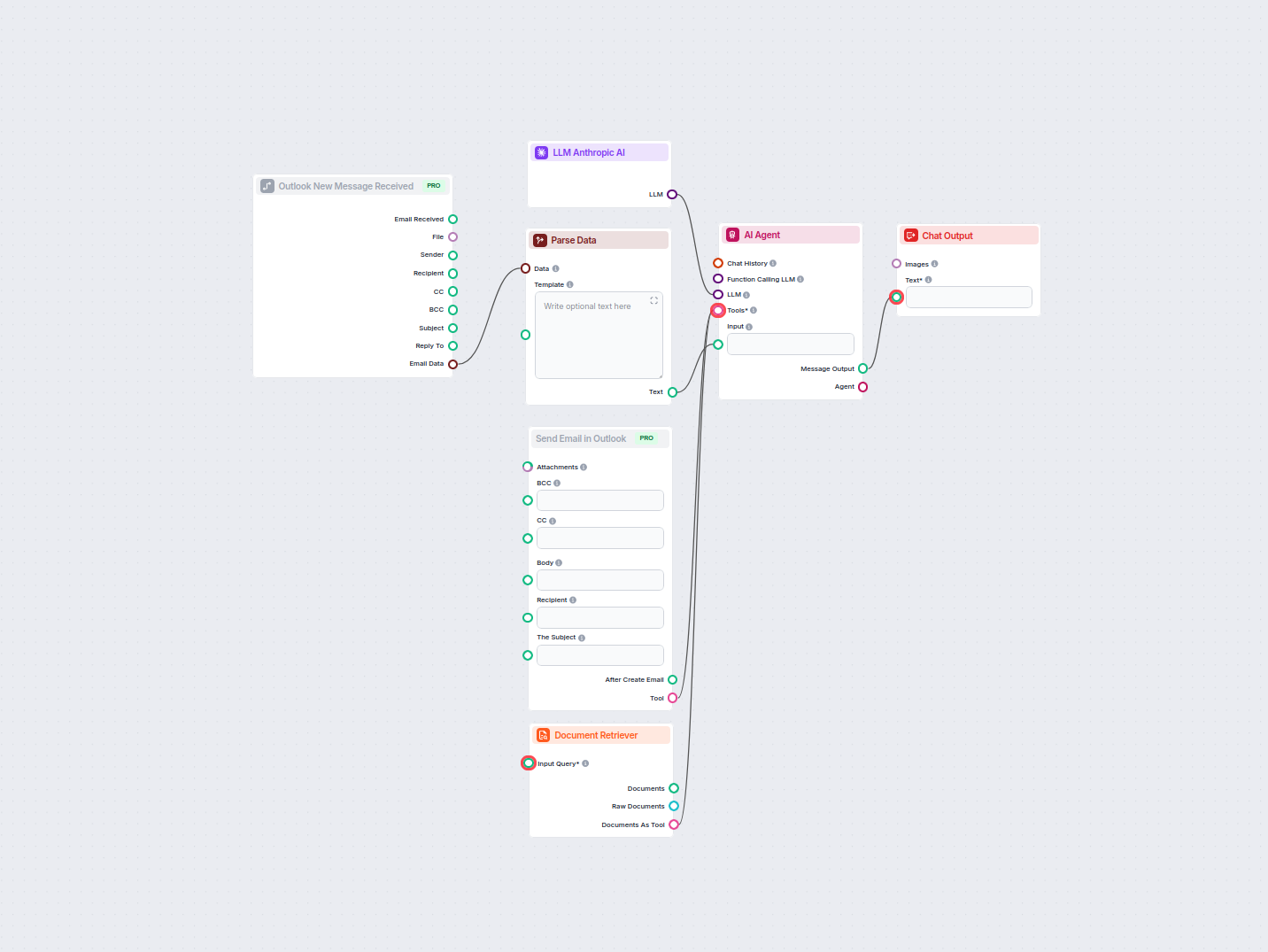

Automatyzuj profesjonalne odpowiedzi na e-maile w Outlooku przy użyciu agenta AI, który wykorzystuje źródła wiedzy organizacyjnej. Przychodzące e-maile są odbie...

Automatycznie generuj opisy kategorii stron e-commerce zoptymalizowane pod SEO za pomocą AI. Wystarczy podać adres URL kategorii, a workflow zbada kategorię, pr...

Ten oparty na AI workflow bada konkurencję i tematy na czasie, aby wygenerować pomysły na blogi o wysokim wpływie i zoptymalizowane pod SEO dla FlowHunt.io. Wyk...

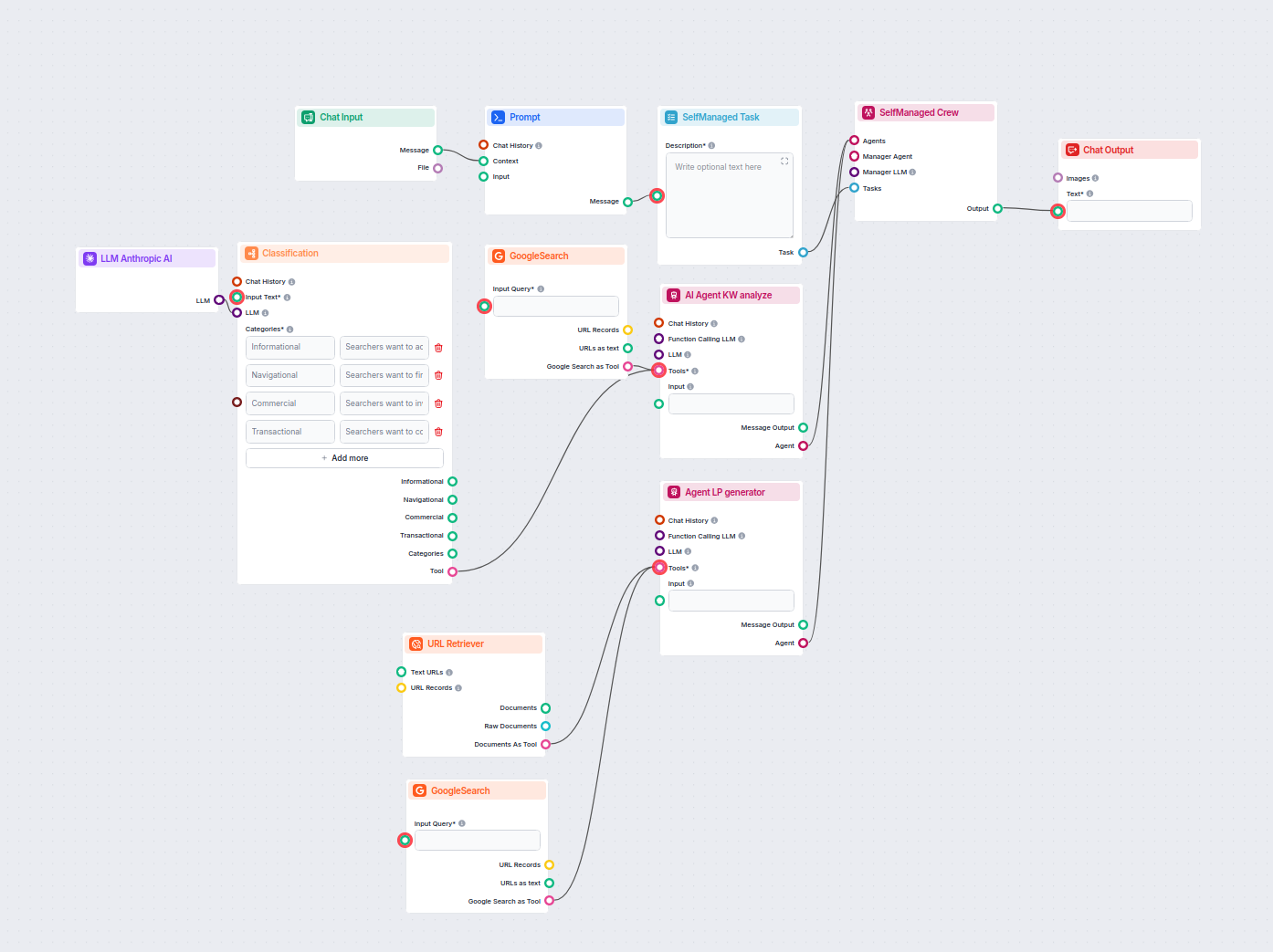

Ten przepływ pracy oparty na AI klasyfikuje zapytania wyszukiwania według intencji, bada najlepiej pozycjonowane adresy URL i generuje wysoko zoptymalizowaną st...

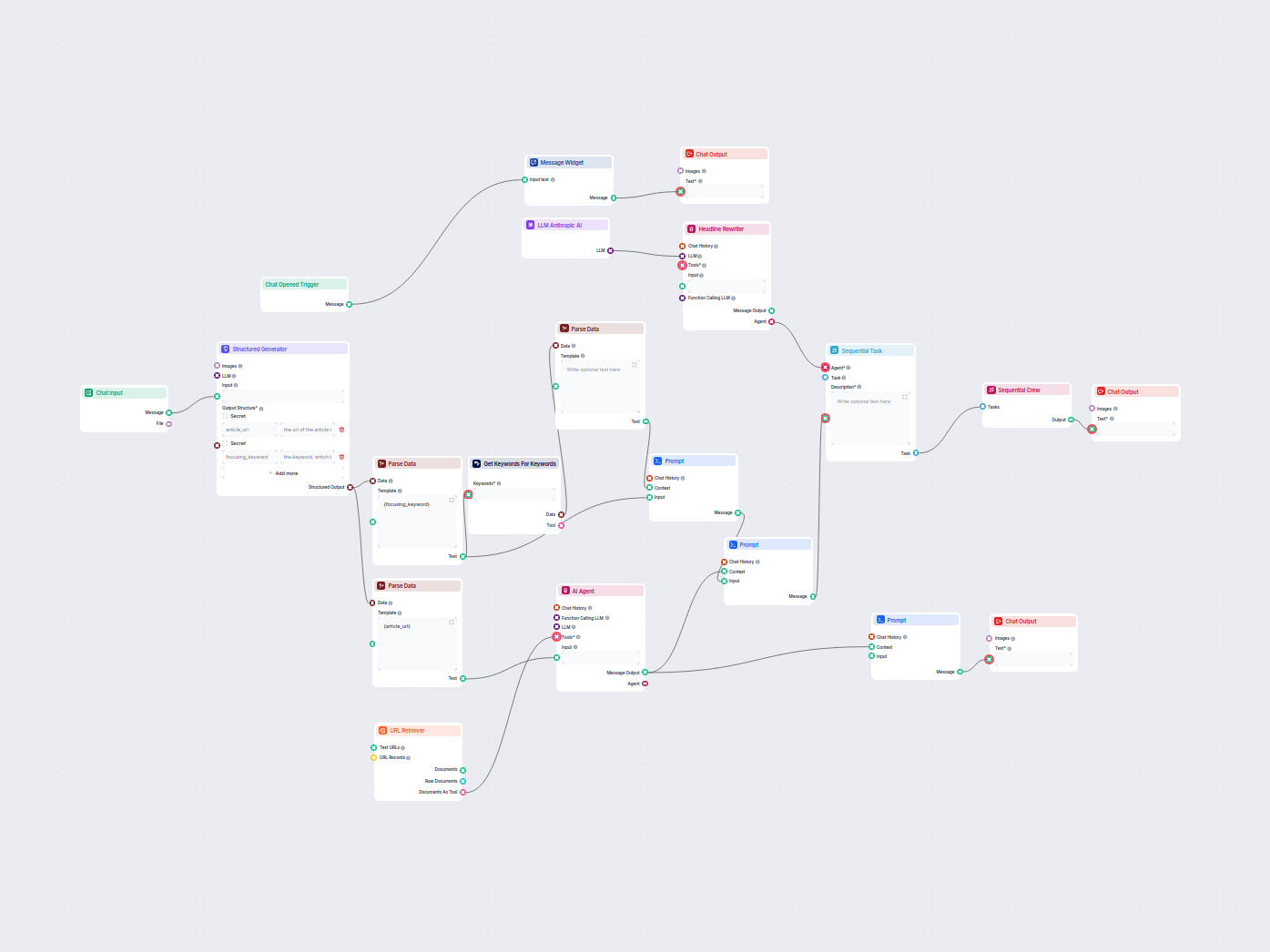

Automatycznie optymalizuj nagłówki i tytuł artykułu pod wybrane słowo kluczowe lub klaster słów kluczowych, aby poprawić wyniki SEO. Ten workflow analizuje Twój...

Ten oparty na AI przepływ pracy ulepsza opisy produktów Shopify na podstawie nazwy produktu lub adresu URL podanego przez użytkownika. Wykorzystuje modele język...

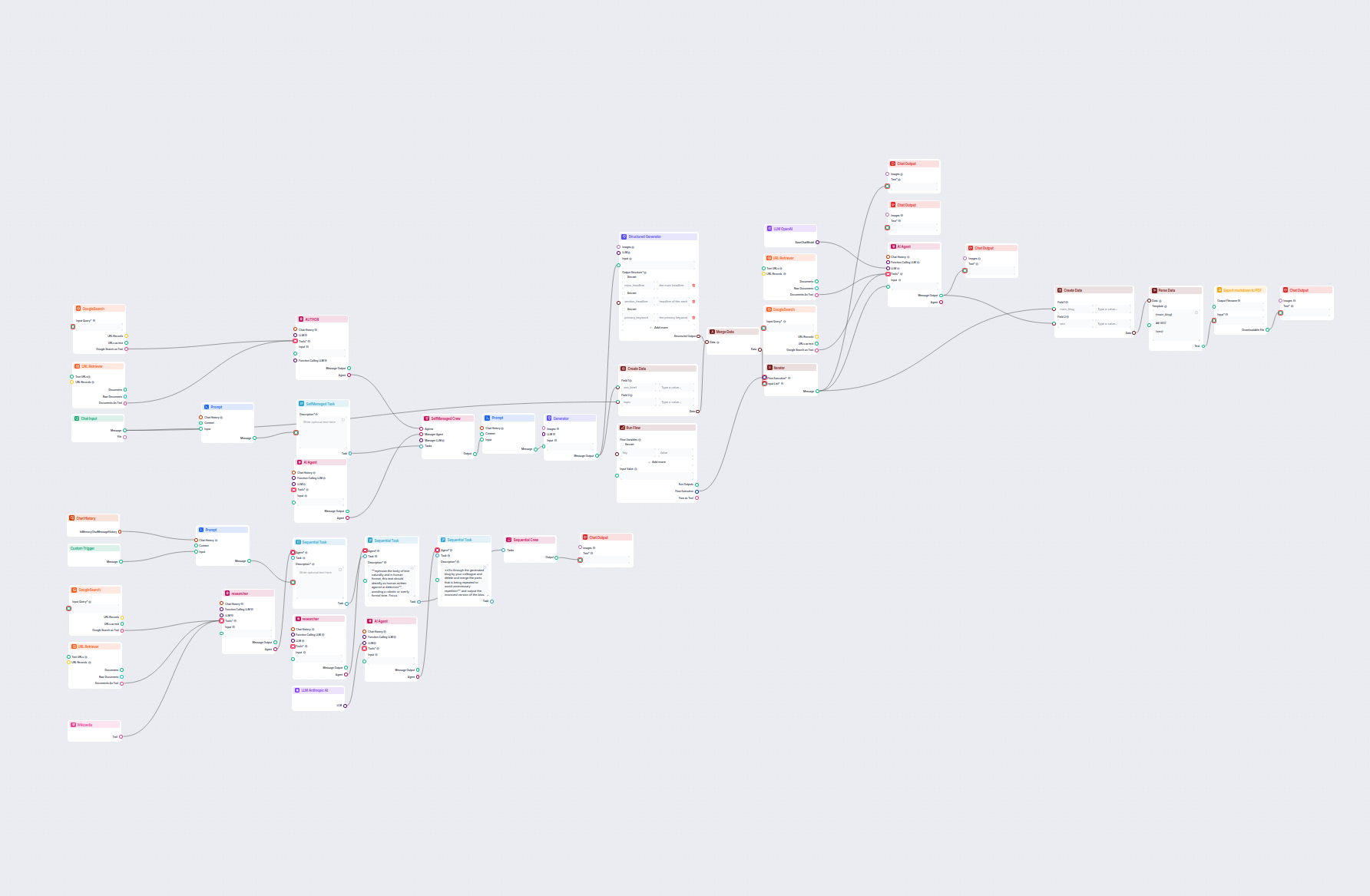

Generuj kompleksowe, zoptymalizowane pod SEO wpisy na bloga o zaawansowanej strukturze i wysokiej liczbie słów, korzystając z wielu agentów AI. Workflow obejmuj...

Komponent LLM Anthropic AI łączy modele Claude firmy Anthropic z Twoimi przepływami w FlowHunt, pozwalając decydować, który model będzie używany do generowania tekstu oraz kontrolować takie ustawienia jak maksymalna liczba tokenów i temperatura.

FlowHunt obsługuje wszystkie najnowsze modele z rodziny Claude, w tym Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku oraz Claude 2.

Maksymalna liczba tokenów ustala ograniczenie długości każdej odpowiedzi, natomiast temperatura kontroluje losowość — niższe wartości sprawiają, że odpowiedzi są bardziej konkretne, wyższe zwiększają kreatywność.

Nie, podłączenie komponentu LLM Anthropic AI jest opcjonalne. Domyślnie komponenty używają ChatGPT-4o, ale możesz dodać ten komponent, aby przełączyć się na modele Claude i dostosować ustawienia.

Zacznij budować własne narzędzia AI i chatboty, korzystając z modeli Claude firmy Anthropic dzięki łatwej integracji w przepływach i zaawansowanej konfiguracji.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele OpenAI. Oto jak używać ChatGPT w swoich narzędziach AI i chatbotach.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele Llama firmy Meta. Dowiedz się, jak zintegrować Llama z własnymi narzędziami AI i chatbotam...

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele xAI. Zobacz, jak korzystać z modeli xAI w swoich narzędziach AI i chatbotach.