Analiza Firmy przez AI do Google Sheets

Ten workflow oparty na AI dostarcza kompleksową, opartą na danych analizę firmy. Zbiera informacje o tle firmy, otoczeniu rynkowym, zespole, produktach, inwesty...

Wykorzystaj moc modeli Gemini od Google w FlowHunt — zamieniaj modele AI, kontroluj ustawienia i buduj inteligentniejsze chatboty AI z łatwością.

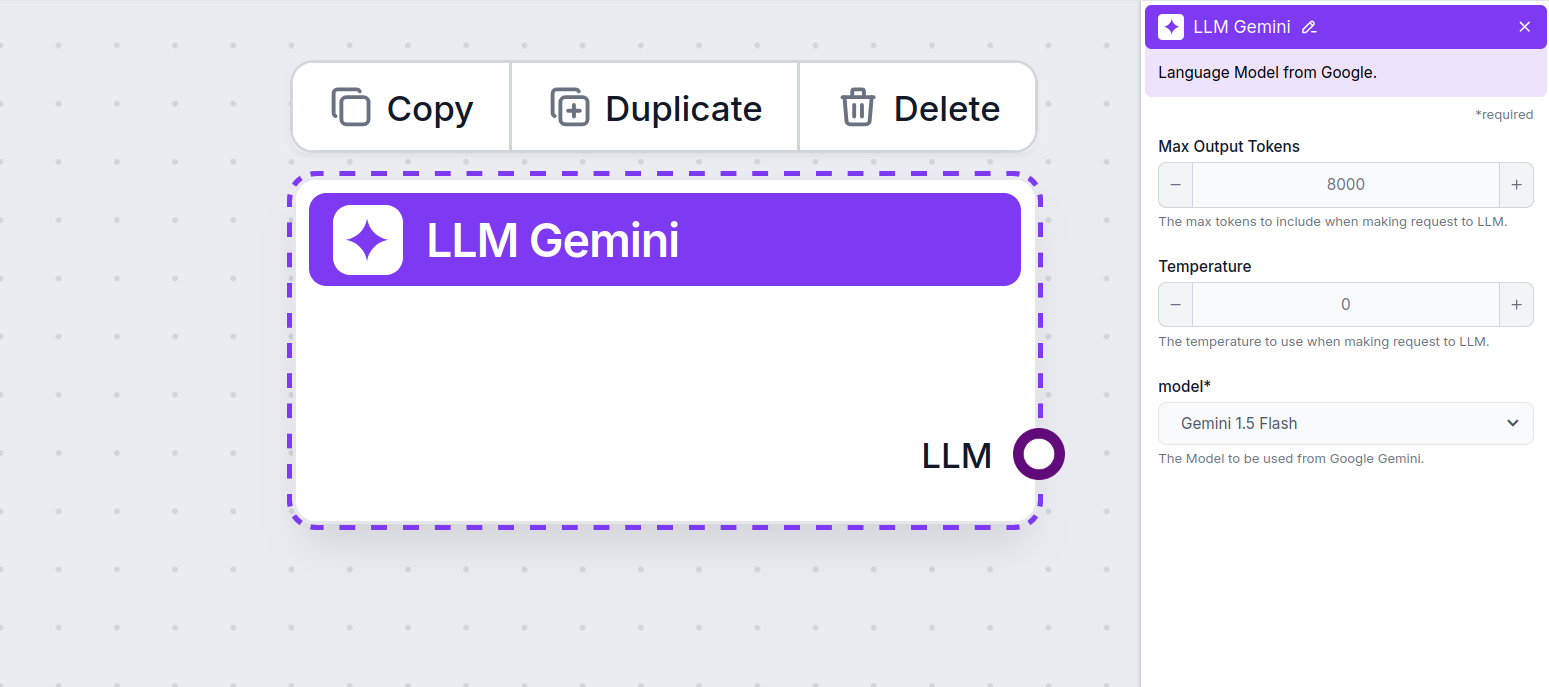

Opis komponentu

The LLM Gemini component connects the Gemini models from Google to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported Gemini models from Google. We support all the latest Gemini models:

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

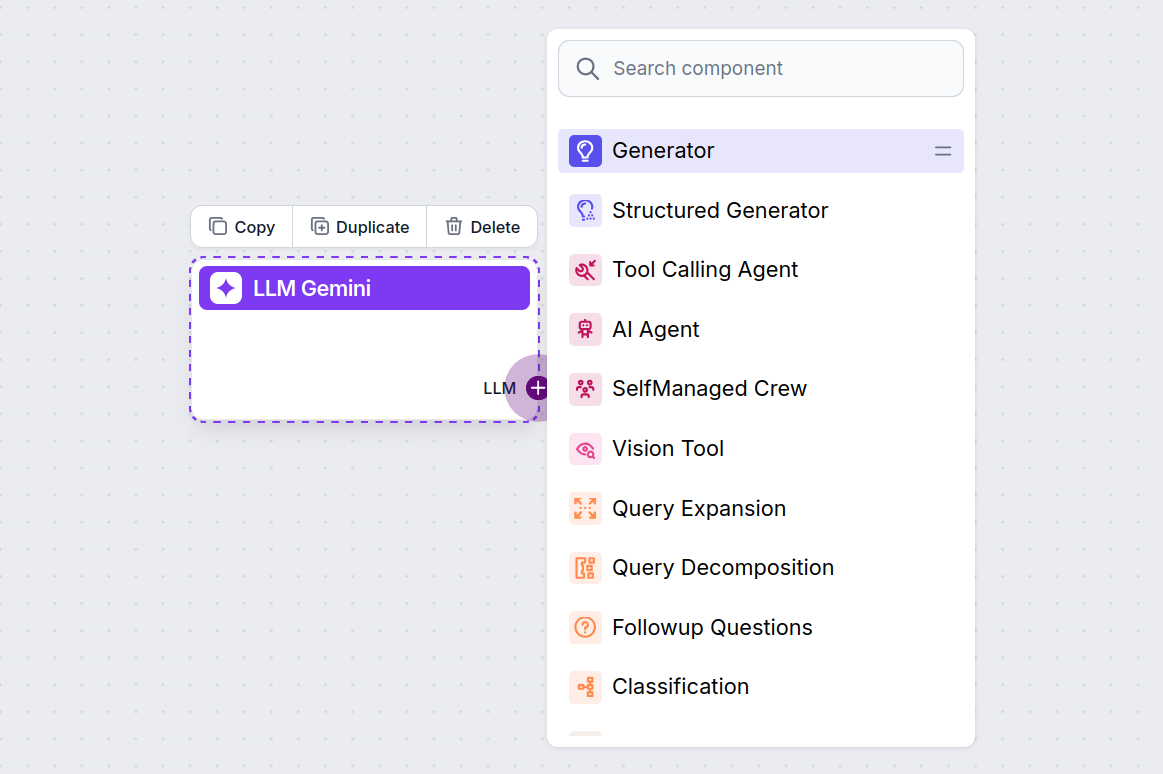

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

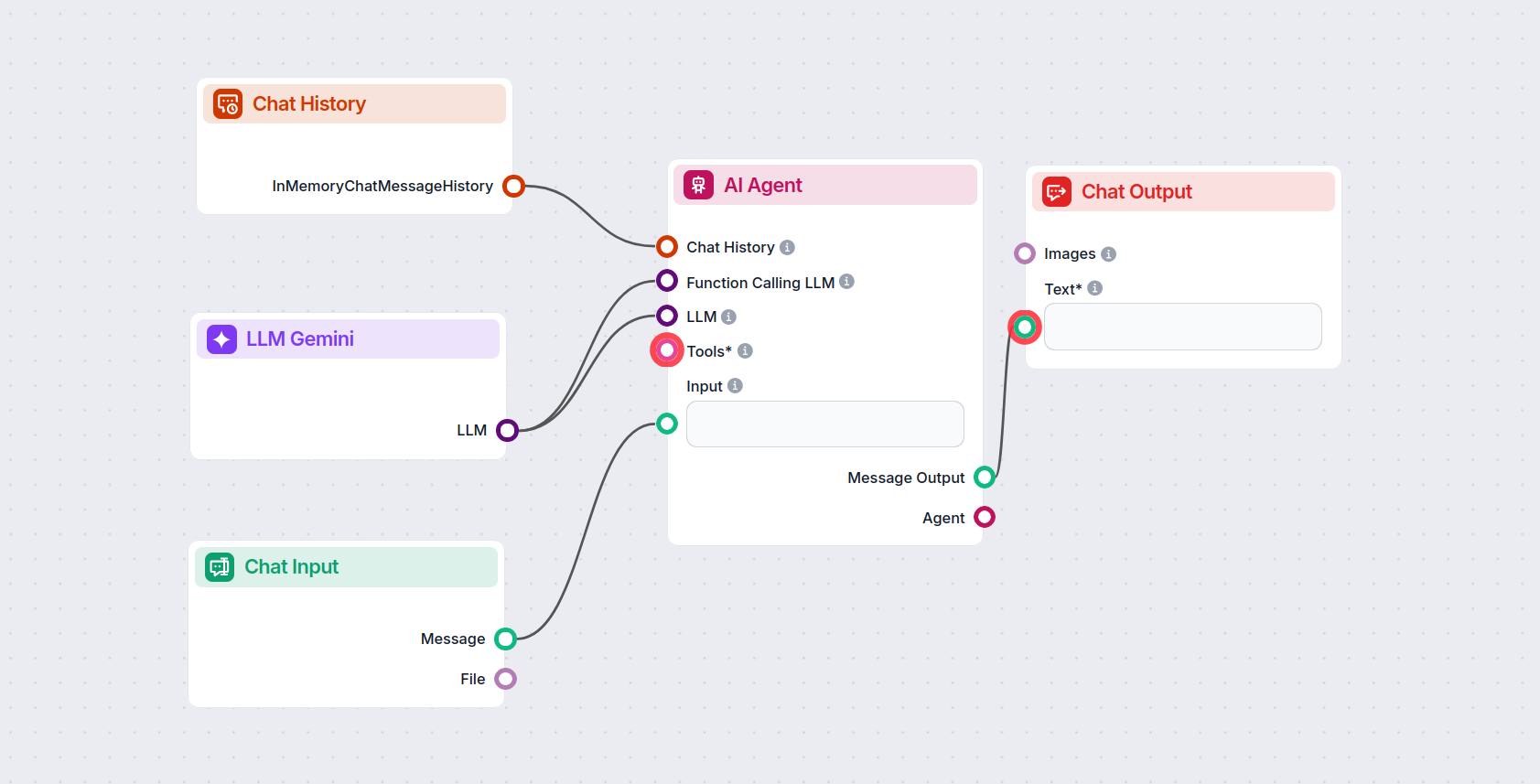

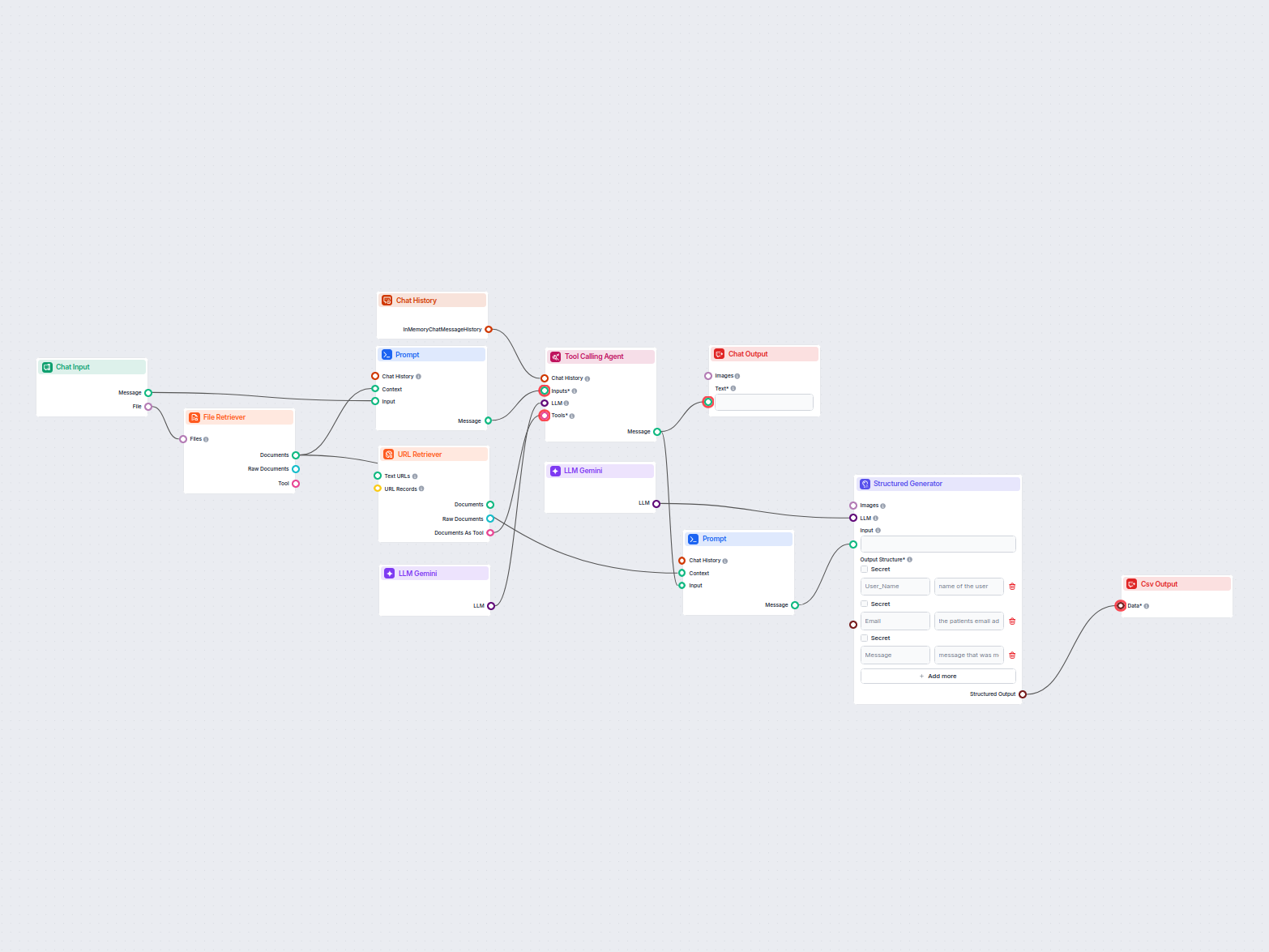

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Gemini 2.0 Flash Experimental to generate responses. You can think of it as a basic Gemini chatbot.

This simple Chatbot Flow includes:

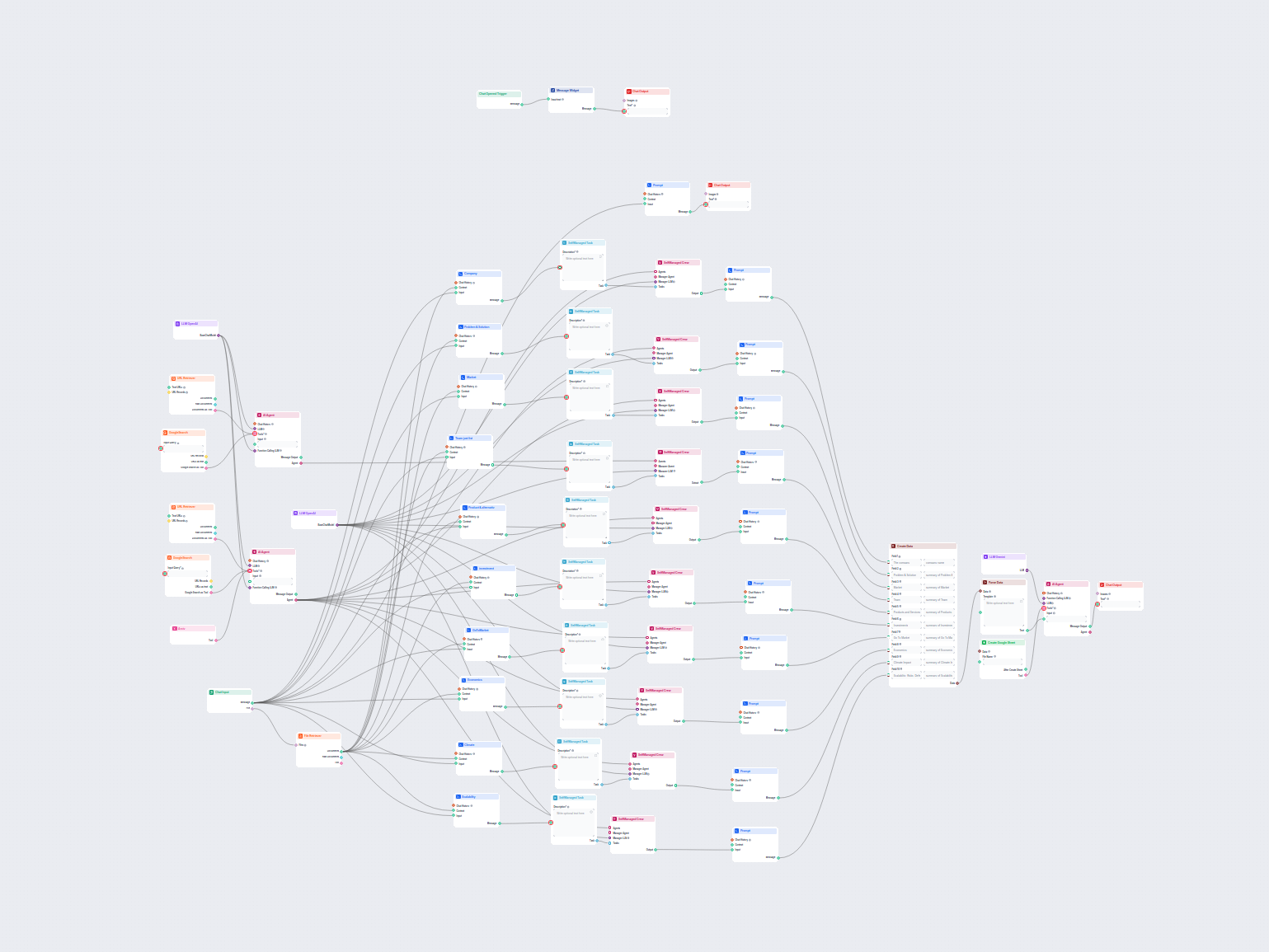

Aby pomóc Ci szybko zacząć, przygotowaliśmy kilka przykładowych szablonów przepływu, które pokazują, jak efektywnie używać komponentu LLM Gemini. Te szablony prezentują różne przypadki użycia i najlepsze praktyki, ułatwiając zrozumienie i implementację komponentu w Twoich własnych projektach.

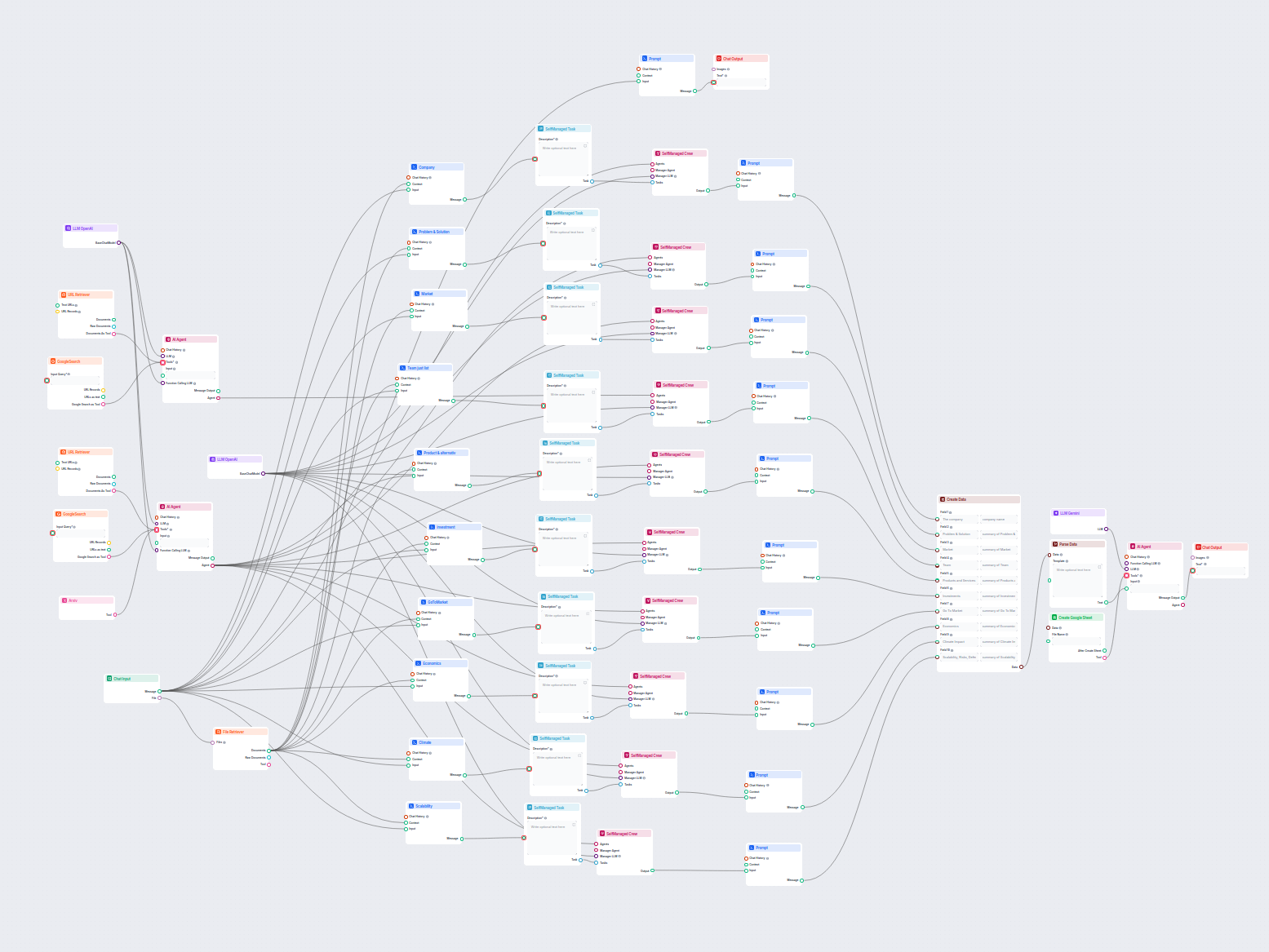

Ten workflow oparty na AI dostarcza kompleksową, opartą na danych analizę firmy. Zbiera informacje o tle firmy, otoczeniu rynkowym, zespole, produktach, inwesty...

Ten przepływ pracy analizuje dowolną firmę wnikliwie poprzez badanie danych publicznych i dokumentów, obejmując rynek, zespół, produkty, inwestycje i więcej. Sy...

Ten przepływ pracy wyodrębnia i porządkuje kluczowe informacje z e-maili oraz załączonych plików, wykorzystuje AI do przetwarzania i strukturyzacji danych, a na...

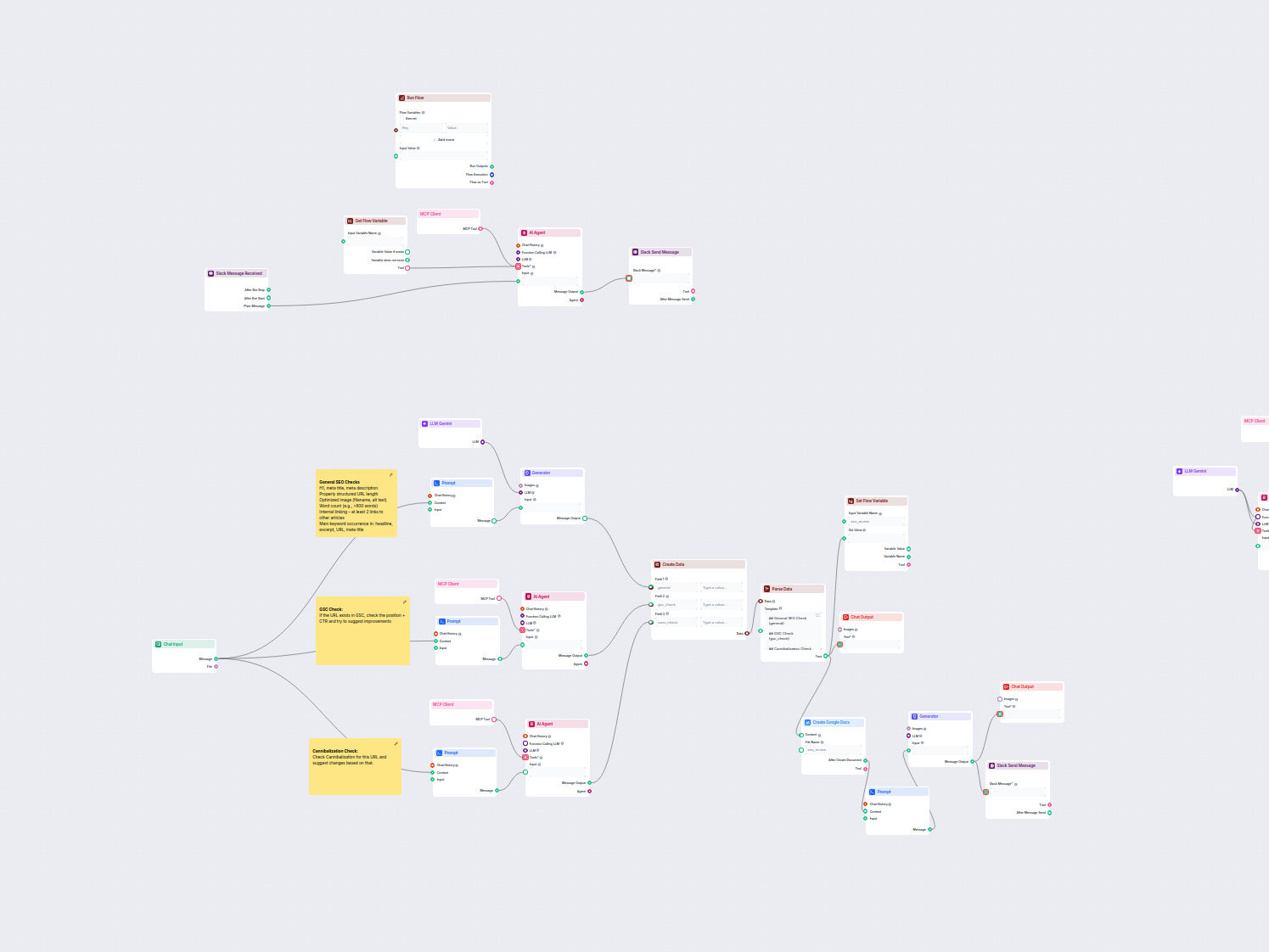

Ten workflow automatyzuje proces przeglądu i audytu SEO dla stron internetowych. Analizuje zawartość strony pod kątem najlepszych praktyk SEO, wykonuje sprawdze...

LLM Gemini łączy modele Gemini od Google z Twoimi przepływami AI w FlowHunt, umożliwiając wybór najnowszych wariantów Gemini do generowania tekstu oraz dostosowywanie ich działania.

FlowHunt obsługuje Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B oraz Gemini 1.5 Pro — każdy z nich oferuje unikalne możliwości dla tekstu, obrazu, dźwięku i wideo.

Max Tokens ogranicza długość odpowiedzi, a Temperatura steruje kreatywnością — niższe wartości dają bardziej konkretne odpowiedzi, wyższe pozwalają na większą różnorodność. Oba parametry można ustawić indywidualnie dla każdego modelu w FlowHunt.

Nie, użycie komponentów LLM jest opcjonalne. Wszystkie przepływy AI domyślnie korzystają z ChatGPT-4o, ale dodanie LLM Gemini pozwala przełączyć się na modele Google i precyzyjnie dostroić ich ustawienia.

Zacznij budować zaawansowane chatboty AI i narzędzia z Gemini oraz innymi topowymi modelami — wszystko w jednym panelu. Przełączaj modele, personalizuj ustawienia i usprawniaj swoje workflowy.

FlowHunt obsługuje dziesiątki modeli AI, w tym rewolucyjne modele DeepSeek. Oto jak korzystać z DeepSeek w swoich narzędziach AI i chatbotach.

FlowHunt obsługuje dziesiątki modeli tekstowych AI, w tym modele Mistral. Dowiedz się, jak używać Mistral w swoich narzędziach AI i chatbotach.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele Llama firmy Meta. Dowiedz się, jak zintegrować Llama z własnymi narzędziami AI i chatbotam...