LLM xAI

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele xAI. Zobacz, jak korzystać z modeli xAI w swoich narzędziach AI i chatbotach.

LLM Meta AI w FlowHunt łączy modele Llama firmy Meta i dziesiątki innych modeli AI w jednym, łatwym do kontrolowania panelu do elastycznego generowania tekstu i obrazów.

Opis komponentu

The LLM Meta AI component connects the Claude family of model to your Flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the used model. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

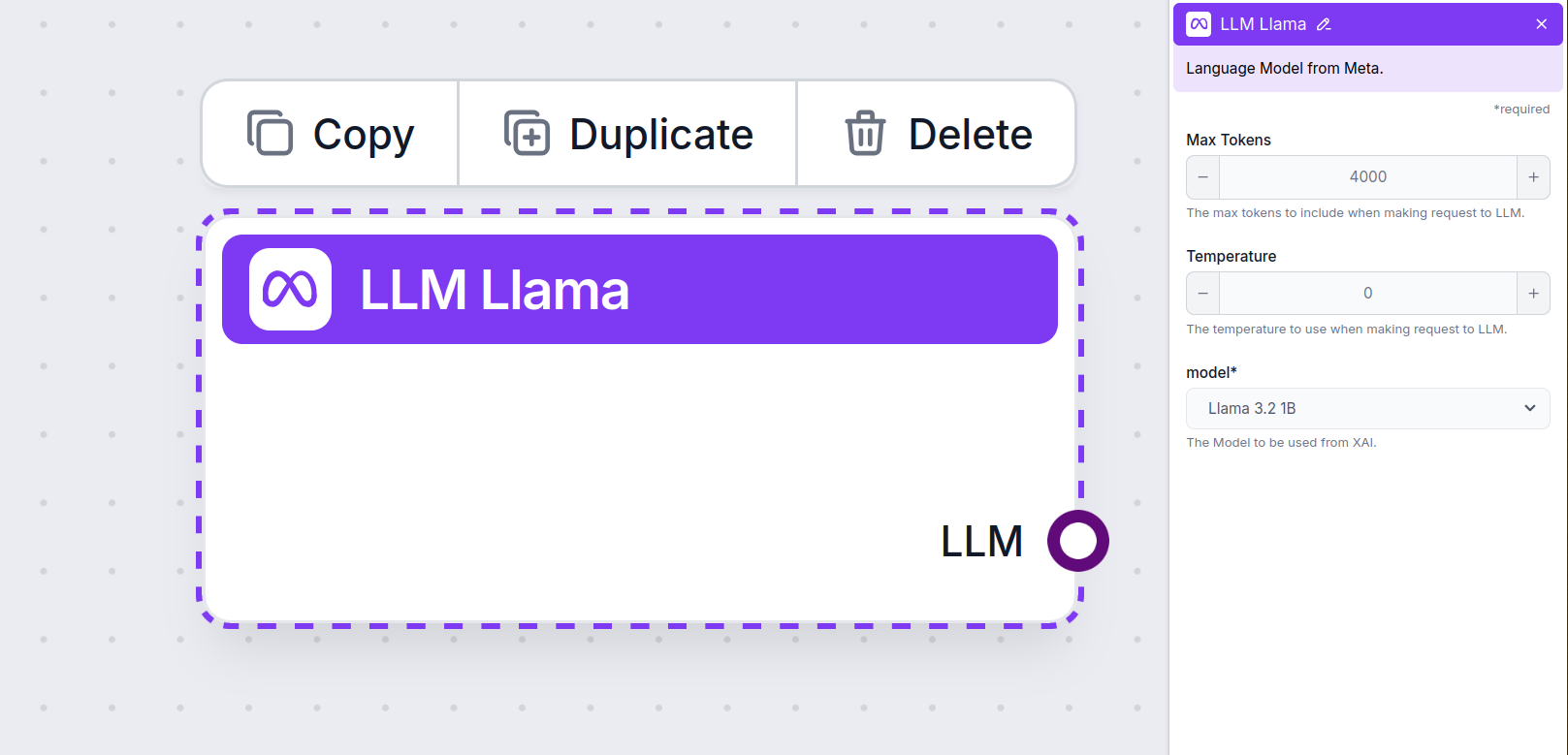

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. You’ll find all the supported models from Meta AI here. We support Meta’s open-source lightweight Llama models. These models are designed for efficient on-device and edge deployments:

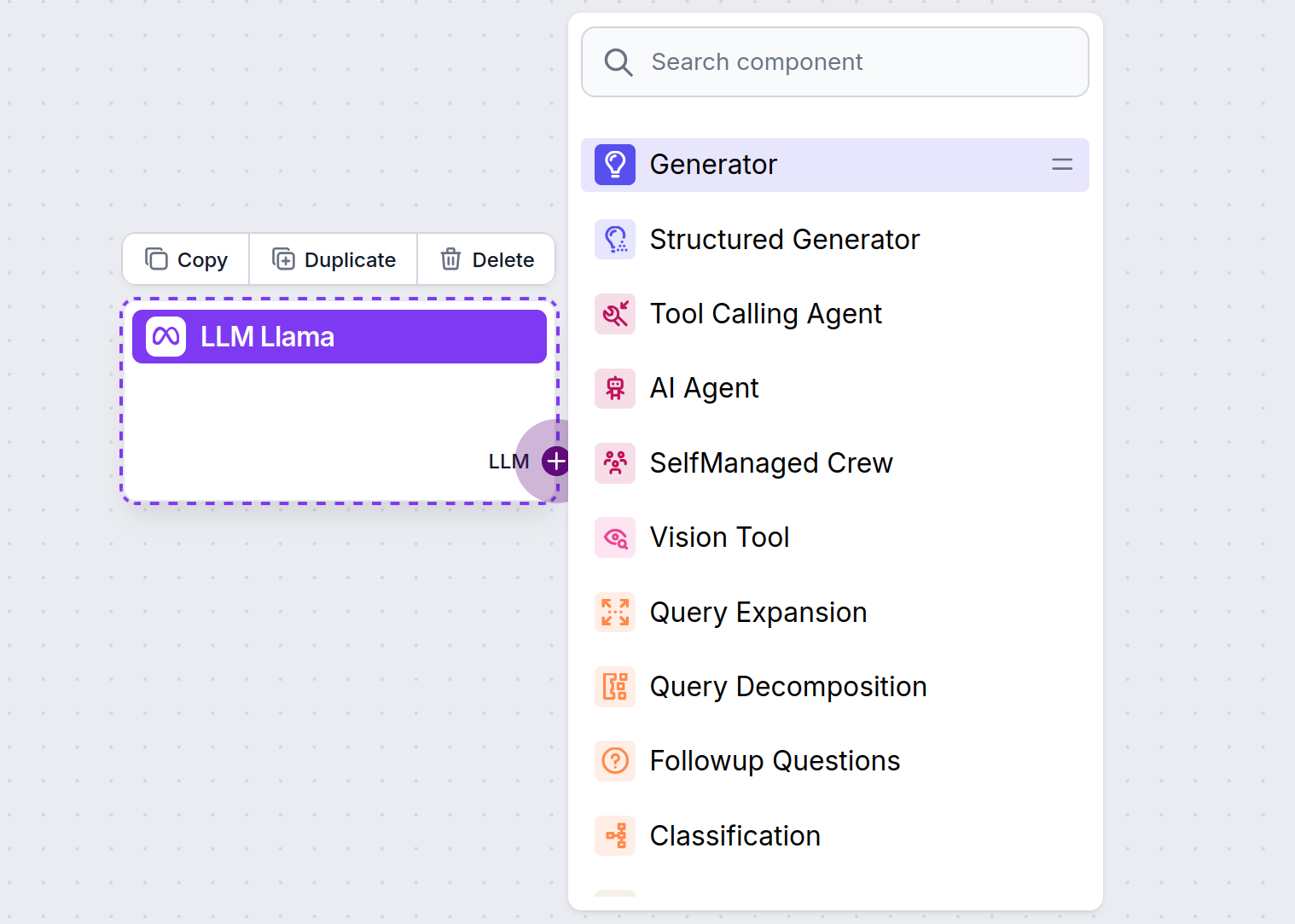

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

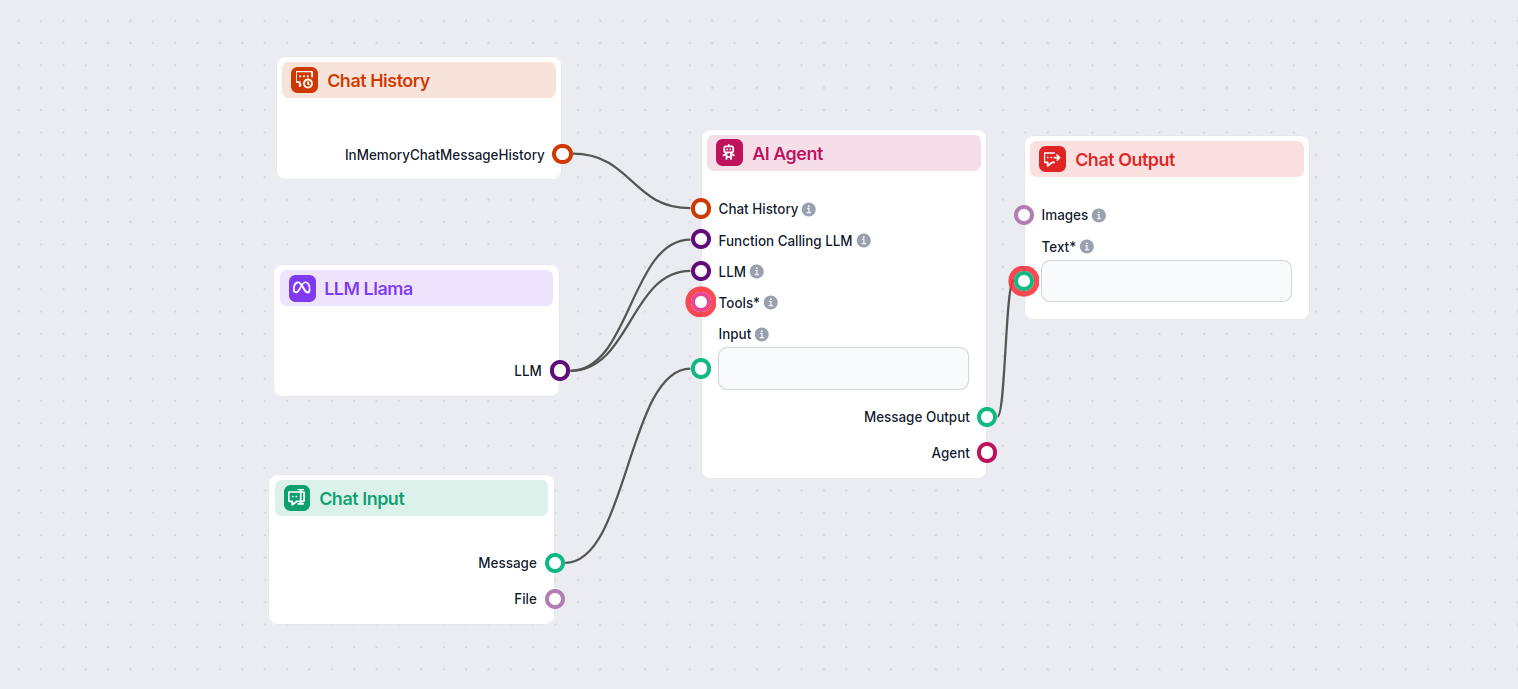

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Meta AI’s Llama 3.2 1B to generate responses. You can think of it as a basic Llama chatbot.

This simple Chatbot Flow includes:

Komponent LLM Meta AI pozwala podłączyć modele Llama firmy Meta oraz inne generatory tekstu/obrazów do Twoich przepływów, umożliwiając łatwy wybór modelu i zaawansowaną konfigurację, taką jak maksymalna liczba tokenów czy temperatura.

FlowHunt obsługuje otwartoźródłowe modele Llama firmy Meta, w tym Llama 3.2 1B i 3B, zoptymalizowane pod kątem wydajności, podsumowań i wdrożeń na urządzeniach.

Możesz dostosować takie ustawienia jak maksymalna liczba tokenów (ogranicza długość odpowiedzi), temperatura (reguluje kreatywność odpowiedzi) oraz wybór modelu bezpośrednio z panelu FlowHunt dla każdego komponentu.

Nie, dodanie komponentu LLM Meta AI jest opcjonalne. Domyślnie komponenty korzystają z ChatGPT-4o, ale możesz przełączyć się na Llama lub inne modele, by mieć większą kontrolę lub dla konkretnych zastosowań.

Zacznij budować inteligentniejsze chatboty i narzędzia AI z wykorzystaniem modeli Llama firmy Meta oraz dziesiątek innych generatorów AI — wszystko na jednej platformie.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele xAI. Zobacz, jak korzystać z modeli xAI w swoich narzędziach AI i chatbotach.

FlowHunt obsługuje dziesiątki modeli tekstowych AI, w tym modele Mistral. Dowiedz się, jak używać Mistral w swoich narzędziach AI i chatbotach.

FlowHunt obsługuje dziesiątki modeli AI, w tym modele Claude firmy Anthropic. Dowiedz się, jak korzystać z Claude w swoich narzędziach AI i chatbotach dzięki ko...