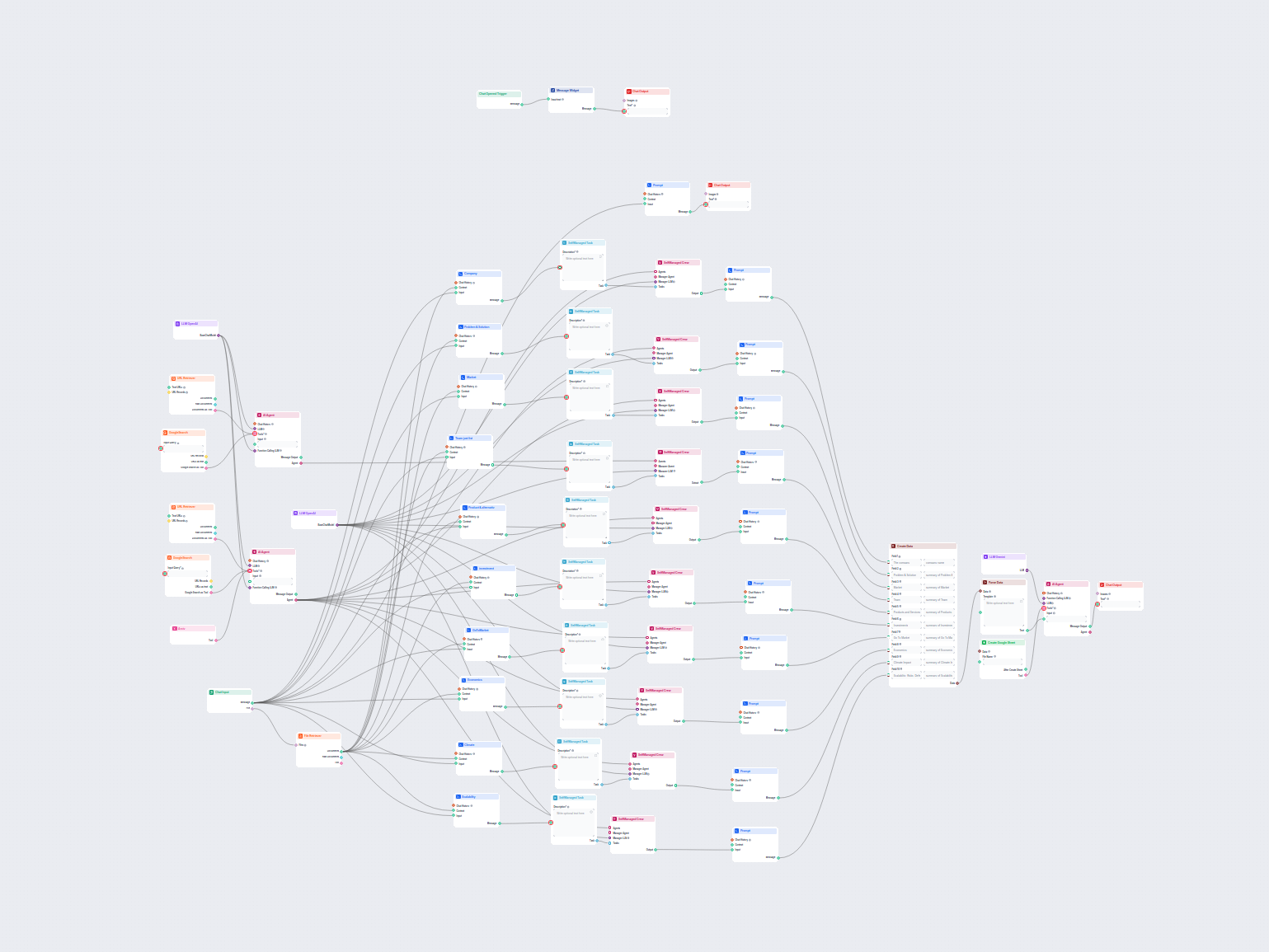

Agent AI do obsługi klienta dla LiveAgent

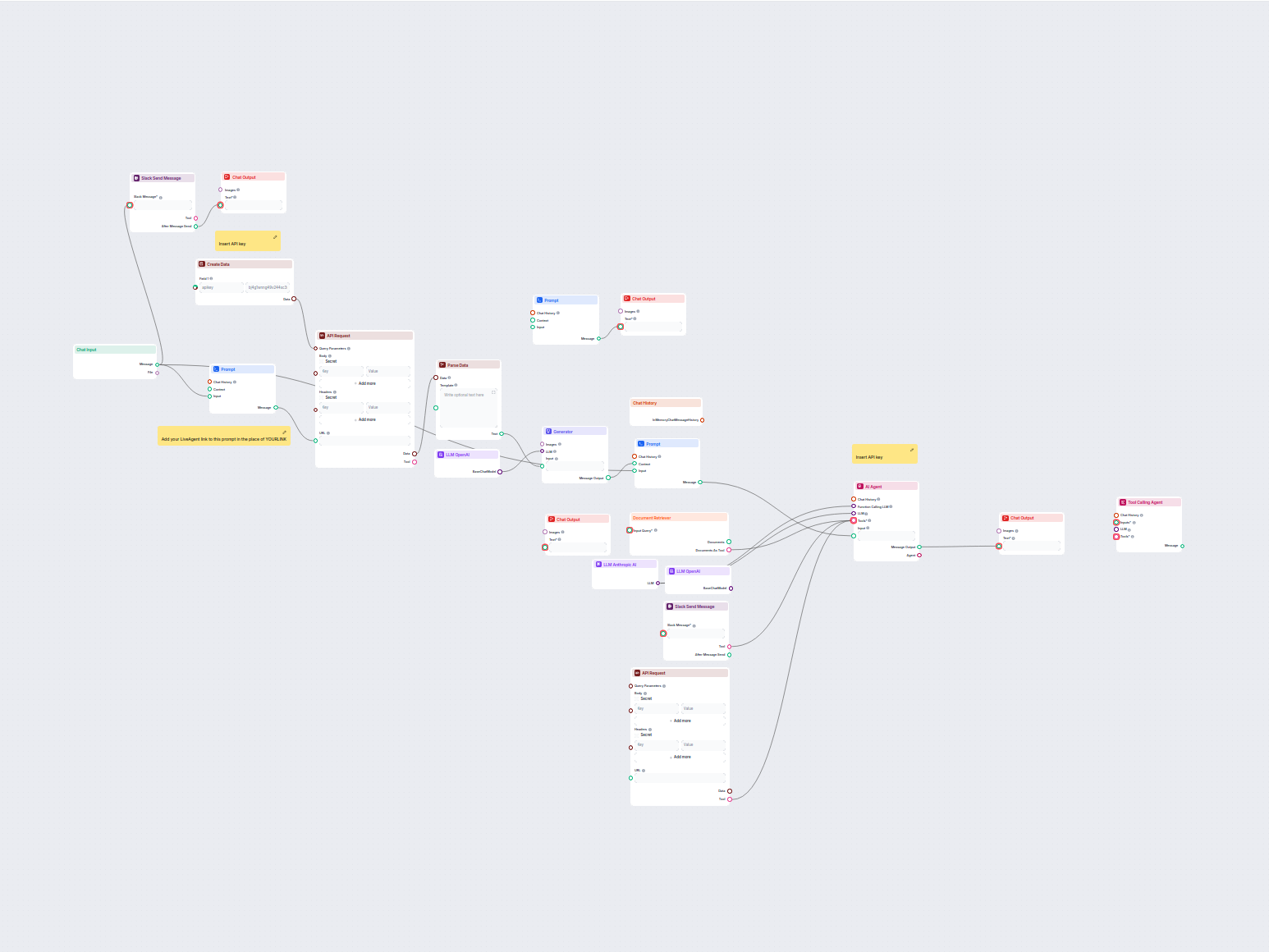

Ten workflow automatyzuje obsługę klienta w Twojej firmie poprzez integrację rozmów z LiveAgent, wydobywanie istotnych danych z konwersacji, generowanie odpowie...

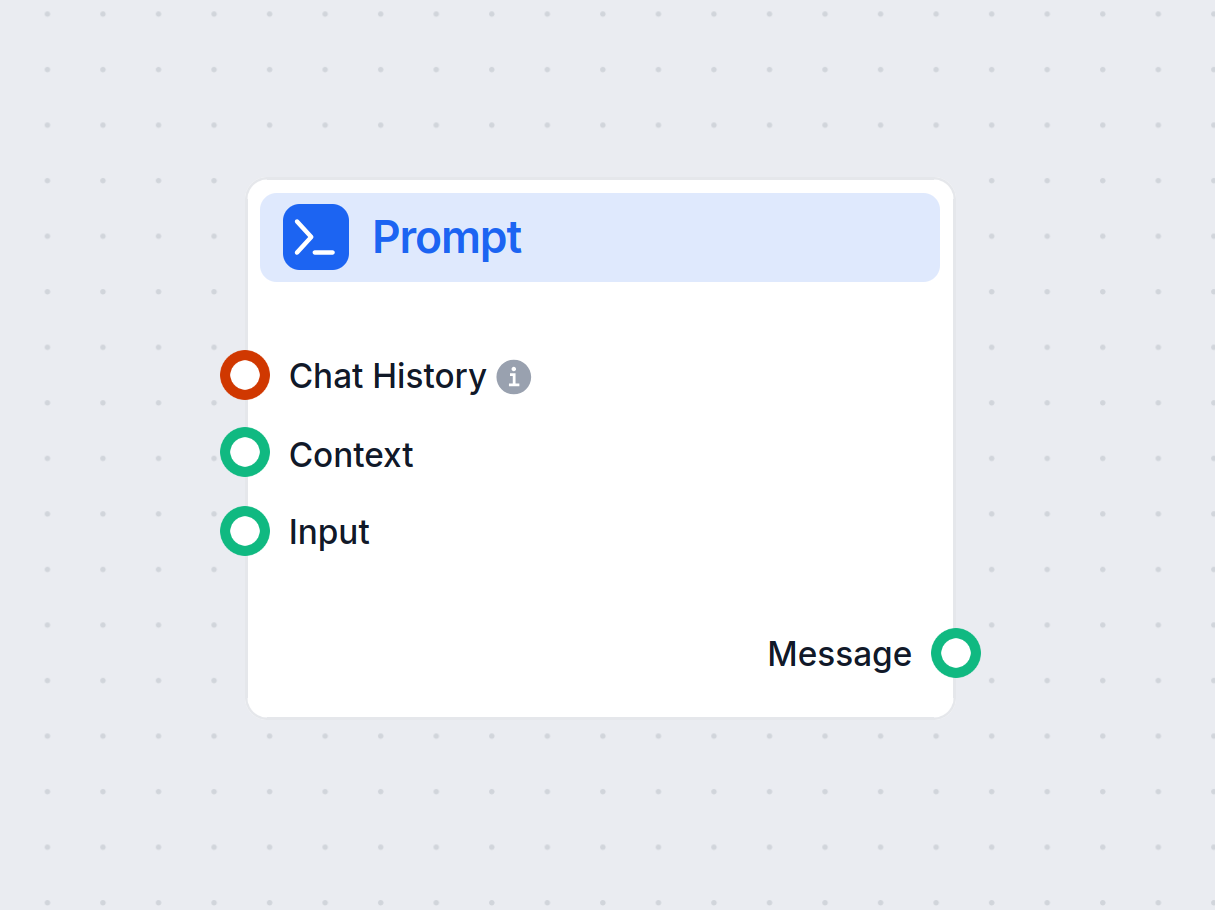

Komponent Prompt w FlowHunt określa role i zachowanie bota dla spersonalizowanych odpowiedzi AI. Kontroluj wynik za pomocą własnych szablonów, aby budować skuteczne, kontekstowe czatboty.

Opis komponentu

Without a good prompt, all bots would act the same way and often miss the mark with their answers. Prompts give instructions and context to the language model, helping it to understand what kind of text it should produce.

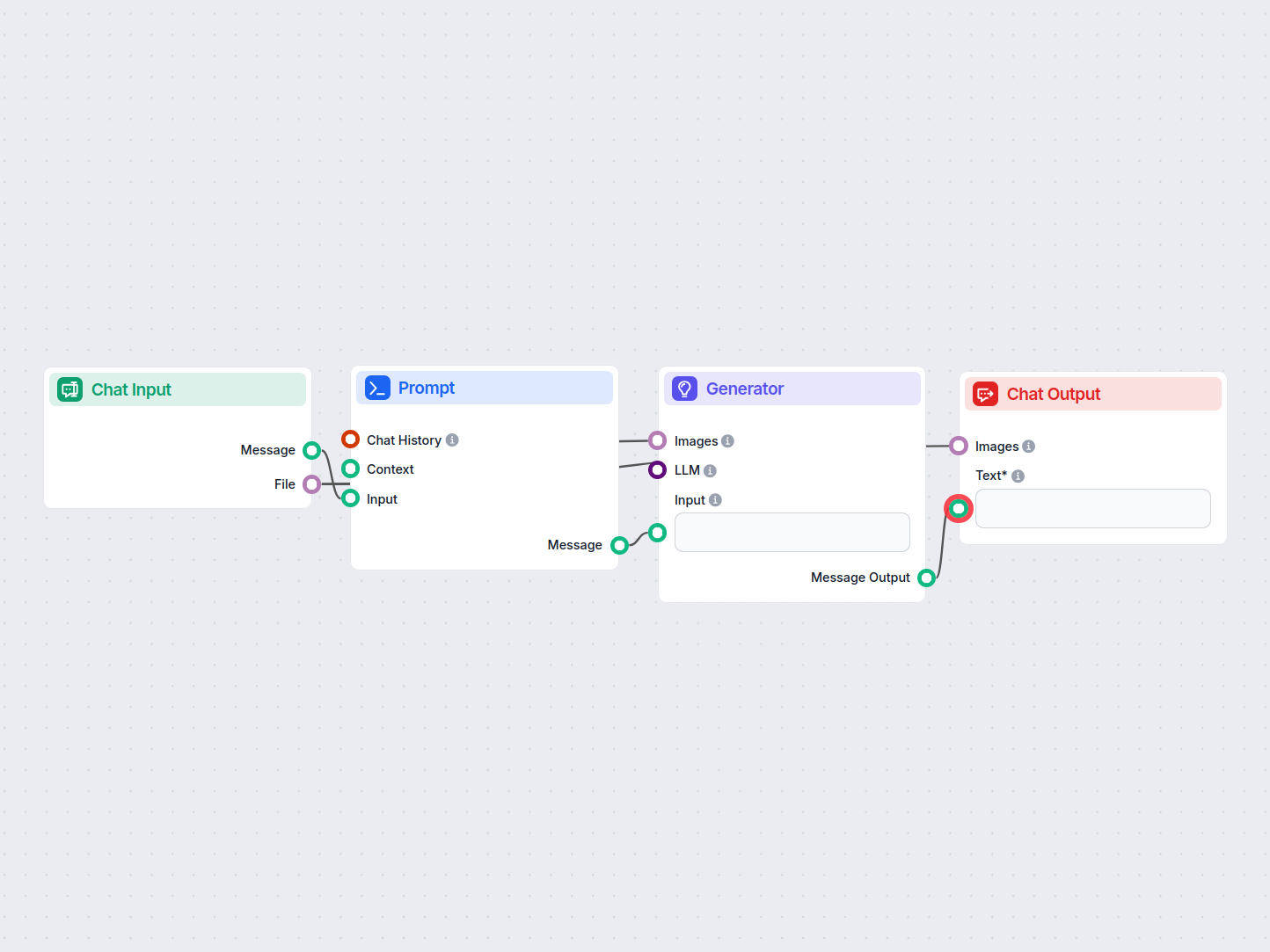

The Prompt component is designed to generate flexible prompt templates for use in AI workflows, allowing dynamic insertion of variables and context. This component is particularly useful in conversational AI scenarios, such as chatbots or virtual assistants, where creating adaptable and context-aware prompts is essential.

The Prompt component creates a prompt template that can incorporate various dynamic variables, such as user input, chat history, system instructions, and context messages. By leveraging these variables, the component helps you structure rich and context-sensitive prompts that enhance the performance and relevance of downstream AI models or agents.

{input}, {human_input}, {context}, {chat_history}, {system_message}, and {all_input_variables} directly into the prompt template.The following inputs can be provided to the Prompt component:

| Input Name | Type | Required | Description |

|---|---|---|---|

| Chat History | InMemoryChatMessageHistory | No | Previous conversation messages. Useful for maintaining context or generating alternative queries. |

| Context | Message | No | Additional context information to be included in the prompt. |

| Input | Message | No | The main user input or message. |

| System Message | String (multiline) | No | System-level instructions to guide the AI’s behavior. |

| Template | Prompt (multiline) | No | The actual template for the prompt, supporting dynamic variables for customization. |

| Output Name | Type | Description |

|---|---|---|

| Message | Message | The generated prompt, ready for use in downstream AI components. |

| Feature | Benefit |

|---|---|

| Dynamic variable injection | Context-aware, adaptable prompts |

| Support for chat history | Maintains continuity in multi-turn interactions |

| System message integration | Fine-tunes AI personality or instructions |

| Easy integration in workflows | Streamlines prompt creation for downstream AI |

This component is a foundational tool for anyone building sophisticated, context-sensitive AI workflows where prompt construction is key to achieving high-quality results.

This is an advanced optional setting. You can create prompt templates with specified variables to control the chat output fully. For example:

As a skilled SEO, analyze the content of the URL and come up with a title up to 65 characters long.— Content of the URL —{input}Task: Generate a Title similar to others using {human_input} query. Don’t change {human_input} in the new title. NEW TITLE:

The default prompt template looks like this:

You are an AI language model assistant.

Your task is to generate answer based on the input query.

If context is provided, use it to generate the answer to INPUT and HUMAN_INPUT query.

Format answer with markdown.

ANSWER IN LANGUAGE: {lang}

VARIABLES:

{"session_start_time": "2025-06-03 07:35:22", "current_page_url": "https://app.flowhunt.io/aistudio/flows/de6c2e2c-d817-4b2f-af2c-12dba3f46870?ws=74be5f74-d7c5-4076-839d-8ac1771a3b75"}

INPUT: {input}

ANSWER:

The default prompt copies the same structure as the component’s settings. You can override the settings by altering and using the variables in the template field. Creating your own templates gives you greater control over the output.

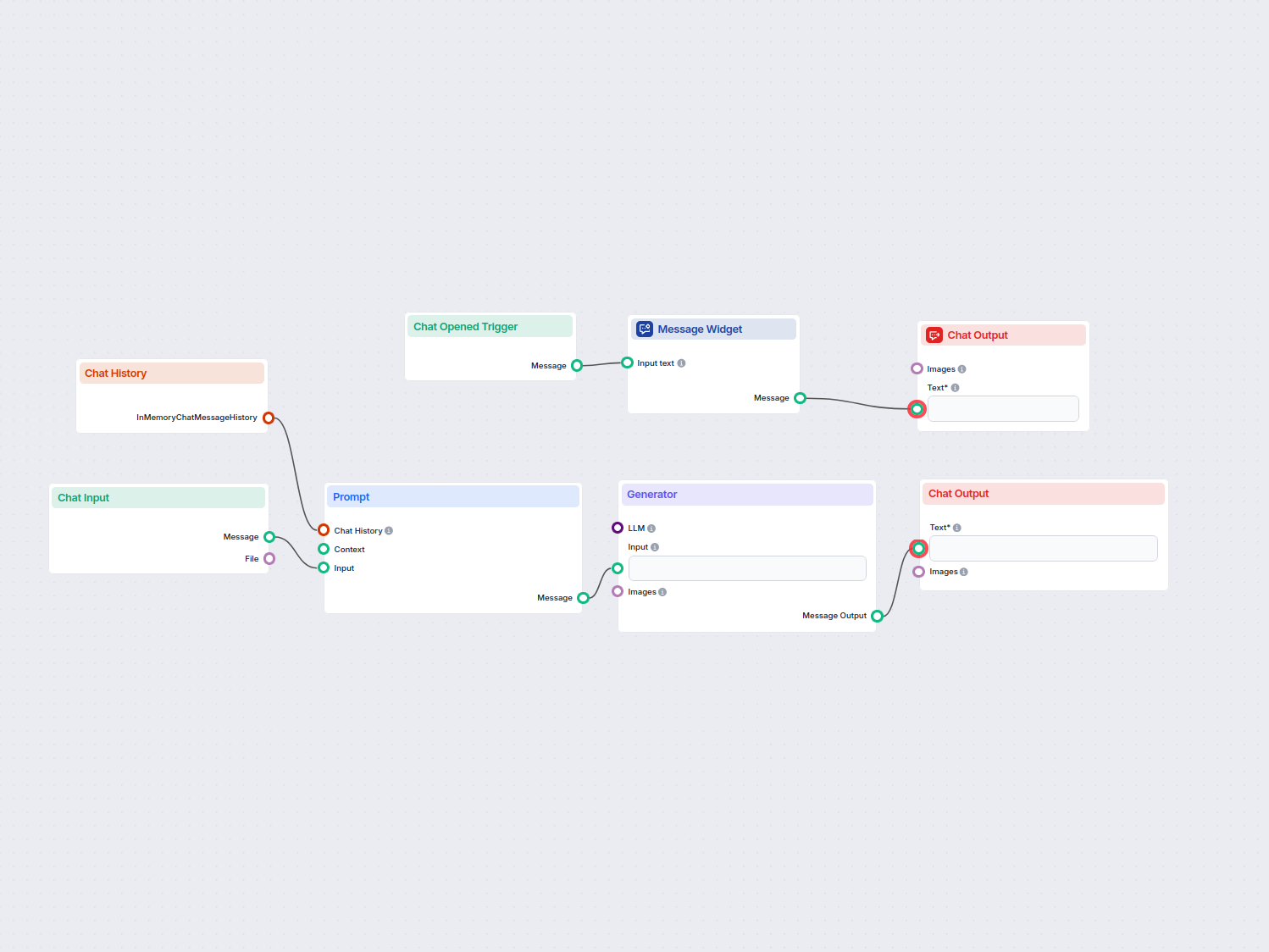

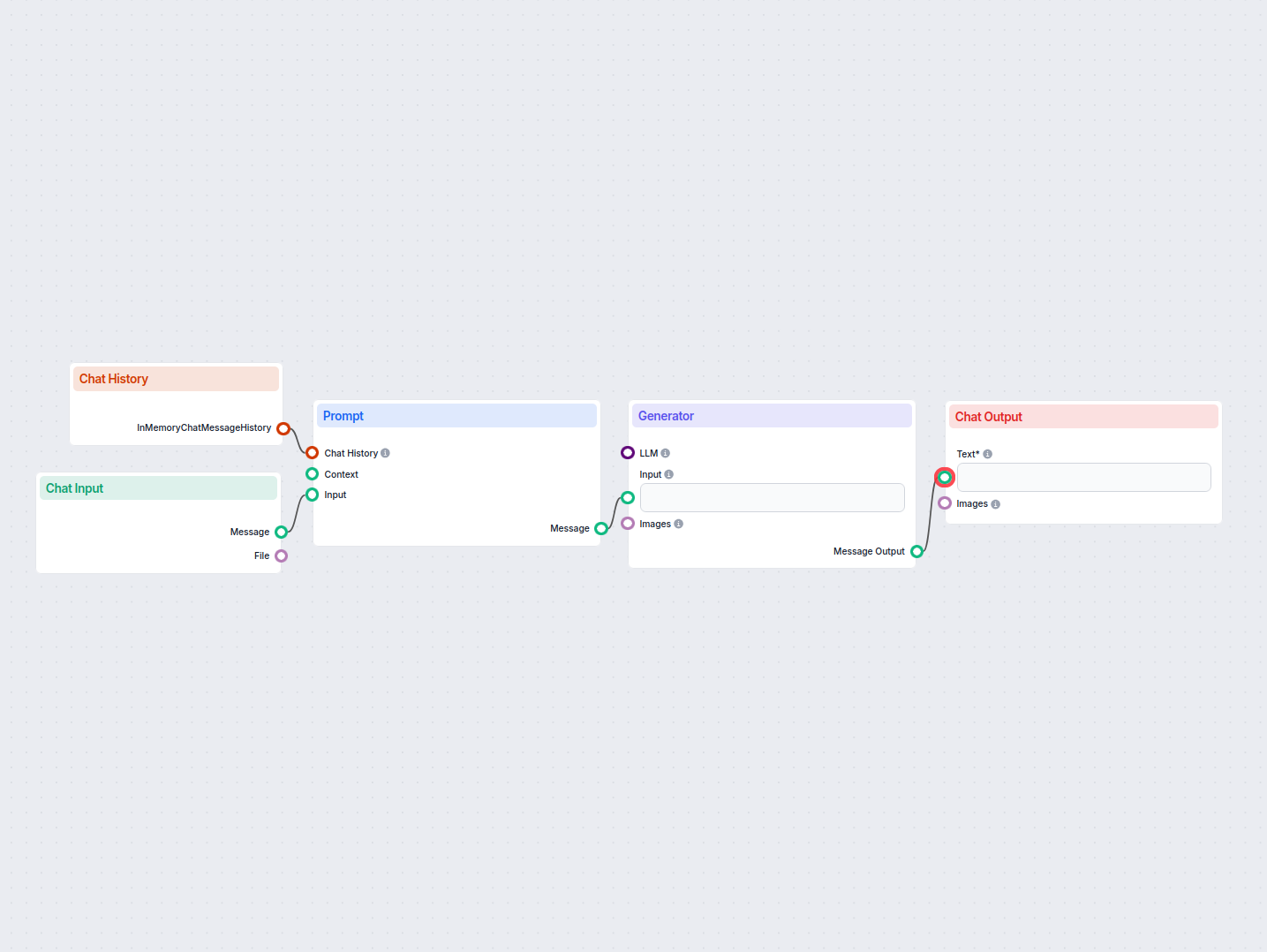

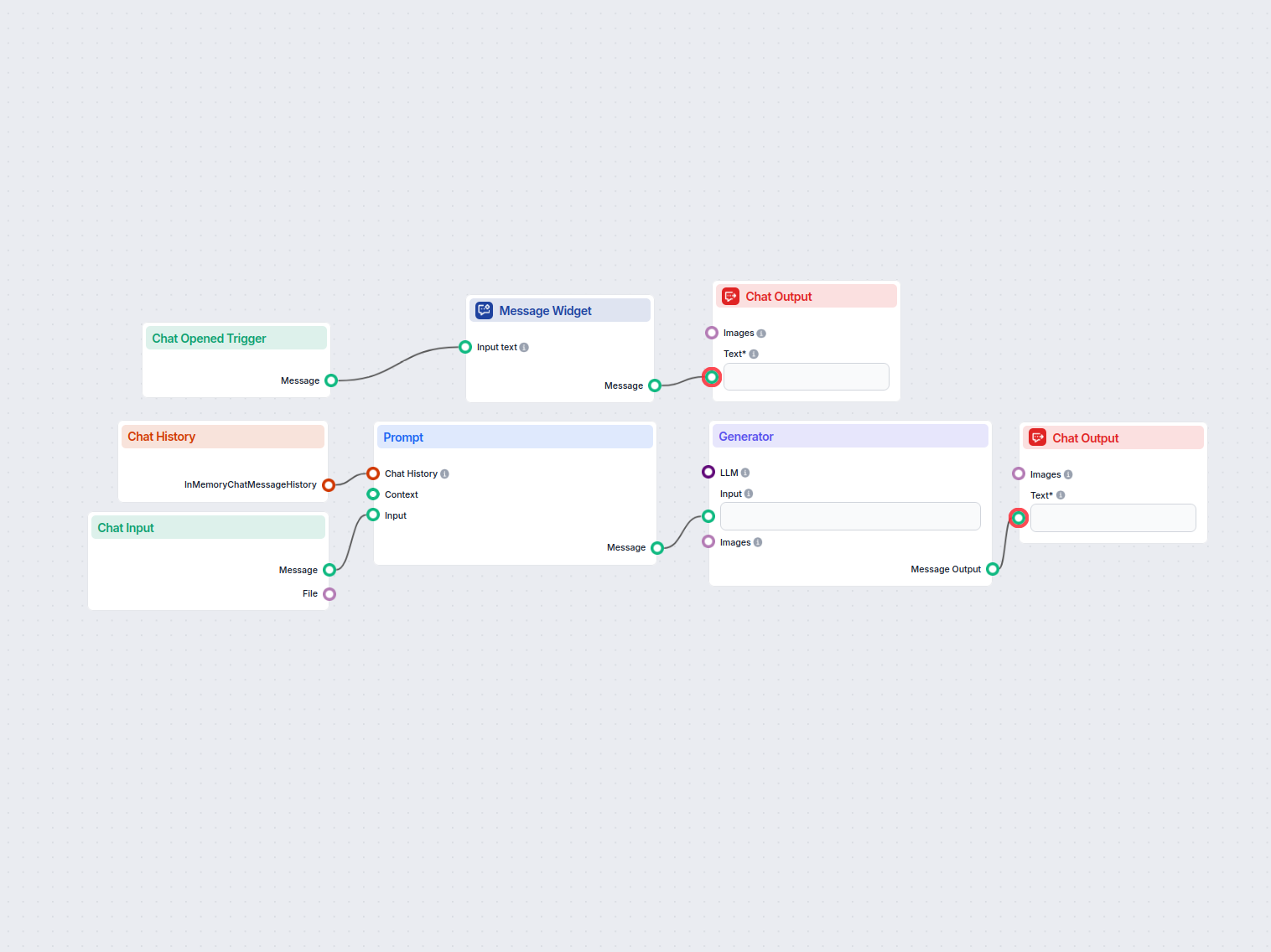

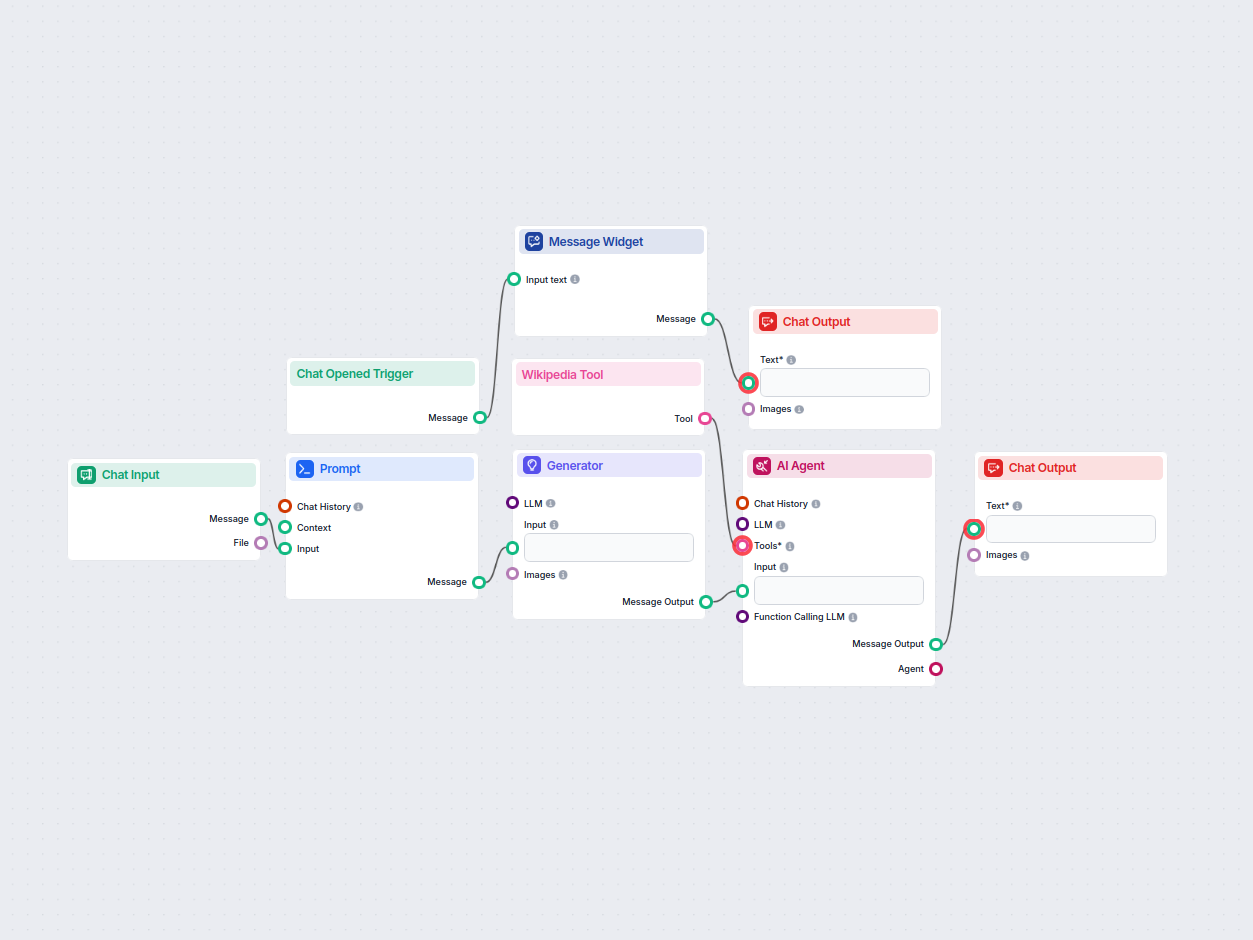

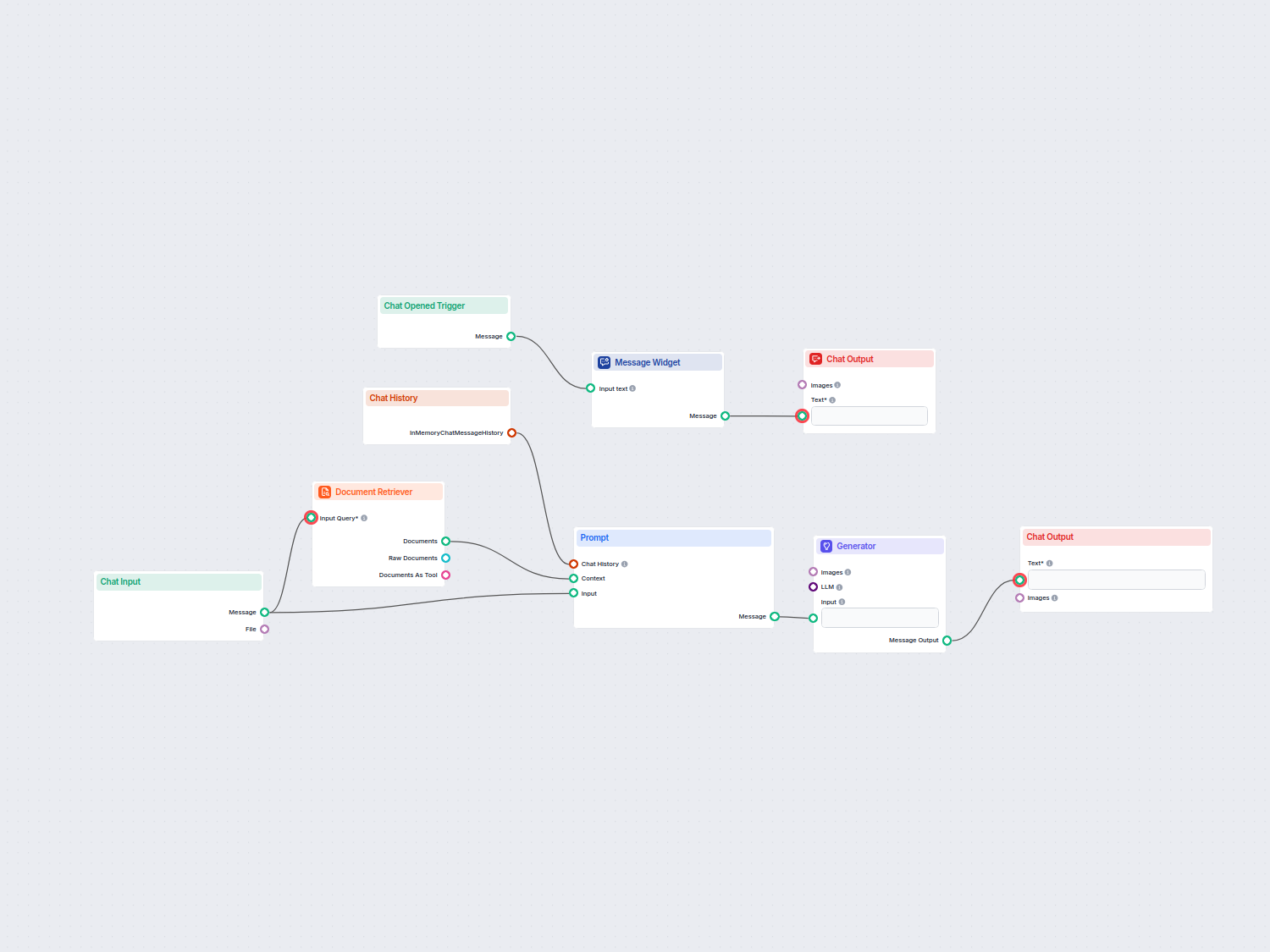

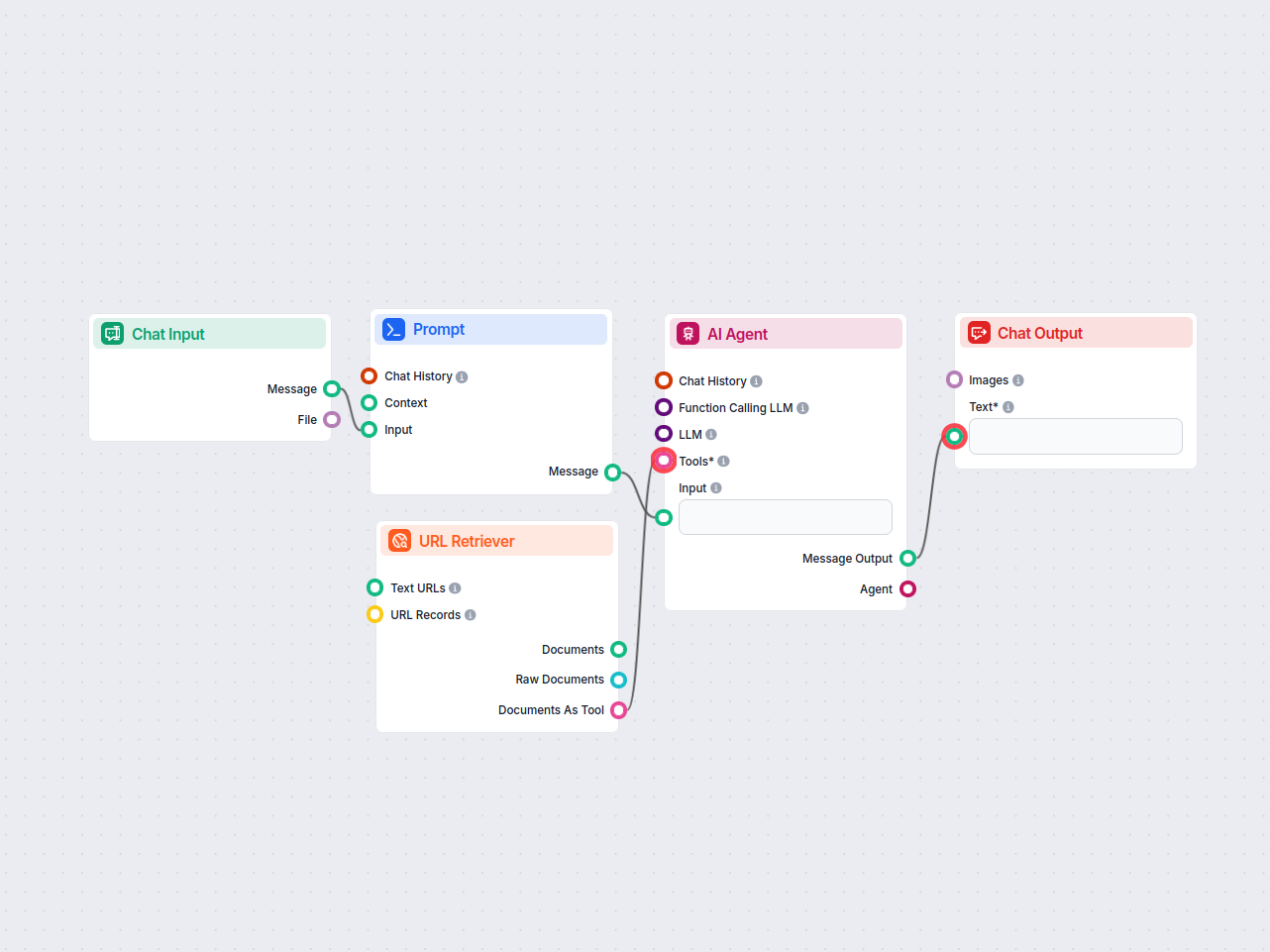

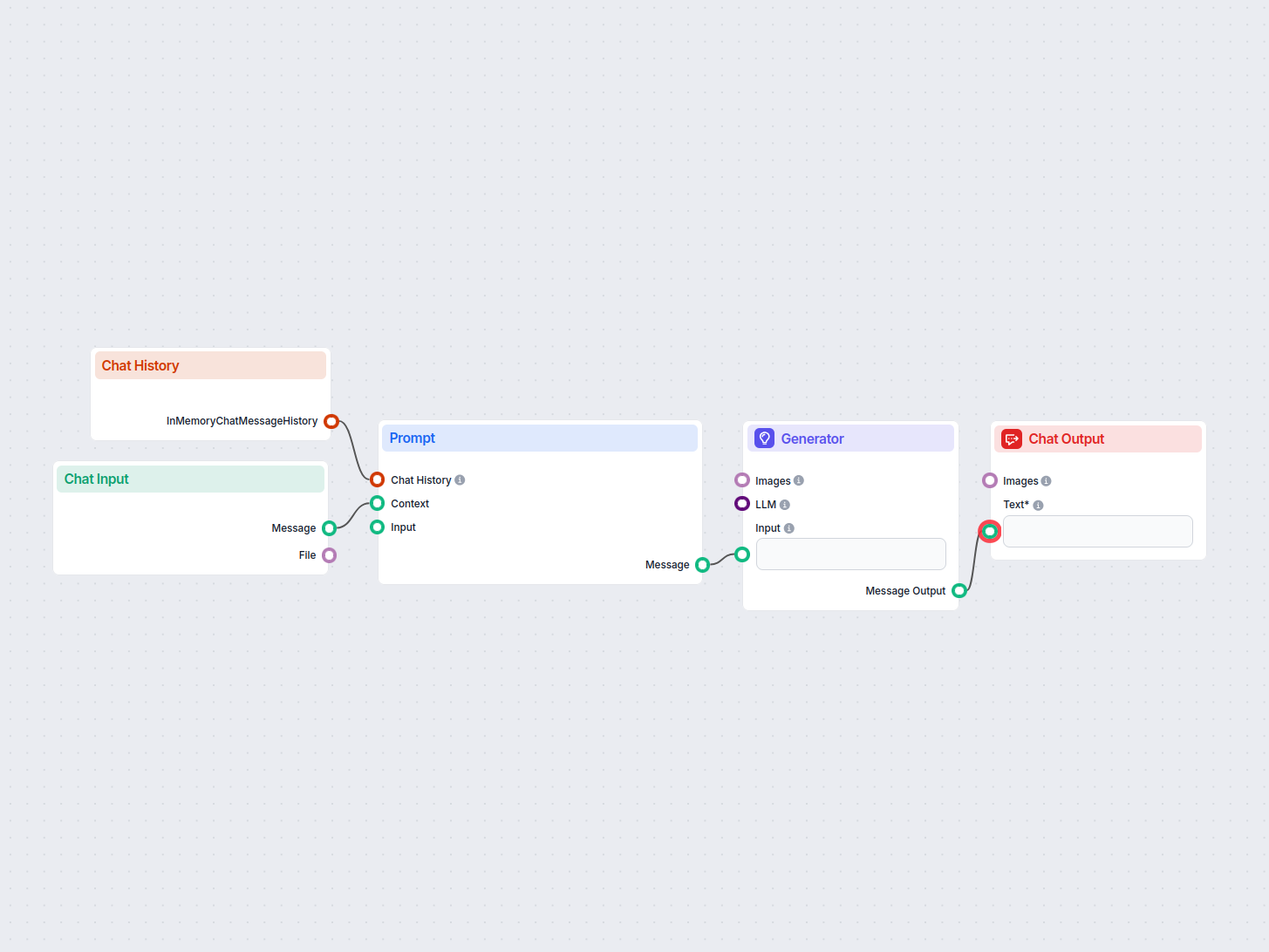

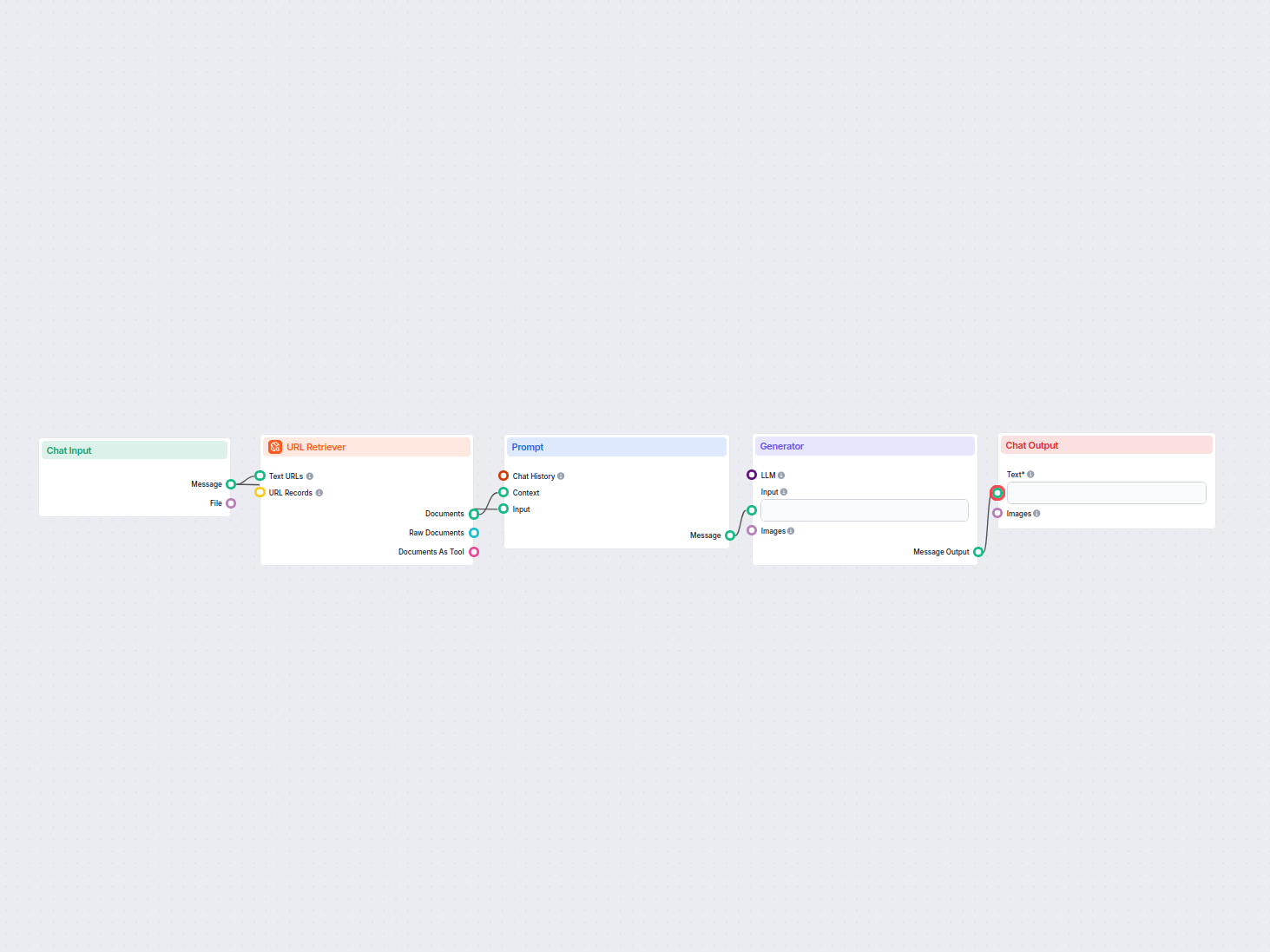

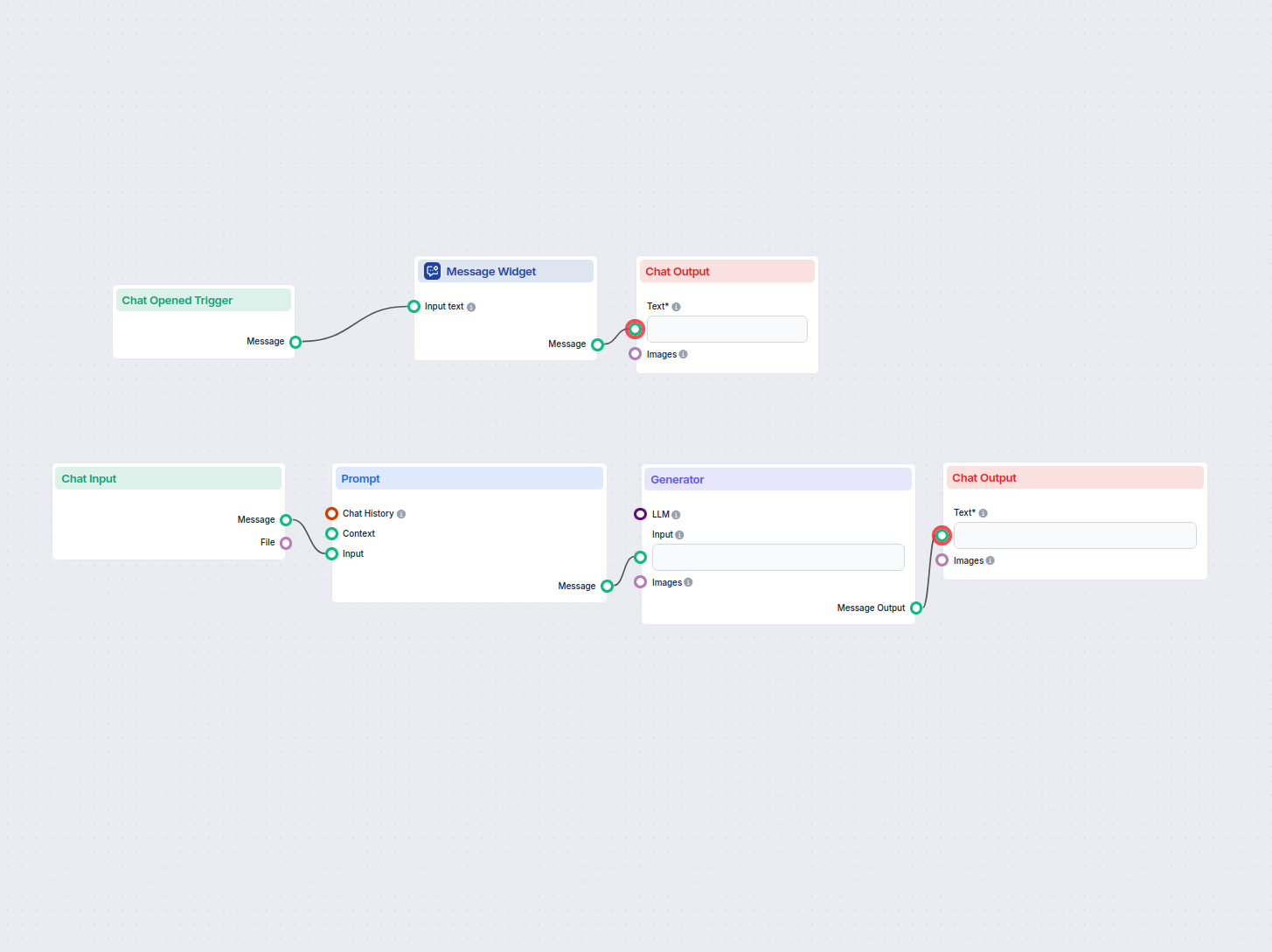

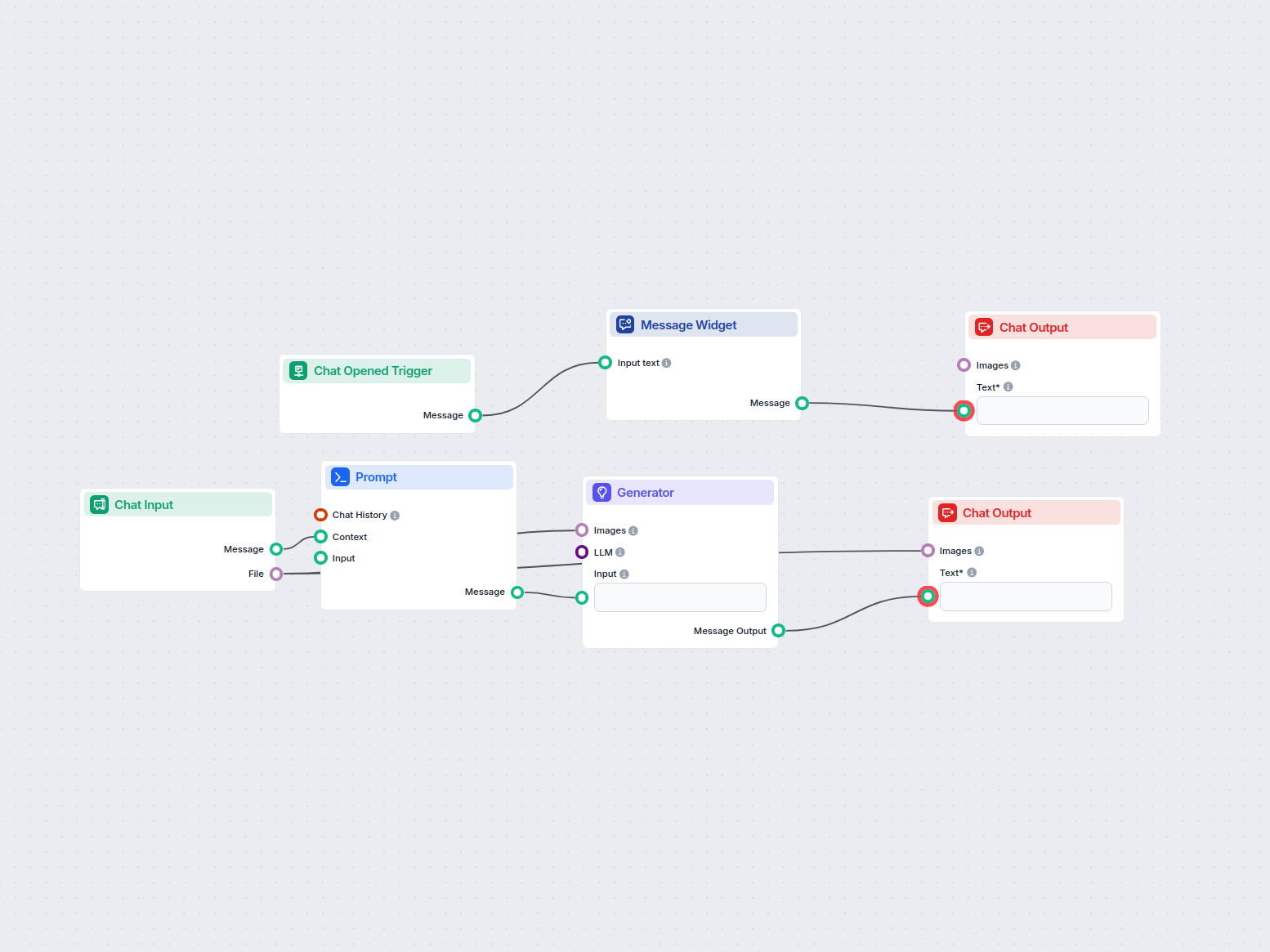

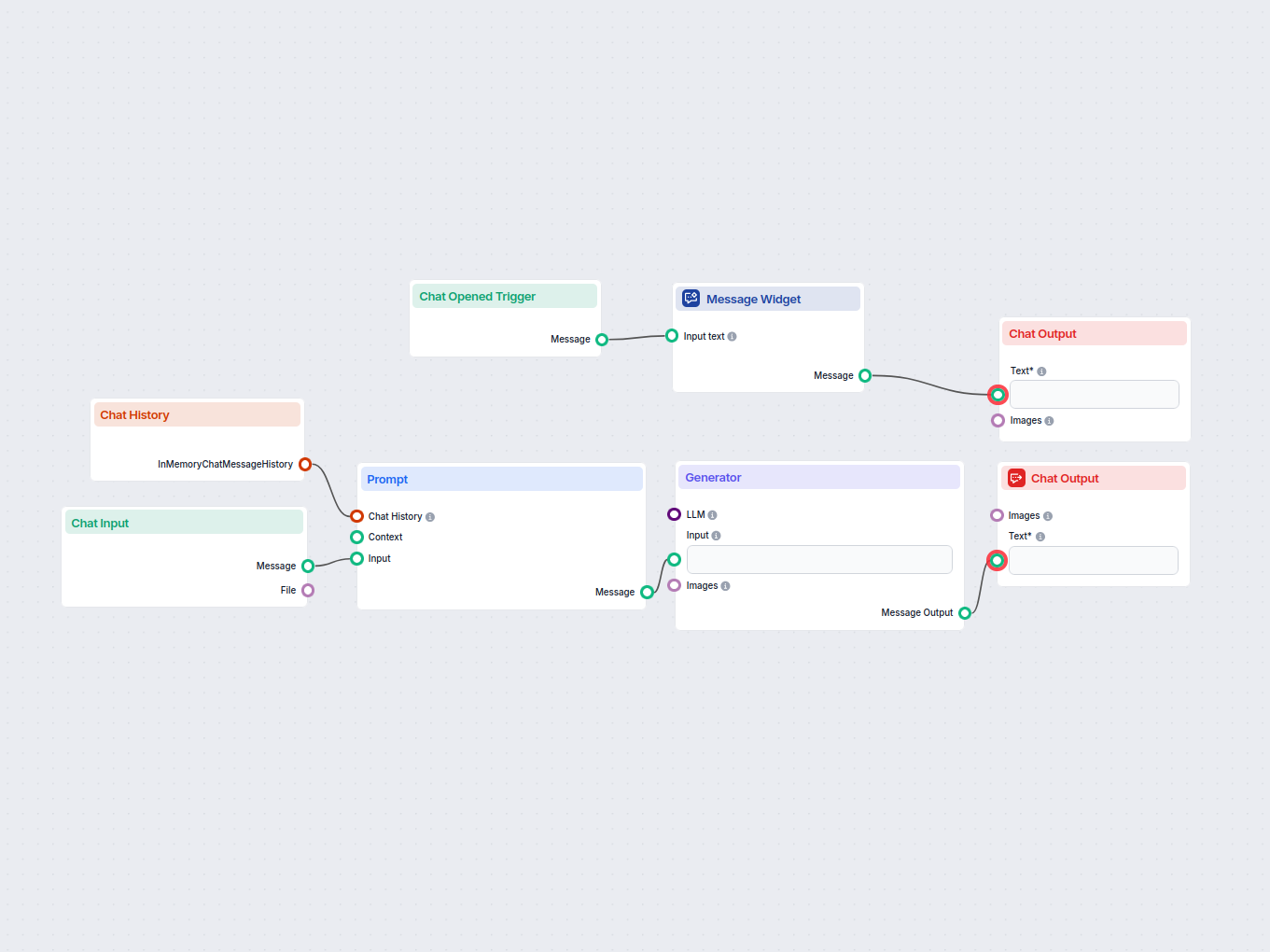

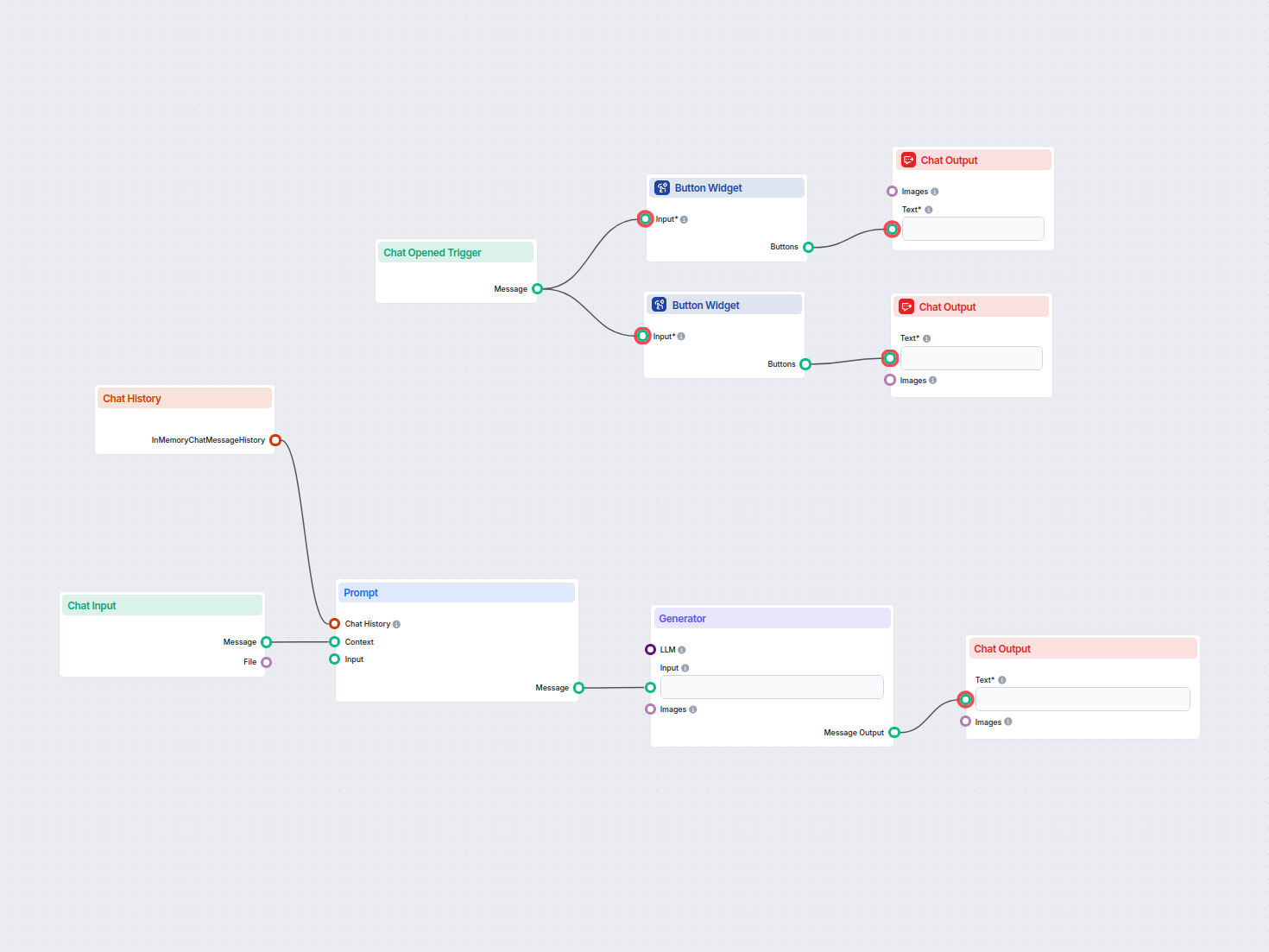

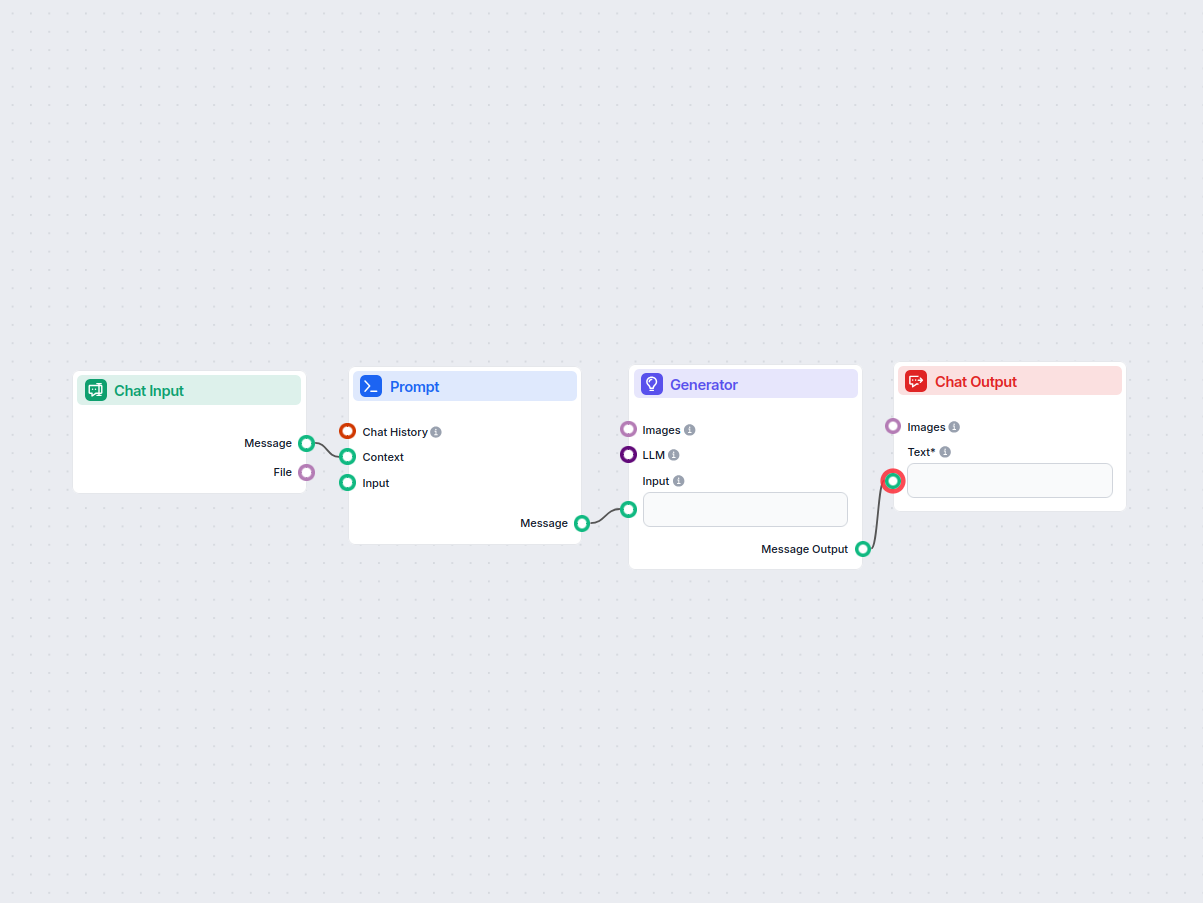

The prompt is an optional component that further modifies and specifies the final output. It needs several components to be connected:

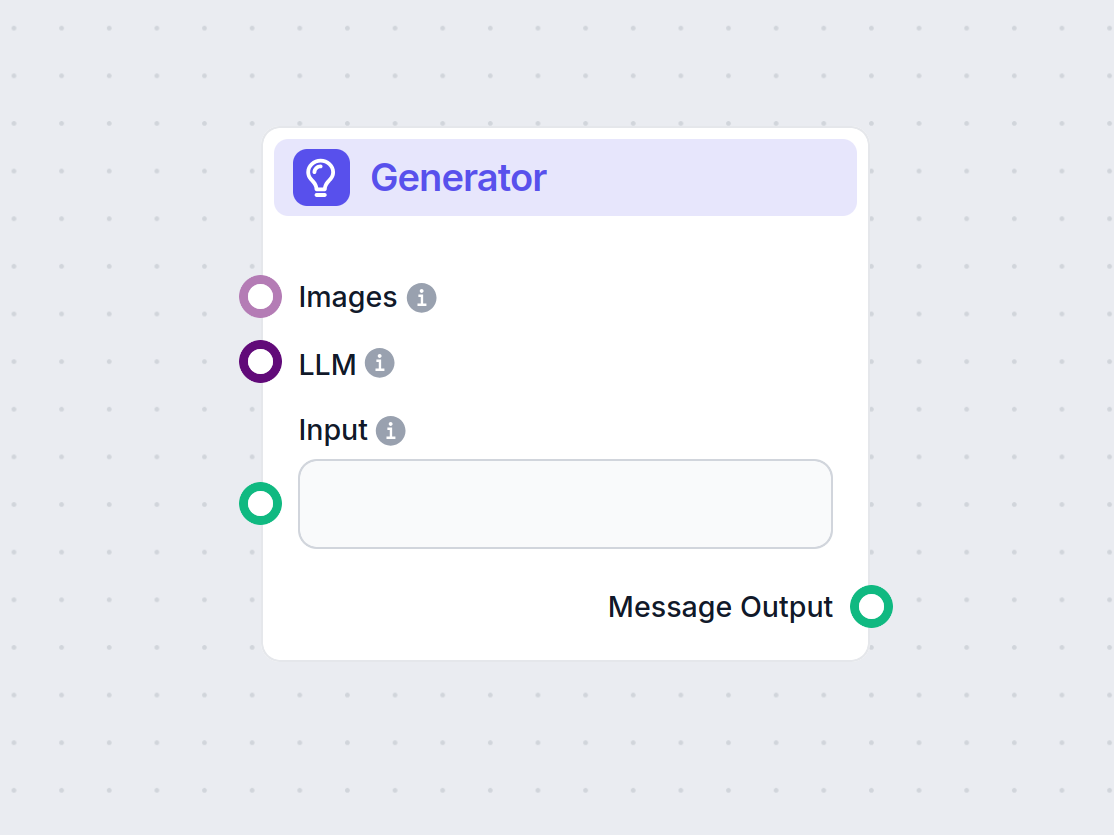

This component’s output is text that can be connected to various components. Most of the time, you immediately follow up with the Generator component to connect the prompt to an LLM.

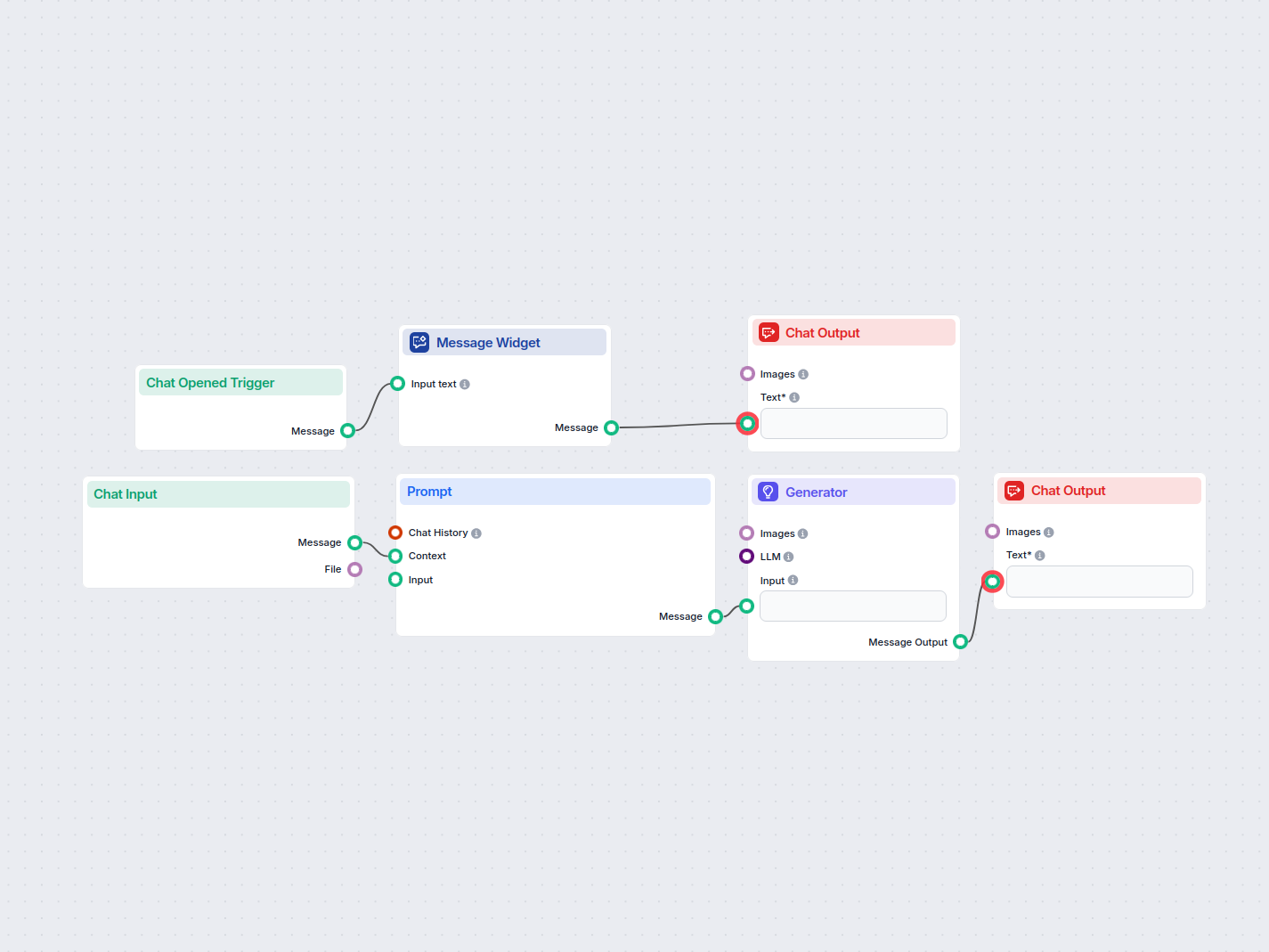

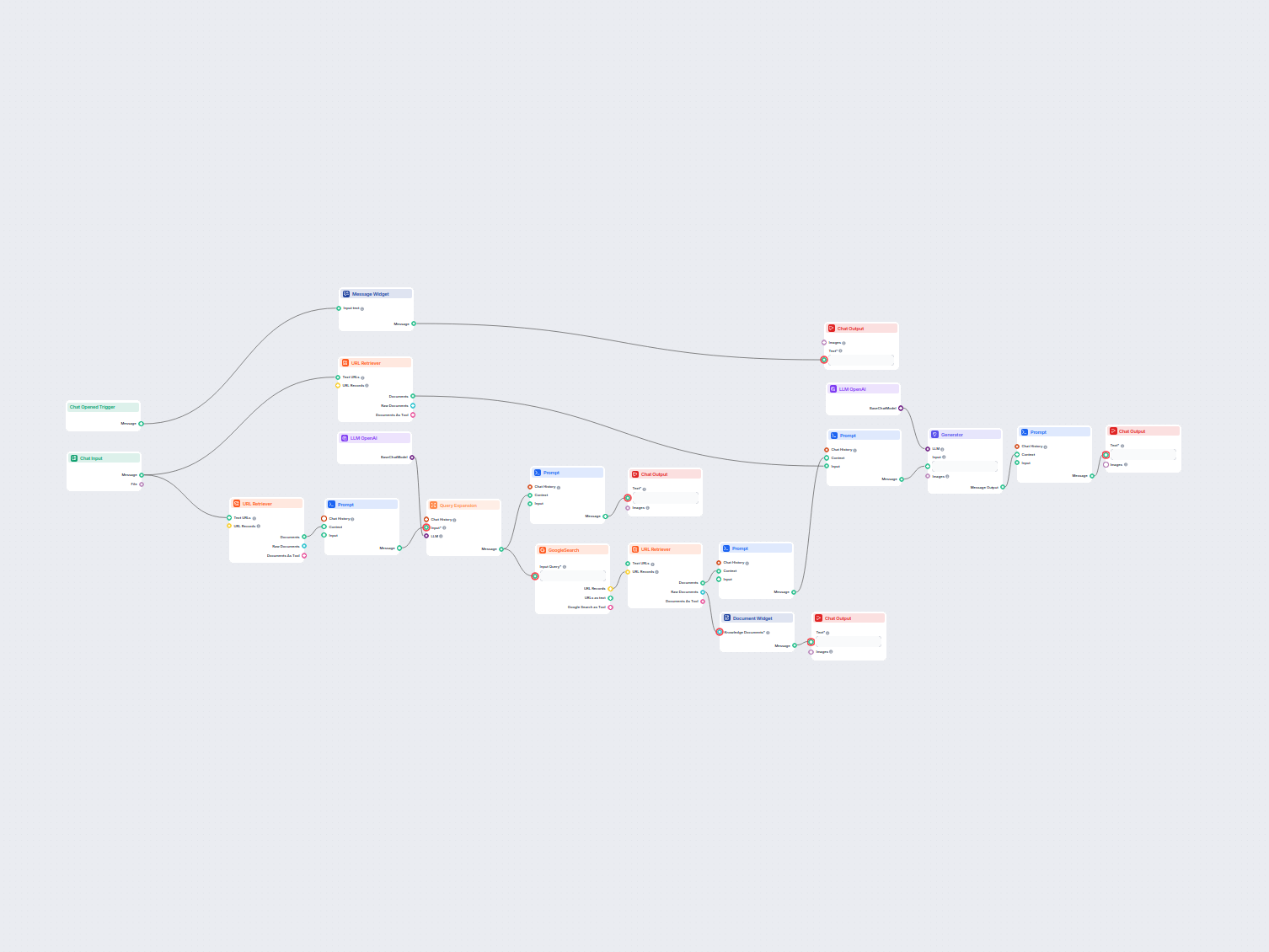

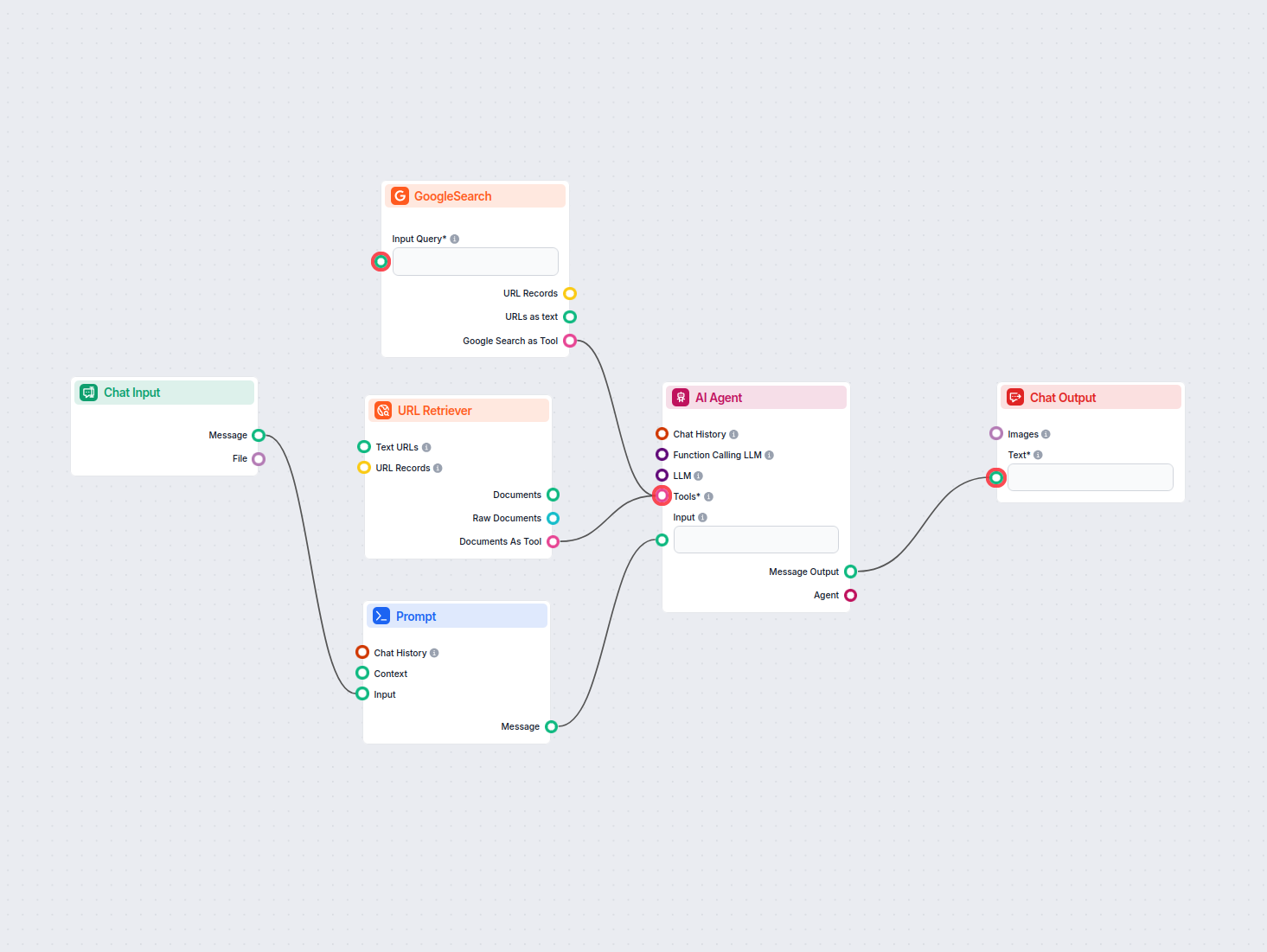

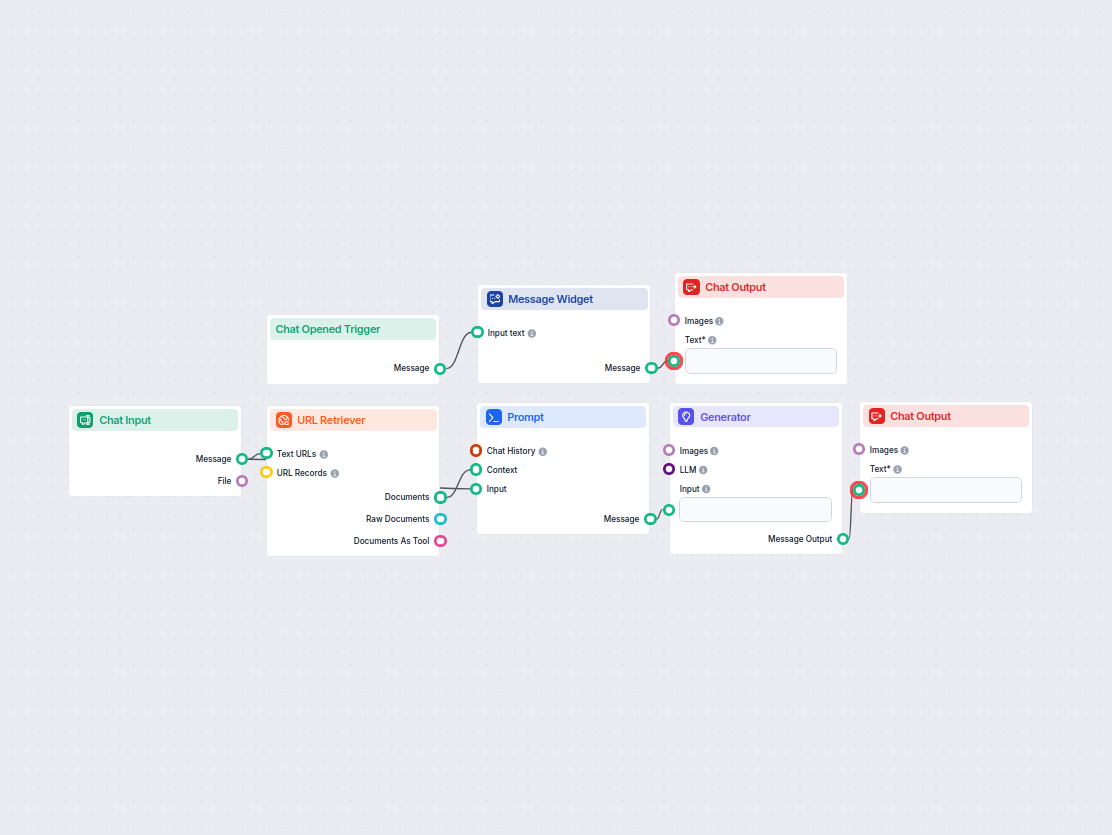

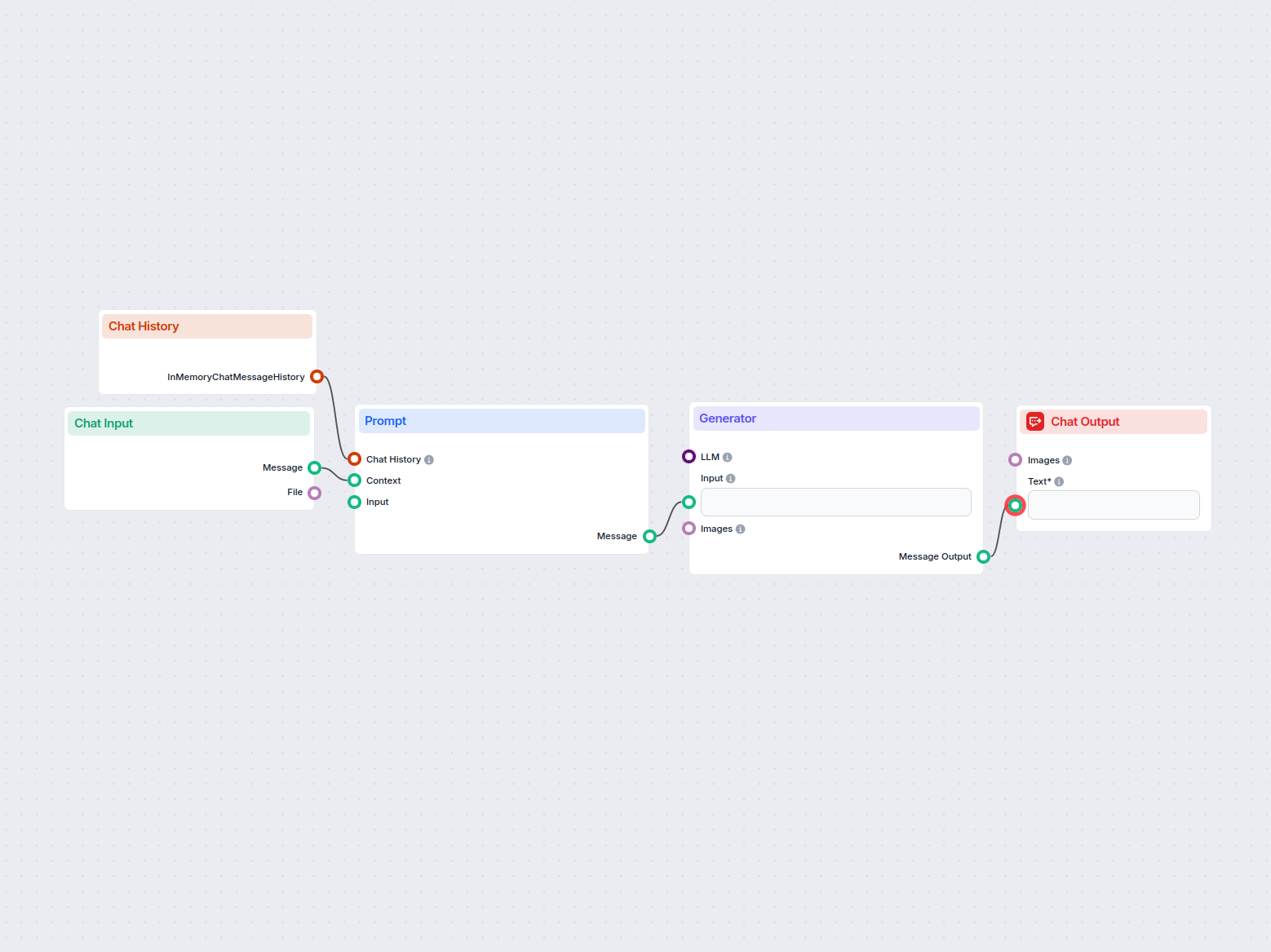

Let’s create a very simple bot. We’ll expand on the medieval knight bot example from earlier. While it talks funny, its main mission is to be a helpful customer service bot, and we want it to provide relevant information.

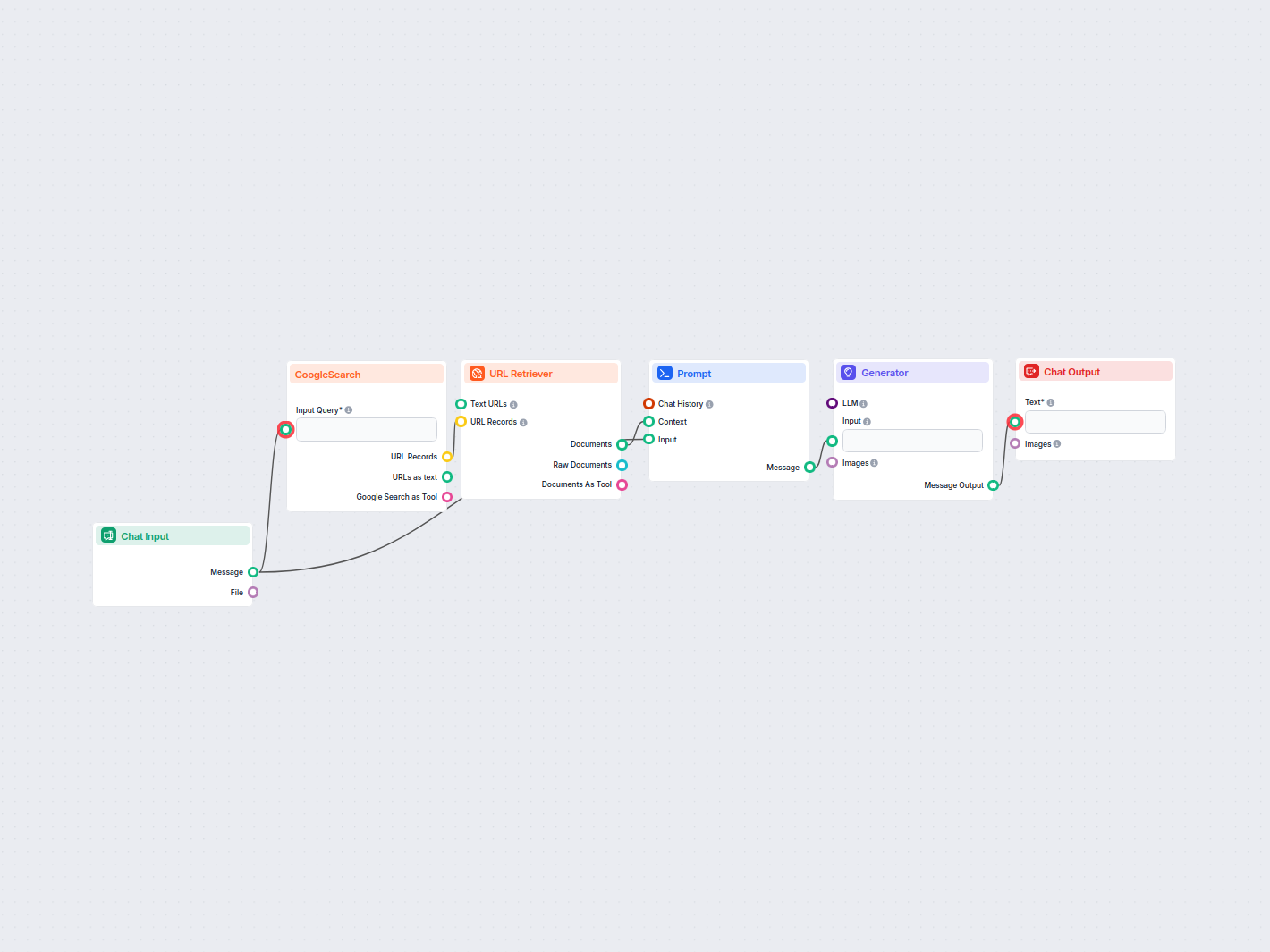

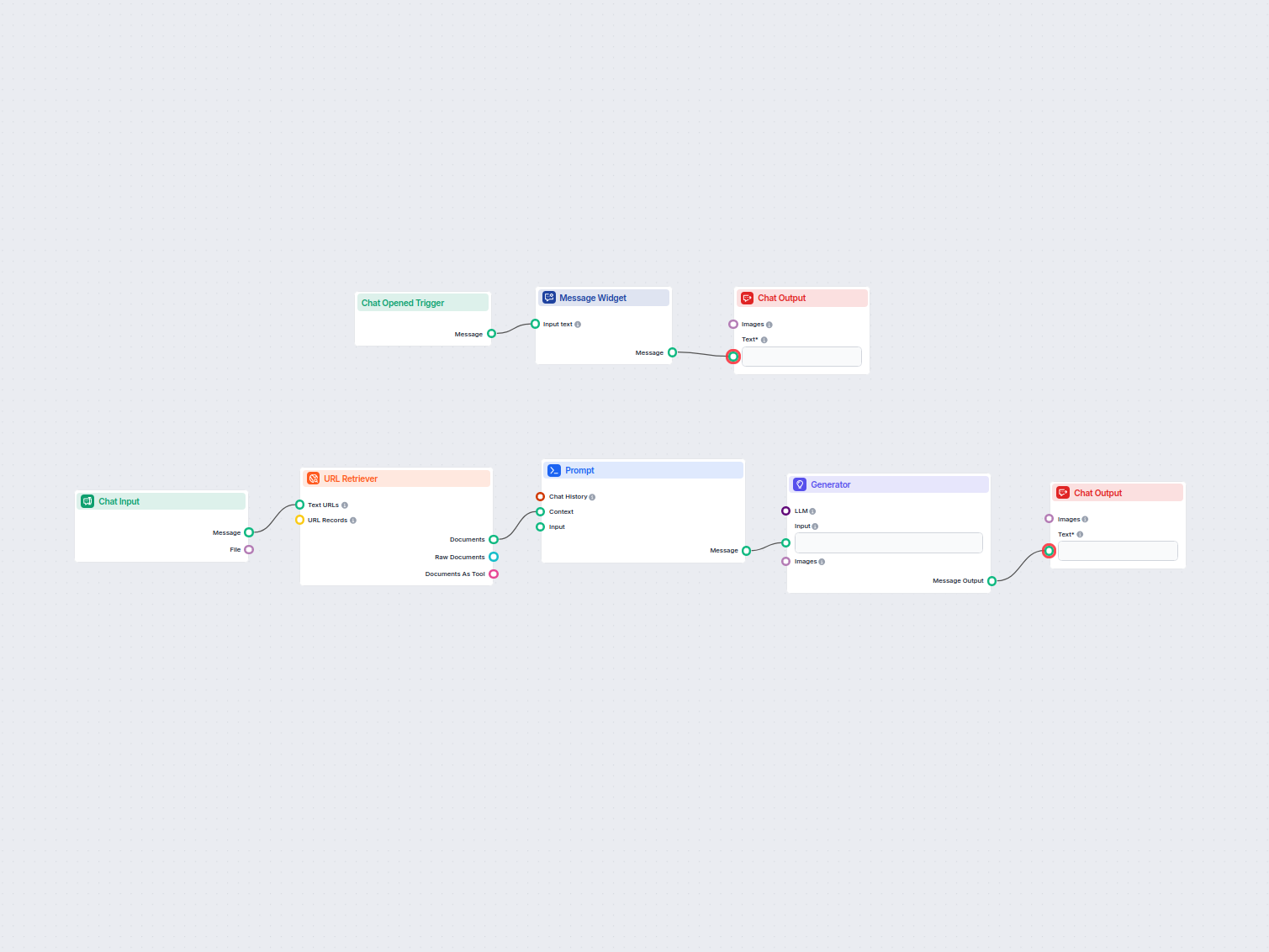

Let’s ask our bot a typical customer service question. We’ll ask about the pricing of URLsLab. To get a successful answer, we need to:

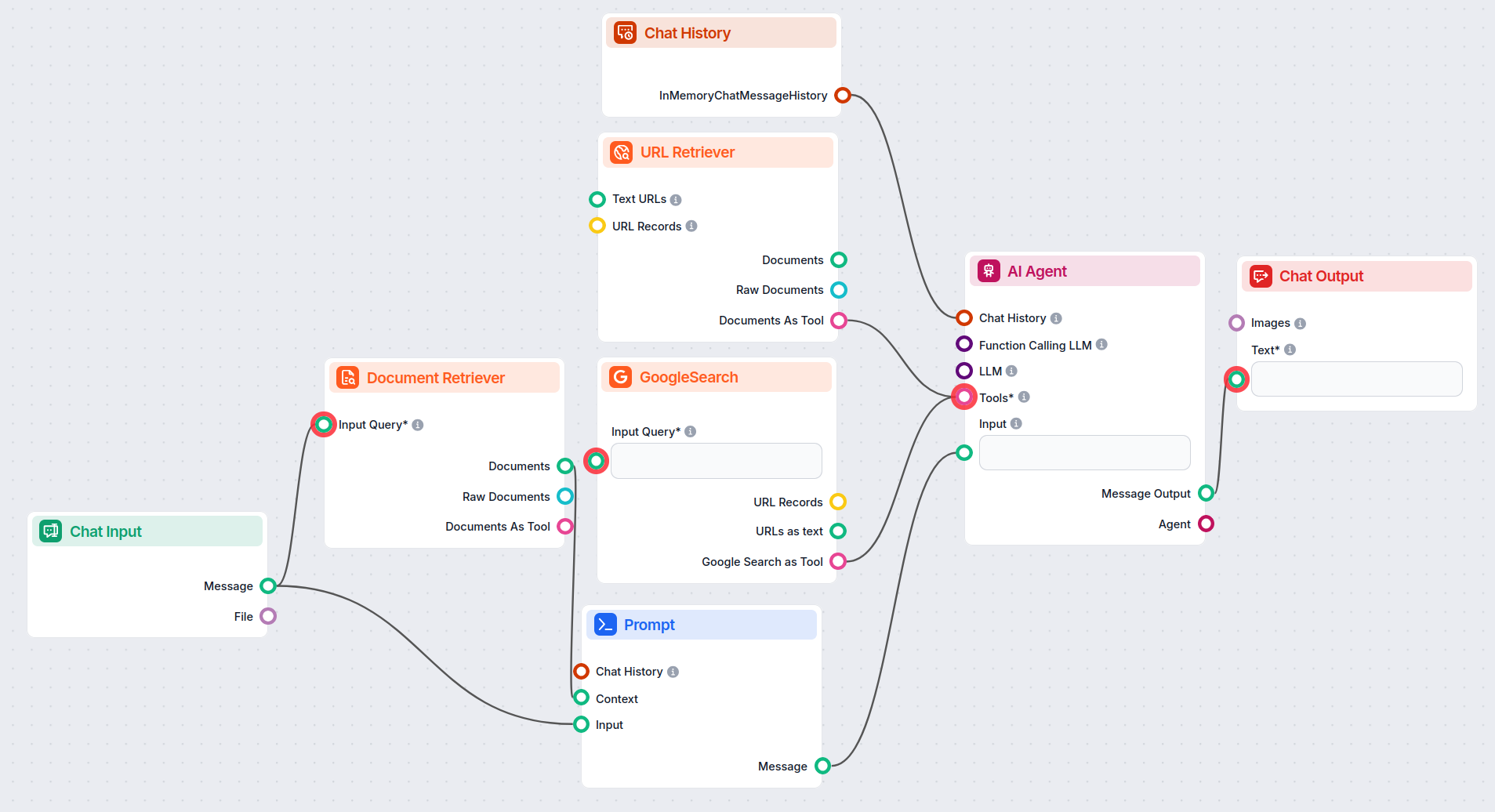

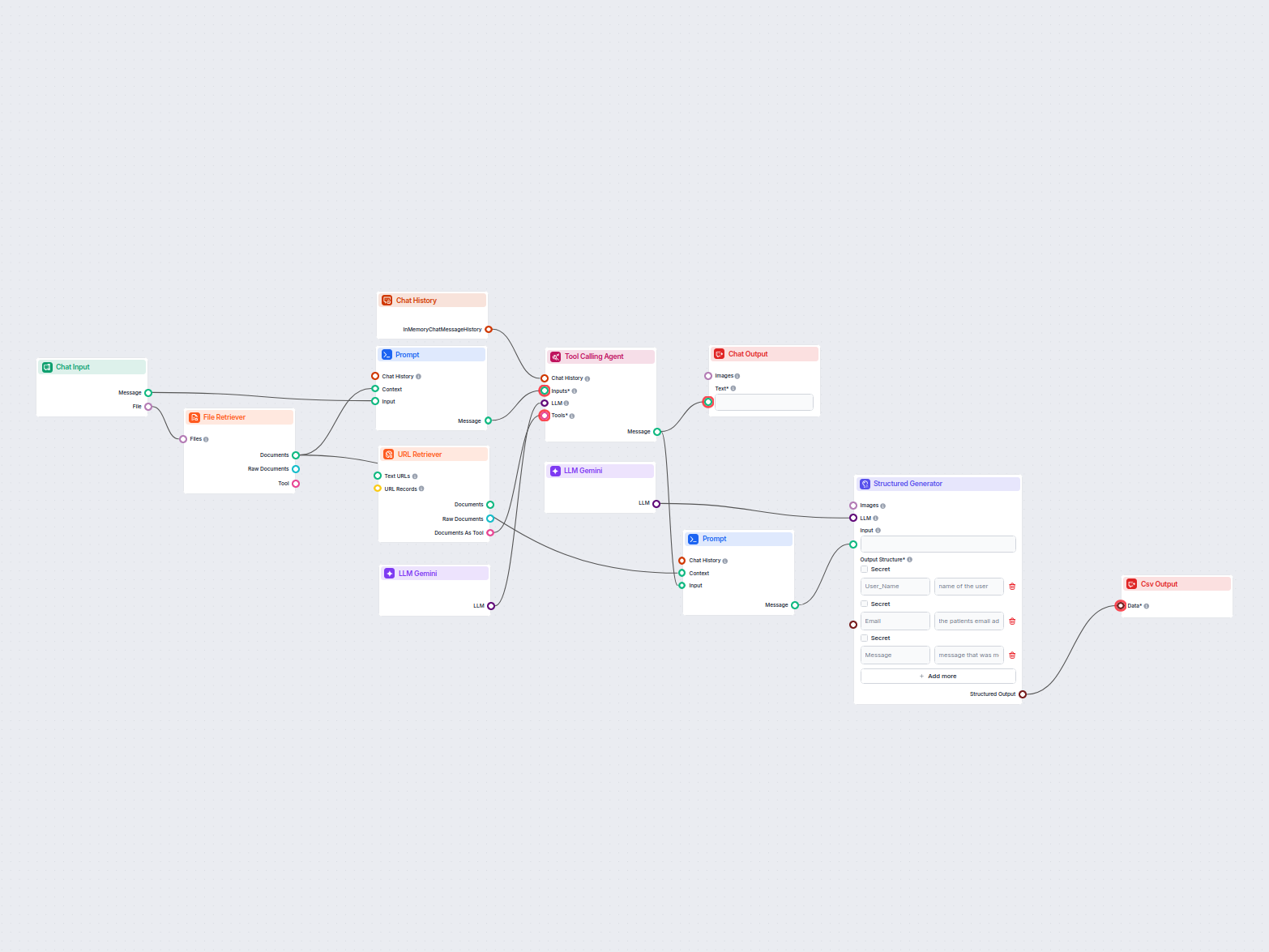

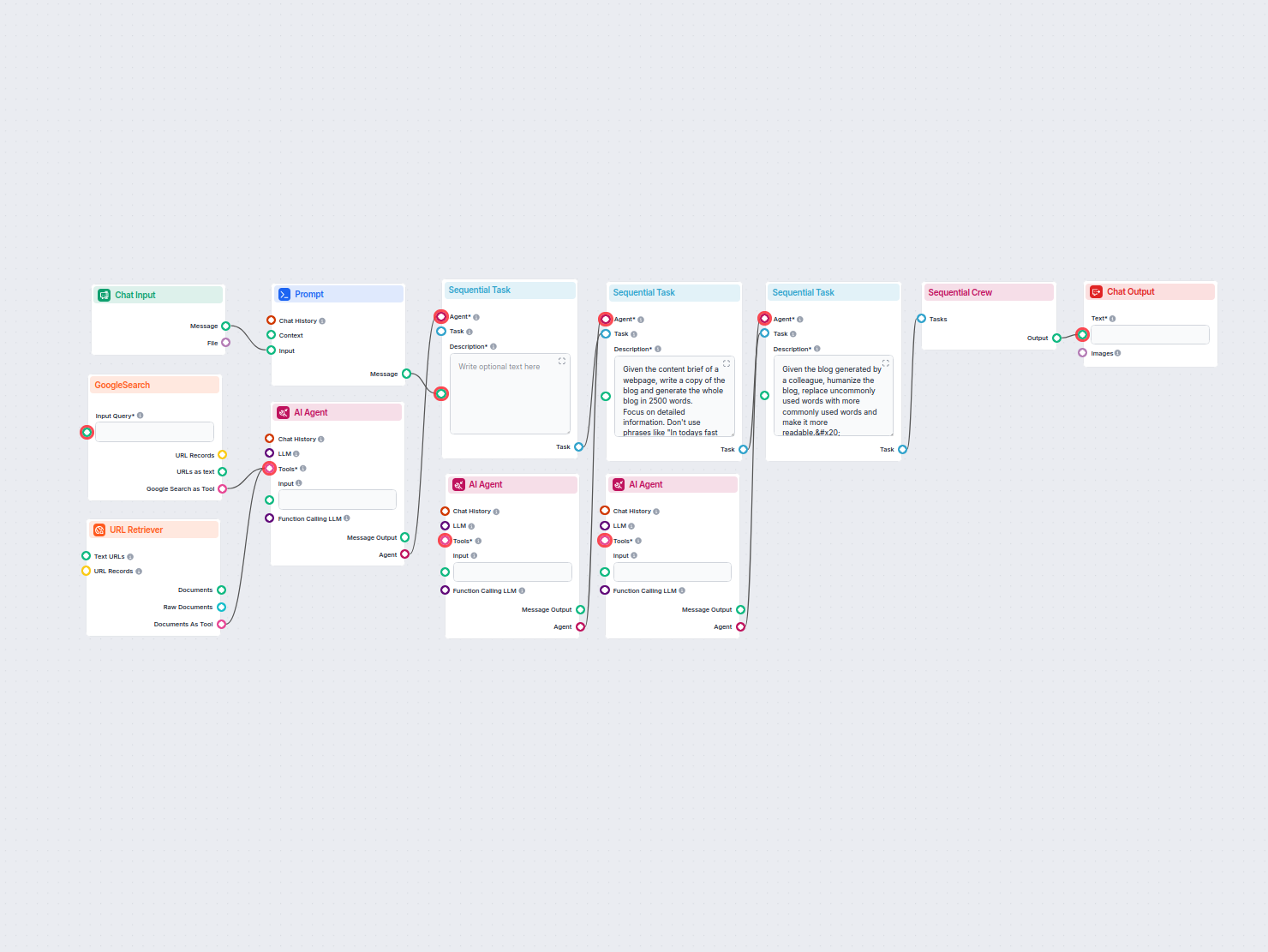

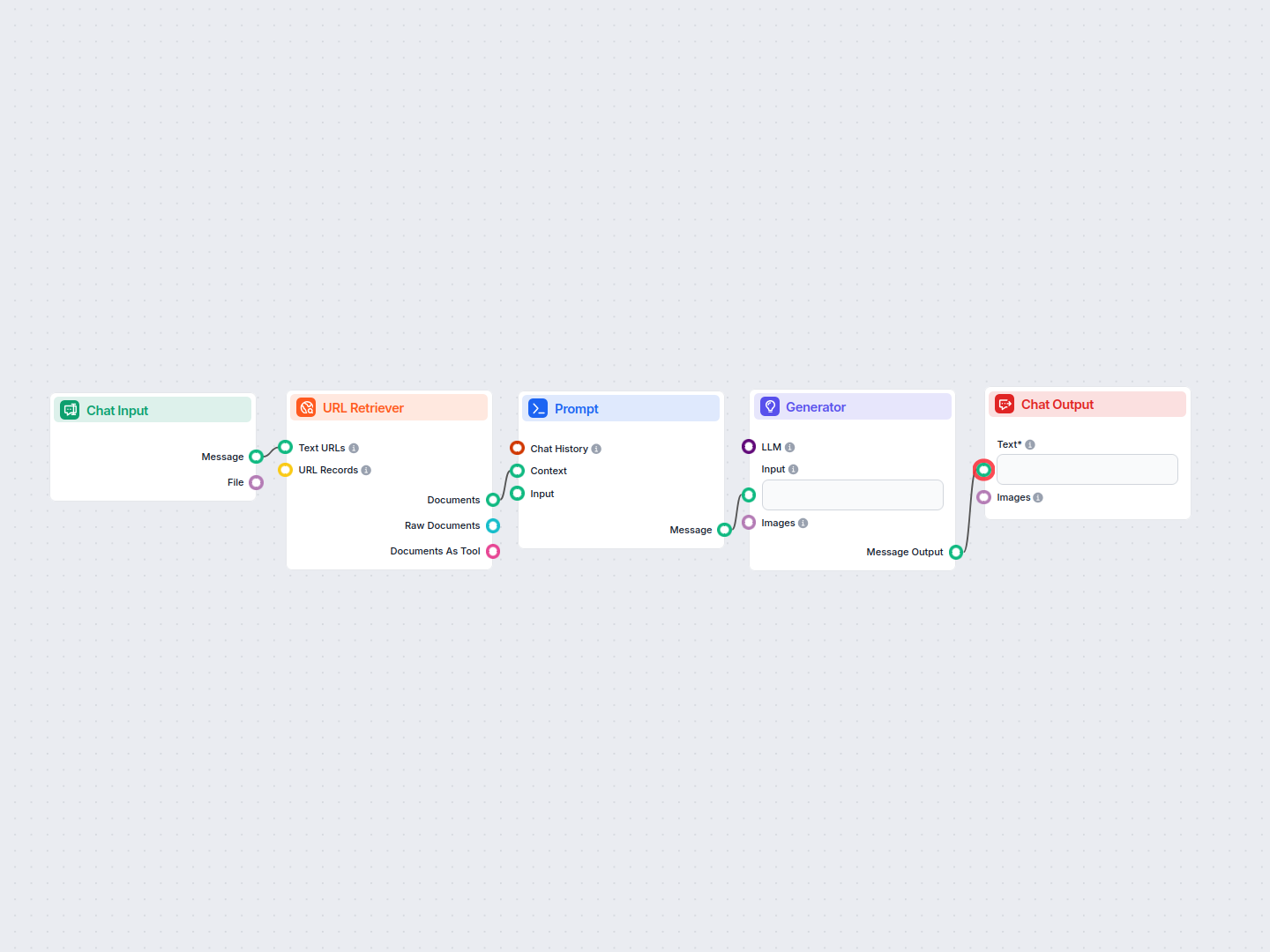

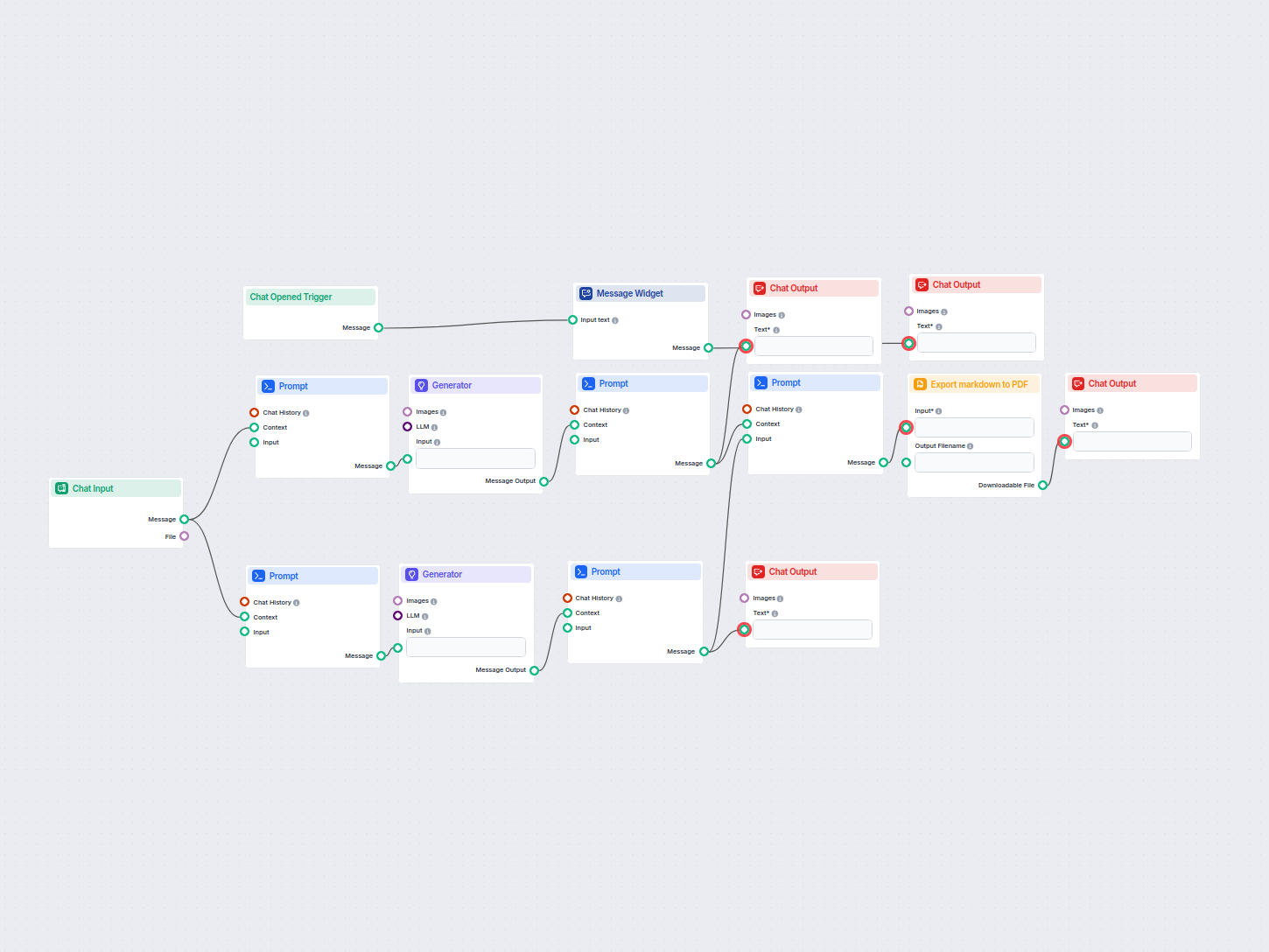

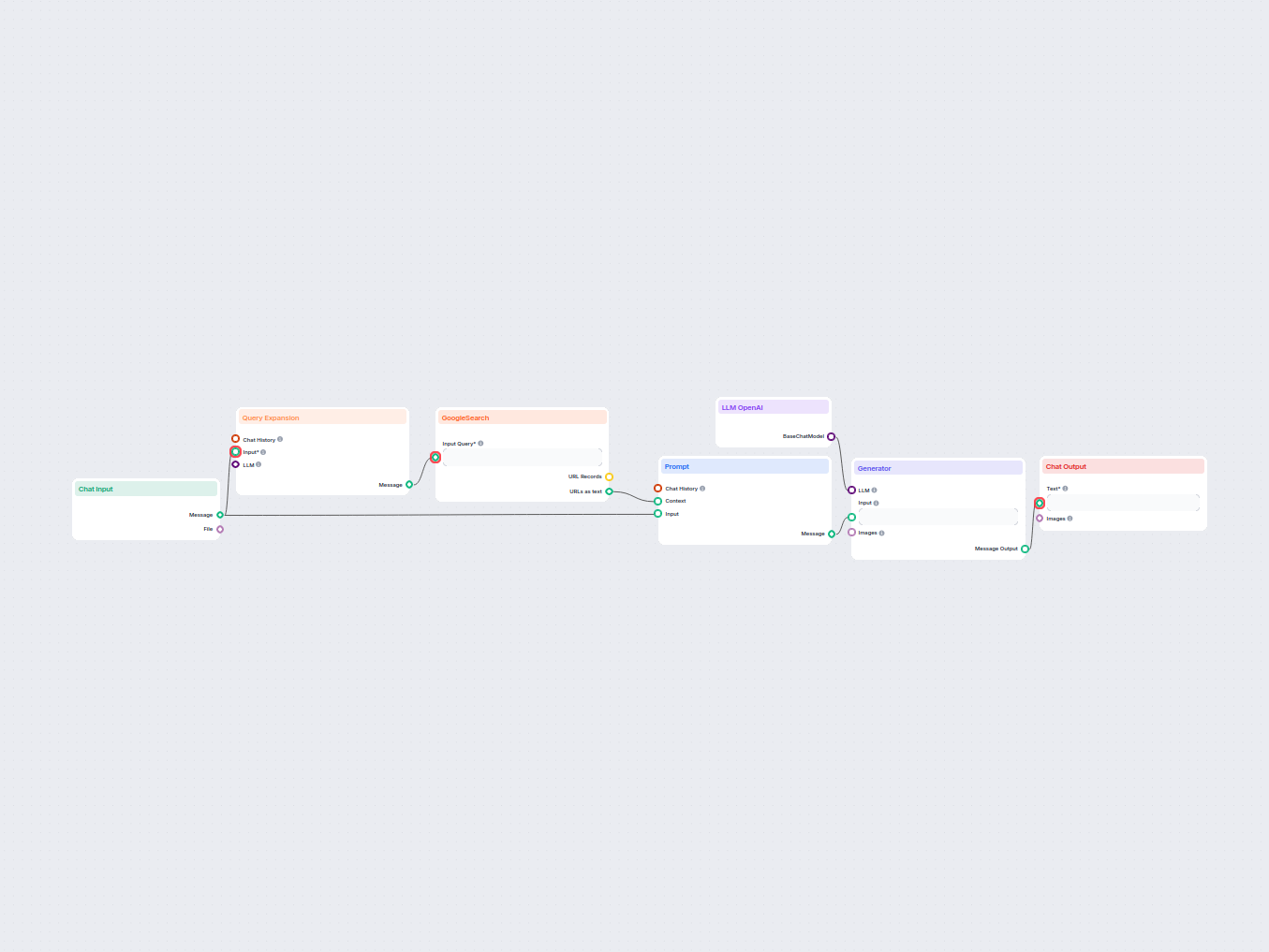

The resulting flow will look something like this:

It’s time to test the knowledge of our medieval knight bot. The URL we gave it is the pricing for URLsLab. So let’s ask about it:

Our bot now uses pompous old-timey language to answer basic queries. But more importantly, notice how the bot adheres to its central role as a helpful customer service bot. Lastly, it successfully uses the information from the specified URL.

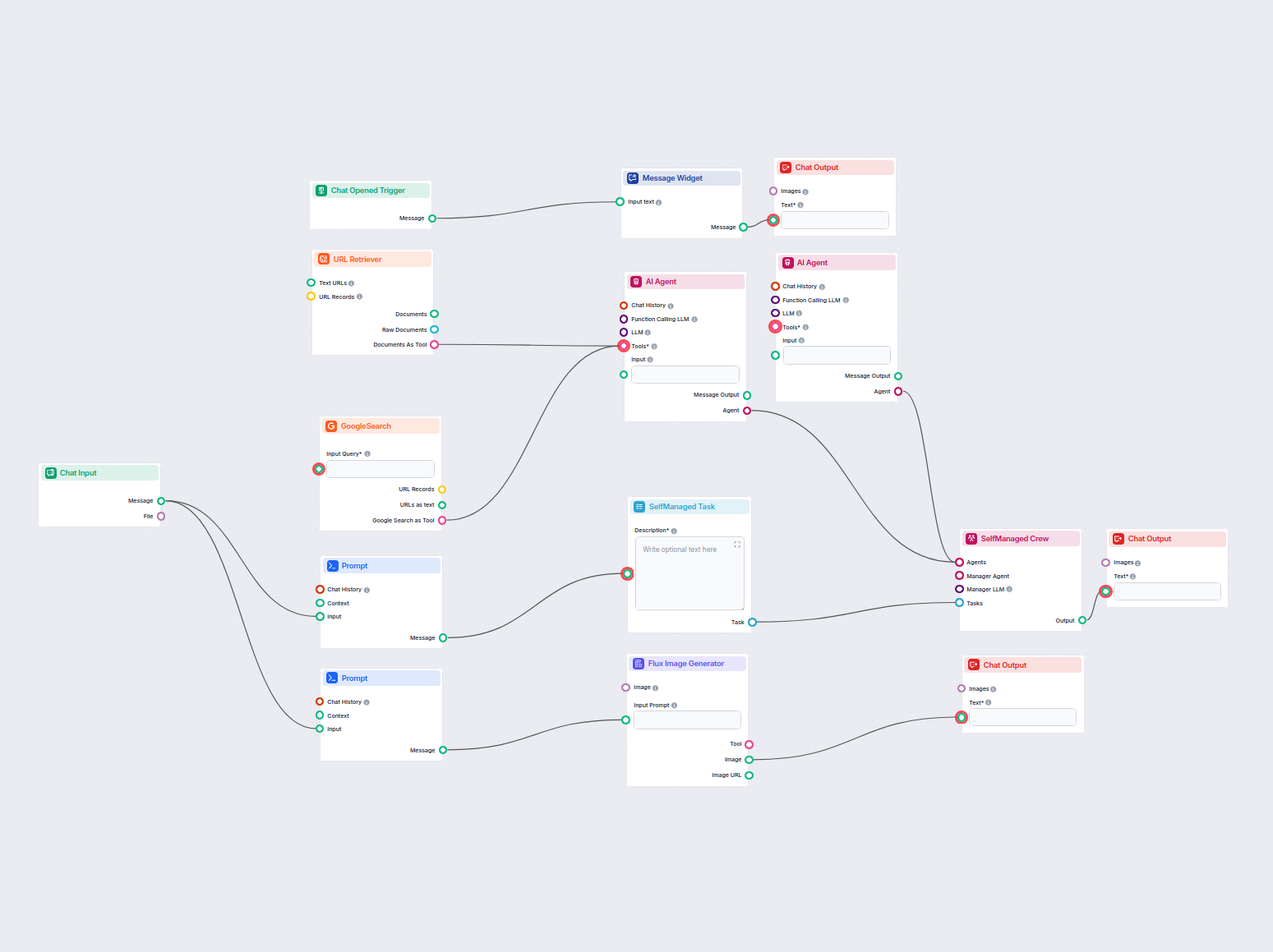

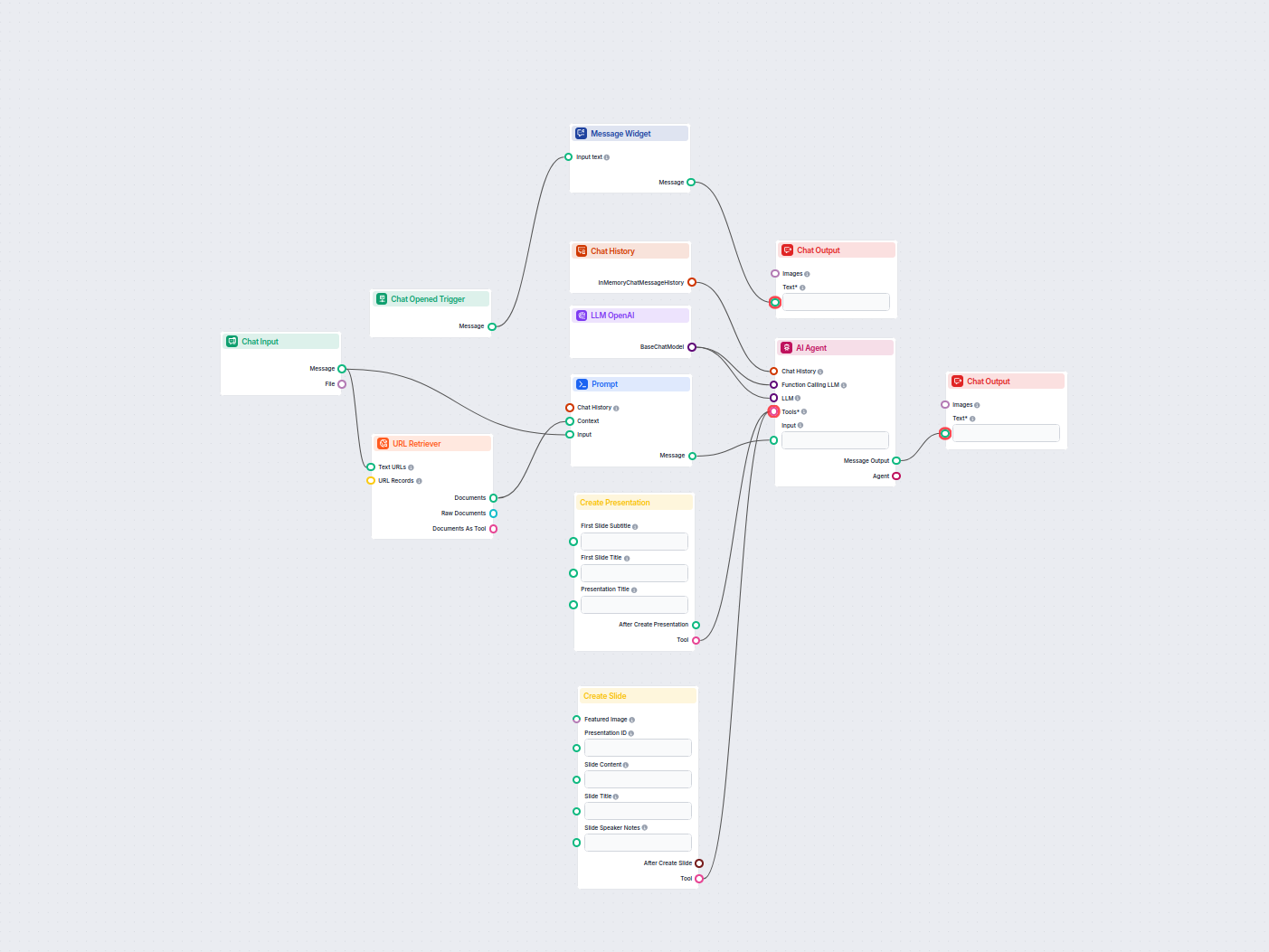

Aby pomóc Ci szybko zacząć, przygotowaliśmy kilka przykładowych szablonów przepływu, które pokazują, jak efektywnie używać komponentu Komponent Prompt w FlowHunt. Te szablony prezentują różne przypadki użycia i najlepsze praktyki, ułatwiając zrozumienie i implementację komponentu w Twoich własnych projektach.

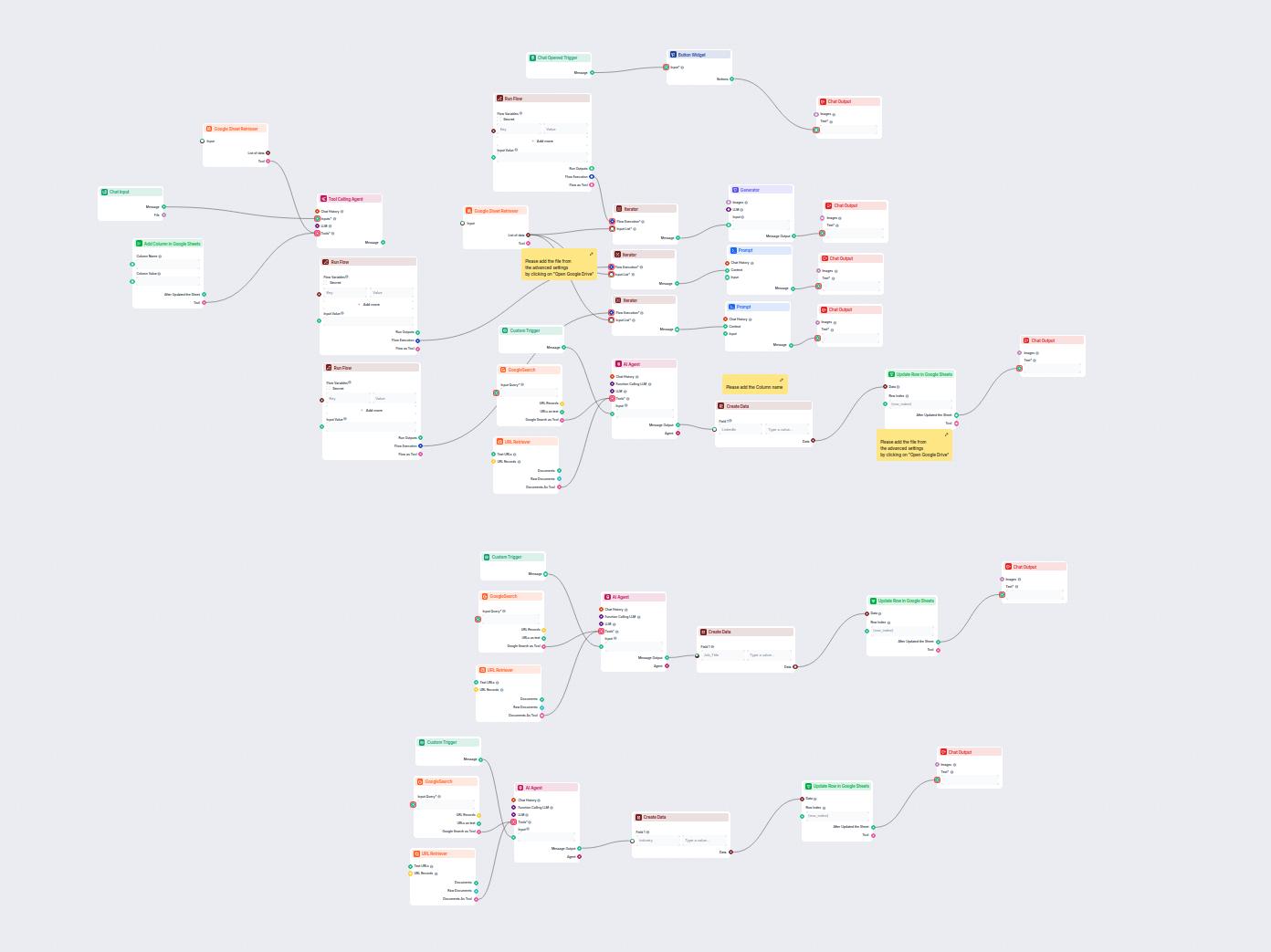

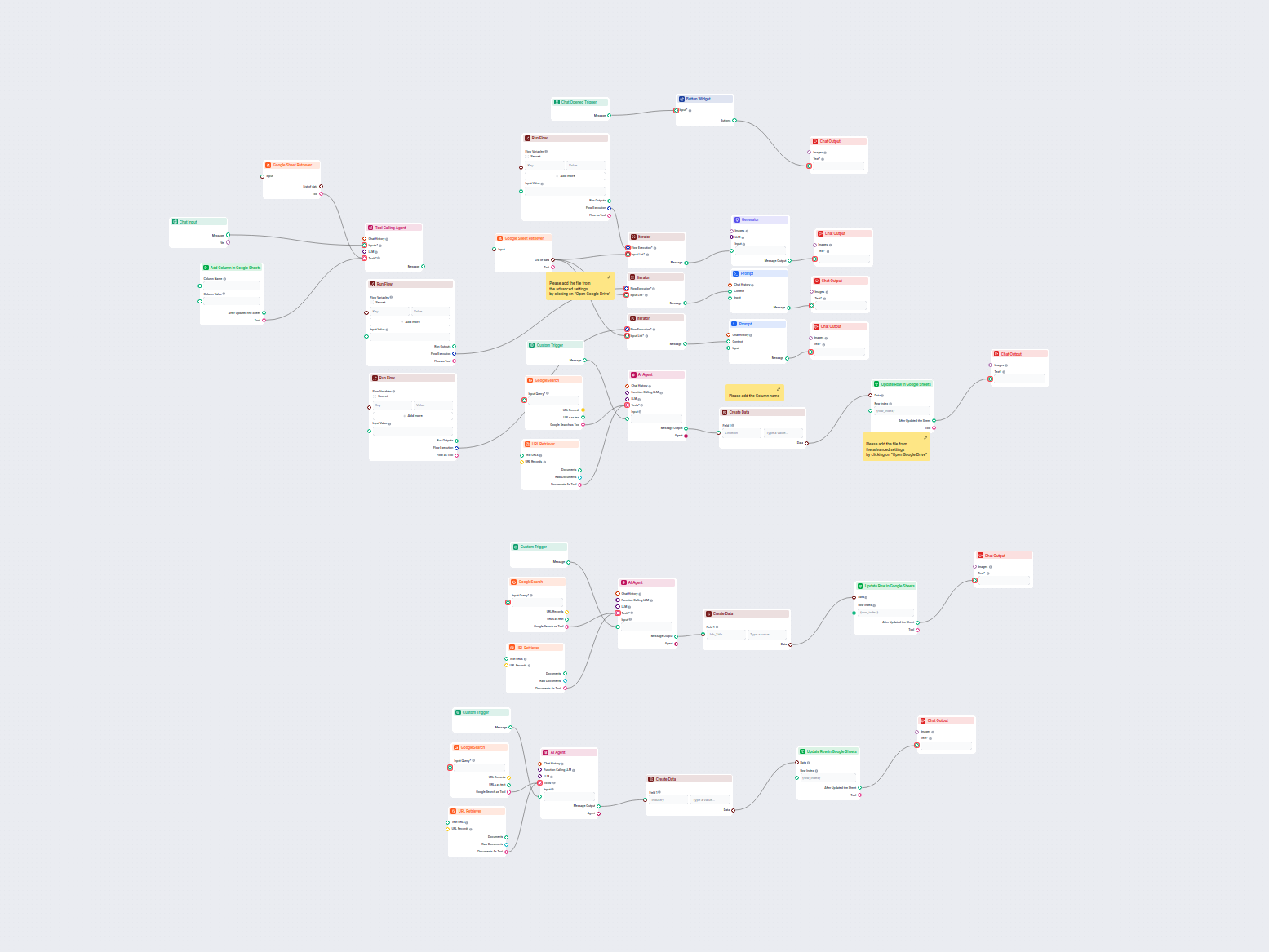

Ten workflow automatyzuje obsługę klienta w Twojej firmie poprzez integrację rozmów z LiveAgent, wydobywanie istotnych danych z konwersacji, generowanie odpowie...

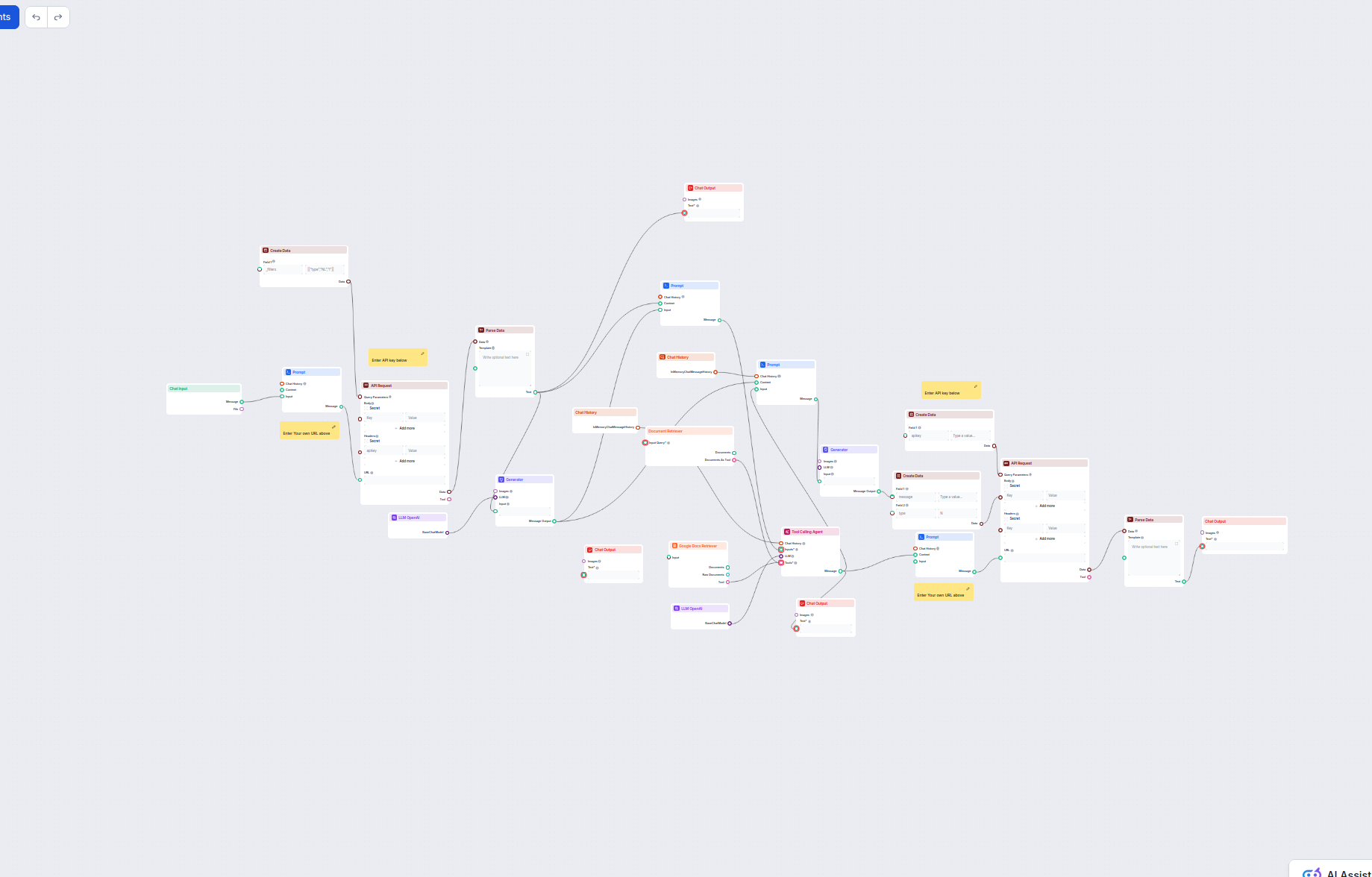

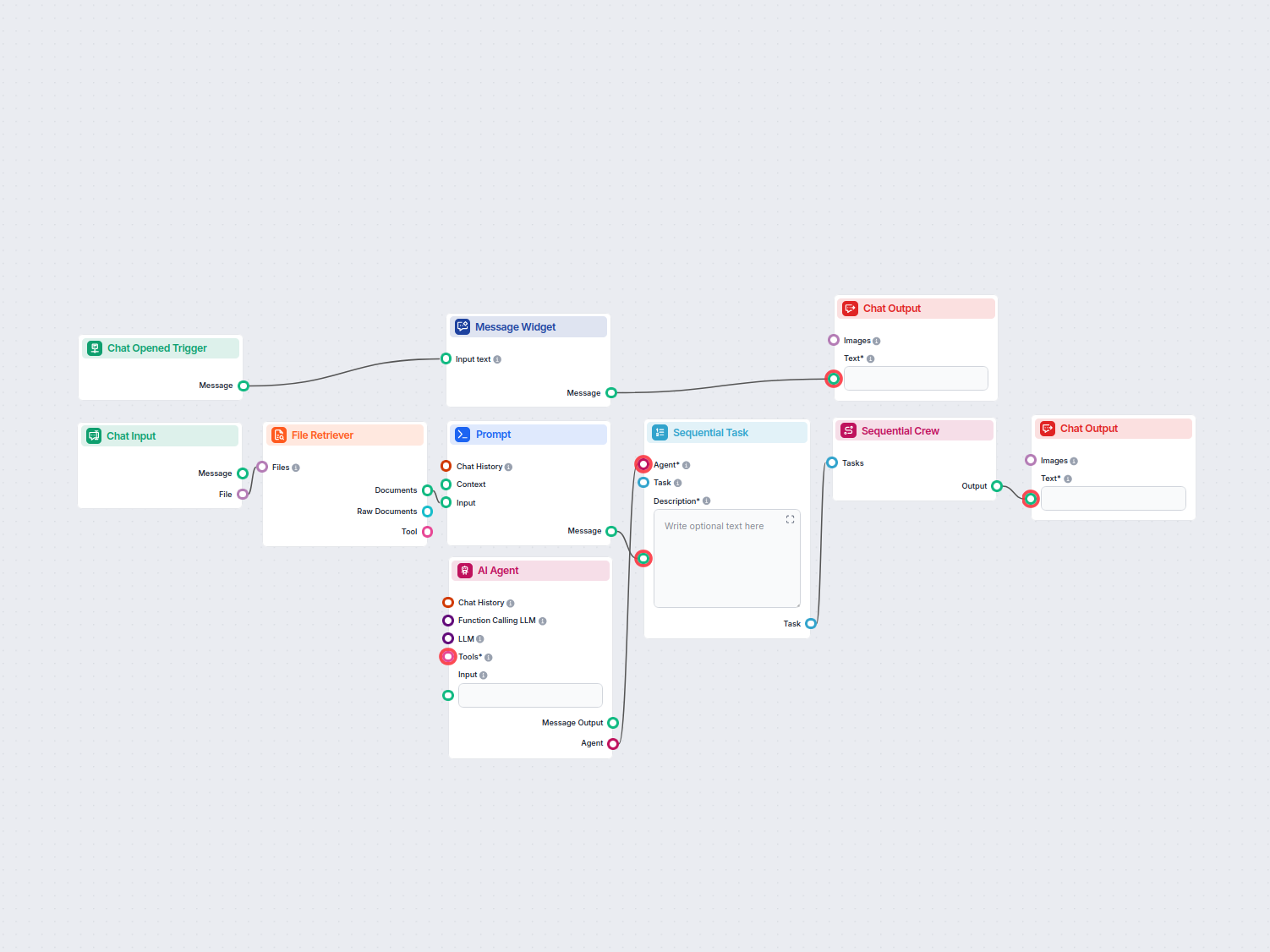

Ten oparty na AI workflow automatyzuje obsługę klienta poprzez łączenie wyszukiwania w wewnętrznej bazie wiedzy, pobierania informacji z Google Docs, integracji...

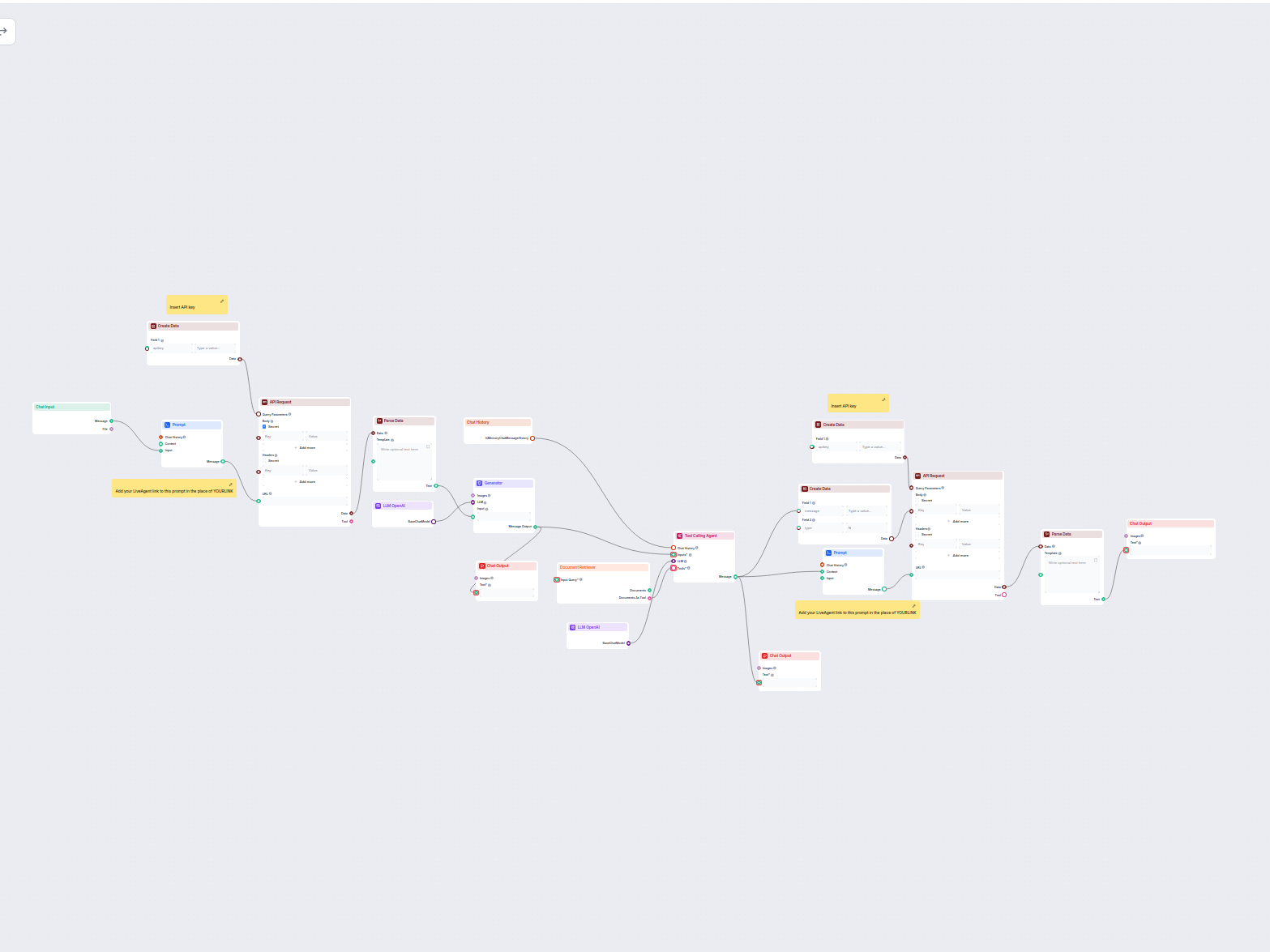

Ten zautomatyzowany przez AI workflow automatyzuje obsługę klienta poprzez łączenie zapytań użytkowników ze źródłami wiedzy firmy, zewnętrznymi API (takimi jak ...

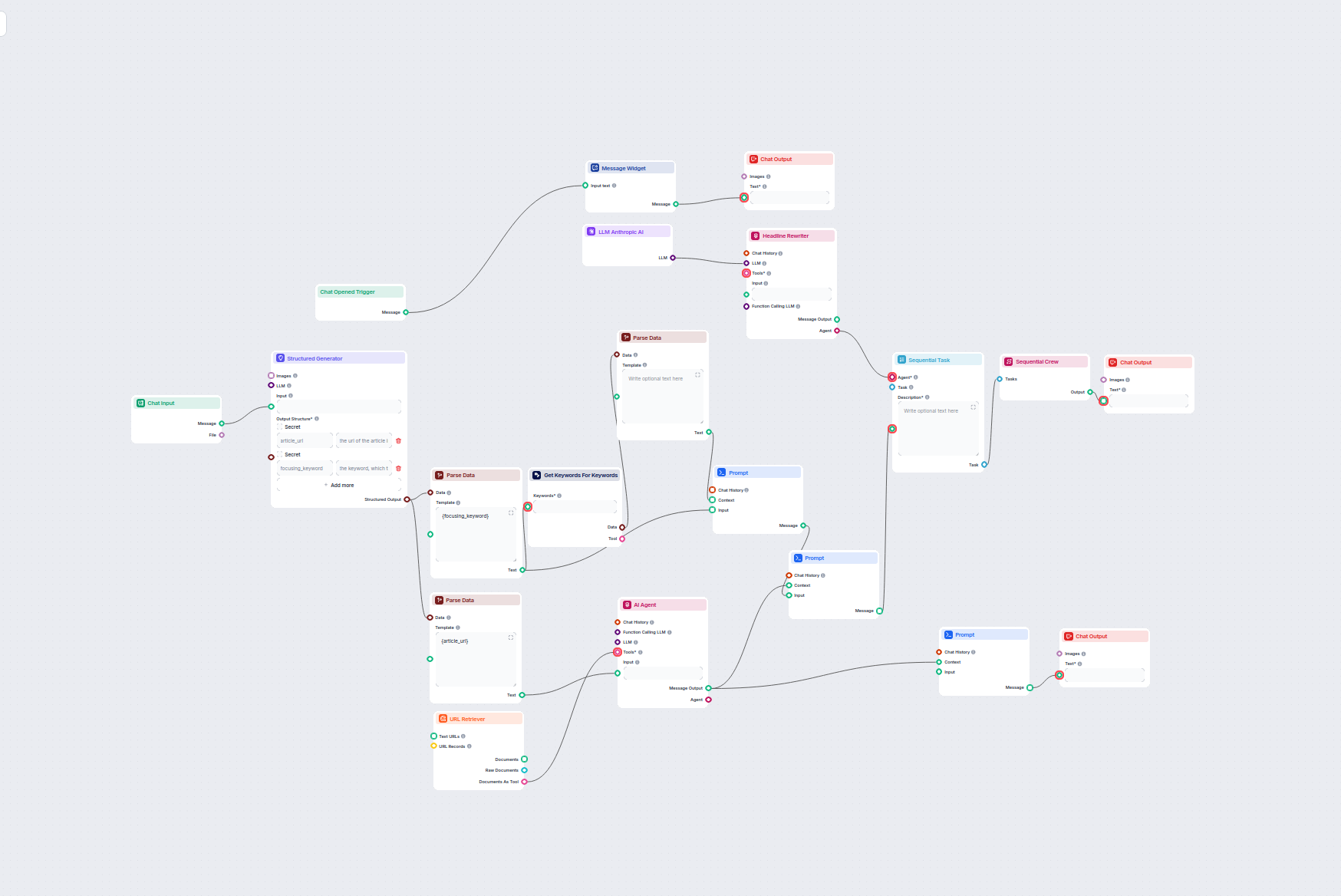

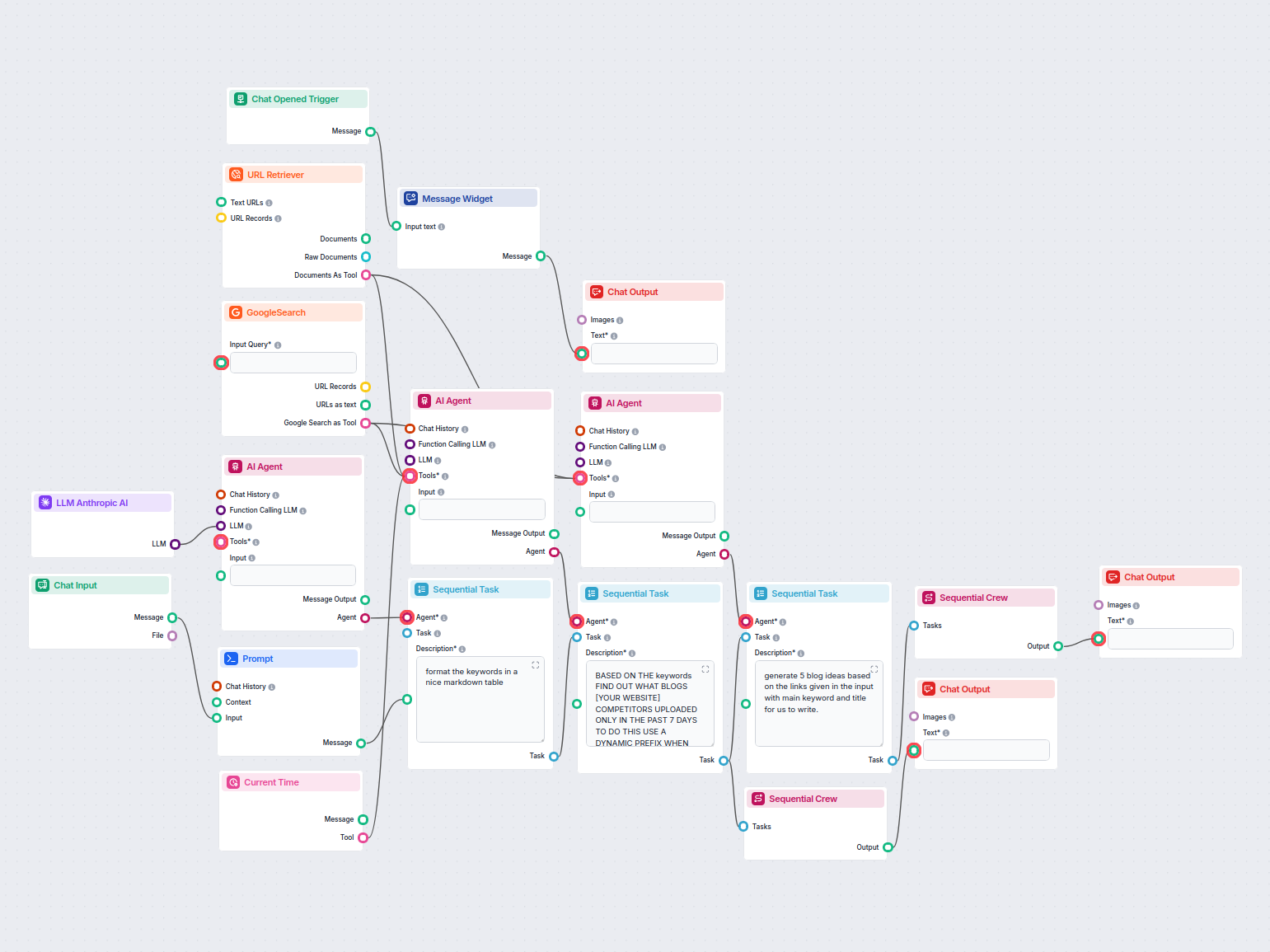

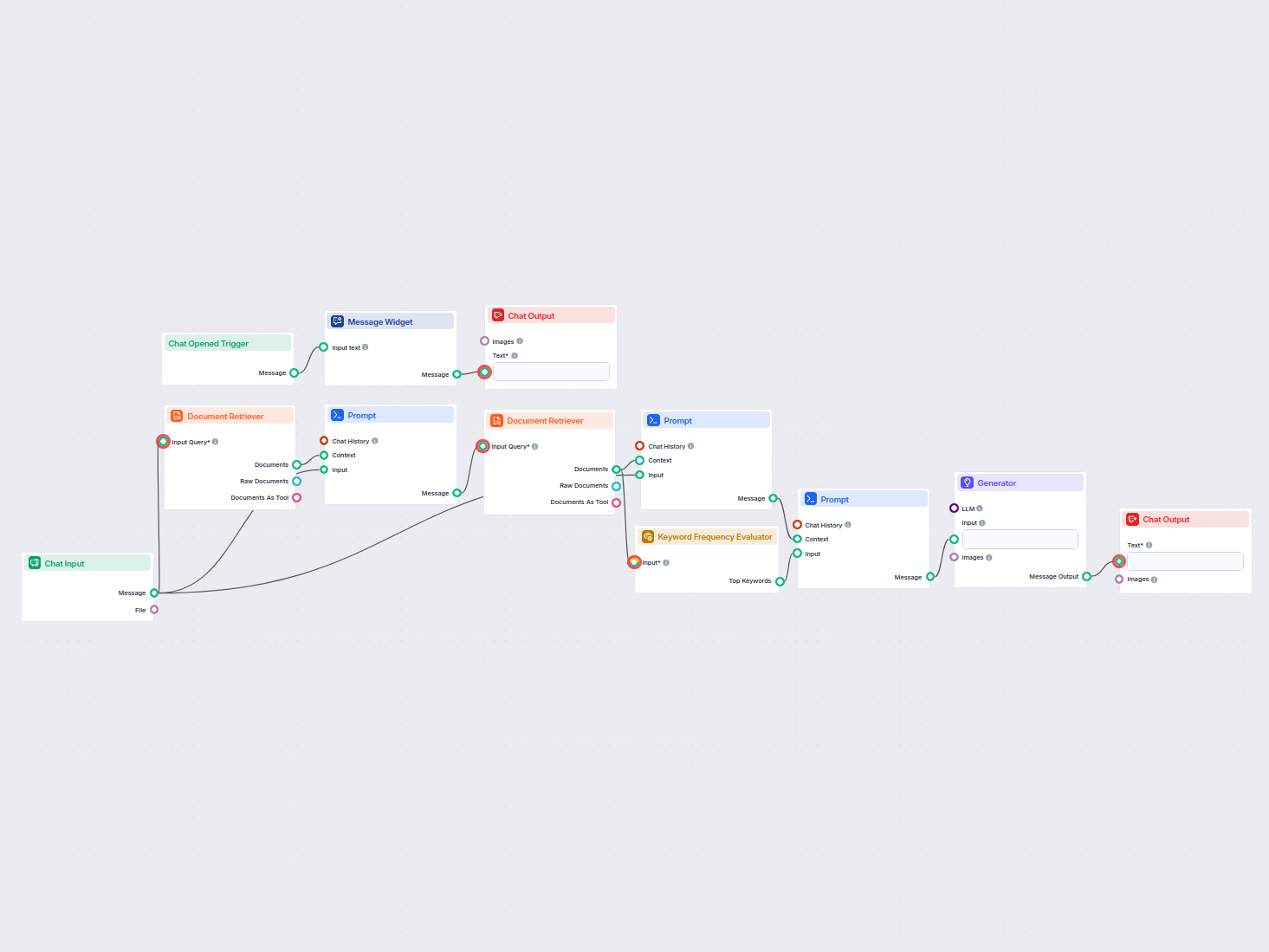

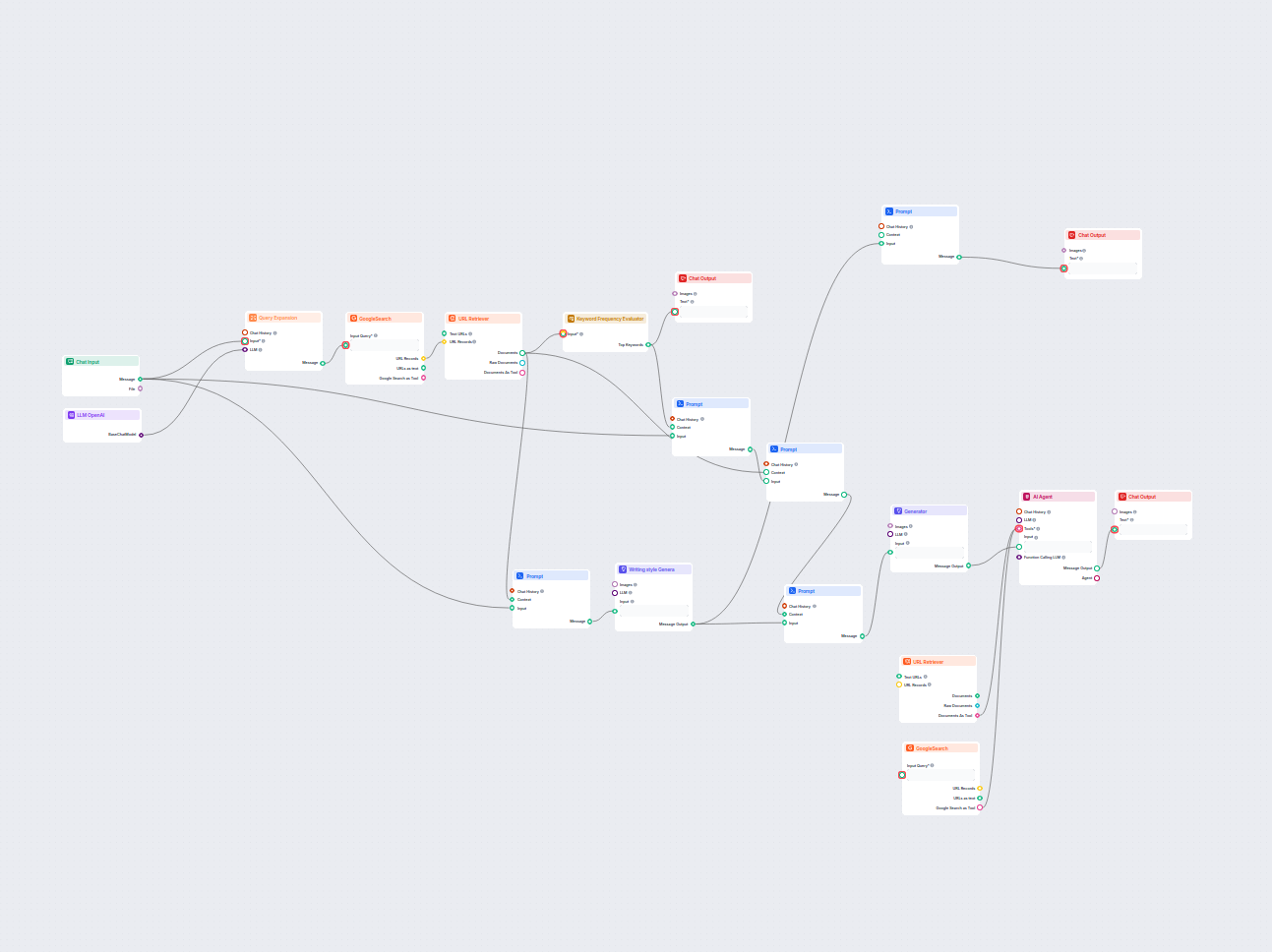

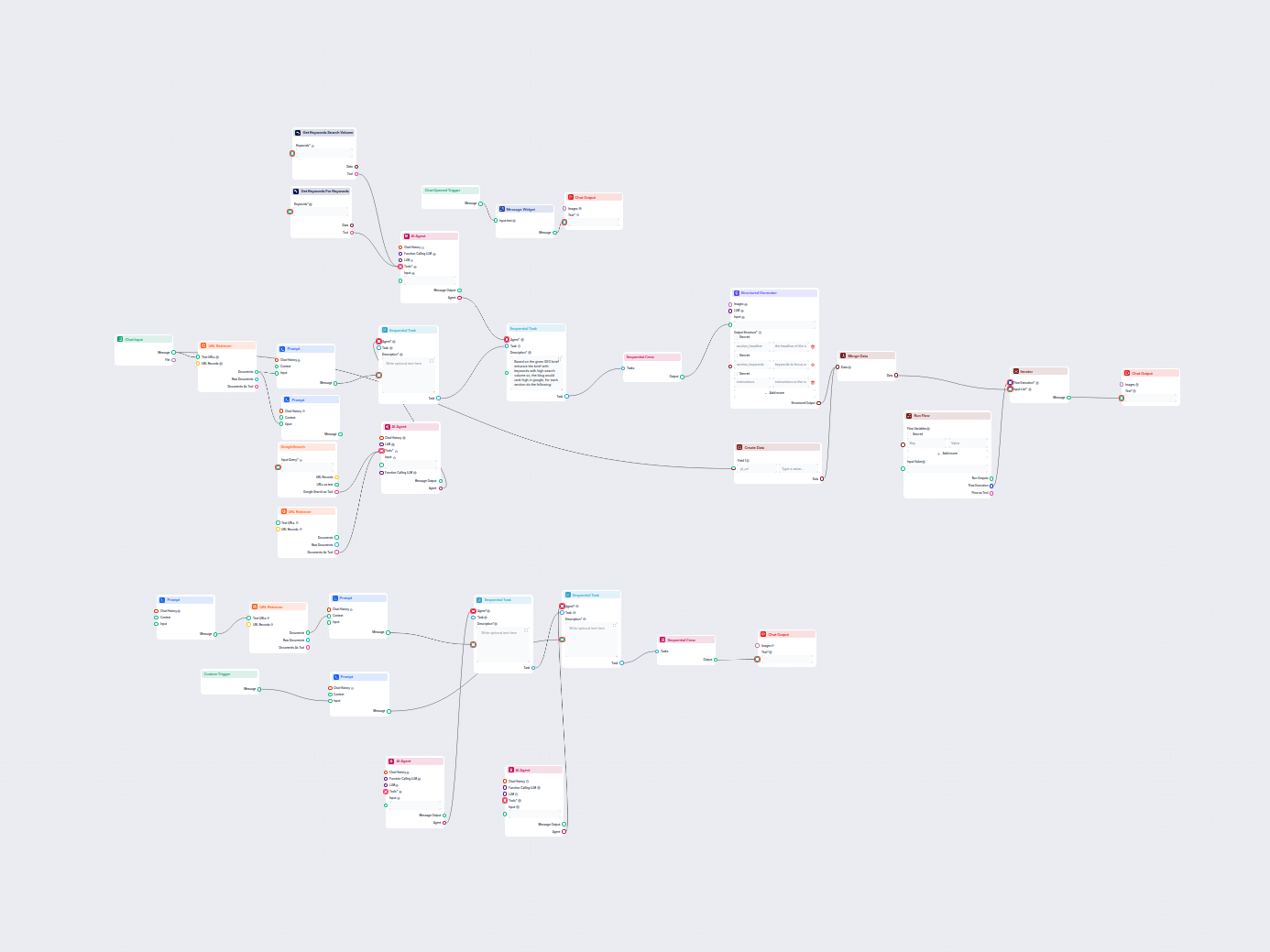

Ten workflow oparty na AI znajduje najlepsze słowa kluczowe SEO dla Twojego artykułu na blogu i automatycznie przepisuje nagłówki, aby kierować je na te słowa k...

Czatujący bot obsługi klienta zasilany AI, który wykorzystuje Twoje wewnętrzne źródła wiedzy, aby zapewnić natychmiastowe, dokładne i pomocne odpowiedzi na zapy...

Łatwo podsumuj dowolny tekst wejściowy do zwięzłych kluczowych punktów przy użyciu AI. Ten workflow przyjmuje tekst od użytkownika, generuje krótkie podsumowani...

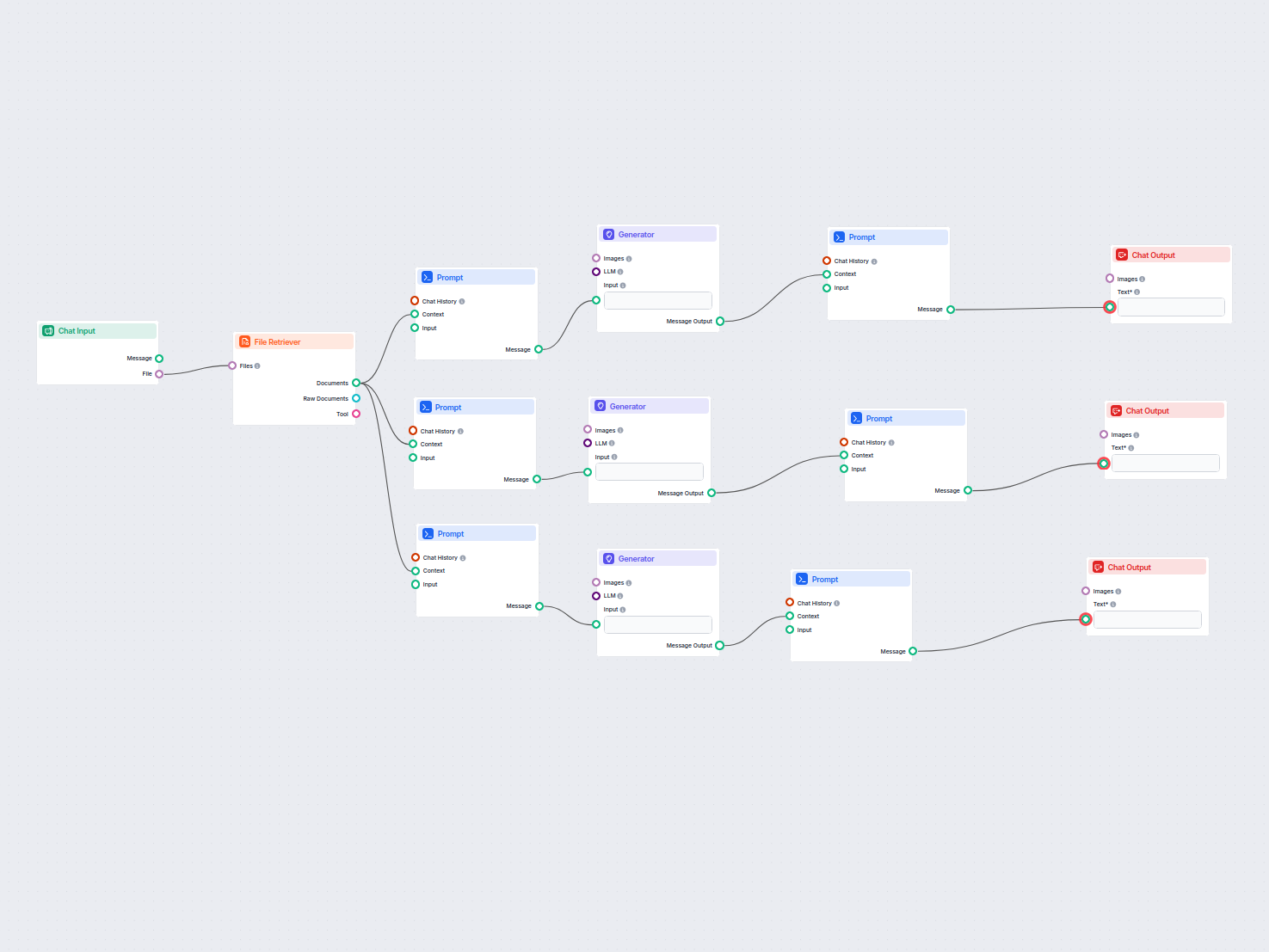

Przekształć załączniki ze spotkań w praktyczne podsumowania, maile follow-up oraz wpisy na bloga dzięki AI. Ten workflow automatyzuje tworzenie treści z plików ...

Automatycznie porządkuje Twoją listę słów kluczowych w klastry tematyczne za pomocą AI, tworząc uporządkowaną i łatwą do analizy tabelę dla lepszej strategii tr...

Zautomatyzowany, oparty na AI przepływ pracy do pobierania, podsumowywania i prezentowania najlepszych historii z Hacker News, w tym szczegółów, adresów URL i n...

Ten workflow oparty na AI automatycznie rozwiązuje obrazkowe CAPTCHA przesyłane przez użytkowników. Prowadzi użytkownika poprzez instrukcje, przetwarza przesłan...

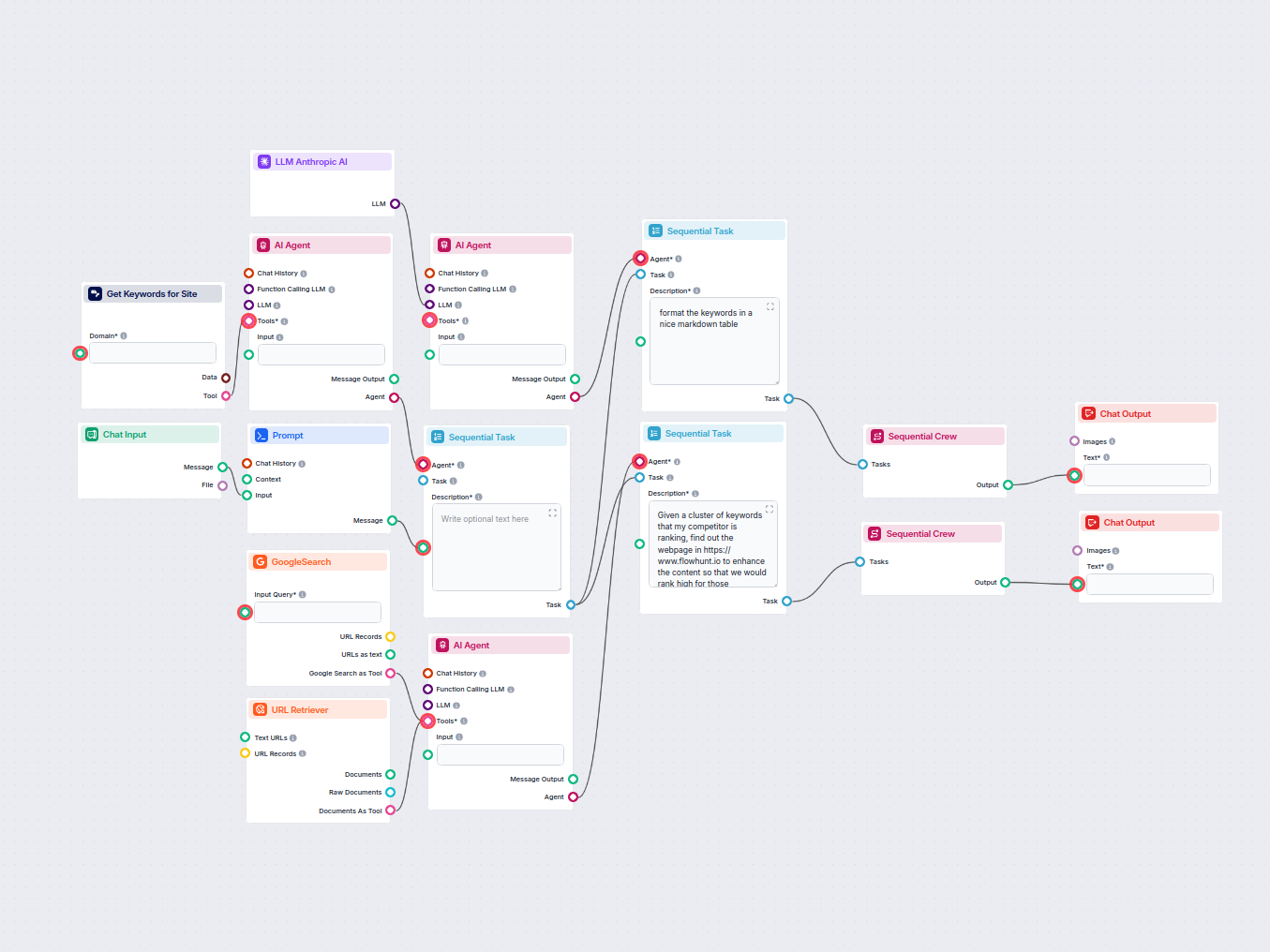

Automatycznie analizuj stronę główną konkurenta, aby odkryć jego najwyżej pozycjonowane słowa kluczowe, zbierz dane o słowach kluczowych z Google i otrzymaj pra...

Łatwo przepisuj dowolny tekst, zamieniając słowa na synonimy przy zachowaniu oryginalnego sensu. Idealne dla marketerów, copywriterów oraz wszystkich potrzebują...

Automatycznie analizuj najlepiej pozycjonowane blogi konkurencji z ostatniego tygodnia i generuj nowe pomysły na bloga dla swojej strony internetowej. Ten przep...

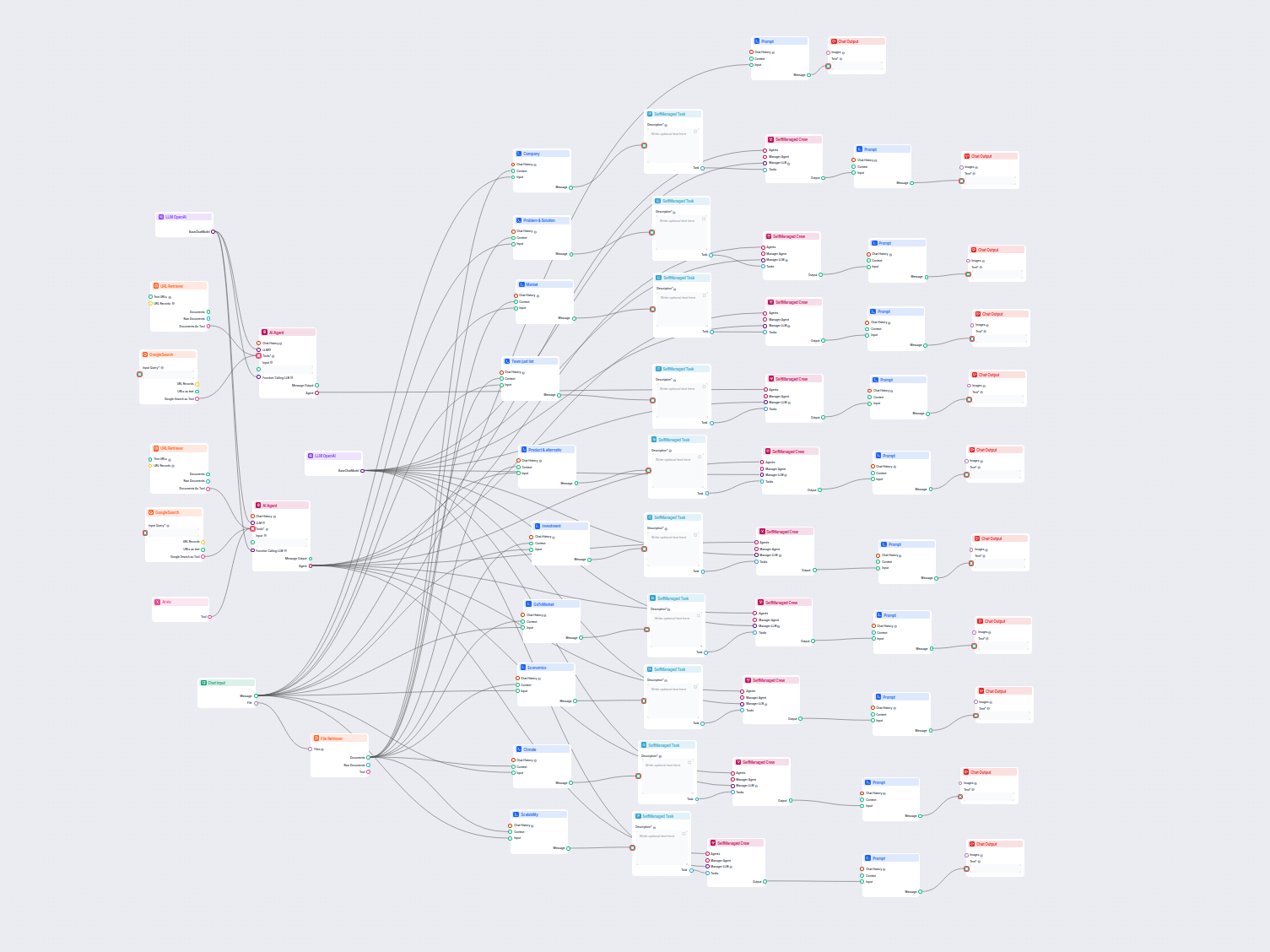

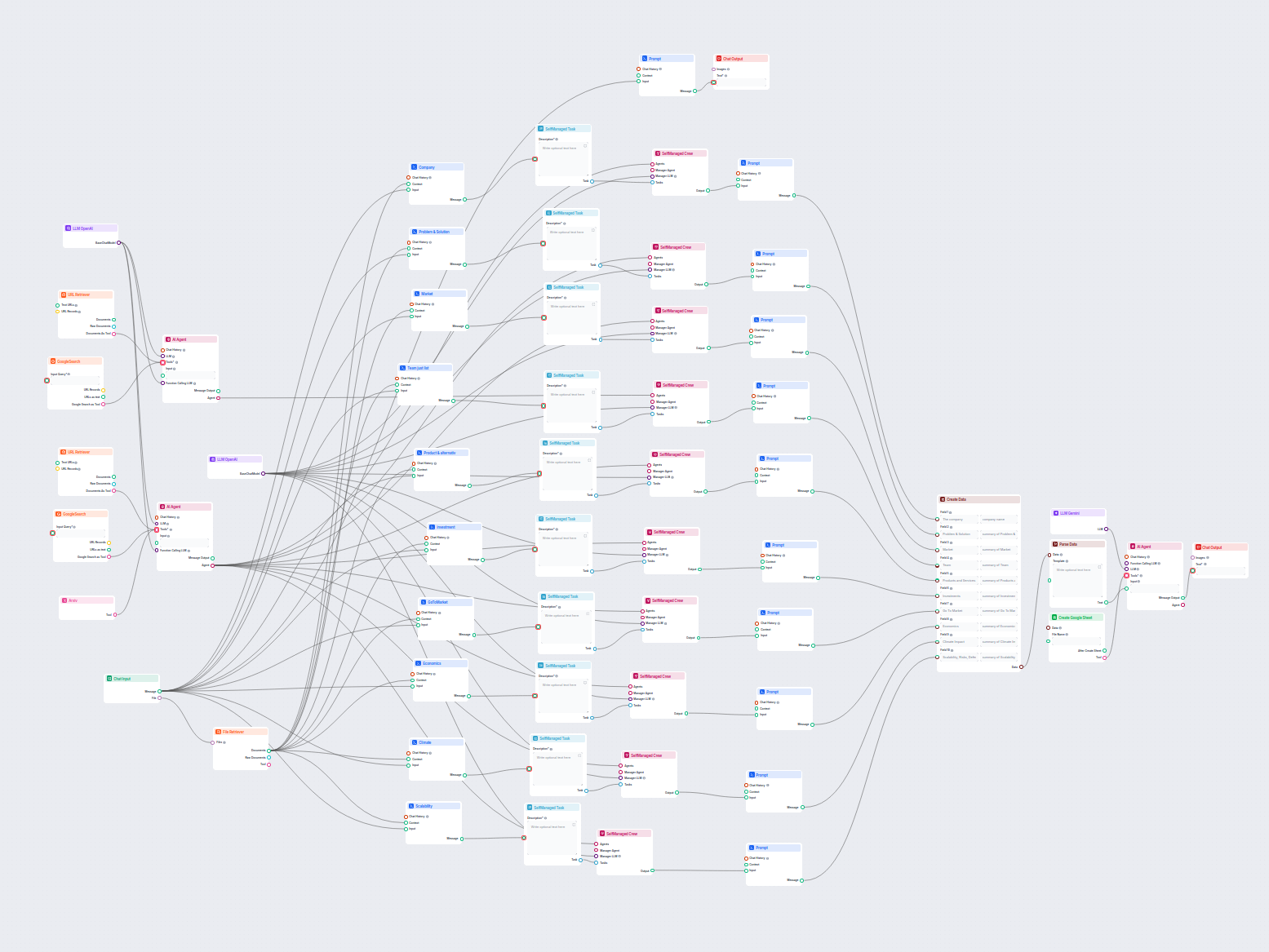

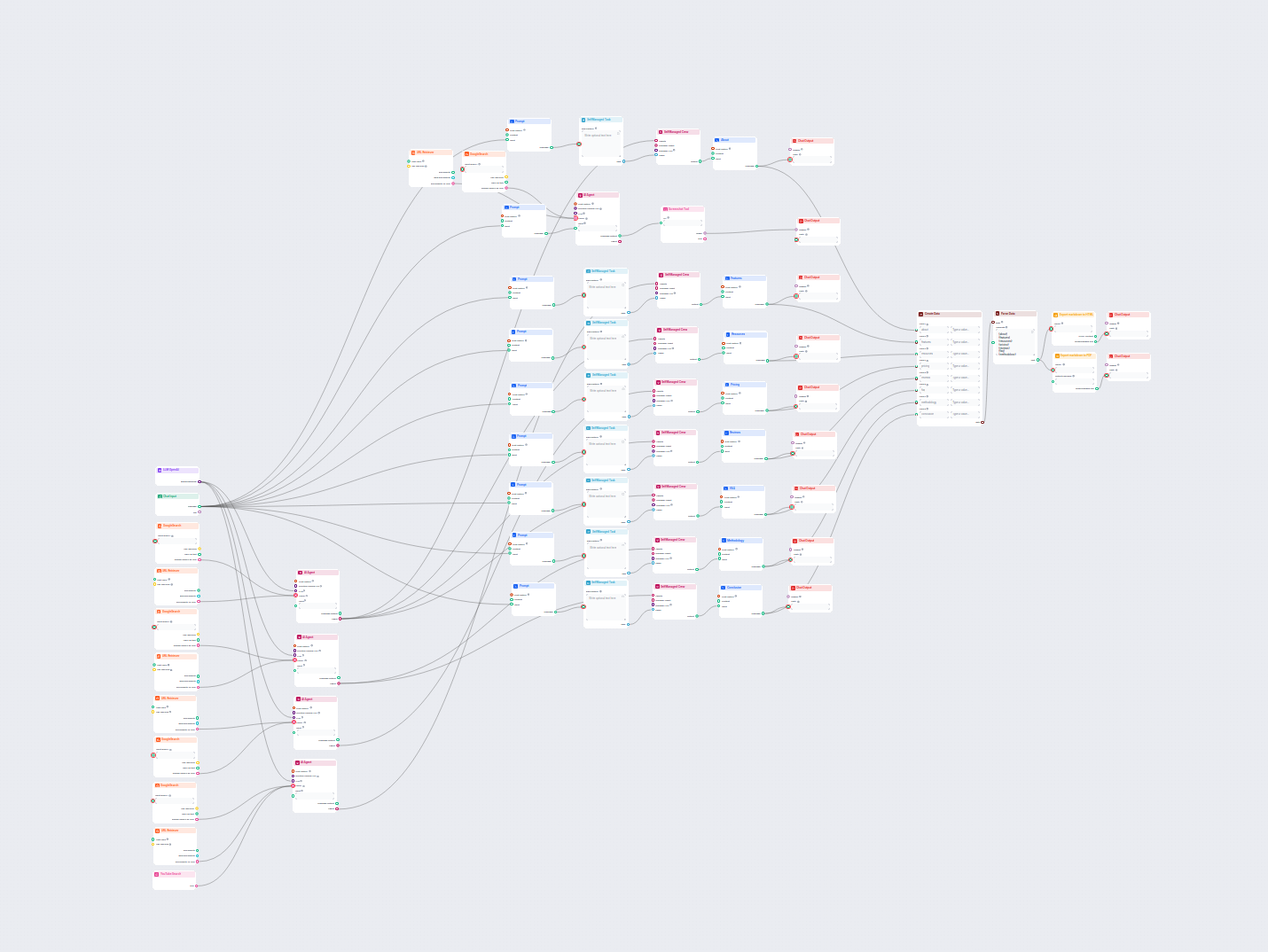

Kompleksowy workflow do analizy firm i badań rynku oparty na sztucznej inteligencji. Automatycznie zbiera i analizuje dane dotyczące tła firmy, pozycji rynkowej...

Ten workflow oparty na AI dostarcza kompleksową, opartą na danych analizę firmy. Zbiera informacje o tle firmy, otoczeniu rynkowym, zespole, produktach, inwesty...

Ten przepływ pracy analizuje dowolną firmę wnikliwie poprzez badanie danych publicznych i dokumentów, obejmując rynek, zespół, produkty, inwestycje i więcej. Sy...

Ten workflow oparty na AI analizuje strukturę treści Twojej strony internetowej, porównuje ją ze stronami konkurencji o najwyższych pozycjach i przedstawia sper...

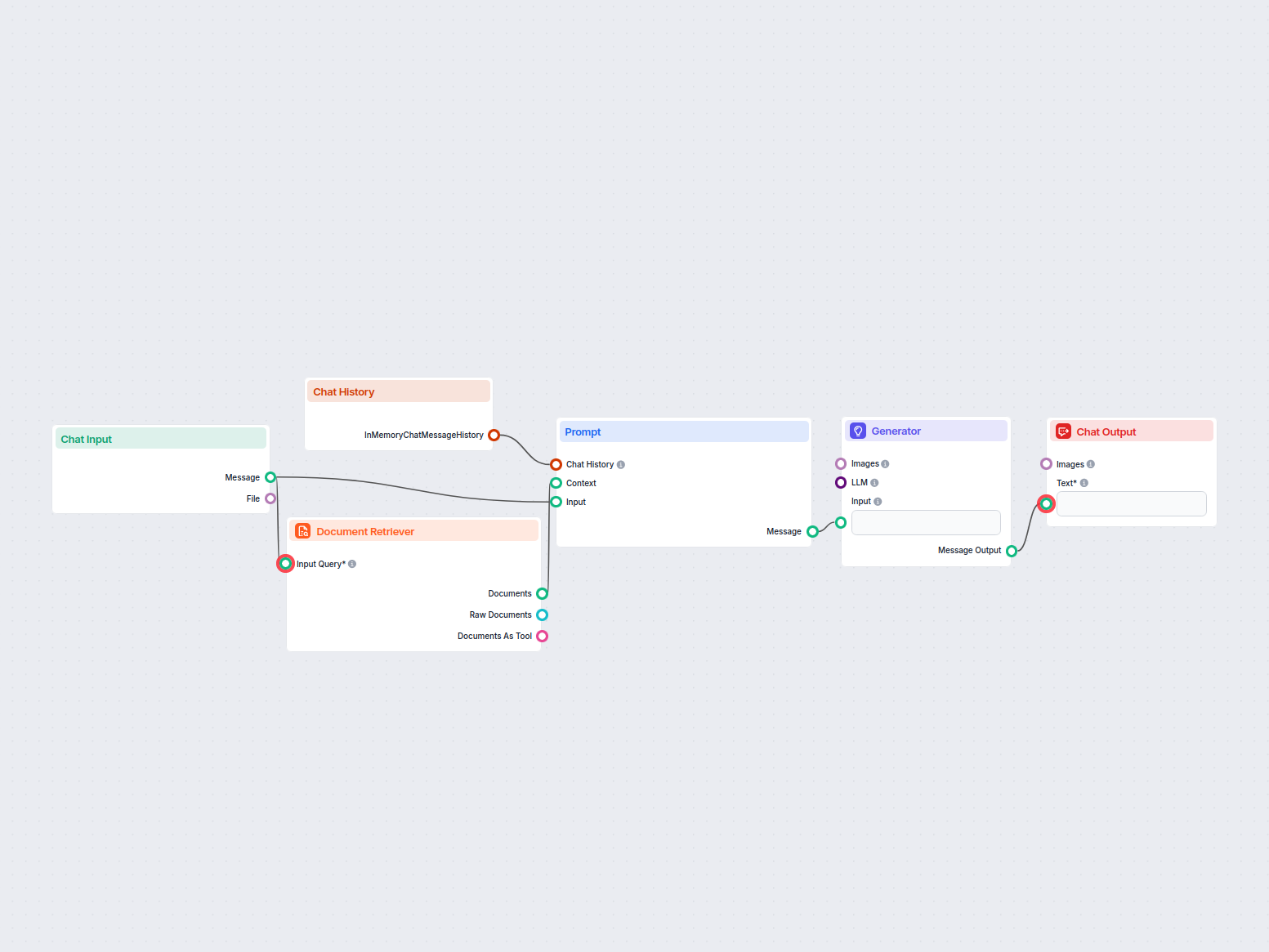

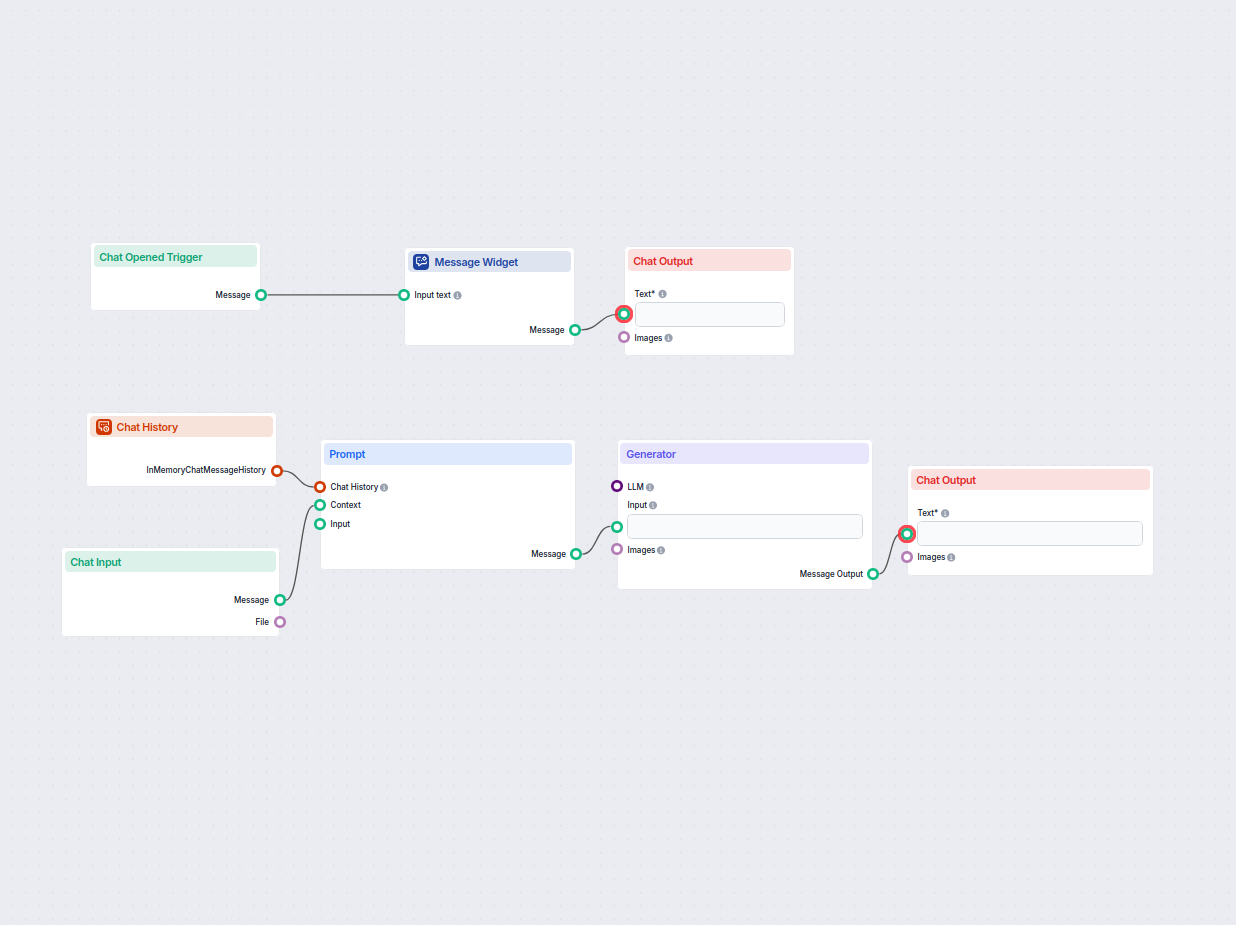

Prosty workflow asystenta AI na czacie, który wykorzystuje poprzednią historię rozmowy do generowania trafnych odpowiedzi na wiadomości użytkownika. Zawiera wia...

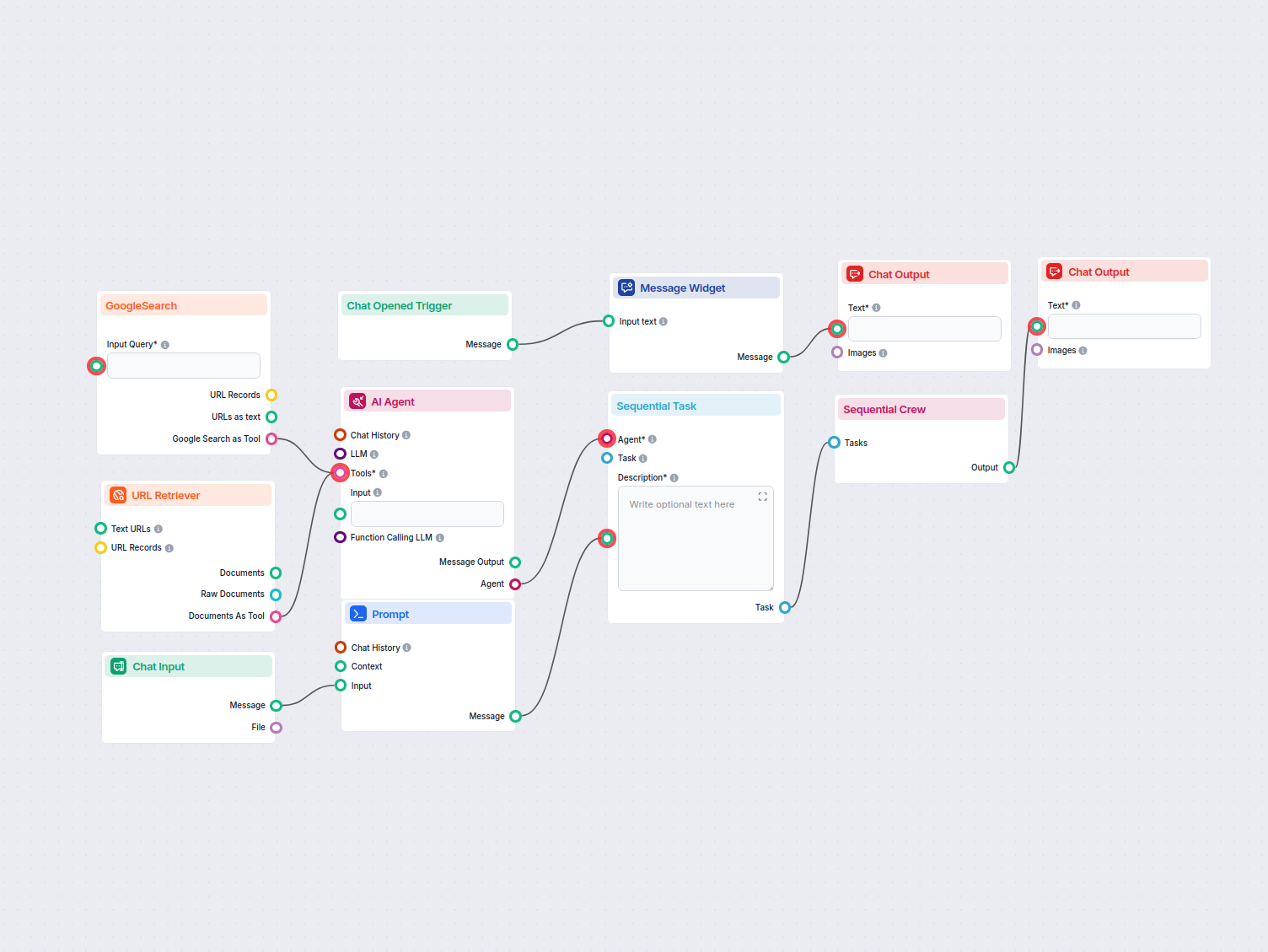

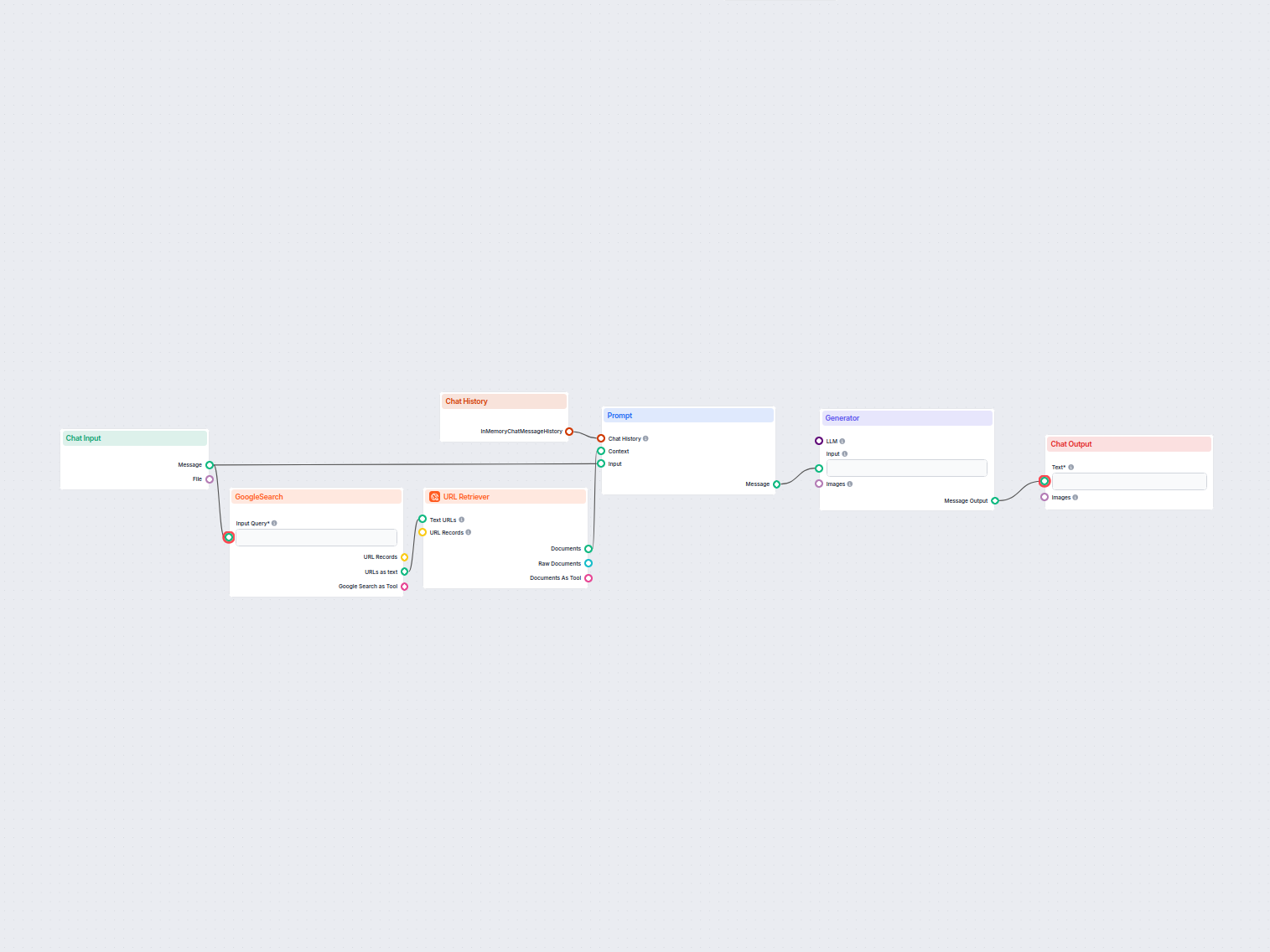

Asystent AI, który odpowiada na pytania użytkowników, korzystając z rzetelnych i dobrze udokumentowanych informacji, opierając odpowiedzi na podejściu RIG i źró...

Asystent chatbot AI oparty na OpenAI GPT-4o, który automatycznie przeszukuje i wykorzystuje wewnętrzne dokumenty firmowe do odpowiadania na pytania użytkowników...

Ten workflow oparty na AI wzbogaca dane leadów w Google Sheets poprzez automatyczne pobieranie brakujących profili LinkedIn, stanowisk i branż z internetu, wyko...

Ten przepływ pracy automatycznie wzbogaca dane kontaktowe w Google Sheets poprzez wyszukiwanie profili LinkedIn, wyodrębnianie stanowisk i branż oraz aktualizac...

Ten workflow oparty na AI generuje zwięzłe, wysokiej jakości odpowiedzi FAQ na dowolne pytanie, przeszukując internet, wydobywając odpowiednie treści i tworząc ...

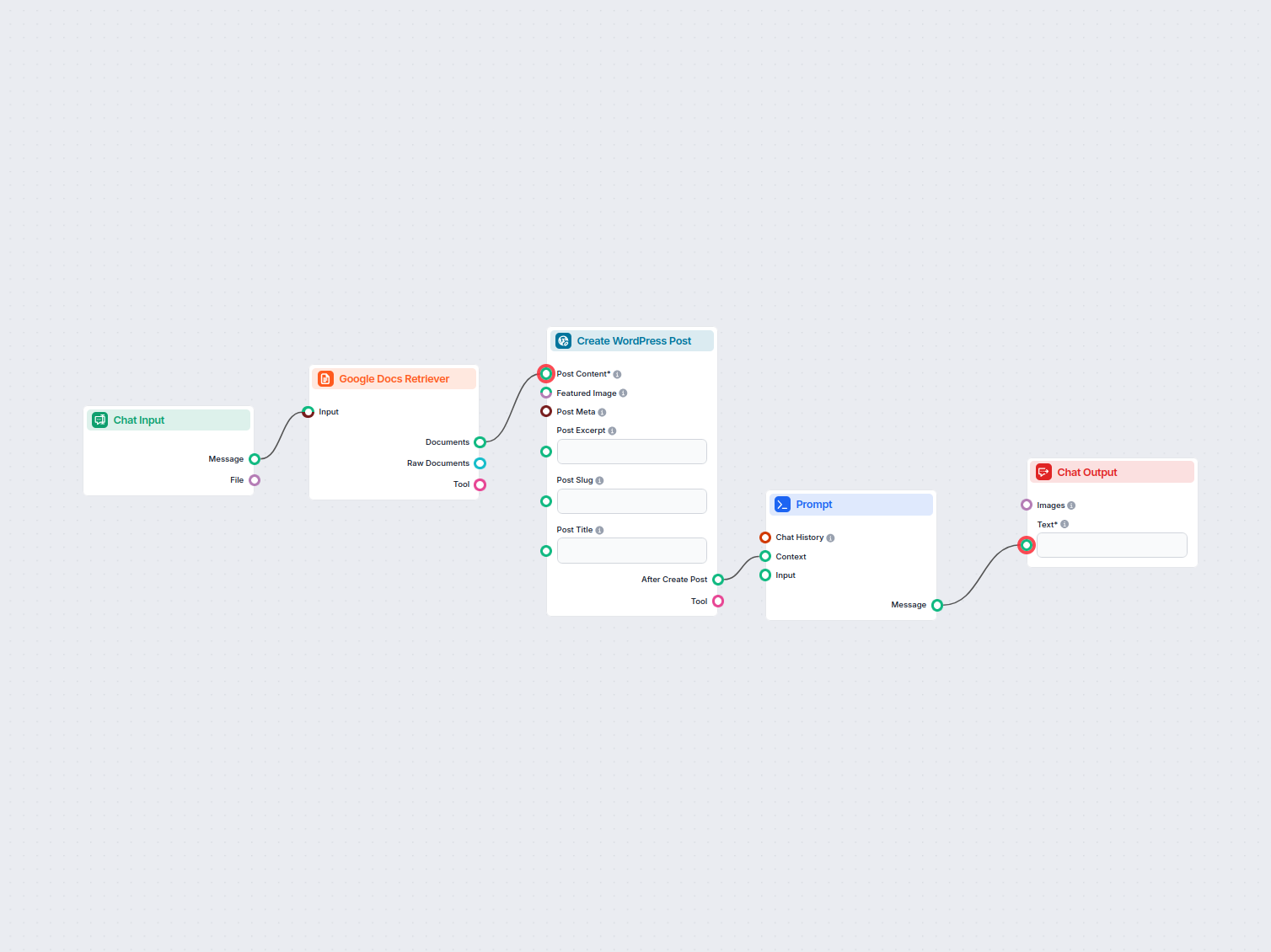

Automatycznie przenoś treści z Google Docs na swoją stronę WordPress jako nowe wpisy, usprawniając publikację dla blogerów, marketerów i zespołów contentowych....

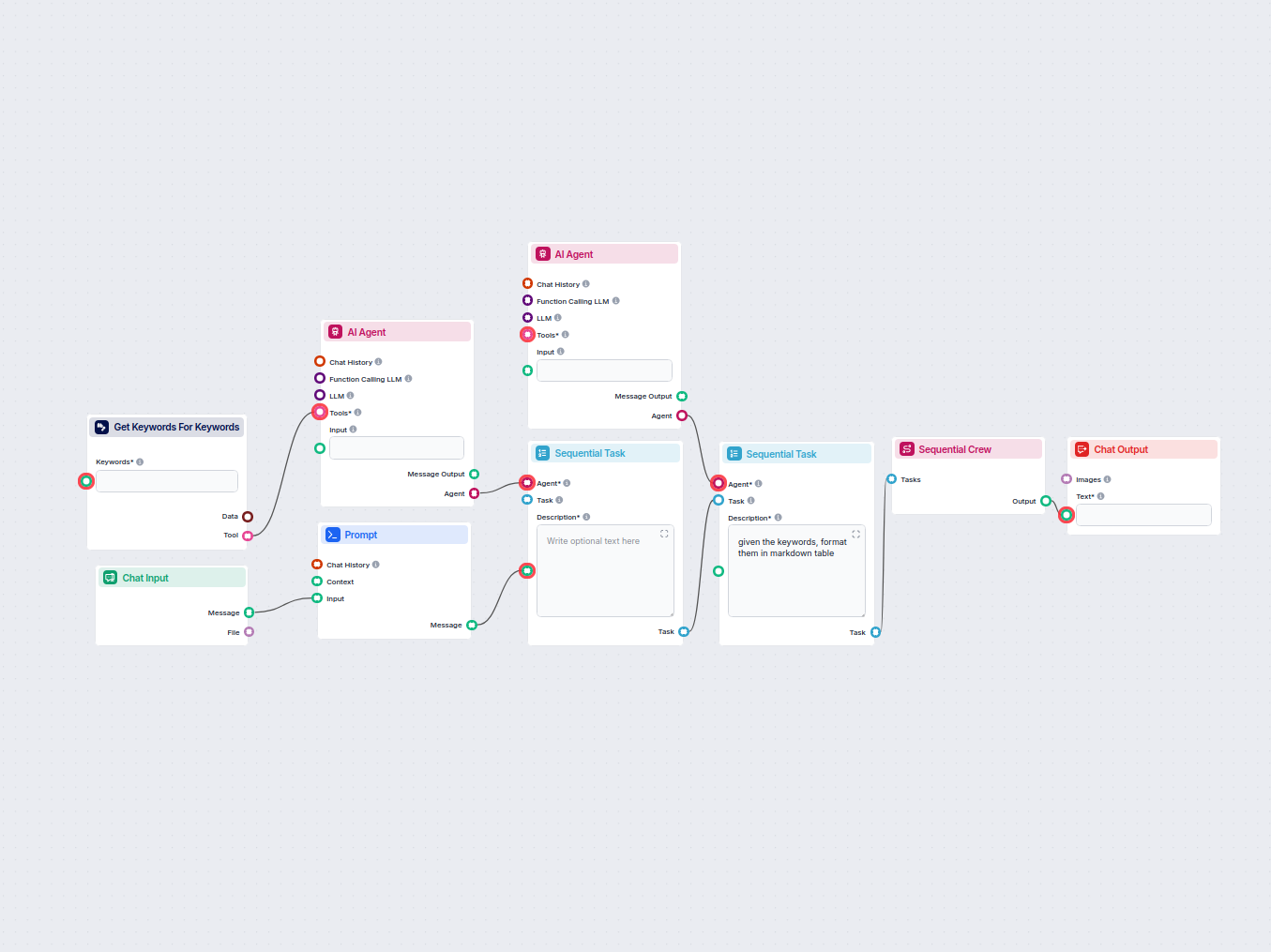

Ten workflow automatyzuje badanie słów kluczowych, generując szczegółową tabelę powiązanych słów dla Twojej frazy docelowej, w tym kluczowe metryki SEO takie ja...

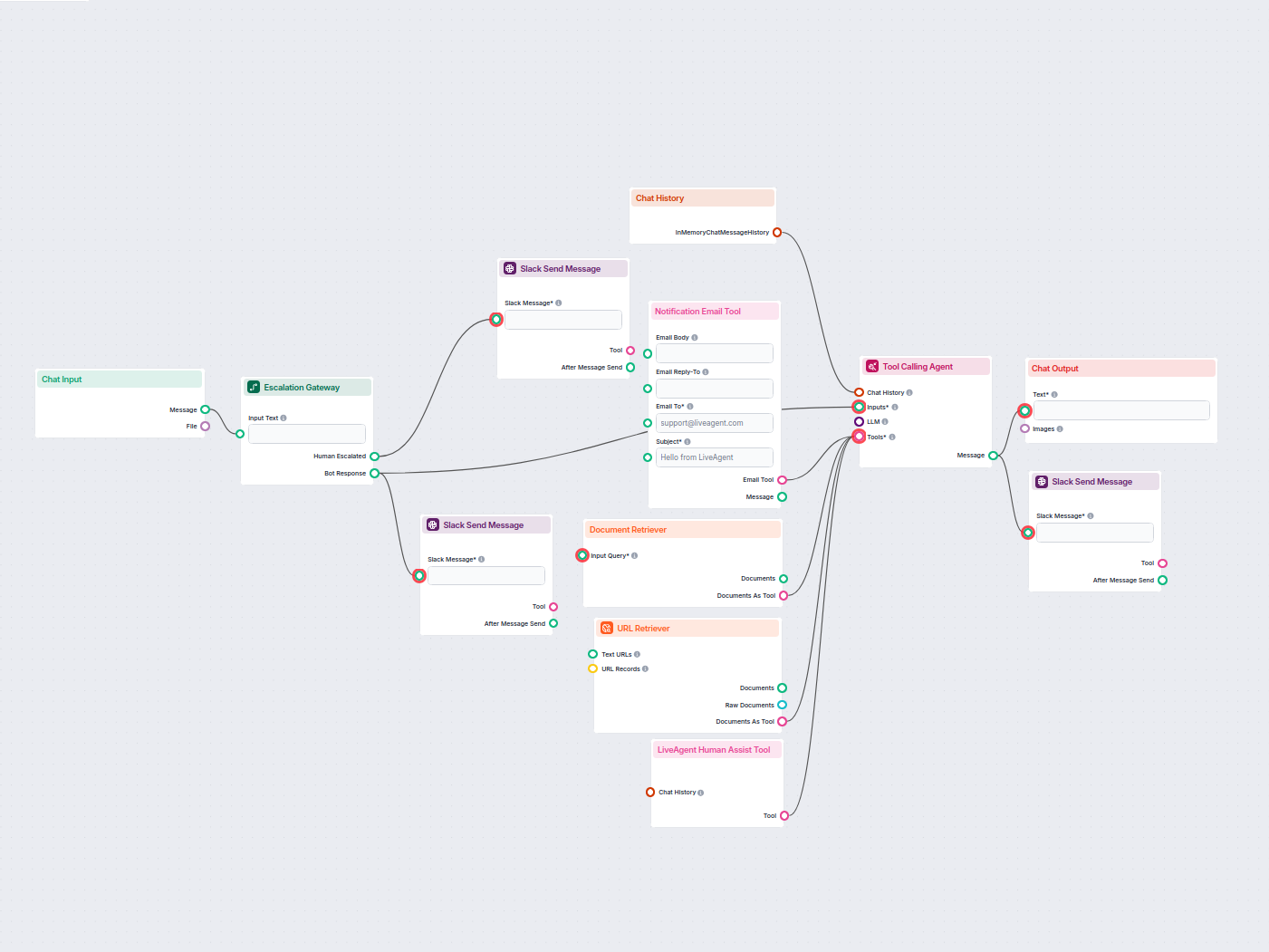

Wdrażaj inteligentnego czatbota do obsługi klienta w LiveAgent, który automatycznie odpowiada na pytania odwiedzających, pobiera dokumenty z bazy wiedzy i eskal...

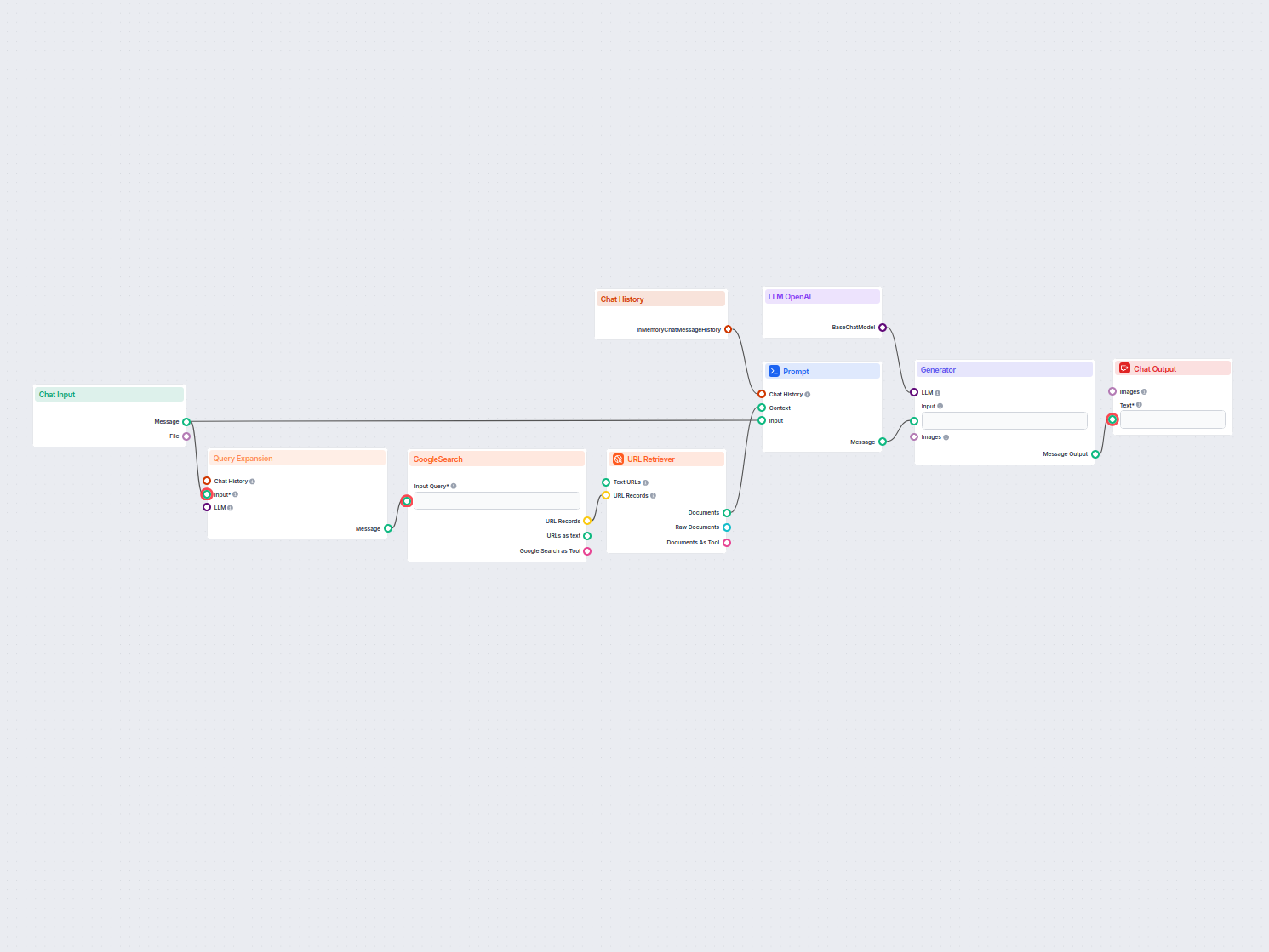

Czatbot w czasie rzeczywistym, który korzysta z wyszukiwarki Google ograniczonej do Twojej własnej domeny, pobiera odpowiednie treści z sieci i wykorzystuje Ope...

Ten przepływ pracy wyodrębnia i porządkuje kluczowe informacje z e-maili oraz załączonych plików, wykorzystuje AI do przetwarzania i strukturyzacji danych, a na...

Automatycznie generuje krótki, angażujący akapit na Twoją stronę internetową, zawierający linki do najbardziej powiązanych artykułów. Ten workflow oparty na AI ...

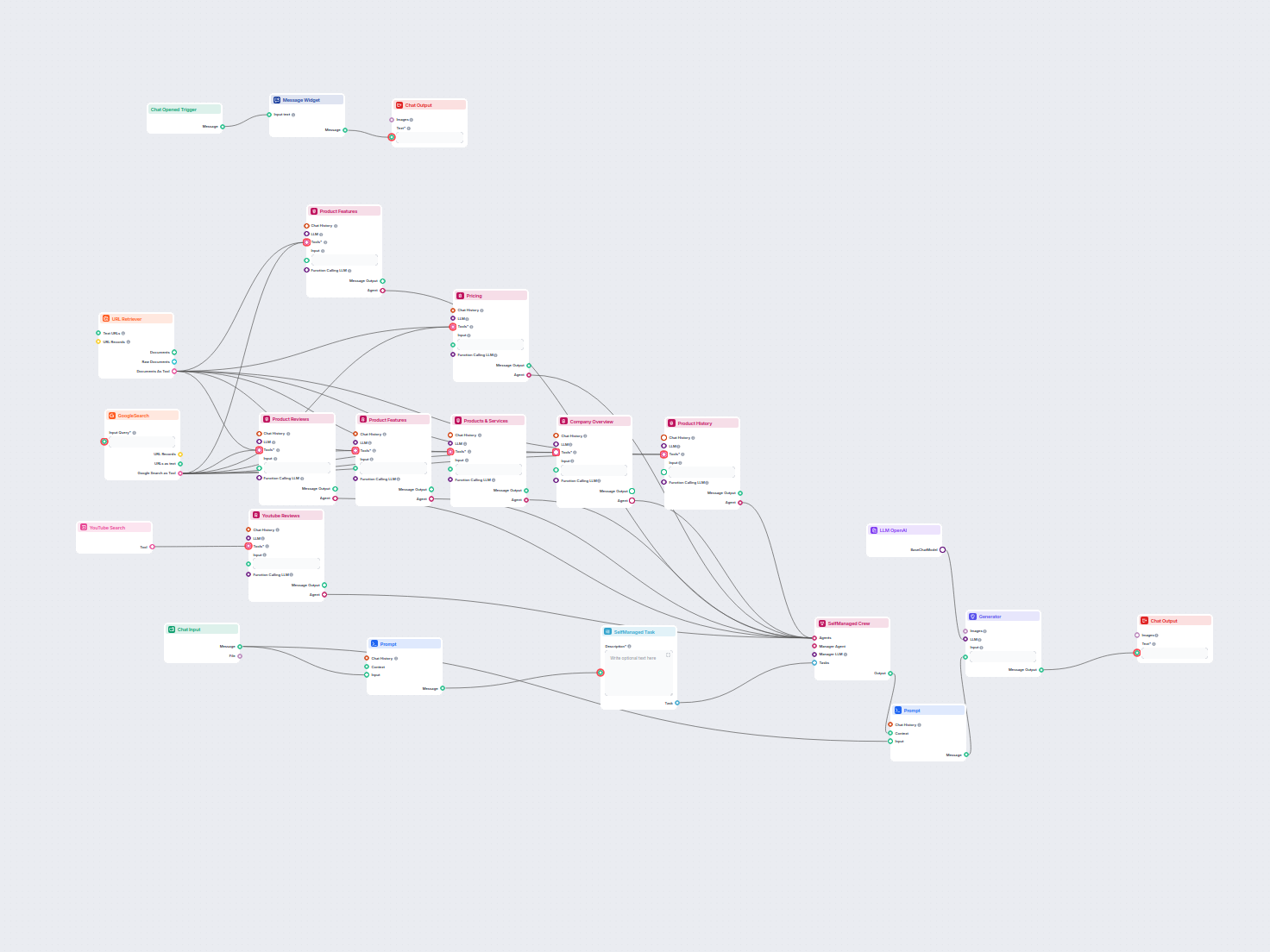

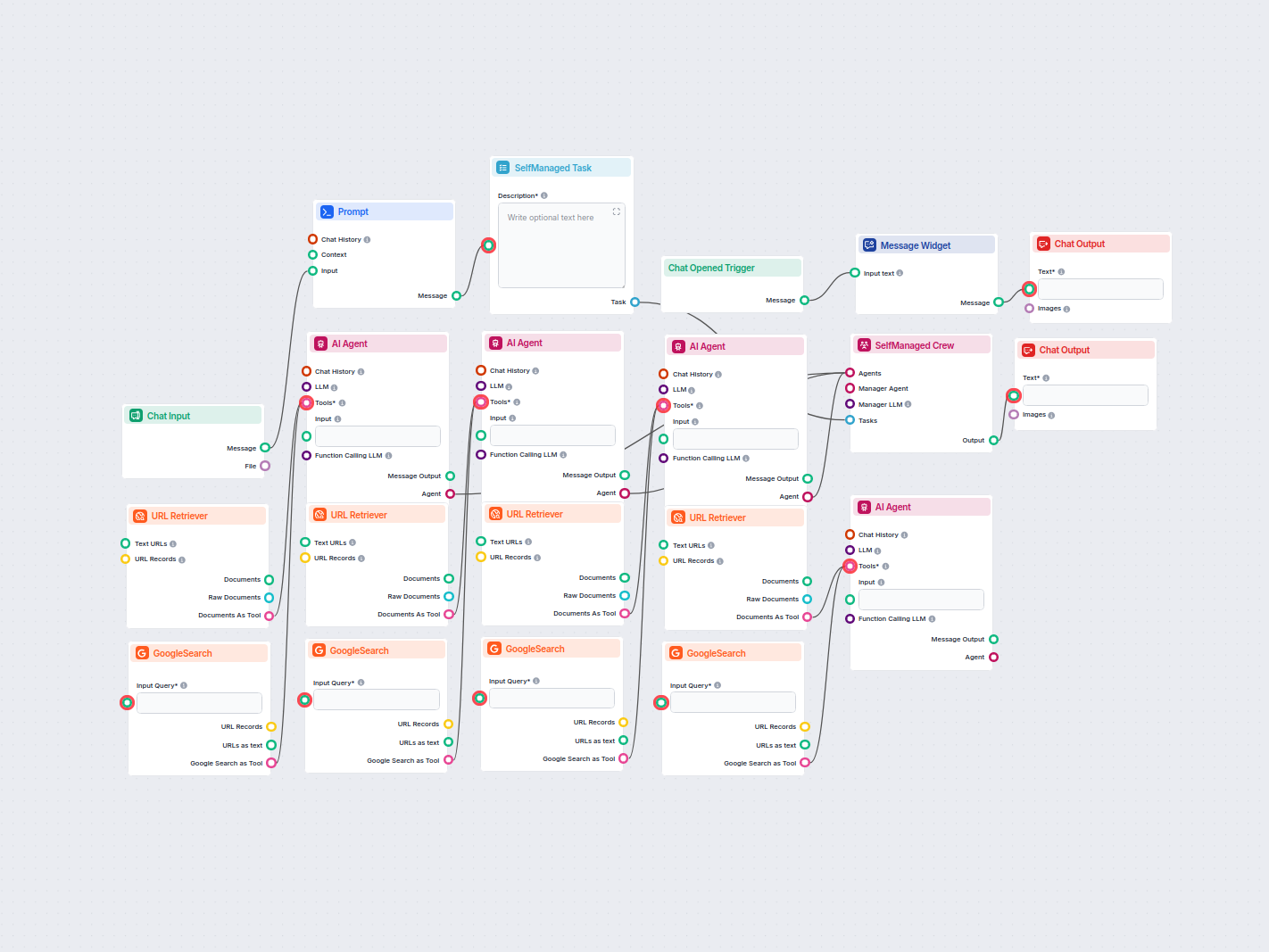

Generuj kompleksowe analizy produktów przy użyciu agentów AI, którzy zbierają i podsumowują informacje o produkcie, ceny, funkcje, recenzje, alternatywy i więce...

Ten workflow oparty na AI pomaga specjalistom ds. sprzedaży przygotować się do spotkań, generując kompleksowy arkusz przygotowawczy. Po podaniu nazwy firmy, pro...

Twórz dogłębne, zoptymalizowane pod SEO artykuły do słownika, wykorzystując AI i bieżące badania internetowe. Ten przepływ analizuje najlepiej pozycjonowane tre...

Generuj kompleksowe, zoptymalizowane pod SEO artykuły recenzujące narzędzia programistyczne, zawierające szczegółowe opisy funkcji, cenniki, recenzje użytkownik...

Wygeneruj wpis bibliograficzny w formacie LaTeX dla dowolnego artykułu naukowego, po prostu podając jego adres URL. Ten przepływ pracy automatyzuje wyodrębniani...

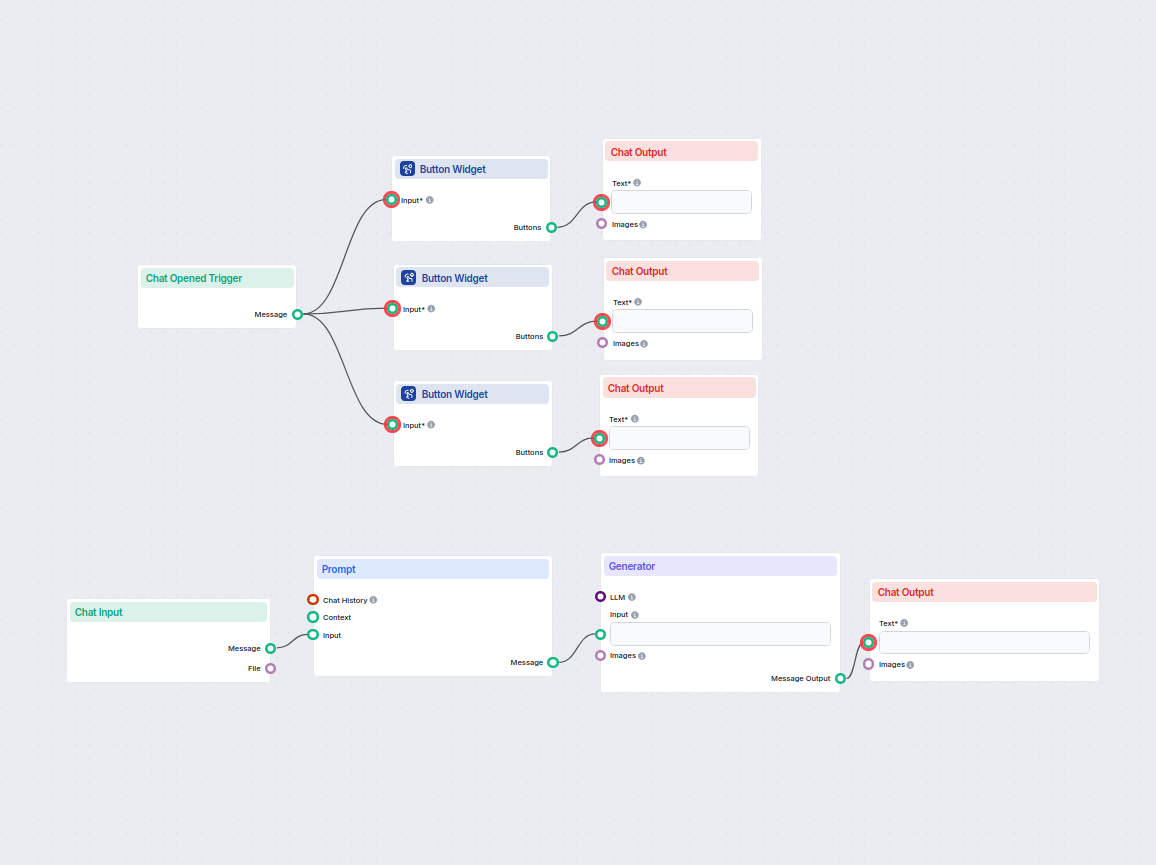

Łatwo generuj kompleksowe biznesplany za pomocą AI. Ten przepływ pracy zbiera dane od użytkownika, wykorzystuje historię czatu dla kontekstu i korzysta ze szabl...

Generuj szczegółowe, zoptymalizowane pod SEO blogi przy pomocy agentów AI. Proces obejmuje analizę najlepszych wyników Google, stworzenie briefu SEO, napisanie ...

Automatycznie generuj wysoko pozycjonowane posty blogowe SEO z filmów YouTube. Ten przepływ wyodrębnia transkrypcje wideo, analizuje najważniejsze słowa kluczow...

Automatycznie generuje dane strukturalne Schema.org w formacie JSON dla dowolnego adresu URL strony internetowej, ułatwiając wyszukiwarkom zrozumienie i indekso...

Natychmiast generuj uporządkowane, jasne e-maile dostosowane do Twojego stylu i intencji, wraz z proponowanym tematem – wszystko za pomocą AI. Idealne dla profe...

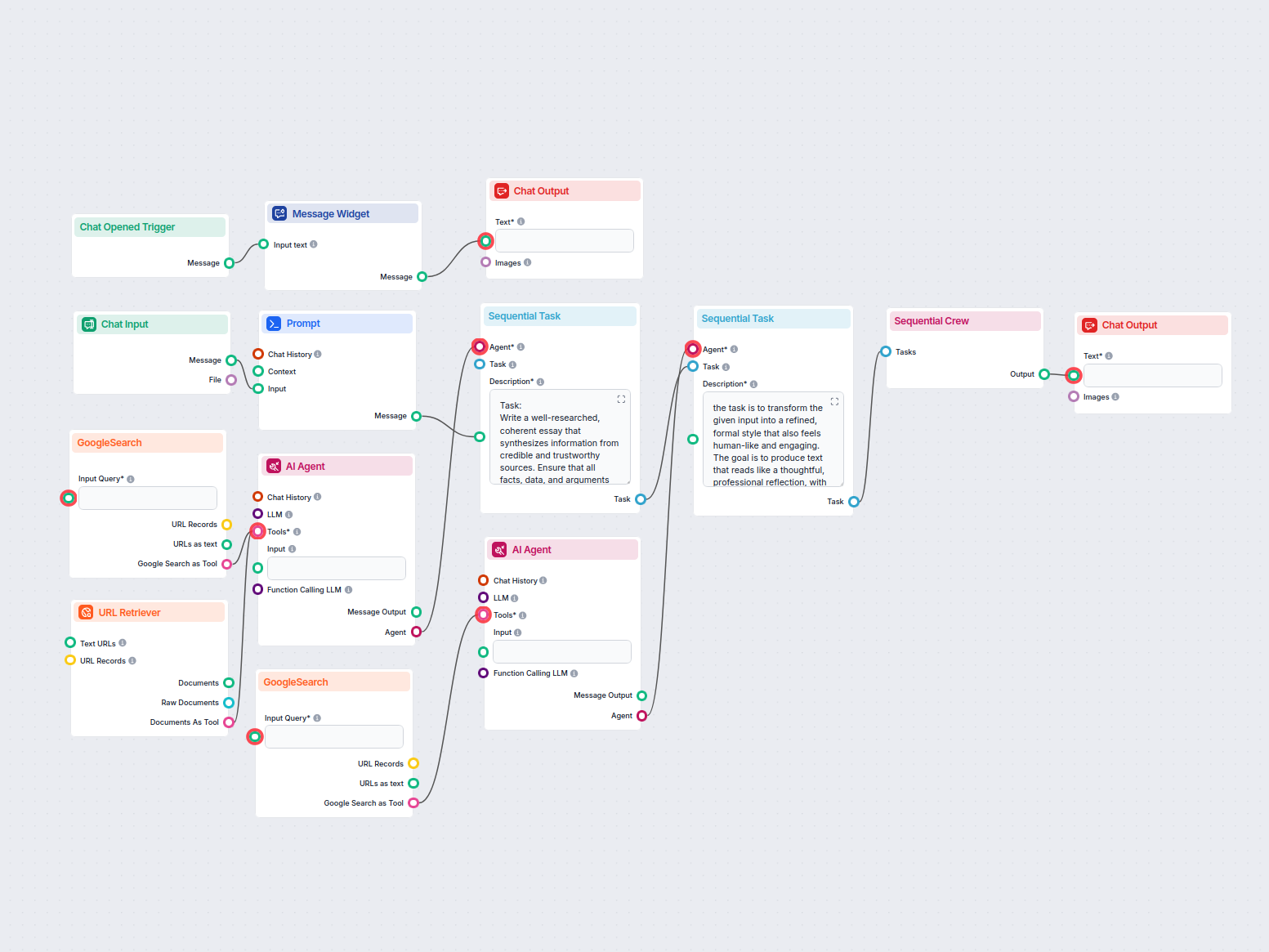

Automatycznie generuje rzeczowe, dobrze ustrukturyzowane eseje w formacie MLA z wykorzystaniem wiarygodnych źródeł znalezionych za pomocą wyszukiwarki Google. I...

Generuj formuły Google Sheets natychmiast na podstawie zapytań w języku naturalnym. Ten workflow oparty na AI pomaga użytkownikom tworzyć dokładne formuły arkus...

Generuj konspekt przyjazny SEO poprzez analizę najwyżej pozycjonowanych wyników wyszukiwania Google dla wybranego słowa kluczowego. Ten przepływ pracy wykorzyst...

Łatwo generuj formalne, nieformalne lub prawne listy dostosowane do Twoich potrzeb. Ten przepływ pracy oparty na AI przyjmuje Twoje dane wejściowe i tworzy sper...

Automatycznie twórz angażujące i profesjonalne nagłówki LinkedIn za pomocą AI. Wystarczy podać krótki opis swojego doświadczenia, a ten przepływ wygeneruje chwy...

Łatwo generuj kreatywne podpisy do obrazów za pomocą AI. Prześlij zdjęcie i natychmiast otrzymaj chwytliwy podpis, idealny do mediów społecznościowych lub proje...

Łatwo generuj kreatywne i trafne propozycje nazw firm za pomocą AI. Użytkownik podaje krótki opis swojej działalności i natychmiast otrzymuje pięć spersonalizow...

Automatycznie generuj zoptymalizowane pod SEO tytuły, opisy i hashtagi do filmów na YouTube z dowolnego adresu URL strony internetowej. Idealne dla marketerów, ...

Automatycznie tworzy dopasowane oświadczenie misji na podstawie danych użytkownika i kontekstu rozmowy. Idealny dla startupów, przedsiębiorców i marketerów, któ...

Generuj innowacyjne pomysły biznesowe dopasowane do wskazówek użytkownika lub wybranych branż dzięki AI. Ten interaktywny przepływ zapewnia sugestie na podstawi...

Bez wysiłku zamieniaj treść swoich plików PDF lub prezentacji w wysoko pozycjonowane, uporządkowane pomysły na wpisy blogowe dzięki AI. Prześlij swój dokument i...

Generuj unikalne pomysły na treści i podsumowania za pomocą AI, badając najważniejsze wyniki Google dla dowolnego słowa kluczowego. Idealne dla marketerów i twó...

Twórz angażujące teksty postów na LinkedIn z dowolnego adresu URL strony internetowej w łatwy i szybki sposób. Ten zautomatyzowany przepływ pracy wyodrębnia tre...

Automatycznie generuj angażujące posty na Instagram, w tym chwytliwe tytuły, kreatywne opisy i atrakcyjne wizualnie zdjęcia dzięki badaniom i generowaniu treści...

Zamień dowolny film z YouTube w profesjonalną prezentację Google Slides w kilka minut. Ten workflow oparty na AI wyodrębnia treść z podanego adresu URL YouTube,...

Generuj wysokiej jakości prompty do obrazów AI, korzystając z najlepszych praktyk. Ten workflow zbiera dane od użytkownika, formatuje je w skuteczny prompt do g...

Automatycznie generuje protokoły spotkań z zadaniami i e-maile podsumowujące na podstawie załączników ze spotkania za pomocą AI oraz eksportuje wyniki do pliku ...

Generuj kompleksowe, raporty oparte na AI dotyczące przypadków użycia produktów programistycznych na potrzeby marketingu i sprzedaży. Ten workflow bada produkt ...

Automatycznie generuj wiele wariantów reklam Google Ads dla dowolnego adresu URL. Wklej link do swojej strony i otrzymaj gotowe do użycia tytuły oraz opisy rekl...

Generuj dobrze ustrukturyzowaną treść strony internetowej na podstawie analizy najwyżej pozycjonowanych stron Google dla dowolnego słowa kluczowego. Ten flow au...

Generuj unikalne, zoptymalizowane pod SEO tytuły stron internetowych z wykorzystaniem AI oraz aktualnych danych z wyszukiwarki Google. Wprowadź docelowe słowa k...

Pokazywanie 1 do 60 z 79 wyników

Komponent Prompt przekazuje botowi instrukcje i kontekst, zapewniając odpowiedzi w pożądany sposób.

W wielu przypadkach to świetny pomysł, ale komponent jest opcjonalny.

To edytowalne pole tekstowe, w którym ustawiasz osobowość i rolę bota. Wystarczy uzupełnić szablon: 'Jesteś {role}, który {behavior}.' Na przykład: 'Jesteś pomocnym czatbotem obsługi klienta, który mówi jak średniowieczny rycerz.'

Zdecydowanie warto rozważyć jego użycie w wielu przypadkach, ale komponent jest opcjonalny.

Rozpocznij budowanie spersonalizowanych, kontekstowych czatbotów AI dzięki intuicyjnej funkcji Prompt w FlowHunt. Definiuj role, zachowania i kontroluj wyniki dla sprytniejszej automatyzacji.

Poznaj komponent Generator w FlowHunt — potężne generowanie tekstu oparte na AI z wykorzystaniem wybranego modelu LLM. Bez wysiłku twórz dynamiczne odpowiedzi c...

Metaprompt w sztucznej inteligencji to instrukcja wysokiego poziomu zaprojektowana do generowania lub ulepszania innych promptów dla dużych modeli językowych (L...

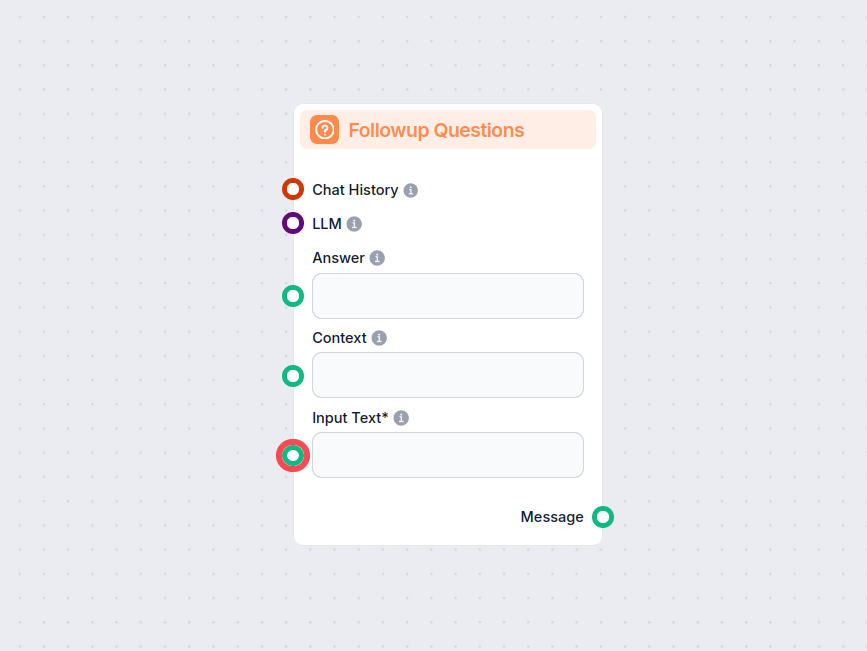

Komponent Pytania Uzupełniające w FlowHunt inteligentnie generuje trafne pytania, które użytkownicy mogą zadać w dalszej części rozmowy, na podstawie aktualnej ...