Sieci neuronowe

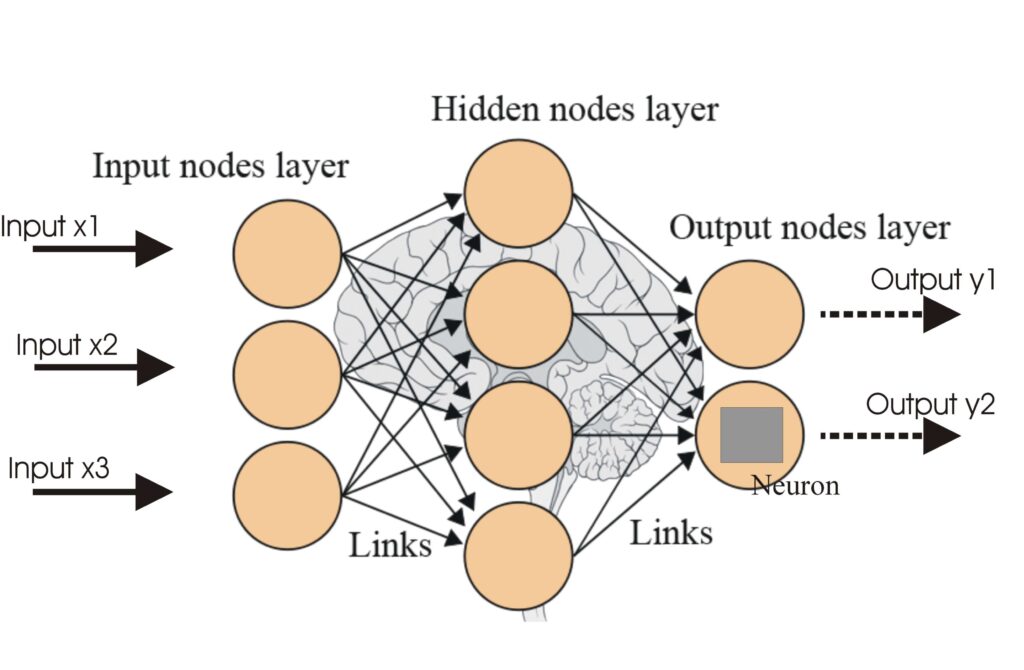

Sieć neuronowa, czyli sztuczna sieć neuronowa (ANN), to model obliczeniowy inspirowany ludzkim mózgiem, kluczowy w AI i uczeniu maszynowym do zadań takich jak r...

RNN to sieci neuronowe zaprojektowane do danych sekwencyjnych, wykorzystujące pamięć do przetwarzania wejść i uchwycenia zależności czasowych, idealne dla NLP, rozpoznawania mowy i prognozowania.

Rekurencyjne sieci neuronowe (RNN) to zaawansowana klasa sztucznych sieci neuronowych zaprojektowanych do przetwarzania danych sekwencyjnych. W przeciwieństwie do tradycyjnych, jednokierunkowych sieci neuronowych, które przetwarzają dane wejściowe jednokrotnie, RNN posiadają wbudowany mechanizm pamięci, dzięki któremu mogą przechowywać informacje o poprzednich wejściach. Sprawia to, że są szczególnie przydatne w zadaniach, gdzie kolejność danych jest kluczowa, takich jak modelowanie języka, rozpoznawanie mowy czy prognozowanie szeregów czasowych.

RNN to skrót od Rekurencyjna Sieć Neuronowa. Ten typ sieci neuronowej charakteryzuje się zdolnością do przetwarzania sekwencji danych poprzez utrzymywanie tzw. ukrytego stanu, który jest aktualizowany na każdym kroku czasowym w oparciu o bieżące wejście i poprzedni ukryty stan.

Rekurencyjna Sieć Neuronowa (RNN) to typ sztucznej sieci neuronowej, która znajduje zastosowanie w AI. Poznaj typy, sposoby uczenia i zastosowania w różnych branżach, gdzie połączenia między węzłami tworzą skierowany graf wzdłuż sekwencji czasowej. Umożliwia to dynamiczne zachowanie czasowe dla sekwencji zdarzeń. W przeciwieństwie do sieci jednokierunkowych, RNN mogą wykorzystywać swój wewnętrzny stan (pamięć) do przetwarzania sekwencji wejść, co sprawia, że są odpowiednie dla zadań takich jak rozpoznawanie pisma odręcznego, rozpoznawanie mowy i przetwarzanie języka naturalnego, stanowiąc pomost w interakcji człowieka z komputerem. Poznaj kluczowe aspekty, działanie i zastosowania już dziś!

Sednem działania RNN jest ich zdolność do zapamiętywania poprzednich informacji i wykorzystywania ich do wpływania na obecne wyjście. Osiągane jest to poprzez ukryty stan, który jest aktualizowany na każdym kroku czasowym. Ukryty stan pełni funkcję pamięci, przechowując informacje o wcześniejszych wejściach. Ta pętla zwrotna umożliwia RNN uchwycenie zależności w danych sekwencyjnych.

Podstawowym elementem RNN jest jednostka rekurencyjna, która składa się z:

RNN występują w różnych architekturach, w zależności od liczby wejść i wyjść:

RNN są niezwykle wszechstronne i mają szerokie zastosowanie:

Jednokierunkowe sieci neuronowe przetwarzają dane wejściowe jednokrotnie i są zazwyczaj stosowane w zadaniach, gdzie kolejność danych nie ma znaczenia, takich jak klasyfikacja obrazów. Natomiast RNN przetwarzają sekwencje wejść, pozwalając na uchwycenie zależności czasowych i przechowywanie informacji przez wiele kroków czasowych.

Aby przezwyciężyć część ograniczeń tradycyjnych RNN, opracowano zaawansowane architektury, takie jak Long Short-Term Memory (LSTM) i Gated Recurrent Unit (GRU). Te rozwiązania pozwalają lepiej uchwycić długoterminowe zależności i ograniczają problem zanikającego gradientu.

Rekurencyjna Sieć Neuronowa (RNN) to typ sztucznej sieci neuronowej zaprojektowanej do przetwarzania danych sekwencyjnych. W przeciwieństwie do jednokierunkowych sieci neuronowych, RNN wykorzystują pamięć poprzednich wejść do generowania aktualnych wyjść, dzięki czemu świetnie sprawdzają się w zadaniach takich jak modelowanie języka, rozpoznawanie mowy czy prognozowanie szeregów czasowych.

Jednokierunkowe sieci neuronowe przetwarzają wejścia jednokrotnie bez pamięci, natomiast RNN przetwarzają sekwencje wejść i przechowują informacje na kolejnych krokach czasu, co pozwala im uchwycić zależności czasowe.

RNN są wykorzystywane w przetwarzaniu języka naturalnego (NLP), rozpoznawaniu mowy, prognozowaniu szeregów czasowych, rozpoznawaniu pisma odręcznego, chatbotach, predykcji tekstu i analizie rynków finansowych.

RNN mogą mieć trudności z problemem zanikającego gradientu, co utrudnia naukę długoterminowych zależności. Są też bardziej obciążające obliczeniowo w porównaniu do sieci jednokierunkowych.

Zaawansowane architektury takie jak LSTM (Long Short-Term Memory) i GRU (Gated Recurrent Unit) zostały opracowane, by przezwyciężyć ograniczenia RNN, szczególnie w uczeniu długotrwałych zależności.

Inteligentne chatboty i narzędzia AI w jednym miejscu. Łącz intuicyjne bloki i zamieniaj pomysły w zautomatyzowane Flowy.

Sieć neuronowa, czyli sztuczna sieć neuronowa (ANN), to model obliczeniowy inspirowany ludzkim mózgiem, kluczowy w AI i uczeniu maszynowym do zadań takich jak r...

Sztuczne Sieci Neuronowe (ANN) to podzbiór algorytmów uczenia maszynowego wzorowanych na ludzkim mózgu. Te modele obliczeniowe składają się ze współpołączonych ...

Konwolucyjna sieć neuronowa (CNN) to specjalistyczny rodzaj sztucznej sieci neuronowej zaprojektowany do przetwarzania uporządkowanych danych siatkowych, takich...