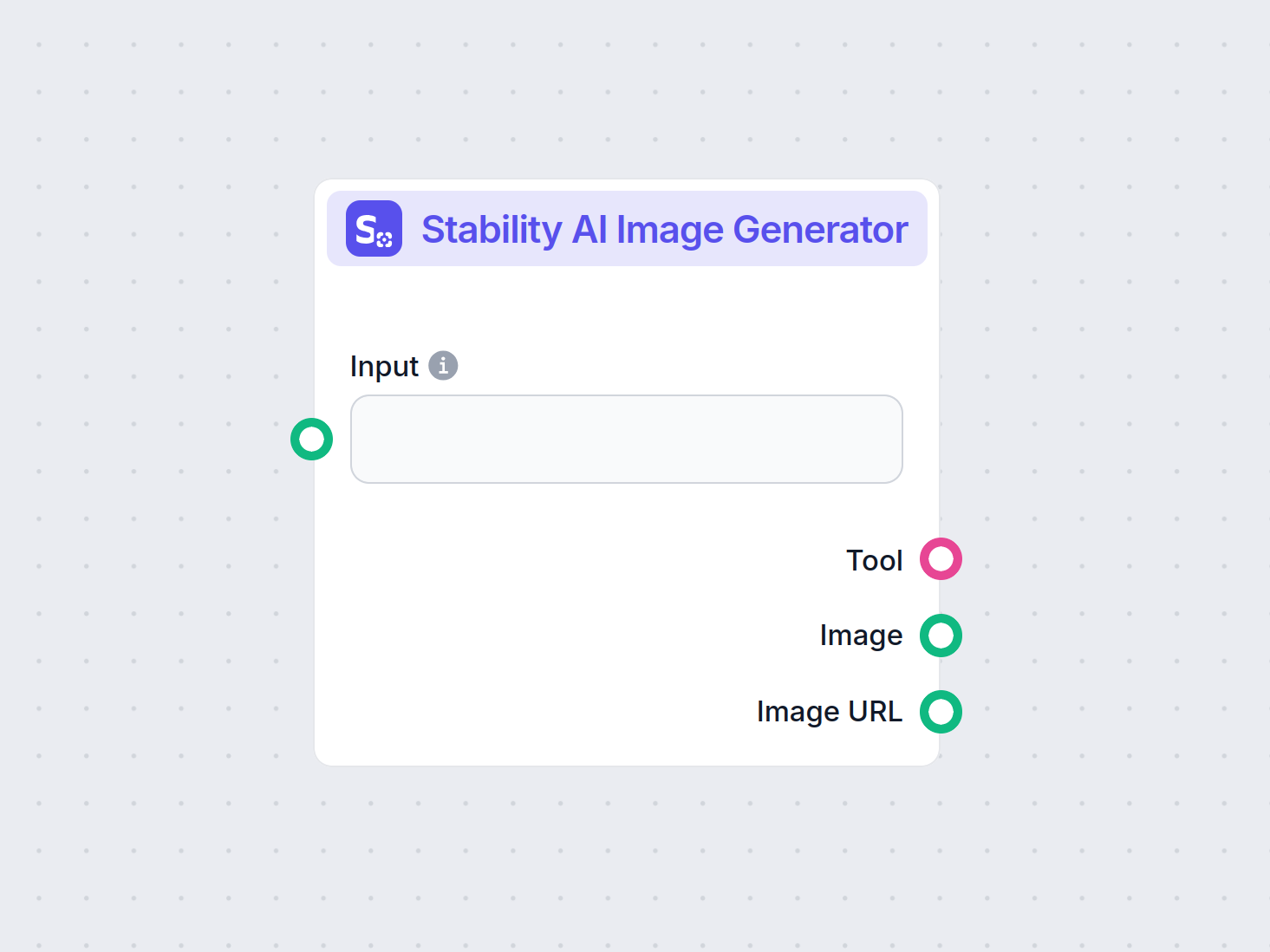

Generator Obrazów Stability AI

Generuj wysokiej jakości obrazy z opisów tekstowych za pomocą komponentu Generator Obrazów Stability AI. Narzędzie to, oparte na modelach Stable Diffusion, ofer...

Stable Diffusion to wiodący model AI tekst-na-obraz, umożliwiający generowanie fotorealistycznych wizualizacji na podstawie promptów z wykorzystaniem zaawansowanych technik latent diffusion i uczenia głębokiego.

Stable Diffusion to model AI tekst-na-obraz, który tworzy wysokiej jakości obrazy na bazie opisów, wykorzystując uczenie głębokie. Stosuje techniki takie jak negatywne promptowanie i obrazy referencyjne dla lepszych rezultatów, szczególnie przy złożonych elementach jak dłonie.

Stable Diffusion to zaawansowany model generowania obrazów na podstawie tekstu, wykorzystujący techniki głębokiego uczenia do tworzenia wysokiej jakości, fotorealistycznych obrazów zgodnie z opisami tekstowymi. Opracowany jako model latent diffusion, stanowi istotny przełom w dziedzinie generatywnej sztucznej inteligencji, łącząc zasady modeli dyfuzji i uczenia maszynowego w celu tworzenia obrazów, które precyzyjnie odpowiadają zadanym promptom.

Stable Diffusion wykorzystuje uczenie głębokie i modele dyfuzji do generowania obrazów poprzez doprecyzowanie losowego szumu i tworzenie spójnych wizualizacji. Pomimo ogromnych zbiorów treningowych z milionami obrazów, model ma trudności ze złożonymi elementami, takimi jak dłonie. Z czasem, wraz z trenowaniem na coraz większych zbiorach danych, te problemy są minimalizowane, a jakość obrazów staje się coraz bardziej realistyczna.

Skuteczną metodą radzenia sobie z problemem dłoni jest stosowanie negatywnych promptów. Dodając do promptu frazy takie jak (-zła anatomia) lub (-złe dłonie -nienaturalne dłonie), możesz nakłonić AI do unikania deformacji. Uważaj jednak, aby nie przesadzić z negatywnymi promptami, gdyż mogą ograniczyć kreatywność modelu.

Kolejna technika polega na użyciu obrazów referencyjnych jako wskazówek dla AI. Umieszczając tag {image} z linkiem do obrazu referencyjnego w promptcie, zapewniasz AI wzorzec wizualny do poprawnego odwzorowania dłoni. Szczególnie przydatne jest to dla zachowania właściwych proporcji i pozycji dłoni.

Najlepsze efekty osiągniesz, łącząc negatywne promptowanie z obrazami referencyjnymi. Takie podejście pozwoli AI uniknąć typowych błędów przy jednoczesnym naśladowaniu wysokiej jakości przykładów.

(-zgięte palce) lub (realistyczne perspektywy), by jeszcze bardziej poprawić jakość dłoni.Opanowując te techniki, znacząco poprawisz odwzorowanie dłoni w swoich pracach ze Stable Diffusion, osiągając efekty na poziomie doświadczonego artysty. Zbierz obrazy referencyjne, twórz precyzyjne prompty i obserwuj ewolucję swojej AI-sztuki!

U podstaw działania Stable Diffusion leży przekształcanie promptów tekstowych w reprezentacje wizualne poprzez szereg procesów obliczeniowych. Zrozumienie tej funkcjonalności wymaga wniknięcia w koncepcje modeli dyfuzji, przestrzeni latentnych i sieci neuronowych.

Modele dyfuzji to klasa modeli generatywnych w uczeniu maszynowym, które uczą się tworzyć dane poprzez odwracanie procesu dyfuzji. Proces ten polega na stopniowym dodawaniu szumu do danych—np. obrazów—aż staną się one nieodróżnialne od losowego szumu. Model następnie uczy się odwracać ten proces, usuwając szum krok po kroku, by odzyskać oryginalne dane. Odwrócony proces dyfuzji jest kluczowy do generowania nowych, spójnych danych z losowego szumu.

Stable Diffusion wykorzystuje konkretnie model latent diffusion. W przeciwieństwie do klasycznych modeli dyfuzji, które operują bezpośrednio w przestrzeni pikseli obrazów, modele latent diffusion działają w skompresowanej przestrzeni latentnej. Przestrzeń ta to niższy wymiarowo reprezentant danych, zawierający ich kluczowe cechy przy mniejszej złożoności obliczeniowej. Dzięki temu Stable Diffusion może generować obrazy wysokiej rozdzielczości bardziej efektywnie.

Mechanizm działania Stable Diffusion polega na odwróconym procesie dyfuzji w przestrzeni latentnej. Zaczynając od losowego wektora latentnego szumu, model iteracyjnie doprecyzowuje tę reprezentację, przewidując i usuwając szum na każdym kroku. Ten proces jest prowadzony przez opis tekstowy podany przez użytkownika. Powtarza się aż do uzyskania wektora latentnego, który po dekodowaniu generuje obraz zgodny z promptem tekstowym.

Architektura Stable Diffusion integruje kilka kluczowych komponentów, które wspólnie przekształcają prompty tekstowe w obrazy.

VAE pełni rolę systemu kodowania-dekodowania, który kompresuje obrazy do przestrzeni latentnej i rekonstruuje je z powrotem do obrazów. Enkoder przekształca obraz w reprezentację latentną, uchwytując kluczowe cechy w zredukowanej formie. Dekoder z tej reprezentacji odtwarza szczegółowy obraz.

Proces ten jest kluczowy, ponieważ pozwala modelowi pracować na danych o niższej wymiarowości, znacznie ograniczając zasoby obliczeniowe w porównaniu do operowania na pełnej przestrzeni pikseli.

U-Net to specjalistyczna architektura sieci neuronowej wykorzystywana w Stable Diffusion do zadań przetwarzania obrazu. Składa się ze ścieżki kodującej i dekodującej z połączeniami pomiędzy analogicznymi warstwami. W kontekście Stable Diffusion U-Net służy jako predyktor szumu podczas odwróconego procesu dyfuzji.

Na każdym etapie procesu dyfuzji U-Net przewiduje ilość szumu w reprezentacji latentnej. Przewidywanie to służy do oczyszczenia wektora latentnego przez odejmowanie oszacowanego szumu, stopniowo denoisingując przestrzeń latentną do obrazu zgodnego z promptem.

Aby uwzględnić informacje tekstowe, Stable Diffusion używa enkodera tekstu opartego na modelu CLIP (Contrastive Language-Image Pretraining). CLIP został zaprojektowany do rozumienia i powiązywania informacji tekstowych i wizualnych poprzez mapowanie ich do wspólnej przestrzeni latentnej.

Gdy użytkownik podaje prompt tekstowy, enkoder tekstu zamienia prompt w osadzenia—liczbowe reprezentacje danych tekstowych. Te osadzenia warunkują działanie U-Net podczas procesu dyfuzji, prowadząc generowanie obrazu tak, by odzwierciedlał treść promptu.

Stable Diffusion oferuje wszechstronność w generowaniu obrazów i może być wykorzystywany na różne sposoby w zależności od potrzeb użytkownika.

Główne zastosowanie Stable Diffusion to generowanie obrazów z promptów tekstowych. Użytkownik wpisuje opis, a model generuje obraz odpowiadający tej treści. Przykładowo, prompt „Spokojna plaża o zachodzie słońca z palmami” wygeneruje odpowiadającą temu scenę.

Możliwość ta jest szczególnie cenna w branżach kreatywnych, podczas tworzenia treści i projektowania, gdzie szybka wizualizacja koncepcji jest niezbędna.

Poza generowaniem obrazów od zera, Stable Diffusion umożliwia także modyfikację istniejących obrazów na podstawie instrukcji tekstowych. Podając obraz wejściowy i prompt tekstowy, model może wygenerować nowy obraz z uwzględnieniem opisanych zmian.

Na przykład, użytkownik może wprowadzić obraz miasta za dnia z promptem „zmień na noc z neonami”, otrzymując obraz po odpowiednich modyfikacjach.

Inpainting polega na wypełnieniu brakujących lub uszkodzonych części obrazu. Stable Diffusion świetnie radzi sobie w tej dziedzinie, wykorzystując prompty tekstowe do prowadzenia rekonstrukcji fragmentów obrazu. Użytkownik może zamaskować fragmenty zdjęcia i opisać, co powinno je wypełnić.

Opcja ta jest przydatna przy renowacji zdjęć, usuwaniu niepożądanych elementów lub modyfikowaniu konkretnych części obrazu przy zachowaniu spójności całości.

Poprzez generowanie sekwencji obrazów z drobnymi różnicami Stable Diffusion można rozszerzyć do tworzenia animacji lub materiałów wideo. Narzędzia takie jak Deforum poszerzają możliwości Stable Diffusion w generowaniu dynamicznych treści wizualnych na podstawie promptów tekstowych w czasie.

To otwiera możliwości w animacji, efektach wizualnych oraz generowaniu dynamicznej treści bez klasycznej animacji klatkowej.

Zdolność Stable Diffusion do generowania obrazów z opisów tekstowych czyni go potężnym narzędziem w automatyzacji AI i rozwoju chatbotów.

Włączenie Stable Diffusion do chatbotów umożliwia generowanie treści wizualnych w odpowiedzi na zapytania użytkownika. Przykładowo, w obsłudze klienta, chatbot może na bieżąco tworzyć wizualne instrukcje lub ilustracje.

Prompty tekstowe są zamieniane na osadzenia przez enkoder tekstowy CLIP. Osadzenia te są kluczowe do warunkowania procesu generowania obrazu, zapewniając zgodność obrazu z opisem użytkownika.

Proces ten polega na iteracyjnym doprecyzowywaniu reprezentacji latentnej przez odejmowanie przewidzianego szumu. Na każdym etapie model bierze pod uwagę osadzenia tekstowe oraz bieżący stan wektora latentnego, by trafnie przewidzieć składnik szumu.

Sprawność modelu w radzeniu sobie z szumem wynika z jego treningu na dużych zbiorach, gdzie uczy się rozpoznawać i usuwać szum. Dzięki temu generuje przejrzyste obrazy nawet startując od losowego szumu.

Praca w przestrzeni latentnej zapewnia wydajność obliczeniową. Ponieważ ma ona mniej wymiarów niż przestrzeń pikseli, operacje są mniej zasobożerne. Dzięki temu Stable Diffusion generuje obrazy w wysokiej rozdzielczości bez nadmiernych wymagań sprzętowych.

Artyści i projektanci mogą szybko prototypować wizualizacje na podstawie opisów koncepcji, wspierając proces twórczy i skracając czas od pomysłu do realizacji.

Zespoły marketingowe mogą generować dedykowane grafiki do kampanii, social mediów czy reklam bez potrzeby angażowania szerokiego zespołu grafików.

Twórcy gier mogą generować assety, środowiska i koncept arty na bazie promptów opisowych, usprawniając pipeline assetów.

Sprzedawcy mogą tworzyć wizualizacje produktów w różnych aranżacjach lub konfiguracjach, poprawiając prezentację i doświadczenia klientów.

Nauczyciele i twórcy mogą generować ilustracje i diagramy do wyjaśniania złożonych zagadnień, czyniąc materiały bardziej angażującymi.

Naukowcy w dziedzinie AI i wizji komputerowej mogą wykorzystywać Stable Diffusion do dalszego eksplorowania potencjału modeli dyfuzji i przestrzeni latentnych.

Aby efektywnie korzystać ze Stable Diffusion, należy zwrócić uwagę na następujące kwestie techniczne:

Aby rozpocząć pracę ze Stable Diffusion, wykonaj poniższe kroki:

Dla deweloperów budujących systemy automatyzacji AI i chatboty Stable Diffusion można zintegrować w celu rozbudowy funkcjonalności.

Korzystając ze Stable Diffusion, pamiętaj o aspektach etycznych.

Stable diffusion to istotny temat w dziedzinie modeli generatywnych, szczególnie dla augmentacji danych i syntezy obrazów. Najnowsze prace badają różne aspekty stable diffusion, podkreślając jego zastosowania i skuteczność.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments – Fuxi Wen (2013):

Przedstawia algorytm diffusion least mean p-power (LMP) przeznaczony do rozproszonego szacowania w warunkach szumu alfa-stabilnego. Badanie porównuje metodę diffusion LMP z diffusion least mean squares (LMS), wykazując lepszą wydajność w warunkach alfa-stabilnego szumu. To istotne dla opracowania odpornych technik estymacji w środowiskach zaszumionych. Czytaj więcej

Stable Diffusion for Data Augmentation in COCO and Weed Datasets – Boyang Deng (2024):

Bada wykorzystanie modeli stable diffusion do generowania wysokorozdzielczych syntetycznych obrazów w celu poprawy małych zbiorów danych. Wykorzystując techniki takie jak translacja obraz-na-obraz, Dreambooth i ControlNet, praca ocenia efektywność stable diffusion w klasyfikacji i detekcji. Wyniki wskazują na obiecujące zastosowania stable diffusion w różnych dziedzinach. Czytaj więcej

Diffusion and Relaxation Controlled by Tempered α-stable Processes – Aleksander Stanislavsky, Karina Weron, Aleksander Weron (2011):

Opisuje właściwości anomalnej dyfuzji i nieliniowego relaksu z wykorzystaniem tempered α-stable processes. Rozwiązuje problem nieskończonych momentów związany z α-stable random operational time i prezentuje model obejmujący subdyfuzję jako przypadek szczególny. Czytaj więcej

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion – Andreas Stöckl (2022):

Ocena syntetycznych obrazów generowanych przez model Stable Diffusion z użyciem taksonomii Wordnet. Analizuje zdolność modelu do tworzenia poprawnych obrazów dla różnych pojęć, ilustrując różnice w dokładności odwzorowania. Oceny te są kluczowe dla zrozumienia roli stable diffusion w augmentacji danych. Czytaj więcej

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion – Sanchayan Vivekananthan (2024):

Bada trzy generatywne frameworki: VAEs, GANs i Stable Diffusion. Praca podkreśla zalety i ograniczenia każdego z nich, zaznaczając, że mimo atutów VAEs i GANs, stable diffusion wyróżnia się w niektórych zadaniach syntezy. Czytaj więcej

Przyjrzyjmy się, jak zaimplementować model Stable Diffusion w Pythonie z użyciem biblioteki Hugging Face Diffusers.

Zainstaluj wymagane biblioteki:

pip install torch transformers diffusers accelerate

pip install xformers # Opcjonalnie

Biblioteka Diffusers umożliwia łatwe ładowanie wytrenowanych modeli:

from diffusers import StableDiffusionPipeline

import torch

# Załaduj model Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Przenieś model na GPU dla szybszego wnioskowania

Aby wygenerować obraz, wystarczy podać prompt tekstowy:

prompt = "Spokojny krajobraz z górami i jeziorem, fotorealistyczny, rozdzielczość 8K"

image = pipe(prompt).images[0]

# Zapisz lub wyświetl obraz

image.save("generated_image.png")

model_id.torch.float16 zmniejsza zużycie pamięci.Możesz dostosować różne parametry:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Liczba kroków denoisingu

guidance

Stable Diffusion to zaawansowany model AI przeznaczony do generowania wysokiej jakości, fotorealistycznych obrazów na podstawie promptów tekstowych. Wykorzystuje latent diffusion i uczenie głębokie, by przekształcać opisy tekstowe w wizualizacje.

Stable Diffusion działa, konwertując prompt tekstowy na osadzenia obrazu za pomocą enkodera tekstowego CLIP, a następnie iteracyjnie usuwa szum z latentnej reprezentacji prowadzonej przez prompt, uzyskując spójny obraz jako wynik.

Stable Diffusion jest wykorzystywany do kreatywnego generowania treści, materiałów marketingowych, tworzenia assetów do gier, wizualizacji produktów w e-commerce, ilustracji edukacyjnych oraz chatbotów wspieranych przez AI.

Tak, Stable Diffusion obsługuje translację obraz-na-obraz oraz inpainting, umożliwiając użytkownikom modyfikację istniejących obrazów lub wypełnianie brakujących części na podstawie promptów tekstowych.

Zalecany jest komputer z nowoczesną kartą GPU do efektywnego generowania obrazów przy użyciu Stable Diffusion. Model wymaga także Pythona oraz bibliotek takich jak PyTorch i Diffusers.

Tak, Stable Diffusion jest wydany na otwartej, elastycznej licencji open source, co zachęca do wkładu społeczności, dostosowań i szerokiej dostępności.

Uwolnij kreatywność ze Stable Diffusion i zobacz, jak AI może zmienić Twoje pomysły w oszałamiające wizualizacje.

Generuj wysokiej jakości obrazy z opisów tekstowych za pomocą komponentu Generator Obrazów Stability AI. Narzędzie to, oparte na modelach Stable Diffusion, ofer...

Model Flux AI od Black Forest Labs to zaawansowany system generowania obrazów na podstawie tekstu, który przekształca polecenia w języku naturalnym w bardzo szc...

Zapoznaj się z naszą szczegółową recenzją Stability AI SD3 Large. Analizujemy jego mocne i słabe strony oraz efekty twórcze w odpowiedzi na różnorodne polecenia...