LLM OpenAI

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele OpenAI. Oto jak używać ChatGPT w swoich narzędziach AI i chatbotach.

OpenAI Whisper to open-source’owy system ASR, który precyzyjnie zamienia mowę na tekst w 99 językach, wspierając transkrypcję, tłumaczenie i identyfikację języka dla zaawansowanej automatyzacji AI.

OpenAI Whisper można uznać zarówno za model, jak i system, w zależności od kontekstu.

Główną funkcją Whisper jest transkrypcja mowy na tekst. Model doskonale sprawdza się w:

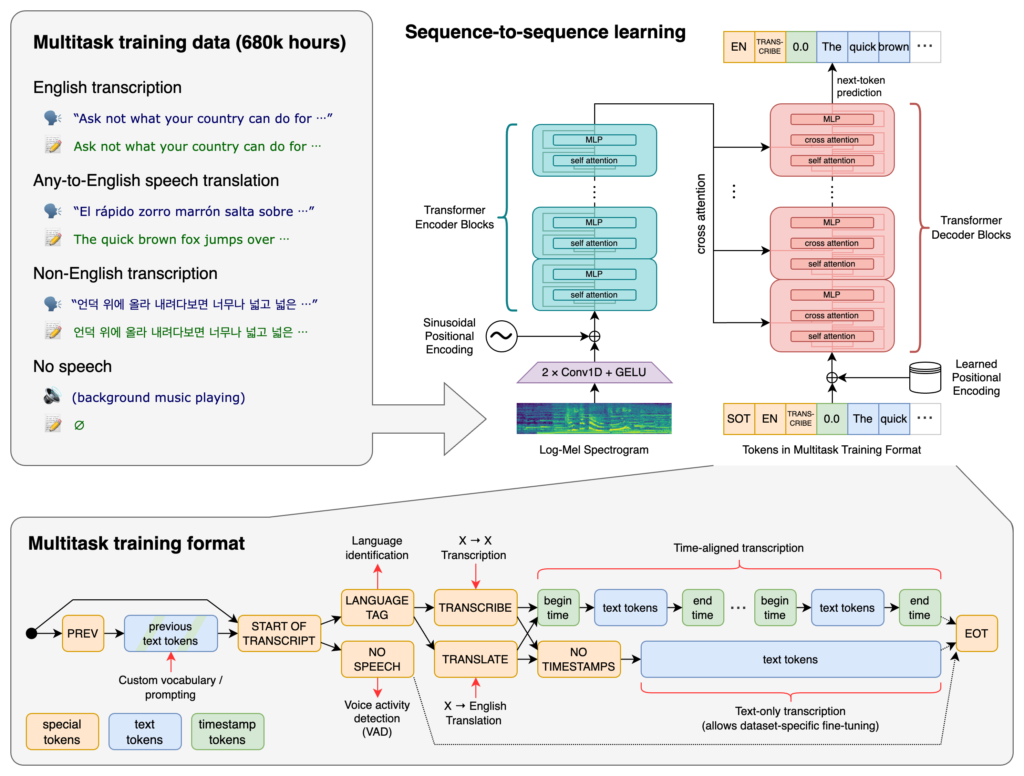

Sercem Whisper jest architektura Transformer, konkretnie model typu encoder-decoder. Transformery to sieci neuronowe, które świetnie sprawdzają się w przetwarzaniu sekwencyjnych danych i rozumieniu kontekstu na dłuższych odcinkach. Wprowadzone w artykule „Attention is All You Need” w 2017 roku, stały się podstawą wielu zadań NLP.

Proces działania Whispera obejmuje:

Whisper był trenowany na ogromnym zbiorze 680 000 godzin nadzorowanych danych zebranych z internetu. Obejmuje to:

Dzięki wsparciu dla 99 języków Whisper wyróżnia się zdolnością do obsługi zróżnicowanych danych językowych. Ta wielojęzyczność sprawia, że jest odpowiedni do zastosowań globalnych i usług dla międzynarodowych odbiorców.

Wytrenowany na obszernych danych nadzorowanych, Whisper osiąga wysoką precyzję transkrypcji. Jego odporność na akcenty, dialekty i szumy tła zapewnia wiarygodność w różnych rzeczywistych scenariuszach.

Oprócz transkrypcji Whisper oferuje:

Wydany jako oprogramowanie open-source, Whisper pozwala programistom:

Dzięki integracji Whispera z chatbotami i asystentami AI możesz umożliwić:

Whisper jest zaimplementowany jako biblioteka Pythona, co umożliwia płynną integrację z projektami opartymi na tym języku. Używanie Whispera w Pythonie wymaga przygotowania środowiska, instalacji potrzebnych zależności oraz wykorzystania funkcji biblioteki do transkrypcji lub tłumaczenia plików audio.

Przed użyciem Whispera należy przygotować środowisko pracy, instalując Pythona, PyTorch, FFmpeg i samą bibliotekę Whisper.

Jeśli nie masz zainstalowanego Pythona, pobierz go z oficjalnej strony. Aby zainstalować PyTorch, użyj pip:

pip install torch

Alternatywnie odwiedź stronę PyTorch, aby uzyskać szczegółowe instrukcje dla swojego systemu operacyjnego i wersji Pythona.

Whisper wymaga FFmpeg do przetwarzania plików audio. Zainstaluj FFmpeg przy użyciu odpowiedniego menedżera pakietów.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (Homebrew):

brew install ffmpeg

Windows (Chocolatey):

choco install ffmpeg

Zainstaluj pakiet Whisper dla Pythona przez pip:

pip install -U openai-whisper

Aby zainstalować najnowszą wersję bezpośrednio z repozytorium GitHub:

pip install git+https://github.com/openai/whisper.git

Upewnij się, że tryb deweloperski jest włączony:

Whisper oferuje kilka modeli różniących się rozmiarem i możliwościami. Zakres modeli: od tiny do large, każdy balansuje pomiędzy szybkością a dokładnością.

| Rozmiar | Parametry | Model tylko angielski | Model wielojęzyczny | Wymagany VRAM | Względna szybkość |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Zoptymalizowane do transkrypcji angielskiego, zapewniają lepszą wydajność dla audio w tym języku.Po przygotowaniu środowiska i zainstalowaniu niezbędnych komponentów możesz rozpocząć korzystanie z Whispera w swoich projektach Python.

Zacznij od zaimportowania biblioteki Whisper i załadowania modelu:

import whisper

# Załaduj wybrany model

model = whisper.load_model("base")

Zmień "base" na nazwę modelu odpowiednią dla Twojej aplikacji.

Whisper udostępnia prostą funkcję transcribe do konwersji plików audio na tekst.

Przykład: Transkrypcja angielskiego pliku audio

# Transkrybuj plik audio

result = model.transcribe("path/to/english_audio.mp3")

# Wyświetl transkrypcję

print(result["text"])

model.transcribe(): Przetwarza plik audio i zwraca słownik z transkrypcją i innymi danymi.result["text"]: Uzyskuje tekst transkrypcji z wyniku.Whisper potrafi tłumaczyć audio z różnych języków na angielski.

Przykład: Tłumaczenie hiszpańskiego audio na angielski

# Transkrybuj i przetłumacz hiszpańskie audio na angielski

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Wyświetl tłumaczenie

print(result["text"])

task="translate": Wskazuje modelowi, by tłumaczył audio na angielski zamiast transkrybować dosłownie.Whisper potrafi automatycznie wykrywać język, ale jego wskazanie może zwiększyć dokładność i szybkość.

Przykład: Transkrypcja francuskiego audio

# Transkrybuj francuskie audio, wskazując język

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Wyświetl transkrypcję

print(result["text"])

Whisper pozwala wykryć język mówiony w pliku za pomocą metody detect_language.

Przykład: Wykrywanie języka

# Załaduj i przetwórz audio

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Zamień na log-Mel spektrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Wykryj język

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Ładuje plik audio.whisper.pad_or_trim(): Dopasowuje długość audio do wymagań modelu.whisper.log_mel_spectrogram(): Konwertuje audio do formatu oczekiwanego przez model.model.detect_language(): Zwraca prawdopodobieństwa dla każdego języka i wybiera najbardziej prawdopodobny.Aby uzyskać większą kontrolę nad procesem transkrypcji, możesz korzystać z funkcji niskopoziomowych i dostosowywać opcje dekodowania.

decodeFunkcja decode pozwala określić opcje takie jak język, zadanie czy obecność znaczników czasu.

Przykład: Własne opcje dekodowania

# Ustaw opcje dekodowania

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Dekoduj audio

result = whisper.decode(model, mel, options)

# Wyświetl rozpoznany tekst

print(result.text)

Możesz zintegrować Whispera do transkrypcji dźwięku z mikrofonu w czasie rzeczywistym.

Przykład: Transkrypcja dźwięku z mikrofonu

import whisper

import sounddevice as sd

# Załaduj model

model = whisper.load_model("base")

# Nagrywaj audio z mikrofonu

duration = 5 # sekundy

fs = 16000 # Próbkowanie

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper to zaawansowany system automatycznego rozpoznawania mowy (ASR) opracowany przez OpenAI, zaprojektowany do transkrypcji mowy na tekst pisany przy użyciu głębokiego uczenia. Obsługuje 99 języków i doskonale sprawdza się w transkrypcji, tłumaczeniu oraz identyfikacji języka.

Whisper wykorzystuje architekturę typu encoder-decoder bazującą na transformerach, przetwarza audio do postaci log-Mel spektrogramów i generuje tekst za pomocą modelu językowego. Model był trenowany na 680 000 godzin wielojęzycznych, wielozadaniowych danych, aby zapewnić wysoką dokładność i odporność.

Whisper obsługuje wielojęzyczne rozpoznawanie mowy, tłumaczenie mowy, automatyczną identyfikację języka, odporność na akcenty i szumy oraz zapewnia dostęp open-source do personalizacji i integracji.

Wymagania sprzętowe zależą od rozmiaru modelu: mniejsze modele jak 'tiny' wymagają ~1GB VRAM, a największy około ~10GB. Whisper działa szybciej na GPU, ale może pracować także na CPU, choć przetwarzanie trwa wtedy dłużej.

Tak, Whisper jest zaimplementowany jako biblioteka Pythona i można go zainstalować przez pip. Umożliwia łatwą integrację z projektami Python do transkrypcji mowy, tłumaczenia i aplikacji głosowych w czasie rzeczywistym.

Typowe zastosowania to automatyczna transkrypcja spotkań, chatboty obsługujące głos, tłumaczenie na żywo, narzędzia dostępności (napisy i wsparcie asystujące), automatyzacja call center oraz systemy automatyzacji sterowane głosem.

Tak, alternatywami są silniki open-source, takie jak Mozilla DeepSpeech, Kaldi, Wav2vec, oraz komercyjne API jak Google Cloud Speech-to-Text, Microsoft Azure AI Speech i AWS Transcribe.

Tak, OpenAI Whisper jest open-source, co pozwala programistom na personalizację, dostrajanie i integrację z własnymi produktami i usługami bez ograniczeń licencyjnych.

Zintegruj zaawansowane funkcje zamiany mowy na tekst w swoich aplikacjach, automatyzuj procesy i zwiększ komfort użytkowników dzięki OpenAI Whisper i FlowHunt.

FlowHunt obsługuje dziesiątki modeli generowania tekstu, w tym modele OpenAI. Oto jak używać ChatGPT w swoich narzędziach AI i chatbotach.

Duży model językowy (LLM) to rodzaj sztucznej inteligencji, trenowany na ogromnych zbiorach tekstowych, aby rozumieć, generować i przetwarzać ludzki język. LLM-...

Poznaj, jak zaawansowane możliwości rozumowania i uczenie przez wzmacnianie w OpenAI O1 przewyższają GPT4o pod kątem dokładności RAG, poparte benchmarkami i ana...