iTerm MCP Server

Serwer iTerm MCP umożliwia bezproblemową integrację pomiędzy asystentami AI a iTerm2 na macOS, pozwalając na programowalną automatyzację terminala, zarządzanie ...

Umożliwiaj asystentom AI bezpieczną i wydajną interakcję z terminalem iTerm w celu usprawnionego rozwoju, automatyzacji REPL i wykonywania poleceń.

FlowHunt zapewnia dodatkową warstwę bezpieczeństwa między Twoimi systemami wewnętrznymi a narzędziami AI, dając Ci szczegółową kontrolę nad tym, które narzędzia są dostępne z Twoich serwerów MCP. Serwery MCP hostowane w naszej infrastrukturze można bezproblemowo zintegrować z chatbotem FlowHunt oraz popularnymi platformami AI, takimi jak ChatGPT, Claude i różne edytory AI.

iterm-mcp MCP Server to serwer Model Context Protocol zaprojektowany, by zapewnić asystentom AI bezpośredni dostęp do Twojej sesji iTerm. To potężne narzędzie umożliwia dużym modelom językowym (LLM) wykonywanie poleceń, interakcję z REPL oraz zarządzanie przepływami pracy w aktywnym terminalu iTerm. Łącząc klientów AI ze środowiskiem terminala, iterm-mcp usprawnia procesy deweloperskie poprzez naturalny, współdzielony dostęp — ułatwiając wykonywanie poleceń powłoki, inspekcję wyjścia terminala czy wysyłanie znaków sterujących (np. sygnałów przerwania). Efektywne wykorzystanie tokenów sprawia, że udostępniane są tylko istotne wyjścia, a minimalne zależności pozwalają na łatwą integrację z platformami takimi jak Claude Desktop i innymi klientami obsługującymi MCP, upraszczając wsparcie CLI i REPL dla deweloperów.

W repozytorium nie udokumentowano szablonów promptów.

W repozytorium nie udokumentowano jawnych zasobów.

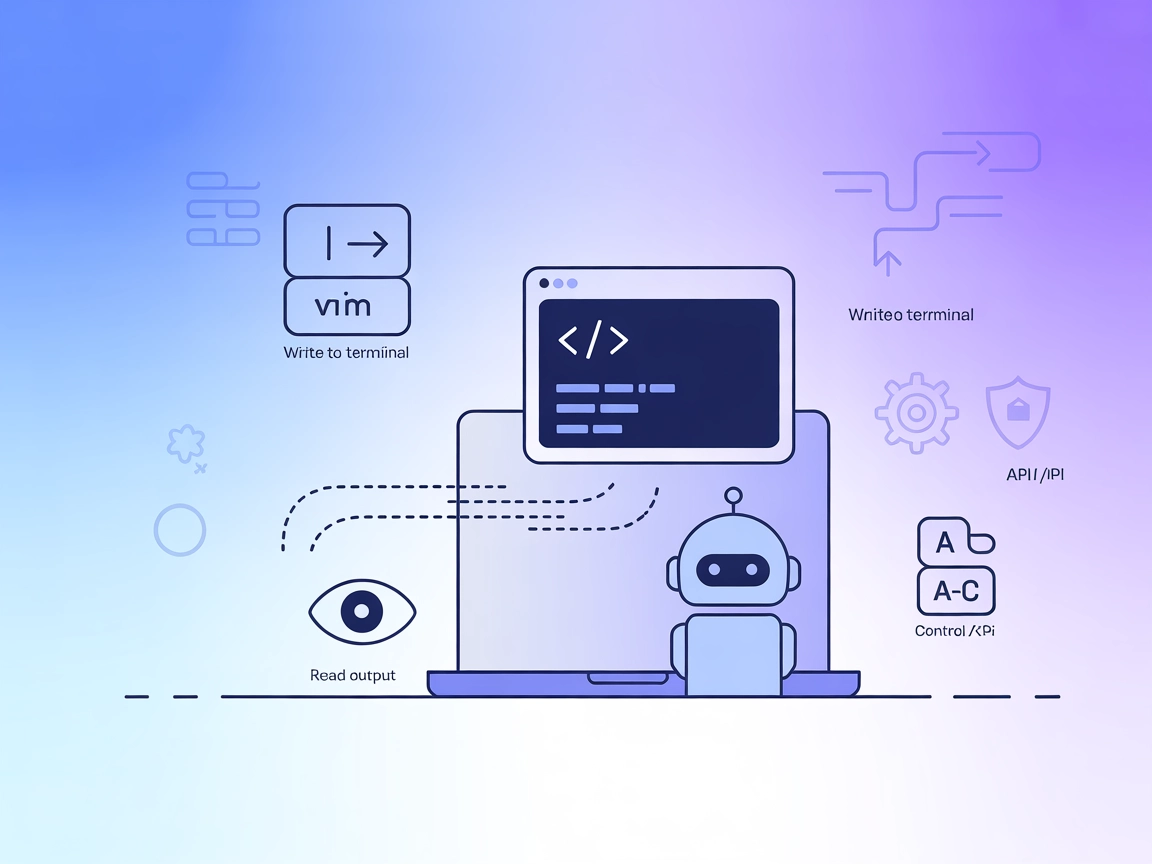

write_to_terminal

Wpisuje dane do aktywnej sesji terminala iTerm. Najczęściej używane do uruchamiania poleceń powłoki i zwraca liczbę wygenerowanych linii wyjścia.

read_terminal_output

Odczytuje określoną liczbę linii z aktywnego wyjścia terminala iTerm, pozwalając modelom na pobranie ostatnich działań w terminalu.

send_control_character

Wysyła znaki sterujące (jak Ctrl+C lub Ctrl+Z) do aktywnego terminala iTerm, umożliwiając przerywanie lub wstrzymywanie procesów.

Automatyzacja i wsparcie REPL

Pozwala LLM-om na interakcję z aktywnymi sesjami REPL, wykonywanie poleceń, inspekcję wyników i zarządzanie wieloetapowymi przepływami w sposób interaktywny.

Automatyzacja przepływów CLI

Umożliwia agentom AI wykonywanie i monitorowanie poleceń powłoki, automatyzację rutynowych zadań deweloperskich oraz obsługę parsowania wyników czy błędów.

Inspekcja wyjścia terminala

Modele mogą analizować bieżące lub wcześniejsze wyjście terminala, odpowiadać na pytania dotyczące zawartości ekranu oraz wspierać debugowanie lub analizę logów.

Zarządzanie procesami

Dzięki znakom sterującym deweloperzy mogą przekazać zadania przerywania, wstrzymywania lub wznawiania procesów asystentom AI, poprawiając bezpieczeństwo pracy.

Wykonywanie i testowanie kodu

Umożliwia uruchamianie fragmentów kodu lub skryptów bezpośrednio w terminalu, z możliwością przechwytywania wyników przez model AI i iteracji na ich podstawie.

mcpServers:{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": [

"-y",

"iterm-mcp"

]

}

}

}

Zabezpieczanie kluczy API:

Jeśli serwer wymaga zmiennych środowiskowych lub sekretów, dodaj je w następujący sposób:

{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": ["-y", "iterm-mcp"],

"env": {

"MY_SECRET_KEY": "value"

}

}

}

}

~/Library/Application Support/Claude/claude_desktop_config.json (macOS)%APPDATA%/Claude/claude_desktop_config.json (Windows)mcpServers:{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": [

"-y",

"iterm-mcp"

]

}

}

}

Zabezpieczanie kluczy API:

Sekrety dodaj w obiekcie env w razie potrzeby.

{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": [

"-y",

"iterm-mcp"

]

}

}

}

Zabezpieczanie kluczy API:

Dodaj sekrety poprzez atrybut env.

{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": [

"-y",

"iterm-mcp"

]

}

}

}

Zabezpieczanie kluczy API:

Skonfiguruj sekrety jako zmienne środowiskowe w konfiguracji, np.:

{

"mcpServers": {

"iterm-mcp": {

"command": "npx",

"args": ["-y", "iterm-mcp"],

"env": {

"MY_SECRET_KEY": "value"

}

}

}

}

Korzystanie z MCP w FlowHunt

Aby zintegrować serwery MCP z przepływem pracy w FlowHunt, dodaj komponent MCP do swojego flow i połącz go z agentem AI:

Kliknij w komponent MCP, by otworzyć panel konfiguracji. W sekcji konfiguracji systemowej MCP wklej szczegóły serwera MCP w tym formacie JSON:

{

"iterm-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Po skonfigurowaniu agent AI może korzystać z tego MCP jako narzędzia ze wszystkimi jego funkcjami i możliwościami. Pamiętaj, by zmienić “MCP-name” na własną nazwę serwera MCP (np. “github-mcp”, “weather-api” itd.) oraz podać własny adres URL serwera MCP.

| Sekcja | Dostępność | Szczegóły/Uwagi |

|---|---|---|

| Podsumowanie | ✅ | |

| Lista promptów | ⛔ | Brak udokumentowanych szablonów promptów |

| Lista zasobów | ⛔ | Brak udokumentowanych zasobów |

| Lista narzędzi | ✅ | write_to_terminal, read_terminal_output, send_control_character |

| Zabezpieczanie kluczy API | ✅ | Przykłady konfiguracji z env udokumentowane |

| Obsługa sampling (mniej ważne w ocenie) | ⛔ | Brak wzmianki o wsparciu samplingu |

Na podstawie dostępnych informacji, iterm-mcp oferuje solidną integrację z terminalem i udostępnia narzędzia, wraz z jasnymi instrukcjami konfiguracji i wskazówkami bezpieczeństwa, ale nie posiada udokumentowanych szablonów promptów, jawnych zasobów ani zaawansowanych funkcji MCP, takich jak roots czy sampling. Dzięki temu świetnie sprawdzi się w pracy skoncentrowanej na terminalu, lecz ma mniej funkcji dla szerszych zastosowań MCP.

| Posiada LICENCJĘ | ✅ (MIT) |

|---|---|

| Czy ma przynajmniej jedno narzędzie | ✅ |

| Liczba forków | 32 |

| Liczba gwiazdek | 360 |

iterm-mcp to serwer Model Context Protocol, który umożliwia asystentom AI bezpośredni dostęp i interakcję z Twoją sesją terminala iTerm. Pozwala na wykonywanie poleceń, automatyzację REPL, inspekcję wyjścia terminala oraz zarządzanie procesami poprzez bezpieczną, uproszczoną integrację.

iterm-mcp udostępnia narzędzia, takie jak write_to_terminal (uruchamianie poleceń powłoki), read_terminal_output (pobieranie ostatniego wyjścia terminala) oraz send_control_character (wysyłanie sygnałów, takich jak Ctrl+C lub Ctrl+Z do zarządzania procesami).

Możesz zintegrować iterm-mcp z Windsurf, Claude Desktop, Cursor i Cline. Każda platforma wymaga prostej aktualizacji konfiguracji w celu dodania serwera MCP.

Dodaj sekrety lub zmienne środowiskowe w obiekcie `env` w konfiguracji serwera MCP. W ten sposób poufne dane pozostają chronione podczas działania.

iterm-mcp idealnie sprawdza się do automatyzacji REPL, automatyzacji przepływów CLI, inspekcji wyjścia terminala, zarządzania procesami oraz wykonywania i testowania kodu — wszystko dzięki terminalowi sterowanemu przez AI.

Zwiększ wydajność swoich przepływów CLI i automatyzuj sesje REPL, integrując iterm-mcp z FlowHunt. Podnieś produktywność dzięki płynnemu dostępowi do terminala wspieranemu przez AI.

Serwer iTerm MCP umożliwia bezproblemową integrację pomiędzy asystentami AI a iTerm2 na macOS, pozwalając na programowalną automatyzację terminala, zarządzanie ...

Terminal Controller MCP Server umożliwia bezpieczne wykonywanie poleceń terminalowych, nawigację po katalogach i operacje na systemie plików przez ustandaryzowa...

Serwer git-mcp-go MCP umożliwia płynną interakcję z repozytoriami Git przy użyciu dużych modeli językowych (LLM), pozwalając asystentom AI automatyzować zadania...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.