Analisador de Concorrentes de Anúncios do LinkedIn

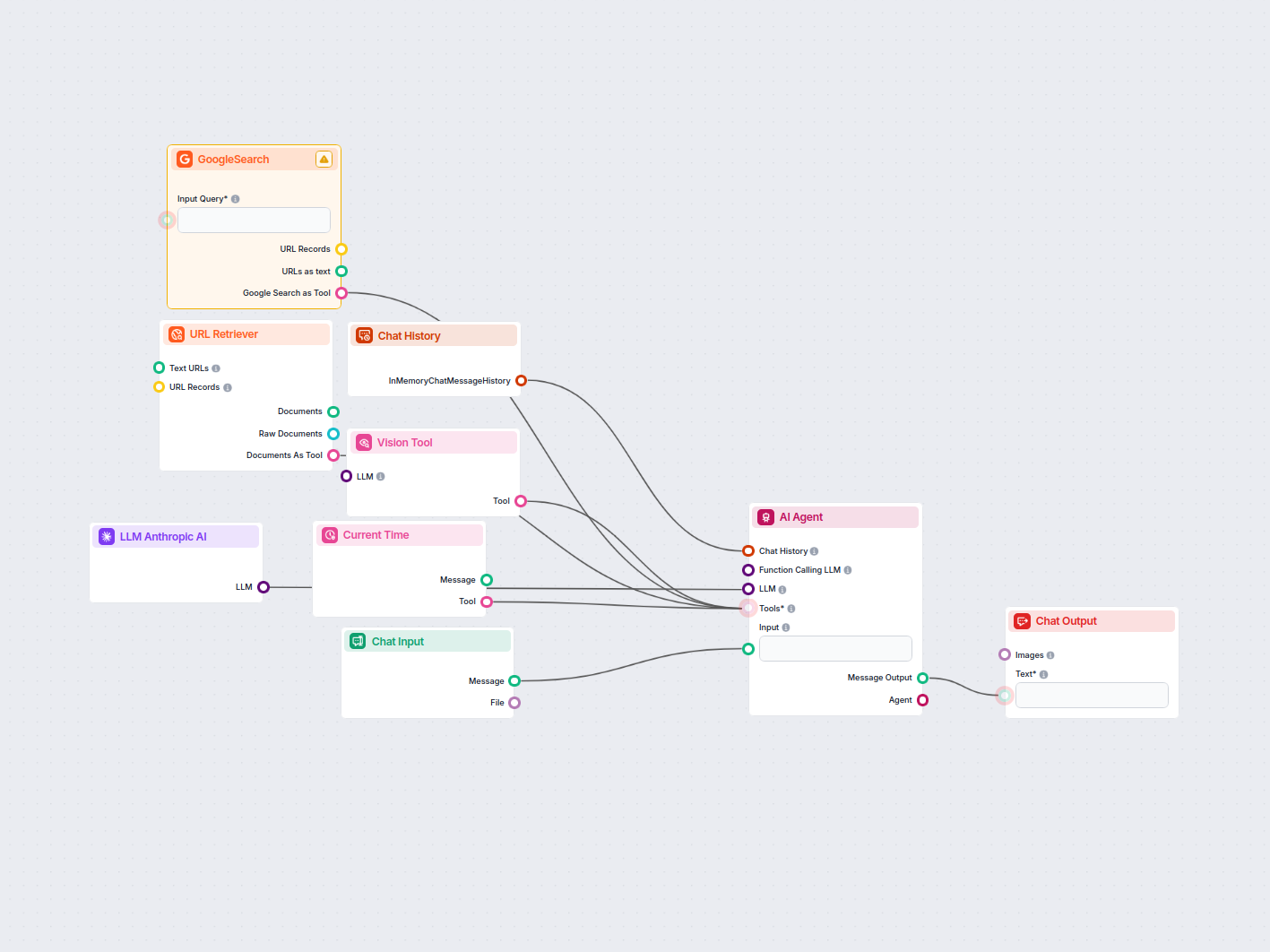

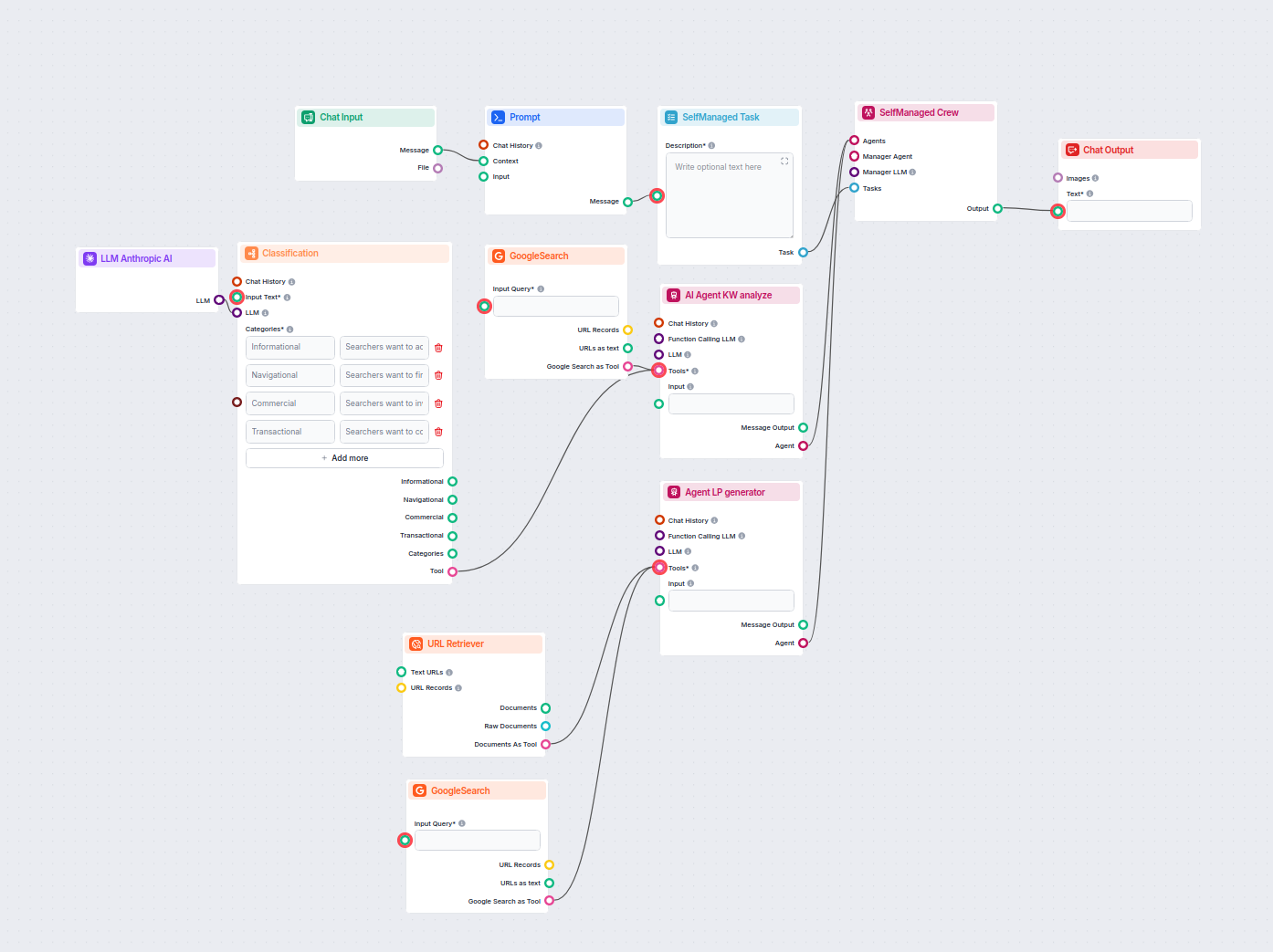

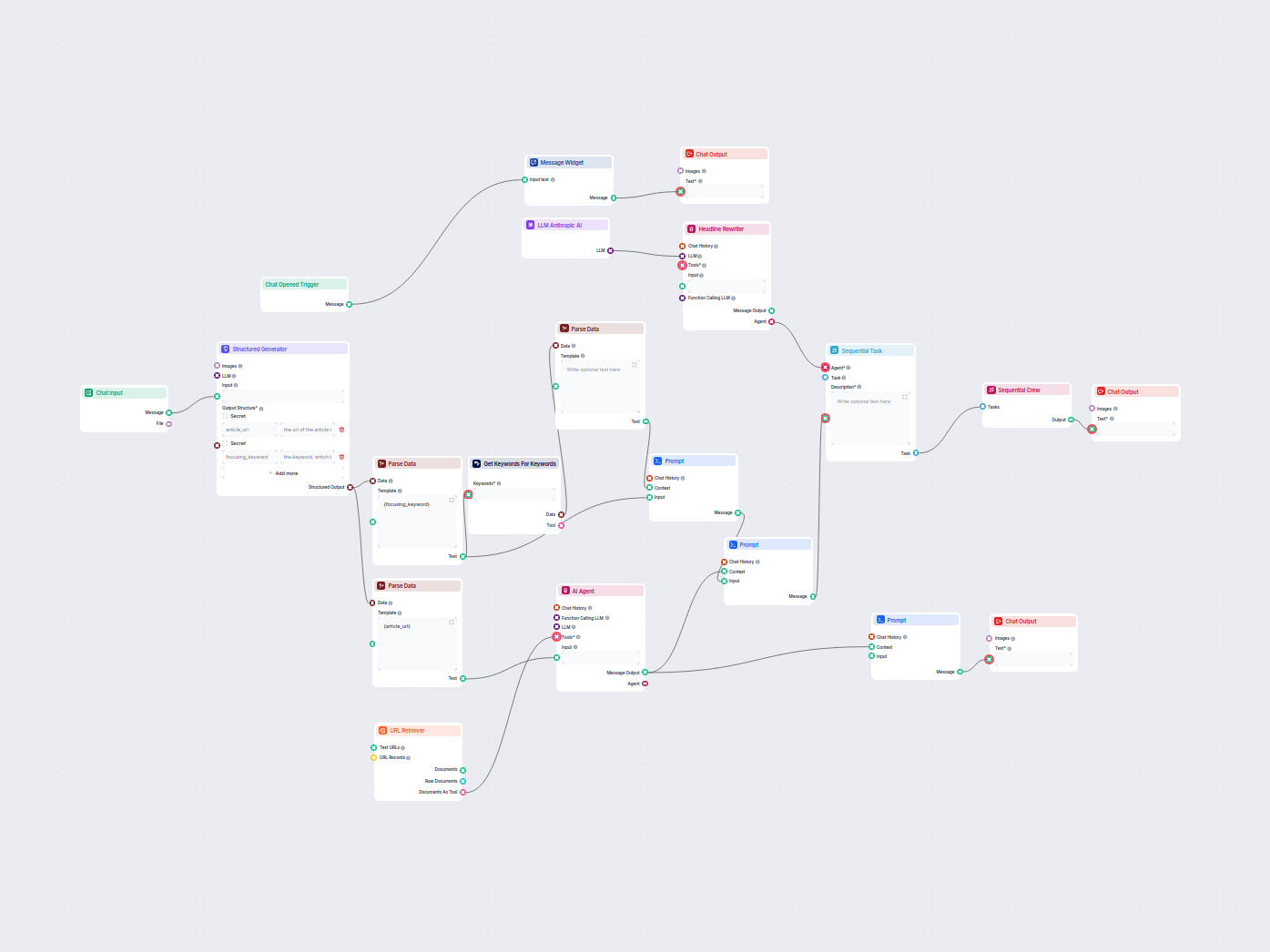

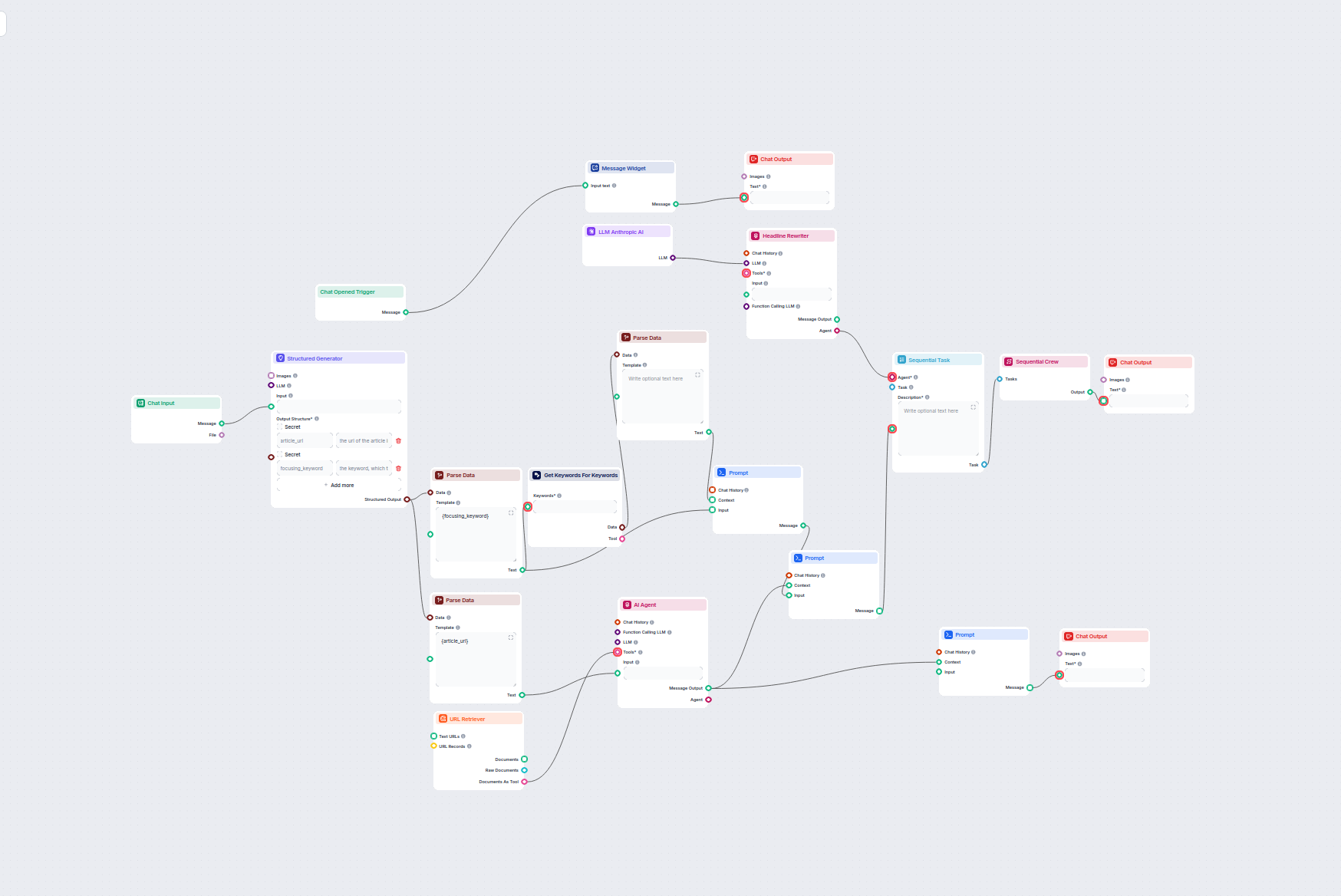

Este fluxo de trabalho automatiza a pesquisa de mercado de anúncios no LinkedIn ao identificar os principais concorrentes para uma palavra-chave, analisar os te...

Automação de IA

Conecte os modelos Claude da Anthropic ao seu painel FlowHunt para geração flexível de texto por IA e soluções de chatbot, com controle sobre tokens, temperatura e seleção do modelo.

Descrição do componente

Different tasks call for different models, and FlowHunt is committed to giving you the best of AI without the need to sign up for countless subscriptions. Instead, you get dozens of text and image generator models in a single dashboard. The LLM type of components houses text generation and their diverse applications in AI, content creation, and automation.") models grouped by provider, allowing you to swap AI models on the fly.

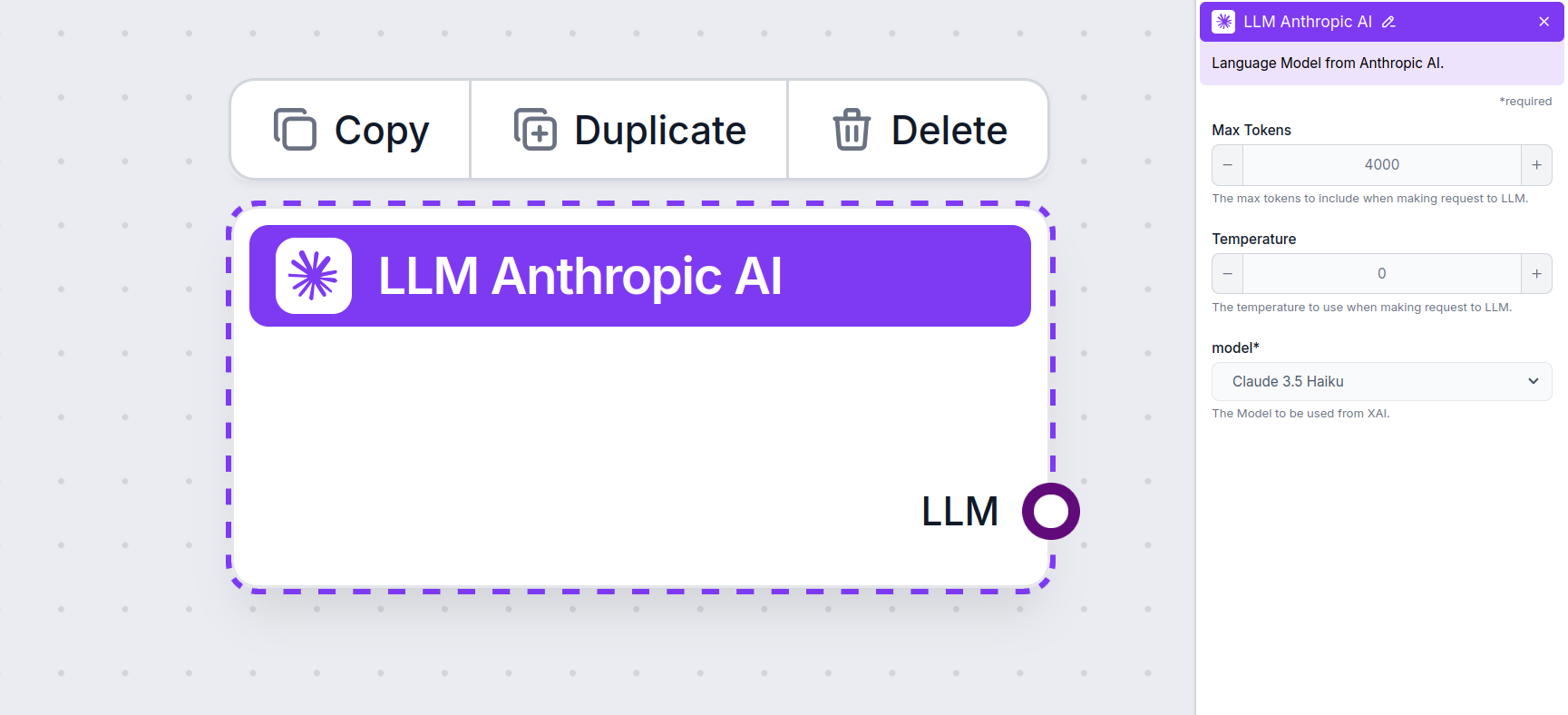

The LLM Anthropic AI component connects the Claude family of models to your flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to control the model used. All components come with ChatGPT-4 by default. You can connect this component if you wish to change the model or gain more control over it.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, which is the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported models from Anthropic. We currently support all the latest models from the Claude family:

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

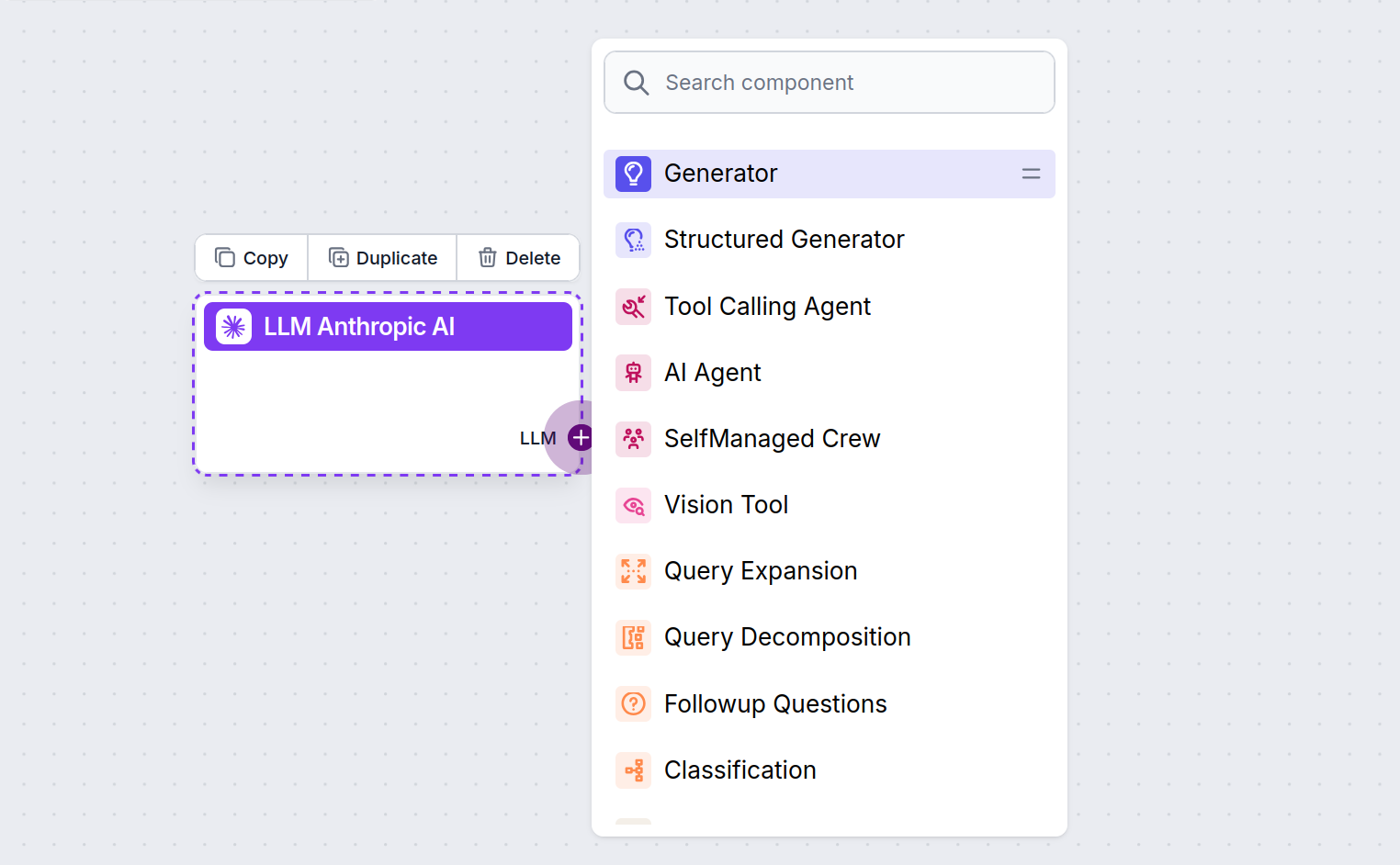

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

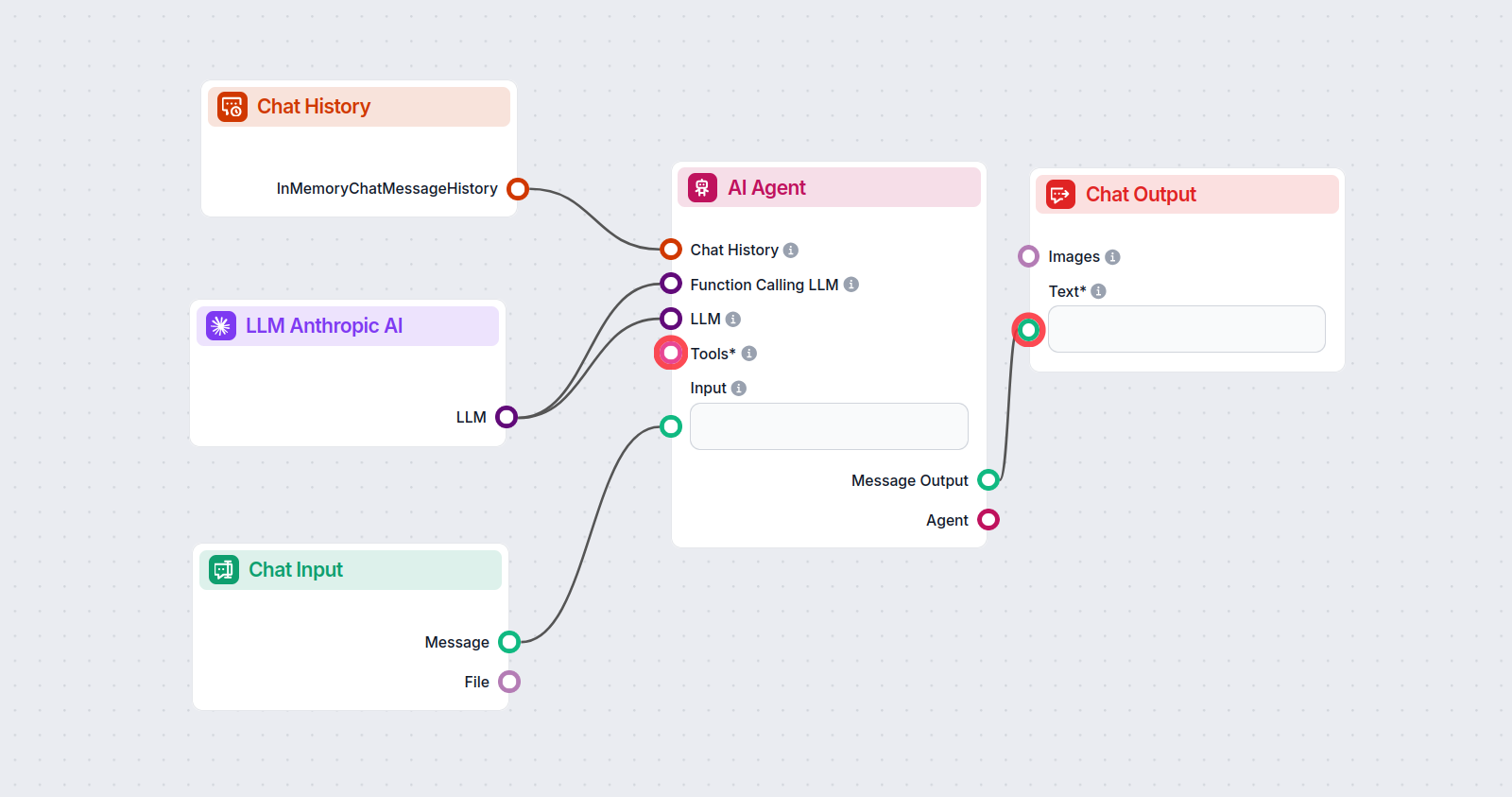

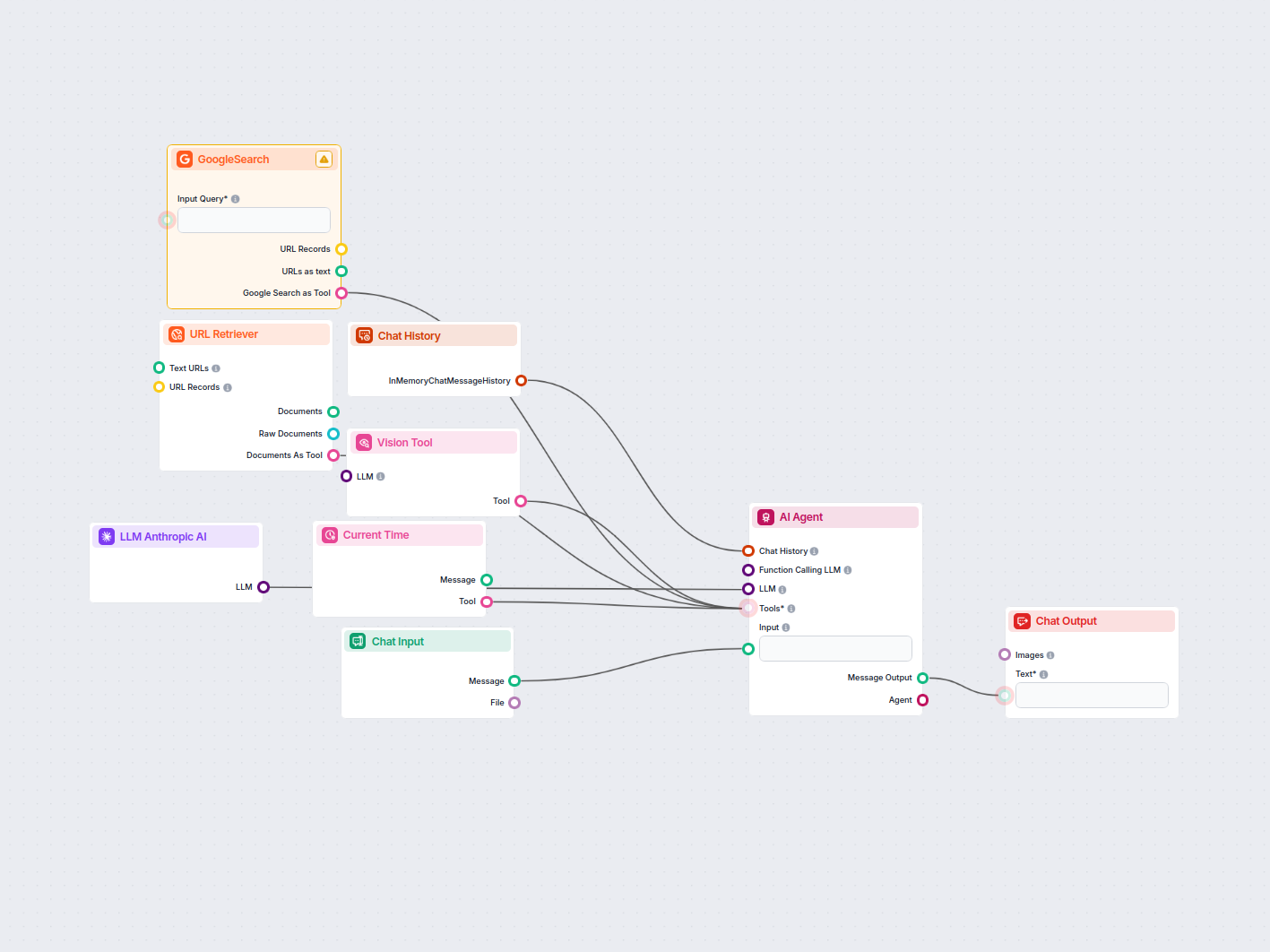

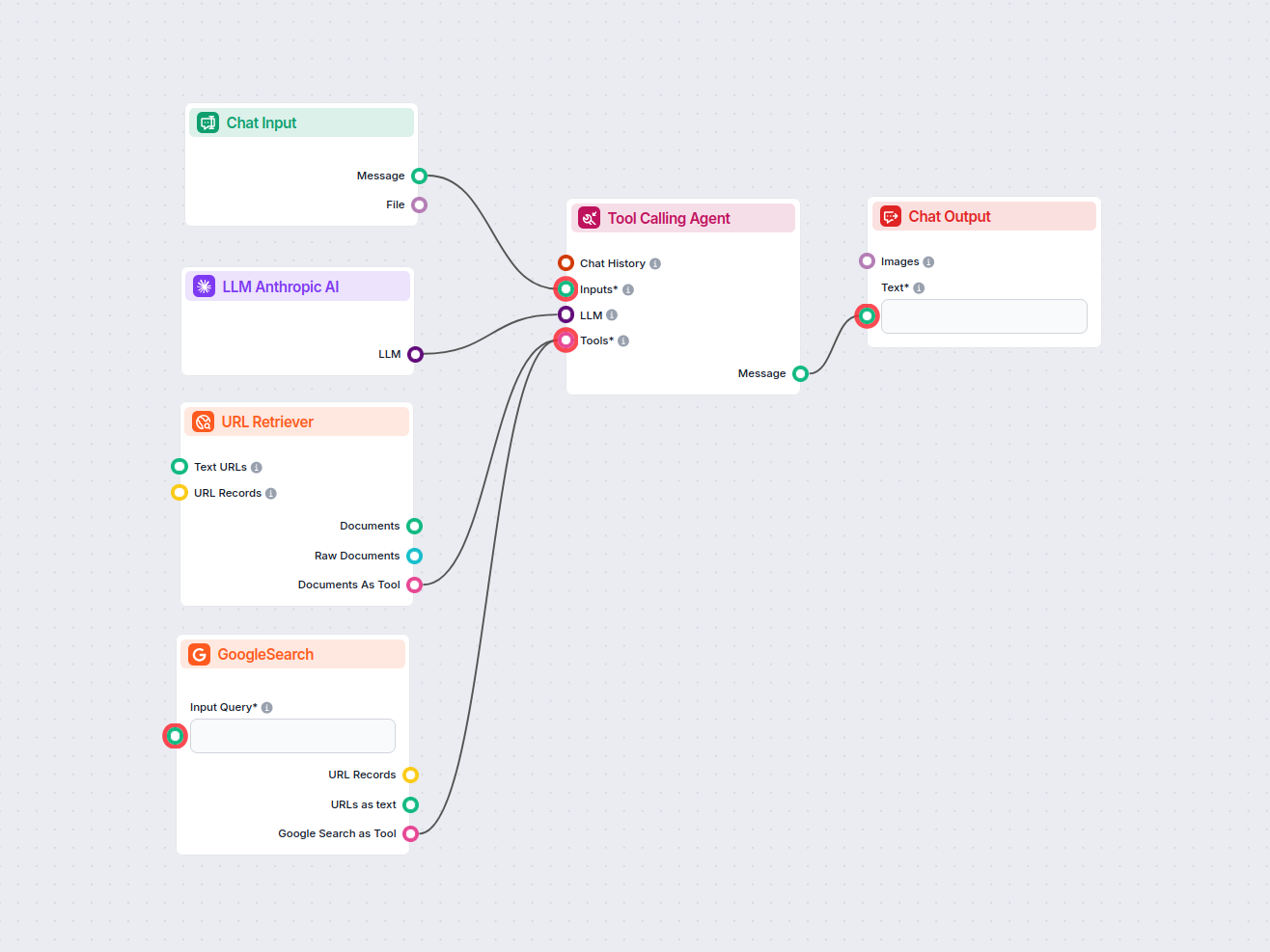

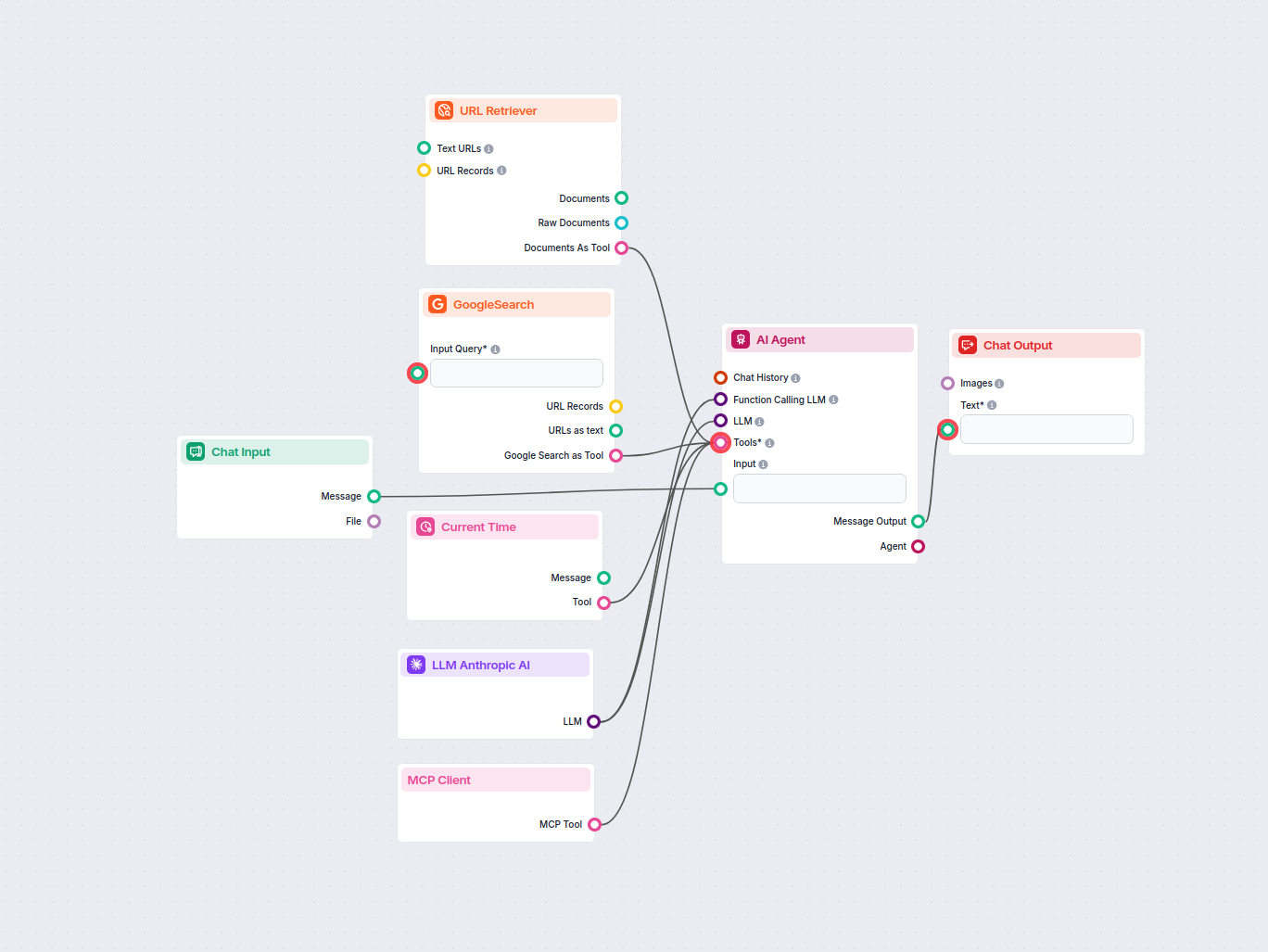

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow that’s using Anthropic’s Claude 3.5 Sonnet to generate responses. You can think of it as a basic Anthropic chatbot.

This simple Chatbot Flow includes:

Para ajudá-lo a começar rapidamente, preparamos vários modelos de fluxo de exemplo que demonstram como usar o componente LLM Anthropic AI de forma eficaz. Esses modelos apresentam diferentes casos de uso e melhores práticas, tornando mais fácil para você entender e implementar o componente em seus próprios projetos.

Este fluxo de trabalho automatiza a pesquisa de mercado de anúncios no LinkedIn ao identificar os principais concorrentes para uma palavra-chave, analisar os te...

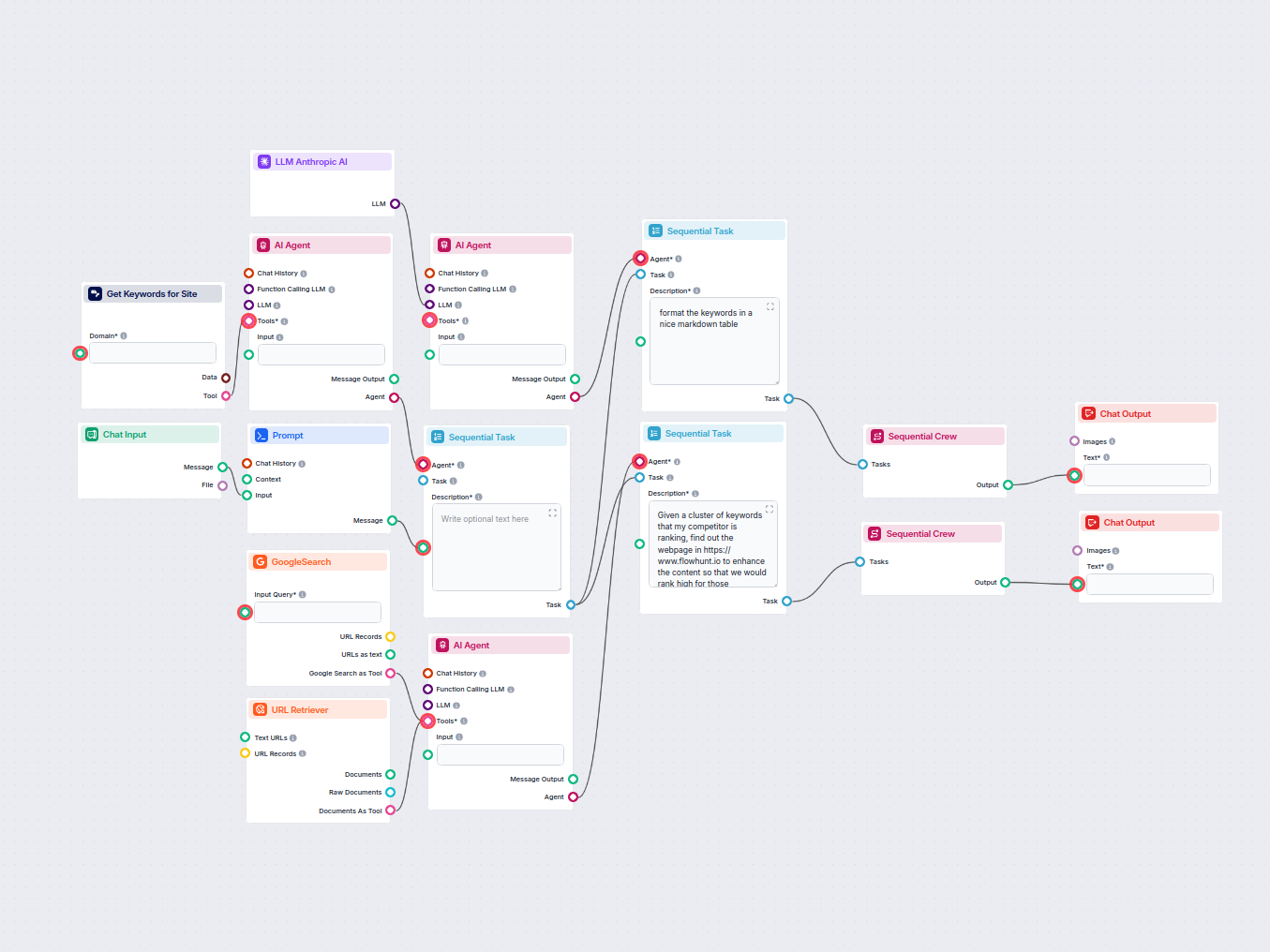

Analise automaticamente a URL da página inicial do seu concorrente para descobrir suas principais palavras-chave de ranqueamento, obtenha dados de palavras-chav...

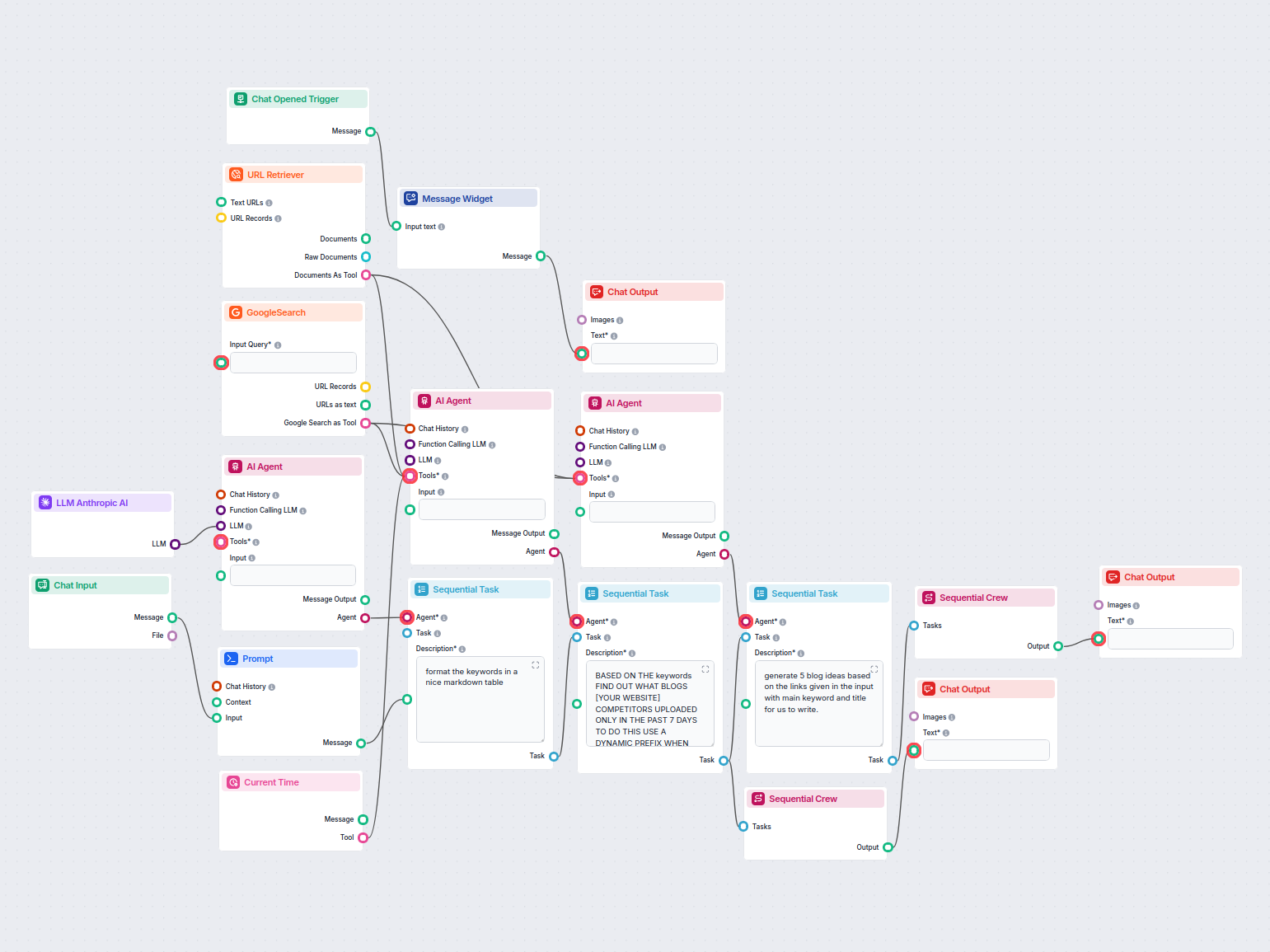

Analise automaticamente os blogs concorrentes de melhor classificação da última semana e gere novas ideias de blog para o seu site. Este fluxo de trabalho de IA...

Este fluxo de trabalho com IA aprimora descrições de produtos Shopify com base no nome do produto ou URL fornecido pelo usuário. Ele utiliza LLMs, recupera cont...

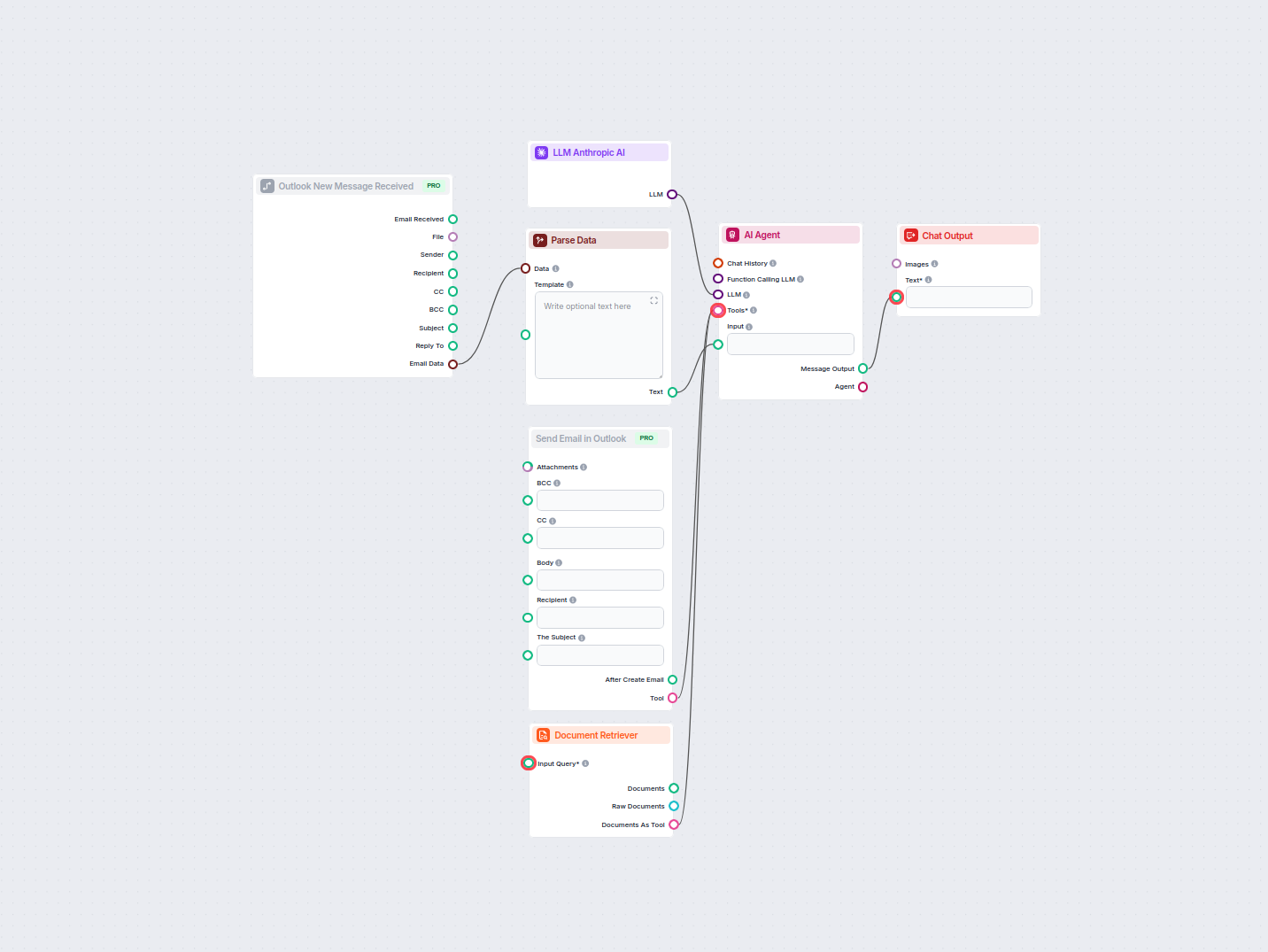

Automatize respostas profissionais de e-mail no Outlook usando um agente de IA que utiliza fontes de conhecimento organizacionais. E-mails recebidos são captura...

Este fluxo de trabalho com IA classifica as buscas por intenção, pesquisa as URLs mais bem ranqueadas e gera uma landing page altamente otimizada para campanhas...

Este fluxo de trabalho com IA classifica automaticamente e-mails recebidos como spam ou não, e encaminha de forma inteligente mensagens legítimas para um assist...

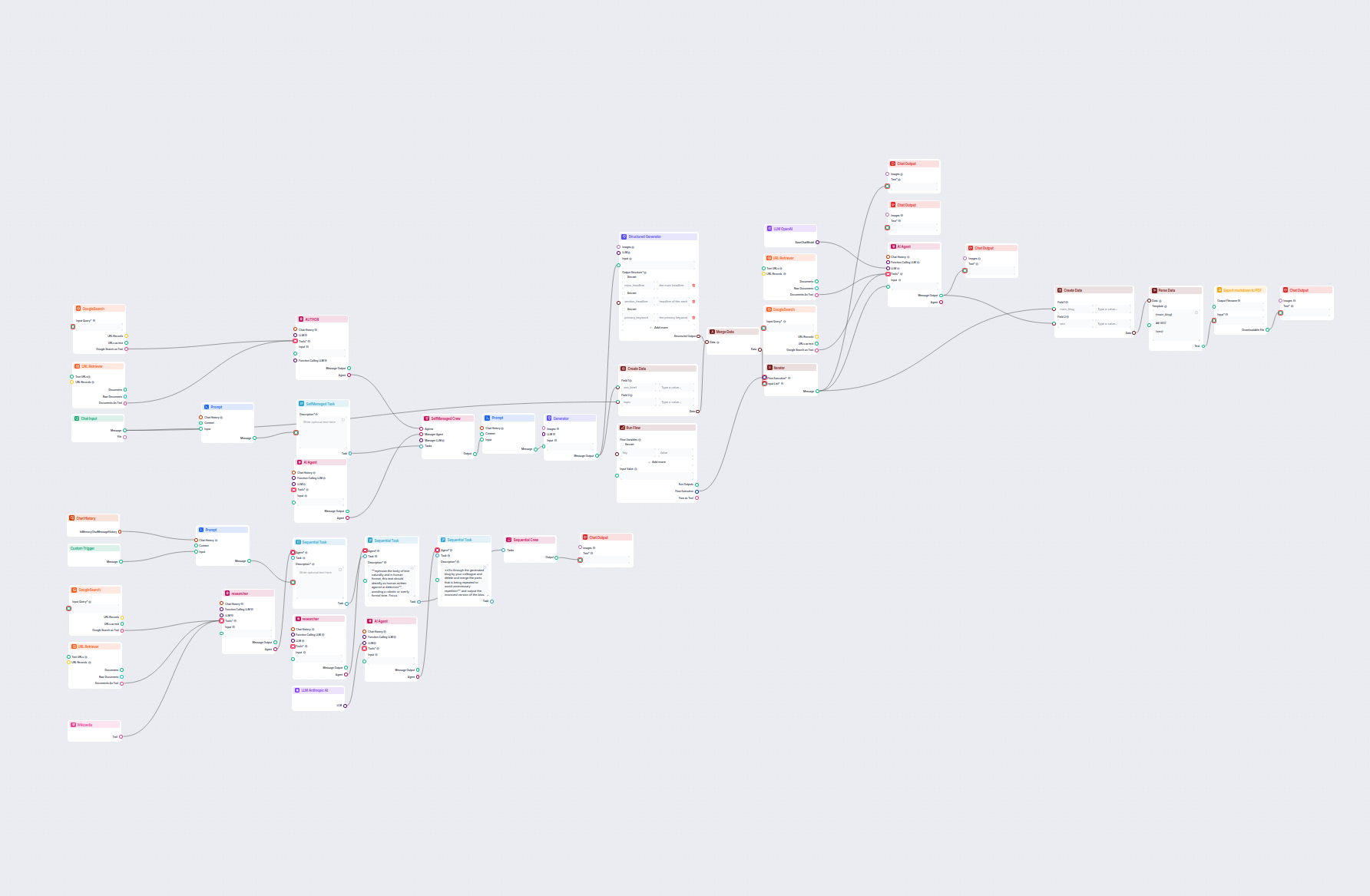

Gere posts de blog abrangentes e otimizados para SEO com estrutura avançada e alta contagem de palavras utilizando múltiplos agentes de IA. O fluxo inclui pesqu...

Gere automaticamente descrições otimizadas para SEO para páginas de categorias de e-commerce usando IA. Basta fornecer a URL da categoria e o fluxo de trabalho ...

Este fluxo de trabalho com IA pesquisa concorrentes e tópicos em alta para gerar ideias de blog de alto impacto e otimizadas para SEO para o FlowHunt.io. Utiliz...

Otimize automaticamente os títulos e manchetes do seu artigo para uma palavra-chave ou cluster de palavras-chave específico, melhorando o desempenho em SEO. Est...

Esse fluxo de trabalho movido por IA encontra as melhores palavras-chave de SEO para seu artigo de blog e reescreve automaticamente os títulos para direcionar e...

O componente LLM Anthropic AI conecta os modelos Claude da Anthropic aos seus fluxos no FlowHunt, permitindo que você personalize qual modelo será usado para geração de texto e controle configurações como máximo de tokens e temperatura.

O FlowHunt suporta todos os modelos mais recentes da família Claude, incluindo Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku e Claude 2.

O máximo de tokens define o limite de tamanho para cada resposta, enquanto a temperatura controla o grau de aleatoriedade — valores baixos tornam a saída mais focada, valores altos aumentam a criatividade.

Não, conectar o componente LLM Anthropic AI é opcional. Por padrão, os componentes usam o ChatGPT-4o, mas você pode adicionar este componente para alternar para modelos Claude e ajustar as configurações.

Comece a construir ferramentas e chatbots de IA personalizados usando os modelos Claude da Anthropic com fácil integração em fluxos e configuração poderosa.