LLM Gemini

O FlowHunt suporta dezenas de modelos de IA, incluindo o Google Gemini. Saiba como usar o Gemini em suas ferramentas e chatbots de IA, alternar entre modelos e ...

O LLM DeepSeek da FlowHunt permite acessar e personalizar os principais modelos de IA como o DeepSeek R1 para geração de texto e imagem em seus chatbots e ferramentas de IA, tudo a partir de um único painel.

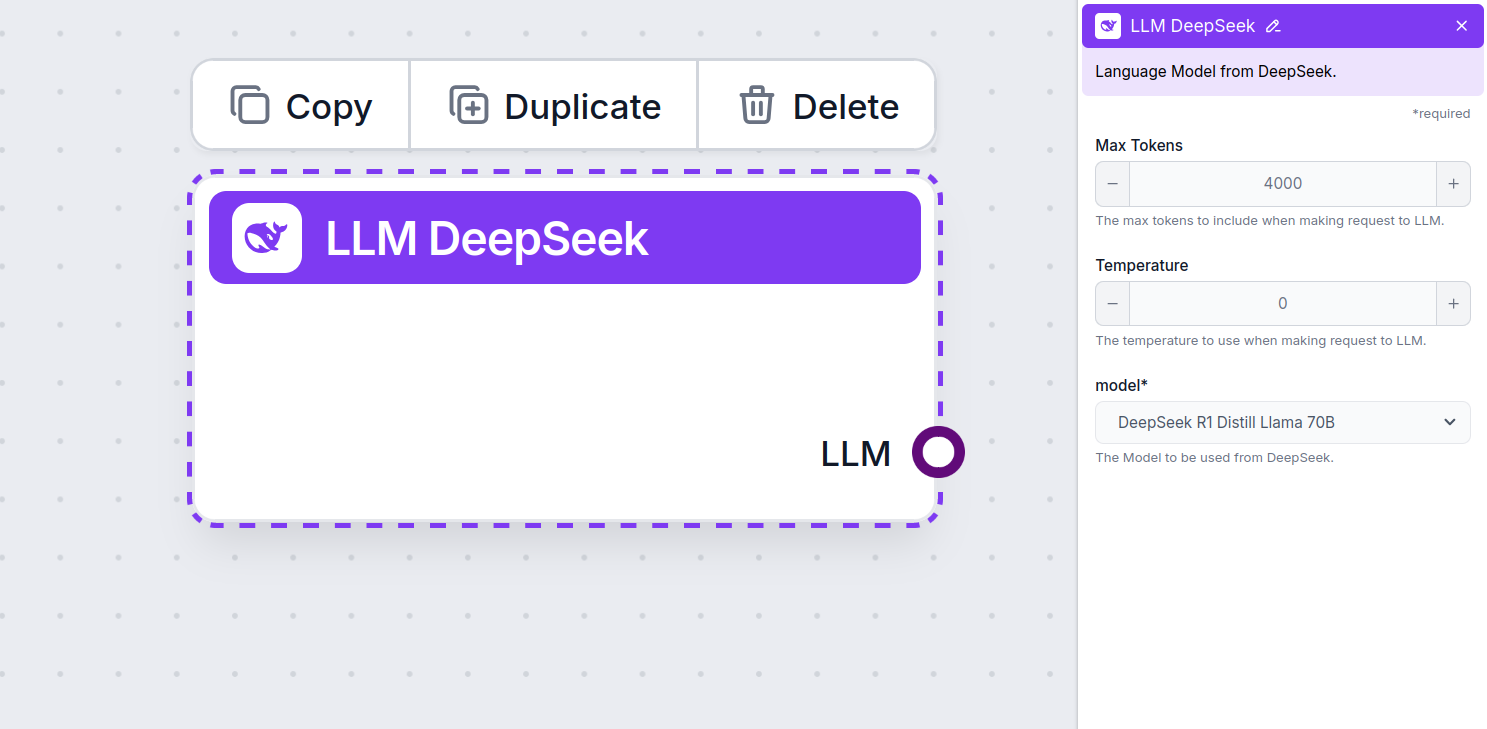

Descrição do componente

The LLM DeepSeek component connects the DeepSeek models to your Flow. While the Generators and Agents are where the actual magic happens, LLM components allow you to swap and control the model used.

Remember that connecting an LLM Component is optional. All components that use an LLM come with ChatGPT-4o as the default. The LLM components allow you to change the model and control model settings.

Tokens represent the individual units of text the model processes and generates. Token usage varies with models, and a single token can be anything from words or subwords to a single character. Models are usually priced in millions of tokens.

The max tokens setting limits the total number of tokens that can be processed in a single interaction or request, ensuring the responses are generated within reasonable bounds. The default limit is 4,000 tokens, the optimal size for summarizing documents and several sources to generate an answer.

Temperature controls the variability of answers, ranging from 0 to 1.

A temperature of 0.1 will make the responses very to the point but potentially repetitive and deficient.

A high temperature of 1 allows for maximum creativity in answers but creates the risk of irrelevant or even hallucinatory responses.

For example, the recommended temperature for a customer service bot is between 0.2 and 0.5. This level should keep the answers relevant and to the script while allowing for a natural response variation.

This is the model picker. Here, you’ll find all the supported DeepSeek models. We support all the latest Gemini models:

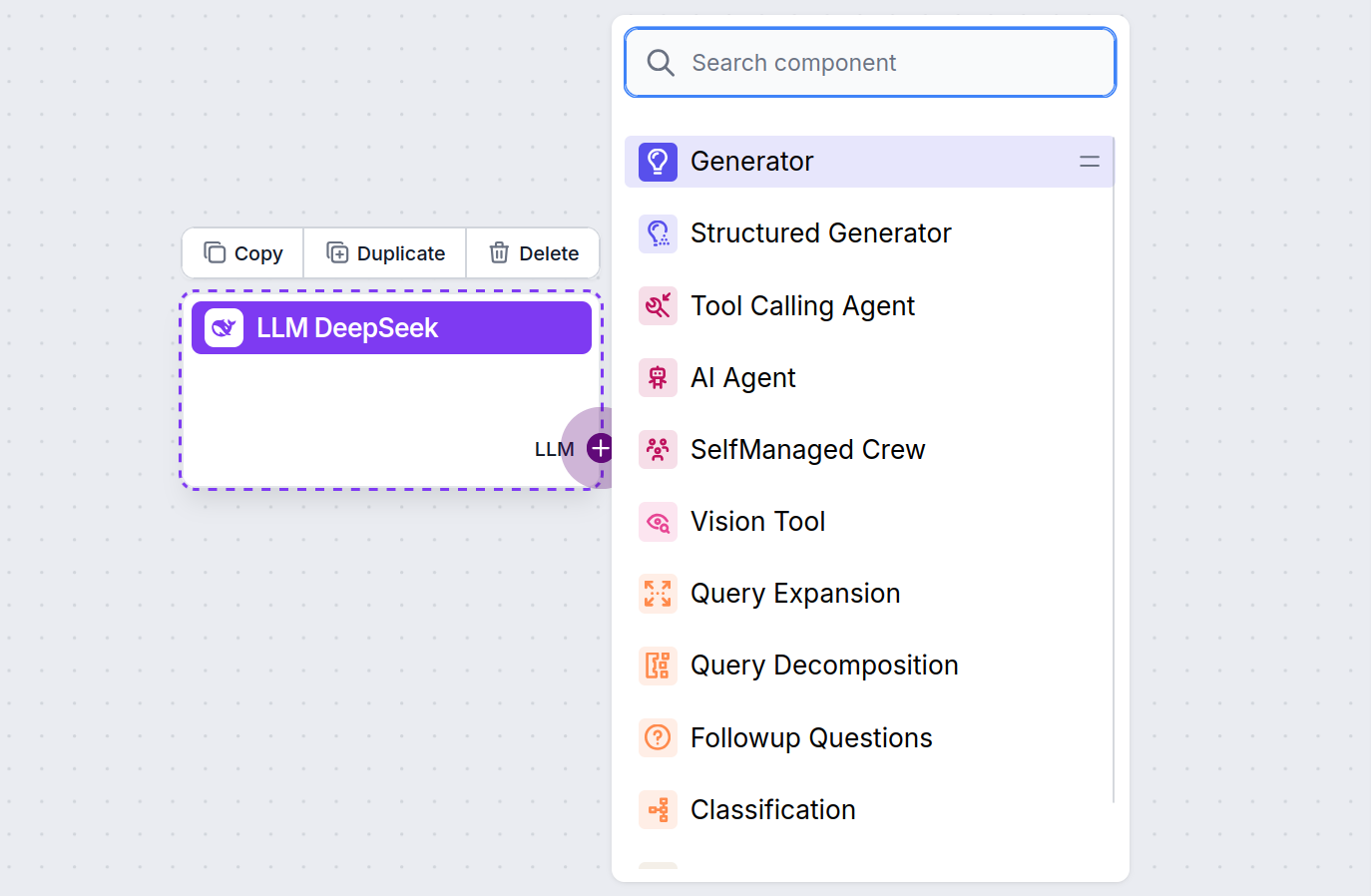

You’ll notice that all LLM components only have an output handle. Input doesn’t pass through the component, as it only represents the model, while the actual generation happens in AI Agents and Generators.

The LLM handle is always purple. The LLM input handle is found on any component that uses AI to generate text or process data. You can see the options by clicking the handle:

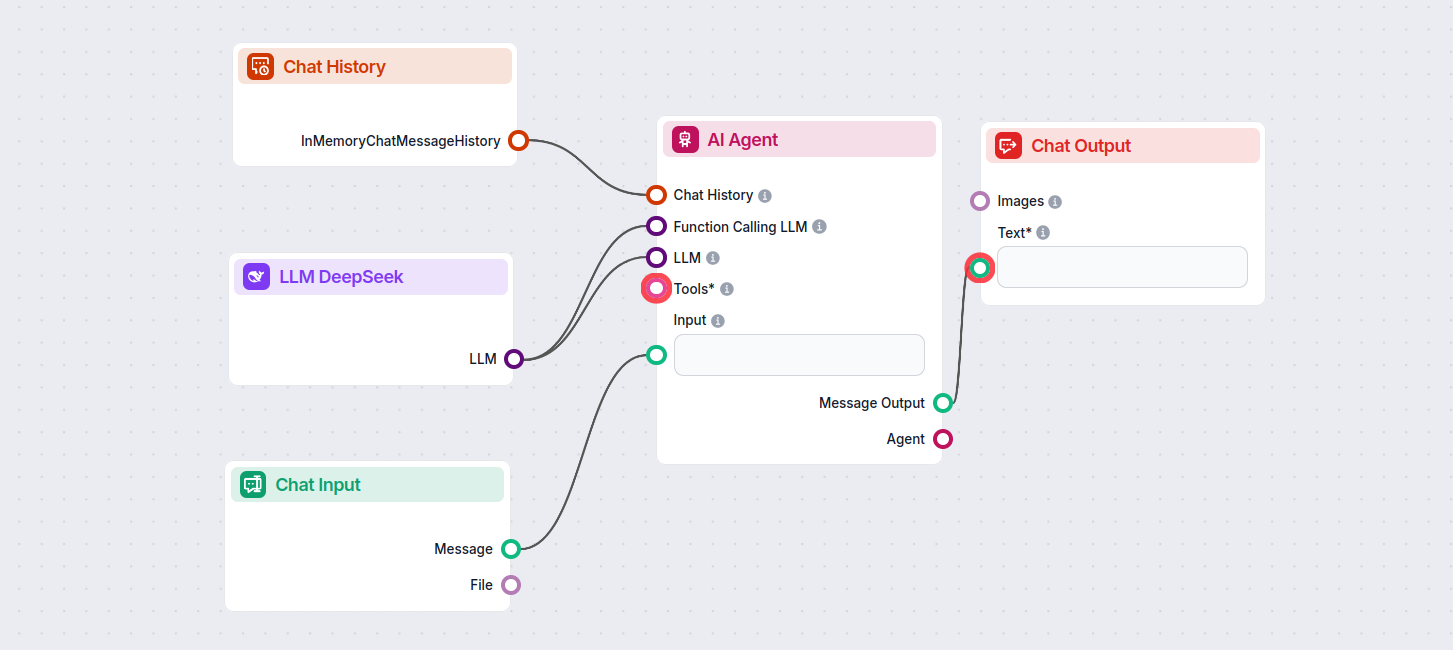

This allows you to create all sorts of tools. Let’s see the component in action. Here’s a simple AI Agent chatbot Flow using DeepSeek R1 to generate responses. You can think of it as a basic DeepSeek chatbot.

This simple Chatbot Flow includes:

O LLM DeepSeek é um componente do FlowHunt que permite conectar e controlar modelos de IA DeepSeek para geração de texto e imagem, possibilitando chatbots poderosos e fluxos automatizados.

O FlowHunt suporta todos os modelos DeepSeek mais recentes, incluindo o DeepSeek R1, conhecido por sua velocidade e desempenho, especialmente em comparação com outros modelos líderes de IA.

Você pode ajustar o máximo de tokens para o comprimento das respostas e a temperatura para criatividade das respostas, além de alternar entre os modelos DeepSeek disponíveis diretamente no painel do FlowHunt.

Não, conectar um componente LLM é opcional. Por padrão, o FlowHunt utiliza o ChatGPT-4o, mas adicionar o LLM DeepSeek permite que você troque e controle qual modelo de IA alimenta seus fluxos.

Comece a construir chatbots de IA e ferramentas de automação mais inteligentes usando os avançados modelos DeepSeek—tudo sem configuração complexa ou várias assinaturas.

O FlowHunt suporta dezenas de modelos de IA, incluindo o Google Gemini. Saiba como usar o Gemini em suas ferramentas e chatbots de IA, alternar entre modelos e ...

O FlowHunt suporta dezenas de modelos de geração de texto, incluindo modelos da xAI. Veja como usar os modelos da xAI em suas ferramentas de IA e chatbots.

O FlowHunt suporta dezenas de modelos de geração de texto, incluindo os modelos Llama da Meta. Saiba como integrar o Llama às suas ferramentas e chatbots de IA,...