Redes Neurais

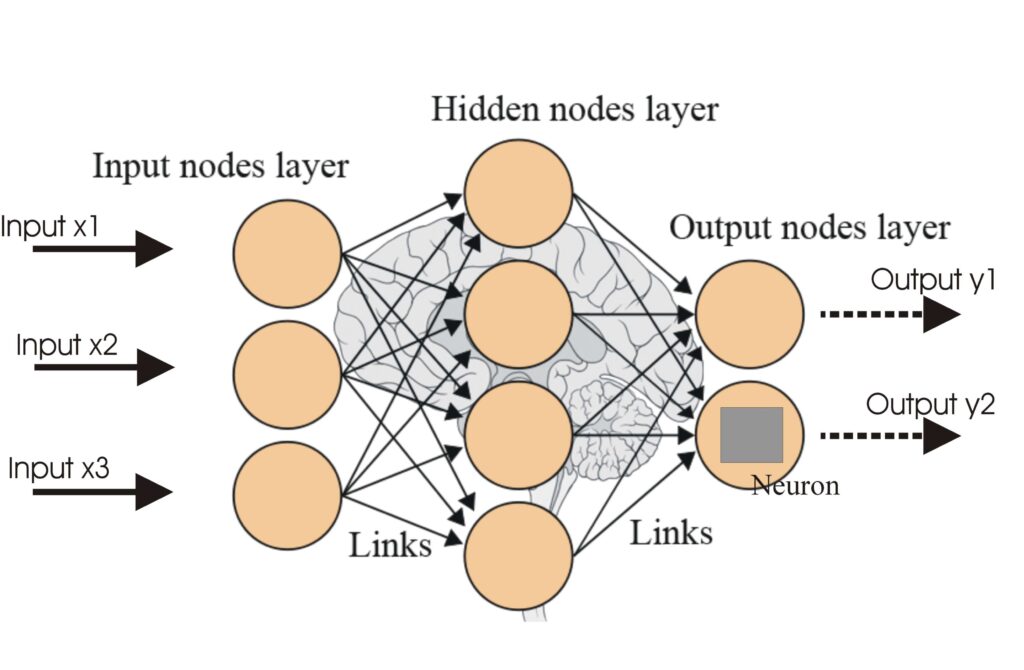

Uma rede neural, ou rede neural artificial (RNA), é um modelo computacional inspirado no cérebro humano, essencial em IA e aprendizado de máquina para tarefas c...

Funções de ativação introduzem não linearidade em redes neurais, permitindo que aprendam padrões complexos essenciais para aplicações de IA e deep learning.

Funções de ativação são fundamentais para a arquitetura das redes neurais artificiais (RNAs), influenciando significativamente a capacidade da rede de aprender e executar tarefas complexas. Este artigo do glossário aprofunda-se nas complexidades das funções de ativação, examinando seu propósito, tipos e aplicações, especialmente nos domínios de IA, deep learning e redes neurais.

Uma função de ativação em uma rede neural é uma operação matemática aplicada à saída de um neurônio. Ela determina se um neurônio deve ser ativado ou não, introduzindo não linearidade ao modelo, o que permite que a rede aprenda padrões complexos. Sem essas funções, uma rede neural essencialmente agiria como um modelo de regressão linear, independentemente de sua profundidade ou número de camadas.

Função Sigmoid

Função Tanh

ReLU (Unidade Linear Retificada)

Leaky ReLU

Função Softmax

Função Swish

As funções de ativação são essenciais para várias aplicações de IA, incluindo:

Uma função de ativação é uma operação matemática aplicada à saída de um neurônio, introduzindo não linearidade e permitindo que redes neurais aprendam padrões complexos além de simples relações lineares.

Funções de ativação permitem que redes neurais solucionem problemas complexos e não lineares ao possibilitar o aprendizado de padrões intrincados, sendo cruciais para tarefas como classificação de imagens, processamento de linguagem e automação.

Tipos comuns incluem Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax e Swish, cada um com características e usos específicos em diferentes camadas de redes neurais.

Desafios comuns incluem o problema do gradiente desaparecendo (especialmente com Sigmoid e Tanh), o dying ReLU e o custo computacional de funções como Softmax em aplicações em tempo real.

Chatbots inteligentes e ferramentas de IA em um só lugar. Conecte blocos intuitivos para transformar suas ideias em Fluxos automatizados.

Uma rede neural, ou rede neural artificial (RNA), é um modelo computacional inspirado no cérebro humano, essencial em IA e aprendizado de máquina para tarefas c...

Redes Neurais Artificiais (ANNs) são um subconjunto de algoritmos de aprendizado de máquina inspirados no cérebro humano. Esses modelos computacionais consistem...

Redes Neurais Recorrentes (RNNs) são uma classe sofisticada de redes neurais artificiais projetadas para processar dados sequenciais utilizando memória de entra...