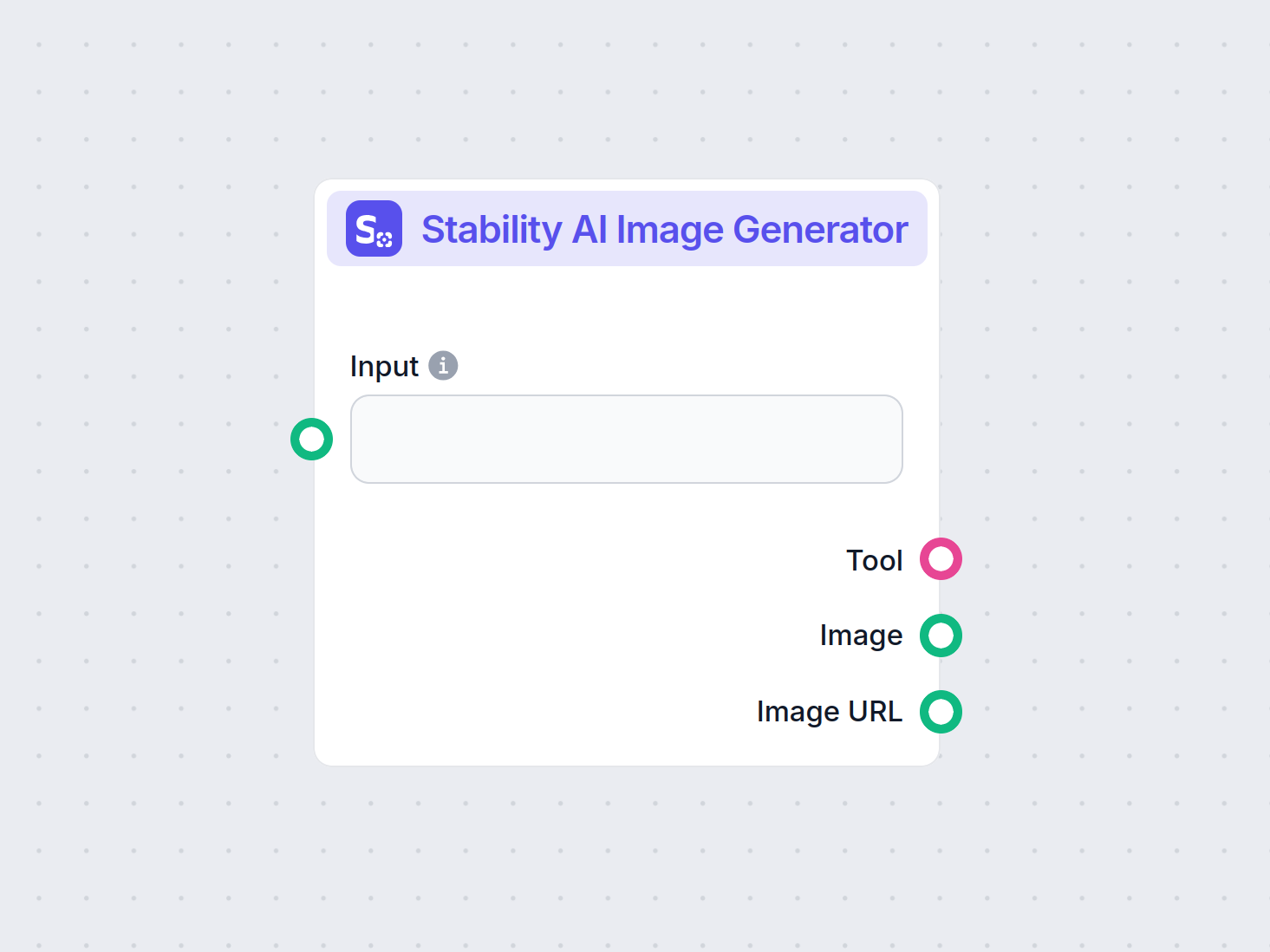

Gerador de Imagens Stability AI

Gere imagens de alta qualidade a partir de prompts de texto com o componente Gerador de Imagens Stability AI. Alimentado por modelos Stable Diffusion, esta ferr...

Stable Diffusion é um dos principais modelos de IA texto-para-imagem, permitindo aos usuários gerar visuais fotorrealistas a partir de prompts utilizando técnicas avançadas de difusão latente e aprendizado profundo.

Stable Diffusion é um modelo de IA de texto para imagem que cria imagens de alta qualidade a partir de descrições usando aprendizado profundo. Ele utiliza técnicas como prompts negativos e imagens de referência para melhores resultados, especialmente com elementos complexos como mãos.

Stable Diffusion é um modelo avançado de geração de imagens a partir de texto que utiliza técnicas de aprendizado profundo para produzir imagens fotorrealistas de alta qualidade com base em descrições textuais. Desenvolvido como um modelo de difusão latente, representa um avanço significativo no campo da inteligência artificial generativa, combinando os princípios de modelos de difusão e aprendizado de máquina para criar imagens que correspondem de perto aos prompts textuais fornecidos.

O Stable Diffusion utiliza aprendizado profundo e modelos de difusão para gerar imagens refinando ruído aleatório até criar visuais coerentes. Apesar de seu extenso treinamento em milhões de imagens, ele tem dificuldades com elementos complexos como mãos. Com o tempo, à medida que os modelos são treinados em conjuntos de dados cada vez maiores, esses problemas estão diminuindo e a qualidade das imagens está se tornando cada vez mais realista.

Um método eficaz para lidar com o problema das mãos é o uso de prompts negativos. Ao adicionar frases como (-bad anatomy) ou (-bad hands -unnatural hands) aos seus prompts, você pode instruir a IA a evitar produzir características distorcidas. Tenha cuidado para não exagerar nos prompts negativos, pois eles podem limitar a criatividade do modelo.

Outra técnica envolve o uso de imagens de referência para guiar a IA. Ao incluir uma tag {image} com um link para uma imagem de referência em seu prompt, você fornece à IA um modelo visual para uma renderização precisa das mãos. Isso é particularmente útil para manter proporções e poses corretas.

Para melhores resultados, combine prompts negativos e imagens de referência. Essa abordagem dupla garante que a IA evite erros comuns enquanto segue exemplos de alta qualidade.

(-bent fingers) ou (realistic perspectives) para melhorar ainda mais a qualidade das mãos.Dominando essas técnicas, você pode melhorar significativamente a renderização das mãos em suas criações com o Stable Diffusion, alcançando obras com o requinte de um artista experiente. Reúna suas imagens de referência, elabore prompts precisos e veja sua arte com IA evoluir!

No seu núcleo, o Stable Diffusion opera transformando prompts de texto em representações visuais através de uma série de processos computacionais. Compreender sua funcionalidade envolve explorar os conceitos de modelos de difusão, espaços latentes e redes neurais.

Modelos de difusão são uma classe de modelos generativos em aprendizado de máquina que aprendem a criar dados revertendo um processo de difusão. O processo de difusão envolve adicionar gradualmente ruído aos dados—como imagens—até que se tornem indistinguíveis de ruído aleatório. O modelo então aprende a reverter esse processo, removendo o ruído passo a passo para recuperar os dados originais. Esse processo de difusão reversa é fundamental para gerar novos dados coerentes a partir do ruído.

O Stable Diffusion utiliza especificamente um modelo de difusão latente. Diferente de modelos tradicionais de difusão que operam diretamente no espaço de pixels de alta dimensão das imagens, modelos de difusão latente trabalham em um espaço latente comprimido. Esse espaço latente é uma representação de menor dimensão dos dados, capturando características essenciais enquanto reduz a complexidade computacional. Ao operar no espaço latente, o Stable Diffusion pode gerar imagens em alta resolução de maneira mais eficiente.

O principal mecanismo do Stable Diffusion envolve o processo de difusão reversa no espaço latente. Começando com um vetor latente de ruído aleatório, o modelo refina iterativamente essa representação latente prevendo e removendo o ruído a cada etapa. Esse refinamento é guiado pela descrição textual fornecida pelo usuário. O processo continua até que o vetor latente converja para um estado que, ao ser decodificado, produza uma imagem consistente com o prompt de texto.

A arquitetura do Stable Diffusion integra vários componentes-chave que trabalham juntos para transformar prompts textuais em imagens.

O VAE atua como o sistema codificador-decodificador que comprime as imagens para o espaço latente e as reconstrói de volta em imagens. O codificador transforma uma imagem em sua representação latente, capturando as características fundamentais em uma forma reduzida. O decodificador pega essa representação latente e a reconstrói na imagem detalhada.

Esse processo é crucial porque permite ao modelo trabalhar com dados de menor dimensão, reduzindo significativamente os recursos computacionais em comparação com a operação no espaço total de pixels.

O U-Net é uma arquitetura de rede neural especializada usada no Stable Diffusion para tarefas de processamento de imagens. Ele consiste em um caminho de codificação e um de decodificação com conexões de atalho entre camadas espelhadas. No contexto do Stable Diffusion, o U-Net funciona como o preditor de ruído durante o processo de difusão reversa.

A cada etapa do processo de difusão, o U-Net prevê a quantidade de ruído presente na representação latente. Essa previsão é usada para refinar o vetor latente subtraindo o ruído estimado, progressivamente eliminando o ruído do espaço latente em direção a uma imagem que corresponda ao prompt de texto.

Para incorporar informações textuais, o Stable Diffusion emprega um codificador de texto baseado no modelo CLIP (Contrastive Language-Image Pretraining). O CLIP é projetado para entender e relacionar informações textuais e visuais mapeando-as em um espaço latente compartilhado.

Quando um usuário fornece um prompt textual, o codificador de texto converte esse prompt em uma série de embeddings—representações numéricas dos dados textuais. Esses embeddings condicionam o U-Net durante o processo de difusão reversa, guiando a geração da imagem para refletir o conteúdo do prompt.

O Stable Diffusion oferece versatilidade na geração de imagens e pode ser utilizado de várias formas dependendo das necessidades do usuário.

O uso principal do Stable Diffusion é gerar imagens a partir de prompts textuais. Usuários inserem uma descrição e o modelo gera uma imagem que representa essa descrição. Por exemplo, um usuário pode inserir “Uma praia serena ao pôr do sol com palmeiras” e receber uma imagem retratando essa cena.

Essa capacidade é particularmente valiosa em indústrias criativas, criação de conteúdo e design, onde a visualização rápida de conceitos é essencial.

Além de gerar imagens do zero, o Stable Diffusion também pode modificar imagens existentes com base em instruções textuais. Ao fornecer uma imagem inicial e um prompt textual, o modelo pode produzir uma nova imagem que incorpora as alterações descritas.

Por exemplo, um usuário pode fornecer uma imagem de uma paisagem urbana diurna com o prompt “mudar para noite com luzes de neon”, resultando em uma imagem que reflete essas modificações.

Inpainting envolve preencher partes ausentes ou corrompidas de uma imagem. O Stable Diffusion se destaca nessa área usando prompts textuais para guiar a reconstrução de áreas específicas da imagem. Usuários podem mascarar partes de uma imagem e fornecer descrições do que deve preencher o espaço.

Esse recurso é útil para restauração de fotos, remoção de objetos indesejados ou alteração de elementos específicos em uma imagem mantendo a coerência geral.

Gerando sequências de imagens com pequenas variações, o Stable Diffusion pode ser estendido para criar animações ou conteúdo em vídeo. Ferramentas como Deforum ampliam as capacidades do Stable Diffusion para produzir conteúdo visual dinâmico guiado por prompts textuais ao longo do tempo.

Isso abre possibilidades em animação, efeitos visuais e geração de conteúdo dinâmico sem a necessidade de técnicas tradicionais de animação quadro a quadro.

A capacidade do Stable Diffusion de gerar imagens a partir de descrições textuais o torna uma ferramenta poderosa em automação de IA e desenvolvimento de chatbots.

Incorporar o Stable Diffusion em chatbots permite a geração de conteúdo visual em resposta a consultas dos usuários. Por exemplo, em um cenário de atendimento ao cliente, um chatbot pode fornecer guias visuais ou ilustrações geradas em tempo real para ajudar os usuários.

Prompts de texto são convertidos em embeddings usando o codificador de texto CLIP. Esses embeddings são cruciais para condicionar o processo de geração de imagem, garantindo que a imagem de saída esteja alinhada com a descrição textual do usuário.

O processo de difusão reversa envolve o refinamento iterativo da representação latente removendo o ruído previsto. A cada etapa, o modelo considera os embeddings de texto e o estado atual do vetor latente para prever o componente de ruído de forma precisa.

A proficiência do modelo em lidar com imagens ruidosas advém de seu treinamento em grandes conjuntos de dados, onde aprende a distinguir e remover ruído de imagens de forma eficaz. Esse treinamento permite gerar imagens nítidas mesmo partindo de ruído aleatório.

Trabalhar no espaço latente oferece eficiência computacional. Como o espaço latente tem menos dimensões que o espaço de pixels, as operações são menos intensivas em recursos. Essa eficiência permite ao Stable Diffusion gerar imagens em alta resolução sem exigir recursos computacionais excessivos.

Artistas e designers podem usar o Stable Diffusion para prototipar rapidamente visuais a partir de descrições conceituais, auxiliando no processo criativo e reduzindo o tempo da ideia à visualização.

Equipes de marketing podem gerar imagens personalizadas para campanhas, redes sociais e anúncios sem a necessidade de extensos recursos de design gráfico.

Desenvolvedores de jogos podem criar ativos, ambientes e artes conceituais fornecendo prompts descritivos, otimizando a criação de ativos.

Varejistas podem gerar imagens de produtos em diferentes cenários ou configurações, aprimorando a visualização do produto e a experiência do cliente.

Educadores e criadores de conteúdo podem produzir ilustrações e diagramas para explicar conceitos complexos, tornando o material didático mais envolvente.

Pesquisadores em inteligência artificial e visão computacional podem usar o Stable Diffusion para explorar ainda mais as capacidades de modelos de difusão e espaços latentes.

Para utilizar o Stable Diffusion de forma eficaz, alguns requisitos técnicos devem ser observados.

Para começar a usar o Stable Diffusion, siga estes passos:

Para desenvolvedores que constroem sistemas de automação em IA e chatbots, o Stable Diffusion pode ser integrado para aprimorar funcionalidades.

Ao utilizar o Stable Diffusion, é importante estar atento a implicações éticas.

A difusão estável é um tema importante no campo de modelos generativos, especialmente para aumento de dados e síntese de imagens. Estudos recentes exploraram vários aspectos da difusão estável, destacando suas aplicações e eficácia.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments por Fuxi Wen (2013):

Introduz um algoritmo de difusão least mean p-power (LMP) projetado para estimação distribuída em ambientes caracterizados por ruído alfa-estável. O estudo compara o método de difusão LMP com o algoritmo diffusion least mean squares (LMS) e demonstra desempenho aprimorado em condições de ruído alfa-estável. Essa pesquisa é crucial para o desenvolvimento de técnicas robustas de estimação em ambientes ruidosos. Leia mais

Stable Diffusion for Data Augmentation in COCO and Weed Datasets por Boyang Deng (2024):

Investiga o uso de modelos de difusão estável para gerar imagens sintéticas de alta resolução a fim de melhorar pequenos conjuntos de dados. Utilizando técnicas como tradução de imagem para imagem, Dreambooth e ControlNet, a pesquisa avalia a eficiência da difusão estável em tarefas de classificação e detecção. Os resultados sugerem aplicações promissoras da difusão estável em vários campos. Leia mais

Diffusion and Relaxation Controlled by Tempered α-stable Processes por Aleksander Stanislavsky, Karina Weron, e Aleksander Weron (2011):

Deriva propriedades de difusão anômala e relaxamento não exponencial usando processos α-estáveis temperados. Aborda a dificuldade de momentos infinitos associada ao tempo operacional aleatório α-estável e fornece um modelo que inclui subdifusão como caso especial. Leia mais

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion por Andreas Stöckl (2022):

Avalia imagens sintéticas geradas pelo modelo Stable Diffusion usando a taxonomia do Wordnet. Analisa a capacidade do modelo de produzir imagens corretas para vários conceitos, ilustrando diferenças na precisão da representação. Essas avaliações são vitais para compreender o papel da difusão estável no aumento de dados. Leia mais

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion por Sanchayan Vivekananthan (2024):

Explora três estruturas generativas: VAEs, GANs e modelos de Stable Diffusion. A pesquisa destaca pontos fortes e limitações de cada modelo, observando que, enquanto VAEs e GANs têm suas vantagens, a difusão estável se destaca em determinadas tarefas de síntese. Leia mais

Vamos ver como implementar um modelo Stable Diffusion em Python usando a biblioteca Diffusers da Hugging Face.

Instale as bibliotecas necessárias:

pip install torch transformers diffusers accelerate

pip install xformers # Opcional

A biblioteca Diffusers oferece uma forma prática de carregar modelos pré-treinados:

from diffusers import StableDiffusionPipeline

import torch

# Carregar o modelo Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Move o modelo para a GPU para inferência mais rápida

Para gerar imagens, basta fornecer um prompt textual:

prompt = "Uma paisagem serena com montanhas e um lago, fotorrealista, resolução 8K"

image = pipe(prompt).images[0]

# Salvar ou exibir a imagem

image.save("generated_image.png")

model_id.torch.float16 reduz o uso de memória.Você pode personalizar vários parâmetros:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Número de etapas de remoção de ruído

guidance

Stable Diffusion é um modelo avançado de IA projetado para gerar imagens fotorrealistas de alta qualidade a partir de prompts de texto. Utiliza difusão latente e aprendizado profundo para transformar descrições textuais em visuais.

O Stable Diffusion opera convertendo prompts de texto em embeddings de imagem usando um codificador de texto CLIP, depois remove iterativamente o ruído de uma representação latente guiada pelo prompt, resultando em uma saída de imagem coerente.

Stable Diffusion é utilizado para geração criativa de conteúdo, materiais de marketing, criação de ativos para jogos, visualização de produtos para e-commerce, ilustrações educacionais e chatbots alimentados por IA.

Sim, o Stable Diffusion suporta tradução de imagem para imagem e inpainting, permitindo aos usuários alterar imagens existentes ou preencher partes ausentes com base em prompts de texto.

Um computador com uma GPU moderna é recomendado para geração eficiente de imagens usando o Stable Diffusion. O modelo também requer Python e bibliotecas como PyTorch e Diffusers.

Sim, o Stable Diffusion é lançado sob uma licença open source permissiva, incentivando contribuições da comunidade, personalização e ampla acessibilidade.

Libere sua criatividade com o Stable Diffusion e veja como a IA pode transformar suas ideias em visuais impressionantes.

Gere imagens de alta qualidade a partir de prompts de texto com o componente Gerador de Imagens Stability AI. Alimentado por modelos Stable Diffusion, esta ferr...

Confira nossa análise detalhada do Stability AI SD3 Large. Analise seus pontos fortes, fracos e resultados criativos em diversos prompts de texto para imagem, e...

O Modelo Flux AI da Black Forest Labs é um avançado sistema de geração de imagens a partir de texto que converte comandos em linguagem natural em imagens altame...