Integração do HubSpot MCP Server

O HubSpot MCP Server conecta assistentes de IA diretamente ao HubSpot CRM, permitindo acesso contínuo a contatos, empresas e dados de engajamento. Com armazenam...

O HubSpot MCP Server conecta assistentes de IA diretamente ao HubSpot CRM, permitindo acesso contínuo a contatos, empresas e dados de engajamento. Com armazenam...

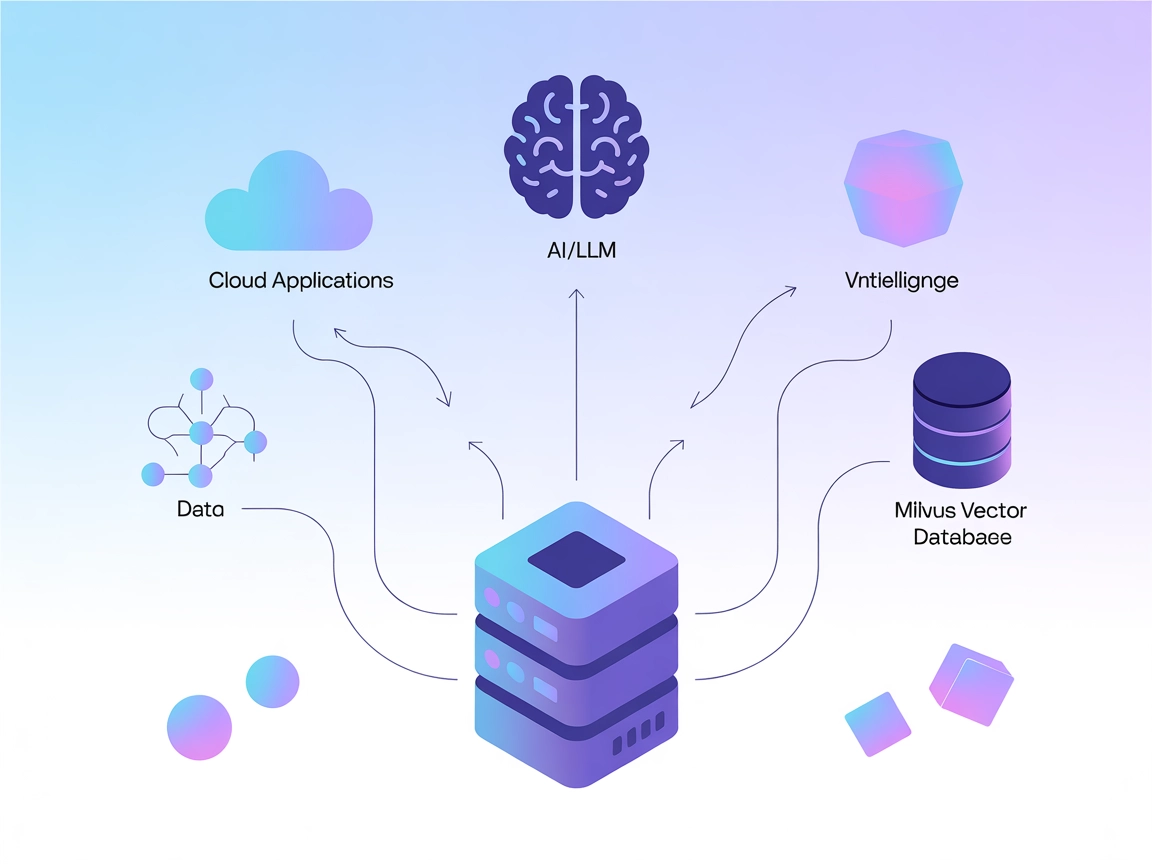

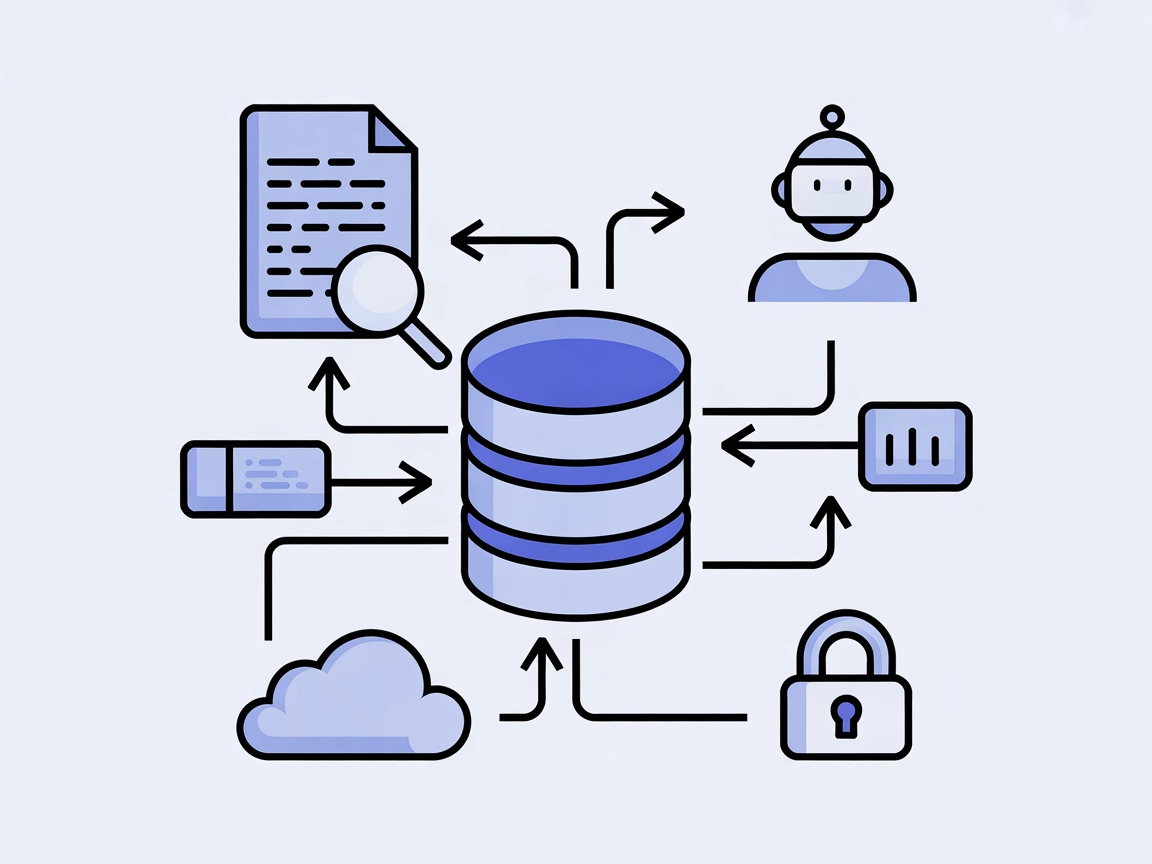

O Servidor Milvus MCP conecta assistentes de IA e aplicações alimentadas por LLM ao banco de dados vetorial Milvus, possibilitando busca vetorial avançada, gere...

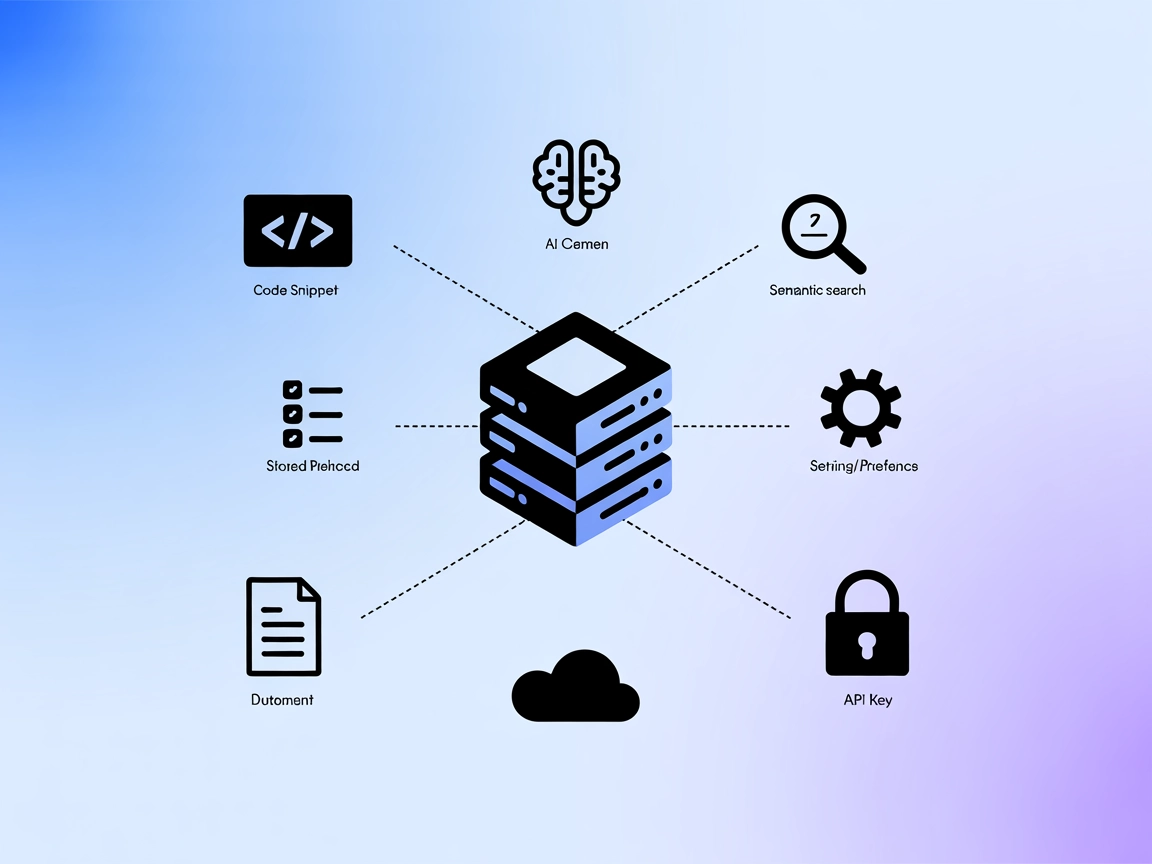

O mem0 MCP Server conecta assistentes de IA com armazenamento estruturado, recuperação e busca semântica para trechos de código, documentação e práticas recomen...

Integre o FlowHunt com bancos de dados vetoriais Pinecone usando o Pinecone MCP Server. Habilite busca semântica, Geração Aumentada por Recuperação (RAG) e gere...

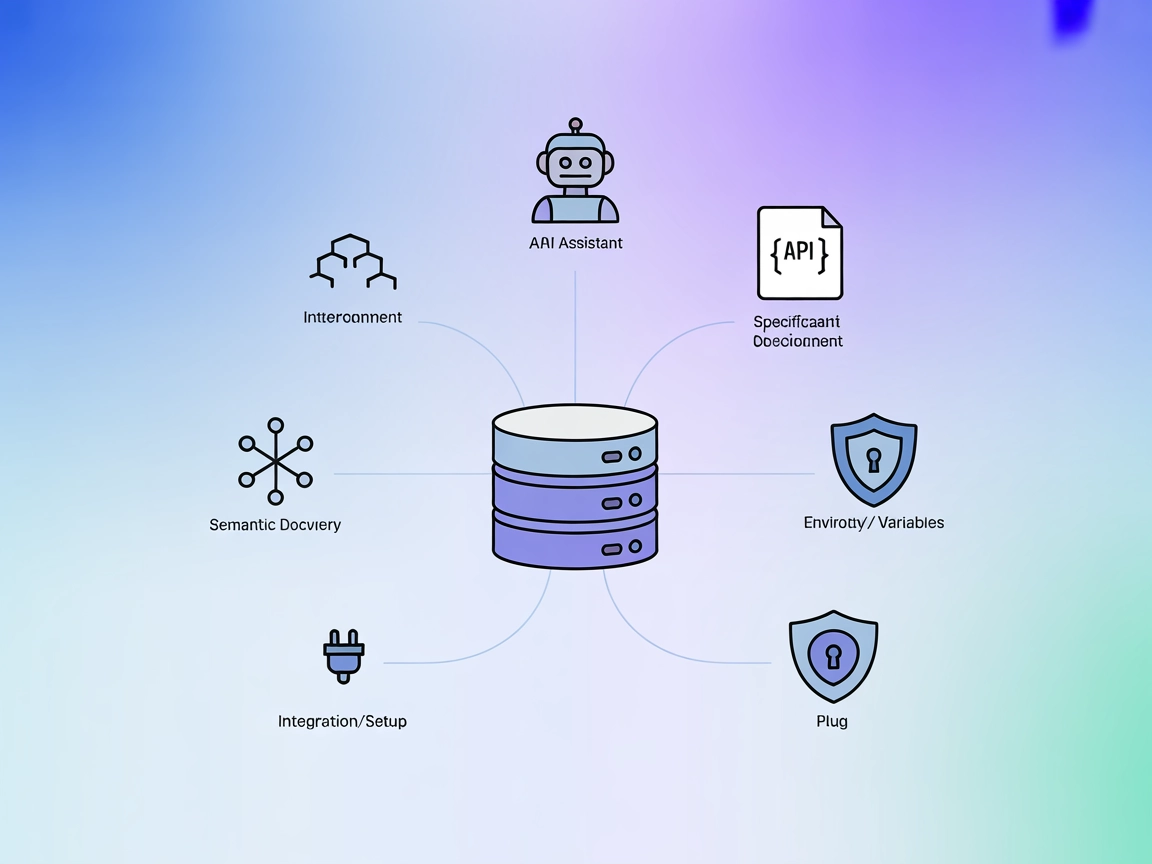

Conecte assistentes de IA como o Claude a qualquer API com uma especificação OpenAPI (Swagger). O Qualquer Servidor MCP OpenAPI permite a descoberta semântica d...

O Ragie MCP Server permite que assistentes de IA realizem buscas semânticas e recuperem informações relevantes das bases de conhecimento Ragie, aprimorando flux...

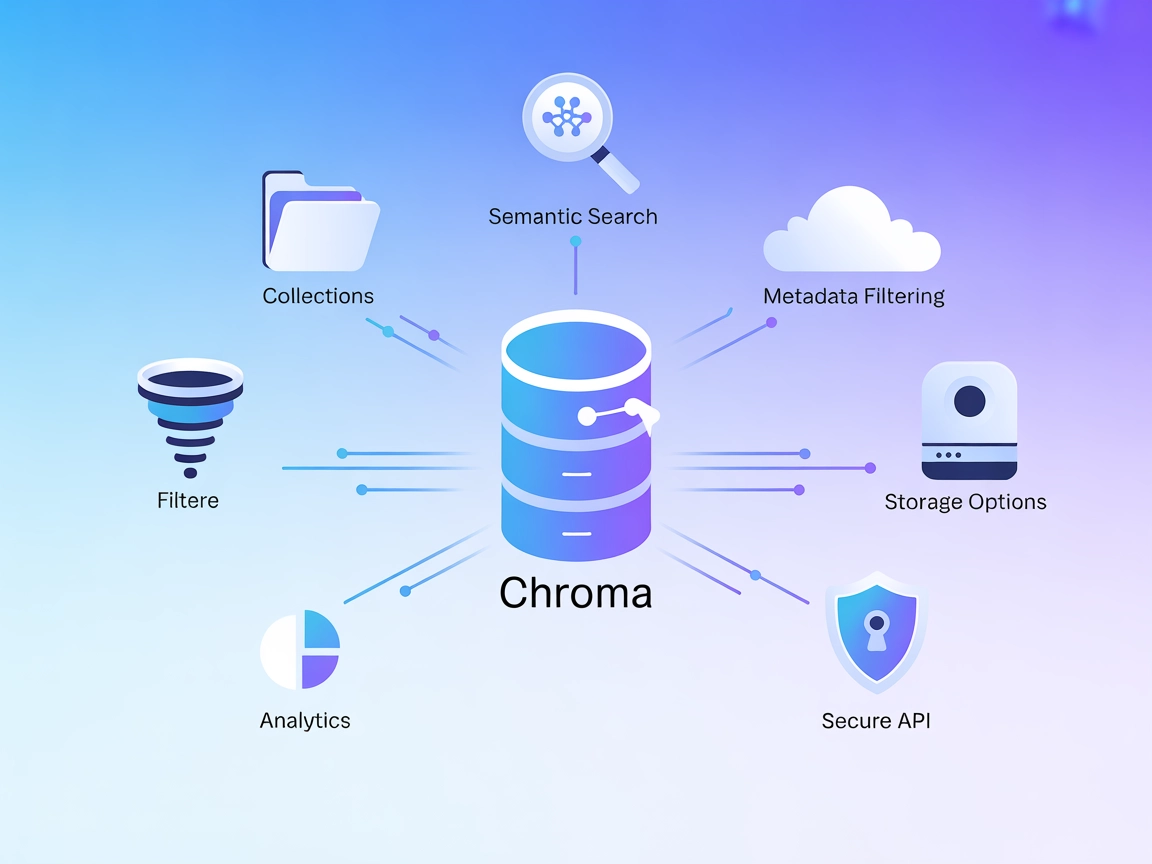

O Servidor MCP Chroma capacita usuários do FlowHunt com recursos avançados de banco de dados vetorial, incluindo busca semântica, filtragem por metadados e gest...

O servidor MCP mcp-rag-local capacita assistentes de IA com memória semântica, permitindo o armazenamento e a recuperação de passagens de texto com base no sign...

O Rememberizer MCP Server faz a ponte entre assistentes de IA e a gestão do conhecimento, permitindo busca semântica, recuperação unificada de documentos e cola...

O Servidor Lambda Capture MCP permite busca semântica e consultas em tempo real sobre conjuntos de dados macroeconômicos para agentes de IA de pesquisa quantita...

Integre o Vectorize MCP Server com o FlowHunt para habilitar recuperação avançada de vetores, busca semântica e extração de texto para fluxos de trabalho podero...

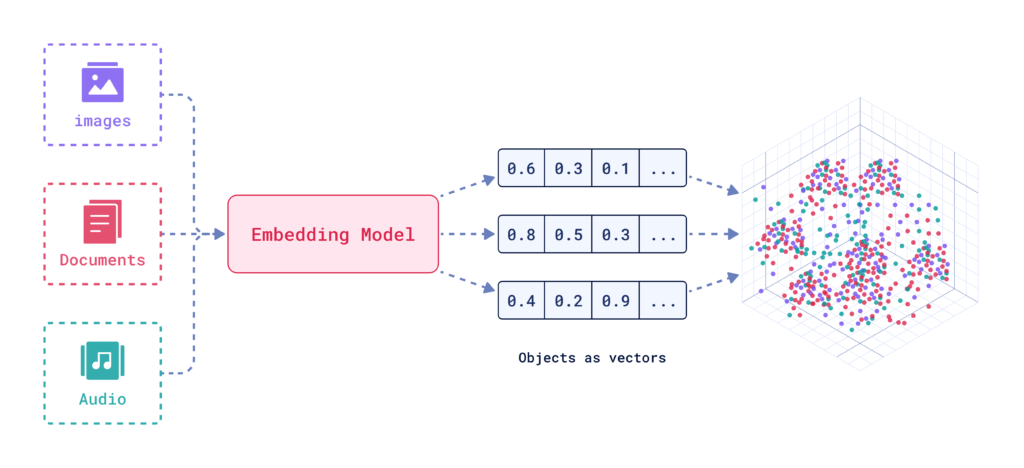

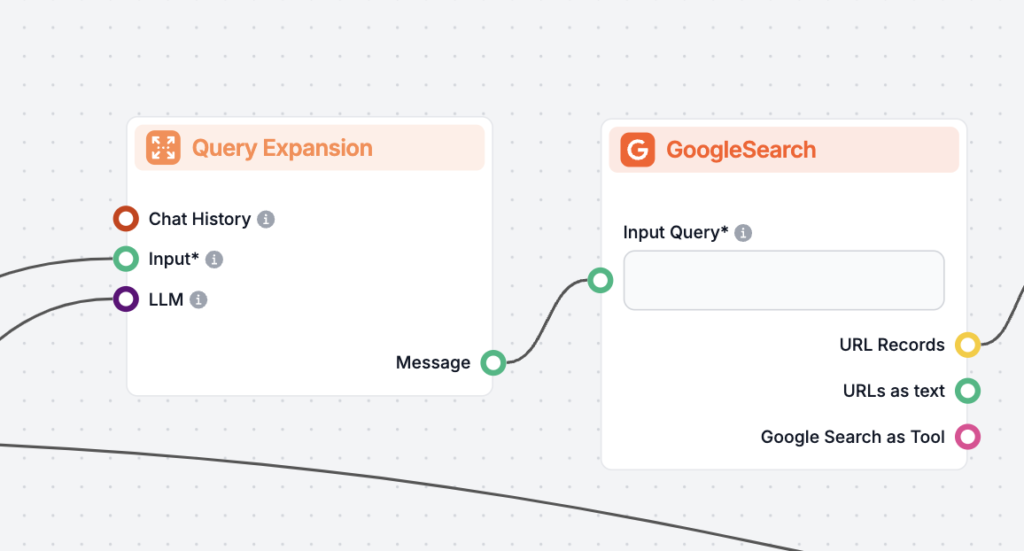

A Busca Aprimorada de Documentos com PLN integra técnicas avançadas de Processamento de Linguagem Natural aos sistemas de recuperação de documentos, melhorando ...

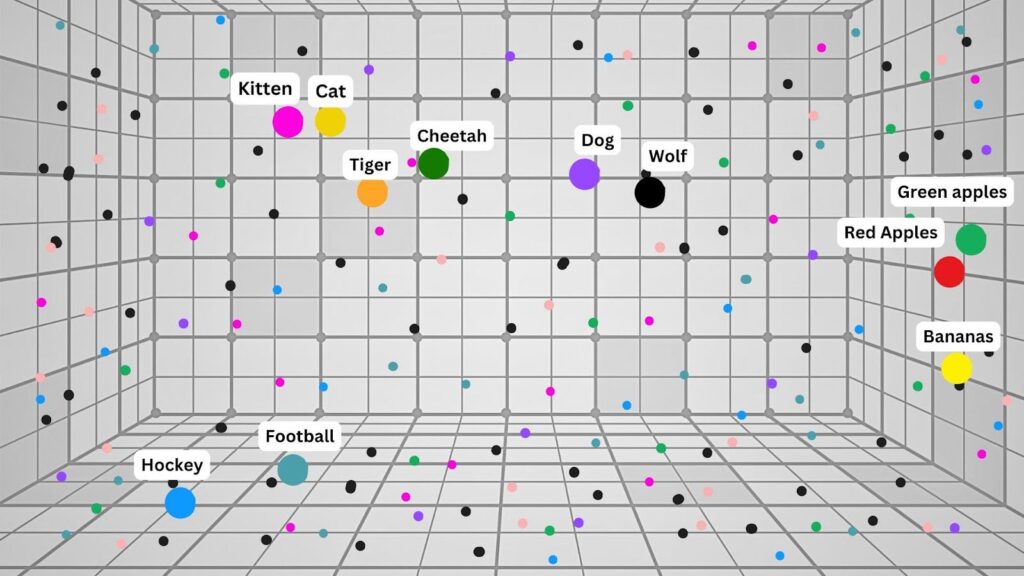

A Busca por IA é uma metodologia de busca semântica ou baseada em vetores que utiliza modelos de aprendizado de máquina para compreender a intenção e o signific...

A correspondência aproximada é uma técnica de busca utilizada para encontrar correspondências aproximadas a uma consulta, permitindo variações, erros ou inconsi...

Descubra o que é um Motor de Insights—uma plataforma avançada, baseada em IA, que aprimora a busca e análise de dados ao compreender contexto e intenção. Saiba ...

Aprimore a precisão do seu chatbot de IA com o recurso de pular indexação do FlowHunt. Exclua conteúdos inadequados para manter as interações relevantes e segur...

A reclassificação de documentos é o processo de reordenar documentos recuperados com base em sua relevância para a consulta do usuário, refinando os resultados ...

A Resposta a Perguntas com Geração Aumentada por Recuperação (RAG) combina recuperação de informações e geração de linguagem natural para aprimorar grandes mode...