Token

Un token, în contextul modelelor lingvistice mari (LLM), este o secvență de caractere pe care modelul o convertește în reprezentări numerice pentru o procesare ...

LLM DeepSeek de la FlowHunt îți permite să accesezi și să personalizezi cele mai bune modele AI precum DeepSeek R1 pentru generare de text și imagini în chatbot-urile și instrumentele tale AI, totul dintr-un singur panou de control.

Descrierea componentei

Componenta LLM DeepSeek conectează modelele DeepSeek la Flow-ul tău. În timp ce Generatoarele și Agenții sunt locul unde are loc magia propriu-zisă, componentele LLM îți permit să schimbi și să controlezi modelul folosit.

Ține minte că conectarea unei componente LLM este opțională. Toate componentele care folosesc un LLM vin cu ChatGPT-4o ca implicit. Componentele LLM îți permit să schimbi modelul și să controlezi setările acestuia.

Tokenii reprezintă unitățile individuale de text pe care modelul le procesează și generează. Utilizarea tokenilor variază în funcție de model, iar un token poate însemna orice de la cuvinte sau sub-cuvinte până la un singur caracter. Modelele sunt de obicei tarifate la milioane de tokeni.

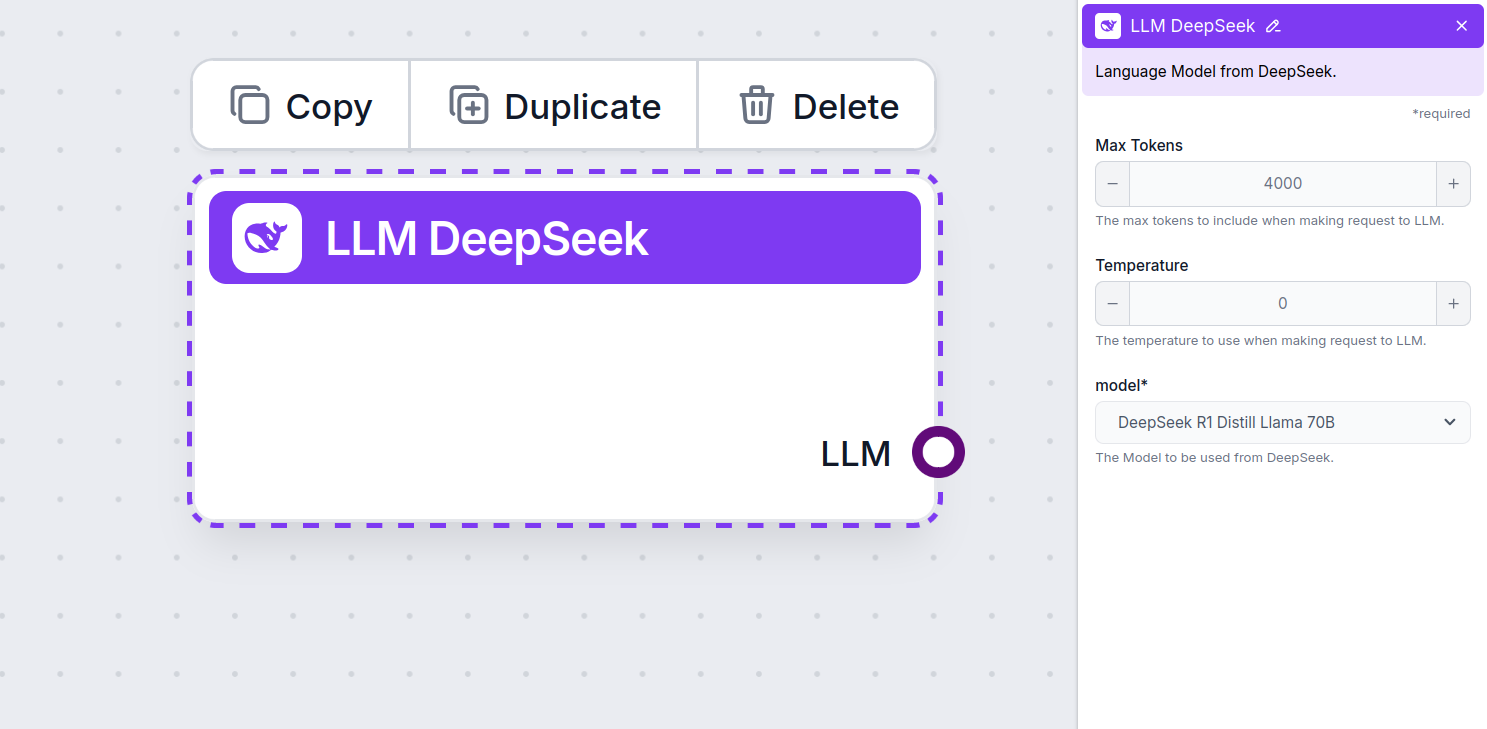

Setarea pentru numărul maxim de tokeni limitează numărul total de tokeni care pot fi procesați într-o singură interacțiune sau solicitare, asigurând că răspunsurile sunt generate în limite rezonabile. Limita implicită este de 4.000 de tokeni, dimensiunea optimă pentru rezumarea documentelor și a mai multor surse pentru a genera un răspuns.

Temperatura controlează variabilitatea răspunsurilor, variind de la 0 la 1.

O temperatură de 0,1 va face ca răspunsurile să fie foarte la obiect, dar potențial repetitive și sărace în conținut.

O temperatură ridicată de 1 permite creativitate maximă în răspunsuri, dar crește riscul unor rezultate irelevante sau chiar halucinante.

De exemplu, temperatura recomandată pentru un chatbot de servicii clienți este între 0,2 și 0,5. Acest nivel ar trebui să mențină răspunsurile relevante și la subiect, permițând totodată o variație naturală.

Aceasta este selecția de model. Aici vei găsi toate modelele DeepSeek suportate. Susținem toate cele mai noi modele Gemini:

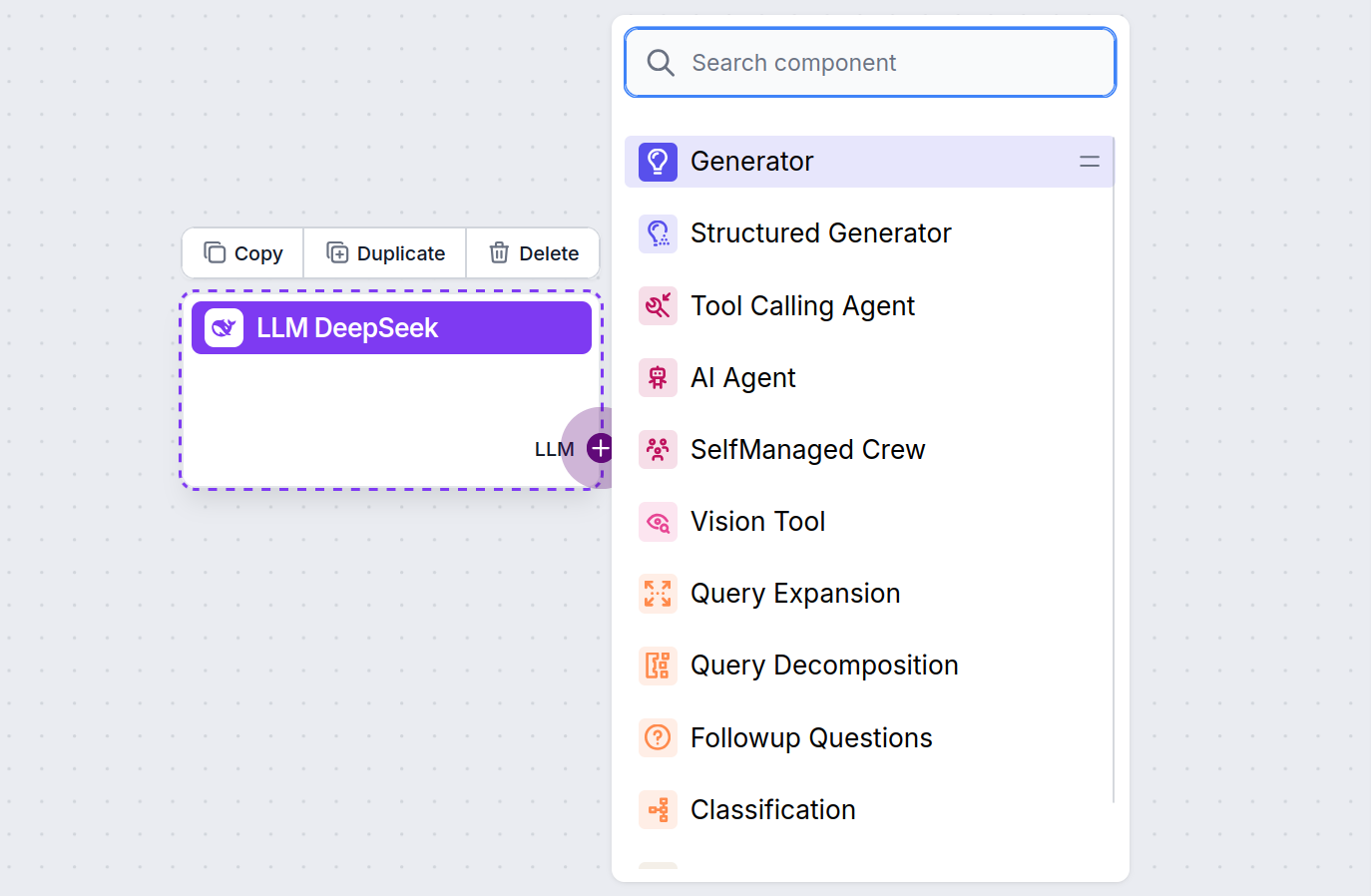

Vei observa că toate componentele LLM au doar un handle de ieșire. Inputul nu trece prin componentă, deoarece aceasta reprezintă doar modelul, în timp ce generarea efectivă se realizează în AI Agenți și Generatoare.

Handle-ul LLM este mereu mov. Handle-ul de input LLM se găsește pe orice componentă care folosește AI pentru generare de text sau procesare de date. Poți vedea opțiunile făcând click pe handle:

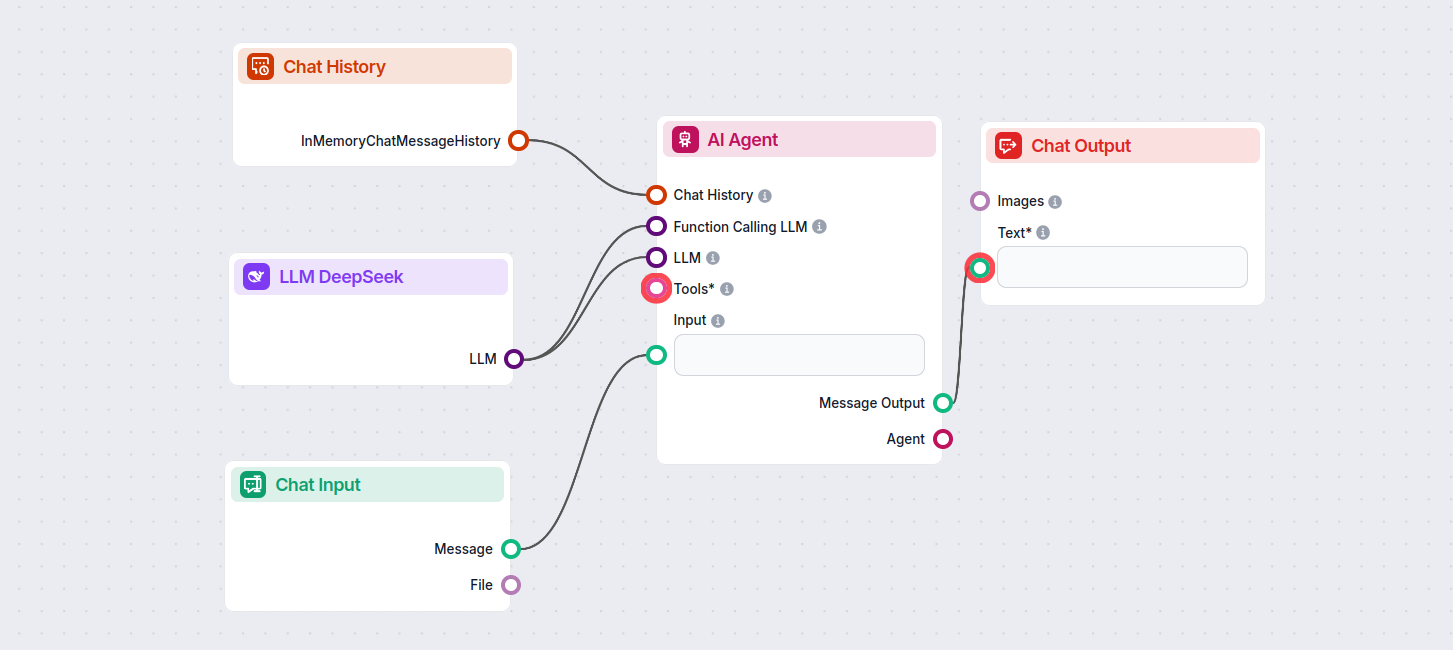

Acest lucru îți permite să creezi tot felul de instrumente. Să vedem componenta în acțiune. Iată un Flow simplu de chatbot AI Agent care folosește DeepSeek R1 pentru generarea răspunsurilor. Îl poți considera un chatbot DeepSeek de bază.

Acest Flow simplu de Chatbot include:

LLM DeepSeek este o componentă din FlowHunt care îți permite să conectezi și să controlezi modelele AI DeepSeek pentru generarea de text și imagini, permițând crearea de chatbot-uri puternice și fluxuri automatizate.

FlowHunt suportă toate cele mai noi modele DeepSeek, inclusiv DeepSeek R1, cunoscut pentru viteza și performanța sa, mai ales în comparație cu alte modele AI de top.

Poți ajusta numărul maxim de tokeni pentru lungimea răspunsului și temperatura pentru creativitatea răspunsului, precum și să schimbi între modelele DeepSeek disponibile direct din panoul FlowHunt.

Nu, conectarea unei componente LLM este opțională. Implicit, FlowHunt folosește ChatGPT-4o, dar adăugarea LLM DeepSeek îți permite să schimbi și să controlezi ce model AI alimentează fluxurile tale.

Începe să construiești chatbot-uri AI și instrumente de automatizare mai inteligente folosind modelele avansate DeepSeek—totul fără configurări complexe sau abonamente multiple.

Un token, în contextul modelelor lingvistice mari (LLM), este o secvență de caractere pe care modelul o convertește în reprezentări numerice pentru o procesare ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.