Analizator de Reclame LinkedIn al Competiției

Acest flux de lucru automatizează cercetarea pieței reclamelor LinkedIn prin identificarea principalilor competitori pentru un cuvânt-cheie, analizând textele ș...

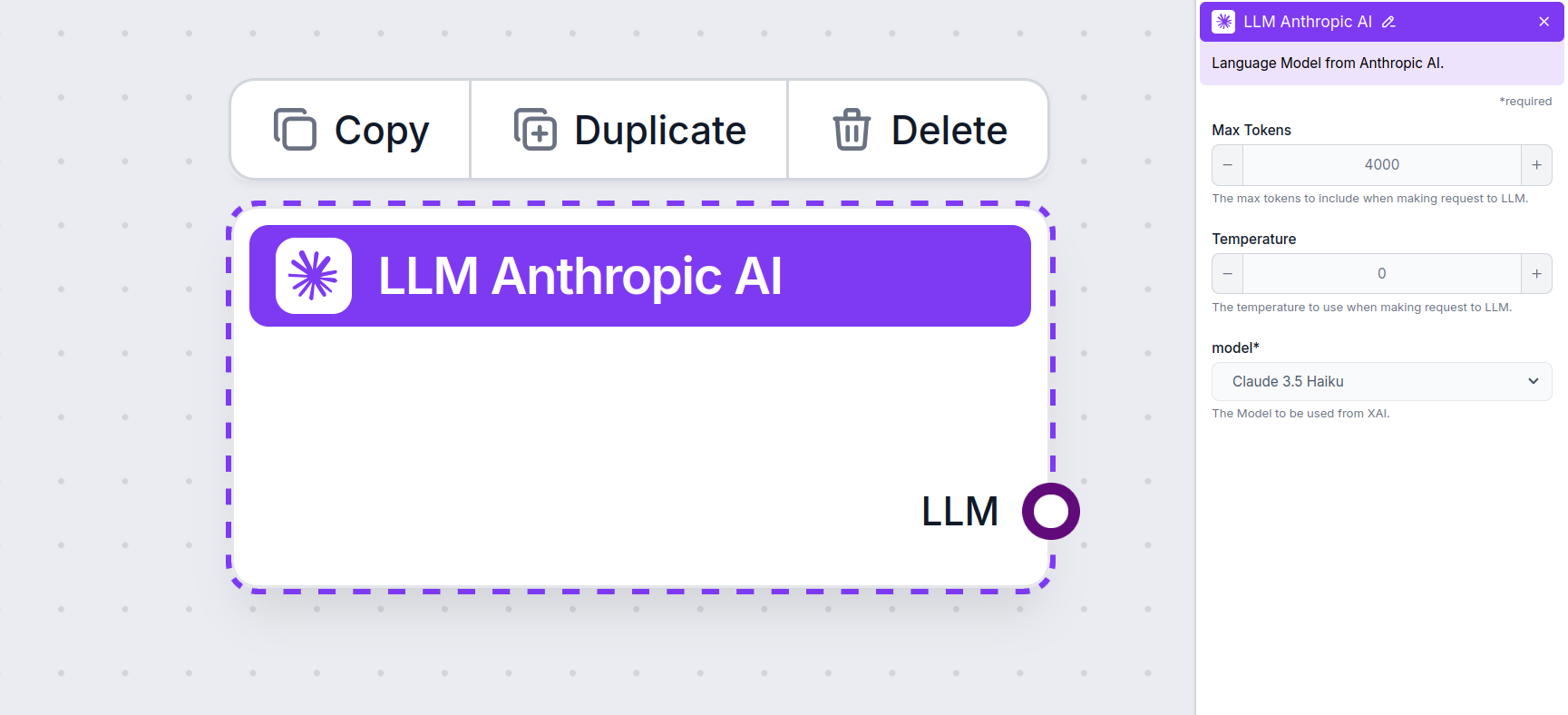

Conectează modelele Claude de la Anthropic la dashboard-ul tău FlowHunt pentru generare flexibilă de text AI și soluții de chatbot, cu control asupra tokenilor, temperaturii și selecției modelului.

Descrierea componentei

Sarcinile diferite necesită modele diferite, iar FlowHunt este dedicat să îți ofere tot ce e mai bun din AI fără să fie nevoie să te abonezi la nenumărate servicii. În schimb, ai la dispoziție zeci de modele generatoare de text și imagini într-un singur dashboard. Componentele de tip LLM găzduiesc modele de generare de text și aplicațiile lor diverse în AI, creare de conținut și automatizare, grupate după furnizor, permițându-ți să schimbi modelele AI pe loc.

Componenta LLM Anthropic AI conectează familia de modele Claude la flow-ul tău. Deși Generatoarele și Agenții sunt locul unde are loc magia propriu-zisă, componentele LLM îți permit să controlezi modelul folosit. Toate componentele vin implicit cu ChatGPT-4. Poți conecta această componentă dacă dorești să schimbi modelul sau să ai mai mult control asupra lui.

Amintește-ți că conectarea unei componente LLM este opțională. Toate componentele care folosesc un LLM vin cu ChatGPT-4o ca implicit. Componentele LLM îți permit să schimbi modelul și să controlezi setările modelului.

Tokenii reprezintă unitățile individuale de text pe care modelul le procesează și generează. Utilizarea tokenilor variază în funcție de model, iar un token poate fi orice, de la cuvinte sau sub-cuvinte la un singur caracter. Modelele sunt de obicei tarifate la milioane de tokeni.

Setarea max tokens limitează numărul total de tokeni ce pot fi procesați într-o singură interacțiune sau cerere, asigurând că răspunsurile sunt generate în limite rezonabile. Limita implicită este de 4.000 de tokeni, fiind dimensiunea optimă pentru sumarizarea documentelor și a mai multor surse pentru a genera un răspuns.

Temperatura controlează variabilitatea răspunsurilor și variază de la 0 la 1.

De exemplu, temperatura recomandată pentru un bot de servicii clienți este între 0.2 și 0.5. Acest nivel ar trebui să păstreze răspunsurile relevante și la subiect, permițând totodată o variație naturală a răspunsului.

Aceasta este zona de selecție a modelului. Aici vei găsi toate modelele suportate de la Anthropic. În prezent, suportăm toate modelele recente din familia Claude:

Vei observa că toate componentele LLM au doar un output handle. Input-ul nu trece prin componentă, deoarece aceasta reprezintă doar modelul, iar generarea propriu-zisă are loc în AI Agents și Generatoare.

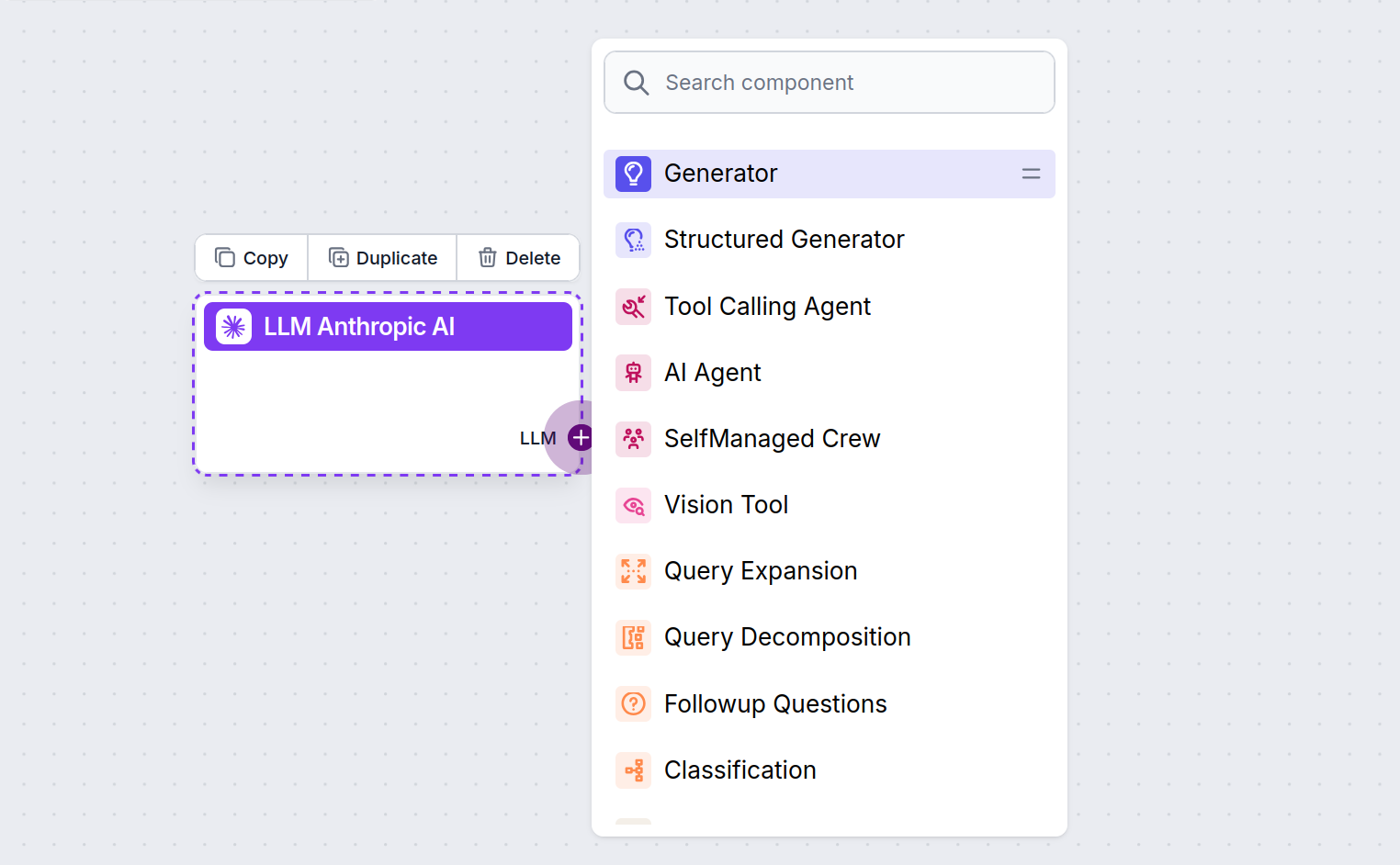

Handle-ul LLM este întotdeauna mov. Input handle-ul LLM se găsește pe orice componentă care folosește AI pentru a genera text sau a procesa date. Poți vedea opțiunile dând click pe handle:

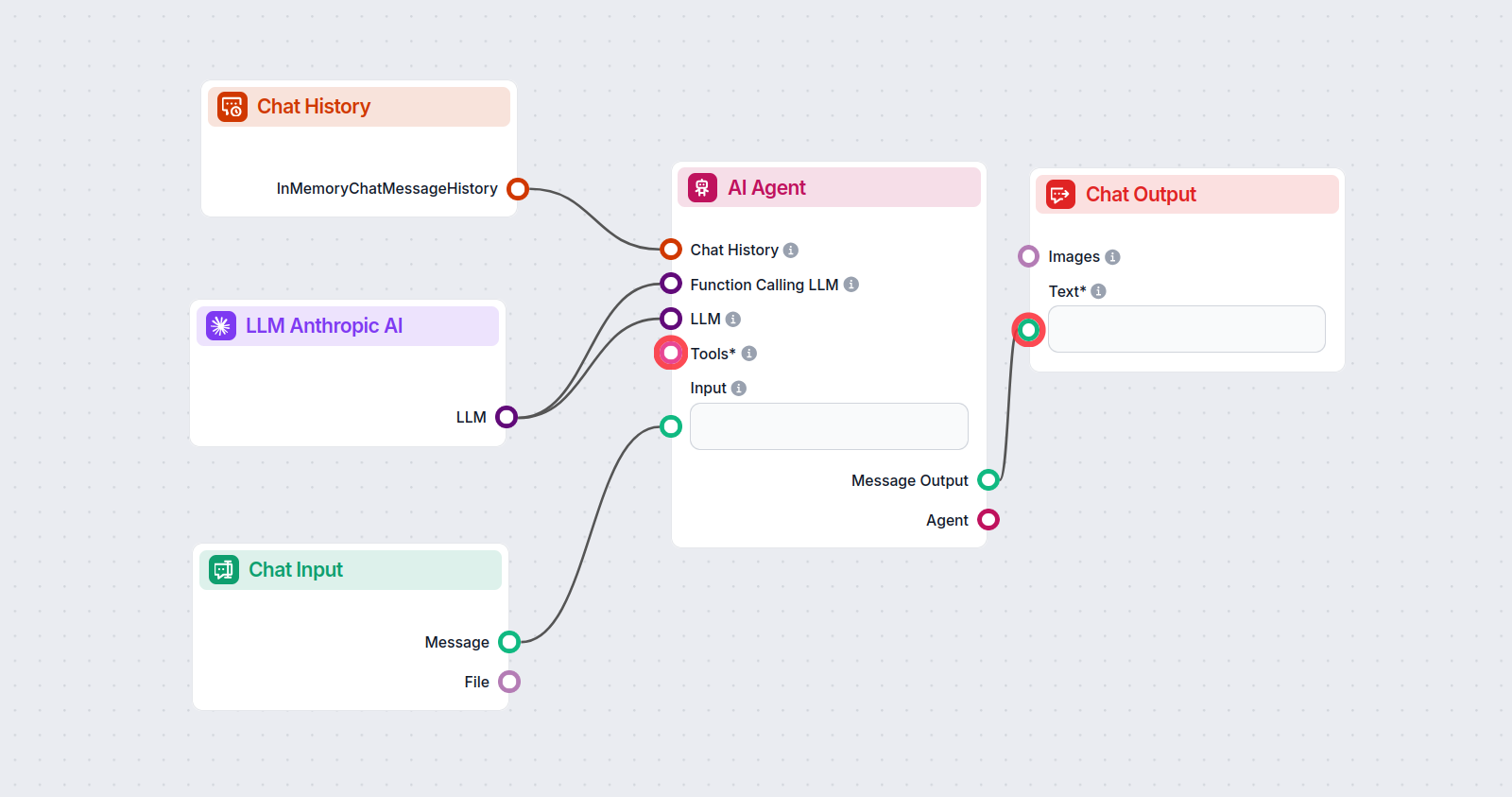

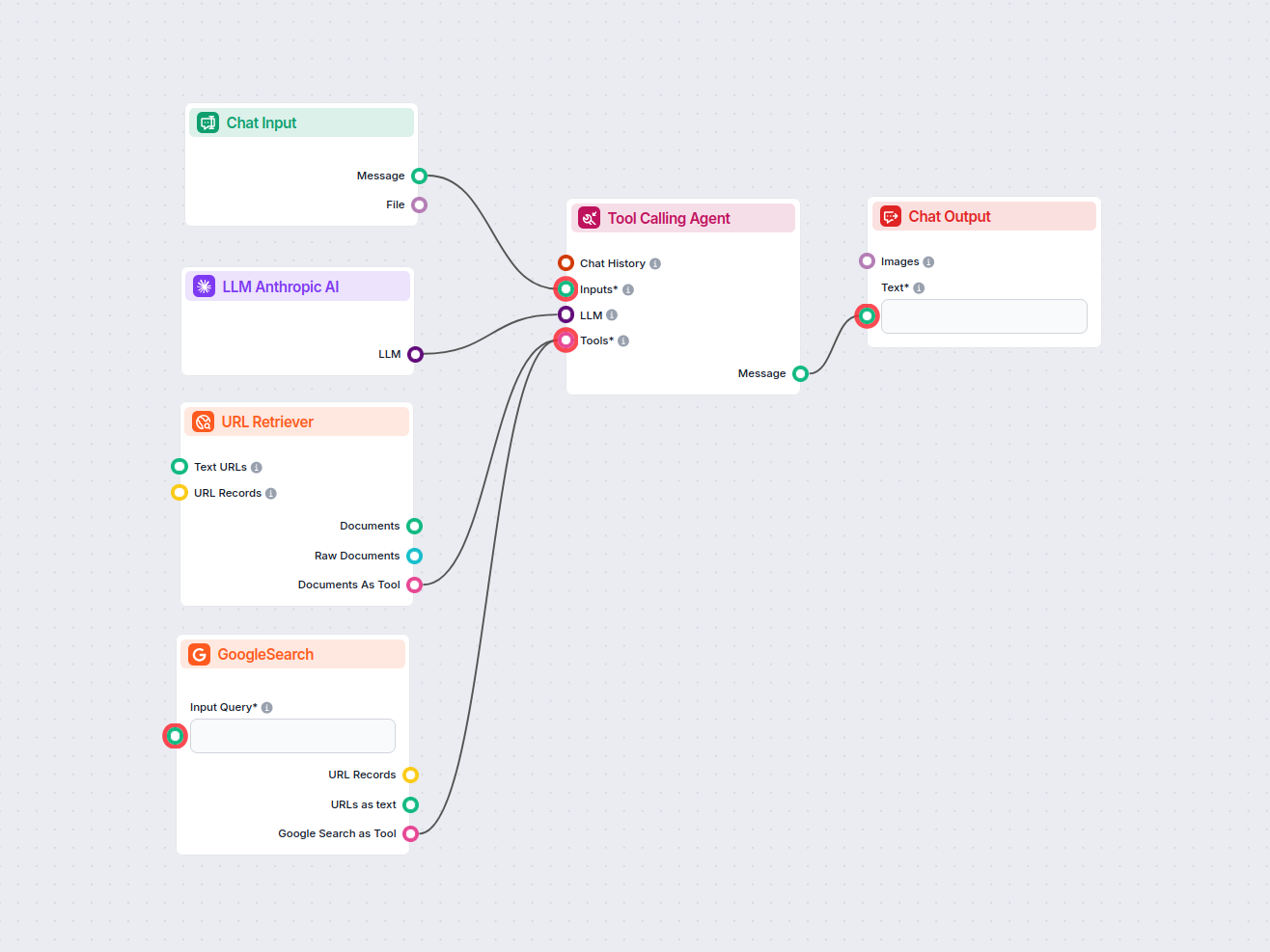

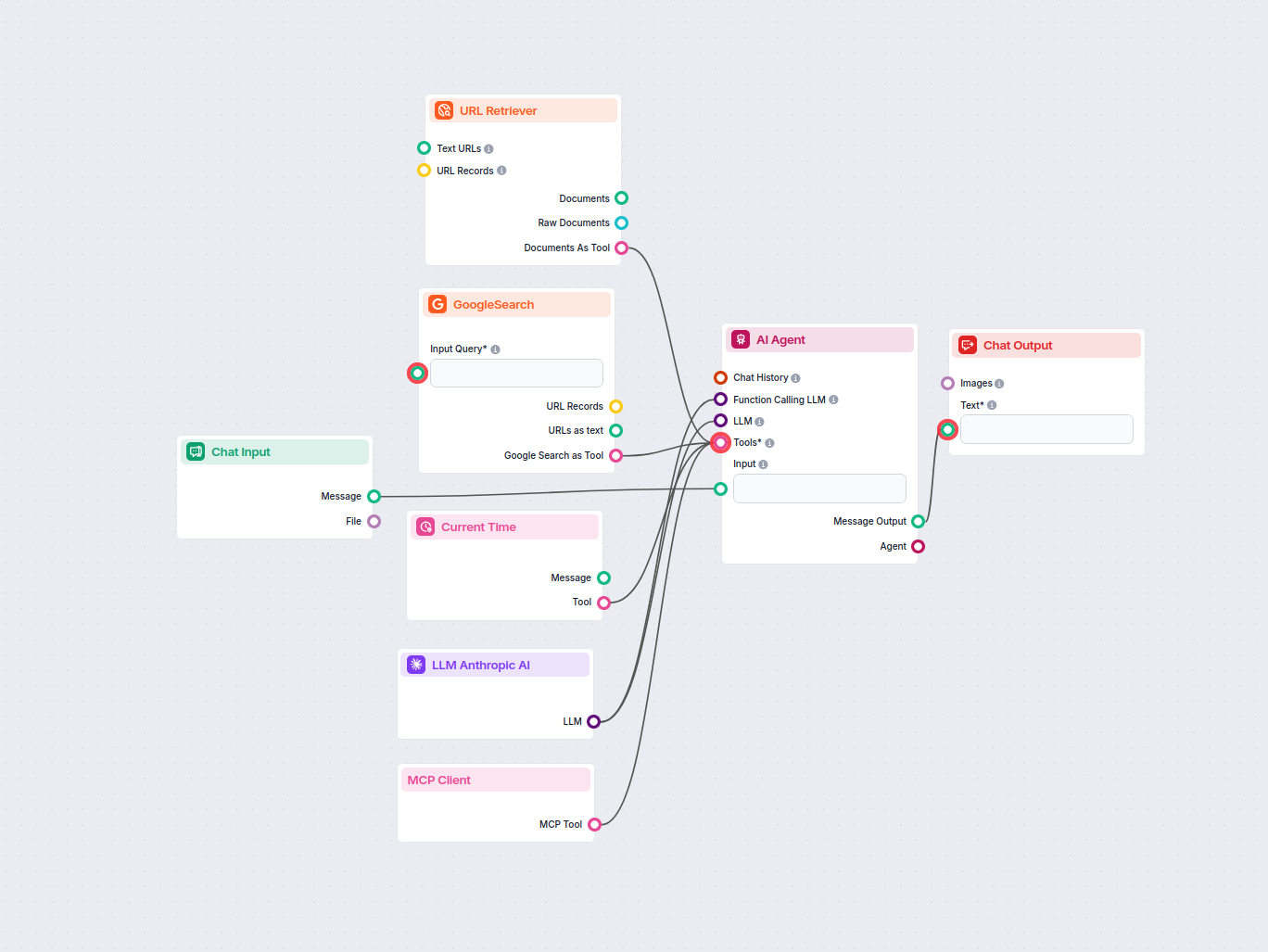

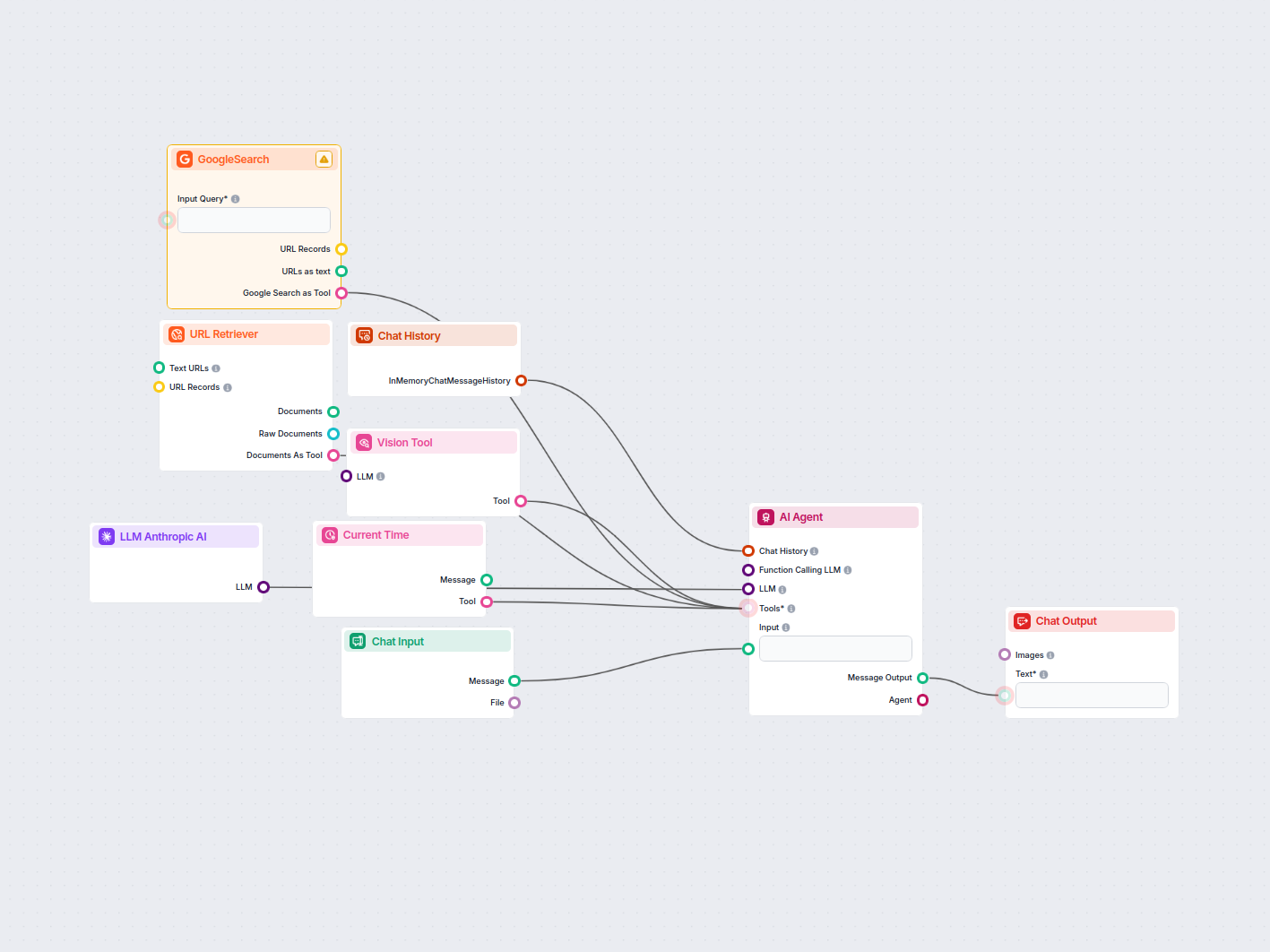

Aceasta îți permite să creezi tot felul de instrumente. Să vedem componenta în acțiune. Iată un flow simplu de chatbot AI Agent care folosește Claude 3.5 Sonnet de la Anthropic pentru a genera răspunsuri. Îl poți considera un chatbot Anthropic de bază.

Acest flow simplu de Chatbot include:

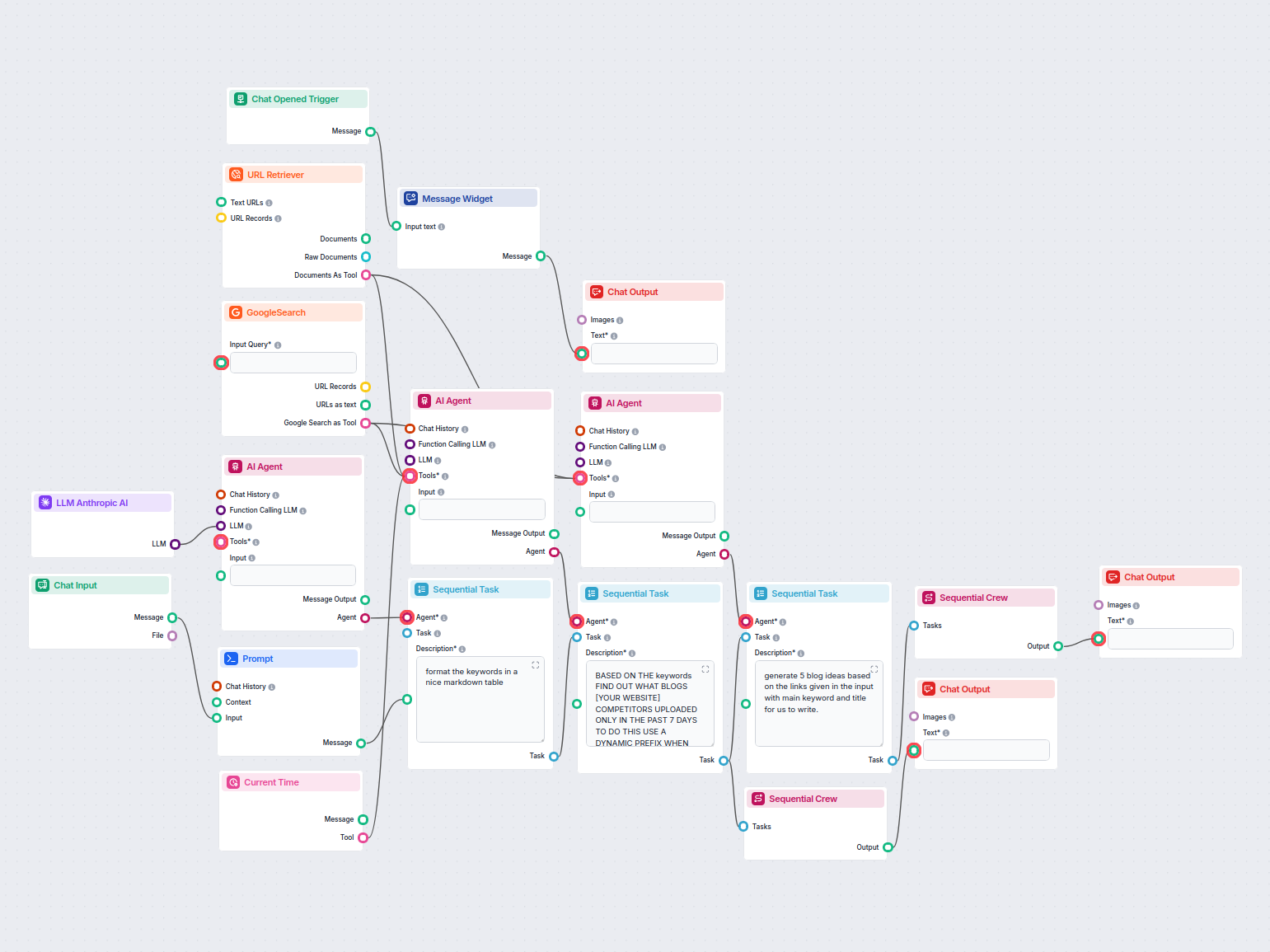

Pentru a te ajuta să începi rapid, am pregătit mai multe șabloane flow exemplu care demonstrează cum să folosești componenta LLM Anthropic AI eficient. Aceste șabloane prezintă diferite cazuri de utilizare și cele mai bune practici, făcând mai ușor pentru tine să înțelegi și să implementezi componenta în propriile tale proiecte.

Acest flux de lucru automatizează cercetarea pieței reclamelor LinkedIn prin identificarea principalilor competitori pentru un cuvânt-cheie, analizând textele ș...

Analizează automat blogurile concurenților de top din ultima săptămână și generează idei noi de articole pentru site-ul tău. Acest flux de lucru AI cercetează c...

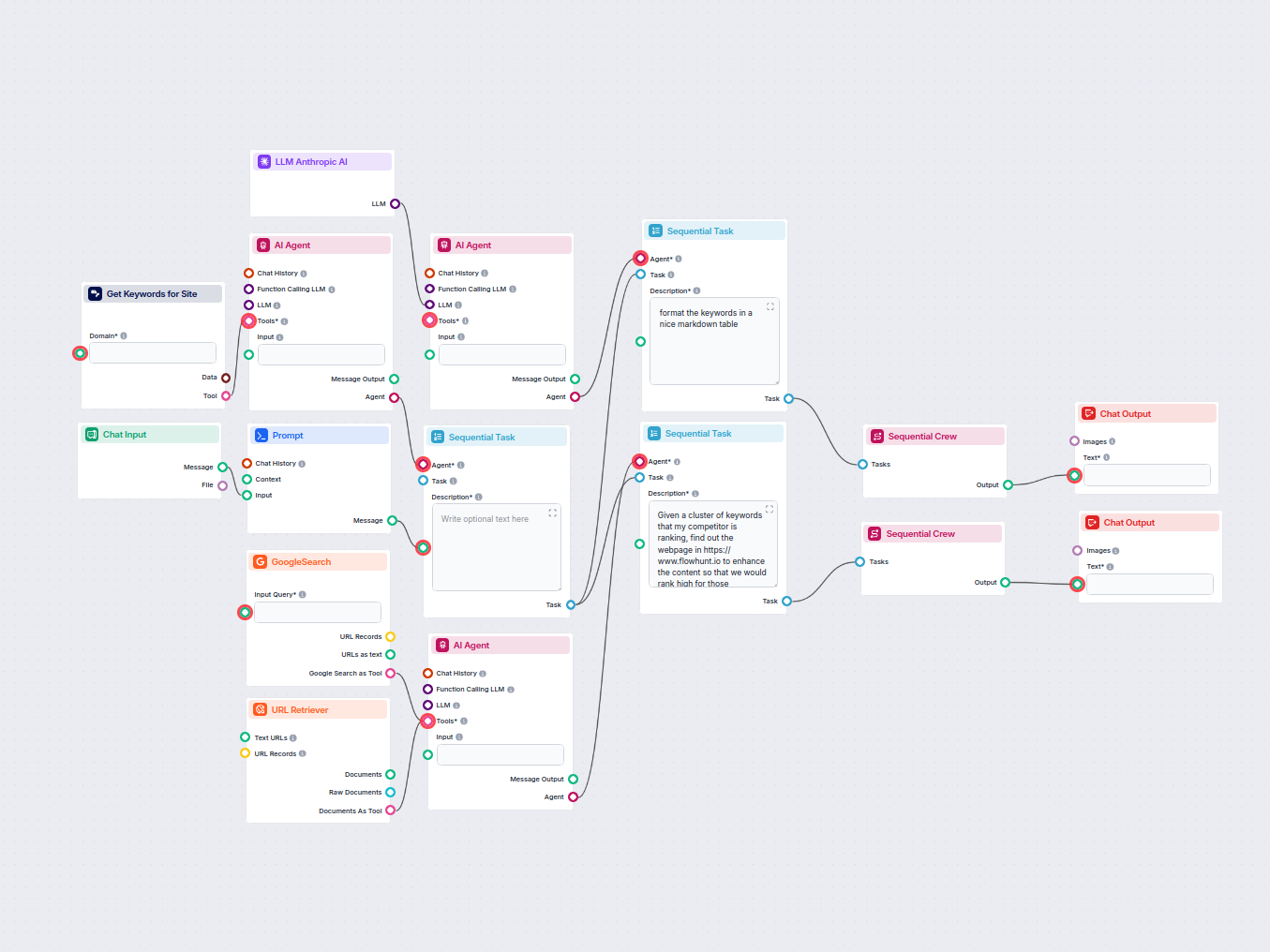

Analizează automat URL-ul paginii principale a concurentului tău pentru a descoperi principalele lor cuvinte cheie de top, colectează date despre cuvinte cheie ...

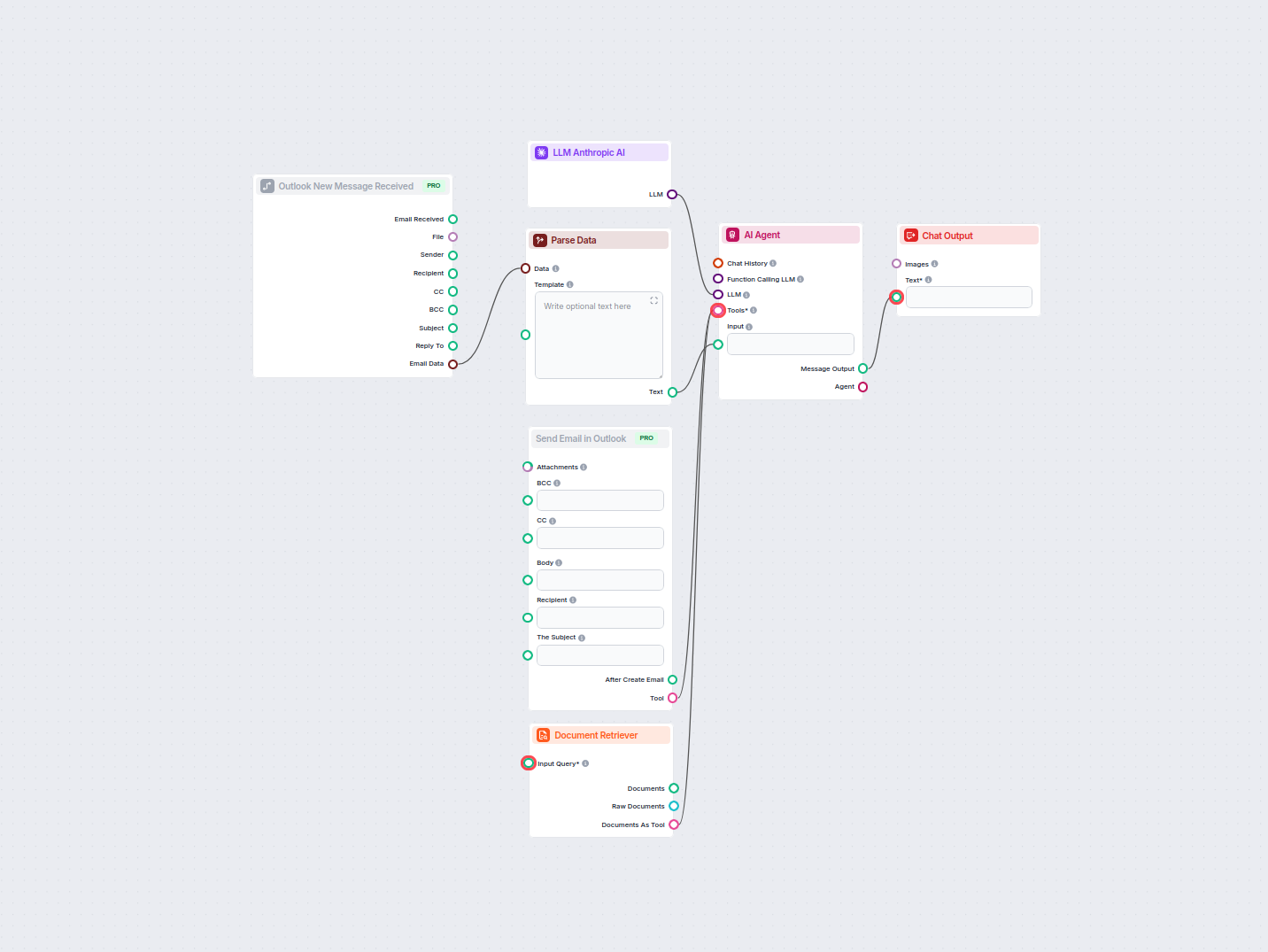

Automatizează răspunsurile profesionale la emailuri în Outlook folosind un agent AI care valorifică surse de cunoștințe organizaționale. Emailurile primite sunt...

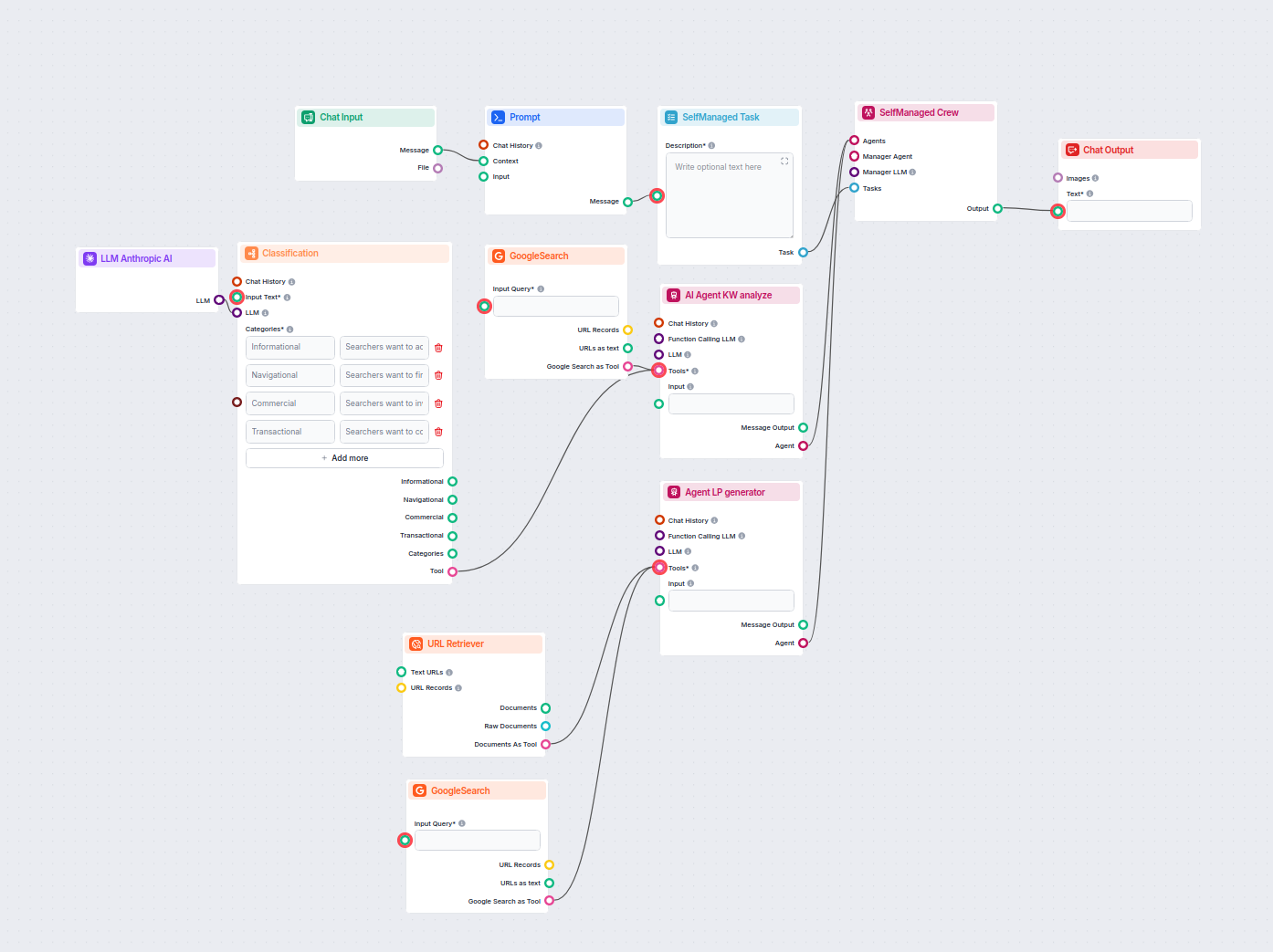

Acest flux de lucru alimentat de AI clasifică interogările de căutare după intenție, cercetează URL-urile de top și generează o pagină de destinație optimizată ...

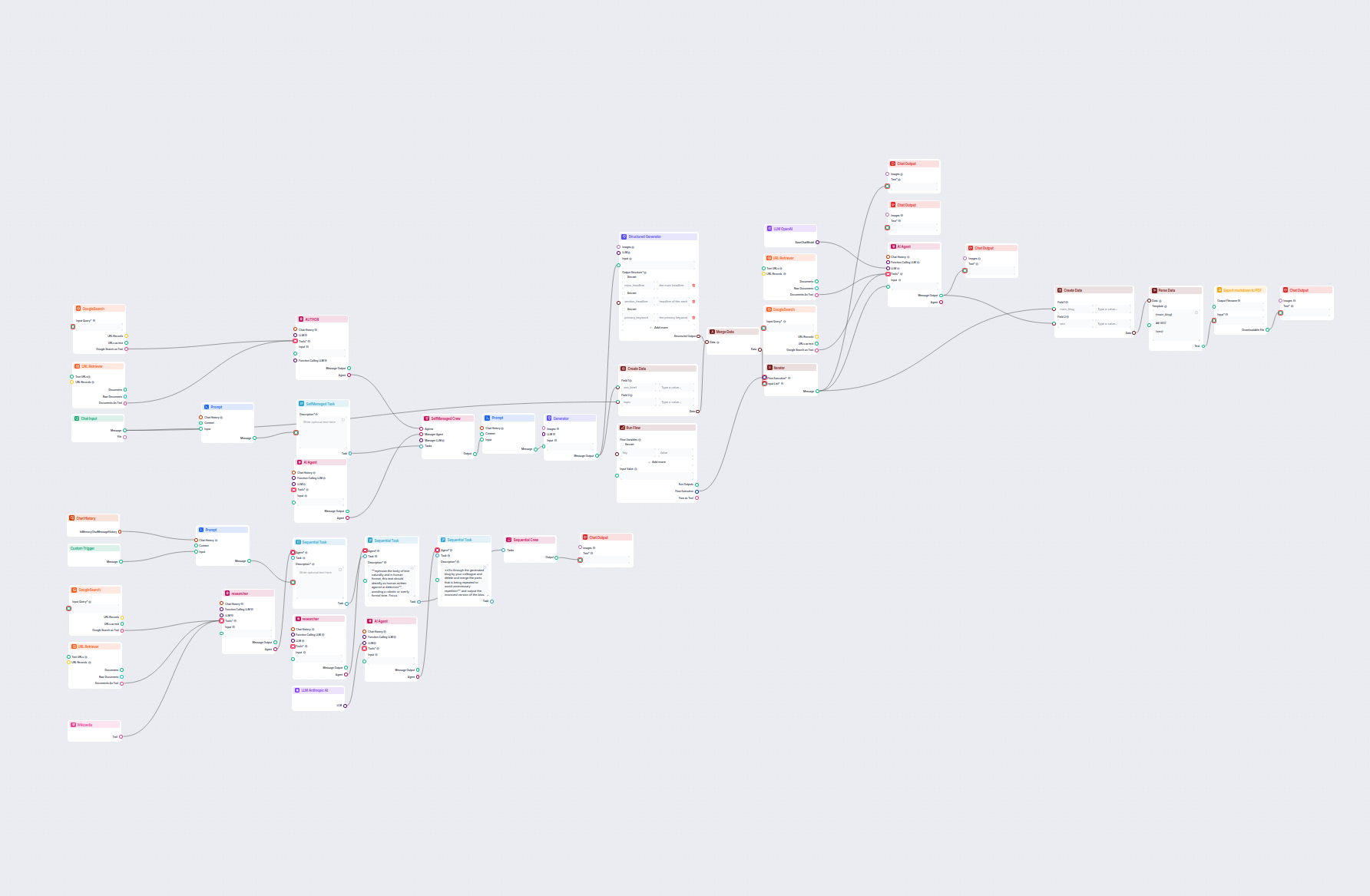

Generează postări de blog cuprinzătoare, optimizate SEO, cu structură avansată și număr mare de cuvinte, folosind mai mulți agenți AI. Fluxul include cercetare ...

Generează automat descrieri optimizate SEO pentru paginile de categorii din e-commerce folosind AI. Doar furnizează un URL de categorie, iar fluxul cercetează c...

Acest flux de lucru alimentat de AI cercetează competitorii și subiectele în tendință pentru a genera idei de blog cu impact puternic, optimizate SEO, pentru Fl...

Acest flux de lucru asistat de AI îmbunătățește descrierile produselor Shopify pe baza numelui produsului sau a URL-ului furnizat de utilizator. Folosește LLM-u...

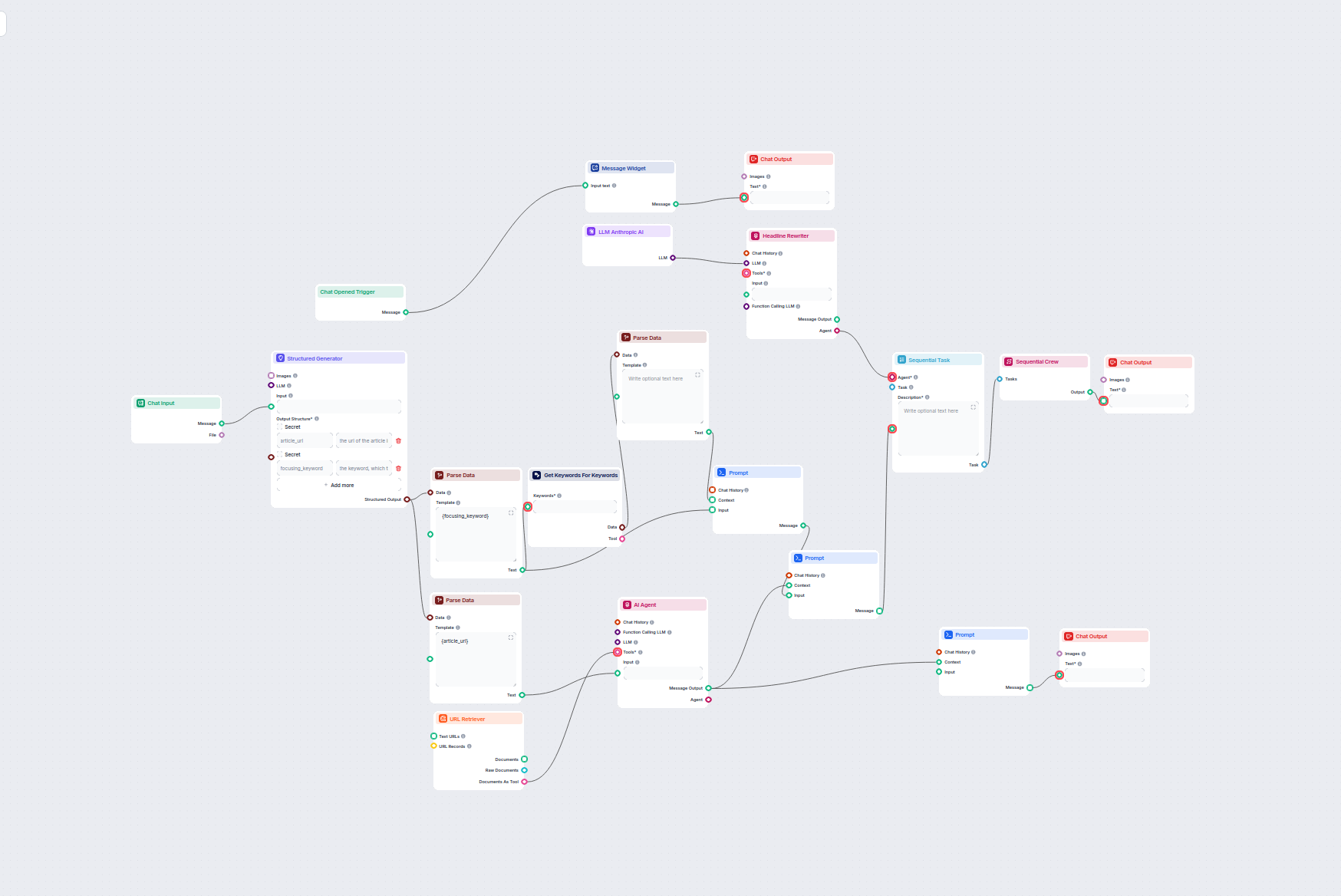

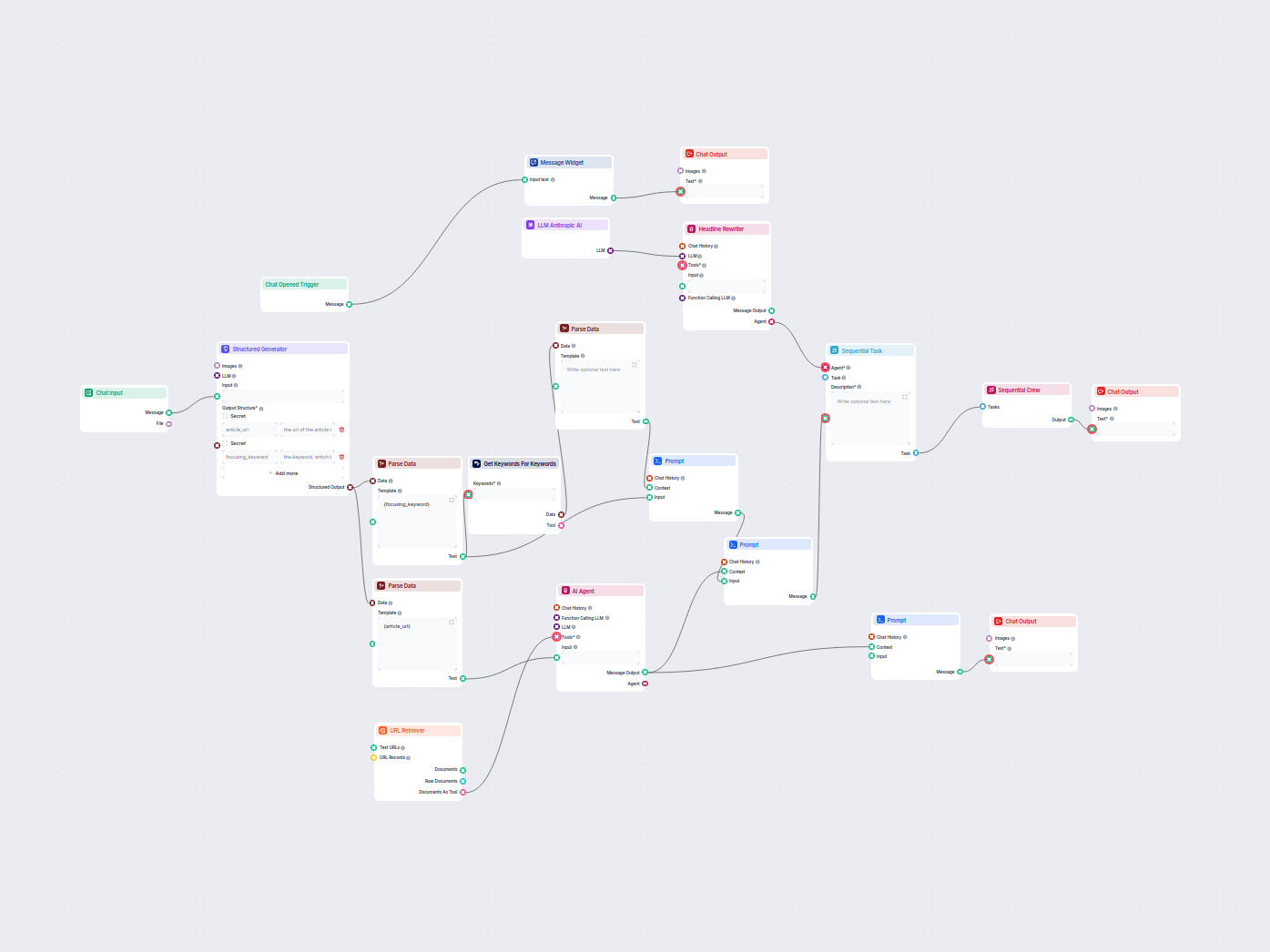

Acest flux de lucru bazat pe AI găsește cele mai bune cuvinte cheie SEO pentru articolul tău de blog și rescrie automat titlurile pentru a viza acele cuvinte ch...

Optimizează automat titlurile și subtitlurile articolului tău pentru un anumit cuvânt cheie sau un grup de cuvinte cheie pentru a îmbunătăți performanța SEO. Ac...

Componenta LLM Anthropic AI conectează modelele Claude de la Anthropic la flow-urile tale FlowHunt, permițându-ți să personalizezi ce model este folosit pentru generarea de text și să controlezi setări precum numărul maxim de tokeni și temperatura.

FlowHunt suportă toate modelele recente din familia Claude, inclusiv Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku și Claude 2.

Max tokens stabilește limita de lungime pentru fiecare răspuns, iar temperatura controlează gradul de aleatorietate—valori mai mici fac răspunsurile mai concentrate, valori mai mari cresc creativitatea.

Nu, conectarea componentei LLM Anthropic AI este opțională. Implicit, componentele folosesc ChatGPT-4o, dar poți adăuga această componentă pentru a trece la modelele Claude și a ajusta setările.

Începe să construiești instrumente AI personalizate și chatbot-uri folosind modelele Claude de la Anthropic, cu integrare ușoară în flow și configurare puternică.

FlowHunt suportă zeci de modele de generare de text, inclusiv modele de la OpenAI. Iată cum poți folosi ChatGPT în instrumentele și chatbot-urile tale AI.

FlowHunt acceptă zeci de modele de generare de text, inclusiv modelele Llama de la Meta. Află cum să integrezi Llama în instrumentele și chatbot-urile tale AI, ...

Descoperă puterea modelelor lingvistice personalizate cu componenta LLM OpenAI Personalizat din FlowHunt. Integrează fără efort propriile tale modele compatibil...