Analiză AI a Companiilor exportată în Google Sheets

Acest flux de lucru bazat pe inteligență artificială oferă o analiză cuprinzătoare și bazată pe date a unei companii. Colectează informații despre istoricul com...

Descoperă puterea modelelor Gemini de la Google în FlowHunt—schimbă modele AI, controlează setările și creează chatbot-uri AI mai inteligente cu ușurință.

Descrierea componentei

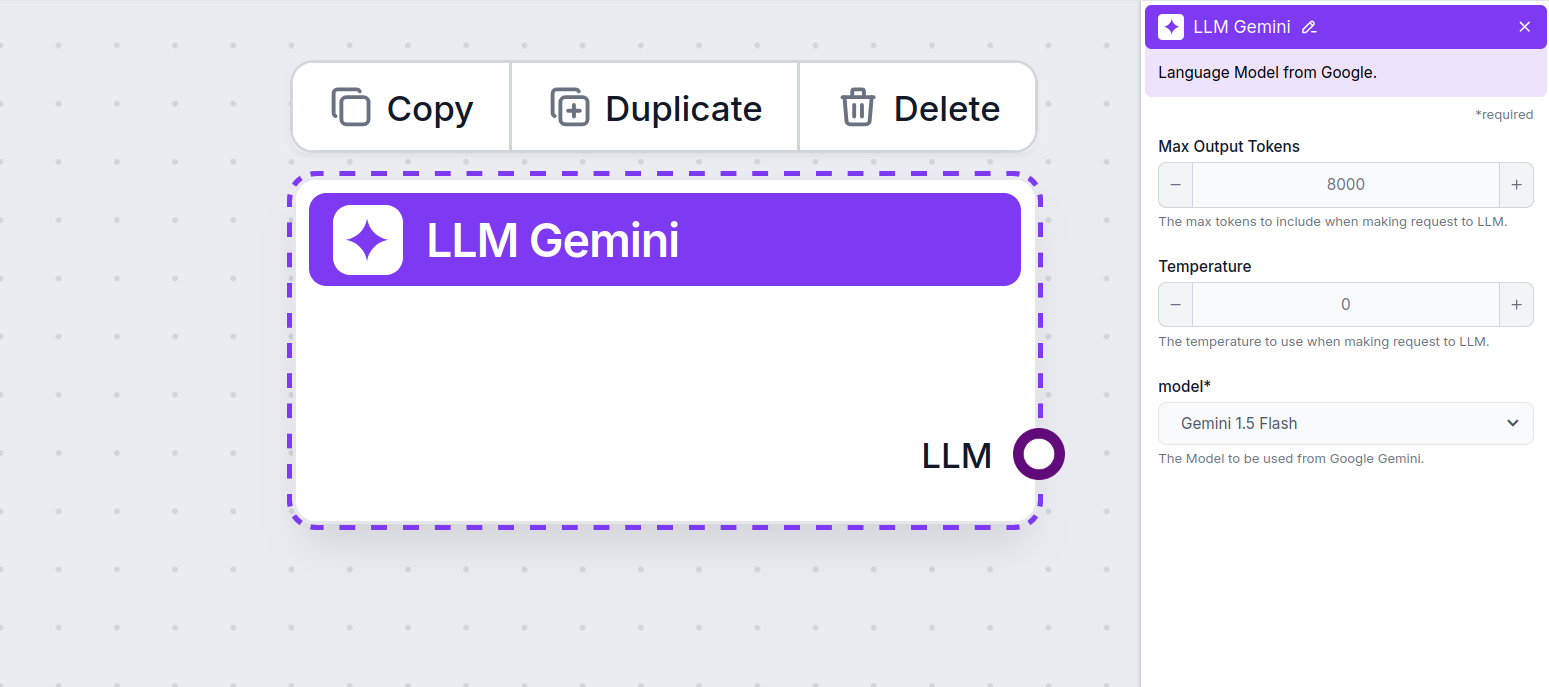

Componenta LLM Gemini conectează modelele Gemini de la Google la fluxul tău. În timp ce Generatorii și Agenții sunt locul unde se întâmplă magia propriu-zisă, componentele LLM îți permit să controlezi modelul folosit. Toate componentele vin cu ChatGPT-4 implicit. Poți conecta această componentă dacă dorești să schimbi modelul sau să ai mai mult control asupra acestuia.

Ține minte că conectarea unei componente LLM este opțională. Toate componentele care folosesc un LLM vin cu ChatGPT-4o ca opțiune implicită. Componentele LLM îți permit să schimbi modelul și să controlezi setările acestuia.

Tokenii reprezintă unități individuale de text pe care modelul le procesează și generează. Utilizarea tokenilor variază în funcție de model, iar un token poate fi orice, de la cuvinte sau sub-cuvinte până la un singur caracter. Modelele sunt de obicei taxate la milioane de tokeni.

Setarea max tokens limitează numărul total de tokeni care pot fi procesați într-o singură interacțiune sau solicitare, asigurând că răspunsurile sunt generate în limite rezonabile. Limita implicită este de 4.000 de tokeni, dimensiunea optimă pentru a rezuma documente și surse multiple pentru a genera un răspuns.

Temperature controlează variabilitatea răspunsurilor, variind de la 0 la 1.

O temperatură de 0.1 va face răspunsurile foarte la obiect, dar potențial repetitive și deficitare.

O temperatură ridicată de 1 permite creativitate maximă în răspunsuri, dar creează riscul unor răspunsuri irelevante sau chiar halucinatorii.

De exemplu, temperatura recomandată pentru un bot de asistență clienți este între 0.2 și 0.5. Acest nivel ar trebui să păstreze răspunsurile relevante și la subiect, permițând în același timp o variație naturală a răspunsurilor.

Acesta este selectorul de model. Aici vei găsi toate modelele Gemini suportate de Google. Susținem toate modelele Gemini de ultimă generație:

Vei observa că toate componentele LLM au doar un output handle. Inputul nu trece prin componentă, deoarece aceasta doar reprezintă modelul, în timp ce generarea efectivă are loc în AI Agenți și Generatoare.

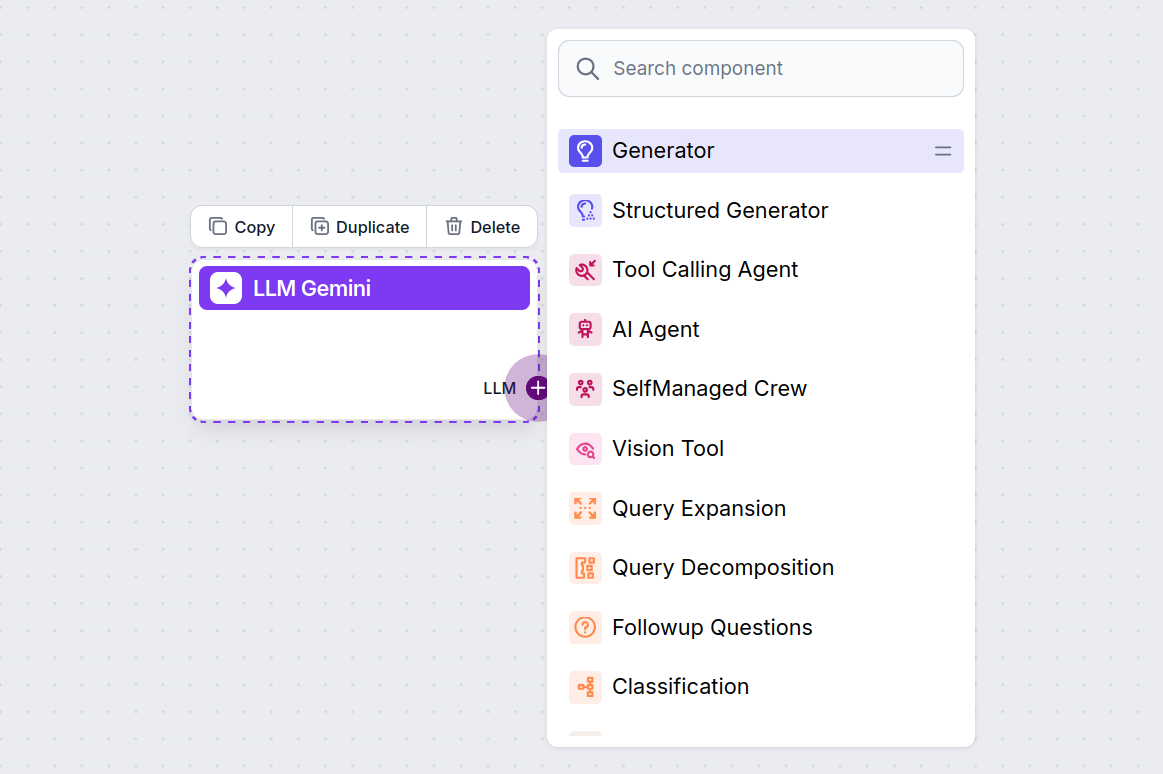

Handle-ul LLM este întotdeauna mov. Input handle-ul LLM se găsește pe orice componentă care folosește AI pentru a genera text sau a procesa date. Poți vedea opțiunile făcând clic pe handle:

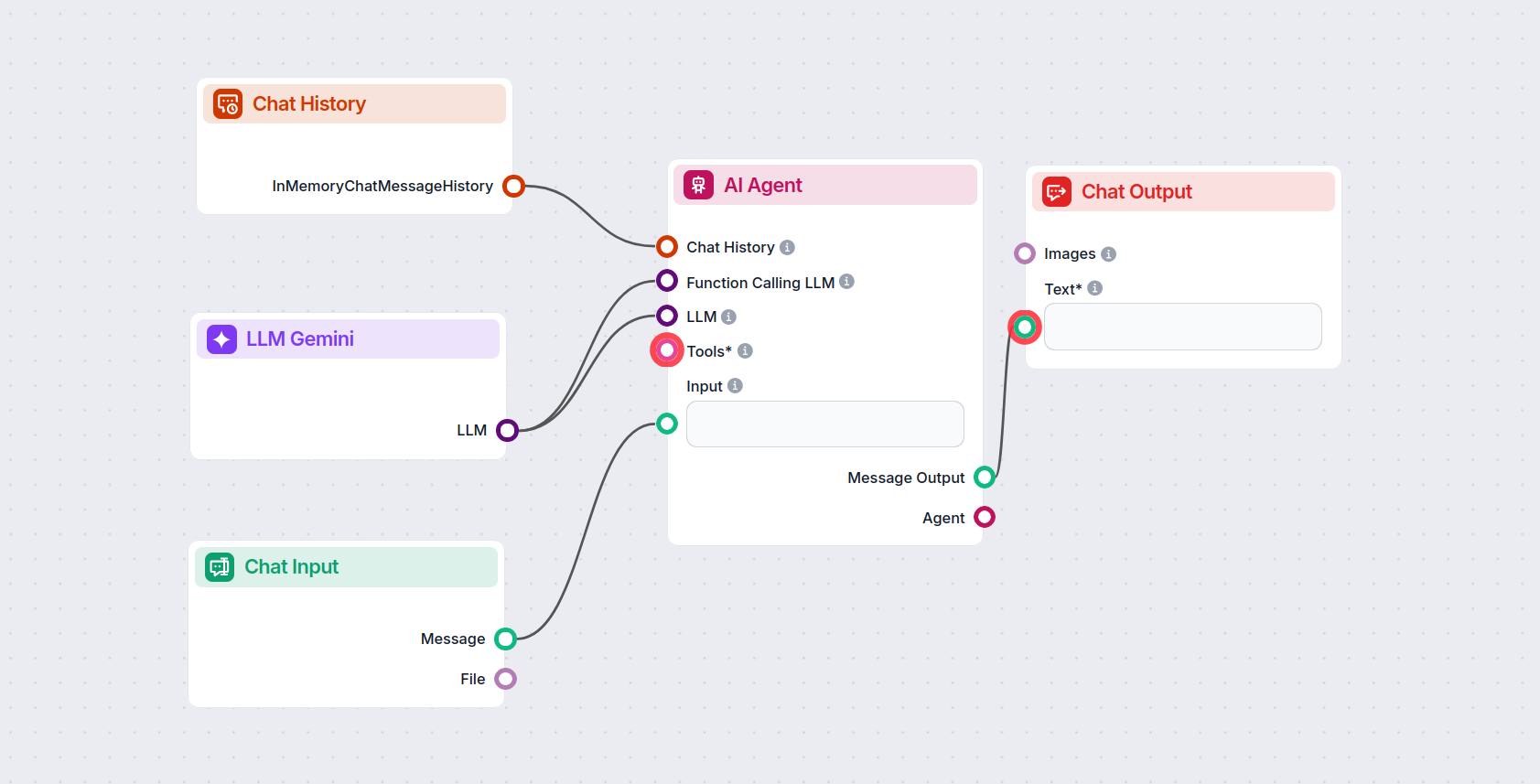

Aceasta îți permite să creezi tot felul de instrumente. Să vedem componenta în acțiune. Iată un flux simplu de chatbot AI Agent care folosește Gemini 2.0 Flash Experimental pentru a genera răspunsuri. Poți să îl privești ca pe un chatbot Gemini de bază.

Acest flux simplu de chatbot include:

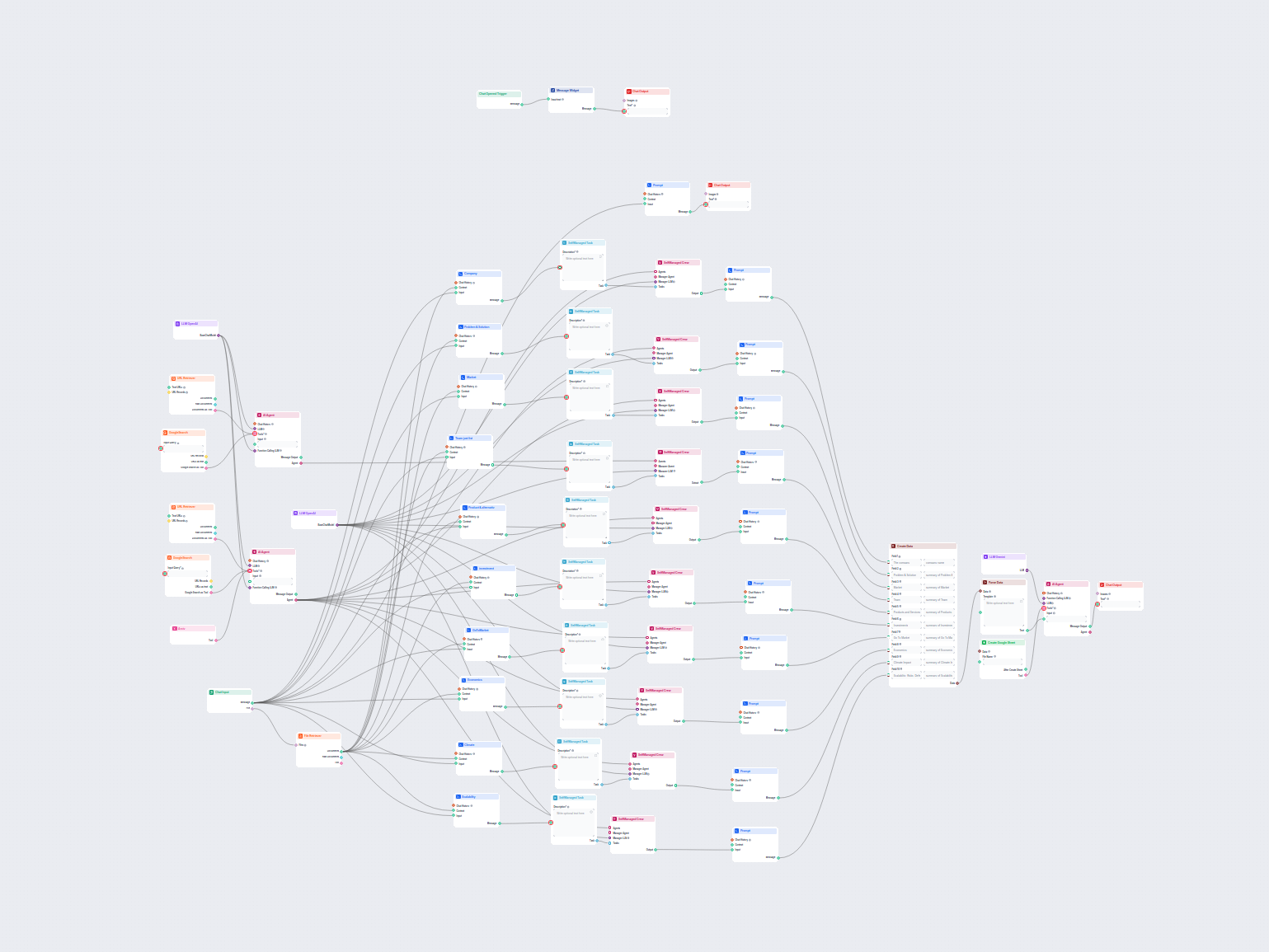

Pentru a te ajuta să începi rapid, am pregătit mai multe șabloane flow exemplu care demonstrează cum să folosești componenta LLM Gemini eficient. Aceste șabloane prezintă diferite cazuri de utilizare și cele mai bune practici, făcând mai ușor pentru tine să înțelegi și să implementezi componenta în propriile tale proiecte.

Acest flux de lucru bazat pe inteligență artificială oferă o analiză cuprinzătoare și bazată pe date a unei companii. Colectează informații despre istoricul com...

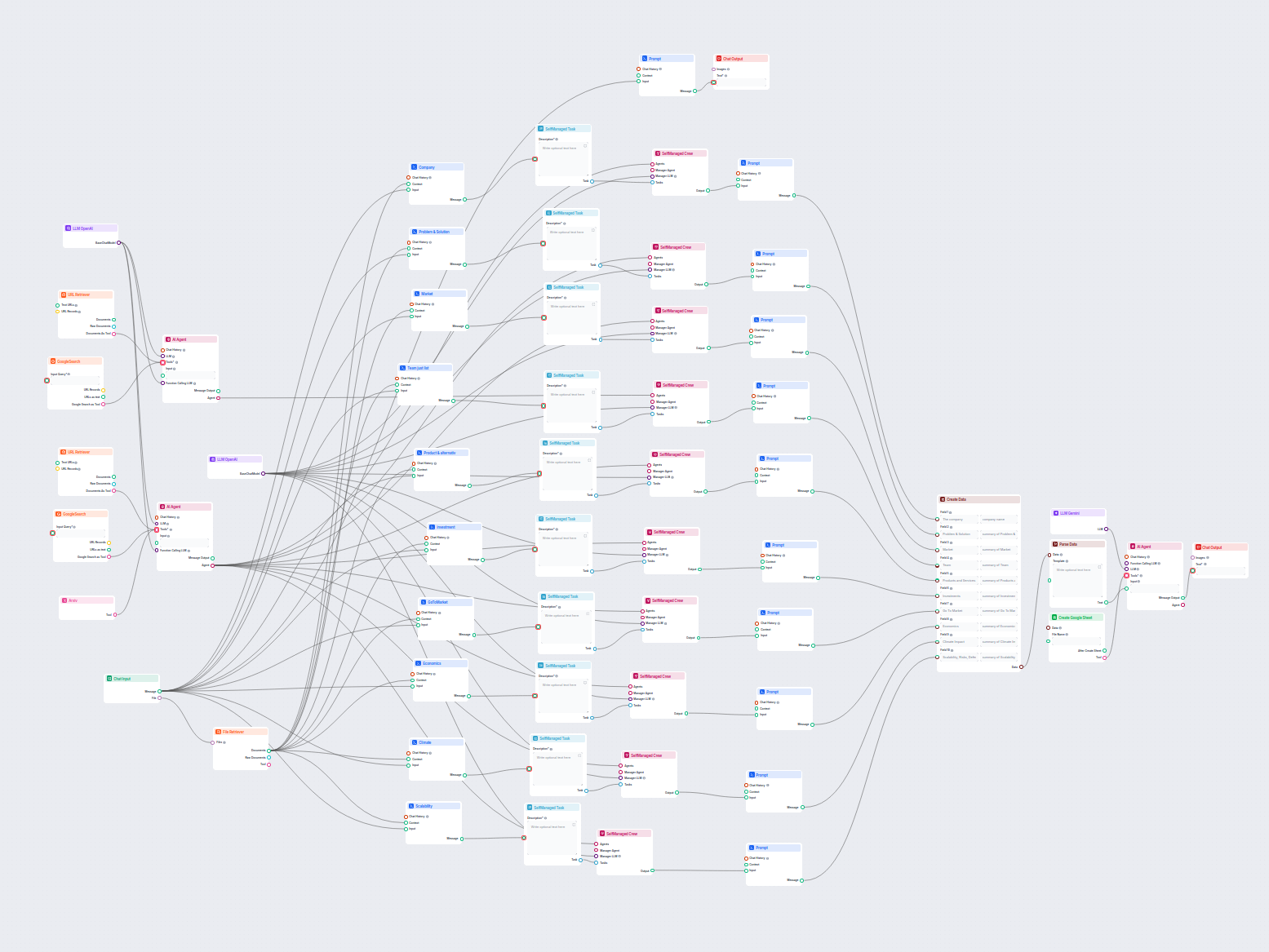

Acest flux de lucru cu AI analizează în profunzime orice companie, cercetând date și documente publice despre piață, echipă, produse, investiții și multe altele...

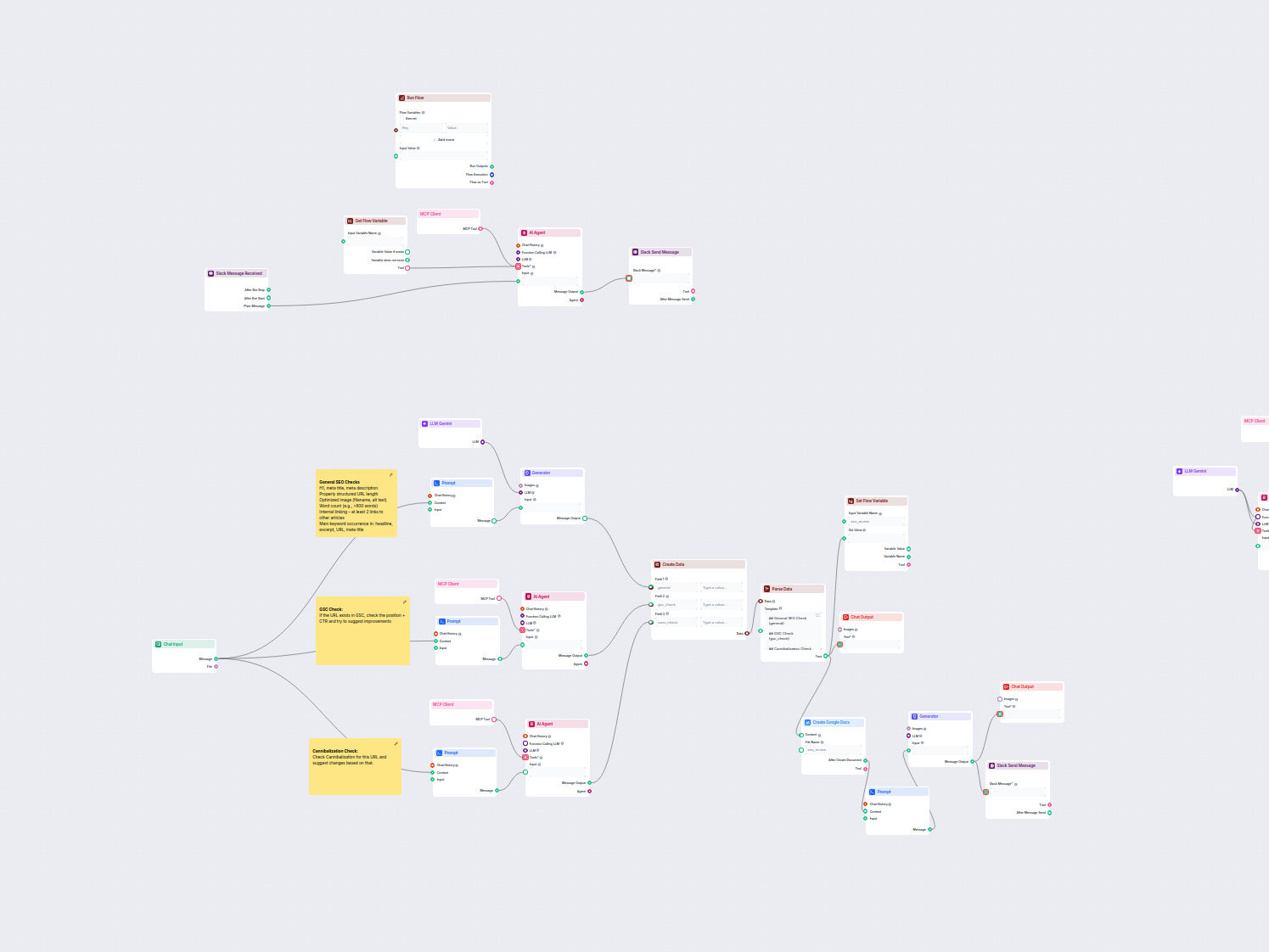

Acest workflow automatizează procesul de revizuire și audit SEO pentru paginile web. Analizează conținutul paginii pentru cele mai bune practici SEO, efectuează...

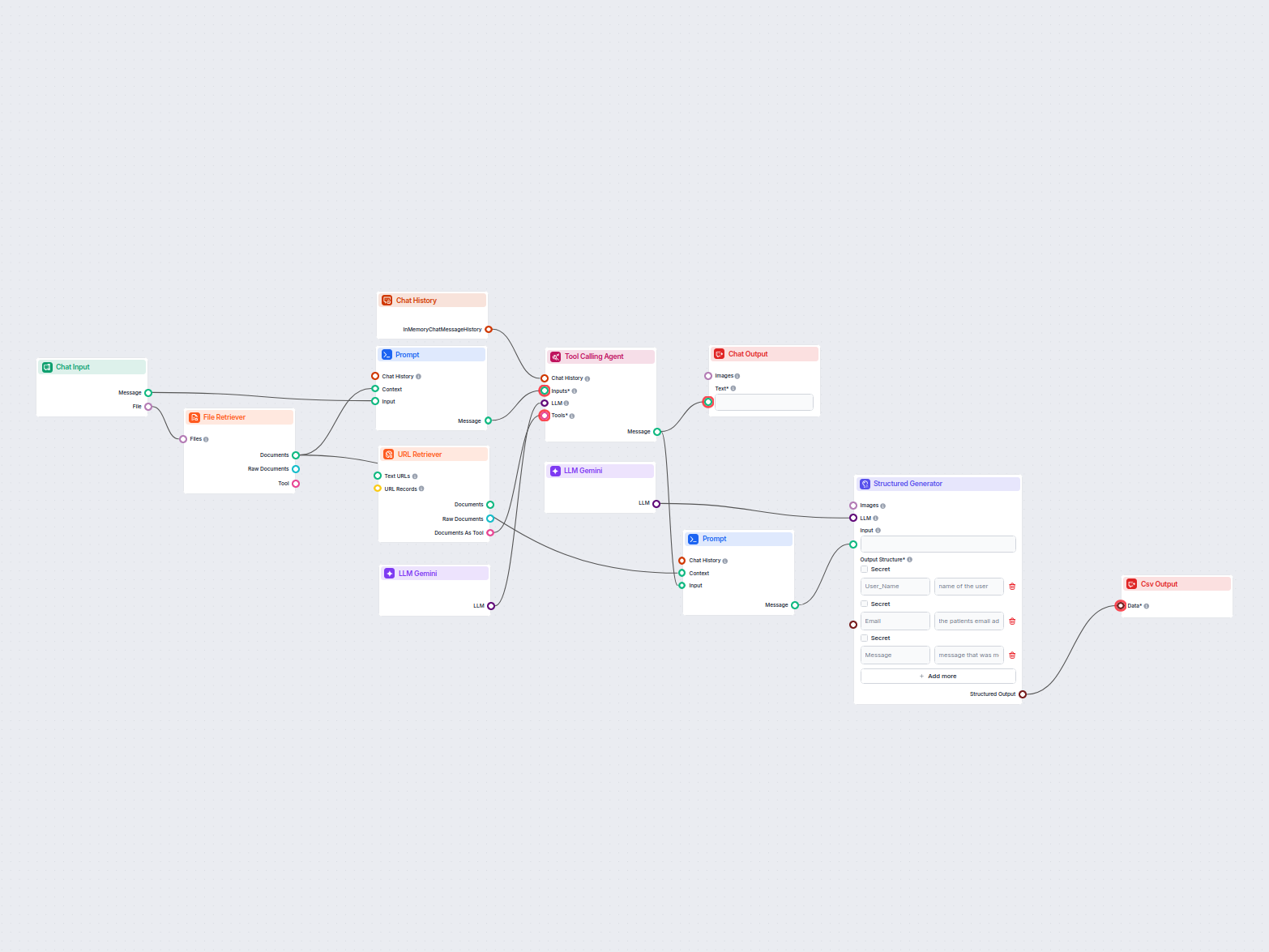

Acest flux extrage și organizează informațiile cheie din emailuri și fișiere atașate, utilizează AI pentru a procesa și structura datele și exportă rezultatele ...

LLM Gemini conectează modelele Gemini de la Google la fluxurile tale AI în FlowHunt, permițându-ți să alegi dintre cele mai noi variante Gemini pentru generarea de text și să le personalizezi comportamentul.

FlowHunt suportă Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B și Gemini 1.5 Pro—fiecare oferind capabilități unice pentru text, imagine, audio și video.

Max Tokens limitează lungimea răspunsului, iar Temperature controlează creativitatea—valori mici oferă răspunsuri concentrate, valori mari permit mai multă varietate. Ambele pot fi setate individual pentru fiecare model în FlowHunt.

Nu, folosirea componentelor LLM este opțională. Toate fluxurile AI au implicit ChatGPT-4o, dar adăugând LLM Gemini poți comuta la modelele Google și ajusta setările acestora.

Începe să creezi chatbot-uri AI avansate și instrumente cu Gemini și alte modele de top—totul într-un singur dashboard. Schimbă modele, personalizează setări și eficientizează fluxurile de lucru.

FlowHunt suportă zeci de modele AI, inclusiv modelele revoluționare DeepSeek. Iată cum să folosești DeepSeek în instrumentele și chatbot-urile tale AI.

FlowHunt acceptă zeci de modele AI de generare de text, inclusiv modele de la Mistral. Iată cum poți folosi Mistral în instrumentele și chatbot-urile tale AI....

FlowHunt acceptă zeci de modele de generare de text, inclusiv modelele Llama de la Meta. Află cum să integrezi Llama în instrumentele și chatbot-urile tale AI, ...