LLM Meta AI

FlowHunt acceptă zeci de modele de generare de text, inclusiv modelele Llama de la Meta. Află cum să integrezi Llama în instrumentele și chatbot-urile tale AI, ...

LLM xAI de la FlowHunt îți permite să integrezi modelele de generare text xAI, precum Grok-beta, în chatboții și uneltele tale AI, cu setări flexibile pentru tokeni, temperatură și selecția modelului.

Descrierea componentei

Componenta LLM xAI conectează modelul Grok la fluxul tău. Deși Generatoarele și Agenții sunt locul unde are loc magia propriu-zisă, componentele LLM îți permit să controlezi modelul folosit. Toate componentele vin cu ChatGPT-4 implicit. Poți conecta această componentă dacă dorești să schimbi modelul sau să ai mai mult control asupra lui.

Ține minte că conectarea unei componente LLM este opțională. Toate componentele care folosesc un LLM vin cu ChatGPT-4o ca implicit. Componentele LLM îți permit să schimbi modelul și să controlezi setările acestuia.

Tokenii reprezintă unități individuale de text pe care modelul le procesează și generează. Utilizarea tokenilor variază de la un model la altul, iar un token poate fi orice, de la cuvinte sau subcuvinte la un singur caracter. Modelele sunt, de obicei, tarifate la milioane de tokeni.

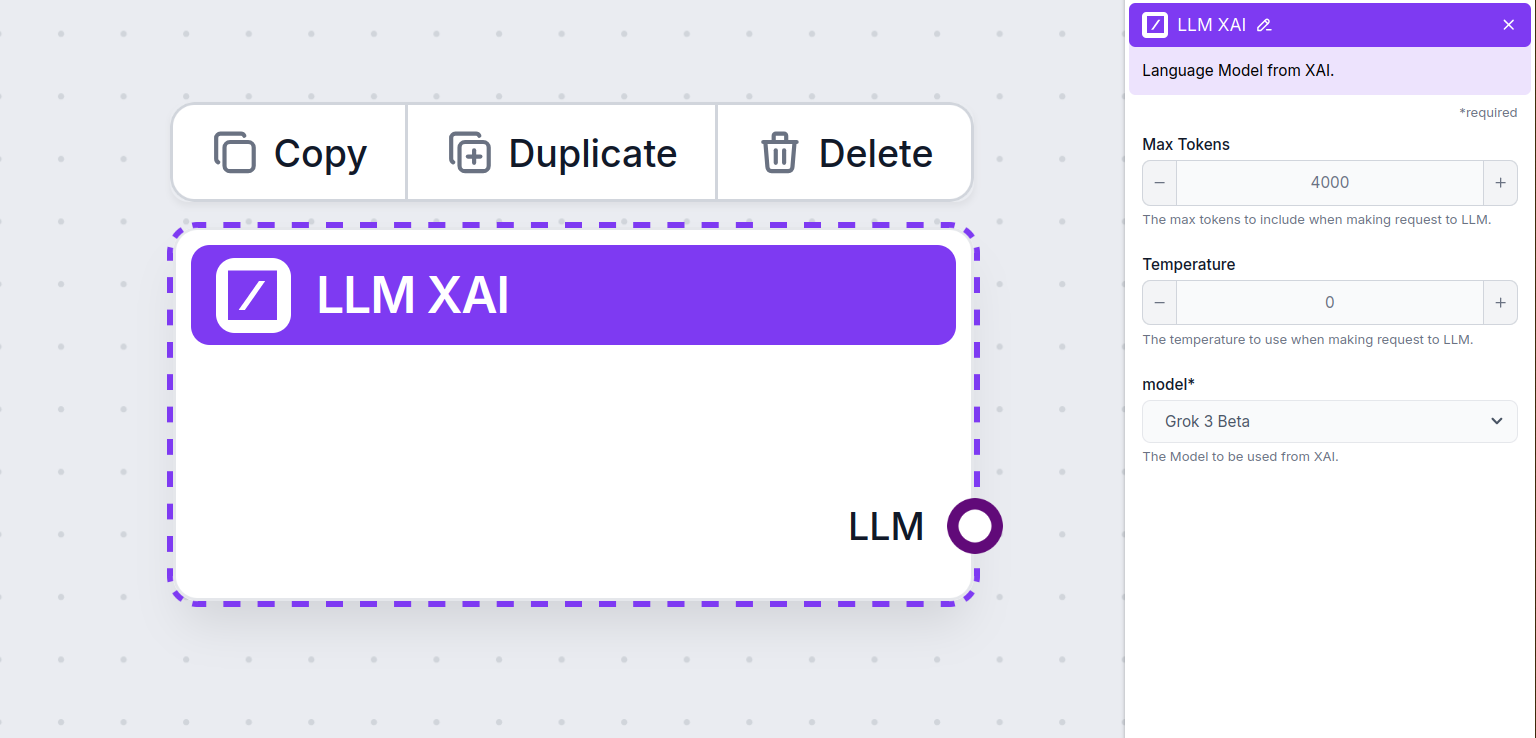

Setarea pentru numărul maxim de tokeni limitează numărul total de tokeni care pot fi procesați într-o singură interacțiune sau cerere, asigurând că răspunsurile sunt generate în limite rezonabile. Limita implicită este de 4.000 tokeni, aceasta fiind dimensiunea optimă pentru rezumarea documentelor și a mai multor surse pentru a genera un răspuns.

Temperatura controlează variația răspunsurilor, având valori de la 0 la 1.

O temperatură de 0.1 va face răspunsurile foarte la obiect, dar potențial repetitive și deficitare.

O temperatură ridicată de 1 permite o creativitate maximă în răspunsuri, dar crește riscul de răspunsuri irelevante sau chiar halucinatorii.

De exemplu, temperatura recomandată pentru un chatbot de suport clienți este între 0.2 și 0.5. Acest nivel ar trebui să mențină răspunsurile relevante și la subiect, permițând totodată o variație naturală a răspunsurilor.

Acesta este selectorul de model. Aici vei găsi toate modelele acceptate de furnizorul xAI. Modelul principal de text al xAI se numește Grok. În prezent, acceptăm doar modelul grok-beta, deoarece este singurul lansat pentru utilizare publică prin API.

Vrei să afli mai multe despre Grok-beta și să vezi cum se compară cu alte modele? Citește acest articol.

Vei observa că toate componentele LLM au doar un output handle. Intrarea nu trece prin componentă, deoarece aceasta reprezintă doar modelul, iar generarea efectivă are loc în AI Agenți și Generatoare.

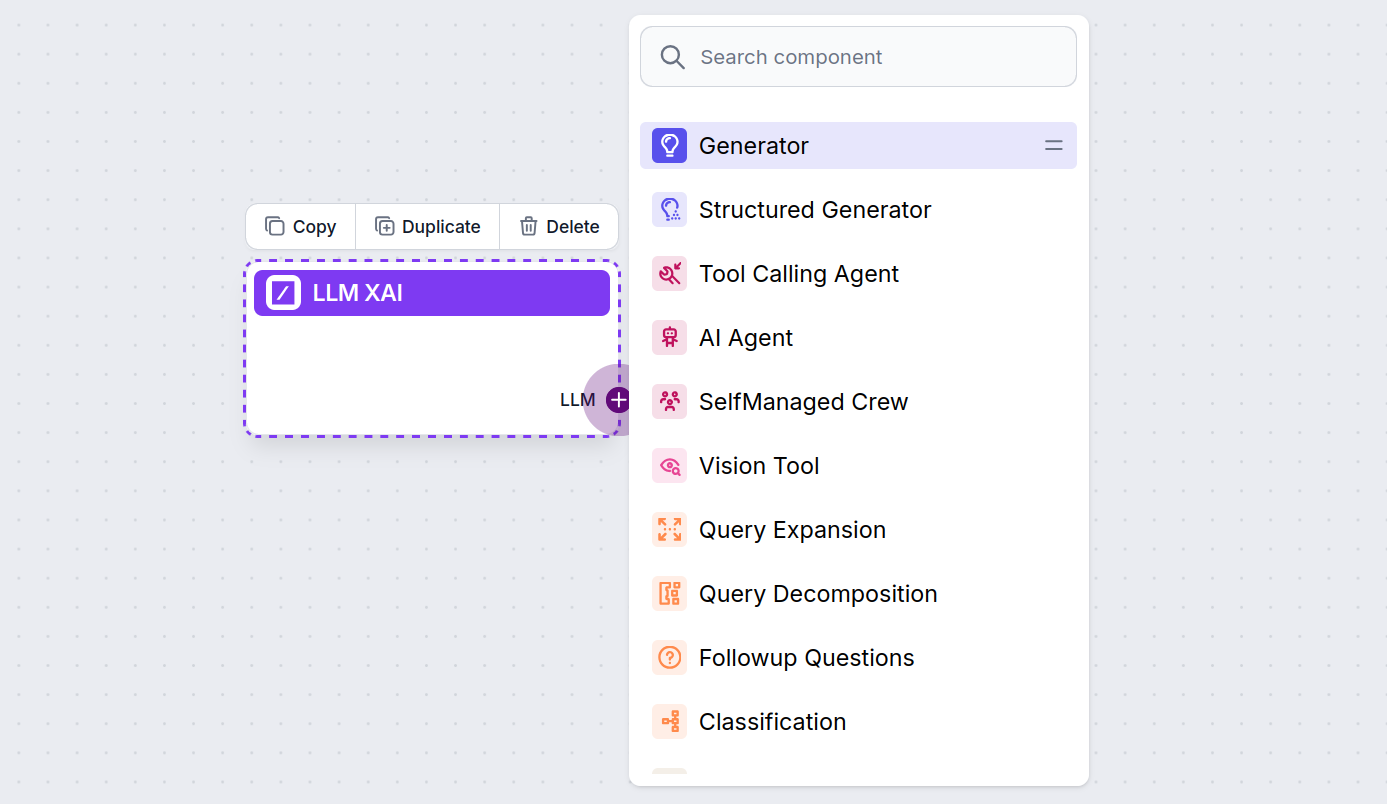

Handle-ul LLM este întotdeauna mov. Handle-ul de intrare LLM se găsește pe orice componentă care folosește AI pentru generarea textului sau procesarea datelor. Poți vedea opțiunile făcând clic pe handle:

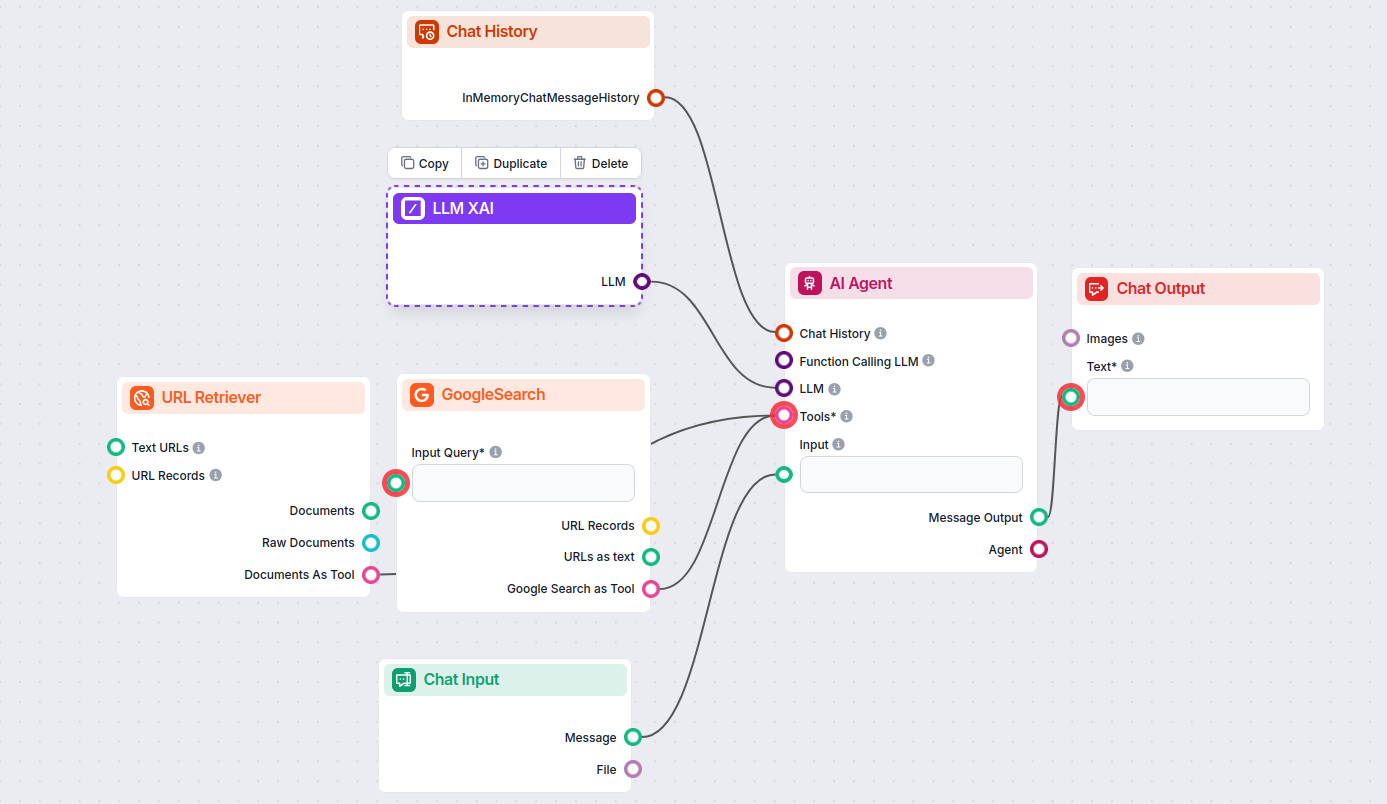

Aceasta îți permite să creezi tot felul de unelte. Să vedem componenta în acțiune. Iată un flux simplu de chatbot AI Agent care folosește grok-beta de la xAI pentru a genera răspunsuri. Îl poți privi ca pe un chatbot xAI de bază.

Acest flux simplu de Chatbot include:

LLM xAI este o componentă FlowHunt care îți permite să conectezi și să controlezi modelele de generare text ale furnizorilor xAI, precum Grok-beta, în fluxurile și chatboții tăi AI.

În prezent, FlowHunt acceptă modelul grok-beta de la xAI, urmând ca mai multe modele să fie adăugate pe măsură ce devin disponibile pentru utilizare publică prin API.

Poți ajusta numărul maxim de tokeni, temperatura (variația răspunsurilor) și poți selecta din modelele xAI disponibile pentru a personaliza comportamentul chatbotului sau uneltei AI.

Nu, este opțional. În mod implicit, componentele folosesc ChatGPT-4o, însă poți conecta LLM xAI pentru a trece la modele xAI sau pentru a obține mai mult control.

Adaugă pur și simplu componenta LLM la fluxul tău; aceasta acționează ca un selector de model. Generarea efectivă de text are loc în AI Agenți și Generatoare conectate la ea.

Începe să construiești chatboți AI și unelte mai inteligente cu FlowHunt. Conectează-te la cele mai bune modele xAI precum Grok-beta într-un panou flexibil, fără cod.

FlowHunt acceptă zeci de modele de generare de text, inclusiv modelele Llama de la Meta. Află cum să integrezi Llama în instrumentele și chatbot-urile tale AI, ...

FlowHunt suportă zeci de modele de generare de text, inclusiv modele de la OpenAI. Iată cum poți folosi ChatGPT în instrumentele și chatbot-urile tale AI.

FlowHunt suportă zeci de modele AI, inclusiv modelele revoluționare DeepSeek. Iată cum să folosești DeepSeek în instrumentele și chatbot-urile tale AI.