Rețele Neuronale Artificiale (ANN-uri)

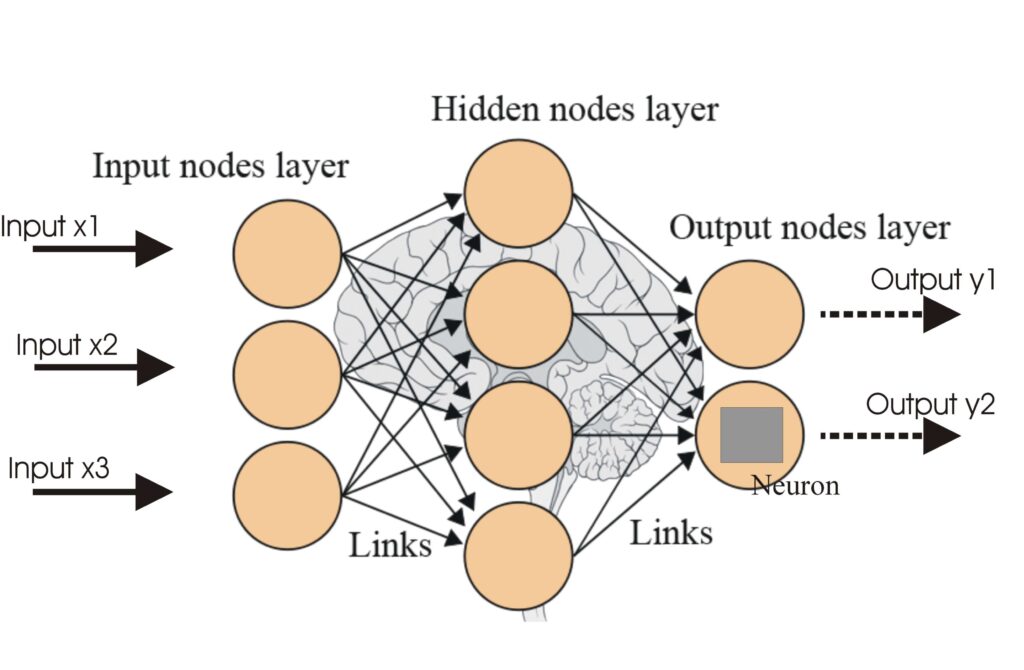

Rețelele Neuronale Artificiale (ANN-uri) sunt o subcategorie de algoritmi de învățare automată modelați după creierul uman. Aceste modele computaționale constau...

Funcțiile de activare introduc non-liniaritate în rețelele neuronale, permițându-le să învețe tipare complexe esențiale pentru aplicații AI și deep learning.

Funcțiile de activare sunt fundamentale pentru arhitectura rețelelor neuronale artificiale (ANN), influențând semnificativ capacitatea rețelei de a învăța și de a executa sarcini complexe. Acest articol din glosar aprofundează complexitățile funcțiilor de activare, analizând scopul, tipurile și aplicațiile lor, în special în domeniile AI, deep learning și rețele neuronale.

O funcție de activare într-o rețea neuronală este o operație matematică aplicată asupra ieșirii unui neuron. Ea determină dacă un neuron trebuie activat sau nu, introducând non-liniaritate în model, ceea ce permite rețelei să învețe tipare complexe. Fără aceste funcții, o rețea neuronală ar acționa practic ca un model de regresie liniară, indiferent de adâncimea sau numărul său de straturi.

Funcția Sigmoid

Funcția Tanh

ReLU (Rectified Linear Unit)

Leaky ReLU

Funcția Softmax

Funcția Swish

Funcțiile de activare sunt esențiale în diverse aplicații AI, inclusiv:

O funcție de activare este o operație matematică aplicată asupra ieșirii unui neuron, introducând non-liniaritate și permițând rețelelor neuronale să învețe tipare complexe dincolo de relațiile liniare simple.

Funcțiile de activare permit rețelelor neuronale să rezolve probleme complexe, non-liniare, prin învățarea unor tipare sofisticate, fiind cruciale pentru sarcini precum clasificarea imaginilor, procesarea limbajului și automatizare.

Tipuri comune includ Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax și Swish, fiecare având caracteristici și utilizări specifice în diferite straturi ale rețelelor neuronale.

Provocări frecvente includ problema gradientului care dispare (în special la Sigmoid și Tanh), dying ReLU și costuri computaționale ridicate pentru funcții precum Softmax în aplicații în timp real.

Chatboți inteligenți și instrumente AI sub același acoperiș. Conectează blocuri intuitive pentru a-ți transforma ideile în Fluxuri automatizate.

Rețelele Neuronale Artificiale (ANN-uri) sunt o subcategorie de algoritmi de învățare automată modelați după creierul uman. Aceste modele computaționale constau...

O rețea neuronală, sau rețea neuronală artificială (ANN), este un model computațional inspirat de creierul uman, esențial în AI și învățarea automată pentru sar...

Rețelele neuronale recursive (RNN) sunt o clasă sofisticată de rețele neuronale artificiale proiectate pentru a procesa date secvențiale utilizând memoria intră...