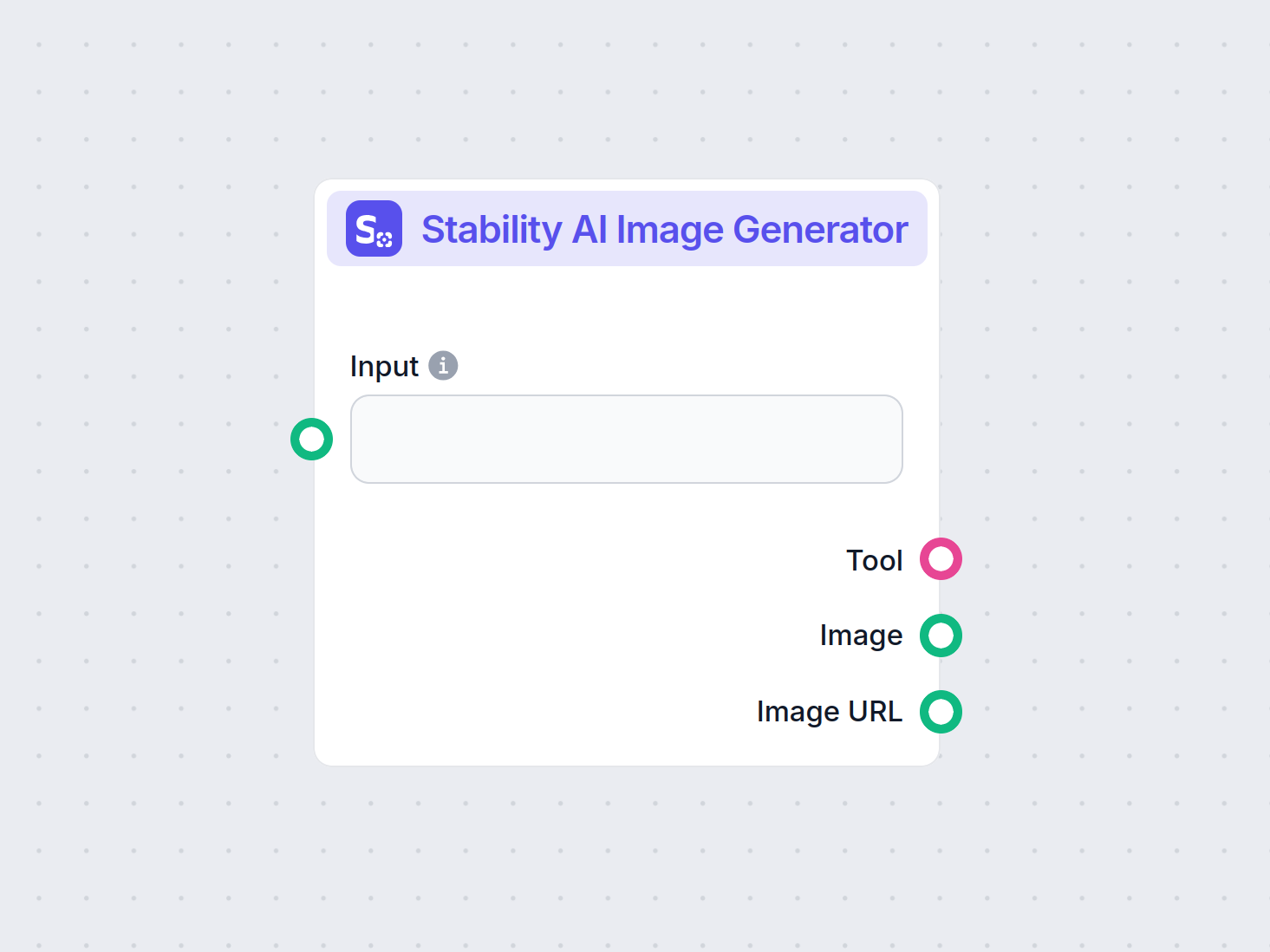

Generator de imagini Stability AI

Generează imagini de înaltă calitate din prompturi text cu componenta Generator de imagini Stability AI. Alimentat de modelele Stable Diffusion, acest instrumen...

Stable Diffusion este un model AI de top pentru text-în-imagine, care permite utilizatorilor să genereze imagini fotorealiste din indicații folosind tehnici avansate de difuzie latentă și învățare profundă.

Stable Diffusion este un model AI text-în-imagine care creează imagini de înaltă calitate din descrieri folosind învățarea profundă. Utilizează tehnici precum prompturi negative și imagini de referință pentru rezultate mai bune, mai ales cu elemente complexe precum mâinile.

Stable Diffusion este un model avansat de generare text-în-imagine care utilizează tehnici de învățare profundă pentru a produce imagini fotorealiste, de înaltă calitate, pe baza descrierilor textuale. Dezvoltat ca model de difuzie latentă, reprezintă o descoperire semnificativă în domeniul inteligenței artificiale generative, combinând principiile modelelor de difuzie și ale învățării automate pentru a crea imagini ce reflectă fidel prompturile textuale.

Stable Diffusion folosește învățarea profundă și modele de difuzie pentru a genera imagini prin rafinarea zgomotului aleator pentru a crea vizuale coerente. Chiar dacă a fost antrenat pe milioane de imagini, întâmpină dificultăți la elemente complexe, precum mâinile. În timp, pe măsură ce modelele sunt antrenate pe seturi de date din ce în ce mai mari, aceste probleme se diminuează și calitatea imaginilor devine tot mai realistă.

O metodă eficientă de a aborda problema mâinilor este folosirea prompturilor negative. Adăugând expresii precum (-bad anatomy) sau (-bad hands -unnatural hands) la prompturile tale, poți indica AI-ului să evite generarea unor trăsături distorsionate. Atenție însă la suprasolicitarea prompturilor negative, deoarece pot limita creativitatea modelului.

O altă tehnică implică utilizarea imaginilor de referință pentru a ghida AI-ul. Prin includerea unui tag {image} cu un link către o imagine de referință în prompt, oferi AI-ului un șablon vizual pentru redarea corectă a mâinilor. Aceasta este utilă mai ales pentru a menține proporțiile și pozițiile corecte ale mâinilor.

Pentru rezultate cât mai bune, combină prompturile negative cu imaginile de referință. Această abordare asigură că AI-ul evită erorile comune și urmează exemple de calitate.

(-bent fingers) sau (realistic perspectives) pentru a îmbunătăți și mai mult calitatea mâinilor.Stăpânind aceste tehnici, poți îmbunătăți semnificativ redarea mâinilor în creațiile tale cu Stable Diffusion, obținând lucrări artistice cu rafinamentul unui profesionist. Strânge imaginile de referință, formulează prompturi precise și urmărește cum arta ta AI evoluează!

La bază, Stable Diffusion transformă prompturile text în reprezentări vizuale printr-o serie de procese computaționale. Înțelegerea funcționalității implică aprofundarea conceptelor de modele de difuzie, spații latente și rețele neuronale.

Modelele de difuzie sunt o clasă de modele generative în învățarea automată care învață să creeze date inversând un proces de difuzie. Procesul de difuzie implică adăugarea treptată de zgomot la date—precum imaginile—până când acestea devin indistincte de zgomotul aleator. Modelul învață apoi să inverseze acest proces, eliminând zgomotul pas cu pas pentru a recupera datele originale. Acest proces invers de difuzie este cheia generării de date noi, coerente, pornind de la zgomot.

Stable Diffusion folosește în mod specific un model de difuzie latentă. Spre deosebire de modelele tradiționale de difuzie care operează direct în spațiul pixelilor, modelele de difuzie latentă lucrează într-un spațiu latent comprimat. Acest spațiu latent este o reprezentare de dimensiuni reduse a datelor, captând trăsăturile esențiale și reducând complexitatea computațională. Prin operarea în spațiul latent, Stable Diffusion poate genera imagini de înaltă rezoluție mult mai eficient.

Mecanismul central al Stable Diffusion implică procesul invers de difuzie în spațiul latent. Pornind de la un vector latent de zgomot aleator, modelul rafinează iterativ această reprezentare latentă, prezicând și eliminând zgomotul la fiecare pas. Această rafinare este ghidată de descrierea textuală oferită de utilizator. Procesul continuă până când vectorul latent converge către o stare care, decodată, produce o imagine conformă cu promptul text.

Arhitectura Stable Diffusion integrează mai multe componente esențiale care colaborează pentru a transforma prompturile text în imagini.

VAE acționează ca sistem de codare-decodare care comprimă imaginile în spațiul latent și le reconstruiește înapoi în imagini. Encoder-ul transformă o imagine într-o reprezentare latentă, captând trăsăturile fundamentale într-o formă redusă. Decoder-ul ia această reprezentare latentă și o reconstruiește într-o imagine detaliată.

Acest proces este crucial deoarece permite modelului să lucreze cu date de dimensiuni mai mici, reducând semnificativ resursele computaționale comparativ cu operarea direct în spațiul pixelilor.

U-Net este o arhitectură neuronală specializată folosită în Stable Diffusion pentru sarcini de procesare a imaginilor. Are o cale de codare și una de decodare, cu conexiuni între straturi pereche. În contextul Stable Diffusion, U-Net funcționează ca predictor de zgomot în procesul invers de difuzie.

La fiecare pas al procesului de difuzie, U-Net prezice cantitatea de zgomot prezentă în reprezentarea latentă. Această predicție este folosită pentru a rafina vectorul latent prin scăderea zgomotului estimat, denoizând progresiv spațiul latent către o imagine aliniată cu promptul text.

Pentru a integra informația textuală, Stable Diffusion folosește un encoder text bazat pe modelul CLIP (Contrastive Language-Image Pretraining). CLIP este conceput pentru a înțelege și corela informația textuală și vizuală, mapându-le într-un spațiu latent comun.

Când utilizatorul oferă un prompt text, encoderul convertește promptul într-o serie de embedding-uri—reprezentări numerice ale datelor textuale. Aceste embedding-uri condiționează U-Net în procesul invers de difuzie, ghidând generarea imaginii pentru a reflecta conținutul promptului.

Stable Diffusion oferă versatilitate în generarea de imagini și poate fi folosit în diverse moduri, în funcție de nevoile utilizatorului.

Utilizarea principală a Stable Diffusion este generarea de imagini din prompturi text. Utilizatorii introduc o descriere, iar modelul generează o imagine care reflectă descrierea. De exemplu, un utilizator poate introduce „O plajă liniștită la apus cu palmieri” și va primi o imagine care ilustrează această scenă.

Această capacitate este deosebit de valoroasă în industriile creative, crearea de conținut și design, unde vizualizarea rapidă a conceptelor este esențială.

Pe lângă generarea de imagini de la zero, Stable Diffusion poate și modifica imagini existente pe baza instrucțiunilor textuale. Oferind o imagine inițială și un prompt text, modelul poate produce o imagine nouă care integrează modificările descrise în text.

De exemplu, un utilizator poate introduce o imagine cu un oraș ziua și promptul „transformă în noapte cu lumini neon”, rezultând o imagine modificată conform cerințelor.

Inpainting-ul presupune completarea părților lipsă sau corupte dintr-o imagine. Stable Diffusion excelează aici, folosind prompturi text pentru a ghida reconstrucția anumitor zone. Utilizatorii pot masca porțiuni ale unei imagini și pot oferi descrieri textuale pentru completare.

Această funcție este utilă la restaurarea fotografiilor, eliminarea elementelor nedorite sau modificarea unor detalii, menținând coerența generală a imaginii.

Prin generarea de secvențe de imagini cu variații mici, Stable Diffusion poate fi extins pentru a crea animații sau conținut video. Instrumente ca Deforum extind capacitățile Stable Diffusion pentru a produce conținut vizual dinamic, ghidat de prompturi text pe parcursul timpului.

Aceasta deschide noi posibilități în animație, efecte vizuale și generare de conținut dinamic fără tehnici tradiționale de animație cadru cu cadru.

Capacitatea Stable Diffusion de a genera imagini din descrieri textuale îl face un instrument puternic în dezvoltarea de automatizări AI și chatboturi.

Integrarea Stable Diffusion în chatboturi permite generarea de conținut vizual ca răspuns la întrebările utilizatorilor. De exemplu, într-un scenariu de suport clienți, un chatbot ar putea oferi ghiduri vizuale sau ilustrații generate pe loc pentru a asista utilizatorii.

Prompturile text sunt convertite în embedding-uri folosind encoderul text CLIP. Aceste embedding-uri sunt esențiale pentru condiționarea procesului de generare a imaginii, asigurând că rezultatul reflectă descrierea utilizatorului.

Procesul invers de difuzie presupune rafinarea iterativă a reprezentării latente prin eliminarea zgomotului prezis. La fiecare pas, modelul ia în considerare embedding-urile text și starea curentă a vectorului latent pentru a prezice corect componenta de zgomot.

Capacitatea modelului de a gestiona imagini zgomotoase provine din antrenamente pe seturi mari de date, unde învață să distingă și să denoizeze eficient. Acest antrenament îi permite să genereze imagini clare chiar și pornind de la zgomot aleator.

Lucrul în spațiul latent aduce eficiență computațională. Deoarece spațiul latent are mai puține dimensiuni decât cel al pixelilor, operațiunile sunt mai puțin consumatoare de resurse. Această eficiență permite generarea de imagini de înaltă rezoluție fără cerințe computaționale excesive.

Artiștii și designerii pot folosi Stable Diffusion pentru a prototipa rapid vizualuri pe baza unor descrieri conceptuale, sprijinind procesul creativ și reducând timpul de la idee la vizualizare.

Echipele de marketing pot genera imagini personalizate pentru campanii, social media și reclame fără a fi nevoie de resurse extinse de design grafic.

Dezvoltatorii de jocuri pot crea asset-uri, medii și concept art oferind prompturi descriptive, simplificând procesul de creare a resurselor vizuale.

Retailerii pot genera imagini ale produselor în diverse contexte sau configurații, îmbunătățind vizualizarea produselor și experiența clienților.

Educatorii și creatorii de conținut pot produce ilustrații și diagrame pentru a explica concepte complexe, făcând materialele educaționale mai atractive.

Cercetătorii în inteligență artificială și viziune computerizată pot folosi Stable Diffusion pentru a explora și mai mult capacitățile modelelor de difuzie și ale spațiilor latente.

Pentru a folosi eficient Stable Diffusion, trebuie avute în vedere anumite aspecte tehnice.

Pentru a începe să folosești Stable Diffusion, urmează acești pași:

Pentru dezvoltatorii care construiesc sisteme de automatizare AI și chatboturi, Stable Diffusion poate fi integrat pentru a crește funcționalitatea.

Când folosești Stable Diffusion, este important să ai în vedere implicațiile etice.

Stable Diffusion este un subiect important în domeniul modelelor generative, în special pentru augmentarea datelor și sinteza de imagini. Studii recente au explorat diferite aspecte ale difuziei stabile, evidențiind aplicațiile și eficiența acesteia.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments de Fuxi Wen (2013):

Prezintă un algoritm diffusion least mean p-power (LMP) conceput pentru estimarea distribuită în medii caracterizate de zgomot alpha-stabil. Studiul compară metoda diffusion LMP cu algoritmul diffusion least mean squares (LMS) și demonstrează performanțe îmbunătățite în condiții de zgomot alpha-stabil. Această cercetare este esențială pentru dezvoltarea unor tehnici robuste de estimare în medii zgomotoase. Citește mai mult

Stable Diffusion for Data Augmentation in COCO and Weed Datasets de Boyang Deng (2024):

Investighează utilizarea modelelor de difuzie stabilă pentru generarea de imagini sintetice de înaltă rezoluție, cu scopul de a îmbunătăți seturi de date mici. Folosind tehnici precum traducerea imagine-la-imagine, Dreambooth și ControlNet, cercetarea evaluează eficiența difuziei stabile în sarcini de clasificare și detecție. Concluziile sugerează aplicații promițătoare ale difuziei stabile în diverse domenii. Citește mai mult

Diffusion and Relaxation Controlled by Tempered α-stable Processes de Aleksander Stanislavsky, Karina Weron și Aleksander Weron (2011):

Derivează proprietăți ale difuziei anomale și relaxării neexponențiale folosind procese α-stabile temperate. Abordează problema momentelor infinite asociată timpului operațional aleator α-stabil și oferă un model ce include subdifuzia ca un caz special. Citește mai mult

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion de Andreas Stöckl (2022):

Evaluează imagini sintetice generate de modelul Stable Diffusion folosind taxonomia Wordnet. Analizează capacitatea modelului de a produce imagini corecte pentru diverse concepte, ilustrând diferențe de acuratețe a reprezentării. Aceste evaluări sunt vitale pentru înțelegerea rolului difuziei stabile în augmentarea datelor. Citește mai mult

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion de Sanchayan Vivekananthan (2024):

Explorează trei cadre generative: VAE, GAN și modelele Stable Diffusion. Cercetarea evidențiază punctele tari și limitările fiecărui model, menționând că, deși VAE-urile și GAN-urile au avantajele lor, difuzia stabilă excelează în anumite sarcini de sinteză. Citește mai mult

Să vedem cum poate fi implementat un model Stable Diffusion în Python folosind librăria Hugging Face Diffusers.

Instalează librăriile necesare:

pip install torch transformers diffusers accelerate

pip install xformers # Opțional

Librăria Diffusers oferă o modalitate convenabilă de a încărca modele pre-antrenate:

from diffusers import StableDiffusionPipeline

import torch

# Încarcă modelul Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Mută modelul pe GPU pentru inferență mai rapidă

Pentru a genera imagini, oferă pur și simplu un prompt text:

prompt = "Un peisaj liniștit cu munți și un lac, fotorealist, rezoluție 8K"

image = pipe(prompt).images[0]

# Salvează sau afișează imaginea

image.save("generated_image.png")

model_id.torch.float16 reduce consumul de memorie.Poți personaliza diverși parametri:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Numărul de pași de denoising

guidance

Stable Diffusion este un model AI avansat conceput pentru generarea de imagini fotorealiste de înaltă calitate pornind de la indicații textuale. Folosește difuzia latentă și învățarea profundă pentru a transforma descrierile textuale în imagini.

Stable Diffusion funcționează prin convertirea indicațiilor text în embedding-uri de imagine folosind un encoder text CLIP, apoi denoizează iterativ o reprezentare latentă ghidată de prompt, rezultând o imagine coerentă.

Stable Diffusion este folosit pentru generarea de conținut creativ, materiale de marketing, creare de asset-uri pentru jocuri, vizualizarea produselor în e-commerce, ilustrații educaționale și chatbot-uri alimentate de AI.

Da, Stable Diffusion suportă traducerea imagine-la-imagine și inpainting, permițând utilizatorilor să modifice imagini existente sau să completeze părți lipsă pe baza indicațiilor textuale.

Se recomandă un computer cu GPU modern pentru generarea eficientă a imaginilor cu Stable Diffusion. Modelul necesită și Python, precum și librării ca PyTorch și Diffusers.

Da, Stable Diffusion este lansat sub o licență open-source permisivă, încurajând contribuțiile comunității, personalizarea și accesibilitatea largă.

Dezlantui-ți creativitatea cu Stable Diffusion și vezi cum AI-ul îți poate transforma ideile în imagini uimitoare.

Generează imagini de înaltă calitate din prompturi text cu componenta Generator de imagini Stability AI. Alimentat de modelele Stable Diffusion, acest instrumen...

Modelul Flux AI de la Black Forest Labs este un sistem avansat de generare text-în-imagine care transformă instrucțiuni în limbaj natural în imagini extrem de d...

Explorați recenzia noastră detaliată a modelului Stability AI SD3 Large. Analizați punctele forte, slăbiciunile și rezultatele creative pe o varietate de solici...