Claude Opus

Află mai multe despre modelul Opus al Claude de la Anthropic. Descoperă punctele sale forte și slăbiciunile, precum și cum se compară cu celelalte modele.

OpenAI Whisper este un sistem ASR open-source care convertește precis vorbirea în text în 99 de limbi, suportând transcriere, traducere și identificare a limbii pentru automatizare AI robustă.

OpenAI Whisper poate fi considerat atât un model, cât și un sistem, în funcție de context.

Funcția principală a lui Whisper este să transcrie vorbirea în text. Excelează în:

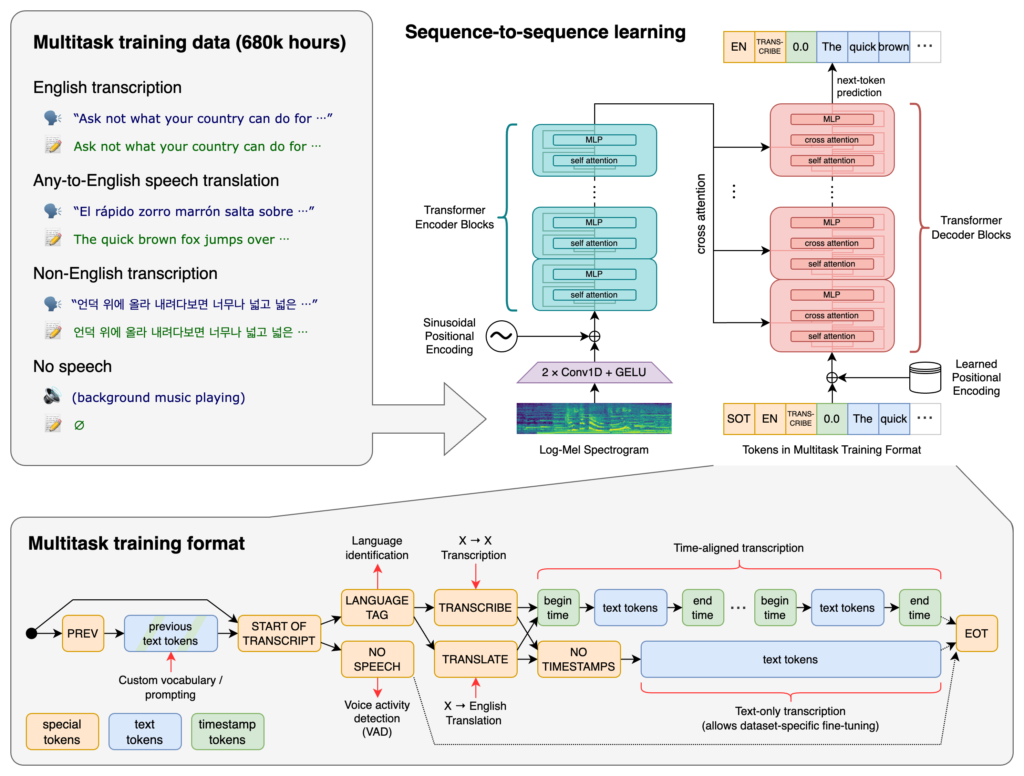

La baza lui Whisper se află arhitectura Transformer, în special un model encoder-decoder. Transformer-ele sunt rețele neuronale care excelează în procesarea datelor secvențiale și înțelegerea contextului pe secvențe lungi. Introduse în lucrarea „Attention is All You Need” în 2017, Transformer-ele au devenit fundamentale în multe sarcini NLP.

Procesul Whisper implică:

Whisper a fost antrenat pe un set masiv de 680.000 de ore de date supervizate colectate de pe web. Acesta include:

Cu acoperire pentru 99 de limbi, Whisper se remarcă prin capacitatea de a gestiona intrări lingvistice diverse. Această capacitate multilingvă îl face potrivit pentru aplicații și servicii globale ce vizează public internațional.

Antrenat pe date supervizate extinse, Whisper obține rate mari de acuratețe la transcriere. Robustețea sa la accente, dialecte și zgomote de fundal variate îl face de încredere în scenarii reale.

Dincolo de transcriere, Whisper poate realiza:

Lansat ca software open-source, Whisper permite dezvoltatorilor să:

Prin integrarea Whisper în chatboți și asistenți AI, dezvoltatorii pot activa:

Whisper este implementat ca o bibliotecă Python, permițând integrarea facilă în proiecte dezvoltate cu Python. Utilizarea Whisper în Python implică pregătirea mediului potrivit, instalarea dependențelor necesare și folosirea funcțiilor bibliotecii pentru a transcrie sau traduce fișiere audio.

Înainte de a folosi Whisper, trebuie să pregătești mediul de dezvoltare instalând Python, PyTorch, FFmpeg și biblioteca Whisper.

Dacă nu ai deja Python instalat, descarcă-l de pe site-ul oficial. Pentru a instala PyTorch, folosește pip:

pip install torch

Alternativ, vizitează site-ul PyTorch pentru instrucțiuni specifice în funcție de sistemul de operare și versiunea de Python.

Whisper necesită FFmpeg pentru procesarea fișierelor audio. Instalează FFmpeg cu managerul de pachete potrivit pentru sistemul tău de operare.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (cu Homebrew):

brew install ffmpeg

Windows (cu Chocolatey):

choco install ffmpeg

Instalează pachetul Python Whisper folosind pip:

pip install -U openai-whisper

Pentru a instala cea mai recentă versiune direct de pe repository-ul GitHub:

pip install git+https://github.com/openai/whisper.git

Asigură-te că este activat Developer Mode:

Whisper oferă mai multe modele ce variază ca dimensiune și capabilități. Modelele variază de la tiny la large, fiecare echilibrând diferit viteza și acuratețea.

| Dimensiune | Parametri | Model doar pentru engleză | Model multilingv | VRAM necesar | Viteză relativă |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Optimizate pentru transcriere în engleză, oferind performanță îmbunătățită pentru audio în engleză.După ce ai configurat mediul și ai instalat componentele necesare, poți începe să folosești Whisper în proiectele tale Python.

Începe prin a importa biblioteca Whisper și a încărca un model:

import whisper

# Încarcă modelul dorit

model = whisper.load_model("base")

Înlocuiește "base" cu numele modelului potrivit aplicației tale.

Whisper oferă o funcție simplă transcribe pentru a converti fișiere audio în text.

Exemplu: Transcrierea unui fișier audio în engleză

# Transcrie fișierul audio

result = model.transcribe("cale/catre/audio_engleza.mp3")

# Afișează transcrierea

print(result["text"])

model.transcribe(): Procesează fișierul audio și returnează un dicționar cu transcrierea și alte meta-date.result["text"]: Accesează textul transcris din rezultat.Whisper poate traduce audio din diferite limbi în engleză.

Exemplu: Traducerea audio spaniol în engleză

# Transcrie și traduce audio spaniol în engleză

result = model.transcribe("cale/catre/audio_spaniola.mp3", task="translate")

# Afișează textul tradus

print(result["text"])

task="translate": Indică modelului să traducă audio în engleză, nu doar să îl transcrie literal.Deși Whisper poate detecta automat limba, specificarea acesteia poate îmbunătăți acuratețea și viteza.

Exemplu: Transcrierea unui audio în franceză

# Transcrie audio francez specificând limba

result = model.transcribe("cale/catre/audio_franceza.wav", language="fr")

# Afișează transcrierea

print(result["text"])

Whisper poate identifica limba vorbită într-un fișier audio folosind metoda detect_language.

Exemplu: Detectarea limbii

# Încarcă și preprocesează audio-ul

audio = whisper.load_audio("cale/catre/audio_limba_necunoscută.mp3")

audio = whisper.pad_or_trim(audio)

# Convertește în spectrogramă log-Mel

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Detectează limba

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Limba detectată: {language}")

whisper.load_audio(): Încarcă fișierul audio.whisper.pad_or_trim(): Ajustează lungimea audio-ului pentru a se potrivi cerințelor modelului.whisper.log_mel_spectrogram(): Convertește audio-ul în formatul așteptat de model.model.detect_language(): Returnează probabilități pentru fiecare limbă, identificând cea mai probabilă limbă vorbită.Pentru un control mai mare asupra procesului de transcriere, poți folosi funcții la nivel inferior și poți personaliza opțiunile de decodare.

decodeFuncția decode permite specificarea unor opțiuni precum limba, sarcina și dacă să fie incluse marcaje de timp.

Exemplu: Opțiuni de decodare personalizate

# Setează opțiunile de decodare

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Decodează audio-ul

result = whisper.decode(model, mel, options)

# Afișează textul recunoscut

print(result.text)

Poți integra Whisper pentru a transcrie input audio live de la microfon.

Exemplu: Transcrierea input-ului live de la microfon

import whisper

import sounddevice as sd

# Încarcă modelul

model = whisper.load_model("base")

# Înregistrează audio de la microfon

duration = 5 # secunde

fs = 16000 # Rată de eșantionare

print("Înregistrare...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper este un sistem avansat de recunoaștere automată a vorbirii (ASR) dezvoltat de OpenAI, conceput pentru a transcrie limbajul vorbit în text scris folosind deep learning. Suportă 99 de limbi și excelează în transcriere, traducere și identificare a limbii.

Whisper folosește o arhitectură encoder-decoder bazată pe transformer, procesează audio în spectrograme log-Mel și generează text printr-un model lingvistic. A fost antrenat pe 680.000 de ore de date multilingve și multitask pentru acuratețe și robustețe ridicate.

Whisper suportă recunoaștere vocală multilingvă, traducere vocală, identificare automată a limbii, robustețe la accente și zgomot și oferă acces open-source pentru personalizare și integrare.

Cerințele hardware depind de dimensiunea modelului: modelele mai mici precum 'tiny' necesită ~1GB VRAM, iar cel mai mare necesită ~10GB. Whisper rulează mai rapid pe GPU-uri, dar poate funcționa și pe CPU-uri cu timpi de procesare mai mari.

Da, Whisper este implementat ca o bibliotecă Python și poate fi instalat prin pip. Permite integrarea ușoară în proiecte Python pentru transcriere vocală, traducere și aplicații de voce în timp real.

Utilizări comune includ transcriere automată de întâlniri, chatboți cu voce, traducere în timp real, instrumente de accesibilitate (subtitrări și tehnologii asistive), automatizare call center și sisteme de automatizare controlate vocal.

Da, alternativele includ motoare open-source precum Mozilla DeepSpeech, Kaldi, Wav2vec, și API-uri comerciale precum Google Cloud Speech-to-Text, Microsoft Azure AI Speech și AWS Transcribe.

Da, OpenAI Whisper este open-source, permițând dezvoltatorilor să îl personalizeze, ajusteze și integreze în propriile produse și servicii fără constrângeri de licențiere.

Integrează capabilități avansate speech-to-text în aplicațiile tale, automatizează fluxuri de lucru și îmbunătățește experiența utilizatorului cu OpenAI Whisper și FlowHunt.

Află mai multe despre modelul Opus al Claude de la Anthropic. Descoperă punctele sale forte și slăbiciunile, precum și cum se compară cu celelalte modele.

Explorează cum capacitățile avansate de raționament și învățarea prin întărire ale OpenAI O1 depășesc GPT4o în acuratețea RAG, cu benchmark-uri și analiză de co...

Explorează capabilitățile avansate ale Llama 3.3 70B Versatile 128k ca Agent AI. Această recenzie detaliată examinează abilitățile sale de raționament, rezolvar...