FlowHunt 2.4.1 introducerar Claude, Grok, Llama och mer

FlowHunt 2.4.1 introducerar stora nya AI-modeller inklusive Claude, Grok, Llama, Mistral, DALL-E 3 och Stable Diffusion, vilket utökar dina alternativ för exper...

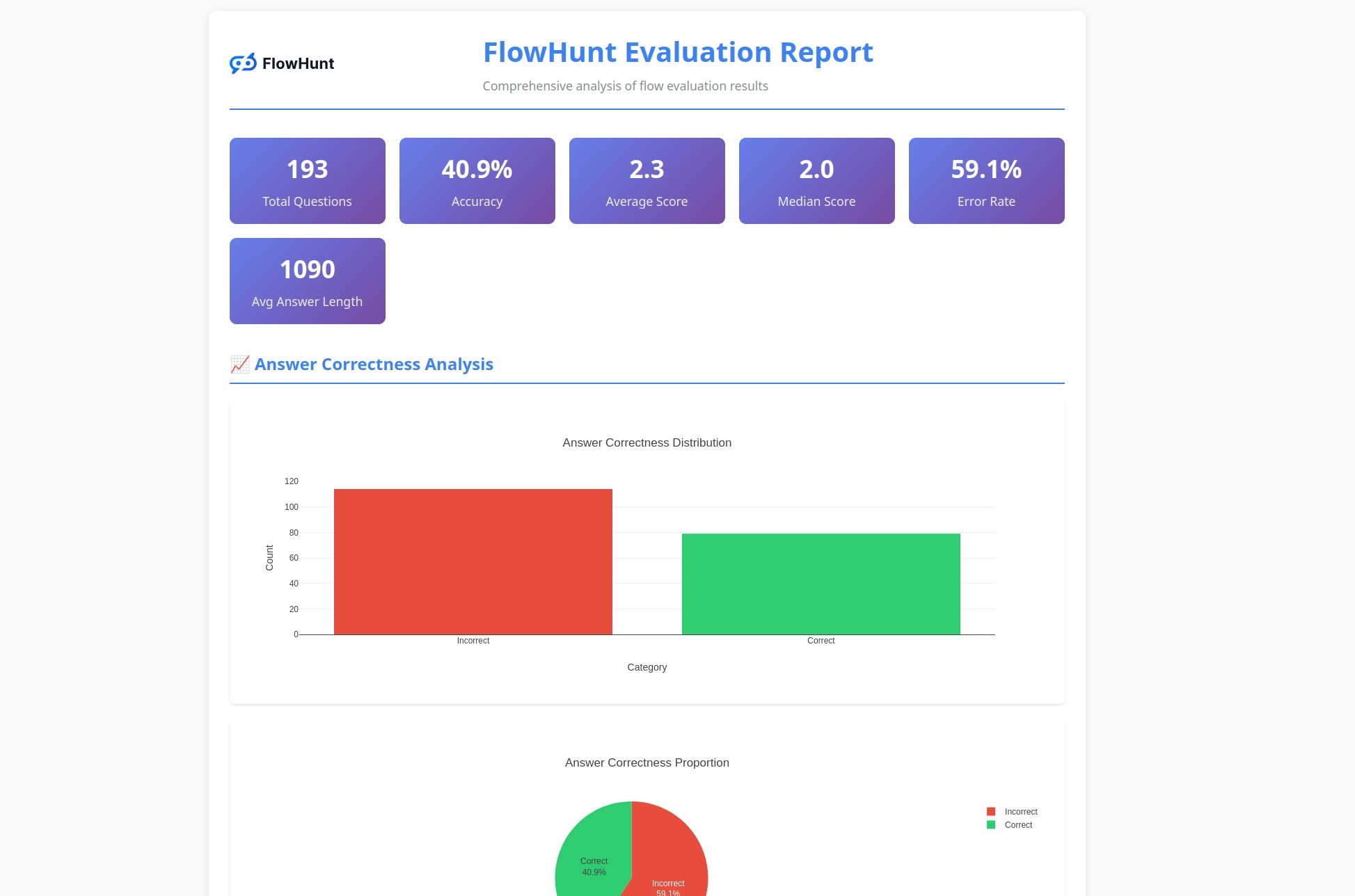

FlowHunts nya open source CLI-verktyg möjliggör omfattande flödesutvärdering med LLM som Domare och erbjuder detaljerad rapportering samt automatiserad kvalitetsbedömning för AI-arbetsflöden.

Vi är glada att kunna presentera FlowHunt CLI Toolkit – vårt nya open source-kommandoradsverktyg designat för att revolutionera hur utvecklare utvärderar och testar AI-flöden. Detta kraftfulla verktyg ger företagsklassad flödesutvärdering till open source-communityn, komplett med avancerad rapportering och vår innovativa implementation av “LLM som Domare”.

FlowHunt CLI Toolkit representerar ett betydande steg framåt inom testning och utvärdering av AI-arbetsflöden. Nu tillgängligt på GitHub, ger detta open source-verktyg utvecklare omfattande verktyg för:

Verktyget förkroppsligar vårt engagemang för transparens och community-drivet utvecklingsarbete, vilket gör avancerade AI-utvärderingstekniker tillgängliga för utvecklare världen över.

En av de mest innovativa funktionerna i vårt CLI-verktyg är implementationen av “LLM som Domare”. Denna metod använder artificiell intelligens för att utvärdera kvaliteten och korrektheten i AI-genererade svar – i praktiken låter vi AI bedöma AI:s prestation med sofistikerad resonemangsförmåga.

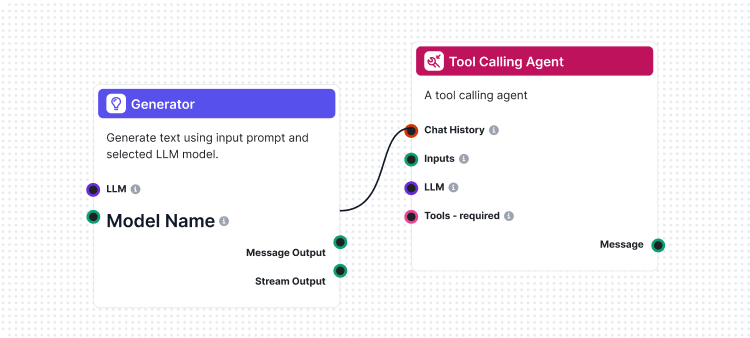

Det som gör vår implementation unik är att vi använde FlowHunt själv för att skapa utvärderingsflödet. Denna meta-approach demonstrerar kraften och flexibiliteten i vår plattform samtidigt som den tillhandahåller ett robust utvärderingssystem. LLM som Domare-flödet består av flera sammankopplade komponenter:

1. Promptmall: Skapar utvärderings-prompten med specifika kriterier

2. Strukturerad utgångsgenerator: Bearbetar utvärderingen med ett LLM

3. Dataparser: Formaterar den strukturerade utgången för rapportering

4. Chattutgång: Presenterar de slutliga utvärderingsresultaten

Kärnan i vårt LLM som Domare-system är en noggrant utformad prompt som säkerställer konsekventa och tillförlitliga utvärderingar. Här är den centrala promptmallen vi använder:

You will be given an ANSWER and REFERENCE couple.

Your task is to provide the following:

1. a 'total_rating' scoring: how close is the ANSWER to the REFERENCE

2. a binary label 'correctness' which can be either 'correct' or 'incorrect', which defines if the ANSWER is correct or not

3. and 'reasoning', which describes the reason behind your choice of scoring and correctness/incorrectness of ANSWER

An ANSWER is correct when it is the same as the REFERENCE in all facts and details, even if worded differently. the ANSWER is incorrect if it contradicts the REFERENCE, changes or omits details. its ok if the ANSWER has more details comparing to REFERENCE.

'total rating' is a scale of 1 to 4, where 1 means that the ANSWER is not the same as REFERENCE at all, and 4 means that the ANSWER is the same as the REFERENCE in all facts and details even if worded differently.

Here is the scale you should use to build your answer:

1: The ANSWER is contradicts the REFERENCE completely, adds additional claims, changes or omits details

2: The ANSWER points to the same topic but the details are omitted or changed completely comparing to REFERENCE

3: The ANSWER's references are not completely correct, but the details are somewhat close to the details mentioned in the REFERENCE. its ok, if there are added details in ANSWER comparing to REFERENCES.

4: The ANSWER is the same as the REFERENCE in all facts and details, even if worded differently. its ok, if there are added details in ANSWER comparing to REFERENCES. if there are sources available in REFERENCE, its exactly the same as ANSWER and is for sure mentioned in ANSWER

REFERENCE

===

{target_response}

===

ANSWER

===

{actual_response}

===

Denna prompt säkerställer att vår LLM-domare ger:

Vårt LLM som Domare-flöde demonstrerar sofistikerad AI-arbetsflödesdesign med FlowHunts visuella flödesbyggare. Så här samverkar komponenterna:

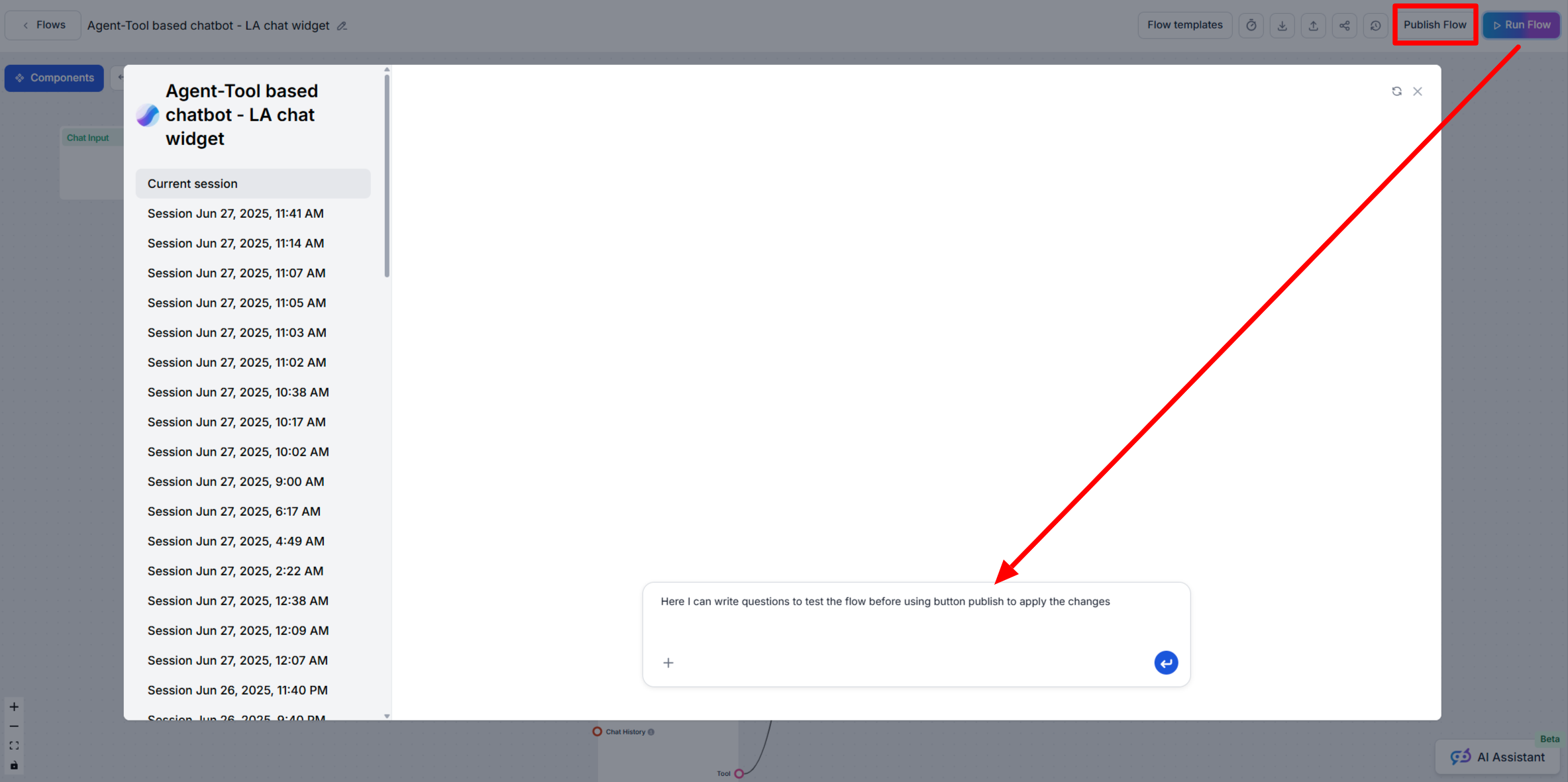

Flödet börjar med en Chat Input-komponent som tar emot utvärderingsförfrågan med både det faktiska svaret och referenssvaret.

Promptmall-komponenten konstruerar dynamiskt utvärderingsprompten genom att:

{target_response}-platsen{actual_response}-platsenStrukturerad utgångsgenerator behandlar prompten med ett valt LLM och genererar strukturerad utgång som innehåller:

total_rating: numerisk poäng från 1–4correctness: binär korrekt/inkorrekt-klassificeringreasoning: detaljerad förklaring till utvärderingenParse Data-komponenten formaterar den strukturerade utgången till läsbart format och Chattutgång-komponenten presenterar de slutliga utvärderingsresultaten.

LLM som Domare-systemet erbjuder flera avancerade funktioner som gör det särskilt effektivt för AI-flödesutvärdering:

Till skillnad från enkel strängmatchning förstår vår LLM-domare:

Den fyrgradiga betygsskalan möjliggör detaljerad utvärdering:

Varje utvärdering innehåller detaljerad motivering, vilket möjliggör att:

CLI-verktyget genererar detaljerade rapporter som ger handlingsbara insikter om flödets prestation:

Redo att börja utvärdera dina AI-flöden med professionella verktyg? Så här kommer du igång:

Enradig installation (rekommenderas) för macOS och Linux:

curl -sSL https://raw.githubusercontent.com/yasha-dev1/flowhunt-toolkit/main/install.sh | bash

Detta kommer automatiskt att:

flowhunt i din PATHManuell installation:

# Klona repot

git clone https://github.com/yasha-dev1/flowhunt-toolkit.git

cd flowhunt-toolkit

# Installera med pip

pip install -e .

Verifiera installationen:

flowhunt --help

flowhunt --version

1. Autentisering

Autentisera dig först mot FlowHunt API:

flowhunt auth

2. Lista dina flöden

flowhunt flows list

3. Utvärdera ett flöde Skapa en CSV-fil med din testdata:

flow_input,expected_output

"What is 2+2?","4"

"What is the capital of France?","Paris"

Kör utvärdering med LLM som Domare:

flowhunt evaluate your-flow-id path/to/test-data.csv --judge-flow-id your-judge-flow-id

4. Batchköra flöden

flowhunt batch-run your-flow-id input.csv --output-dir results/

Utvärderingssystemet tillhandahåller omfattande analys:

flowhunt evaluate FLOW_ID TEST_DATA.csv \

--judge-flow-id JUDGE_FLOW_ID \

--output-dir eval_results/ \

--batch-size 10 \

--verbose

Funktioner inkluderar:

CLI-verktyget integreras sömlöst med FlowHunt-plattformen och gör det möjligt att:

Lanseringen av vårt CLI-verktyg är mer än bara ett nytt verktyg – det är en vision för framtiden där:

Kvalitet är mätbar: Avancerade utvärderingstekniker gör AI-prestationer kvantifierbara och jämförbara.

Testning är automatiserad: Omfattande testningsramverk minskar manuellt arbete och ökar tillförlitligheten.

Transparens är standard: Detaljerad motivering och rapportering gör AI:s beteende förståeligt och felsökningsbart.

Communityn driver innovation: Open source-verktyg möjliggör gemensam förbättring och kunskapsdelning.

Genom att göra FlowHunt CLI Toolkit open source visar vi vårt engagemang för:

FlowHunt CLI Toolkit med LLM som Domare representerar ett stort framsteg inom AI-flödesutvärdering. Genom att kombinera sofistikerad utvärderingslogik med omfattande rapportering och open source-tillgänglighet ger vi utvecklare verktygen att bygga bättre och mer tillförlitliga AI-system.

Meta-approachen att använda FlowHunt för att utvärdera FlowHunt-flöden demonstrerar plattformens mognad och flexibilitet, samtidigt som den tillhandahåller ett kraftfullt verktyg för hela AI-utvecklingscommunityn.

Oavsett om du bygger enkla chattbottar eller komplexa multiagentssystem ger FlowHunt CLI Toolkit dig den utvärderingsinfrastruktur du behöver för att säkerställa kvalitet, tillförlitlighet och kontinuerlig förbättring.

Redo att ta din AI-flödesutvärdering till nästa nivå? Besök vårt GitHub-repository för att komma igång med FlowHunt CLI Toolkit redan idag och upplev kraften med LLM som Domare själv.

Framtiden för AI-utveckling är här – och den är open source.

FlowHunt CLI Toolkit är ett open source-kommandoradsverktyg för utvärdering av AI-flöden med omfattande rapporteringsfunktioner. Det innehåller funktioner som LLM som Domare, analys av korrekta/felaktiga resultat och detaljerade prestandamått.

LLM som Domare använder ett sofistikerat AI-flöde byggt i FlowHunt för att utvärdera andra flöden. Det jämför faktiska svar mot referenssvar och ger betyg, korrekthetsbedömningar och detaljerad motivering för varje utvärdering.

FlowHunt CLI Toolkit är open source och finns på GitHub på https://github.com/yasha-dev1/flowhunt-toolkit. Du kan klona, bidra och använda det fritt för dina behov av AI-flödesutvärdering.

Verktyget genererar omfattande rapporter inklusive uppdelning av korrekta/felaktiga resultat, LLM som Domare-utvärderingar med betyg och motiveringar, prestandamått samt detaljerad analys av flödesbeteende över olika testfall.

Ja! LLM som Domare-flödet är byggt med FlowHunts plattform och kan anpassas för olika utvärderingsscenarier. Du kan ändra promptmallen och utvärderingskriterierna för att passa dina specifika behov.

Yasha är en skicklig mjukvaruutvecklare som specialiserar sig på Python, Java och maskininlärning. Yasha skriver tekniska artiklar om AI, prompt engineering och utveckling av chattbotar.

Bygg och utvärdera sofistikerade AI-arbetsflöden med FlowHunts plattform. Börja skapa flöden som kan bedöma andra flöden redan idag.

FlowHunt 2.4.1 introducerar stora nya AI-modeller inklusive Claude, Grok, Llama, Mistral, DALL-E 3 och Stable Diffusion, vilket utökar dina alternativ för exper...

Lär dig när du ska använda funktionerna Kör Flöde och Publicera Flöde i FlowHunt AIStudio för att säkert testa och distribuera dina AI-arbetsflöden.

Flöden är hjärnan bakom allt i FlowHunt. Lär dig bygga dem med en visuell no-code-byggare, från att placera den första komponenten till webbplatsintegration, dr...