Gemini Flash 2.0: AI med hastighet och precision

Gemini Flash 2.0 sätter nya standarder inom AI med förbättrad prestanda, hastighet och multimodala möjligheter. Utforska dess potential i verkliga applikationer...

Utforska hur Google I/O 2025 markerar starten för Gemini-eran med AI-drivna uppdateringar i hela Googles ekosystem, och se hur FlowHunt tar det senaste Gemini 2.5 Flash-modellen till dina AI-projekt.

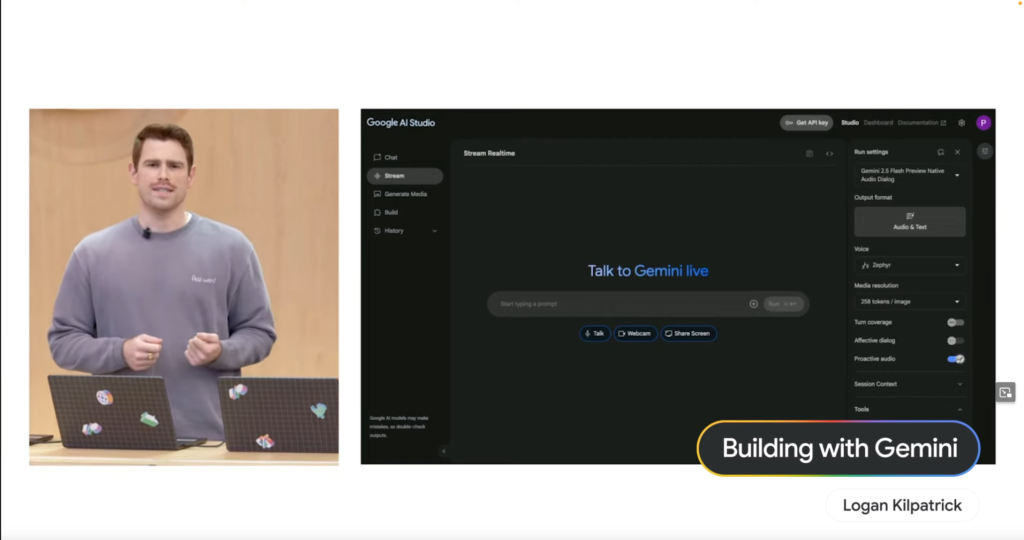

Logan Kilpatrick inledde med att visa hur Project Astra syftar till att göra AI-interaktion helt naturlig. Många av dessa funktioner är nu tillgängliga via Live API, som drivs av den nya Gemini 2.5 Flash inhemska ljudmodellen. Denna modell är skickligare på att ignorera bakgrundsljud och har stöd för 24 språk redan från början, vilket banar väg för mer intuitiva och lyhörda AI-upplevelser.

Paige Bailey demonstrerade styrkan i att bygga med Gemini genom en “Keynote Companion”-demo. Med Google AI Studio visade hon hur AI:n kunde förstå talade kommandon, interagera med live-data (som att visa Shoreline Amphitheatre på en karta) och till och med genomföra komplexa sökningar som att hitta närliggande caféer med Wi-Fi, allt i ett konversationellt flöde. Detta visar på Geminis imponerande multimodala förmågor.

Adaptiv design: Compose och Android XR

Diana Wong betonade Googles satsning på att göra adaptiva gränssnitt enklare att bygga. Nya funktioner i Compose Adaptive Layouts-biblioteket, som Pane Expansion, är utformade för att hjälpa utvecklare skapa appar som sömlöst anpassar sig till olika skärmstorlekar och formfaktorer. Denna adaptiva filosofi gäller även för Android XR, plattformen för utökad verklighet som byggs i samarbete med Samsung. Utvecklare kan redan nu börja bygga för kommande headset som Project Moohan, med vetskap om att deras adaptivt designade appar är redo för denna nya immersiva framtid.

Smartare kodning: AI-agenter i Android Studio

Florina Muntenescu presenterade en verklig gamechanger för Android-utvecklare: en ny AI-agent som snart kommer till Android Studio. Denna agent är utformad för att hjälpa till med tidskrävande uppgifter som versionsuppdateringar. I en övertygande demo analyserade AI-agenten ett gammalt projekt, identifierade byggfel och använde sedan Gemini för att ta reda på hur problemen skulle åtgärdas, och itererade tills bygget lyckades. Detta lovar att effektivisera utvecklingsprocessen avsevärt.

Förenklade webbgränssnitt: Nya möjligheter för komplexa element

Una Kravets lyfte fram nya webbfunktioner som förenklar skapandet av vanliga men förvånansvärt komplexa UI-element. Utvecklare kommer att ha lättare att bygga robusta och tillgängliga komponenter som karuseller och hover-kort, vilket förbättrar användarupplevelser på webben.

Gemini Nano på webben: Multimodala AI-API:er släpps fria

Addy Osmani meddelade att Gemini Nano låser upp nya multimodala möjligheter direkt på webben. Nya inbyggda multimodala AI-API:er gör det möjligt att interagera med Gemini via både ljud- och bildinmatning. En “Cinemal”-demo visade detta genom att låta en användare ta ett foto av en biljett med webbkameran, och AI:n på enheten lokaliserade omedelbart deras sittsektion på en teaterkarta – ett kraftfullt exempel på bearbetning direkt på enheten.

David East visade hur Firebase integrerar AI för att snabba på apputveckling. Utvecklare kan nu förverkliga sina Figma-designer i Firebase Studio med hjälp av Builder.io. Det imponerande? Det handlar inte bara om en monolitisk kodexport; Figma-exporten genererar välisolerade, individuella React-komponenter. Med Gemini i Firebase Studio visade David hur han sedan enkelt kunde be AI:n lägga till funktioner som en “Lägg till i kundvagn”-knapp på en produktsida, vilket AI:n snabbt implementerade och uppdaterade koden och liveförhandsgranskningen.

Gemma 3n: Kraftfull AI på bara 2GB RAM

Gus Martins kom med spännande nyheter för öppen källkod-gemenskapen med lanseringen av Gemma 3n. Denna otroligt effektiva modell kan köras på så lite som 2GB RAM, vilket gör den avsevärt snabbare och lättare för mobil hårdvara jämfört med Gemma 3. Viktigt är också att Gemma 3n nu har stöd för ljudförståelse, vilket gör den verkligt multimodal.

SignGemma: Bryter kommunikationsbarriärer

Google utmanar också tillgängligheten med SignGemma. Denna nya modellfamilj är tränad för att översätta teckenspråk (med nuvarande fokus på amerikanskt teckenspråk – ASL) till talad språktext, vilket öppnar nya möjligheter för kommunikation och inkludering.

Inspirerad av de otroliga AI-framstegen från Google I/O? Vill du börja skapa sofistikerade AI-agenter som kan förstå, resonera och agera?

FlowHunt är plattformen som hjälper dig att skapa kraftfulla AI-agenter sömlöst, utan att du behöver vara expert på maskininlärning. Designa komplexa arbetsflöden, integrera olika verktyg och distribuera intelligenta agenter med enkelhet.

Och det bästa? Som visades i keynoten stöder FlowHunt nu den banbrytande Gemini 2.5 Flash! Det betyder att du omedelbart kan dra nytta av dess hastighet, effektivitet och förbättrade ljudfunktioner för att bygga ännu kraftfullare och mer responsiva AI-agenter.

Prova de nya modellerna som implementerats på mindre än 24 timmar i FlowHunt direkt!

Google I/O 2025 belyser företagets övergång till en AI-inhemsk framtid, med Gemini-modeller i centrum för nya produkter och funktioner i Android, webben och utvecklarverktyg.

Gemini 2.5 Flash är Googles senaste inhemska ljud-AI-modell, som erbjuder snabb, effektiv och flerspråkig ljudbearbetning, nu tillgänglig för utvecklare och integrerad i plattformar som FlowHunt.

Gemma 3n är en effektiv AI-modell som körs på så lite som 2GB RAM med multimodala (ljud) möjligheter. SignGemma är en modellfamilj som översätter teckenspråk, med fokus på ASL, till talad språktext.

FlowHunt stöder nu Gemini 2.5 Flash, vilket gör det möjligt för användare att skapa avancerade AI-agenter med förbättrade ljud- och multimodala funktioner utan krav på maskininlärningsexpertis.

Android introducerade adaptiva gränssnitt, XR-stöd och AI-agenter i Android Studio för smartare kodning. På webben möjliggör Gemini Nano multimodala AI-API:er för ljud- och bildinmatning direkt i webbläsare.

Yasha är en skicklig mjukvaruutvecklare som specialiserar sig på Python, Java och maskininlärning. Yasha skriver tekniska artiklar om AI, prompt engineering och utveckling av chattbotar.

Upplev kraften i den nya Gemini 2.5 Flash-modellen i FlowHunt och bygg nästa generations AI-agenter med avancerade multimodala funktioner.

Gemini Flash 2.0 sätter nya standarder inom AI med förbättrad prestanda, hastighet och multimodala möjligheter. Utforska dess potential i verkliga applikationer...

Utforska tankeprocessen, arkitekturen och beslutsfattandet hos Gemini 1.5 Pro, en mångsidig AI-agent, genom verkliga uppgifter och djupgående analys av dess res...

Utforska arkitekturen, tankesättet och den verkliga prestandan hos Gemini 1.5 Flash 8B—en avancerad AI-agent som utmärker sig inom informationsbearbetning, reso...