OpenAI O3 Mini vs DeepSeek för agentbaserad användning

Jämför OpenAI O3 Mini och DeepSeek på resonemangsuppgifter, schackstrategi och agentbaserat verktygsanvändande. Se vilken AI som utmärker sig i noggrannhet, pri...

OpenAI O1 utnyttjar förstärkningsinlärning och inbyggt kedjeresonerande tänkande för att överträffa GPT4o i komplexa RAG-uppgifter, men till en högre kostnad.

OpenAI har precis släppt en ny modell kallad OpenAI O1 från O1-serien av modeller. Den största arkitektoniska förändringen i dessa modeller är förmågan att tänka innan den svarar på en användares fråga. I den här bloggen går vi på djupet med de viktigaste förändringarna i OpenAI O1, de nya paradigm som dessa modeller använder samt hur denna modell avsevärt kan öka RAG-noggrannheten. Vi kommer att jämföra ett enkelt RAG-flöde med OpenAI GPT4o och OpenAI O1-modellen.

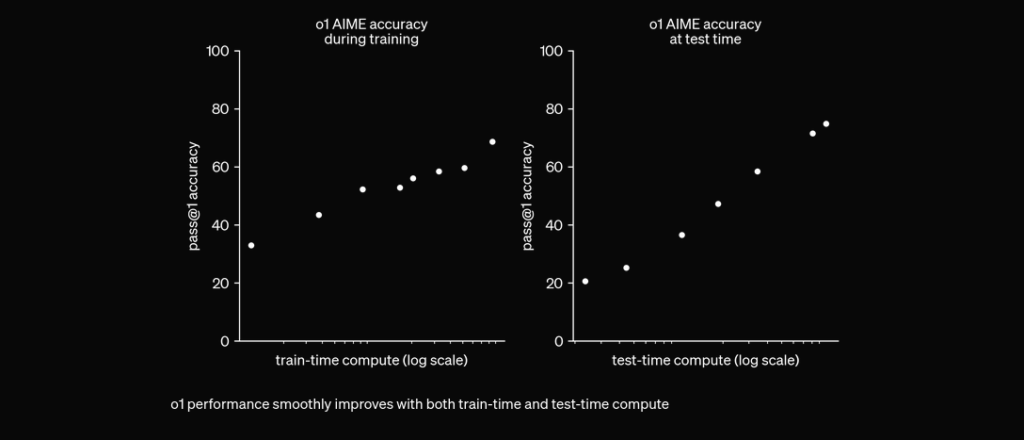

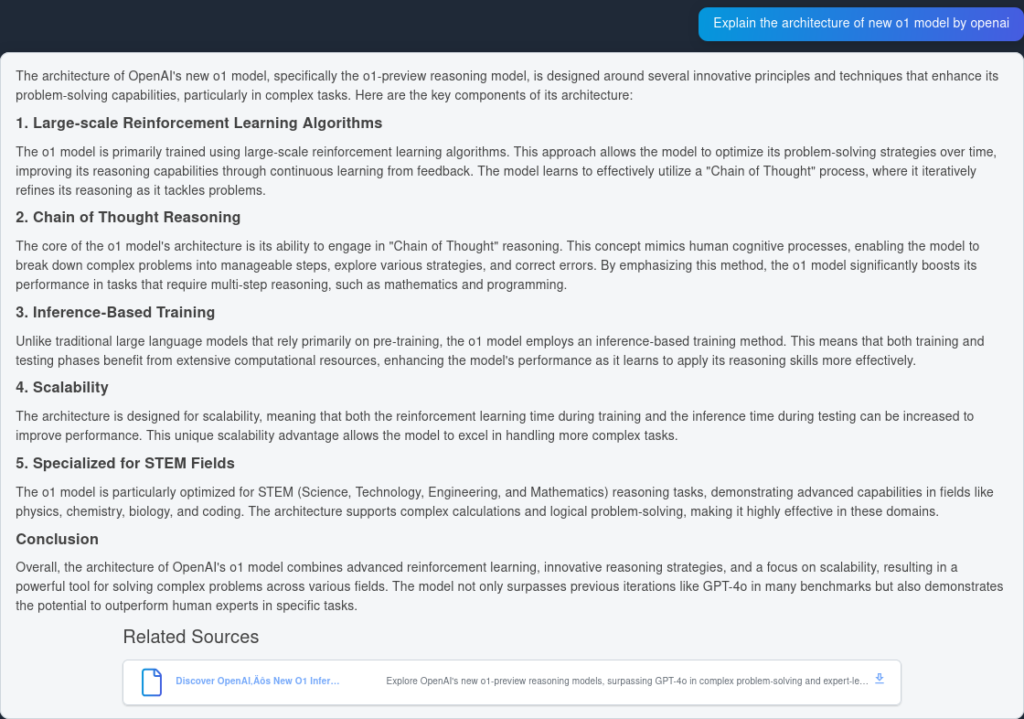

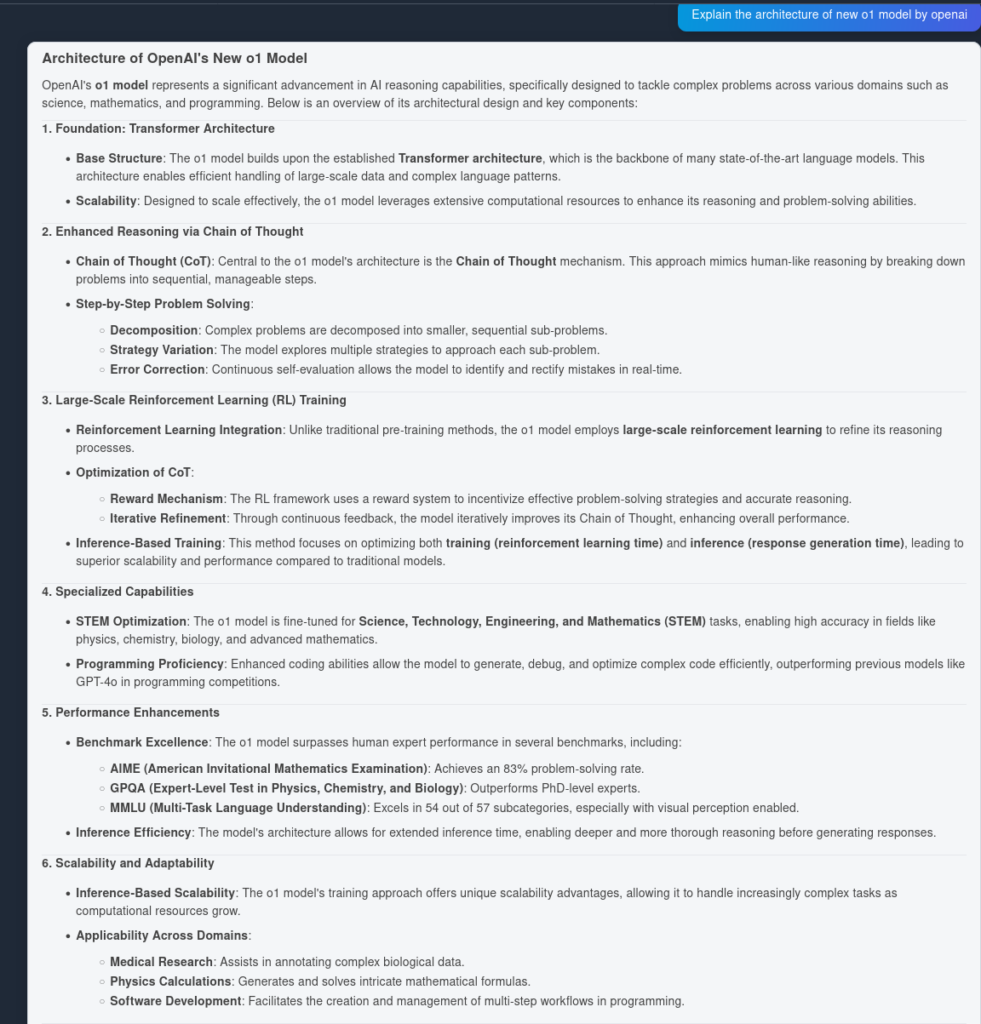

O1-modellen utnyttjar förstärkningsinlärningsalgoritmer i stor skala under sin träningsprocess. Detta gör det möjligt för modellen att utveckla en robust “kedja av tankar” och därmed tänka djupare och mer strategiskt kring problem. Genom att kontinuerligt optimera sina resonemangsvägar med hjälp av förstärkningsinlärning förbättrar O1-modellen avsevärt sin förmåga att analysera och lösa komplexa uppgifter effektivt.

Tidigare har kedjeresonerande tänkande visat sig vara en användbar prompt engineering-mekanism för att få LLM att “tänka” själv och besvara komplexa frågor steg för steg. Med O1-modeller kommer detta steg inbyggt och är integrerat nativt i modellen vid inferenstid, vilket gör det användbart för matematiska och kodningsrelaterade problemlösningsuppgifter.

O1 tränas med RL för att “tänka” innan den svarar via en privat kedja av tankar. Ju längre den tänker, desto bättre presterar den på resonemangsuppgifter. Detta öppnar en ny dimension för skalning. Vi är inte längre flaskhalsade av förträning. Vi kan nu skala inferensberäkning också. pic.twitter.com/niqRO9hhg1

— Noam Brown (@polynoamial) 12 september 2024

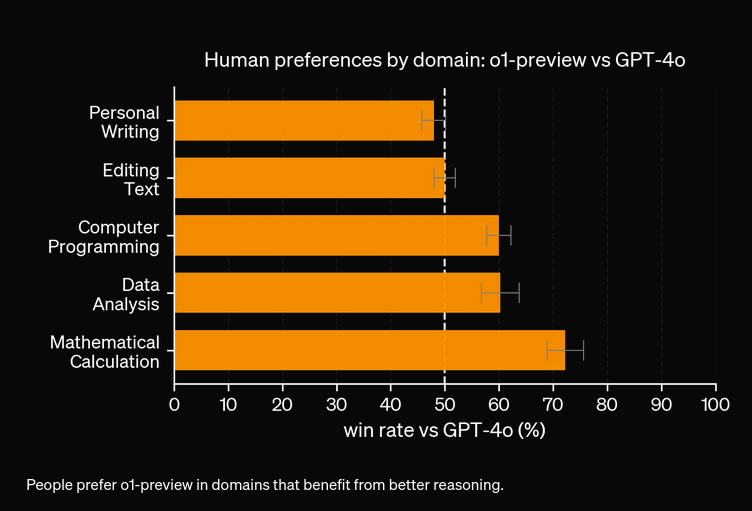

I omfattande utvärderingar har O1-modellen visat anmärkningsvärd prestanda över flera benchmarks:

För att testa prestandanoggrannheten hos OpenAI O1 och GPT4o skapade vi två identiska flöden, men med två olika LLM:er. Vi kommer att jämföra modellerna i deras frågesvarsförmåga på två indexerade källor relaterade till den tekniska rapporten om OpenAI O1.

Först skapar vi ett enkelt RAG-flöde i FlowHunt. Det består av Chat Input, Document Retriever (hämtar relevanta dokument), Prompt, Generator och Chat Output. LLM OpenAI-komponenten läggs till för att specificera modellen (annars används GPT4o som standard).

Här är svaret från GPT4o:

Och här är resultatet från OpenAI O1:

Som du kan se fångade OpenAI O1 fler arkitektoniska fördelar från själva artikeln—6 punkter jämfört med 4. Dessutom drar O1 logiska slutsatser från varje punkt och berikar dokumentet med fler insikter om varför den arkitektoniska förändringen är användbar.

Utifrån våra experiment kostar O1-modellen mer för ökad noggrannhet. Den nya modellen har tre typer av tokens: Prompt Token, Completion Token och Reason Token (en nyligen tillagd typ av token), vilket gör den potentiellt dyrare. I de flesta fall ger OpenAI O1 svar som upplevs mer hjälpsamma om de är förankrade i sanning. Dock finns det tillfällen där GPT4o överträffar OpenAI O1—vissa uppgifter kräver helt enkelt inte resonemang.

OpenAI O1 använder förstärkningsinlärning i stor skala och integrerar kedjeresonerande tänkande vid inferenstid, vilket möjliggör djupare och mer strategisk problemlösning än GPT4o.

Ja, O1 uppnår högre poäng i benchmarks som AIME (83 % vs. GPT4o:s 13 %), GPQA (överträffar experter på doktorandnivå) och MMLU, och presterar bäst i 54 av 57 kategorier.

Inte alltid. Även om O1 utmärker sig i uppgifter som kräver mycket resonemang kan GPT4o överträffa den i enklare användningsfall där avancerat resonemang inte behövs.

O1 introducerar en ny 'Reason'-token utöver Prompt- och Completion-tokens, vilket möjliggör mer sofistikerat resonemang men kan öka driftskostnaden.

Du kan använda plattformar som FlowHunt för att bygga RAG-flöden och AI-agenter med OpenAI O1 för uppgifter som kräver avancerat resonemang och noggrann dokumenthämtning.

Yasha är en skicklig mjukvaruutvecklare som specialiserar sig på Python, Java och maskininlärning. Yasha skriver tekniska artiklar om AI, prompt engineering och utveckling av chattbotar.

Prova FlowHunt för att dra nytta av de senaste LLM:erna som OpenAI O1 och GPT4o för överlägset resonemang och retrieval-augmented generation.

Jämför OpenAI O3 Mini och DeepSeek på resonemangsuppgifter, schackstrategi och agentbaserat verktygsanvändande. Se vilken AI som utmärker sig i noggrannhet, pri...

FlowHunt v2.19.14 introducerar OpenAI:s GPT-4.1-modeller, 9 nya bildgenereringsmodeller från Stable Diffusion, Google och Ideogram samt integration med HubSpot ...

Är OpenAI O3 Mini det rätta AI-verktyget för dig? Vi sätter den på prov med innehållsgenerering, beräkningar och mer. Se hur denna modell balanserar prestanda m...