Intelligenta agenter

En intelligent agent är en autonom enhet utformad för att uppfatta sin omgivning via sensorer och agera på denna miljö med hjälp av ställdon, utrustad med artif...

Upptäck de 12 faktorerna för att bygga robusta, skalbara AI-agenter: från naturlig språk-konvertering och promptägande, till mänskligt samarbete och stateless design. Bygg produktionsklara AI-system som levererar verkligt affärsvärde.

Innan vi dyker ner i faktorerna, låt oss klargöra vad vi menar med “AI-agenter”. I grunden är detta system som kan tolka naturliga språkbegäranden, fatta beslut baserat på kontext och utföra specifika åtgärder via verktyg eller API:er – allt samtidigt som de upprätthåller sammanhängande, pågående interaktioner.

De mest kraftfulla agenterna kombinerar språkmodellernas resonemangsförmåga med deterministisk kods tillförlitlighet. Men att hitta denna balans kräver noggranna designval, vilket är precis vad dessa faktorer adresserar.

Förmågan att omvandla naturliga språkbegäranden till strukturerade verktygsanrop är kärnan i agentens funktionalitet. Det är detta som gör det möjligt för en agent att ta ett enkelt kommando som “skapa en betalningslänk på 750 $ till Terri för AI Tinkerers-träffen i februari” och omvandla det till ett korrekt formaterat API-anrop.

{

"function": {

"name": "create_payment_link",

"parameters": {

"amount": 750,

"customer": "cust_128934ddasf9",

"product": "prod_8675309",

"price": "prc_09874329fds",

"quantity": 1,

"memo": "Hey Jeff - see below for the payment link for the February AI Tinkerers meetup"

}

}

}

Nyckeln till att detta fungerar pålitligt är att använda deterministisk kod för att hantera det strukturerade svaret från din språkmodell. Validera alltid API-payloads innan körning för att förebygga fel, och säkerställ att din LLM returnerar konsekventa JSON-format som kan tolkas pålitligt.

Dina prompts är gränssnittet mellan din applikation och språkmodellen – behandla dem som förstklassig kod. Även om ramverk som abstraherar prompts kan verka bekväma, döljer de ofta hur instruktioner skickas till LLM, vilket gör finjustering svårt eller omöjligt.

Behåll istället direkt kontroll över dina prompts genom att skriva dem explicit:

function DetermineNextStep(thread: string) -> DoneForNow | ListGitTags | DeployBackend | DeployFrontend | RequestMoreInformation {

prompt #"

{{ _.role("system") }}

You are a helpful assistant that manages deployments for frontend and backend systems.

...

{{ _.role("user") }}

{{ thread }}

What should the next step be?

"#

}

Denna metod ger dig flera fördelar:

Kontextfönstret fungerar som LLM:ens indata, inklusive prompts, konversationshistorik och extern data. Optimering av detta fönster förbättrar prestanda och token-effektivitet.

Gå bortom standardiserade meddelandeformat till egna strukturer som maximerar informationsdensitet:

<slack_message>

From: @alex

Channel: #deployments

Text: Can you deploy the backend?

</slack_message>

<list_git_tags>

intent: "list_git_tags"

</list_git_tags>

<list_git_tags_result>

tags:

- name: "v1.2.3"

commit: "abc123"

date: "2024-03-15T10:00:00Z"

</list_git_tags_result>

Denna metod erbjuder flera fördelar:

I grunden är verktyg helt enkelt JSON-utdata från LLM som triggar deterministiska åtgärder i din kod. Detta skapar en tydlig separation mellan AI-beslutsfattande och exekveringslogik.

Definiera verktygsscheman tydligt:

class CreateIssue {

intent: "create_issue";

issue: {

title: string;

description: string;

team_id: string;

assignee_id: string;

};

}

class SearchIssues {

intent: "search_issues";

query: string;

what_youre_looking_for: string;

}

Bygg sedan pålitlig tolkning av LLM:s JSON-utdata, använd deterministisk kod för att utföra åtgärderna och mata tillbaka resultaten i kontexten för iterativa arbetsflöden.

Många agentramverk separerar exekveringstillstånd (t.ex. aktuell steg i ett flöde) från affärstillstånd (t.ex. historik av verktygsanrop och deras resultat). Denna separation tillför onödig komplexitet.

Spara istället allt tillstånd direkt i kontextfönstret, och härled exekveringstillståndet från sekvensen av händelser:

<deploy_backend>

intent: "deploy_backend"

tag: "v1.2.3"

environment: "production"

</deploy_backend>

<error>

error running deploy_backend: Failed to connect to deployment service

</error>

Detta enade arbetssätt ger:

Produktionsklara agenter måste integreras sömlöst med externa system, kunna pausas för långvariga uppgifter och återupptas när de triggas av webhooks eller andra händelser.

Implementera API:er som möjliggör start, paus och återuppta av agenter, med robust lagring av tillstånd mellan operationer. Detta möjliggör:

AI-agenter behöver ofta mänsklig input vid viktiga beslut eller otydliga situationer. Med strukturerade verktygsanrop blir denna interaktion smidig:

class RequestHumanInput {

intent: "request_human_input";

question: string;

context: string;

options: {

urgency: "low" | "medium" | "high";

format: "free_text" | "yes_no" | "multiple_choice";

choices: string[];

};

}

Denna metod ger tydlig specificering av interaktionstyp och brådska, stödjer input från flera användare och kombineras väl med API:er för hållbara arbetsflöden.

Egen kontroll av flödet ger dig möjlighet att pausa för mänskligt godkännande, cacha resultat eller införa ratenbegränsning – och därmed anpassa agentens beteende till dina behov:

async function handleNextStep(thread: Thread) {

while (true) {

const nextStep = await determineNextStep(threadToPrompt(thread));

if (nextStep.intent === 'request_clarification') {

await sendMessageToHuman(nextStep);

await db.saveThread(thread);

break;

} else if (nextStep.intent === 'fetch_open_issues') {

const issues = await linearClient.issues();

thread.events.push({ type: 'fetch_open_issues_result', data: issues });

continue;

}

}

}

Med detta tillvägagångssätt får du:

Att inkludera fel direkt i kontextfönstret gör att AI-agenter kan lära sig av misslyckanden och justera sitt arbetssätt:

try {

const result = await handleNextStep(thread, nextStep);

thread.events.push({ type: `${nextStep.intent}_result`, data: result });

} catch (e) {

thread.events.push({ type: 'error', data: formatError(e) });

}

För att detta ska fungera effektivt:

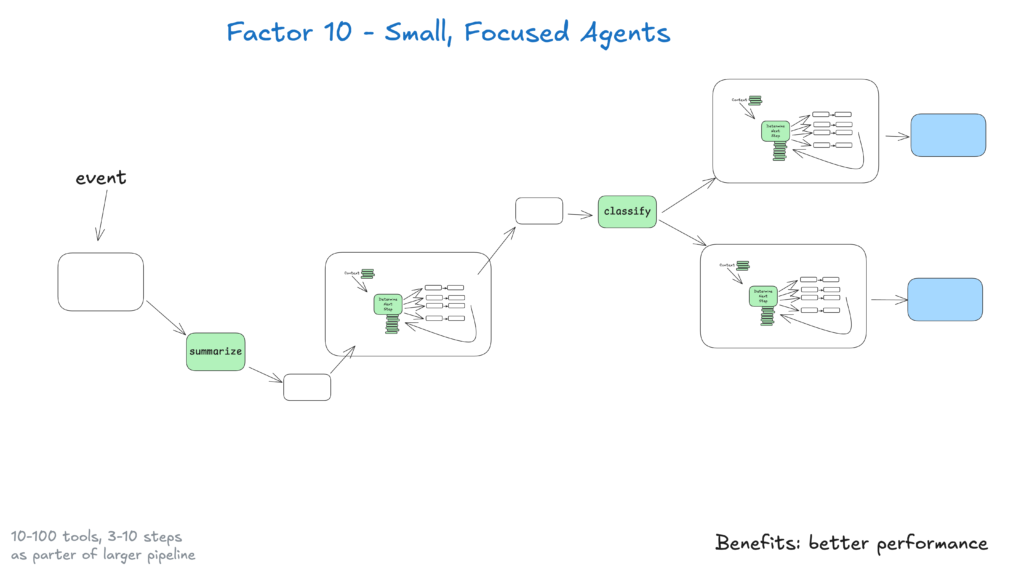

Små agenter som hanterar 3–20 steg bibehåller överskådliga kontextfönster, vilket förbättrar LLM-prestanda och tillförlitlighet. Detta ger:

I takt med att LLM:er fortsätter förbättras kan dessa små agenter utöka sitt omfång samtidigt som kvaliteten bibehålls, vilket garanterar långsiktig skalbarhet.

Gör dina agenter tillgängliga genom att tillåta triggers från Slack, e-post eller eventsystem – och möt användarna där de redan arbetar.

Implementera API:er som startar agenter från olika kanaler och låter dem svara via samma medium. Detta möjliggör:

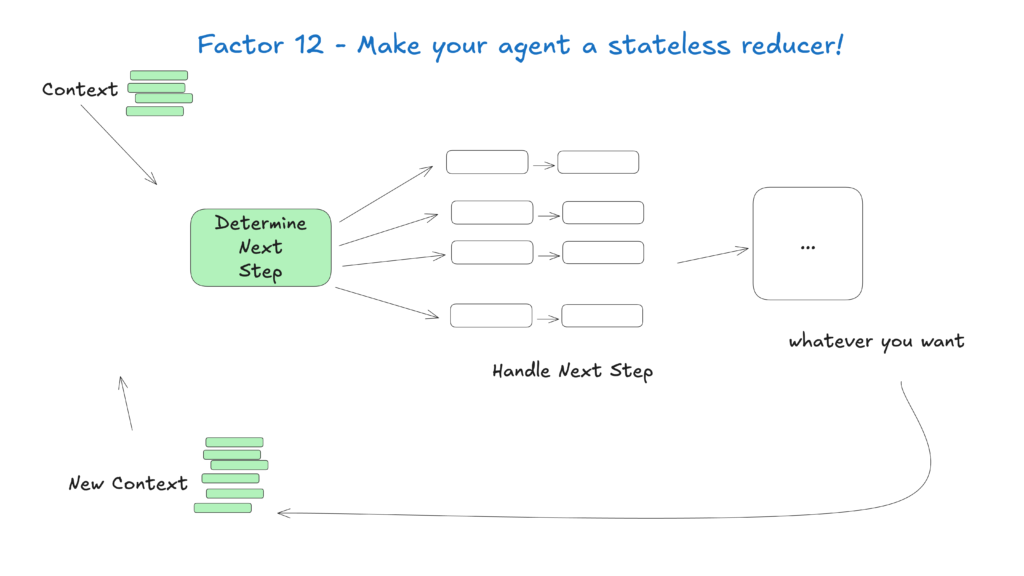

Behandla agenter som stateless-funktioner som omvandlar indata-kontext till utdata-åtgärder för att förenkla tillståndshanteringen, vilket gör dem förutsägbara och enklare att felsöka.

Detta konceptuella tillvägagångssätt ser agenter som rena funktioner utan internt tillstånd och ger:

Fältet AI-agenter utvecklas snabbt, men dessa grundprinciper kommer vara relevanta även när underliggande modeller förbättras. Genom att börja med små, fokuserade agenter som följer dessa principer kan du skapa system som levererar värde idag och anpassar sig till framtida framsteg.

Kom ihåg att de mest effektiva AI-agenterna kombinerar språkmodellernas resonemangsförmåga med deterministisk kods tillförlitlighet – och dessa 12 faktorer hjälper dig att hitta den balansen.

På FlowHunt har vi omsatt dessa principer i praktiken genom att utveckla vår egen AI-agent som automatiskt skapar arbetsflödesautomationer för våra kunder. Här är hur vi tillämpade 12-faktorsmetodiken för att bygga ett tillförlitligt, produktionsklart system

12-faktorsmetodiken för AI-agenter är en uppsättning bästa praxis inspirerade av 12-faktor app-modellen, utformad för att hjälpa utvecklare bygga robusta, underhållbara och skalbara AI-agenter som presterar pålitligt i verkliga produktionsmiljöer.

Kontexthantering säkerställer att AI-agenter behåller relevant konversationshistorik, prompts och tillstånd, vilket optimerar prestanda, minskar tokenanvändning och förbättrar beslutsnoggrannheten.

FlowHunt AI-agenter strukturerar verktygsanrop för att be om mänsklig input vid behov, vilket möjliggör sömlöst samarbete, godkännanden och hållbara arbetsflöden för komplexa eller känsliga scenarier.

Stateless AI-agenter är förutsägbara, lättare att felsöka och enklare att skala eftersom de omvandlar indata-kontext till utdata-åtgärder utan att behålla dolt internt tillstånd.

Arshia är en AI-arbetsflödesingenjör på FlowHunt. Med en bakgrund inom datavetenskap och en passion för AI, specialiserar han sig på att skapa effektiva arbetsflöden som integrerar AI-verktyg i vardagliga uppgifter, vilket förbättrar produktivitet och kreativitet.

Redo att skapa robusta, produktionsklara AI-agenter? Upptäck FlowHunts verktyg och se hur 12-faktorsmetodiken kan förändra din automation.

En intelligent agent är en autonom enhet utformad för att uppfatta sin omgivning via sensorer och agera på denna miljö med hjälp av ställdon, utrustad med artif...

Agentisk AI är en avancerad gren av artificiell intelligens som gör det möjligt för system att agera självständigt, fatta beslut och utföra komplexa uppgifter m...

Utforska AI-agentmodellernas värld med en omfattande analys av 20 banbrytande system. Upptäck hur de tänker, resonerar och presterar inom olika uppgifter, och f...