Human-in-the-Loop – En guide för affärsledare till ansvarsfull AI

En praktisk guide för affärsledare om hur man implementerar Human-in-the-Loop (HITL)-ramverk för ansvarsfull styrning av AI, riskminskning, efterlevnad och för ...

KPMG:s guide för AI-risker och kontrollåtgärder ger organisationer ett strukturerat, etiskt arbetssätt för att hantera AI-risker och stödjer ansvarsfull implementering samt efterlevnad av globala standarder.

Den här statistiken må vara från förra året, men är fortfarande högaktuell. Enligt KPMG:s U.S. CEO Outlook 2024 angav hela 68 % av vd:arna att AI är en av deras främsta investeringsprioriteringar. De räknar med att tekniken ska öka effektiviteten, kompetensutveckla personalen och driva innovation i organisationen.

Det är ett starkt förtroende för AI – men det väcker också en viktig fråga: med så mycket på spel, hur kan organisationer säkerställa att de använder AI ansvarsfullt och etiskt?

Här kommer KPMG:s guide för AI-risker och kontrollåtgärder in i bilden. Den erbjuder ett tydligt och praktiskt ramverk som hjälper företag att ta tillvara AI:s potential och samtidigt hantera de verkliga risker tekniken innebär. I dagens landskap är det inte bara god praxis att bygga pålitlig AI – det är affärskritiskt.

Artificiell intelligens (AI) revolutionerar branscher, frigör nya nivåer av effektivitet, innovation och konkurrenskraft. Men denna förändring medför också särskilda risker och etiska utmaningar som organisationer måste hantera noggrant för att behålla förtroendet och säkerställa ansvarsfull användning. KPMG:s guide för AI-risker och kontrollåtgärder är utformad för att hjälpa organisationer att navigera i denna komplexitet genom att ge ett praktiskt, strukturerat och värderingsdrivet arbetssätt för AI-styrning.

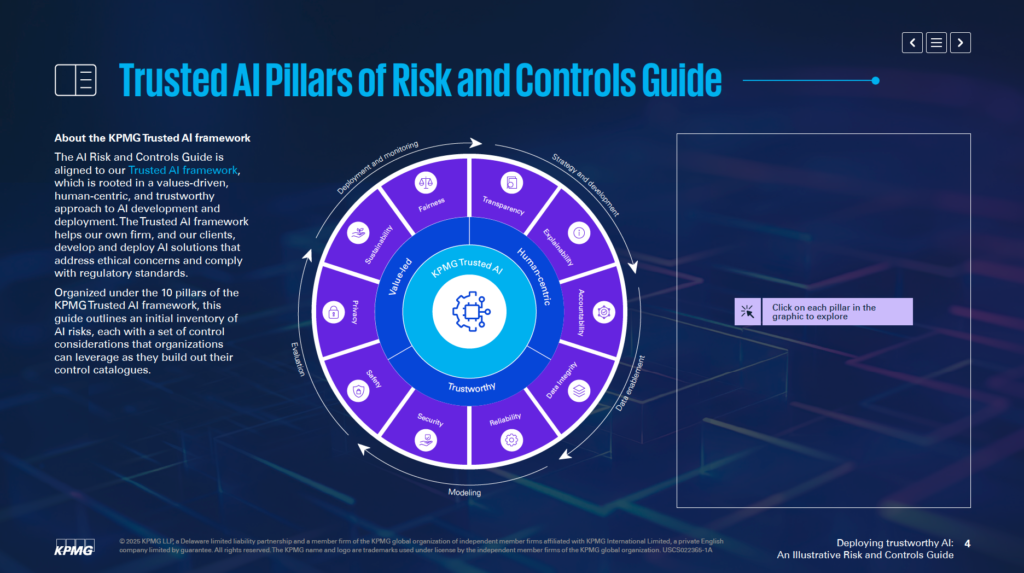

I linje med KPMG:s Trusted AI Framework hjälper guiden företag att utveckla och implementera AI-lösningar som är etiska, människocentrerade och uppfyller globala regulatoriska standarder. Den är uppbyggd kring 10 grundpelare, där varje pelare adresserar en avgörande aspekt av riskhanteringen för AI:

Genom att fokusera på dessa pelare kan organisationer förankra etiska principer i varje fas av AI-livscykeln – från strategi och utveckling till implementering och uppföljning. Guiden stärker inte bara riskresiliensen, utan främjar också innovation som är hållbar, pålitlig och i linje med samhälleliga förväntningar.

Oavsett om du är riskexpert, ledare, data scientist eller juridisk rådgivare erbjuder den här guiden viktiga verktyg och insikter för att du ska kunna använda AI på ett ansvarsfullt sätt.

KPMG:s guide för AI-risker och kontrollåtgärder är en specialiserad resurs som hjälper organisationer att hantera de särskilda risker som är kopplade till artificiell intelligens (AI). Den tar fasta på att AI innebär stora möjligheter, men att komplexiteten och de etiska frågorna kräver ett fokuserat arbetssätt för riskhantering. Guiden ger ett strukturerat ramverk för att möta dessa utmaningar på ett ansvarsfullt och effektivt sätt.

Guiden är inte avsedd att ersätta befintliga system, utan kompletterar befintliga processer för riskhantering. Målet är att inkludera AI-specifika överväganden i organisationens styrningsstrukturer och säkerställa smidig anpassning till nuvarande verksamhetsrutiner. På så sätt kan organisationer förstärka sin riskhanteringsförmåga utan att behöva omarbeta hela ramverket.

Guiden bygger på KPMG:s Trusted AI Framework, som förespråkar ett värderingsdrivet och människocentrerat angreppssätt för AI. Den integrerar principer från välkända standarder, såsom ISO 42001, NIST AI Risk Management Framework och EU AI Act. Detta säkerställer att guiden är både praktisk och i linje med globalt erkända bästa praxis och regulatoriska krav för AI-styrning.

Guiden erbjuder konkreta insikter och praktiska exempel anpassade för att hantera AI-relaterade risker. Den uppmuntrar organisationer att anpassa dessa exempel till sina egna förutsättningar, exempelvis om AI-systemen är egenutvecklade eller levererade av tredje part, samt utifrån typ av data och tillämpade tekniker. Denna flexibilitet gör guiden relevant för många branscher och AI-applikationer.

Guiden syftar till att organisationer ska kunna implementera AI-teknik på ett säkert, etiskt och transparent sätt. Genom att täcka tekniska, operativa och etiska aspekter av AI-risker hjälper den till att bygga förtroende hos intressenter samtidigt som AI:s transformativa möjligheter kan tas tillvara.

Guiden fungerar som en resurs för att säkerställa att AI-systemen är i linje med verksamhetens mål samtidigt som potentiella risker minimeras. Den stödjer innovation på ett sätt som prioriterar ansvar och ansvarstagande.

KPMG:s AI-styrningsguide är utformad för yrkesverksamma som ansvarar för AI-implementering och säkerställer att den sker säkert, etiskt och effektivt. Den är relevant för team inom flera områden i organisationen, till exempel:

C-nivåchefer och ledare som vd, CIO och CTO har stor nytta av guiden för att hantera AI som strategisk prioritet. Enligt KPMG:s US CEO Outlook 2024 anser 68 % av vd:arna att AI är ett viktigt investeringsområde. Guiden hjälper ledningen att anpassa AI-strategier till verksamhetens mål och samtidigt hantera tillhörande risker.

Mjukvaruingenjörer, data scientists och andra som utvecklar och implementerar AI-lösningar kan använda guiden för att integrera etiska principer och robusta kontroller direkt i systemen. Fokus ligger på att anpassa riskhantering till AI-modellens arkitektur och dataflöden.

Guiden är flexibel för företag som utvecklar AI internt, köper från leverantörer eller använder egen data. Den är särskilt relevant för branscher som finans, sjukvård och teknik där avancerade AI-tillämpningar och känslig data är affärskritiska.

Att implementera AI utan tydligt ramverk för styrning kan leda till finansiella, regulatoriska och ryktemässiga risker. KPMG:s guide kompletterar befintliga processer och ger ett strukturerat och etiskt sätt att hantera AI. Den främjar ansvar, transparens och etiska arbetssätt så att organisationer kan använda AI ansvarsfullt och samtidigt frigöra dess potential.

Organisationer bör börja med att koppla AI-specifika risker till sin nuvarande riskklassificering. En riskklassificering är ett strukturerat ramverk för att identifiera, organisera och hantera potentiella sårbarheter. Eftersom AI innebär unika utmaningar behöver traditionella klassificeringar utökas med AI-specifika faktorer. Dessa kan omfatta dataflödets noggrannhet, logiken bakom algoritmer och tillförlitligheten i datakällor. På så sätt blir AI-risker en del av organisationens övergripande riskhantering istället för att behandlas separat.

Guiden betonar vikten av att bedöma hela AI-systemets livscykel. Viktiga områden att granska är datakällor, hur data rör sig genom processer och den grundläggande logiken i AI-modellen. Ett brett perspektiv gör det lättare att identifiera var sårbarheter kan uppstå vid utveckling och användning av AI.

AI-system skiljer sig åt beroende på syfte, utvecklingsmetod och datatyp. Om modellen är egenutvecklad eller köpt av leverantör påverkar riskerna. Även datatypen – egen, publik eller känslig – och valda tekniker kräver skräddarsydda riskhanteringsstrategier.

Guiden rekommenderar att anpassa kontrollåtgärder efter AI-systemets specifika behov. Om du till exempel använder egen data kan striktare åtkomstkontroller krävas, medan AI-system från leverantörer kan kräva noggrann tredjepartsgranskning. Genom att skräddarsy kontrollerna kan du effektivare möta utmaningarna i dina AI-system.

Guiden förespråkar att riskhantering ska genomsyra varje fas i AI-livscykeln. Det innebär att planera för risker redan i designfasen, införa stark övervakning vid implementering och regelbundet uppdatera riskbedömningar när AI-systemet utvecklas. Genom att hantera risker i varje steg kan du minska sårbarheter och säkerställa att AI-systemen är etiska och tillförlitliga.

Att inleda med att koppla AI-risker till befintlig riskklassificering och anpassa kontroller efter behov ger en solid grund för pålitlig AI. Dessa åtgärder gör det möjligt för organisationer att systematiskt identifiera, utvärdera och hantera risker och därmed bygga ett robust ramverk för AI-styrning.

KPMG:s Trusted AI Framework bygger på tio centrala pelare som adresserar de etiska, tekniska och operativa utmaningarna med artificiell intelligens. Pelarna vägleder organisationer i att designa, utveckla och implementera AI-system på ett ansvarsfullt sätt och säkerställer förtroende och ansvar under hela AI-livscykeln.

Mänsklig övervakning och ansvar ska finnas i varje steg av AI-livscykeln. Det innebär att tydligt definiera vem som ansvarar för AI-risker, efterlevnad av lagar och regler samt upprätthålla möjligheten att ingripa, åsidosätta eller återkalla AI-beslut vid behov.

AI-system ska sträva efter att minska eller eliminera bias som kan påverka individer, grupper eller samhällen negativt. Det kräver noggrann granskning av data för att säkerställa representation, införande av rättvisemått vid utveckling och kontinuerlig övervakning av utfall för att främja lika behandling.

Transparens innebär att öppet redovisa hur AI-system fungerar och varför de fattar vissa beslut. Det omfattar dokumentation av systemens begränsningar, prestanda och testmetoder. Användare bör informeras när deras data samlas in, AI-genererat innehåll ska märkas tydligt och känsliga tillämpningar som biometrisk kategorisering ska ha tydlig användarinformation.

AI-system måste kunna ge begripliga skäl till sina beslut. Organisationer bör dokumentera dataset, algoritmer och prestandamått i detalj så att intressenter kan analysera och återskapa resultat effektivt.

Kvaliteten och tillförlitligheten i data under hela livscykeln – insamling, märkning, lagring och analys – är avgörande. Kontroller bör finnas för att hantera risker som datakorruption eller bias. Regelbundna kvalitetskontroller och regressionstester vid systemuppdateringar hjälper till att säkerställa att AI-systemen är korrekta och tillförlitliga.

AI-lösningar måste följa lagar om integritet och dataskydd. Organisationer behöver hantera begäran från registrerade korrekt, utföra konsekvensbedömningar för integritet och använda avancerade metoder som differential privacy för att balansera datanytta och skydda individens integritet.

AI-system ska prestera konsekvent enligt sitt avsedda syfte och med nödvändig noggrannhet. Det kräver grundlig testning, mekanismer för att upptäcka avvikelser samt kontinuerliga feedback-loopar för att validera systemets resultat.

Trygghetsåtgärder skyddar AI-system från att orsaka skada för individer, företag eller egendom. Det kan inkludera failsafes, övervakning mot exempelvis datakorruption eller prompt injection-attacker samt att systemen följer etiska och operativa normer.

Starka säkerhetsrutiner krävs för att skydda AI-system mot hot och illvilliga angrepp. Organisationer bör genomföra regelbundna granskningar, sårbarhetsanalyser och använda kryptering för att skydda känslig data.

AI-system bör designas för att minimera energianvändning och stödja miljömål. Hållbarhet ska beaktas redan i designprocessen och energiförbrukning, effektivitet samt utsläpp bör följas upp under hela AI-livscykeln.

Genom att följa dessa tio pelare kan organisationer skapa AI-system som är etiska, pålitliga och i linje med samhällets förväntningar. Ramverket ger en tydlig struktur för att hantera AI-utmaningar och främjar ansvarsfull innovation.

Dataintegritet är avgörande för att AI-system ska vara korrekta, rättvisa och tillförlitliga. Bristande datastyrning kan leda till risker som bias, felaktigheter och opålitliga resultat. Dessa problem kan underminera förtroendet för AI och skapa stora operativa och ryktemässiga konsekvenser. KPMG:s Trusted AI Framework lyfter vikten av att upprätthålla hög datakvalitet genom hela livscykeln för att säkerställa att AI-system fungerar effektivt och uppfyller etiska krav.

Utan stark datastyrning kan AI-system ge felaktiga resultat. Problem som ofullständig, felaktig eller irrelevant data kan skapa bias eller otillförlitliga utfall och därmed öka riskerna för olika AI-applikationer.

Data flyttas ofta mellan system för exempelvis träning, test eller drift. Om dessa överföringar inte hanteras rätt kan data bli korrupt, förlorad eller försämrad – vilket påverkar AI-systemens prestanda.

För att förbättra datastyrningen kan organisationer:

För att minska risker vid dataöverföringar bör organisationer:

Med hjälp av kontinuerlig övervakning kan organisationer upprätthålla dataintegritet genom hela AI-livscykeln. Sådana system kan upptäcka problem som oväntade förändringar i datakvalitet eller inkonsekvenser i datahanteringen, vilket möjliggör snabba korrigerande åtgärder.

Att upprätthålla dataintegritet är grundläggande för att införa pålitliga AI-system. Organisationer kan minska riskerna genom att etablera starka styrningsramverk, skydda datainteraktioner och säkerställa kontinuerlig validering. Dessa åtgärder ökar AI-resultatens tillförlitlighet och säkerställer att etiska och operativa krav uppfylls, vilket bidrar till ökat förtroende för AI-teknik.

Att hantera begäran om tillgång för registrerade är en stor utmaning för AI och integritet. Organisationer måste säkerställa att individer kan utöva sina rättigheter att få tillgång till, rätta eller radera personuppgifter enligt lagar som GDPR och CCPA. Om dessa begäran inte hanteras korrekt kan det leda till regelbrott, minskat förtroende och skada organisationens rykte.

För att minska risken bör företag skapa program för att utbilda individer om deras datarättigheter vid AI-interaktioner. System måste finnas för att hantera dessa begäran snabbt och transparent. Organisationer bör också föra detaljerad dokumentation över hur begäran hanteras för att kunna visa efterlevnad vid revisioner.

AI-system hanterar ofta känsliga personuppgifter, vilket gör dem till attraktiva mål för cyberattacker. Ett dataintrång kan orsaka stora böter, skada företagets rykte och leda till förlorat kundförtroende.

För att motverka detta rekommenderar KPMG:s Trusted AI Framework etiska granskningar av AI-system som hanterar personuppgifter för att säkerställa att de uppfyller regelverk för integritet. Regelbundna revisioner och konsekvensbedömningar för dataskydd (PIA) är nödvändiga, särskilt när känslig data används till exempel vid träning av AI-modeller. Metoder som differential privacy, där statistiskt brus läggs till i data, kan dessutom hjälpa till att anonymisera information samtidigt som analys möjliggörs.

AI-system som inte har integritetsskydd inbyggt från början riskerar allvarliga problem. Utan privacy-by-design riskerar organisationer att exponera känslig data eller bryta mot lagkrav.

Företag bör införa integritetsskydd redan under utvecklingen av AI-system. Det innebär att följa lagar och regelverk för dataskydd genom god datahantering. Det är avgörande med tydlig dokumentation om hur data samlas in, används och lagras. Organisationer måste också inhämta uttryckligt samtycke från användare för datainsamling och behandling, särskilt vid känsliga tillämpningar som biometrisk data.

När AI-system inte tydligt förklarar hur användardata hanteras kan det leda till misstro och juridisk granskning. Användare ska veta när deras data samlas in och hur den används

KPMG:s guide för AI-risker och kontrollåtgärder är ett praktiskt ramverk utformat för att hjälpa organisationer att hantera AI:s unika risker och säkerställa ansvarsfull, etisk och regelkonform implementering av AI inom olika branscher.

Guiden bygger på tio centrala pelare: Ansvarstagande, Rättvisa, Transparens, Förklarbarhet, Dataintegritet, Tillförlitlighet, Säkerhet, Trygghet, Integritet och Hållbarhet – var och en adresserar viktiga aspekter av AI-riskhantering.

Guiden riktar sig till riskexperter, efterlevnadsteam, cybersäkerhetsspecialister, juridiska rådgivare, ledare, AI-utvecklare, ingenjörer samt organisationer av alla storlekar som vill hantera AI ansvarsfullt.

Den är anpassad till globala standarder som ISO 42001, NIST AI Risk Management Framework och EU AI Act, och hjälper organisationer att integrera AI-specifika kontroller i befintliga styrprocesser och möta regulatoriska krav.

Den föreslår åtgärder som stark datastyrning, privacy-by-design, kontinuerlig övervakning, transparens i AI-beslut, avvikelsedetektering, feedback-loopar och hållbarhetsmål för att minska AI-relaterade risker.

Upptäck hur KPMG:s guide för AI-risker och kontrollåtgärder kan hjälpa din organisation att omfamna AI-innovation samtidigt som ni säkerställer etisk, säker och regelkonform implementering.

En praktisk guide för affärsledare om hur man implementerar Human-in-the-Loop (HITL)-ramverk för ansvarsfull styrning av AI, riskminskning, efterlevnad och för ...

Europeiska unionens artificiella intelligens-förordning (EU AI Act) är världens första heltäckande regelverk utformat för att hantera risker och utnyttja fördel...

Utforska de senaste trenderna inom AI-finansiering 2024, inklusive ökade investeringar, teknikjättarnas dominans, tillväxten inom generativ AI och startupbolage...