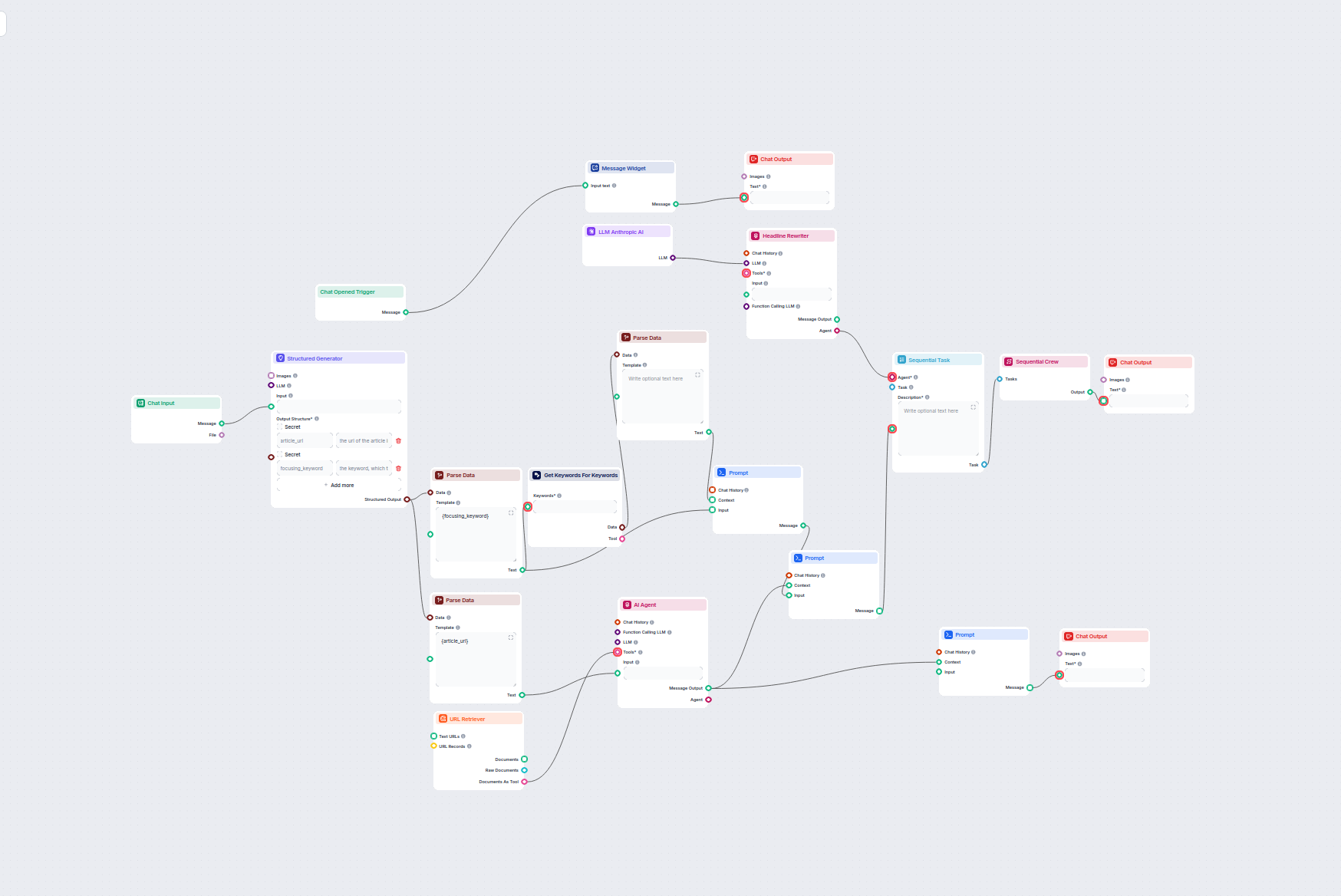

AI Bloggrubriks- & Nyckelordsoptimerare

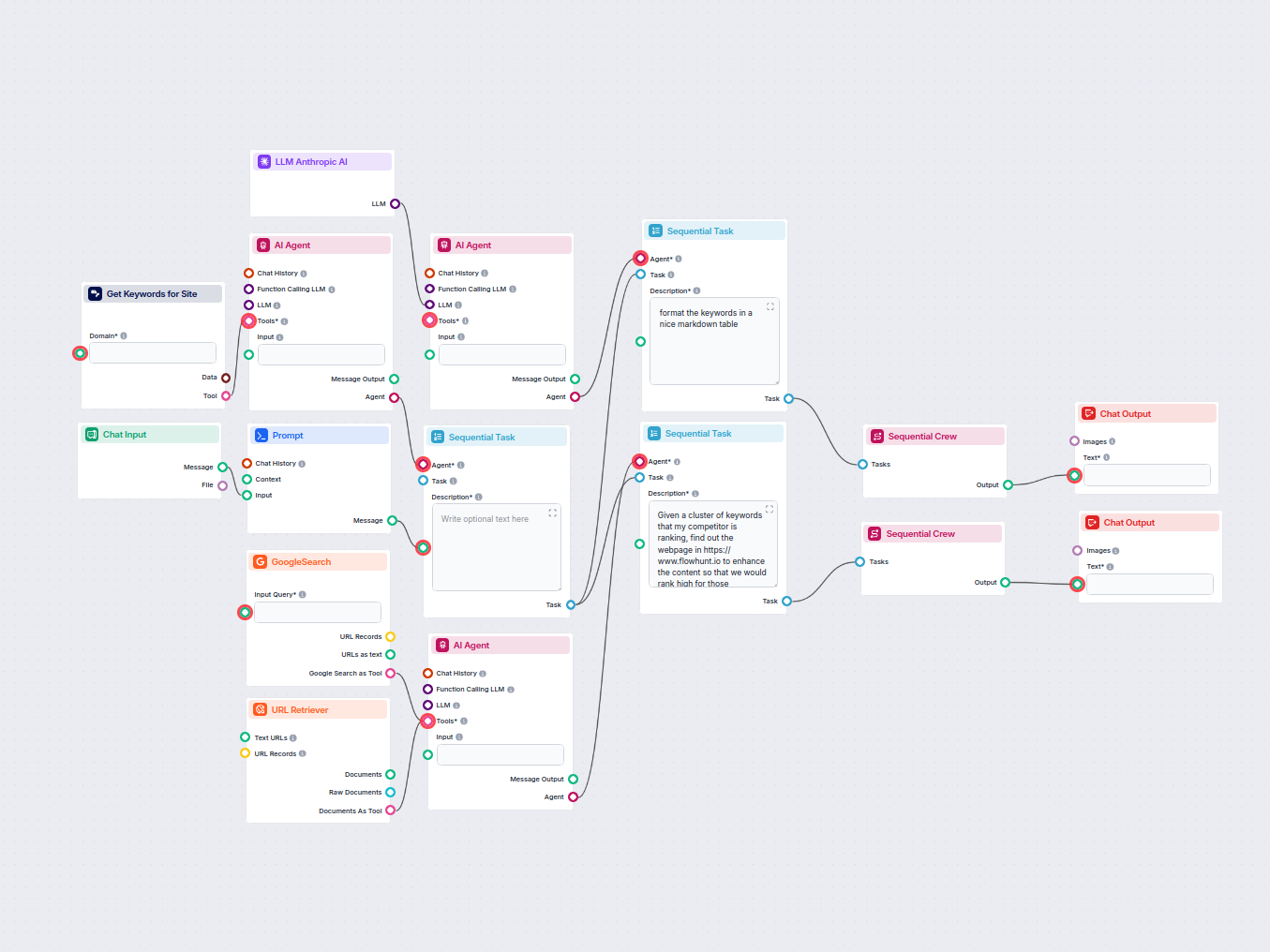

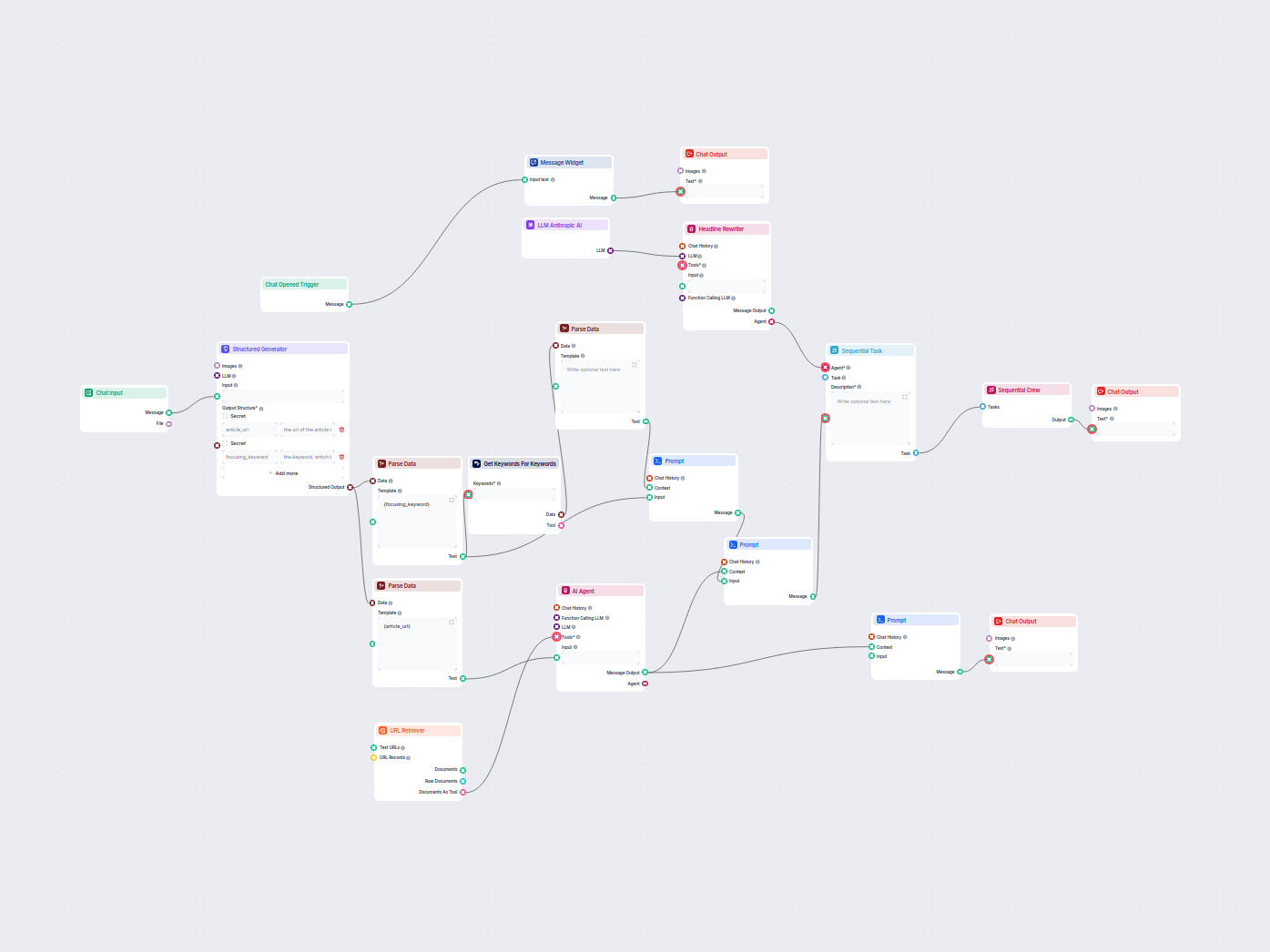

Detta AI-drivna arbetsflöde hittar de bästa SEO-nyckelorden för din bloggartikel och skriver automatiskt om rubriker för att rikta in sig på dessa nyckelord, vi...

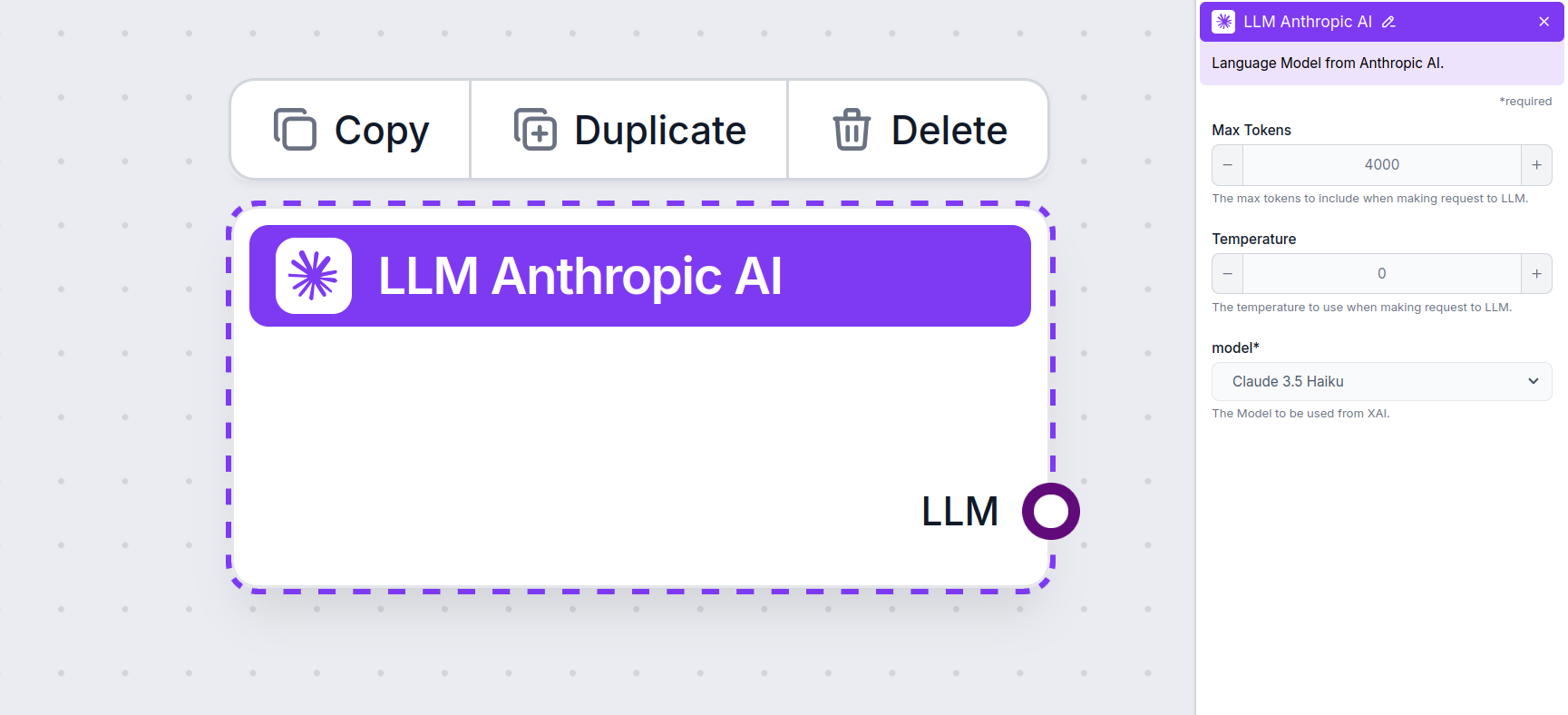

Koppla Anthropic’s Claude-modeller till din FlowHunt-instrumentpanel för flexibel AI-textgenerering och chatbotlösningar, med kontroll över tokens, temperatur och modellval.

Komponentbeskrivning

Olika uppgifter kräver olika modeller, och FlowHunt är engagerad i att ge dig det bästa av AI utan att du behöver teckna otaliga prenumerationer. Istället får du dussintals text- och bildgenereringsmodeller i en och samma instrumentpanel. LLM-komponenterna samlar textgenerering och deras varierande användningsområden inom AI, innehållsskapande och automatisering, grupperade efter leverantör, vilket gör att du kan byta AI-modell i farten.

LLM Anthropic AI-komponenten kopplar Claude-familjens modeller till ditt flöde. Generators och Agents är där magin sker, men LLM-komponenter låter dig styra vilken modell som används. Alla komponenter har ChatGPT-4 som standard. Du kan koppla denna komponent om du vill byta modell eller få mer kontroll över den.

Kom ihåg att det är valfritt att koppla en LLM-komponent. Alla komponenter som använder en LLM har ChatGPT-4o som standard. LLM-komponenterna låter dig byta modell och styra modellinställningarna.

Tokens representerar de individuella enheter av text som modellen bearbetar och genererar. Tokenanvändning varierar mellan modeller, och en token kan vara allt från ord eller delord till ett enda tecken. Modeller prissätts vanligtvis utifrån miljoner tokens.

Inställningen för max tokens begränsar det totala antalet tokens som kan bearbetas i en enskild interaktion eller förfrågan, vilket säkerställer att svaren genereras inom rimliga ramar. Standardgränsen är 4 000 tokens, vilket är den optimala storleken för att sammanfatta dokument och flera källor för att generera ett svar.

Temperatur styr variabiliteten i svaren och varierar från 0 till 1.

Till exempel rekommenderas en temperatur mellan 0,2 och 0,5 för en kundtjänstbot. Den nivån ser till att svaren håller sig relevanta och enligt manus, men ändå möjliggör naturlig variation.

Detta är modellväljaren. Här hittar du alla modeller från Anthropic som stöds. Vi stödjer för närvarande alla de senaste modellerna från Claude-familjen:

Du kommer märka att alla LLM-komponenter bara har ett utgångshandtag. Ingen input passerar genom komponenten, då den endast representerar modellen, medan själva genereringen sker i AI-agenter och generators.

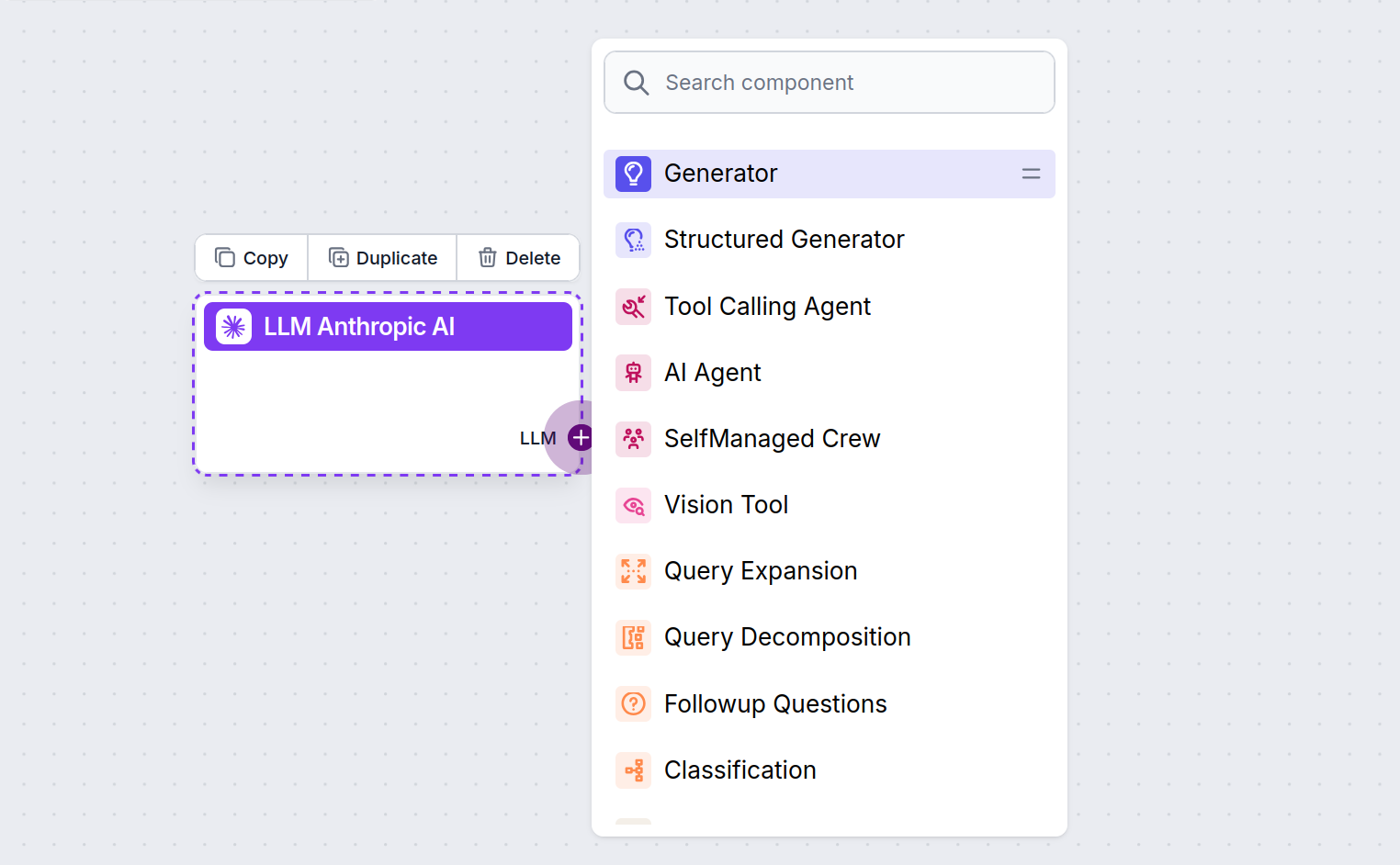

LLM-handtaget är alltid lila. LLM-inmatningshandtaget finns på varje komponent som använder AI för att generera text eller bearbeta data. Du kan se alternativen genom att klicka på handtaget:

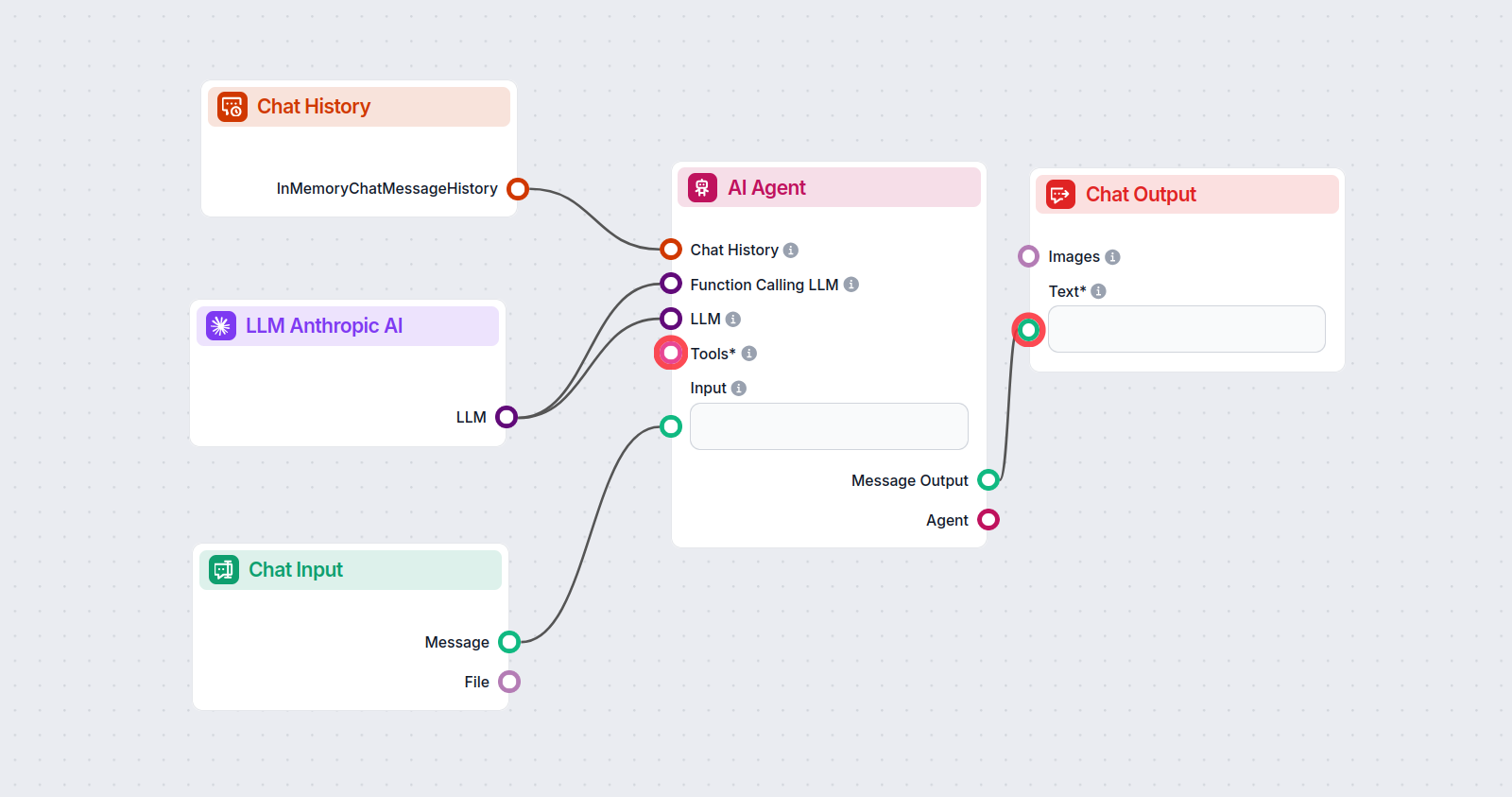

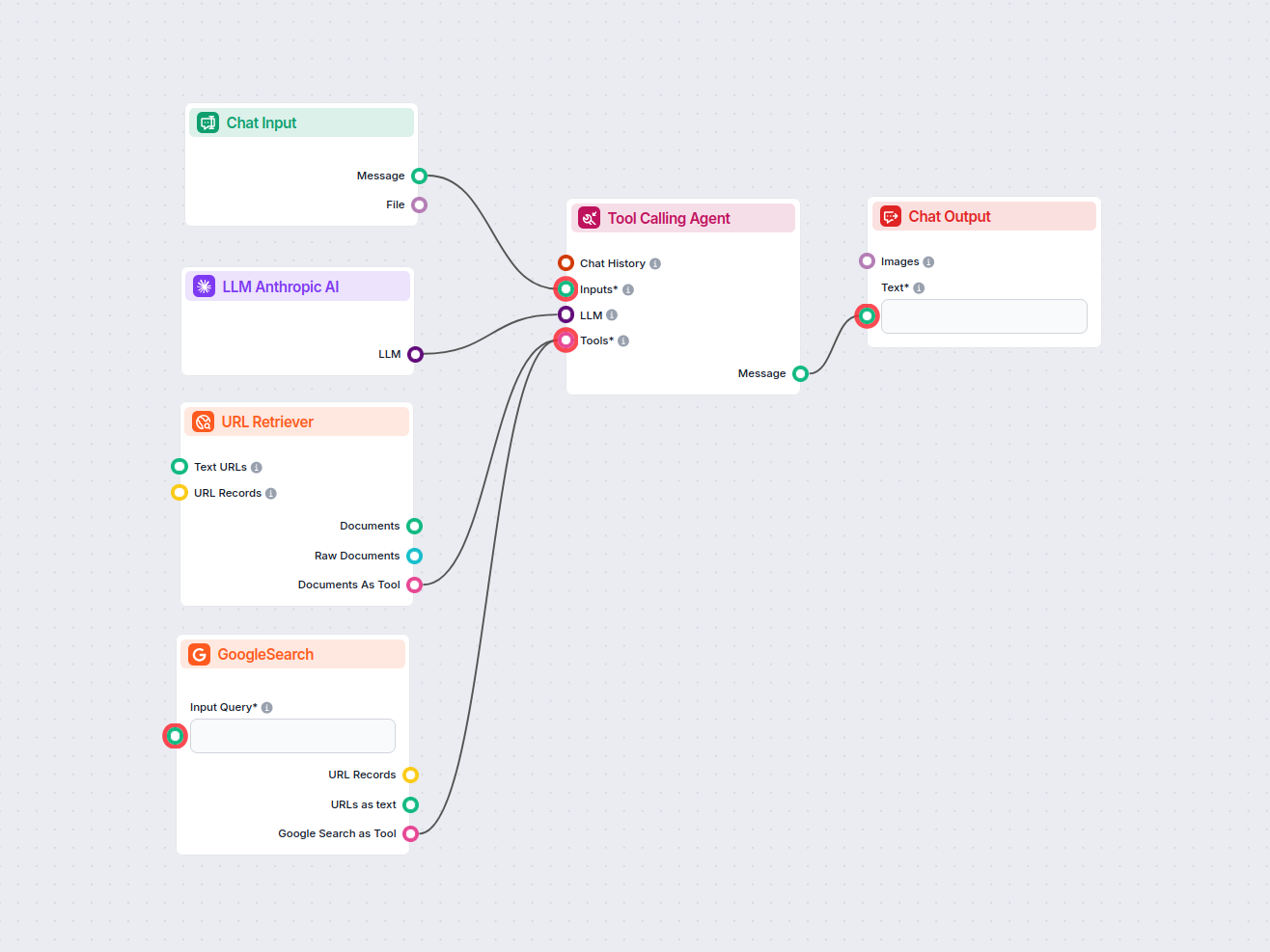

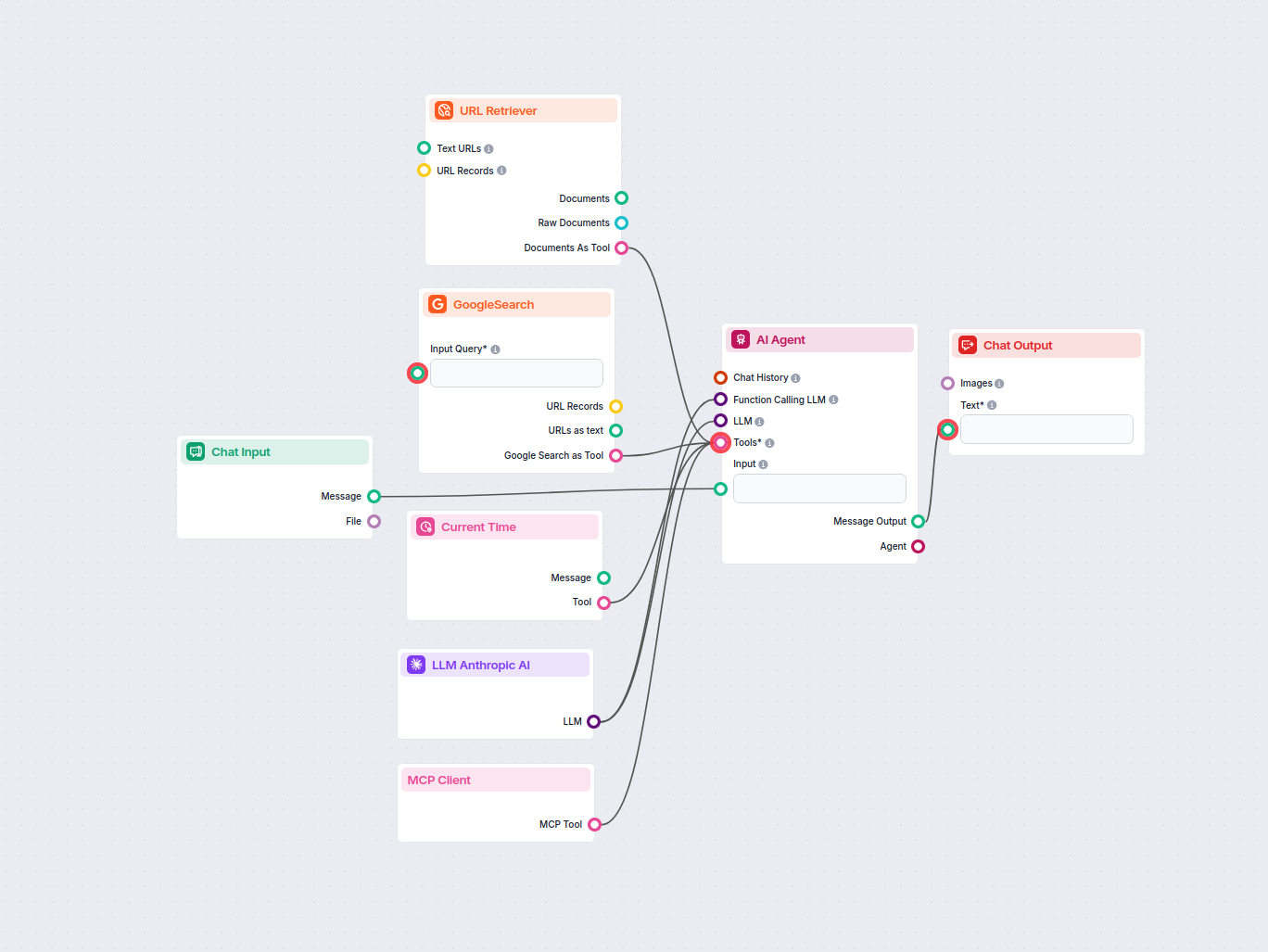

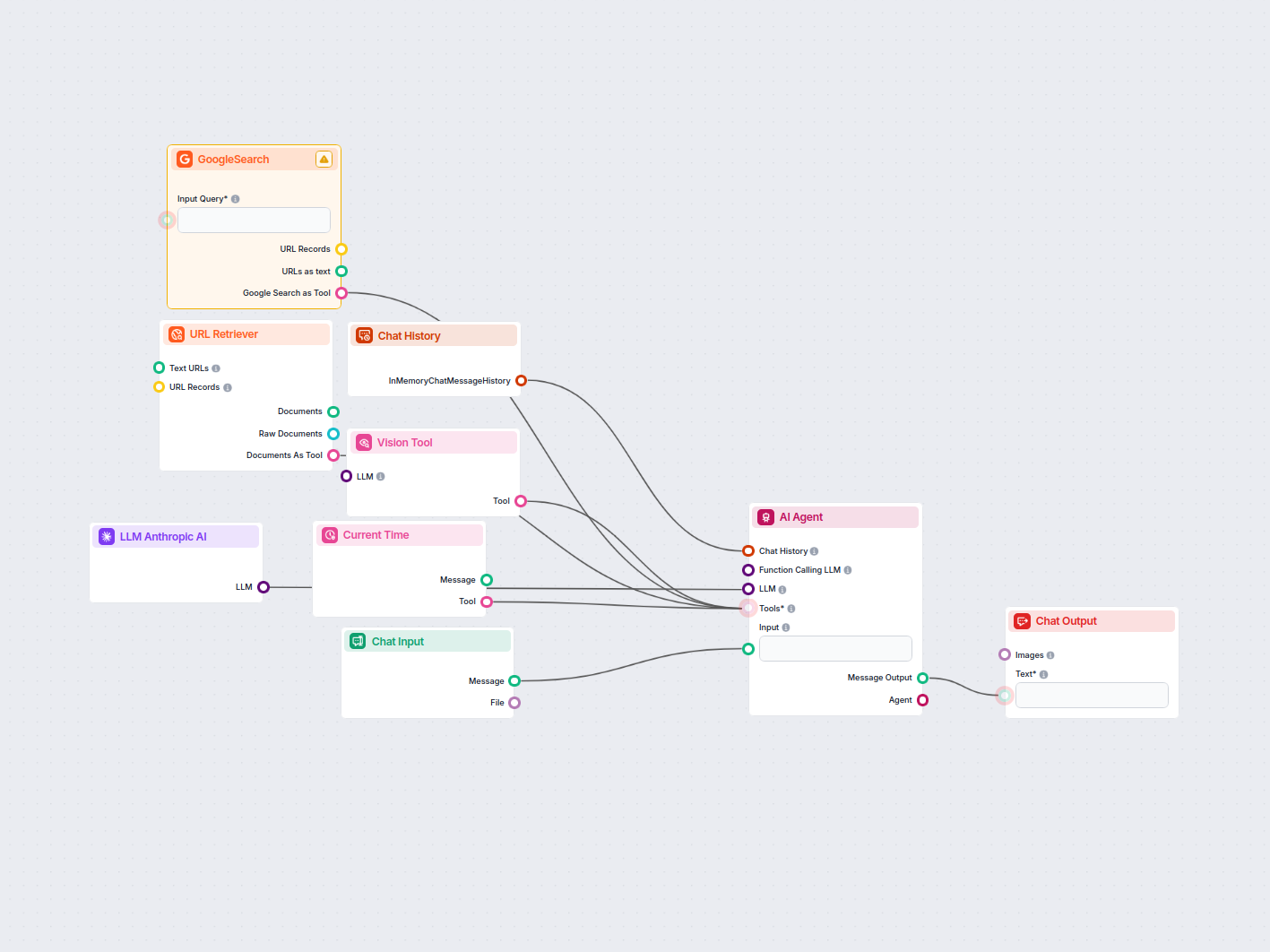

Detta gör att du kan skapa alla möjliga typer av verktyg. Låt oss se komponenten i praktiken. Här är ett enkelt AI Agent chatbot-flöde som använder Anthropic’s Claude 3.5 Sonnet för att generera svar. Du kan se det som en grundläggande Anthropic-chatbot.

Detta enkla chatbot-flöde inkluderar:

För att hjälpa dig komma igång snabbt har vi förberett flera exempel på flow-mallar som demonstrerar hur du använder LLM Anthropic AI-komponenten effektivt. Dessa mallar visar olika användningsfall och bästa praxis, vilket gör det lättare för dig att förstå och implementera komponenten i dina egna projekt.

Detta AI-drivna arbetsflöde hittar de bästa SEO-nyckelorden för din bloggartikel och skriver automatiskt om rubriker för att rikta in sig på dessa nyckelord, vi...

Generera automatiskt SEO-optimerade beskrivningar för kategorisidor i e-handel med hjälp av AI. Ange bara en kategori-URL så undersöker arbetsflödet kategorin, ...

Analysera automatiskt din konkurrents hemsida för att upptäcka deras högst rankade nyckelord, samla in nyckelordsdata från Google och få handlingsbara rekommend...

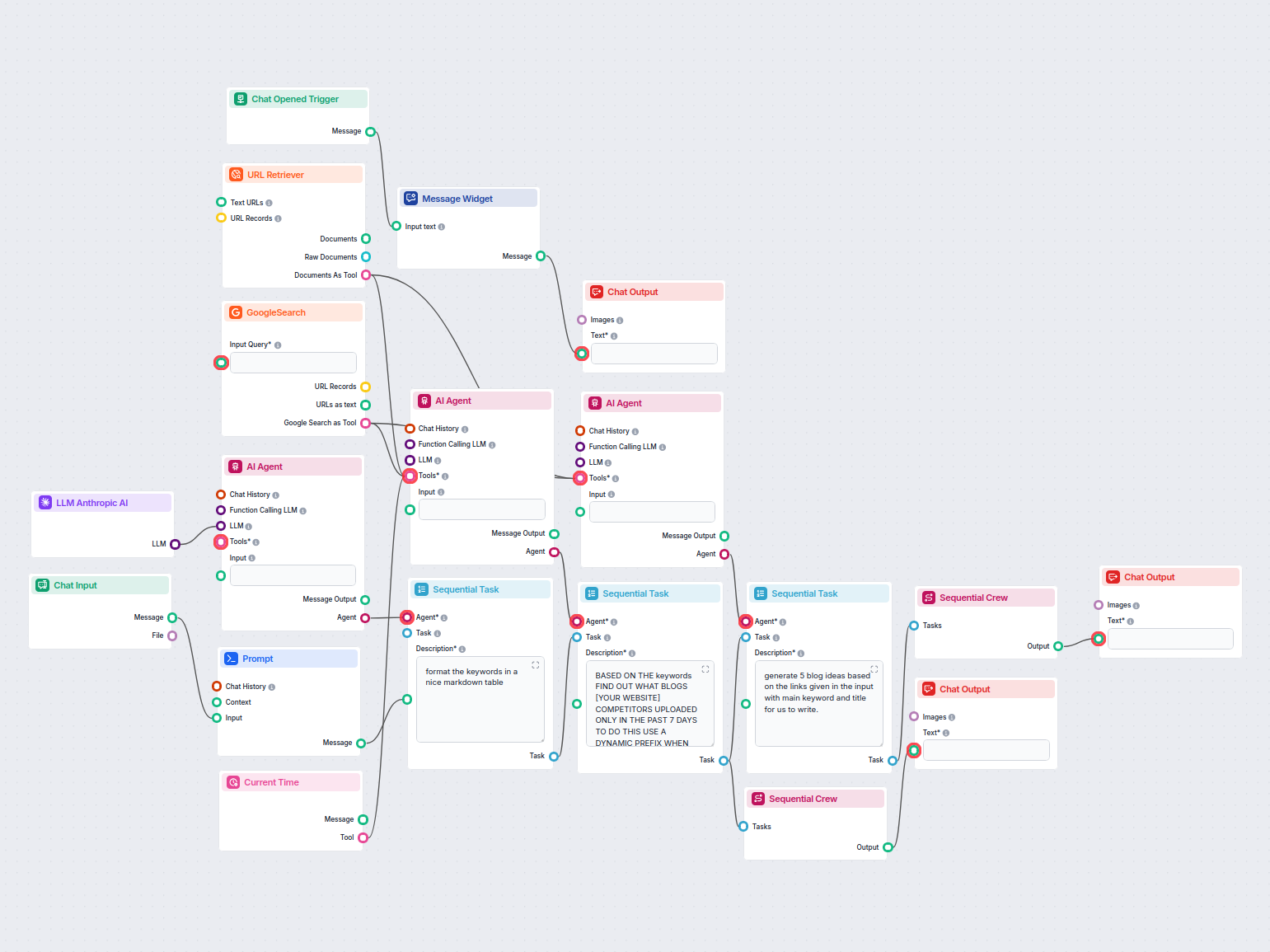

Detta AI-drivna arbetsflöde undersöker konkurrenter och trendande ämnen för att generera högpåverkande, SEO-optimerade bloggidéer för FlowHunt.io. Med hjälp av ...

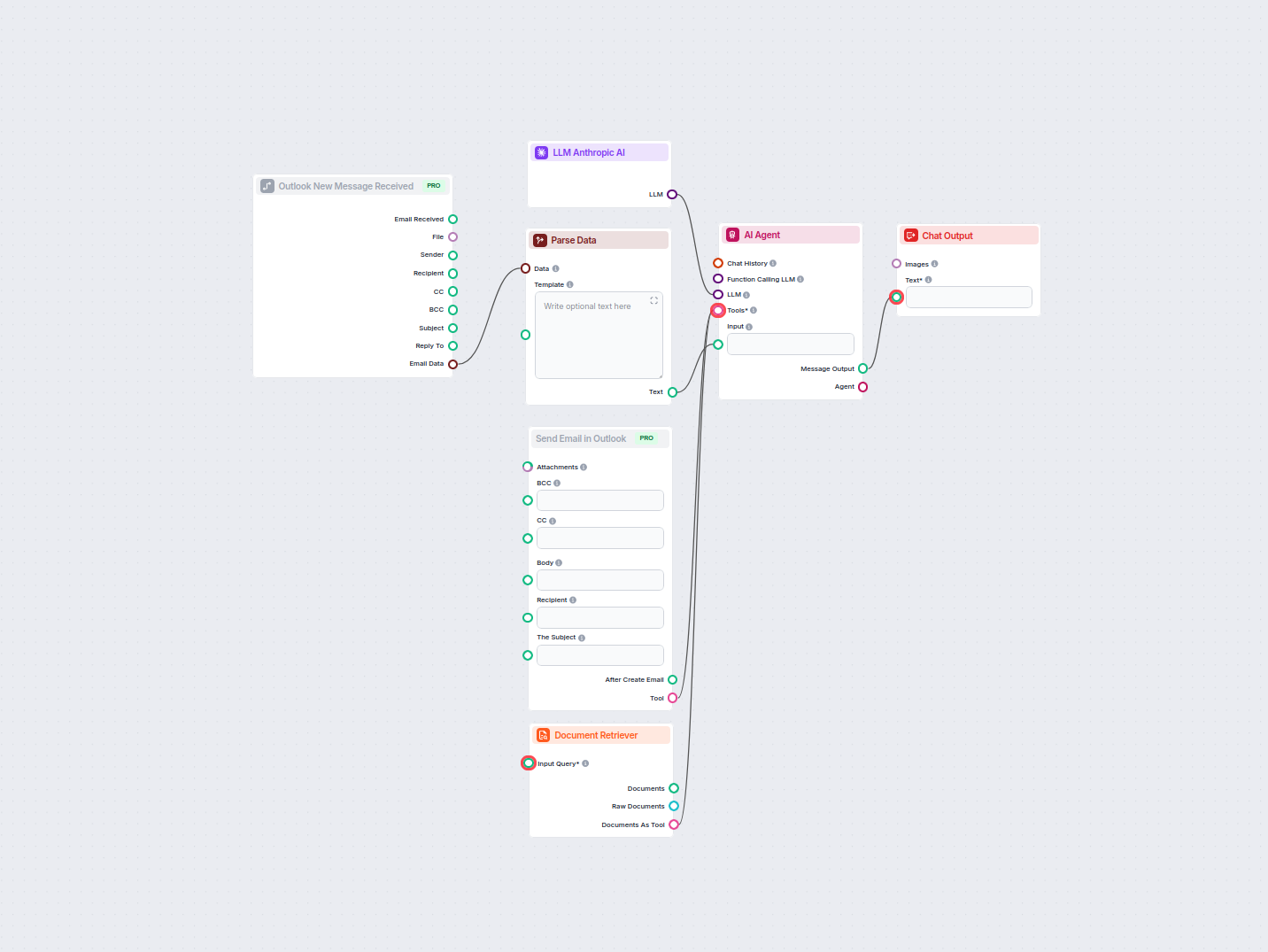

Automatisera professionella e-postsvar i Outlook med en AI-agent som utnyttjar organisatoriska kunskapskällor. Inkommande e-postmeddelanden tas emot, tolkas och...

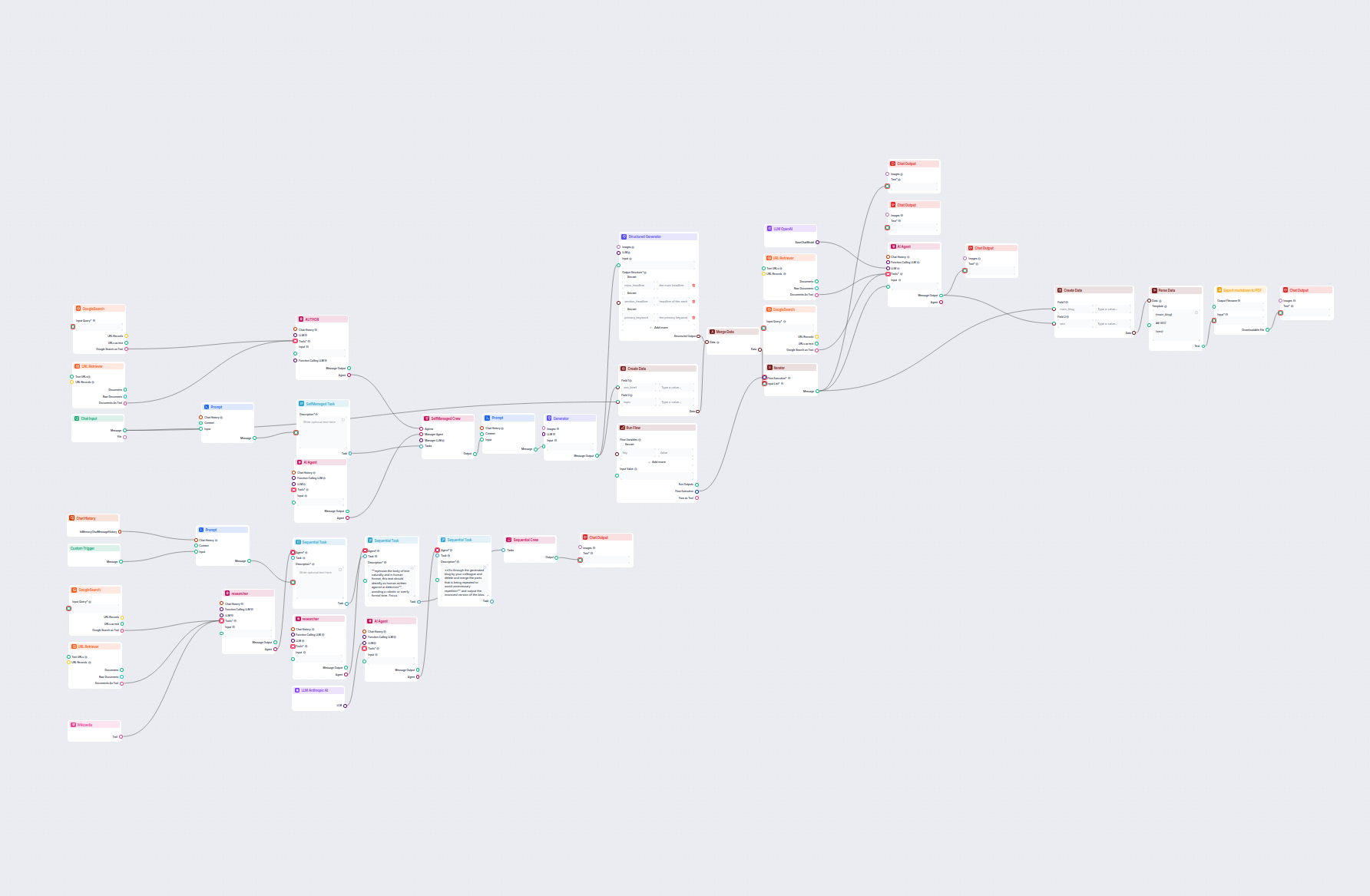

Generera omfattande, SEO-optimerade blogginlägg med avancerad struktur och hög ordräkningsnivå med hjälp av flera AI-agenter. Arbetsflödet inkluderar automatise...

Analysera automatiskt topprankade konkurrentbloggar från den senaste veckan och generera nya bloggidéer för din webbplats. Detta AI-arbetsflöde undersöker konku...

Detta arbetsflöde automatiserar LinkedIn-annonsernas marknadsundersökning genom att identifiera toppkonkurrenter för ett sökord, analysera deras annonstexter oc...

Optimera automatiskt din artikels rubriker och titel för ett specifikt nyckelord eller nyckelordsgrupp för att förbättra SEO-prestandan. Detta arbetsflöde analy...

Detta AI-drivna arbetsflöde förbättrar Shopify-produktbeskrivningar baserat på produktnamn eller URL som användaren tillhandahåller. Det använder LLM:er, hämtar...

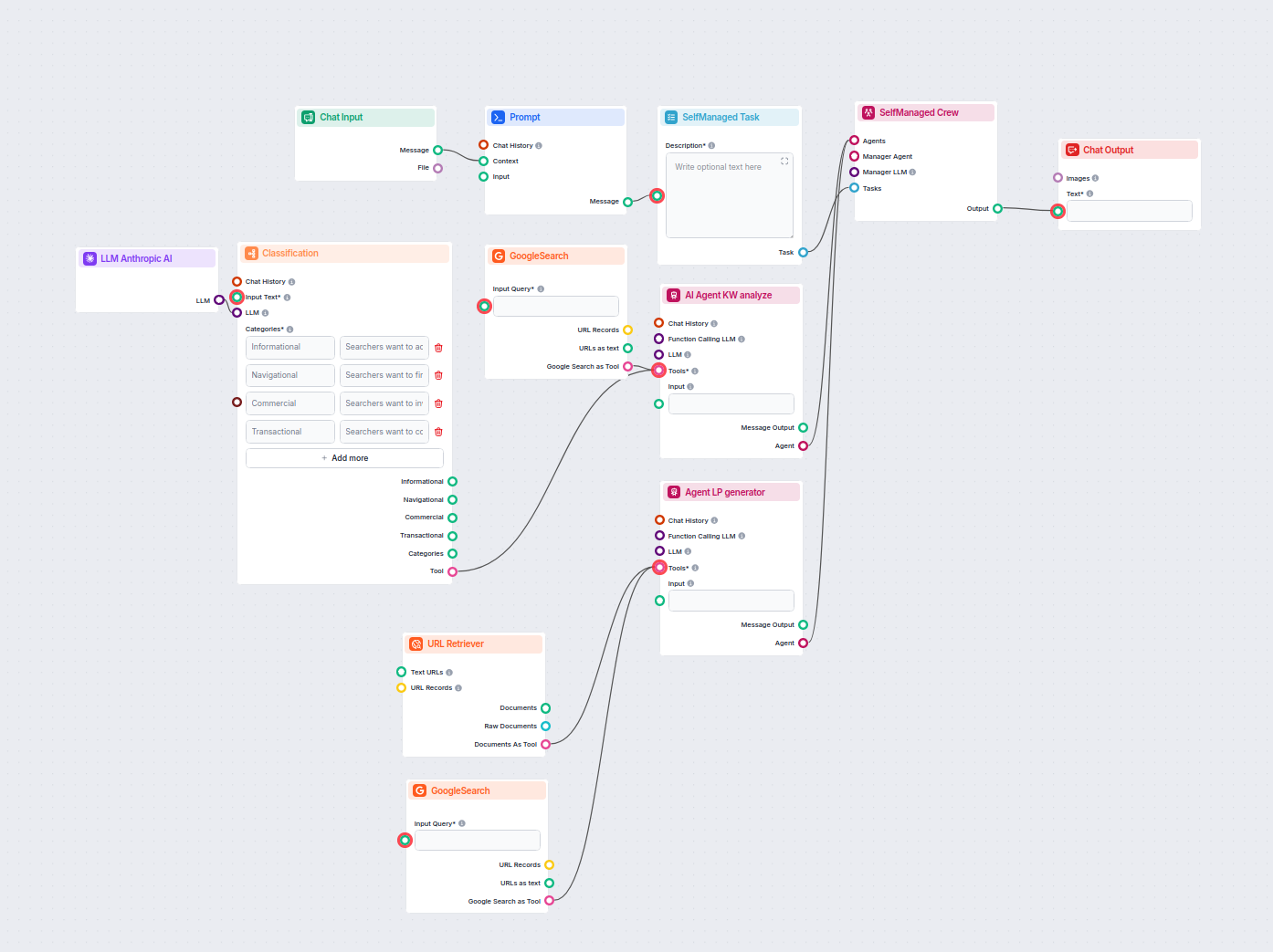

Detta AI-drivna arbetsflöde klassificerar sökfrågor efter intention, undersöker topprankade URL:er och genererar en högoptimerad landningssida för PPC- och SEO-...

LLM Anthropic AI-komponenten kopplar Anthropic’s Claude-modeller till dina FlowHunt-flöden, så att du kan anpassa vilken modell som används för textgenerering och styra inställningar som max tokens och temperatur.

FlowHunt stödjer alla de senaste modellerna från Claude-familjen, inklusive Claude 3.5 Sonnet, Claude 3 Sonnet, Claude 3 Haiku och Claude 2.

Max tokens sätter längdgränsen för varje svar, medan temperatur styr slumpmässigheten—lägre värden ger fokuserade svar, högre värden ökar kreativiteten.

Nej, att koppla LLM Anthropic AI-komponenten är valfritt. Som standard används ChatGPT-4o, men du kan lägga till denna komponent för att byta till Claude-modeller och finjustera inställningarna.

Börja bygga egna AI-verktyg och chatbots med Anthropic’s Claude-modeller, enkel flödesintegration och kraftfull konfiguration.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från OpenAI. Så här använder du ChatGPT i dina AI-verktyg och chatbottar.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive Metas Llama-modeller. Lär dig hur du integrerar Llama i dina AI-verktyg och chatbots, anpassar ins...

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från xAI. Här är hur du använder xAI-modellerna i dina AI-verktyg och chatbots.