LLM Gemini

FlowHunt stöder dussintals AI-modeller, inklusive Google Gemini. Lär dig hur du använder Gemini i dina AI-verktyg och chattbotar, växla mellan modeller och kont...

LLM DeepSeek från FlowHunt låter dig komma åt och anpassa toppmodeller som DeepSeek R1 för text- och bildgenerering i dina chatbottar och AI-verktyg, allt från en enda kontrollpanel.

Komponentbeskrivning

LLM DeepSeek-komponenten kopplar DeepSeek-modellerna till ditt Flöde. Medan Generatorer och Agenter är där själva magin sker, låter LLM-komponenterna dig byta och styra vilken modell som används.

Kom ihåg att det är valfritt att koppla en LLM-komponent. Alla komponenter som använder en LLM har ChatGPT-4o som standard. LLM-komponenterna låter dig byta modell och styra modellinställningarna.

Tokens representerar de individuella enheterna av text som modellen behandlar och genererar. Tokenanvändning varierar mellan modeller, och en token kan vara allt från ord eller delord till ett enskilt tecken. Modeller prissätts vanligtvis per miljon tokens.

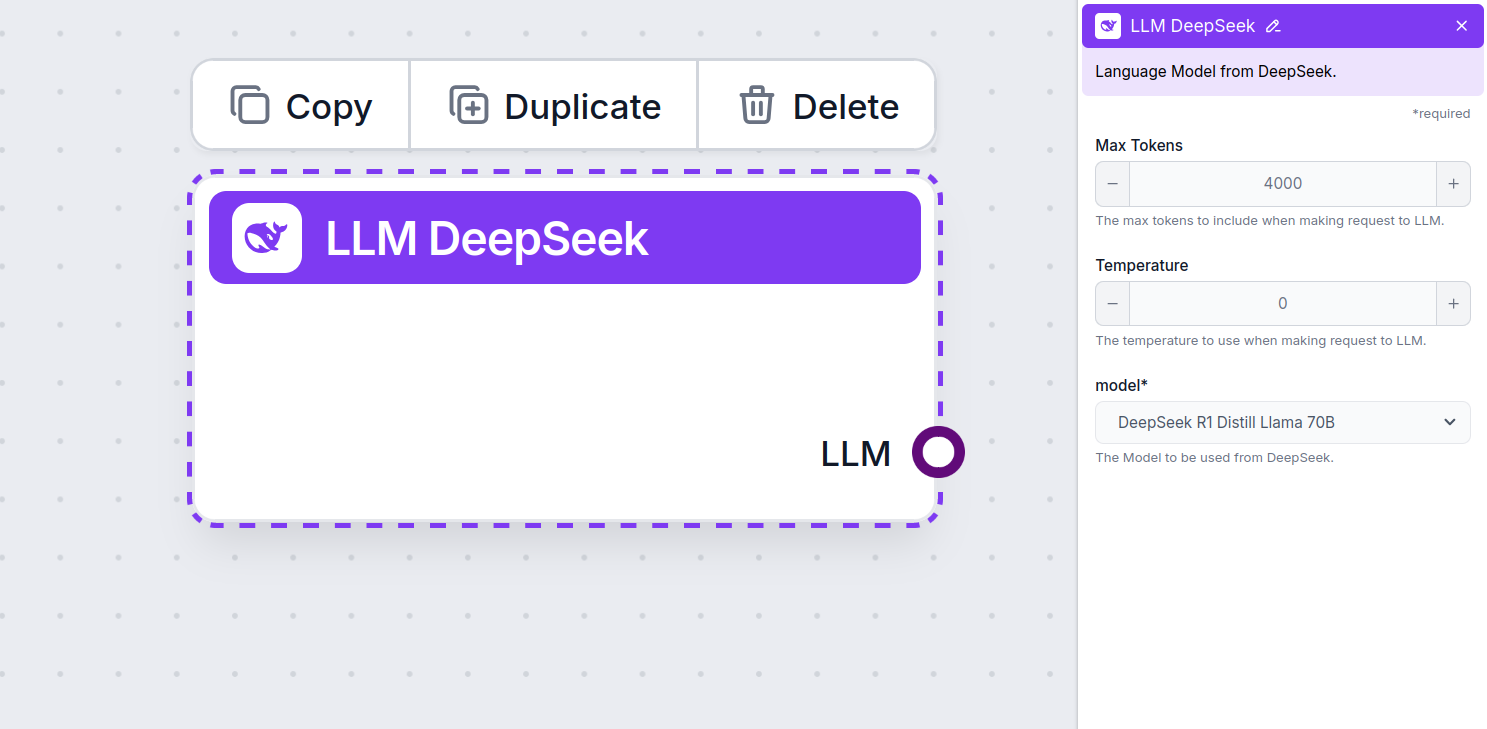

Inställningen för max tokens begränsar det totala antalet tokens som kan behandlas vid en enskild interaktion eller förfrågan, vilket säkerställer att svaren genereras inom rimliga gränser. Standardgränsen är 4 000 tokens, vilket är optimal storlek för att sammanfatta dokument och flera källor för att generera ett svar.

Temperatur styr variationsgraden i svaren och går från 0 till 1.

En temperatur på 0,1 gör svaren väldigt raka på sak men kan leda till upprepningar och brist på variation.

En hög temperatur på 1 tillåter maximal kreativitet i svaren men innebär risk för irrelevanta eller till och med “hallucinerande” svar.

Till exempel rekommenderas en temperatur mellan 0,2 och 0,5 för en kundtjänstbot. Den nivån håller svaren relevanta och efter manus men tillåter naturlig variation.

Detta är modellväljaren. Här hittar du alla stödda DeepSeek-modeller. Vi stöder alla de senaste Gemini-modellerna:

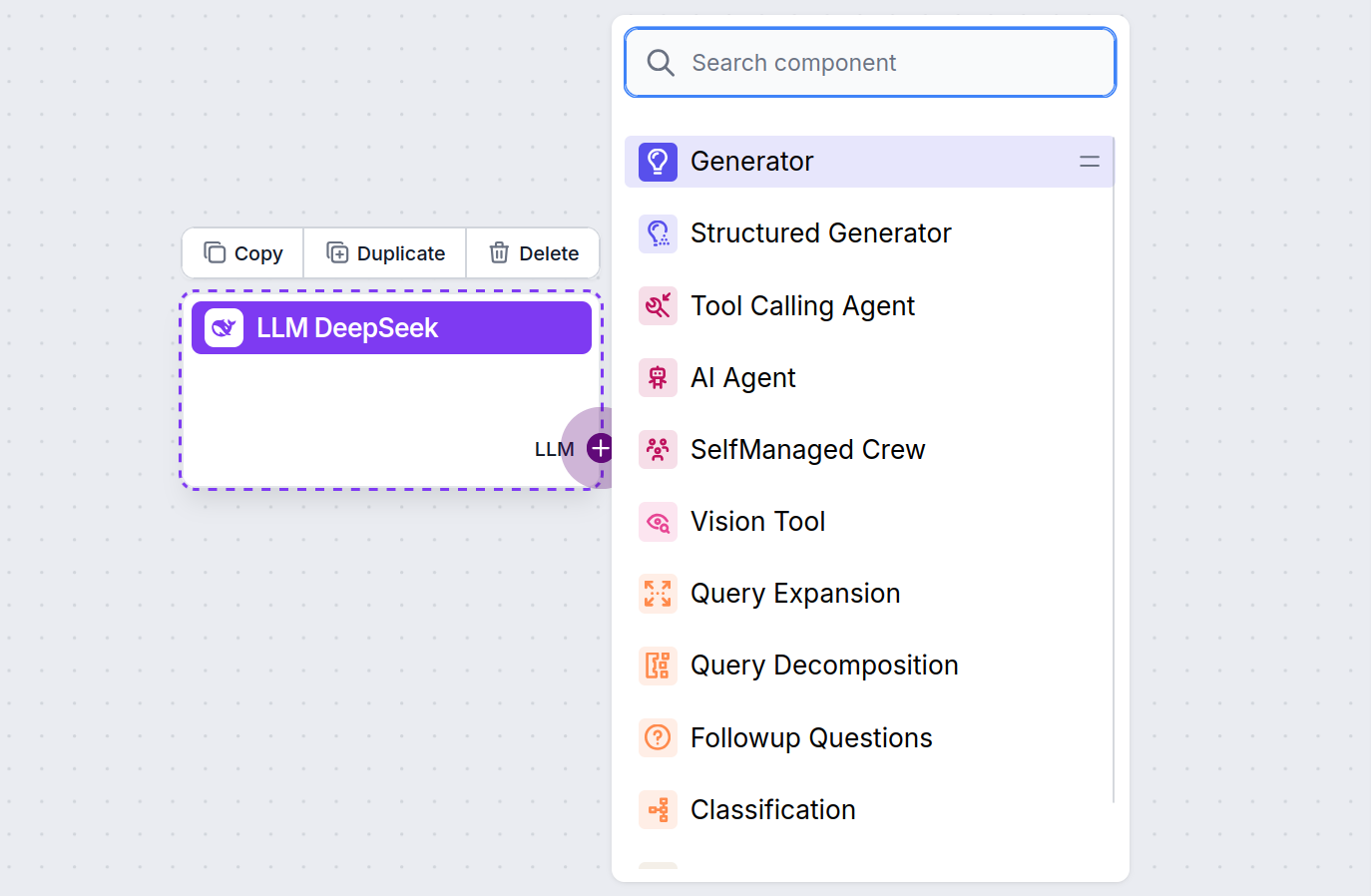

Du kommer att märka att alla LLM-komponenter endast har ett utgångshandtag. Ingång passerar inte genom komponenten, då den endast representerar modellen, medan själva genereringen sker i AI-agenter och Generatorer.

LLM-handtaget är alltid lila. LLM-ingångshandtaget finns på alla komponenter som använder AI för att generera text eller bearbeta data. Du ser alternativen genom att klicka på handtaget:

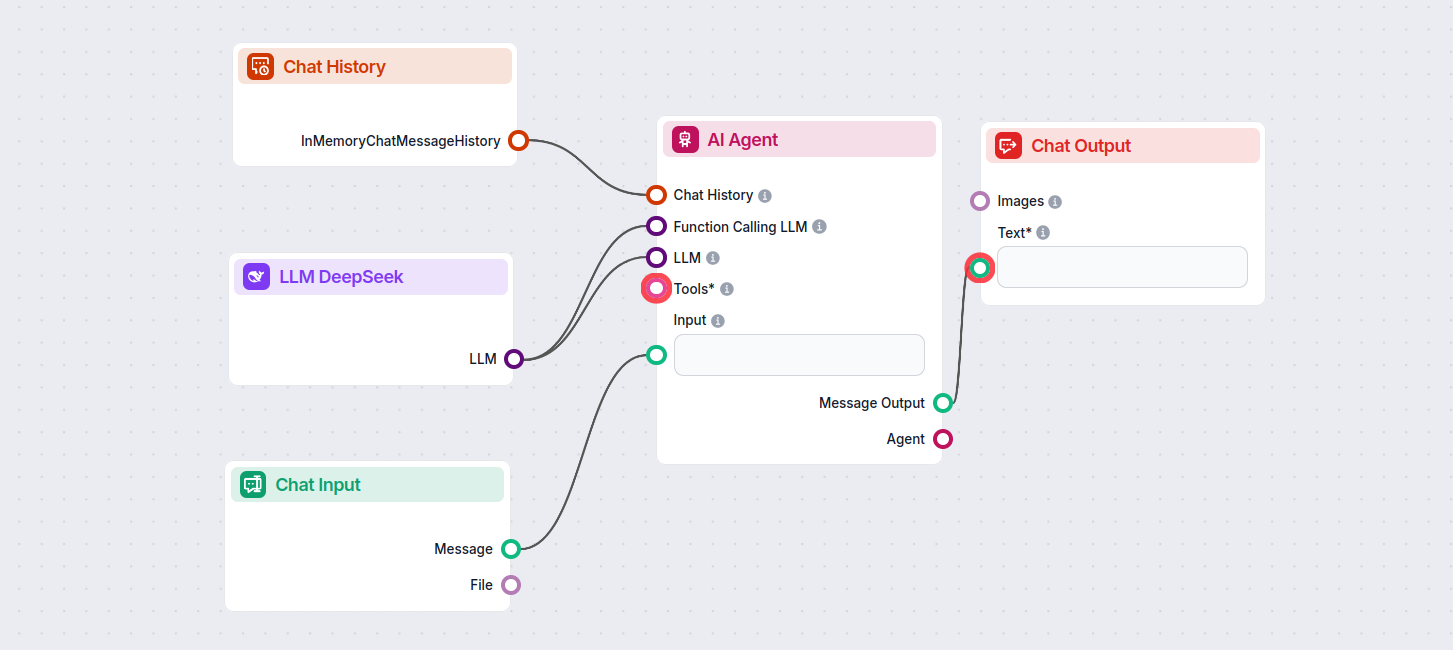

Detta låter dig skapa alla möjliga verktyg. Låt oss se komponenten i aktion. Här är ett enkelt AI-agent chatbotflöde som använder DeepSeek R1 för att generera svar. Du kan se det som en grundläggande DeepSeek-chatbot.

Detta enkla chatbotflöde innehåller:

LLM DeepSeek är en komponent i FlowHunt som låter dig koppla och styra DeepSeek AI-modeller för text- och bildgenerering, vilket möjliggör kraftfulla chatbottar och automatiserade flöden.

FlowHunt stöder alla de senaste DeepSeek-modellerna, inklusive DeepSeek R1, känd för sin hastighet och prestanda, särskilt jämfört med andra ledande AI-modeller.

Du kan justera maxantalet tokens för svarslängd och temperatur för svarens kreativitet, samt byta mellan tillgängliga DeepSeek-modeller direkt i din FlowHunt-panel.

Nej, att koppla en LLM-komponent är valfritt. Som standard använder FlowHunt ChatGPT-4o, men om du lägger till LLM DeepSeek kan du byta och styra vilken AI-modell som driver dina flöden.

Börja bygga smartare AI-chatbottar och automatiseringsverktyg med avancerade DeepSeek-modeller—helt utan krånglig installation eller flera prenumerationer.

FlowHunt stöder dussintals AI-modeller, inklusive Google Gemini. Lär dig hur du använder Gemini i dina AI-verktyg och chattbotar, växla mellan modeller och kont...

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från xAI. Här är hur du använder xAI-modellerna i dina AI-verktyg och chatbots.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive Metas Llama-modeller. Lär dig hur du integrerar Llama i dina AI-verktyg och chatbots, anpassar ins...