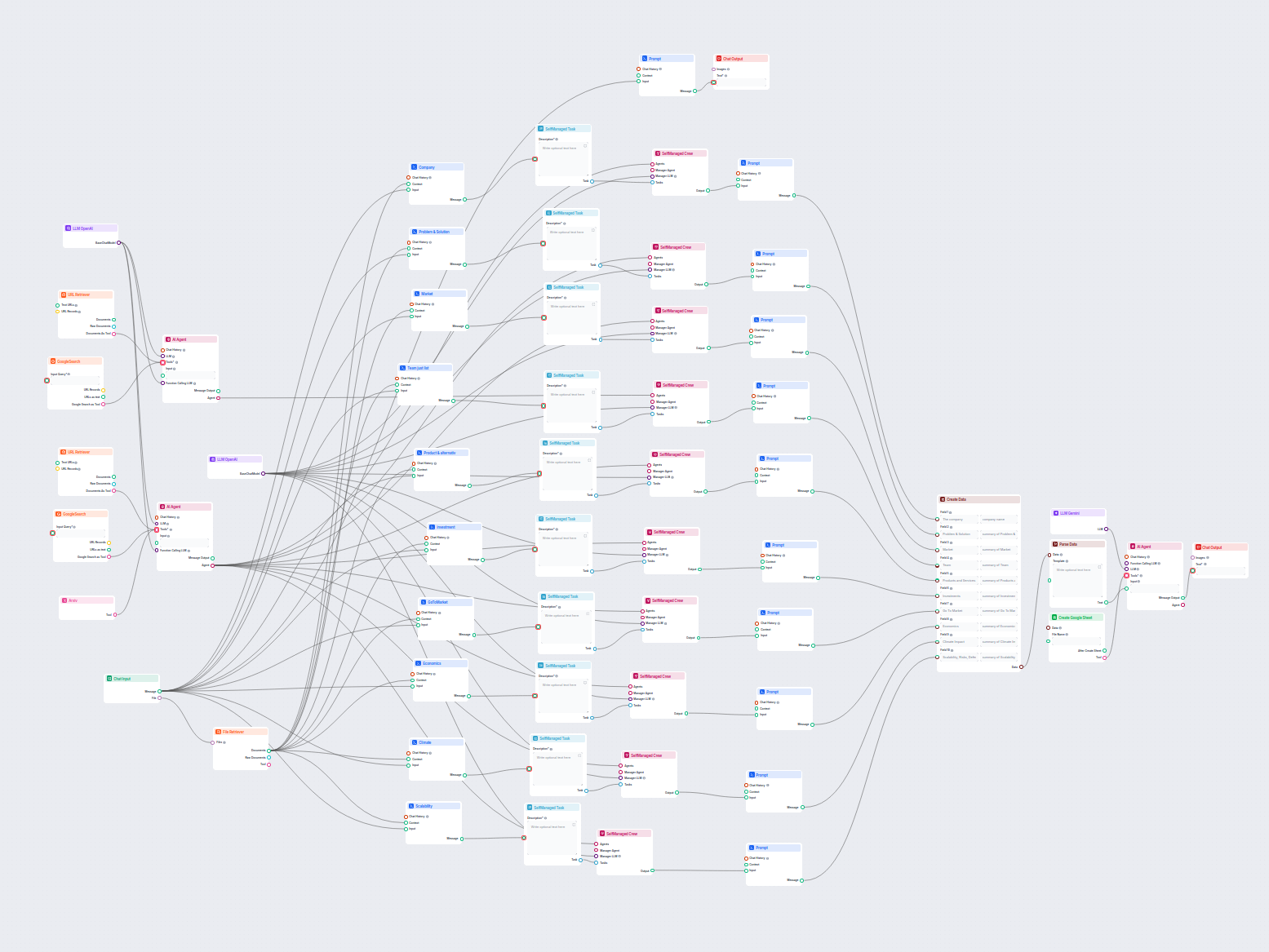

AI-driven företagsanalys och export till Google Sheets

Detta AI-arbetsflöde analyserar vilket företag som helst på djupet genom att undersöka offentliga data och dokument, och täcker marknad, team, produkter, invest...

Lås upp kraften i Googles Gemini-modeller i FlowHunt—växla AI-modeller, styr inställningar och bygg smartare AI-chattbotar enkelt.

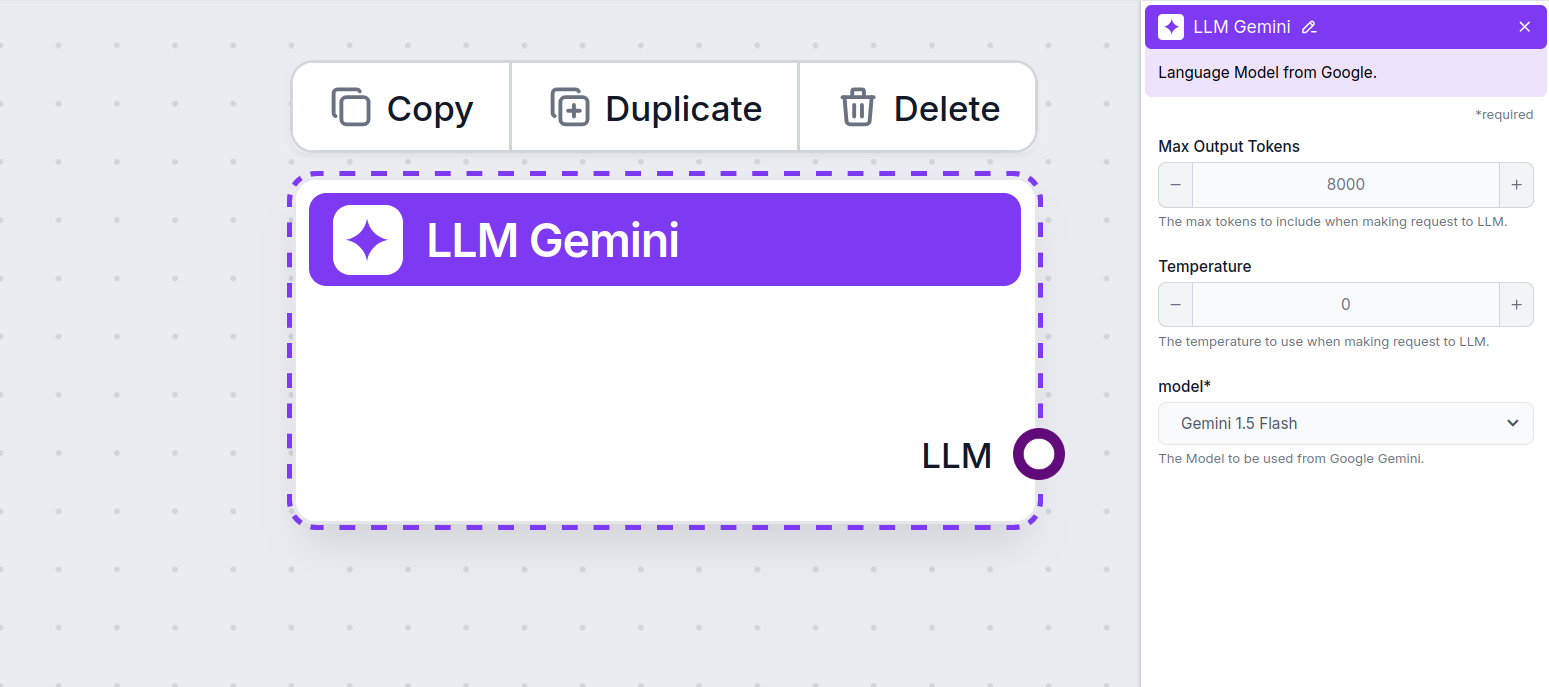

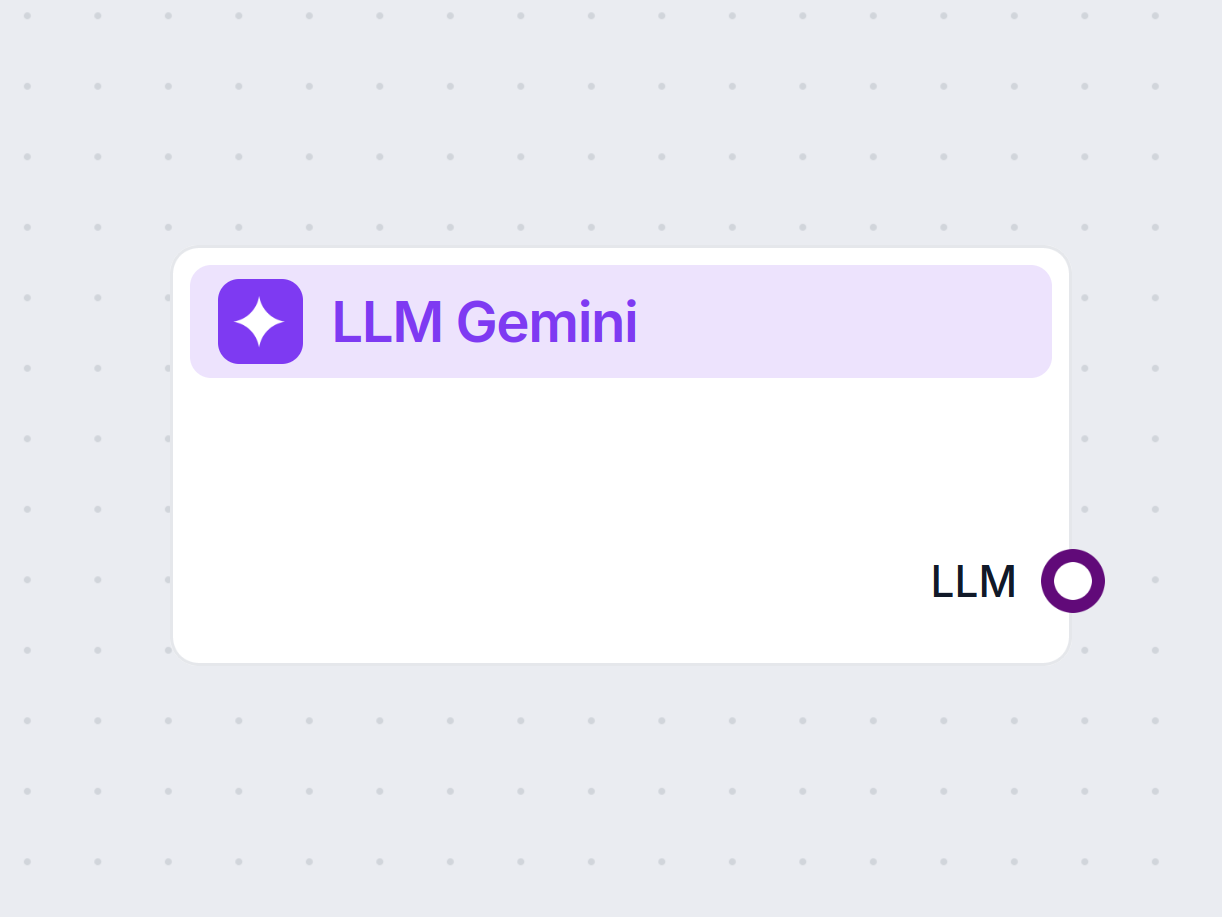

Komponentbeskrivning

LLM Gemini-komponenten kopplar samman Gemini-modellerna från Google med ditt flöde. Medan Generatorer och Agenter är där den verkliga magin sker, tillåter LLM-komponenter dig att kontrollera vilken modell som används. Alla komponenter har ChatGPT-4 som standard. Du kan ansluta denna komponent om du vill byta modell eller få mer kontroll över den.

Kom ihåg att anslutning av en LLM-komponent är valfritt. Alla komponenter som använder en LLM har ChatGPT-4o som standard. LLM-komponenterna låter dig byta modell och styra modellinställningarna.

Tokens representerar de individuella enheter av text som modellen behandlar och genererar. Tokenanvändning varierar mellan modeller, och en enskild token kan vara allt från ord eller delord till ett enda tecken. Modeller prissätts vanligtvis per miljon tokens.

Inställningen för max tokens begränsar det totala antalet tokens som kan behandlas i en enskild interaktion eller begäran, vilket säkerställer att svaren genereras inom rimliga gränser. Standardgränsen är 4 000 tokens, vilket är den optimala storleken för att sammanfatta dokument och flera källor för att generera ett svar.

Temperatur styr variationen i svaren och varierar från 0 till 1.

En temperatur på 0,1 gör svaren väldigt rakt på sak, men kan bli repetitiva och bristfälliga.

En hög temperatur på 1 tillåter maximal kreativitet i svaren men medför risken för irrelevanta eller till och med hallucinerade svar.

Till exempel rekommenderas en temperatur för en kundtjänstbot på mellan 0,2 och 0,5. Denna nivå bör hålla svaren relevanta och enligt manus, samtidigt som den tillåter naturlig variation.

Det här är modellväljaren. Här hittar du alla de Gemini-modeller från Google som stöds. Vi stöder alla de senaste Gemini-modellerna:

Du kommer att märka att alla LLM-komponenter bara har ett utgångshandtag. Ingen input passerar genom komponenten, eftersom den endast representerar modellen, medan själva genereringen sker i AI-agenter och generatorer.

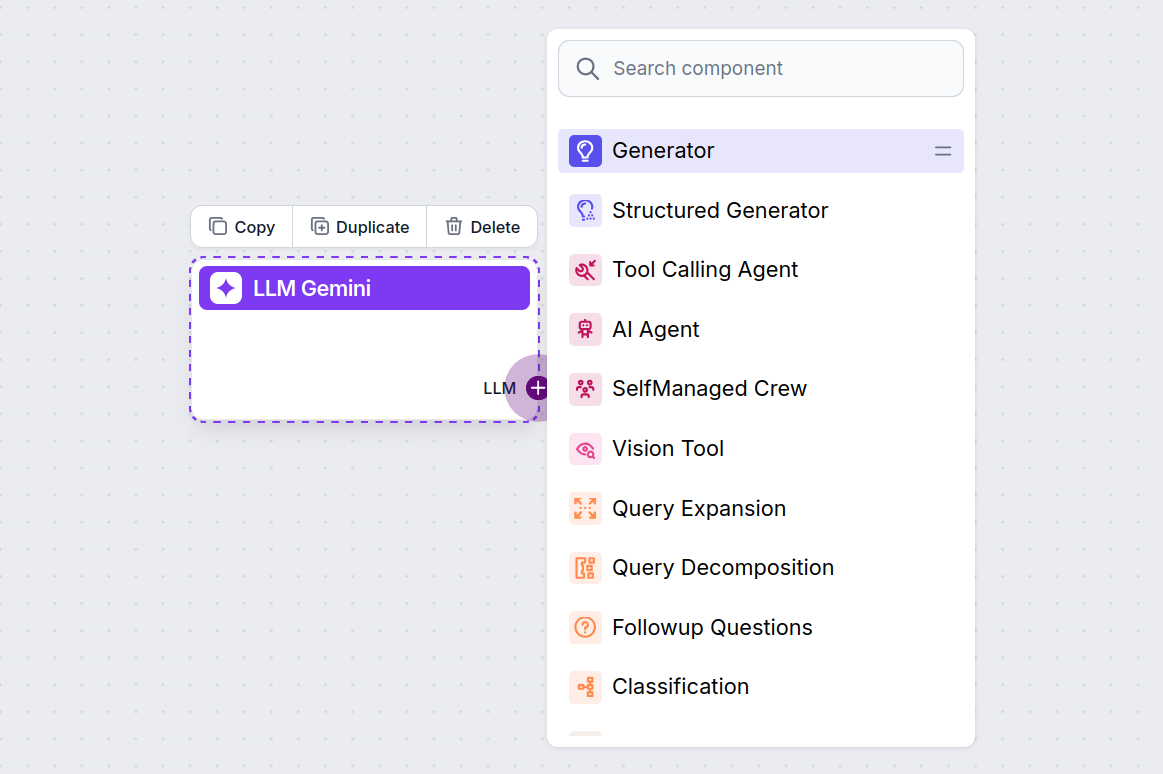

LLM-handtaget är alltid lila. LLM-input-handtaget finns på alla komponenter som använder AI för att generera text eller bearbeta data. Du kan se alternativen genom att klicka på handtaget:

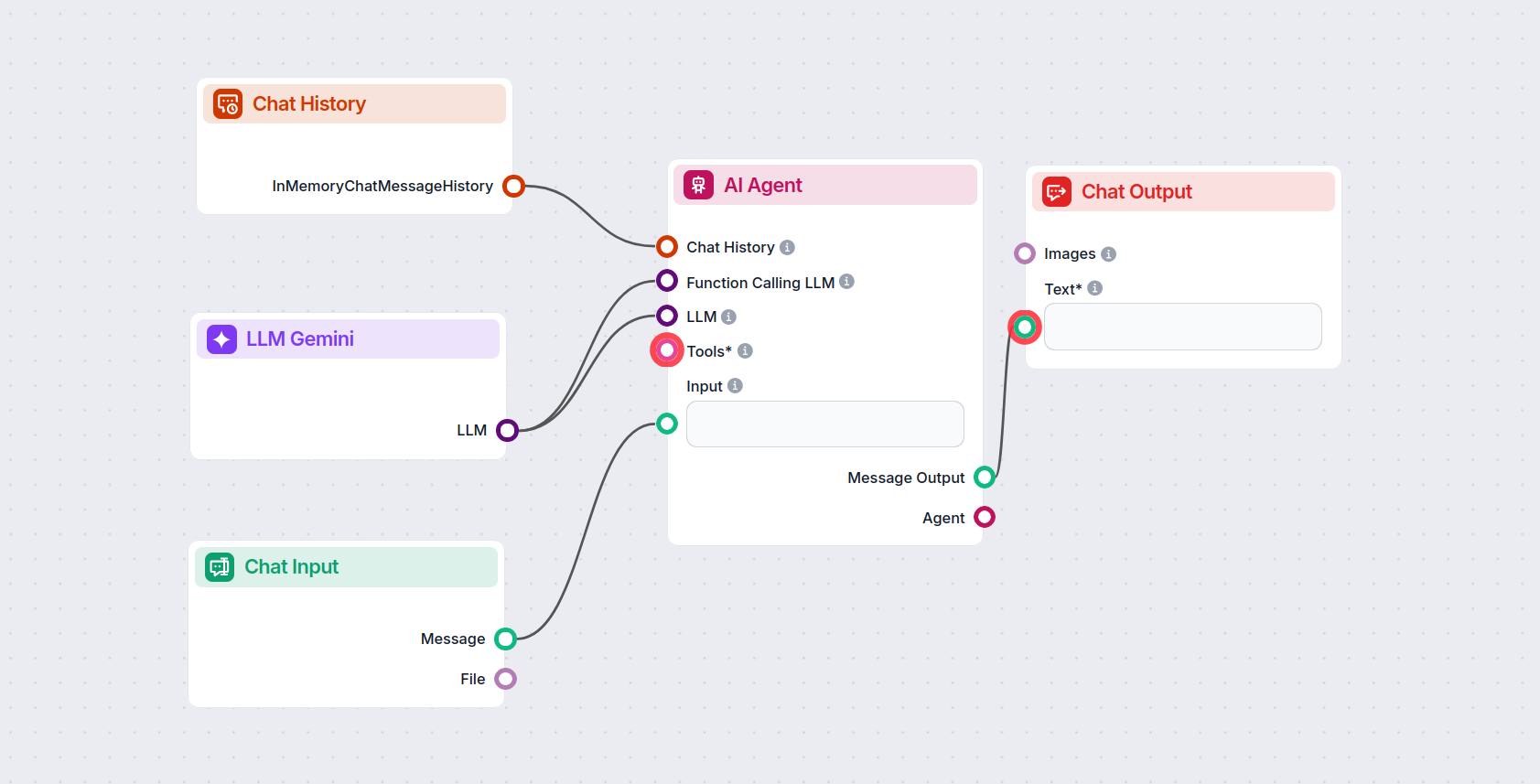

Detta låter dig skapa alla möjliga verktyg. Låt oss se komponenten i aktion. Här är ett enkelt AI Agent-chattbotflöde som använder Gemini 2.0 Flash Experimental för att generera svar. Du kan tänka på det som en grundläggande Gemini-chattbot.

Detta enkla chattbotflöde inkluderar:

För att hjälpa dig komma igång snabbt har vi förberett flera exempel på flow-mallar som demonstrerar hur du använder LLM Gemini-komponenten effektivt. Dessa mallar visar olika användningsfall och bästa praxis, vilket gör det lättare för dig att förstå och implementera komponenten i dina egna projekt.

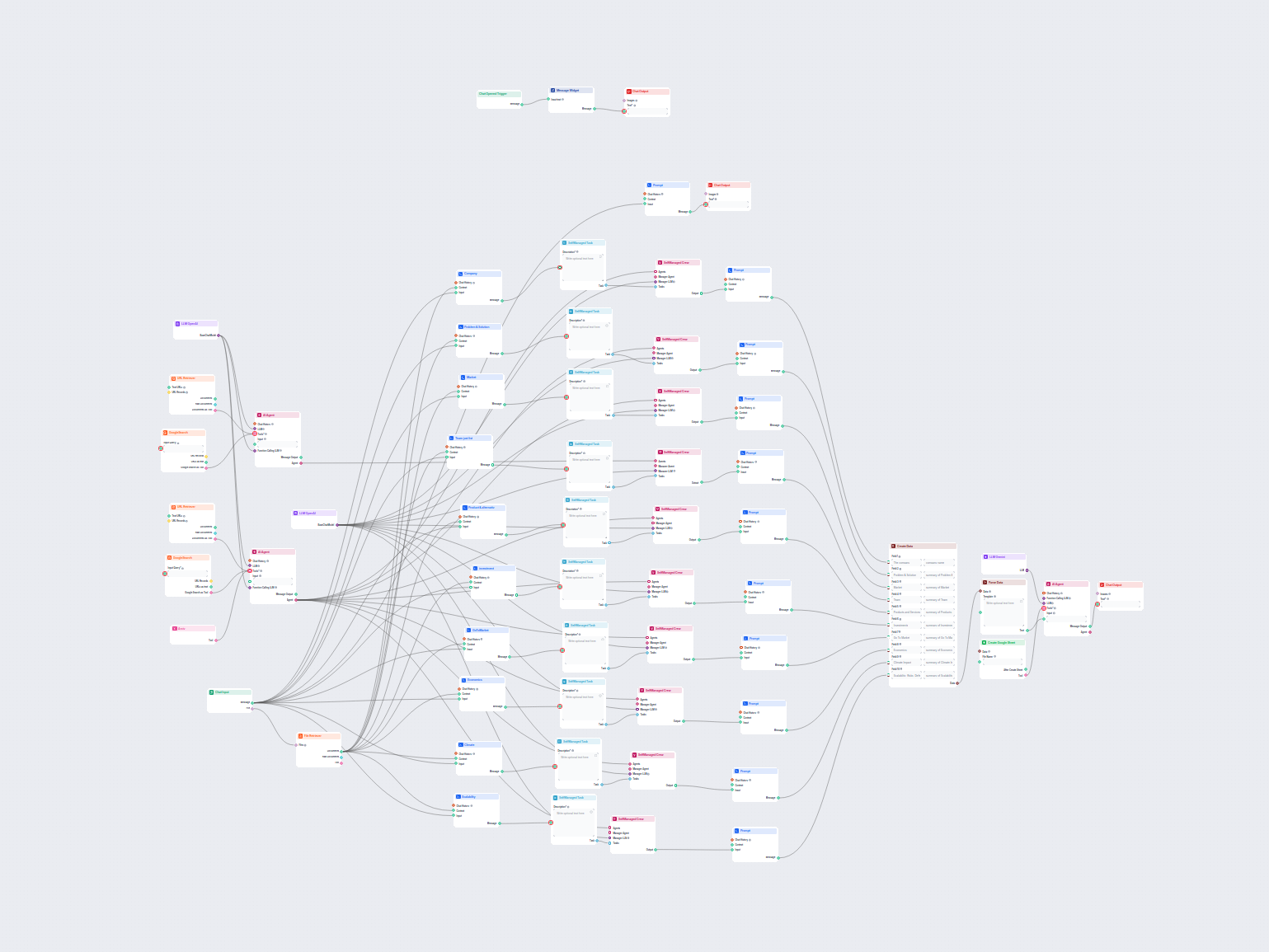

Detta AI-arbetsflöde analyserar vilket företag som helst på djupet genom att undersöka offentliga data och dokument, och täcker marknad, team, produkter, invest...

Detta AI-drivna arbetsflöde levererar en omfattande, datadriven företagsanalys. Det samlar in information om företagets bakgrund, marknadslandskap, team, produk...

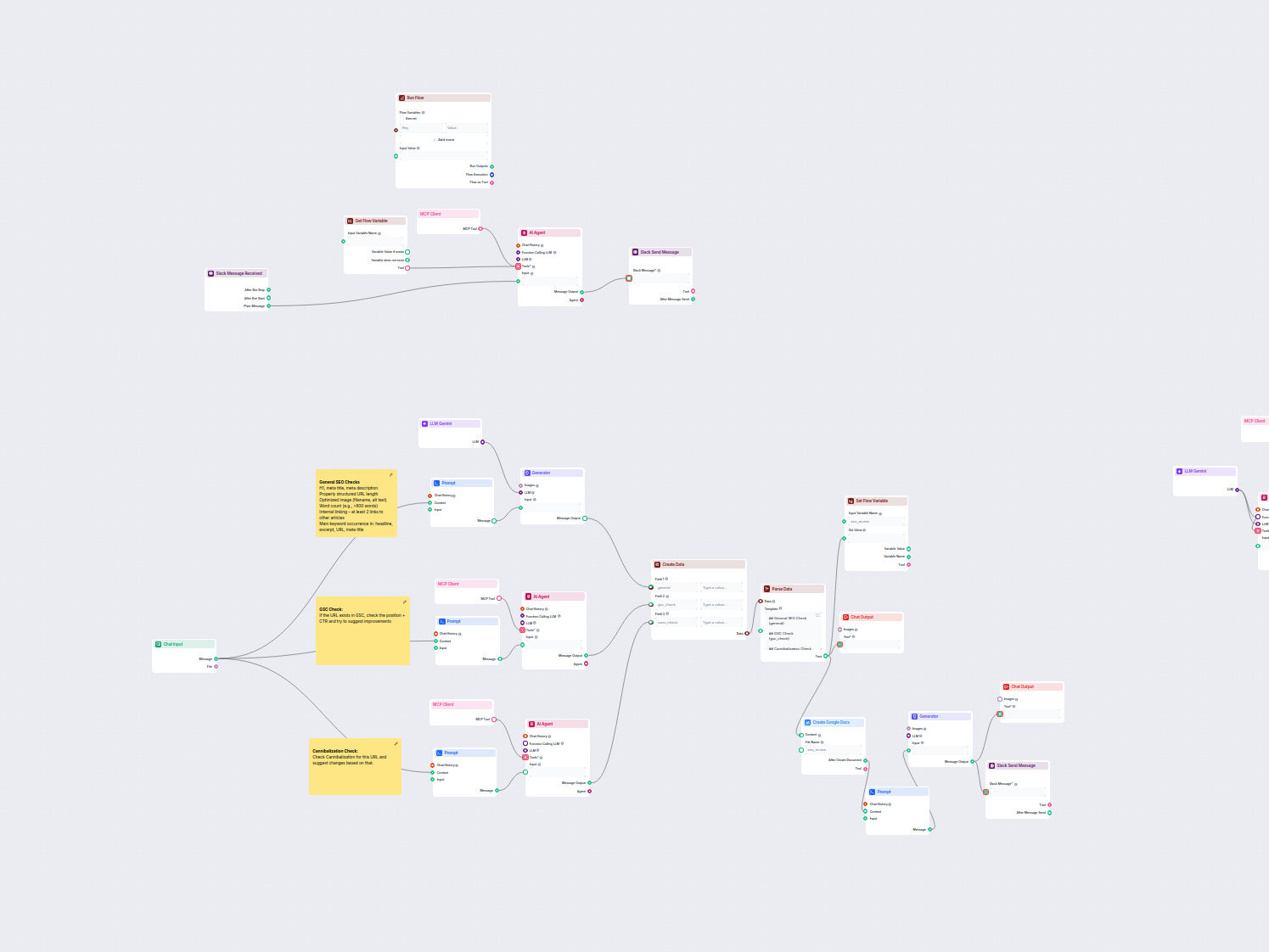

Detta arbetsflöde automatiserar SEO-granskning och revisionsprocessen för webbsidor. Det analyserar sidinnehåll enligt SEO-bästa praxis, utför kontroller i Goog...

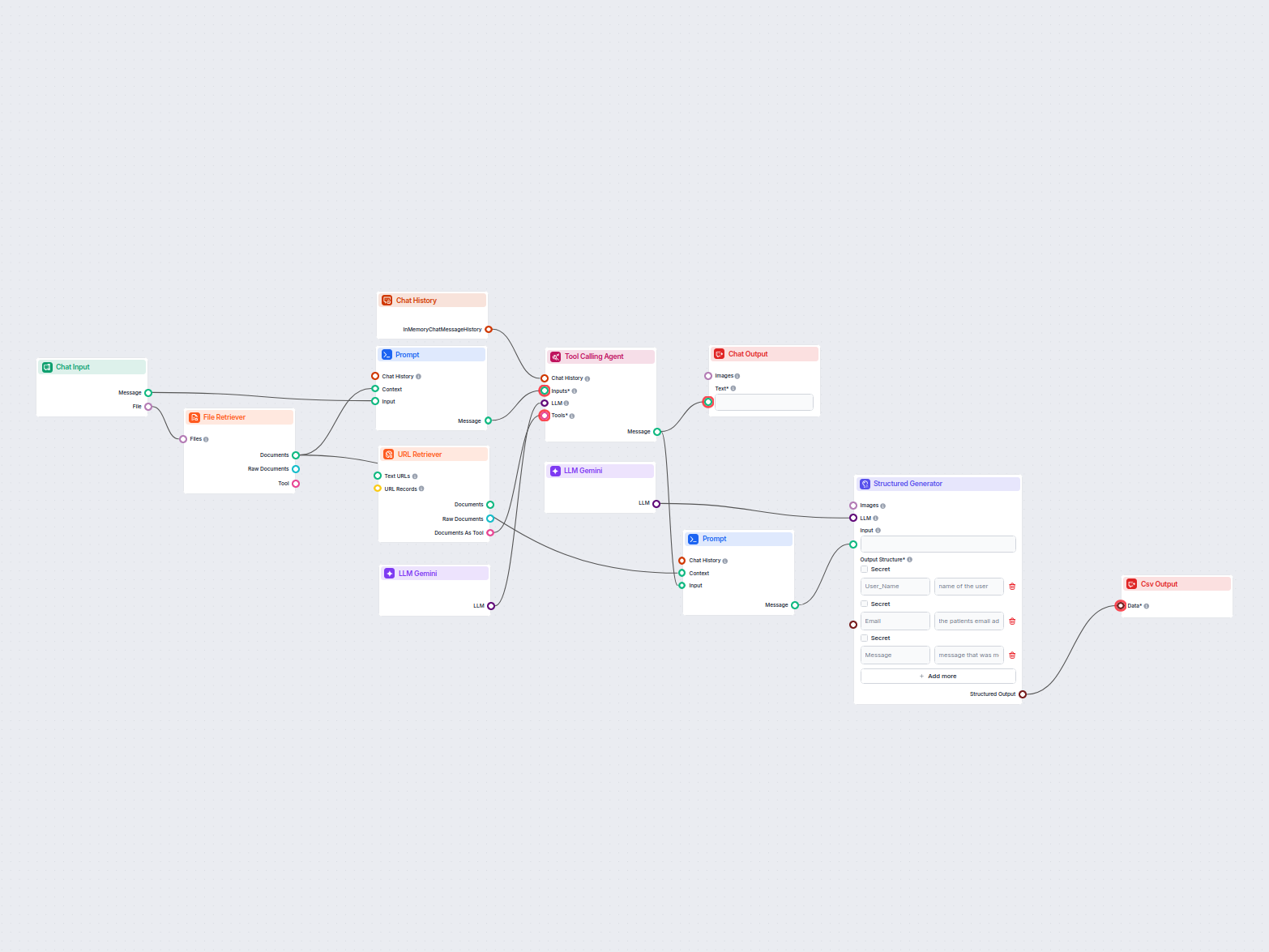

Detta arbetsflöde extraherar och organiserar nyckelinformation från e-postmeddelanden och bifogade filer, använder AI för att bearbeta och strukturera data, och...

LLM Gemini kopplar Googles Gemini-modeller till dina FlowHunt AI-flöden, så att du kan välja bland de senaste Gemini-varianterna för textgenerering och anpassa deras beteende.

FlowHunt stöder Gemini 2.0 Flash Experimental, Gemini 1.5 Flash, Gemini 1.5 Flash-8B och Gemini 1.5 Pro—alla med unika möjligheter för text-, bild-, ljud- och videoinmatning.

Max Tokens begränsar svarens längd, medan Temperatur styr kreativiteten—lägre värden ger fokuserade svar, högre värden tillåter mer variation. Båda kan ställas in per modell i FlowHunt.

Nej, användning av LLM-komponenter är valfritt. Alla AI-flöden har ChatGPT-4o som standard, men med LLM Gemini kan du växla till Google-modeller och finjustera deras inställningar.

Börja bygga avancerade AI-chattbotar och verktyg med Gemini och andra toppmodeller—allt i en och samma dashboard. Växla mellan modeller, anpassa inställningar och effektivisera dina arbetsflöden.

FlowHunt stöder dussintals AI-modeller, inklusive de banbrytande DeepSeek-modellerna. Så här använder du DeepSeek i dina AI-verktyg och chatbottar.

FlowHunt stöder dussintals AI-textmodeller, inklusive modeller från Mistral. Så här använder du Mistral i dina AI-verktyg och chattbotar.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från xAI. Här är hur du använder xAI-modellerna i dina AI-verktyg och chatbots.