LLM xAI

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från xAI. Här är hur du använder xAI-modellerna i dina AI-verktyg och chatbots.

FlowHunt’s LLM Meta AI samlar Metas Llama-modeller och dussintals andra AI-modeller i en enda, lättstyrd instrumentpanel för flexibel text- och bildgenerering.

Komponentbeskrivning

LLM Meta AI-komponenten ansluter Claude-familjen av modeller till ditt Flow. Medan generatorer och agenter är där den faktiska magin sker, låter LLM-komponenter dig styra vilken modell som används. Alla komponenter har ChatGPT-4 som standard. Du kan ansluta denna komponent om du vill byta modell eller få mer kontroll över den.

Kom ihåg att det är valfritt att ansluta en LLM-komponent. Alla komponenter som använder en LLM har ChatGPT-4o som standard. LLM-komponenterna gör det möjligt att byta modell och styra modellinställningar.

Tecken (tokens) representerar de individuella enheterna av text som modellen behandlar och genererar. Antalet tecken varierar mellan modeller, och ett tecken kan vara allt från ord eller delord till enstaka tecken. Modeller prissätts vanligen i miljoner tecken.

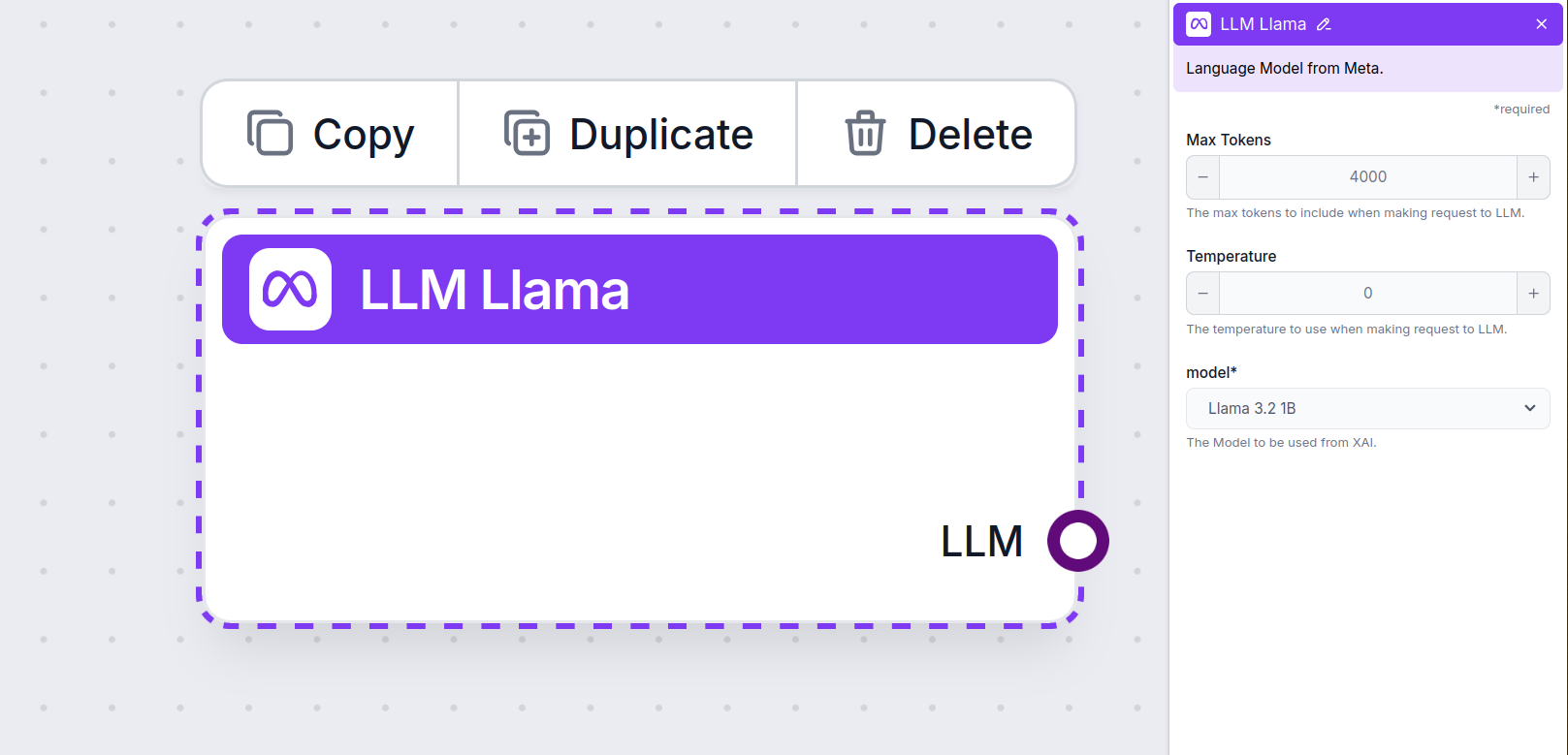

Inställningen för maxantal tecken begränsar det totala antalet tecken som kan behandlas i en enskild interaktion eller förfrågan, vilket säkerställer att svaren genereras inom rimliga gränser. Standardgränsen är 4 000 tecken, vilket är optimalt för att sammanfatta dokument och flera källor för att generera ett svar.

Temperaturen styr variationen i svaren, från 0 till 1.

En temperatur på 0,1 gör svaren mycket koncisa men potentiellt repetitiva och bristfälliga.

En hög temperatur på 1 möjliggör maximal kreativitet i svaren men innebär också en risk för irrelevanta eller till och med hallucinerade svar.

Till exempel är den rekommenderade temperaturen för en kundservicebot mellan 0,2 och 0,5. Den nivån håller svaren relevanta och enligt manus men tillåter naturlig variation.

Detta är modellväljaren. Här hittar du alla modeller från Meta AI som stöds. Vi stöder Metas öppen källkod och lättviktiga Llama-modeller. Dessa modeller är designade för effektiv drift på enheter och i edge-miljöer:

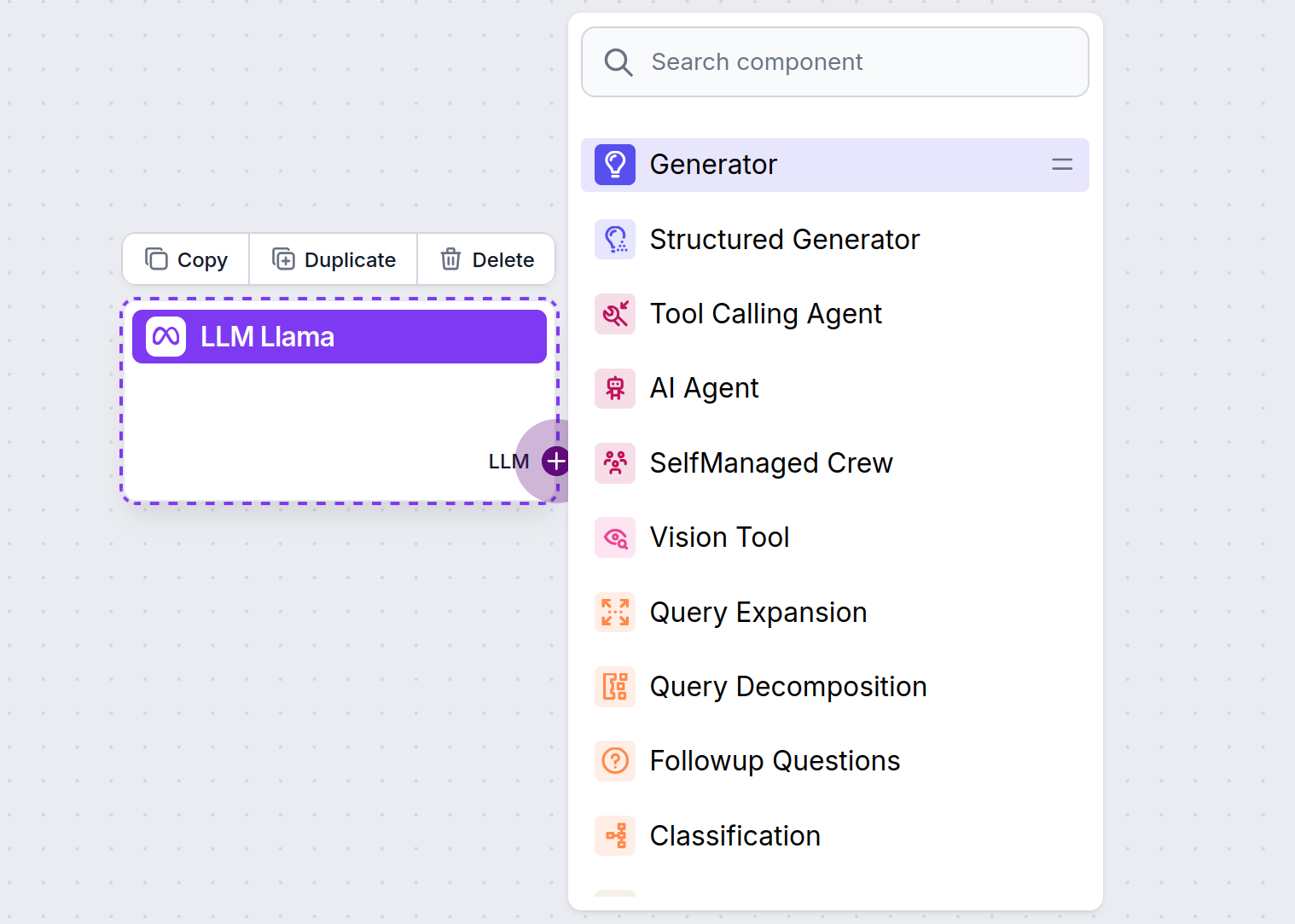

Du kommer att märka att alla LLM-komponenter endast har ett utgångshandtag. Inmatning passerar inte genom komponenten, eftersom den endast representerar modellen, medan själva genereringen sker i AI-agenter och generatorer.

LLM-handtaget är alltid lila. LLM-inmatningshandtaget finns på alla komponenter som använder AI för att generera text eller behandla data. Du ser alternativen genom att klicka på handtaget:

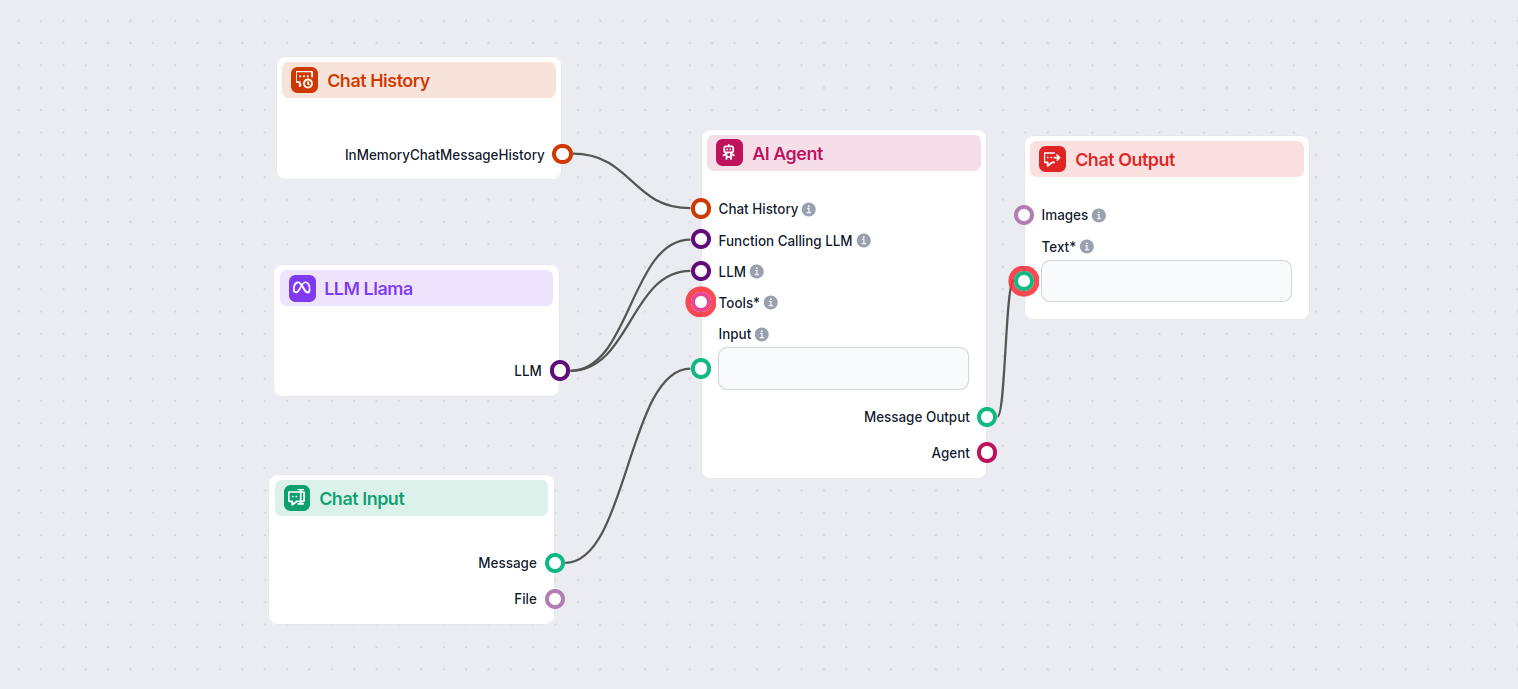

Detta gör att du kan skapa alla möjliga typer av verktyg. Låt oss se komponenten i aktion. Här är ett enkelt AI Agent chatbot-flow som använder Meta AI:s Llama 3.2 1B för att generera svar. Du kan tänka på det som en grundläggande Llama-chatbot.

Detta enkla chatbot-flow består av:

LLM Meta AI-komponenten låter dig ansluta Metas Llama-modeller och andra text-/bildgeneratorer till dina flöden, vilket möjliggör enkel modellval och avancerad konfiguration som maxantal tecken och temperatur.

FlowHunt stöder Metas öppen källkods Llama-modeller, inklusive Llama 3.2 1B och 3B, optimerade för effektivitet, sammanfattning och lokala distributioner.

Du kan justera inställningar som maxantal tecken (begränsar svarsxadlängd), temperatur (styr svarens kreativitet) och modellval direkt från FlowHunt-instrumentpanelen för varje komponent.

Nej, det är valfritt att lägga till LLM Meta AI-komponenten. Som standard används ChatGPT-4o, men du kan byta till Llama eller andra modeller för mer kontroll eller särskilda användningsfall.

Börja bygga smartare chatbots och AI-verktyg med Metas Llama-modeller och dussintals andra AI-generatorer, allt på en plattform.

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från xAI. Här är hur du använder xAI-modellerna i dina AI-verktyg och chatbots.

FlowHunt stöder dussintals AI-textmodeller, inklusive modeller från Mistral. Så här använder du Mistral i dina AI-verktyg och chattbotar.

FlowHunt stödjer dussintals AI-modeller, inklusive Claude-modeller från Anthropic. Lär dig hur du använder Claude i dina AI-verktyg och chatbots med anpassnings...