Neurala nätverk

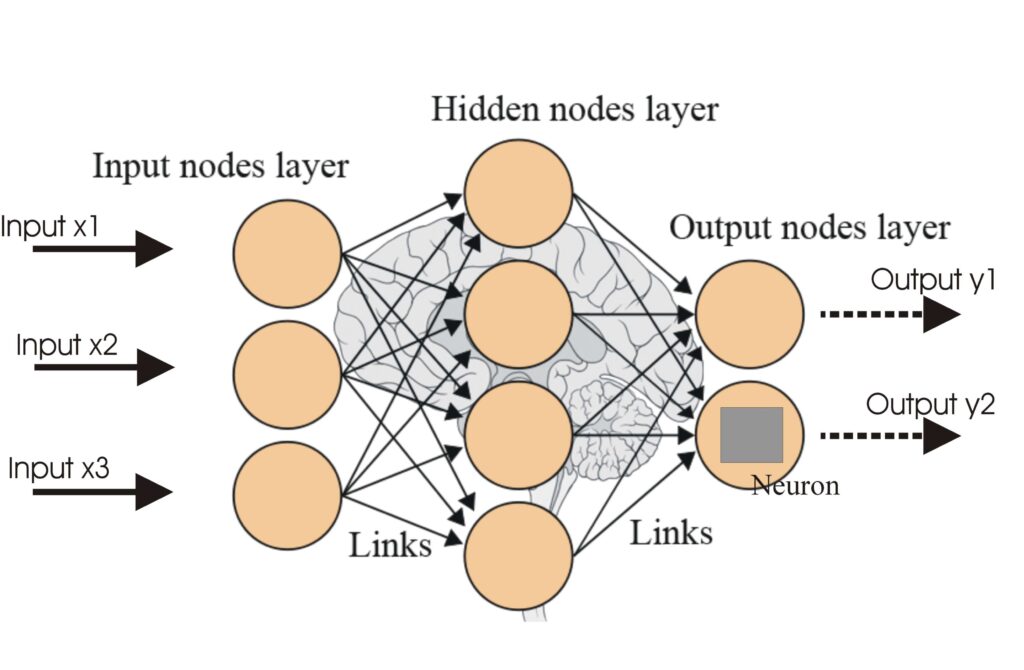

Ett neuralt nätverk, eller artificiellt neuralt nätverk (ANN), är en beräkningsmodell inspirerad av den mänskliga hjärnan, avgörande inom AI och maskininlärning...

Aktiveringsfunktioner introducerar icke-linjäritet i neurala nätverk och gör det möjligt för dem att lära sig komplexa mönster som är avgörande för AI- och djupinlärningsapplikationer.

Aktiveringsfunktioner är grundläggande för arkitekturen hos artificiella neurala nätverk (ANNs) och påverkar avsevärt nätverkets förmåga att lära sig och utföra komplexa uppgifter. Denna ordlistaartikel fördjupar sig i aktiveringsfunktionernas komplexitet, undersöker deras syfte, typer och tillämpningar, särskilt inom AI, djupinlärning och neurala nätverk.

En aktiveringsfunktion i ett neuralt nätverk är en matematisk operation som tillämpas på en neurons utdata. Den avgör om en neuron ska aktiveras eller inte och introducerar icke-linjäritet i modellen, vilket gör det möjligt för nätverket att lära sig komplexa mönster. Utan dessa funktioner skulle ett neuralt nätverk i praktiken fungera som en linjär regressionsmodell, oavsett dess djup eller antal lager.

Sigmoidfunktion

Tanh-funktion

ReLU (Rectified Linear Unit)

Leaky ReLU

Softmaxfunktion

Swish-funktion

Aktiveringsfunktioner är avgörande för olika AI-tillämpningar, inklusive:

En aktiveringsfunktion är en matematisk operation som tillämpas på utdata från en neuron, vilket introducerar icke-linjäritet och möjliggör för neurala nätverk att lära sig komplexa mönster utöver enkla linjära samband.

Aktiveringsfunktioner gör det möjligt för neurala nätverk att lösa komplexa, icke-linjära problem genom att möjliggöra inlärning av intrikata mönster, vilket gör dem avgörande för uppgifter som bildklassificering, språkbehandling och automatisering.

Vanliga typer inkluderar Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax och Swish, som alla har unika egenskaper och användningsområden i olika lager av neurala nätverk.

Vanliga utmaningar är bland annat problemet med försvinnande gradient (särskilt med Sigmoid och Tanh), döende ReLU och hög beräkningskostnad för funktioner som Softmax i realtidsapplikationer.

Smarta chattbottar och AI-verktyg samlade på ett ställe. Koppla ihop intuitiva block för att förvandla dina idéer till automatiserade Flows.

Ett neuralt nätverk, eller artificiellt neuralt nätverk (ANN), är en beräkningsmodell inspirerad av den mänskliga hjärnan, avgörande inom AI och maskininlärning...

Artificiella neurala nätverk (ANNs) är en undergrupp av maskininlärningsalgoritmer som är modellerade efter den mänskliga hjärnan. Dessa beräkningsmodeller best...

Funktionsutvinning omvandlar rådata till en reducerad uppsättning informativa funktioner, vilket förbättrar maskininlärning genom att förenkla data, öka modelle...