Frågebesvarande system

Frågebesvarande system med Retrieval-Augmented Generation (RAG) kombinerar informationssökning och naturlig språkxadgenerering för att förbättra stora språkmode...

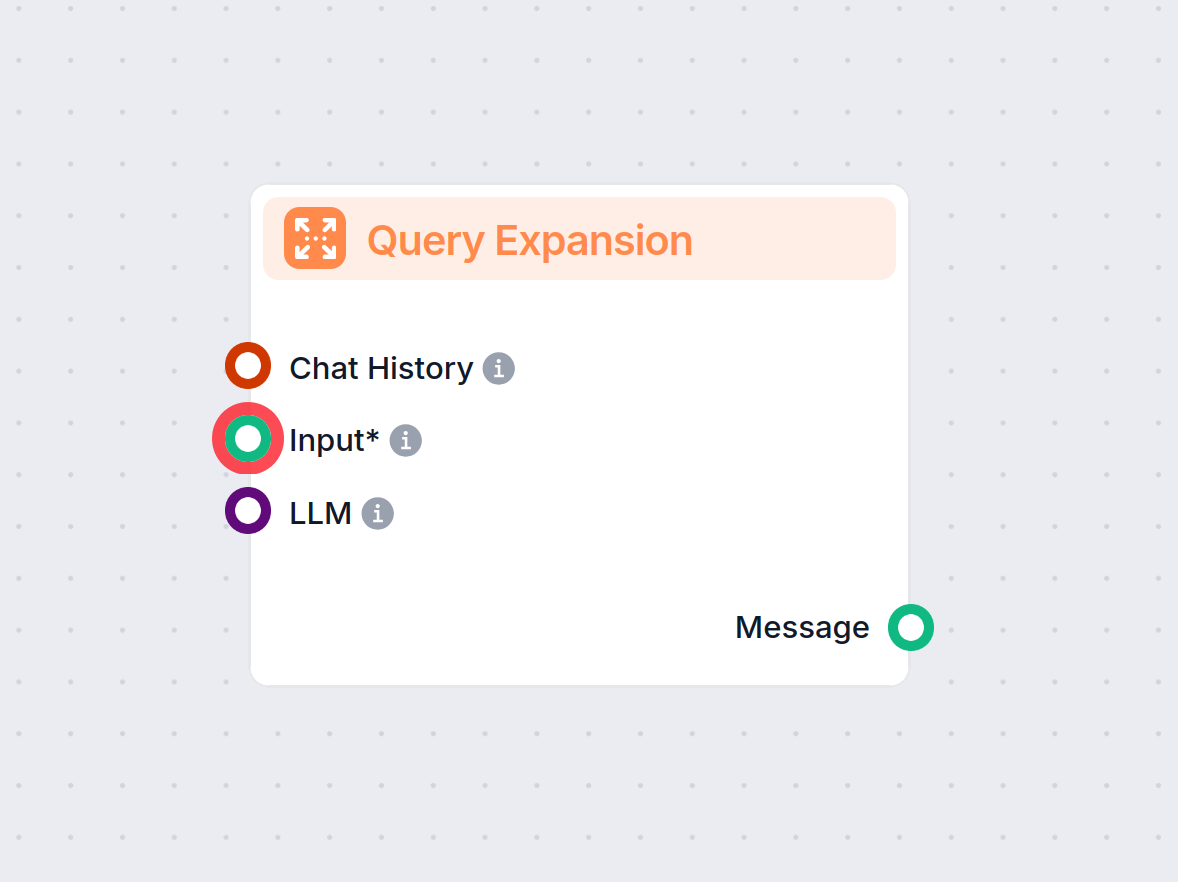

Frågeexpansion berikar användarfrågor med ytterligare kontext eller termer, vilket ökar träffsäkerheten och svarskvaliteten i AI-system som RAG och chattbotar.

Frågeexpansion förbättrar användarfrågor genom att lägga till termer eller kontext, vilket förbättrar dokumentåtervinningen för mer exakta svar. I RAG-system ökar det recall och relevans, och hjälper chattbotar och AI att ge precisa svar genom att effektivt hantera vaga eller synonymfrågor.

Frågeexpansion avser processen att förbättra en användares ursprungliga fråga genom att lägga till ytterligare termer eller kontext innan den skickas till återvinningsmekanismen. Denna utökning hjälper till att hämta mer relevanta dokument eller informationsdelar, som sedan används för att generera ett mer precist och kontextuellt lämpligt svar. Om dokument söks med alternativa frågor och sedan omrankas, blir RAG-processen avsevärt mer precis med dokumentresultat i promptens kontextfönster.

Retrieval-Augmented Generation (RAG) är en AI-arkitektur som kombinerar återvinningsmekanismer med generativa modeller för att producera mer exakta och kontextuellt relevanta svar. I RAG-system hämtar en återvinningskomponent relevanta dokument eller datadelar från en kunskapsbas baserat på en användarfråga. Därefter använder en generativ modell (ofta en Large Language Model eller LLM) denna hämtade information för att generera ett sammanhängande och informativt svar.

I RAG-system beror kvaliteten på det genererade svaret starkt på relevansen hos de hämtade dokumenten. Om återvinningskomponenten misslyckas med att hämta den mest relevanta informationen kan den generativa modellen generera suboptimala eller irrelevanta svar. Frågeexpansion adresserar denna utmaning genom att förbättra den initiala frågan, vilket ökar chansen att hämta alla relevanta dokument.

Genom att utöka den ursprungliga frågan med relaterade termer, synonymer eller omformuleringar breddar frågeexpansion sökutrymmet. Detta ökar återvinningssystemets recall, vilket innebär att det fångar en större andel relevanta dokument från kunskapsbasen. Högre recall leder till mer omfattande kontext för den generativa modellen och förbättrar den övergripande kvaliteten på RAG-systemets output.

LLM som GPT-4 kan generera semantiskt liknande frågor eller omformuleringar av den ursprungliga frågan. Genom att förstå kontext och språkliga nyanser kan LLM skapa högkvalitativa expansioner som fångar olika sätt samma fråga kan ställas på.

Exempel:

I detta tillvägagångssätt genererar systemet ett hypotetiskt svar på användarens fråga med hjälp av en LLM. Det hypotetiska svaret läggs sedan till den ursprungliga frågan för att ge mer kontext vid återvinningen.

Process:

Exempel:

Denna metod innebär att man genererar flera alternativa frågor som fångar olika formuleringar eller aspekter av den ursprungliga frågan. Varje fråga används oberoende för att hämta dokument.

Process:

Exempel:

Scenario:

Ett AI-system är utformat för att besvara frågor baserat på ett företags årsredovisning. En användare frågar: ”Förekom det betydande omsättning i ledningsgruppen?”

Implementering:

Fördel:

Genom att tillföra mer kontext via det hypotetiska svaret hämtar systemet information som annars kunde missats med endast ursprungsfrågan.

Scenario:

En kundsupport-chattbot hjälper användare att felsöka problem. En användare skriver: ”Mitt internet är långsamt.”

Implementering:

Fördel:

Chattboten fångar ett bredare spektrum av potentiella problem och lösningar, vilket ökar sannolikheten att lösa användarens problem effektivt.

Scenario:

En student använder en AI-assistent för att hitta resurser om ett ämne: ”Effekter av sömnbrist på kognitiv funktion.”

Implementering:

Fördel:

Studenten får omfattande information som täcker olika aspekter av ämnet, vilket underlättar grundligare forskning.

Att lägga till för många utökade frågor kan införa irrelevanta dokument, vilket minskar precisionen vid återvinningen.

Åtgärd:

Ord med flera betydelser kan leda till irrelevanta expansioner.

Åtgärd:

Att generera och bearbeta flera utökade frågor kan vara resurskrävande.

Åtgärd:

Säkerställa att de utökade frågorna fungerar effektivt med befintliga återvinningsalgoritmer.

Åtgärd:

Tilldela vikter till termer i de utökade frågorna för att återspegla deras betydelse.

Efter återvinning omrankas dokumenten för att prioritera relevans.

Exempel:

Att använda en cross-encoder efter återvinning för att poängsätta och omrankra dokument baserat på deras relevans för ursprungsfrågan.

Inkorporera användarinteraktioner för att förbättra frågeexpansionen.

Att använda AI och LLM för frågeexpansion drar nytta av avancerad språkförståelse för att förbättra återvinningen. Detta gör det möjligt för AI-system, inklusive chattbotar och virtuella assistenter, att ge mer exakta och kontextuellt lämpliga svar.

Att automatisera frågeexpansionsprocessen minskar bördan för användarna att formulera exakta frågor. AI-automation hanterar komplexiteten bakom kulisserna, vilket ökar effektiviteten i informationsåtervinningssystemen.

Chattbotar gynnas av frågeexpansion genom att bättre förstå användaravsikter, särskilt när användare använder vardagligt språk eller ofullständiga fraser. Detta leder till mer tillfredsställande interaktioner och effektiv problemlösning.

Exempel:

En chattbot som hjälper till med teknisk support kan tolka en användares vaga fråga som ”Min app fungerar inte” genom att expandera den till ”applikationskrascher”, ”programvara svarar inte” och ”appfelmeddelanden”, vilket leder till snabbare lösning.

Forskning om frågeexpansion för RAG

Improving Retrieval for RAG based Question Answering in question answering, enhancing accuracy with real-time data. Discover more!") Models on Financial Documents

Denna artikel undersöker effektiviteten hos stora språkmodeller (LLM) förbättrade med Retrieval-Augmented Generation (RAG), särskilt i finansiella dokument. Den identifierar att felaktigheter i LLM-utdata ofta beror på suboptimal återvinning av textavsnitt snarare än modellerna själva. Studien föreslår förbättringar i RAG-processer, inklusive sofistikerade chunking-tekniker och frågeexpansion, tillsammans med metadata-annoteringar och omrankningsalgoritmer. Dessa metoder syftar till att förfina textåtervinningen och därmed förbättra LLM-prestanda för att generera exakta svar. Läs mer

Enhancing Retrieval and Managing Retrieval: A Four-Module Synergy for Improved Quality and Efficiency in RAG Systems

Artikeln introducerar ett modulärt tillvägagångssätt för att förbättra RAG-system, med fokus på Query Rewriter-modulen, som skapar sökvänliga frågor för att förbättra kunskapsåtervinningen. Den adresserar problem med informationsplatåer och tvetydighet i frågor genom att generera flera frågor. Dessutom föreslås Knowledge Filter och Memory Knowledge Reservoir för att hantera irrelevant kunskap och optimera återvinningsresurser. Dessa framsteg syftar till att öka svarskvalitet och effektivitet i RAG-system, vilket validerats genom experiment på QA-datamängder. Ta del av koden och mer information.

MultiHop-RAG: Benchmarking Retrieval-Augmented Generation for Multi-Hop Queries

Denna forskning belyser utmaningar i befintliga RAG-system vid hantering av multi-hop-frågor, som kräver resonemang över flera informationsbitar. Den introducerar en ny datamängd specifikt utformad för att benchmarka RAG-system på multi-hop-frågor, med målet att tänja gränserna för nuvarande RAG-kapacitet. Artikeln diskuterar nödvändiga framsteg för att RAG-metoder effektivt ska hantera komplexa frågestrukturer och förbättra LLM-användning för praktiska tillämpningar.

Frågeexpansion är processen att utöka en användares ursprungliga fråga genom att lägga till relaterade termer, synonymer eller kontext, vilket hjälper återvinningssystem att hitta mer relevanta dokument och generera exakta svar, särskilt i AI-drivna applikationer.

I RAG-system (Retrieval-Augmented Generation) ökar frågeexpansion återvinningskomponentens recall genom att bredda sökutrymmet, vilket säkerställer att fler relevanta dokument tas med för att generera precisa svar.

Tekniker inkluderar att använda stora språkmodeller för att generera omformulerade frågor, hypotetisk svarsgenerering, multi-query-metoder, termviktning och att använda användarfeedback för kontinuerlig förbättring.

Frågeexpansion förbättrar recall, hanterar vaga eller tvetydiga frågor, känner igen synonymer och förbättrar användarupplevelsen genom att leverera mer exakta och informativa svar utan manuell förfining av frågan.

Ja, utmaningar inkluderar över-expansion (införande av irrelevanta dokument), tvetydighet i termer, krav på beräkningsresurser och att säkerställa kompatibilitet med återvinningsalgoritmer. Dessa kan mildras med kontrollerad generering, relevansfiltrering och effektiva modeller.

Se hur frågeexpansion kan förbättra din AI-chattbots noggrannhet och effektivisera informationsåtervinning. Upptäck FlowHunts lösningar för effektiv, automatiserad frågehantering.

Frågebesvarande system med Retrieval-Augmented Generation (RAG) kombinerar informationssökning och naturlig språkxadgenerering för att förbättra stora språkmode...

Dokumentomrangering är processen att omordna hämtade dokument utifrån deras relevans för en användares fråga, vilket förfinar sökresultaten för att prioritera d...

Frågeutvidgning i FlowHunt förbättrar chatbotens förståelse genom att hitta synonymer, rätta stavfel och säkerställa konsekventa, korrekta svar på användarfrågo...