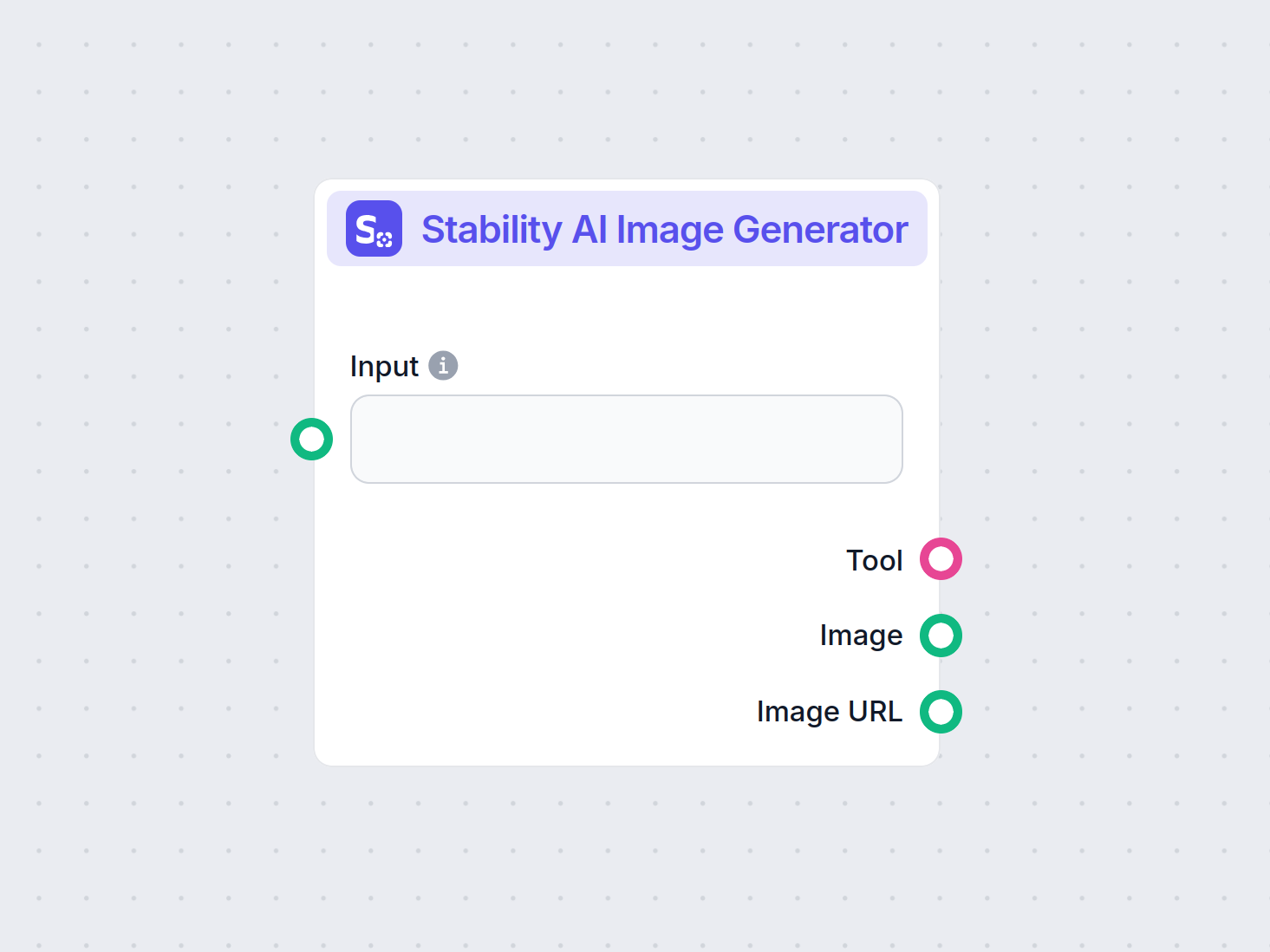

Stability AI Bildgenerator

Generera högkvalitativa bilder från textprompter med Stability AI Bildgenerator-komponenten. Drivs av Stable Diffusion-modeller och erbjuder anpassningsbara ins...

Stable Diffusion är en ledande text-till-bild AI-modell som gör det möjligt för användare att skapa fotorealistiska bilder från instruktioner med avancerad latent diffusion och djupinlärning.

Stable Diffusion är en text-till-bild AI-modell som skapar högkvalitativa bilder från beskrivningar med hjälp av djupinlärning. Den använder tekniker som negativa instruktioner och referensbilder för bättre resultat, särskilt med komplexa element som händer.

Stable Diffusion är en avancerad text-till-bild-genereringsmodell som använder djupinlärningstekniker för att producera högkvalitativa, fotorealistiska bilder utifrån textbeskrivningar. Den är utvecklad som en latent diffusionsmodell och utgör ett betydande genombrott inom generativ artificiell intelligens genom att kombinera principerna för diffusionsmodeller och maskininlärning för att skapa bilder som ligger nära givna textinstruktioner.

Stable Diffusion använder djupinlärning och diffusionsmodeller för att generera bilder genom att förfina slumpmässigt brus till sammanhängande visuella motiv. Trots omfattande träning på miljontals bilder har modellen utmaningar med komplexa element som händer. Med tiden, i takt med att modellerna tränas på allt större datamängder, minskar dessa problem och bildkvaliteten blir allt mer realistisk.

En effektiv metod för att hantera handproblemet är att använda negativa instruktioner. Genom att lägga till fraser som (-bad anatomy) eller (-bad hands -unnatural hands) i dina instruktioner kan du instruera AI:n att undvika att skapa förvrängda drag. Var försiktig så att du inte överanvänder negativa instruktioner, då det kan begränsa modellens kreativa förmåga.

En annan teknik är att använda referensbilder för att vägleda AI:n. Genom att inkludera en {image}-tagg med en länk till en referensbild i din instruktion ger du AI:n en visuell mall för korrekt återgivning av händer. Detta är särskilt användbart för att bevara korrekta proportioner och poser.

För bästa resultat, kombinera både negativa instruktioner och referensbilder. Denna dubbla strategi säkerställer att AI:n undviker vanliga fel samtidigt som den följer högkvalitativa exempel.

(-bent fingers) eller (realistiska perspektiv) för att ytterligare förbättra handkvaliteten.Genom att bemästra dessa tekniker kan du avsevärt förbättra handåtergivningen i dina Stable Diffusion-skapelser och uppnå konstverk med en erfaren konstnärs finess. Samla dina referensbilder, skapa precisa instruktioner och se din AI-konst utvecklas!

I grunden fungerar Stable Diffusion genom att omvandla textinstruktioner till visuella representationer via en serie beräkningsprocesser. För att förstå dess funktionalitet måste man fördjupa sig i diffusionsmodeller, latenta utrymmen och neurala nätverk.

Diffusionsmodeller är en klass av generativa modeller inom maskininlärning som lär sig att skapa data genom att vända på en diffusionsprocess. Diffusionsprocessen innebär att brus gradvis läggs till data – till exempel bilder – tills de är omöjliga att särskilja från slumpmässigt brus. Modellen lär sig sedan att vända på denna process genom att stegvis ta bort brus för att återskapa originaldatan. Denna omvända diffusionsprocess är nyckeln till att generera ny, sammanhängande data från slumpmässigt brus.

Stable Diffusion använder specifikt en latent diffusionsmodell. Till skillnad från traditionella diffusionsmodeller som arbetar direkt i bilders högdimensionella pixelutrymme, arbetar latenta diffusionsmodeller i ett komprimerat latent utrymme. Detta latenta utrymme är en lägre dimensionell representation av datan och fångar de viktigaste egenskaperna samtidigt som den minskar beräkningskomplexiteten. Genom att arbeta i det latenta utrymmet kan Stable Diffusion generera högupplösta bilder mer effektivt.

Kärnmekanismen i Stable Diffusion är den omvända diffusionsprocessen i det latenta utrymmet. Modellen börjar med en slumpmässig latent brusvektor och förfinar denna latenta representation iterativt genom att förutsäga och ta bort brus vid varje steg. Denna förfining styrs av användarens textbeskrivning. Processen fortsätter tills den latenta vektorn konvergerar till ett tillstånd som, när det avkodas, producerar en bild som överensstämmer med textinstruktionen.

Stable Diffusions arkitektur integrerar flera nyckelkomponenter som samarbetar för att omvandla textinstruktioner till bilder.

VAE fungerar som ett kodare-avkodare-system som komprimerar bilder till det latenta utrymmet och rekonstruerar dem tillbaka till bilder. Kodaren omvandlar en bild till dess latenta representation och fångar de grundläggande egenskaperna i en reducerad form. Avkodaren tar denna latenta representation och återskapar den detaljerade bilden.

Denna process är avgörande eftersom den gör det möjligt för modellen att arbeta med data med lägre dimension, vilket avsevärt minskar resursbehovet jämfört med att arbeta direkt i hela pixelutrymmet.

U-Net är en specialiserad neural nätverksarkitektur som används inom Stable Diffusion för bildbehandling. Den består av en kodarväg och en avkodarväg med hoppkopplingar mellan speglade lager. I Stable Diffusions sammanhang fungerar U-Net som brusförutsägare under den omvända diffusionsprocessen.

Vid varje tidsteg i diffusionsprocessen förutsäger U-Net mängden brus i den latenta representationen. Denna förutsägelse används sedan för att förfina den latenta vektorn genom att subtrahera det uppskattade bruset och stegvis avbrusa det latenta utrymmet mot en bild som matchar textinstruktionen.

För att integrera textinformation använder Stable Diffusion en textkodare baserad på CLIP (Contrastive Language-Image Pretraining)-modellen. CLIP är utformad för att förstå och relatera text- och bildinformation genom att mappa dem till ett delat latent utrymme.

När användaren anger en textinstruktion omvandlar textkodaren denna till en serie inbäddningar – numeriska representationer av textdatan. Dessa inbäddningar konditionerar U-Net under den omvända diffusionsprocessen och styr bildgenereringen så att resultatet speglar innehållet i textinstruktionen.

Stable Diffusion erbjuder mångsidighet vid bildgenerering och kan användas på olika sätt beroende på användarens behov.

Det primära användningsområdet för Stable Diffusion är att generera bilder utifrån textinstruktioner. Användare skriver in en beskrivande text och modellen genererar en bild som representerar beskrivningen. En användare kan till exempel skriva in “En stillsam strand vid solnedgången med palmer” och få en bild som visar denna scen.

Denna funktion är särskilt värdefull inom kreativa industrier, innehållsskapande och design där snabb visualisering av idéer är avgörande.

Utöver att generera bilder från grunden kan Stable Diffusion även ändra befintliga bilder utifrån textinstruktioner. Genom att ange en ursprungsbild och en textanvisning kan modellen skapa en ny bild som införlivar de förändringar som beskrivs i texten.

Exempelvis kan en användare ange en bild av en stadsmiljö på dagen och instruktionen “ändra till natt med neonljus” och få en bild som speglar dessa ändringar.

Inpainting innebär att fylla i saknade eller skadade delar av en bild. Stable Diffusion är mycket skicklig på detta område genom att använda textinstruktioner för att styra återuppbyggnaden av specifika bildområden. Användare kan maskera delar av en bild och ge en textbeskrivning av vad som ska fylla utrymmet.

Denna funktion är användbar vid fotorestaurering, borttagning av oönskade objekt eller förändring av specifika element i en bild samtidigt som den övergripande sammanhållningen bibehålls.

Genom att generera bildsekvenser med små variationer kan Stable Diffusion utökas för att skapa animationer eller videoinnehåll. Verktyg som Deforum förbättrar Stable Diffusions förmåga att producera dynamiskt visuellt innehåll styrt av textinstruktioner över tid.

Detta öppnar möjligheter inom animation, visuella effekter och dynamiskt innehåll utan traditionell bild-för-bild-animering.

Stable Diffusions förmåga att generera bilder från textbeskrivningar gör den till ett kraftfullt verktyg inom AI-automation och utveckling av chattbottar.

Genom att integrera Stable Diffusion i chattbottar kan man generera visuellt innehåll som svar på användarfrågor. Till exempel kan en kundtjänstbot ge visuella guider eller illustrationer som genereras direkt för att hjälpa användaren.

Textinstruktioner omvandlas till inbäddningar med hjälp av CLIP-textkodaren. Dessa inbäddningar är avgörande för att styra bildgenereringsprocessen så att resultatbilden motsvarar användarens textbeskrivning.

Den omvända diffusionsprocessen innebär att den latenta representationen förfinas steg för steg genom att ta bort förutsagt brus. Vid varje tidsteg tar modellen hänsyn till textinbäddningarna och den aktuella latenta vektorn för att exakt förutsäga bruskomponenten.

Modellens skicklighet i att hantera brusiga bilder kommer från träning på stora datamängder där den lär sig att urskilja och avbrusa bilder effektivt. Detta gör det möjligt att skapa tydliga bilder även med slumpmässigt brus som utgångspunkt.

Att arbeta i det latenta utrymmet ger beräkningsmässig effektivitet. Eftersom det latenta utrymmet har färre dimensioner än pixelutrymmet kräver operationerna mindre resurser. Denna effektivitet gör att Stable Diffusion kan generera högupplösta bilder utan stora beräkningskrav.

Konstnärer och designers kan använda Stable Diffusion för att snabbt ta fram visuella prototyper utifrån konceptbeskrivningar, vilket underlättar den kreativa processen och minskar tiden från idé till visualisering.

Marknadsföringsteam kan skapa skräddarsydda bilder för kampanjer, sociala medier och annonser utan att behöva omfattande grafiska resurser.

Spelutvecklare kan skapa resurser, miljöer och konceptkonst genom att ange beskrivande instruktioner och effektivisera processen för att skapa tillgångar.

Återförsäljare kan generera bilder av produkter i olika miljöer eller varianter, vilket förbättrar produktvisualisering och kundupplevelse.

Lärare och innehållsskapare kan producera illustrationer och diagram för att förklara komplexa koncept och göra undervisningsmaterial mer engagerande.

Forskare inom artificiell intelligens och datorseende kan använda Stable Diffusion för att vidare utforska diffusionsmodellernas och latenta utrymmens kapacitet.

För att använda Stable Diffusion effektivt bör vissa tekniska förutsättningar beaktas.

Följ dessa steg för att börja använda Stable Diffusion:

För utvecklare som bygger AI-automationssystem och chattbottar kan Stable Diffusion integreras för att förbättra funktionaliteten.

Vid användning av Stable Diffusion är det viktigt att vara medveten om etiska aspekter.

Stable diffusion är ett viktigt ämne inom generativa modeller, särskilt för dataförstärkning och bildsyntes. Färska studier har undersökt olika aspekter av stable diffusion och lyfter fram dess tillämpningar och effektivitet.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments av Fuxi Wen (2013):

Introducerar en diffusion least mean p-power (LMP)-algoritm utformad för distribuerad skattning i miljöer med alfa-stabilt brus. Studien jämför diffusion LMP-metoden med diffusion least mean squares (LMS)-algoritmen och visar förbättrad prestanda vid alfa-stabilt brus. Denna forskning är viktig för att utveckla robusta skattningstekniker i brusiga miljöer. Läs mer

Stable Diffusion for Data Augmentation in COCO and Weed Datasets av Boyang Deng (2024):

Undersöker användningen av stable diffusion-modeller för att skapa högupplösta syntetiska bilder för att förbättra små dataset. Genom att använda tekniker som bild-till-bild-översättning, Dreambooth och ControlNet utvärderar forskningen effektiviteten av stable diffusion vid klassificerings- och detektionsuppgifter. Resultaten visar lovande tillämpningar av stable diffusion inom olika områden. Läs mer

Diffusion and Relaxation Controlled by Tempered α-stable Processes av Aleksander Stanislavsky, Karina Weron och Aleksander Weron (2011):

Härledder egenskaper hos onormal diffusion och icke-exponentiell relaxation med hjälp av tempererade α-stabila processer. Artikeln behandlar problemet med oändliga moment som är kopplat till α-stabil slumpmässig operationstid och presenterar en modell som inkluderar subdiffusion som ett specialfall. Läs mer

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion av Andreas Stöckl (2022):

Utvärderar syntetiska bilder genererade av Stable Diffusion-modellen med hjälp av Wordnet-taxonomi. Studien bedömer modellens förmåga att skapa korrekta bilder för olika begrepp och illustrerar skillnader i representationens träffsäkerhet. Dessa utvärderingar är viktiga för att förstå stable diffusions roll i dataförstärkning. Läs mer

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion av Sanchayan Vivekananthan (2024):

Utforskar tre generativa ramverk: VAE, GAN och Stable Diffusion-modeller. Forskningen lyfter fram styrkor och begränsningar för varje modell och konstaterar att även om VAE:er och GAN:er har sina fördelar utmärker sig stable diffusion i vissa syntesuppgifter. Läs mer

Låt oss titta på hur man implementerar en Stable Diffusion-modell i Python med hjälp av Hugging Face Diffusers-biblioteket.

Installera de nödvändiga biblioteken:

pip install torch transformers diffusers accelerate

pip install xformers # Valfritt

Diffusers-biblioteket erbjuder ett smidigt sätt att ladda förtränade modeller:

from diffusers import StableDiffusionPipeline

import torch

# Ladda Stable Diffusion-modellen

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Flytta modellen till GPU för snabbare inferens

För att generera bilder, ange bara en textinstruktion:

prompt = "Ett stillsamt landskap med berg och en sjö, fotorealistiskt, 8K-upplösning"

image = pipe(prompt).images[0]

# Spara eller visa bilden

image.save("generated_image.png")

model_id.torch.float16 minskas minnesanvändningen.Du kan anpassa olika parametrar:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Antal avbrusningssteg

guidance

Stable Diffusion är en avancerad AI-modell designad för att generera högkvalitativa, fotorealistiska bilder från textinstruktioner. Den använder latent diffusion och djupinlärning för att omvandla textbeskrivningar till bilder.

Stable Diffusion fungerar genom att omvandla textinstruktioner till bildinbäddningar med hjälp av en CLIP-textkodare och sedan iterativt avbrusa en latent representation styrd av instruktionen, vilket resulterar i en sammanhängande bild.

Stable Diffusion används för kreativt innehållsskapande, marknadsföringsmaterial, skapande av spelresurser, produktvisualisering för e-handel, pedagogiska illustrationer och AI-drivna chattbottar.

Ja, Stable Diffusion stöder bild-till-bild-översättning och inpainting, vilket gör det möjligt för användare att ändra befintliga bilder eller fylla i saknade delar baserat på textinstruktioner.

En dator med ett modernt grafikkort rekommenderas för effektiv bildgenerering med Stable Diffusion. Modellen kräver även Python och bibliotek som PyTorch och Diffusers.

Ja, Stable Diffusion är släppt under en tillåtande öppen källkodslicens, vilket uppmuntrar till bidrag från communityn, anpassning och bred tillgänglighet.

Släpp loss din kreativitet med Stable Diffusion och se hur AI kan omvandla dina idéer till fantastiska bilder.

Generera högkvalitativa bilder från textprompter med Stability AI Bildgenerator-komponenten. Drivs av Stable Diffusion-modeller och erbjuder anpassningsbara ins...

Utforska vår djupgående recension av Stability AI SD3 Large. Analysera dess styrkor, svagheter och kreativa resultat över olika text-till-bild-promptar, och upp...

Flux AI-modellen från Black Forest Labs är ett avancerat text-till-bild-genereringssystem som omvandlar naturliga språkprompter till mycket detaljerade, fotorea...