PyTorch

PyTorch är ett öppen källkod maskininlärningsramverk utvecklat av Meta AI, känt för sin flexibilitet, dynamiska beräkningsgrafer, GPU-acceleration och sömlös in...

Torch är ett öppen källkod maskininlärningsbibliotek baserat på Lua, som erbjuder omfattande verktyg för neurala nätverk och djupinlärning, och banade väg för PyTorch.

Torch är ett öppen källkod maskininlärningsbibliotek, vetenskapligt beräkningsramverk och skriptspråk baserat på Lua, särskilt optimerat för djupinlärning och artificiell intelligens. Torch utvecklades ursprungligen av Idiap Research Institute vid EPFL år 2002 och erbjuder en omfattande uppsättning verktyg för att bygga och träna komplexa neurala nätverk. Det var en föregångare till biblioteket PyTorch, som sedan dess har blivit mer framträdande inom maskininlärningsgemenskapen. Trots sitt tidiga inflytande och sina möjligheter begränsades Torch’s spridning av beroendet till Lua, ett mindre utbrett programmeringsspråk jämfört med Python.

N-dimensionella Arrayer (Tensorer):

Torch är uppbyggt kring konceptet Tensorer, som är flerdimensionella arrayer liknande NumPy-arrayer. Dessa tensorer är grundläggande för att utföra olika matematiska operationer som krävs inom maskininlärning och vetenskapliga beräkningar. Tensorer möjliggör effektiva numeriska beräkningar och stöder operationer på CPU:er och GPU:er via optimerade bibliotek som CUDA.

Automatisk Differentiering:

En kärnfunktion i Torch som möjliggör effektiv beräkning av derivator, vilket är avgörande för att träna djupa neurala nätverk. Torch’s automatiska differentiering implementeras via ett modulgränssnitt som tillåter beräkning av förstaderivator. Denna funktion förenklar träningsprocessen av komplexa modeller genom att automatisera derivatberäkningen.

Moduler för Djupa Neurala Nätverk:

Torch’s nn-paket möjliggör konstruktion av neurala nätverk med ett modulärt tillvägagångssätt. Det stöder feedforward-, konvolutions- och rekurrenta nätverk, bland annat, och inkluderar moduler för aktiveringsfunktioner, förlustfunktioner och optimerare. Denna modulära design underlättar skapandet och experimenterandet med olika nätverksarkitekturer.

GPU-acceleration:

Torch utnyttjar GPU-acceleration för att utföra beräkningar effektivt, vilket gör det väl lämpat för storskaliga maskininlärningsuppgifter. Dess integration med CUDA ger betydande prestandaförbättringar, vilket gör att forskare kan träna komplexa modeller snabbare och mer effektivt.

Forskning inom Djupinlärning:

Torch har använts flitigt i akademiska och industriella forskningsmiljöer, särskilt vid utveckling av nya algoritmer för djupinlärning. Dess flexibilitet och snabbhet gör det idealiskt för prototypframtagning av komplexa modeller. Forskare har använt Torch för att experimentera med nya arkitekturer och inlärningsalgoritmer.

Datorseende:

Torch erbjuder verktyg för bildbehandling och datorseendetillämpningar, såsom objektigenkänning och bildklassificering. Dess förmåga att hantera stora datamängder och utföra realtidsbearbetning gör det till ett värdefullt verktyg för visuell dataanalys.

Naturlig Språkbehandling (NLP):

Biblioteket stöder utvecklingen av NLP-modeller, inklusive rekurrenta neurala nätverk och språkmodeller, som är viktiga för uppgifter som maskinöversättning och sentimentanalys. Torch’s dynamiska beräkningsmöjligheter möjliggör effektiv hantering av sekventiella data och variabla indata.

Förstärkningsinlärning:

Torch används inom förstärkningsinlärning för att ta fram modeller som lär sig optimala handlingar genom försök och misstag, vilket är användbart inom områden som robotik och spel-AI. Dess förmåga att hantera komplexa miljöer och processer stöder utvecklingen av intelligenta, adaptiva system.

Bygga Neurala Nätverk:nn-paketet i Torch gör det möjligt att bygga neurala nätverk via ett högnivågränssnitt. Exempelvis kan man skapa en enkel multilayer perceptron med några rader kod, där lager och aktiveringsfunktioner definieras smidigt.

local nn = require 'nn'

local model = nn.Sequential()

model:add(nn.Linear(10, 25))

model:add(nn.Tanh())

model:add(nn.Linear(25, 1))

Datorseende med Torch:

Facebook AI Research har använt Torch för olika datorseendeprojekt, där dess robusta kapacitet har gjort det möjligt att bearbeta och analysera stora datamängder effektivt. Torch’s GPU-förmågor möjliggör realtidsbildbearbetning, vilket gör det till ett förstahandsval för högpresterande visionuppgifter.

NLP-modeller:

Torch’s stöd för dynamiska neurala nätverk gör det idealiskt för utveckling av avancerade NLP-modeller som kräver flexibilitet i bearbetning av textsekvenser. Ramverkets förmåga att hantera variabla indata och dynamiska datatyper är avgörande för avancerade språkbehandlingstillämpningar.

Utvecklingen av Torch har till stor del övergått till PyTorch, ett bibliotek som behåller Torch’s kärnfunktioner men bygger på Pythons popularitet och användarvänlighet. PyTorch erbjuder ett mer intuitivt gränssnitt och bättre integration med Pythons ekosystem, vilket gör det till ett förstahandsval för moderna maskininlärningsutövare. PyTorch’s dynamiska beräkningsgraf och högnivå-API har gjort det till standard inom området och underlättar snabb prototypframtagning och driftsättning av djupinlärningsmodeller.

Torch och dess efterföljare PyTorch är avgörande för utveckling av AI-applikationer, inklusive chattbottar. Förmågan att bearbeta stora mängder data och lära sig dynamiskt är avgörande för att skapa intelligenta system som kan förstå och svara på användarinmatningar effektivt. Med framstegen inom NLP och djupinlärning fortsätter PyTorch att vara ett centralt verktyg för att öka intelligens och effektivitet i chatbot-system.

Torch-biblioteket är ett populärt maskininlärningsbibliotek som har använts flitigt för att implementera djupinlärningsmodeller. Nedan följer en sammanfattning av viktiga forskningsartiklar som diskuterar Torch-biblioteket och dess användningsområden:

Torch-Struct: Deep Structured Prediction Library

Publicerad 2020 av Alexander M. Rush, den här artikeln introducerar Torch-Struct, ett bibliotek utformat för strukturerad prediktion i djupinlärningsramverk. Det integreras med vektoriserade, auto-differentieringsbaserade ramverk och inkluderar en bred samling probabilistiska strukturer. Biblioteket syftar till att erbjuda effektiv, testbar och snabb kod genom batch- och vektoriserade operationer. Experimenten visar betydande prestandavinster jämfört med snabba baslinjer. För mer information kan du läsa artikeln här.

rnn: Rekurrentt bibliotek för Torch för sekventiella datauppgifter som NLP, taligenkänning och tidsserieprognoser. Utforska nu!

Författad av Nicholas Léonard och andra 2015, diskuterar denna artikel rnn-paketet som tillhandahåller komponenter för ett brett utbud av rekurrenta neurala nätverk inom Torch-ramverket. Paketet betonar stark enhetstestning och bakåtkompatibilitet. Det har utvecklats genom tre iterationer och förbättrat sin flexibilitet och kapacitet. Artikeln jämför rnn-paketet med befintliga implementationer och ger insikter i dess utveckling och användning.

cltorch: ett hårdvaruoberoende backend för Torch Deep Neural Network Library, baserat på OpenCL

Skriven av Hugh Perkins 2016, presenterar denna artikel cltorch, som gör det möjligt att träna djupa neurala nätverk på GPU:er från olika hårdvaruleverantörer med hjälp av OpenCL. cltorch kan köra modeller som AlexNet och GoogleNet och fokuserar på att accelerera konvolutionslager för bättre hårdvaruoberoende prestanda. Artikeln diskuterar också de tekniska utmaningarna och lösningarna för snabb implementering.

cito: Ett R-paket för att träna neurala nätverk med hjälp av torch

Publicerad 2024 av Christian Amesoeder och kollegor, introducerar denna artikel ‘cito’, ett R-paket som förenklar specifikationen av djupa neurala nätverk med den välbekanta formelsyntaxen från R-paket. Det utnyttjar Torch-biblioteket för numerisk optimering och syftar till att göra djupinlärning mer tillgänglig för R-användare, särskilt inom ekologi.

Torch är ett öppen källkod maskininlärningsbibliotek och vetenskapligt beräkningsramverk baserat på Lua, optimerat för djupinlärning och artificiell intelligens. Det erbjuder verktyg för att bygga och träna komplexa neurala nätverk och var en föregångare till PyTorch.

Torch erbjuder N-dimensionell tensorkomputation, automatisk differentiering, modulära komponenter för neurala nätverk samt GPU-acceleration för högpresterande djupinlärningsuppgifter.

Torch är baserat på Lua och var ett tidigt ramverk för djupinlärning, medan PyTorch är dess efterföljare baserad på Python, med ett mer intuitivt API, dynamiska beräkningsgrafer och en bredare användning inom maskininlärningsgemenskapen.

Torch har använts för forskning inom djupinlärning, datorseende, naturlig språkbehandling och förstärkningsinlärning, särskilt innan PyTorch blev dominerande.

Övergången skedde eftersom Python används mer allmänt än Lua, och PyTorch erbjuder förbättrad användarvänlighet, integration med Pythons ekosystem och avancerade funktioner för moderna djupinlärningsarbetsflöden.

Upptäck hur Torch och andra AI-verktyg kan stärka dina projekt inom djupinlärning och maskininlärning. Testa FlowHunt’s plattform för att bygga dina egna AI-lösningar.

PyTorch är ett öppen källkod maskininlärningsramverk utvecklat av Meta AI, känt för sin flexibilitet, dynamiska beräkningsgrafer, GPU-acceleration och sömlös in...

AllenNLP är ett robust och omfattande open source-bibliotek för NLP-forskning, byggt på PyTorch av AI2. Det erbjuder modulära, utbyggbara verktyg, förtränade mo...

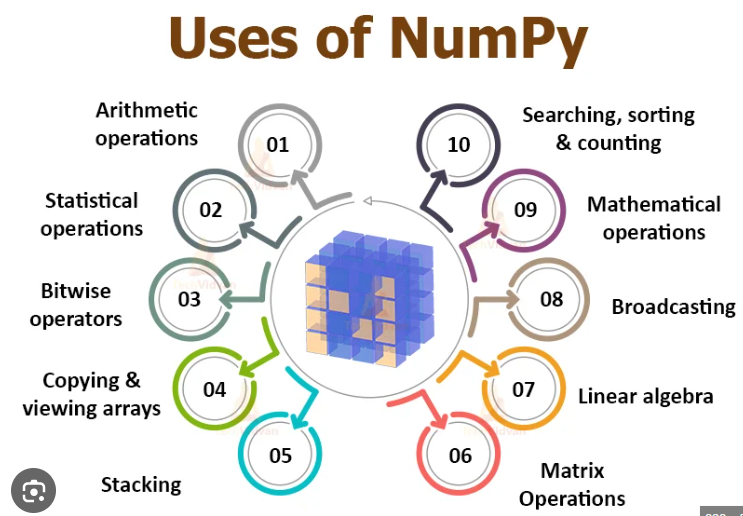

NumPy är ett open source-bibliotek för Python som är avgörande för numeriska beräkningar och erbjuder effektiva arrayoperationer och matematiska funktioner. Det...