Anpassad OpenAI LLM

Lås upp kraften i anpassade språkmodeller med komponenten Anpassad OpenAI LLM i FlowHunt. Integrera sömlöst dina egna OpenAI-kompatibla modeller—inklusive JinaC...

OpenAI Whisper är ett ASR-system med öppen källkod som noggrant omvandlar tal till text på 99 språk, med stöd för transkribering, översättning och språkindentifiering för robust AI-automation.

OpenAI Whisper kan betraktas som både en modell och ett system, beroende på sammanhanget.

Whispers huvudsakliga funktion är att transkribera tal till textutdata. Den utmärker sig inom:

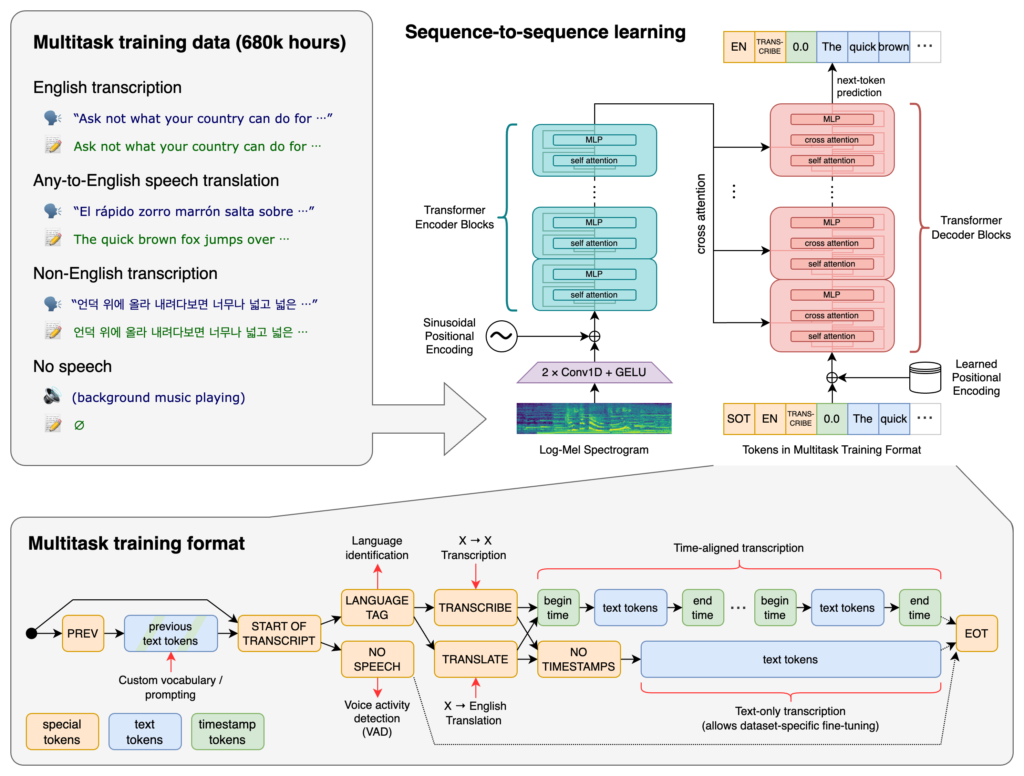

I centrum för Whisper ligger Transformer-arkitekturen, specifikt en encoder-decoder-modell. Transformatorer är neurala nätverk som utmärker sig i att bearbeta sekventiell data och förstå sammanhang över långa sekvenser. De introducerades i artikeln “Attention is All You Need” 2017 och har blivit grundläggande inom många NLP-uppgifter.

Whispers process innebär:

Whisper tränades på en enorm datamängd med 680 000 timmar övervakad data som samlats in från webben. Detta inkluderar:

Med täckning av 99 språk utmärker sig Whisper i att hantera olika språkliga indata. Denna flerspråkiga kapacitet gör den lämplig för globala applikationer och tjänster riktade mot internationella användare.

Tränad på omfattande övervakad data uppnår Whisper hög noggrannhet i transkriberingsuppgifter. Dess robusthet mot olika accenter, dialekter och bakgrundsljud gör den pålitlig i olika verkliga scenarier.

Utöver transkribering kan Whisper utföra:

Släppt som öppen källkod gör Whisper det möjligt för utvecklare att:

Genom att integrera Whisper i chattbottar och AI-assistenter kan utvecklare möjliggöra:

Whisper är implementerat som ett Python-bibliotek, vilket möjliggör sömlös integration i Python-baserade projekt. Att använda Whisper i Python innebär att sätta upp rätt miljö, installera nödvändiga beroenden och använda bibliotekets funktioner för att transkribera eller översätta ljudfiler.

Innan du använder Whisper behöver du förbereda din utvecklingsmiljö genom att installera Python, PyTorch, FFmpeg och själva Whisper-biblioteket.

Om du inte har Python installerat, ladda ner det från officiella webbplatsen. För att installera PyTorch, använd pip:

pip install torch

Alternativt, besök PyTorch-webbplatsen för specifika installationsinstruktioner beroende på operativsystem och Python-version.

Whisper kräver FFmpeg för att bearbeta ljudfiler. Installera FFmpeg med lämplig paketinstallatör för ditt operativsystem.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (med Homebrew):

brew install ffmpeg

Windows (med Chocolatey):

choco install ffmpeg

Installera Whisper Python-paketet med pip:

pip install -U openai-whisper

För att installera den senaste versionen direkt från GitHub:

pip install git+https://github.com/openai/whisper.git

Se till att utvecklarläge är aktiverat:

Whisper erbjuder flera modeller som varierar i storlek och kapacitet. Modellerna sträcker sig från tiny till large, där varje modell balanserar hastighet och noggrannhet på olika sätt.

| Storlek | Parametrar | Endast engelska | Flerspråkig | Krävd VRAM | Relativ hastighet |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Optimerade för engelsk transkribering och ger förbättrad prestanda för engelskt ljud.Efter att du installerat miljön och nödvändiga komponenter kan du börja använda Whisper i dina Python-projekt.

Börja med att importera Whisper-biblioteket och ladda en modell:

import whisper

# Ladda önskad modell

model = whisper.load_model("base")

Byt ut "base" mot den modell som passar din applikation.

Whisper erbjuder en enkel transcribe-funktion för att omvandla ljudfiler till text.

Exempel: Transkribera en engelsk ljudfil

# Transkribera ljudfilen

result = model.transcribe("path/to/english_audio.mp3")

# Skriv ut transkriberingen

print(result["text"])

model.transcribe(): Bearbetar ljudfilen och returnerar en ordbok med transkriberingen och annan metadata.result["text"]: Hämtar den transkriberade texten från resultatet.Whisper kan översätta ljud från olika språk till engelska.

Exempel: Översätta spansk ljudfil till engelska

# Transkribera och översätt spansk ljudfil till engelska

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# Skriv ut den översatta texten

print(result["text"])

task="translate": Instruerar modellen att översätta ljudet till engelska istället för att bara transkribera det.Även om Whisper kan identifiera språk automatiskt kan det förbättra noggrannheten och hastigheten att ange språket.

Exempel: Transkribera fransk ljudfil

# Transkribera fransk ljudfil genom att ange språket

result = model.transcribe("path/to/french_audio.wav", language="fr")

# Skriv ut transkriberingen

print(result["text"])

Whisper kan identifiera vilket språk som talas i en ljudfil med metoden detect_language.

Exempel: Språkindentifiering

# Ladda och förbehandla ljudet

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Konvertera till log-Mel-spektrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Identifiera språk

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Laddar ljudfilen.whisper.pad_or_trim(): Justerar ljudlängden för att passa modellens krav.whisper.log_mel_spectrogram(): Konverterar ljudet till det format som modellen förväntar sig.model.detect_language(): Returnerar sannolikheter för varje språk och identifierar det mest sannolika.För mer kontroll över transkriberingsprocessen kan du använda mer låg-nivå-funktioner och anpassa avkodningsalternativ.

decodeFunktionen decode gör det möjligt att ange alternativ som språk, uppgift och om tidsstämplar ska inkluderas.

Exempel: Anpassade avkodningsalternativ

# Sätt avkodningsalternativ

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Avkoda ljudet

result = whisper.decode(model, mel, options)

# Skriv ut den igenkända texten

print(result.text)

Du kan integrera Whisper för att transkribera live-ljud från mikrofon.

Exempel: Transkribera live-mikrofoninput

import whisper

import sounddevice as sd

# Ladda modellen

model = whisper.load_model("base")

# Spela in ljud från mikrofonen

duration = 5 # sekunder

fs = 16000 # Samplingsfrekvens

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper är ett avancerat system för automatisk taligenkänning (ASR) utvecklat av OpenAI, utformat för att transkribera talat språk till skriven text med hjälp av djupinlärning. Det stöder 99 språk och utmärker sig inom transkribering, översättning och språkindentifiering.

Whisper använder en transformatorbaserad encoder-decoder-arkitektur, bearbetar ljud till log-Mel-spektrogram och genererar text via en språkmodell. Det tränades på 680 000 timmar flerspråkig, multitask-data för hög noggrannhet och robusthet.

Whisper stöder flerspråkig taligenkänning, talöversättning, automatisk språkindentifiering, robusthet mot accenter och brus, samt erbjuder öppen källkod för anpassning och integration.

Hårdvarukraven beror på modellens storlek: mindre modeller som 'tiny' kräver ~1GB VRAM, medan den största kräver ~10GB. Whisper körs snabbare på GPU:er men kan även köras på CPU:er med längre bearbetningstider.

Ja, Whisper är implementerat som ett Python-bibliotek och kan installeras via pip. Det möjliggör enkel integration i Python-projekt för taltranskribering, översättning och realtidsapplikationer för röst.

Vanliga användningsområden inkluderar automatiserad mötestranskribering, röststyrda chattbottar, live-översättning, tillgänglighetsverktyg (textning och hjälpmedel), callcenter-automation och röststyrda automationssystem.

Ja, alternativ inkluderar öppen källkod-motorer som Mozilla DeepSpeech, Kaldi, Wav2vec, och kommersiella API:er såsom Google Cloud Speech-to-Text, Microsoft Azure AI Speech och AWS Transcribe.

Ja, OpenAI Whisper är öppen källkod vilket gör det möjligt för utvecklare att anpassa, finjustera och integrera det i egna produkter och tjänster utan licensbegränsningar.

Integrera avancerad tal-till-text-funktionalitet i dina applikationer, automatisera arbetsflöden och förbättra användarupplevelsen med OpenAI Whisper och FlowHunt.

Lås upp kraften i anpassade språkmodeller med komponenten Anpassad OpenAI LLM i FlowHunt. Integrera sömlöst dina egna OpenAI-kompatibla modeller—inklusive JinaC...

FlowHunt stöder dussintals textgenereringsmodeller, inklusive modeller från OpenAI. Så här använder du ChatGPT i dina AI-verktyg och chatbottar.

Ett grundläggande AI-modell är en storskalig maskininlärningsmodell som tränas på enorma mängder data och kan anpassas till en mängd olika uppgifter. Grundmodel...