mcp-local-rag MCP-server

mcp-local-rag MCP-servern möjliggör integritetsvänlig, lokal Retrieval-Augmented Generation (RAG) webbsökning för LLM:er. Den låter AI-assistenter få tillgång t...

mcp-local-rag MCP-servern möjliggör integritetsvänlig, lokal Retrieval-Augmented Generation (RAG) webbsökning för LLM:er. Den låter AI-assistenter få tillgång t...

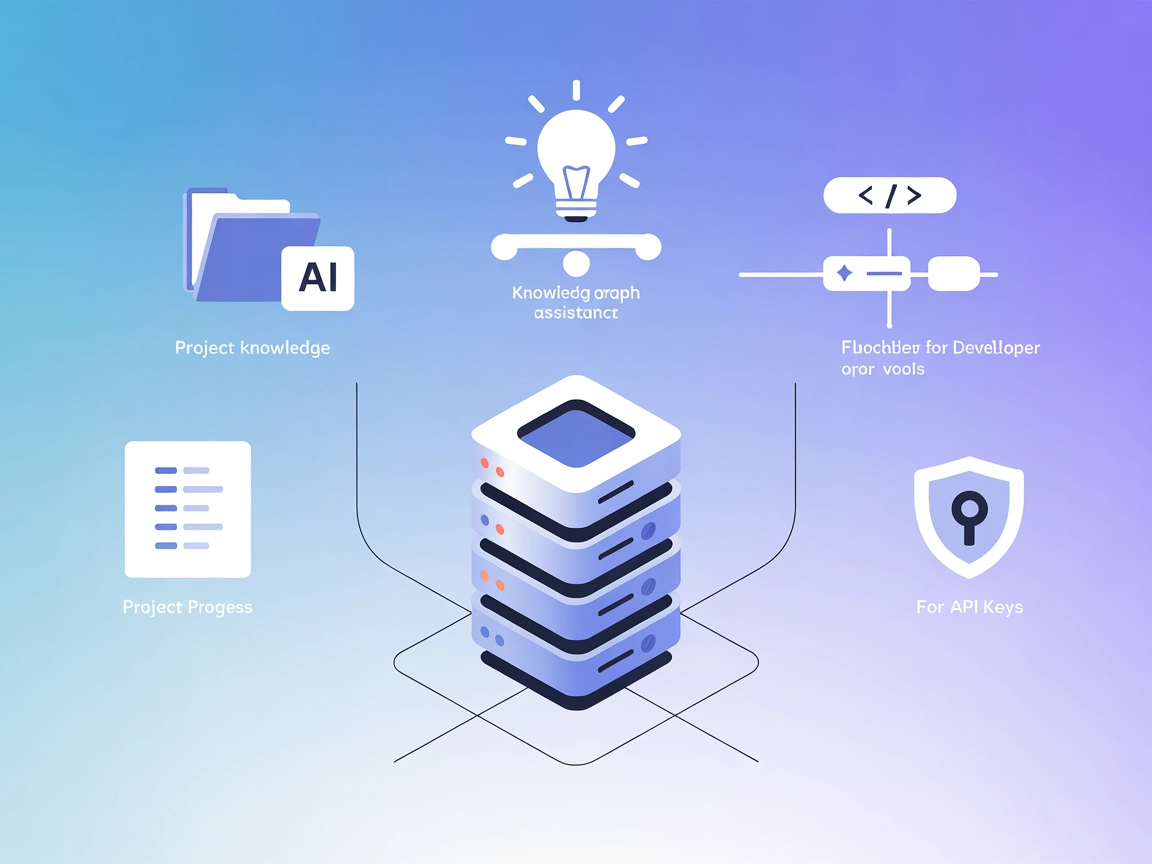

Context Portal (ConPort) är en minnesbank-MCP-server som stärker AI-assistenter och utvecklarverktyg genom att hantera strukturerad projektkontext, möjliggöra R...

Integrera FlowHunt med Pinecone vektordatabaser med hjälp av Pinecone MCP Server. Möjliggör semantisk sökning, Retrieval-Augmented Generation (RAG) och effektiv...

RAG Webbläsare MCP-server utrustar AI-assistenter och LLM:er med live webbsök och innehållsextraktion, vilket möjliggör retrieval-augmented generation (RAG), sa...

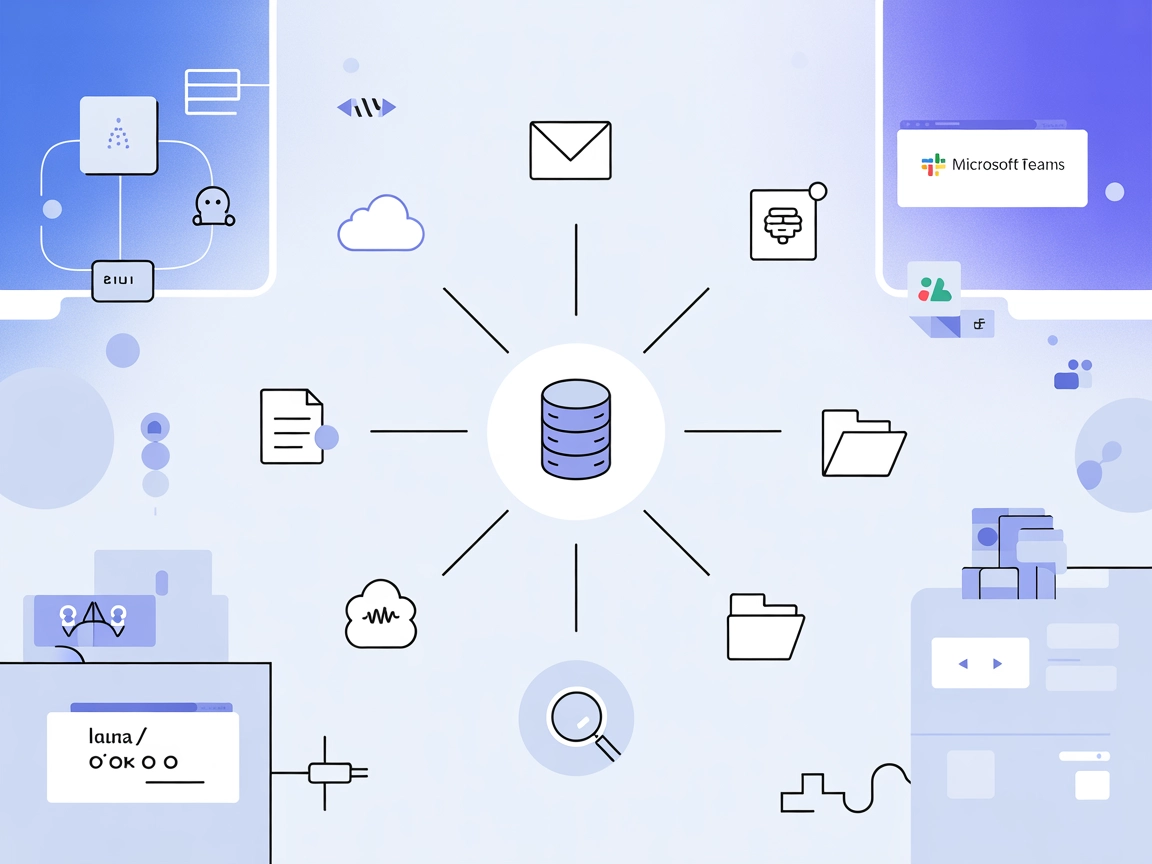

Agentset MCP Server är en öppen plattform som möjliggör Retrieval-Augmented Generation (RAG) med agentiska funktioner, vilket låter AI-assistenter ansluta till ...

Inkeep MCP-servern kopplar AI-assistenter och utvecklarverktyg till uppdaterad produktdokumentation som hanteras i Inkeep, vilket möjliggör direkt, säker och ef...

Mcp-rag-local MCP-server ger AI-assistenter semantisk minne, vilket möjliggör lagring och hämtning av textavsnitt baserat på innebörd – inte bara nyckelord. Den...

Graphlit MCP Server kopplar samman FlowHunt och andra MCP-klienter med en enhetlig kunskapsplattform, vilket möjliggör smidig import, aggregering och hämtning a...

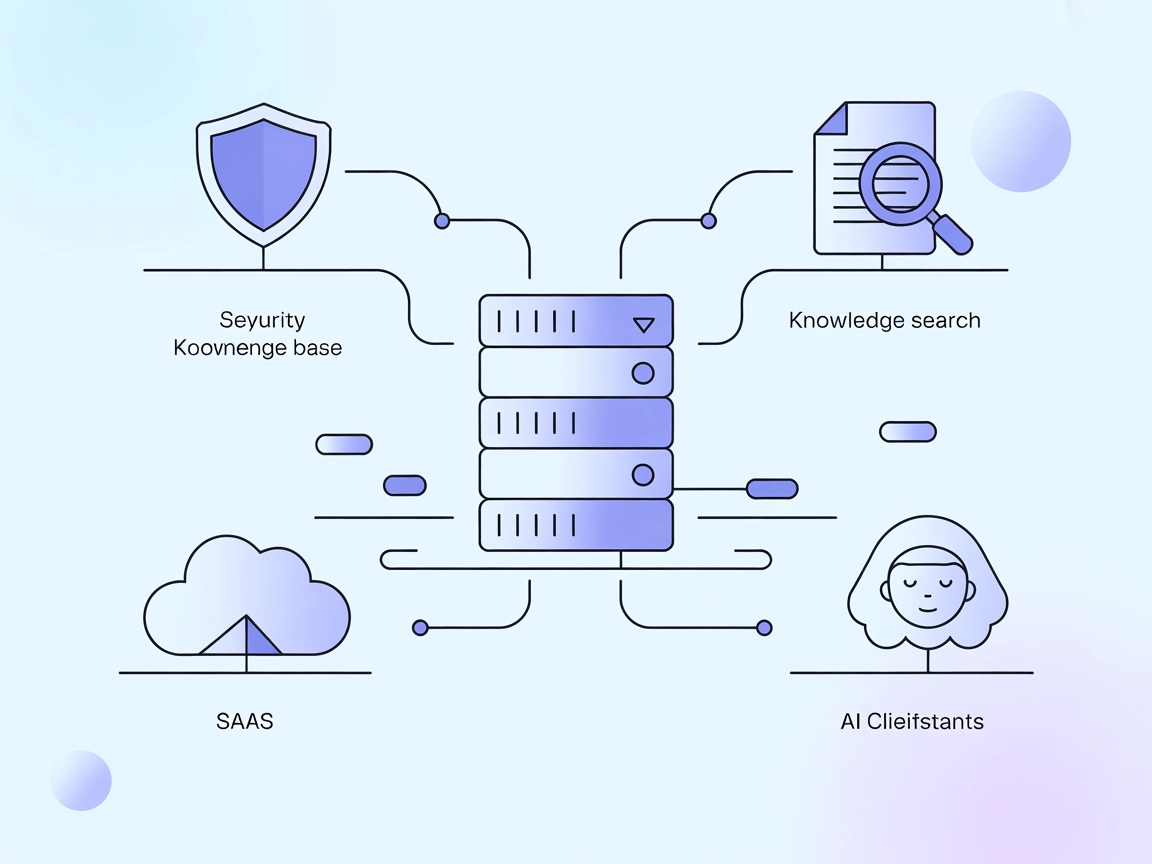

Vectara MCP Server är en öppen källkodslösning som fungerar som en brygga mellan AI-assistenter och Vectaras Trusted RAG-plattform, vilket möjliggör säker och e...

Cache Augmented Generation (CAG) är en ny metod för att förbättra stora språkmodeller (LLM) genom att förladda kunskap som förberäknade nyckel-värde-cacher, vil...

Dokumentbedömning i Retrieval-Augmented Generation (RAG) är processen att utvärdera och rangordna dokument baserat på deras relevans och kvalitet som svar på en...

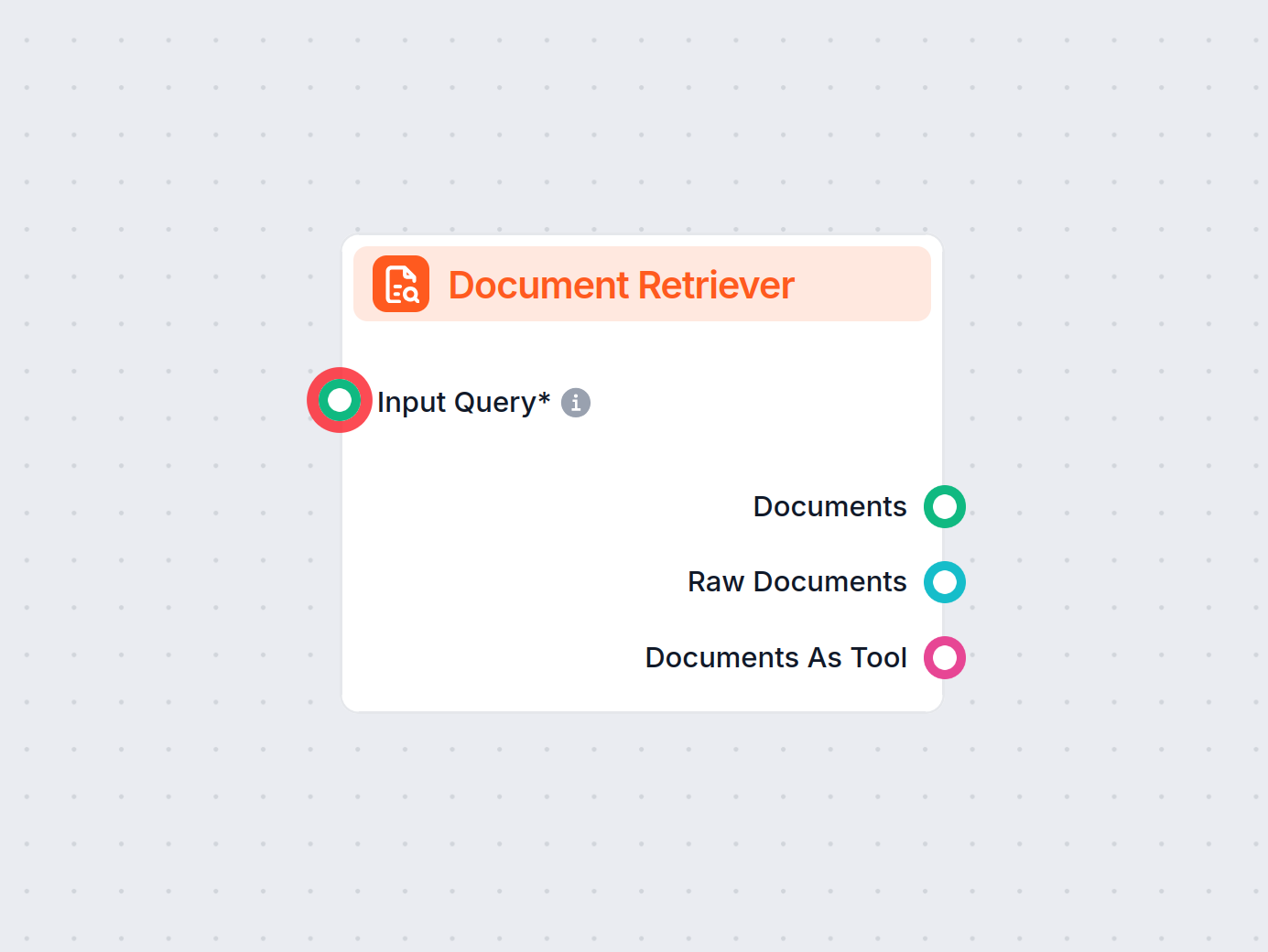

FlowHunts Dokumenthämtare förbättrar AI-noggrannheten genom att koppla generativa modeller till dina egna uppdaterade dokument och webbadresser, vilket säkerstä...

Dokumentomrangering är processen att omordna hämtade dokument utifrån deras relevans för en användares fråga, vilket förfinar sökresultaten för att prioritera d...

Frågebesvarande system med Retrieval-Augmented Generation (RAG) kombinerar informationssökning och naturlig språkxadgenerering för att förbättra stora språkmode...

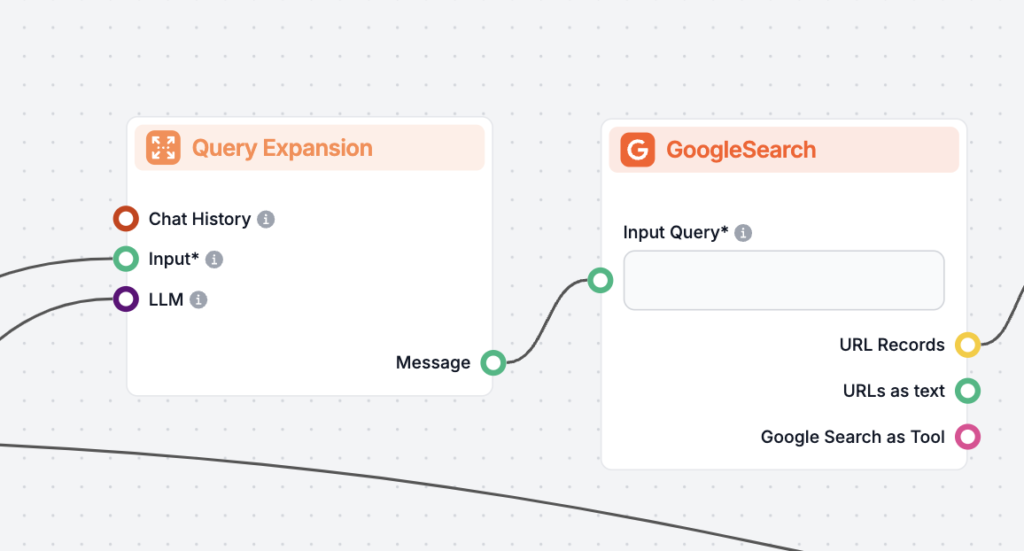

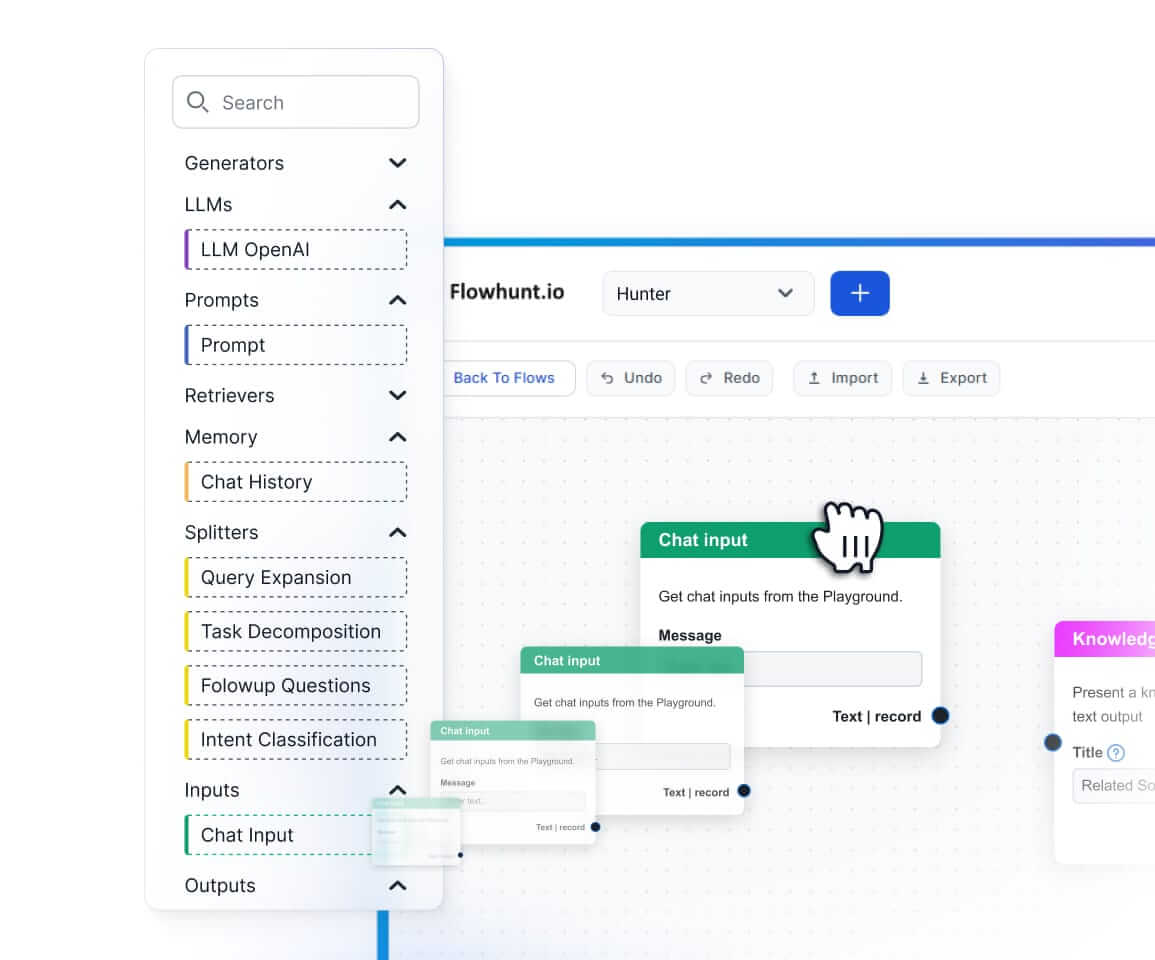

Frågeexpansion är processen att förbättra en användares ursprungliga fråga genom att lägga till termer eller kontext, vilket förbättrar dokumentåtervinningen fö...

Öka AI-noggrannheten med RIG! Lär dig hur du skapar chattbotar som faktagranskar svar med både egna och allmänna datakällor för tillförlitliga, källhänvisade sv...

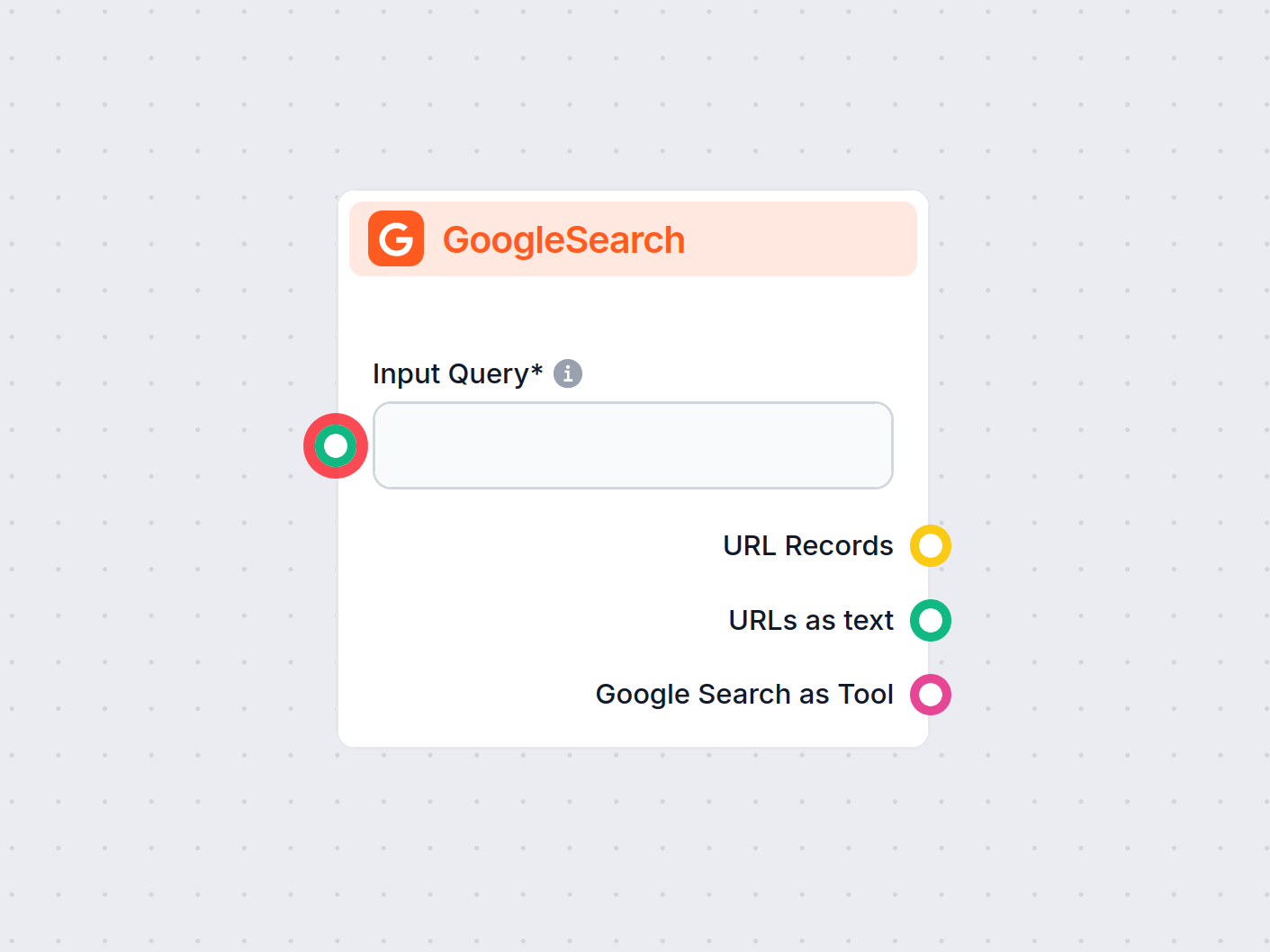

FlowHunt’s GoogleSearch-komponent förbättrar chatbotens noggrannhet genom att använda Retrieval-Augmented Generation (RAG) för att hämta uppdaterad kunskap från...

Upptäck vad en hämtningspipeline är för chatbottar, dess komponenter, användningsområden och hur Retrieval-Augmented Generation (RAG) och externa datakällor möj...

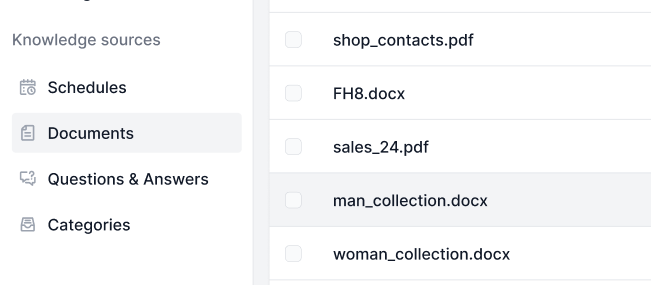

Kunskapskällor gör det enkelt att lära AI:n enligt dina behov. Upptäck alla sätt att koppla kunskap med FlowHunt. Anslut enkelt webbplatser, dokument och videor...

LazyGraphRAG är ett innovativt tillvägagångssätt för Retrieval-Augmented Generation (RAG) som optimerar effektiviteten och minskar kostnader inom AI-drivet data...

Utforska hur OpenAI O1:s avancerade resonemangsförmåga och förstärkningsinlärning överträffar GPT4o i RAG-noggrannhet, med benchmarkresultat och kostnadsanalys....

Retrieval Augmented Generation (RAG) är en avancerad AI-ram som kombinerar traditionella informationssökningssystem med generativa stora språkmodeller (LLMs), v...

Upptäck de viktigaste skillnaderna mellan Retrieval-Augmented Generation (RAG) och Cache-Augmented Generation (CAG) inom AI. Lär dig hur RAG dynamiskt hämtar re...