LLM xAI

FlowHunt, xAI tarafından geliştirilen modeller de dahil olmak üzere onlarca metin üretim modelini destekler. xAI modellerini yapay zeka araçlarınızda ve sohbet ...

FlowHunt’ın LLM Meta AI’sı, Meta’nın Llama modellerini ve onlarca diğer AI modelini esnek metin ve görsel üretimi için tek bir, kolayca kontrol edilebilen panelde bir araya getirir.

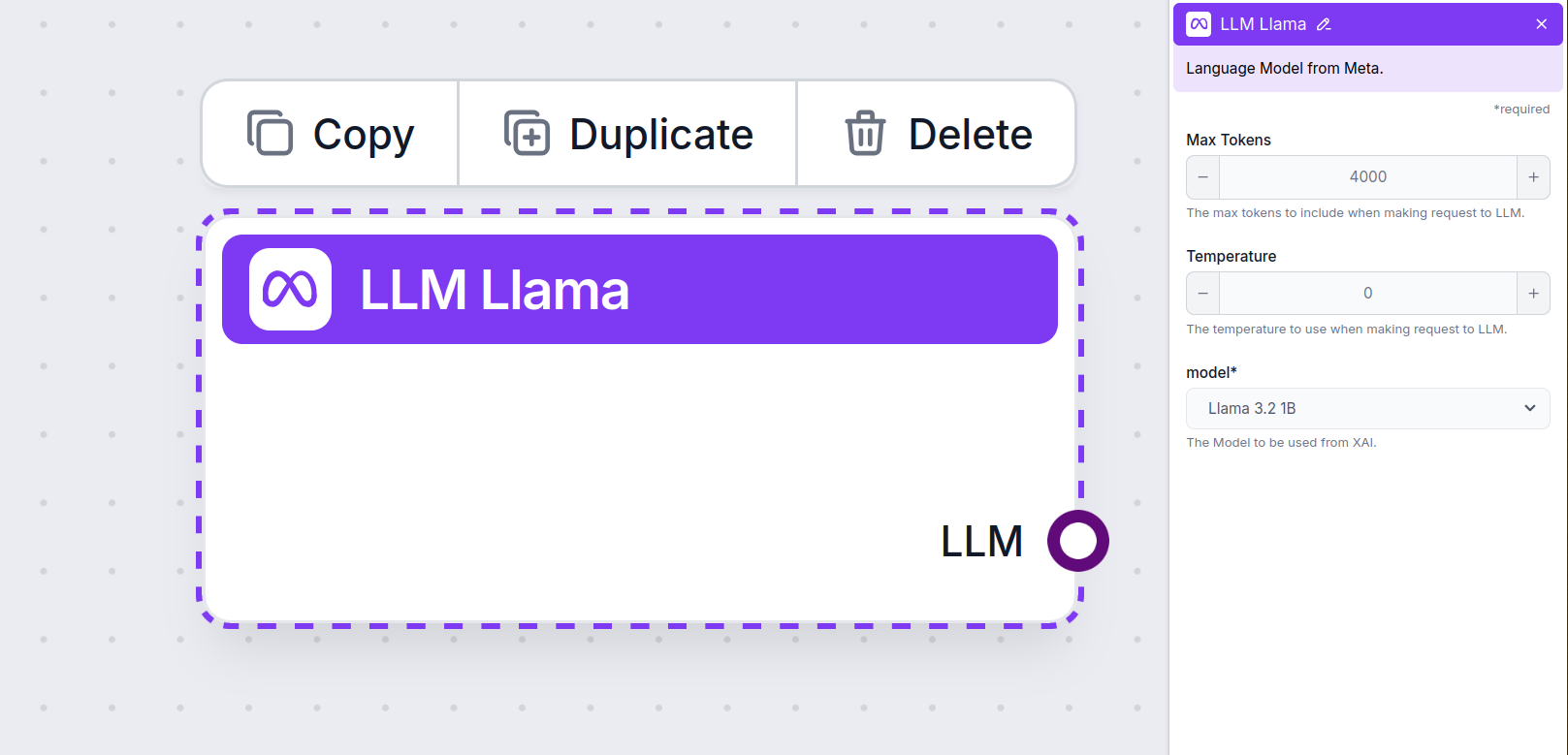

Bileşen açıklaması

LLM Meta AI bileşeni, Claude model ailesini Flow’unuza bağlar. Gerçek sihrin gerçekleştiği yer olan Üreticiler ve Ajanlar’da, LLM bileşenleri kullanılan modeli kontrol etmenizi sağlar. Tüm bileşenler varsayılan olarak ChatGPT-4 ile gelir. Modeli değiştirmek veya üzerinde daha fazla kontrol elde etmek isterseniz, bu bileşeni bağlayabilirsiniz.

Bir LLM Bileşeni bağlamanın isteğe bağlı olduğunu unutmayın. LLM kullanan tüm bileşenler varsayılan olarak ChatGPT-4o ile gelir. LLM bileşenleri, modeli değiştirmenizi ve model ayarlarını kontrol etmenizi sağlar.

Tokenlar, modelin işlediği ve ürettiği metnin bireysel birimlerini temsil eder. Token kullanımı modellere göre değişir ve bir token, kelimelerden veya alt kelime birimlerinden tek bir karaktere kadar herhangi bir şey olabilir. Modeller genellikle milyonlarca token üzerinden fiyatlandırılır.

Maksimum token ayarı, tek bir etkileşimde veya istekte işlenebilecek toplam token sayısını sınırlar ve yanıtların makul sınırlar içinde üretilmesini sağlar. Varsayılan sınır 4.000 tokendir; bu, belgeleri ve birkaç kaynağı özetleyerek yanıt üretmek için en uygun boyuttur.

Sıcaklık, yanıtların çeşitliliğini 0 ile 1 arasında kontrol eder.

0.1 sıcaklık, yanıtları çok kısa ve öz ama muhtemelen tekrarlayıcı ve yetersiz yapar.

1 gibi yüksek bir sıcaklık, yanıtlarda maksimum yaratıcılığa olanak tanır, ancak alakasız veya hatta hayali yanıtlar üretme riski taşır.

Örneğin, bir müşteri hizmetleri botu için önerilen sıcaklık 0.2 ile 0.5 arasında olmalıdır. Bu seviye, yanıtların hem alakalı hem de doğal bir çeşitlilikle olmasını sağlar.

Bu, model seçme alanıdır. Burada Meta AI’nın desteklenen tüm modellerini bulabilirsiniz. Meta’nın açık kaynak, hafif Llama modellerini destekliyoruz. Bu modeller, verimli cihaz üzerinde ve edge dağıtımlar için tasarlanmıştır:

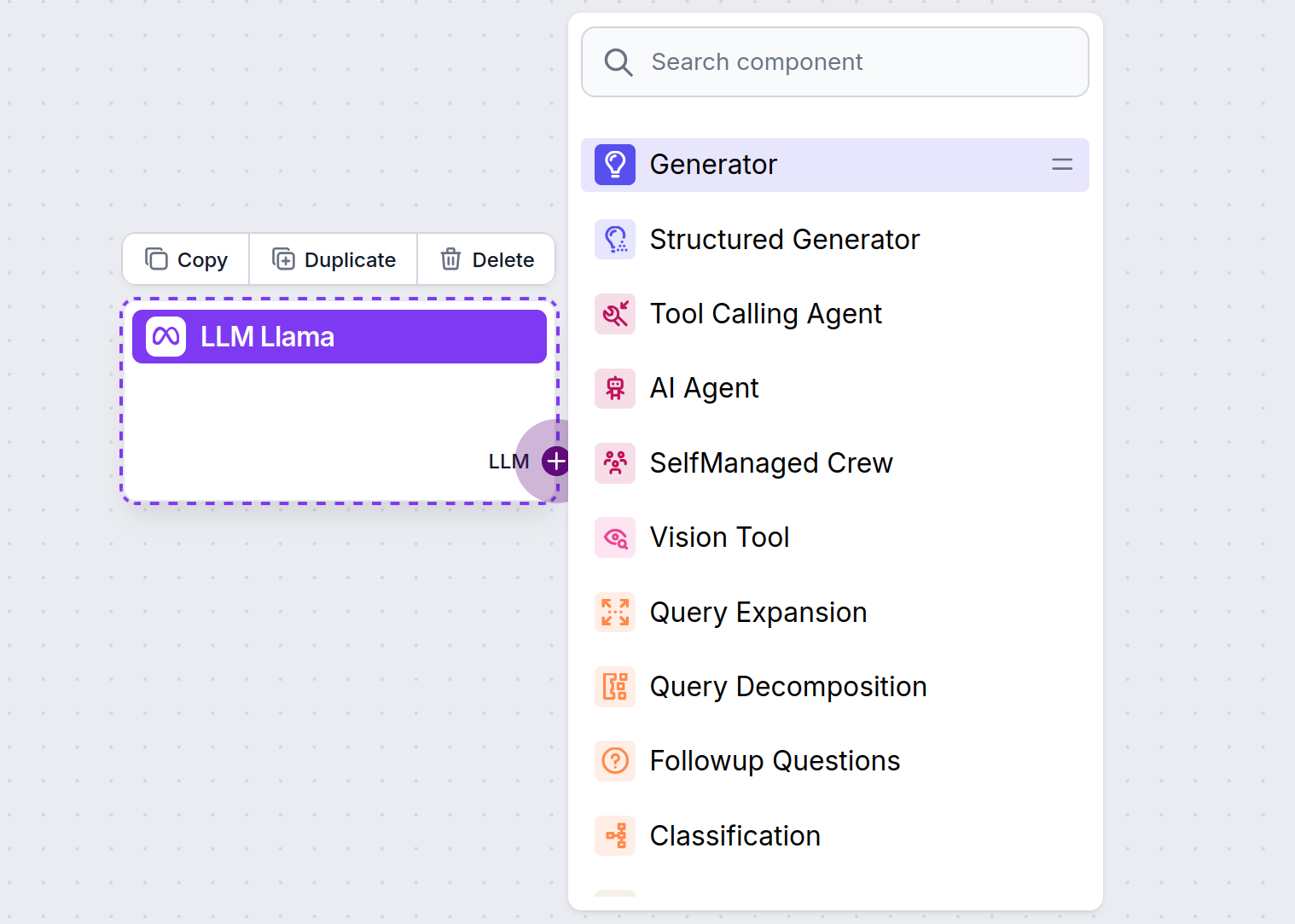

Tüm LLM bileşenlerinin yalnızca bir çıkış tutamacına sahip olduğunu göreceksiniz. Girdi, bileşenden geçmez; çünkü bileşen yalnızca modeli temsil eder, asıl üretim AI Ajanları ve Üreticilerde gerçekleşir.

LLM tutamacı her zaman mordur. LLM giriş tutamacı, metin üretmek veya veri işlemek için AI kullanan herhangi bir bileşende bulunur. Tutamağa tıklayarak seçenekleri görebilirsiniz:

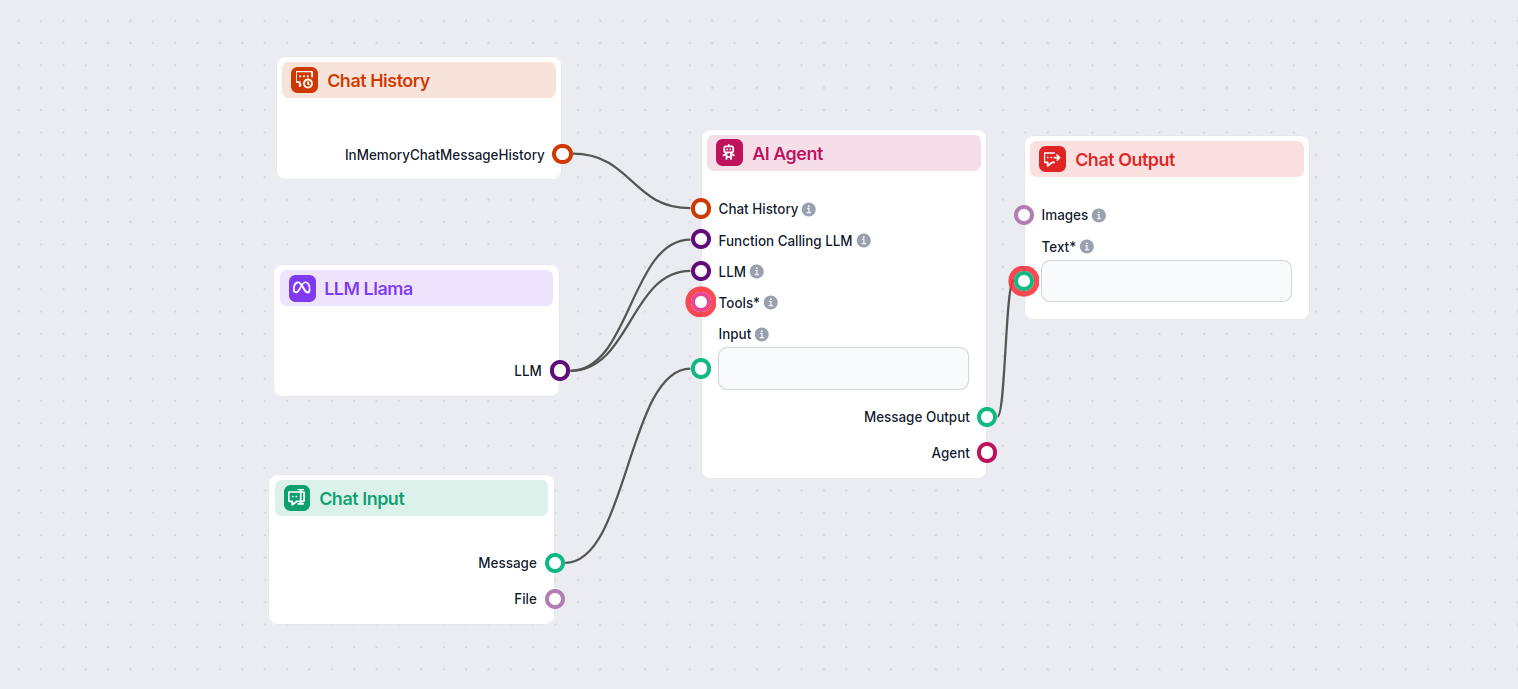

Bu, her türlü aracı oluşturmanıza olanak tanır. Şimdi bileşeni uygulamada görelim. İşte Meta AI’nın Llama 3.2 1B’sini yanıt üretmek için kullanan basit bir AI Ajan sohbet botu akışı. Bunu temel bir Llama sohbet botu olarak düşünebilirsiniz.

Bu basit Sohbet Botu Akışı şunları içerir:

LLM Meta AI bileşeni, Meta'nın Llama modellerini ve diğer metin/görsel üreticilerini akışlarınıza bağlamanızı sağlar; kolay model seçimi ve maksimum token ve sıcaklık gibi gelişmiş yapılandırmalar sunar.

FlowHunt, verimlilik, özetleme ve cihaz üzerinde dağıtımlar için optimize edilmiş Llama 3.2 1B ve 3B de dahil olmak üzere Meta'nın açık kaynak Llama modellerini destekler.

Her bir bileşen için FlowHunt panelinden maksimum token (yanıt uzunluğunu sınırlar), sıcaklık (yanıtın yaratıcılığını kontrol eder) ve model seçimi gibi ayarları doğrudan düzenleyebilirsiniz.

Hayır, LLM Meta AI bileşenini eklemek isteğe bağlıdır. Varsayılan olarak bileşenler ChatGPT-4o kullanır, ancak daha fazla kontrol veya özel kullanım senaryoları için Llama veya diğer modellere geçebilirsiniz.

Meta'nın Llama modelleri ve onlarca diğer AI üreticisiyle daha akıllı sohbet botları ve AI araçları oluşturmaya başlayın, hepsi tek bir platformda.

FlowHunt, xAI tarafından geliştirilen modeller de dahil olmak üzere onlarca metin üretim modelini destekler. xAI modellerini yapay zeka araçlarınızda ve sohbet ...

FlowHunt, Mistral tarafından geliştirilenler de dahil olmak üzere onlarca AI metin modelini destekler. Mistral'ı AI araçlarınızda ve sohbet botlarınızda nasıl k...

FlowHunt, Claude modelleri de dahil olmak üzere onlarca AI modeli destekler. Kendi ayarlanabilir yanıtlarınız için Claude'u AI araçlarınızda ve sohbet botlarını...