LLM Meta AI

FlowHunt, Meta'nın Llama modelleri de dahil olmak üzere onlarca metin üretim modelini destekler. Llama'yı AI araçlarınıza ve sohbet botlarınıza nasıl entegre ed...

FlowHunt üzerinde LLM Mistral, gelişmiş Mistral AI modellerinin sohbet botlarında ve AI araçlarında sorunsuz metin üretimi için esnek entegrasyonunu sağlar.

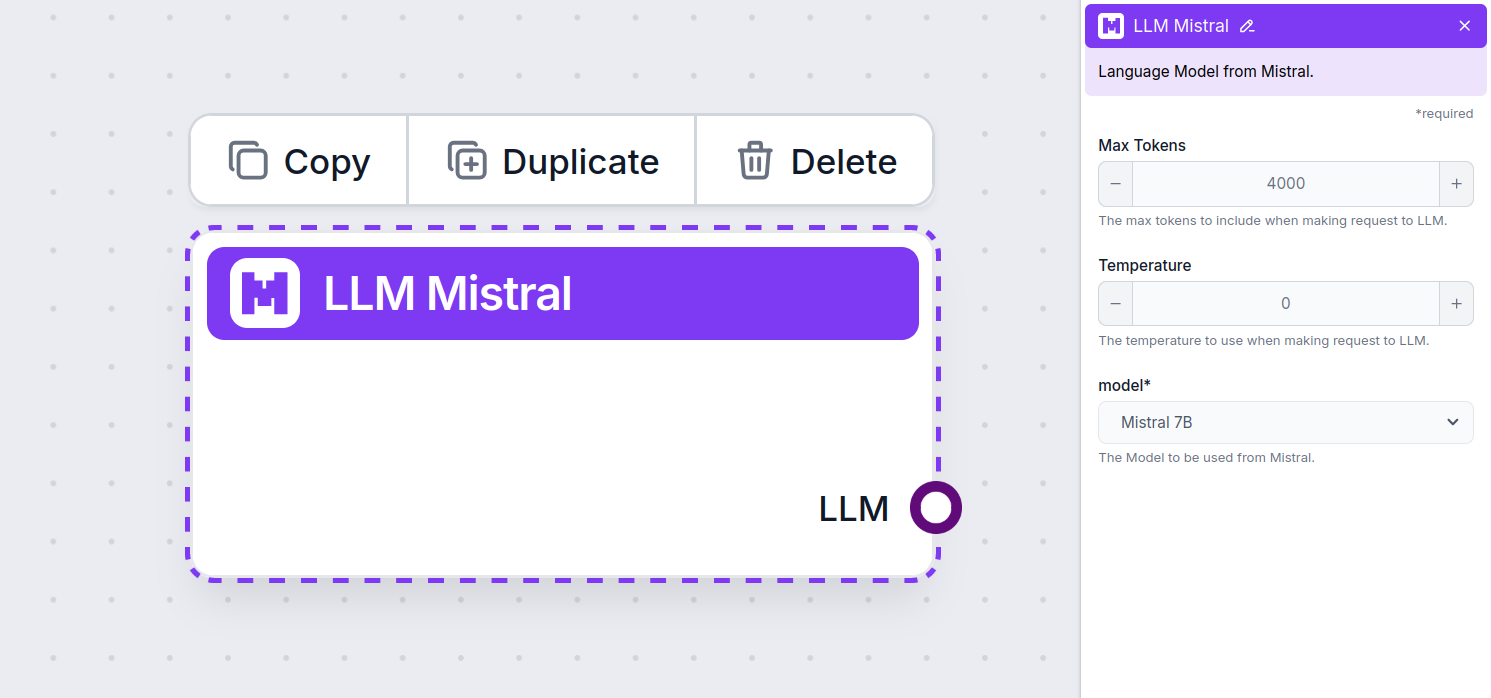

Bileşen açıklaması

LLM Mistral bileşeni, Mistral modellerini akışınıza bağlar. Gerçek büyünün gerçekleştiği yer Generatörler ve Ajanlar olsa da, LLM bileşenleri kullanılan modeli kontrol etmenizi sağlar. Tüm bileşenler varsayılan olarak ChatGPT-4 ile gelir. Modeli değiştirmek veya üzerinde daha fazla denetim sağlamak isterseniz bu bileşeni bağlayabilirsiniz.

Bir LLM Bileşenini bağlamanın isteğe bağlı olduğunu unutmayın. LLM kullanan tüm bileşenler varsayılan olarak ChatGPT-4o ile gelir. LLM bileşenleri, modeli değiştirmenize ve model ayarlarını kontrol etmenize olanak tanır.

Token’lar, modelin işlediği ve ürettiği metnin bireysel birimleridir. Token kullanımı modellere göre değişir ve tek bir token bir kelime, alt kelime veya tek bir karakter olabilir. Modeller genellikle milyonlarca token üzerinden fiyatlandırılır.

Maksimum token ayarı, tek bir etkileşim veya istekte işlenebilecek toplam token sayısını sınırlar ve yanıtların makul sınırlar içinde üretilmesini sağlar. Varsayılan sınır 4.000 token’dır; bu, belgeleri ve birkaç kaynağı özetleyip yanıt oluşturmak için ideal boyuttur.

Sıcaklık, yanıtların çeşitliliğini 0 ile 1 arasında kontrol eder.

0.1 sıcaklık, yanıtları çok direkt fakat potansiyel olarak tekrarlı ve yetersiz yapar.

1 gibi yüksek bir sıcaklık ise, yanıtlarda maksimum yaratıcılığa izin verir ama alakasız veya hatta uydurma yanıtlar üretme riski taşır.

Örneğin, bir müşteri hizmetleri botu için önerilen sıcaklık 0.2 ile 0.5 arasındadır. Bu seviye, yanıtların hem alakalı hem de doğal değişkenlikte olmasını sağlar.

Burası model seçicisidir. Burada Mistral’dan desteklenen tüm modelleri bulacaksınız. Şu anda aşağıdaki modelleri destekliyoruz:

LLM Mistral’ı Akışınıza Nasıl Ekleyebilirsiniz?

Tüm LLM bileşenlerinin yalnızca bir çıktı koluna sahip olduğunu fark edeceksiniz. Girdi, bileşenden geçmez; çünkü bu yalnızca modeli temsil eder, asıl üretim ise AI Ajanları ve Generatörlerde gerçekleşir.

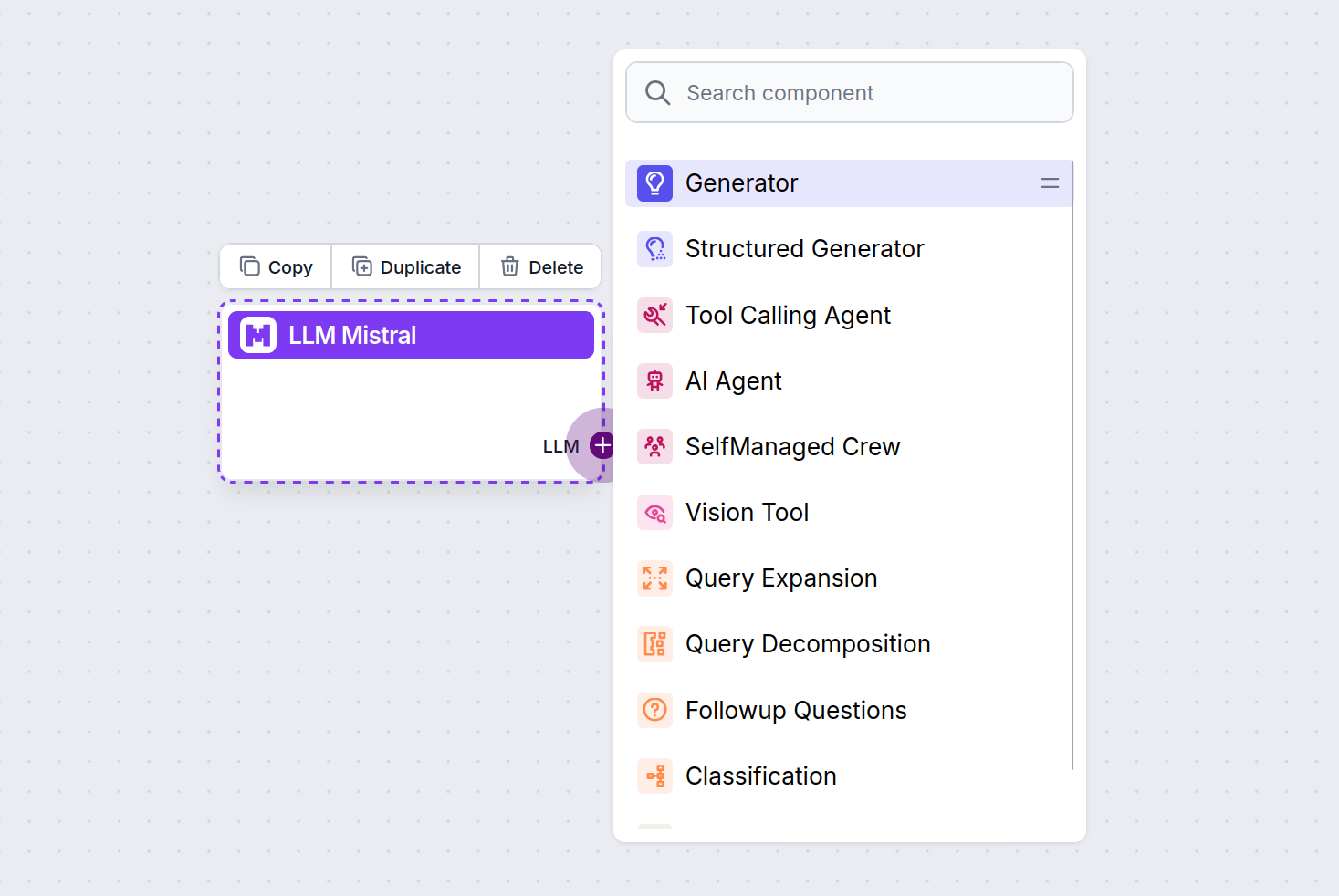

LLM kolu her zaman mor renktedir. LLM giriş kolu, AI kullanarak metin üreten veya veri işleyen herhangi bir bileşende bulunur. Kola tıklayarak seçenekleri görebilirsiniz:

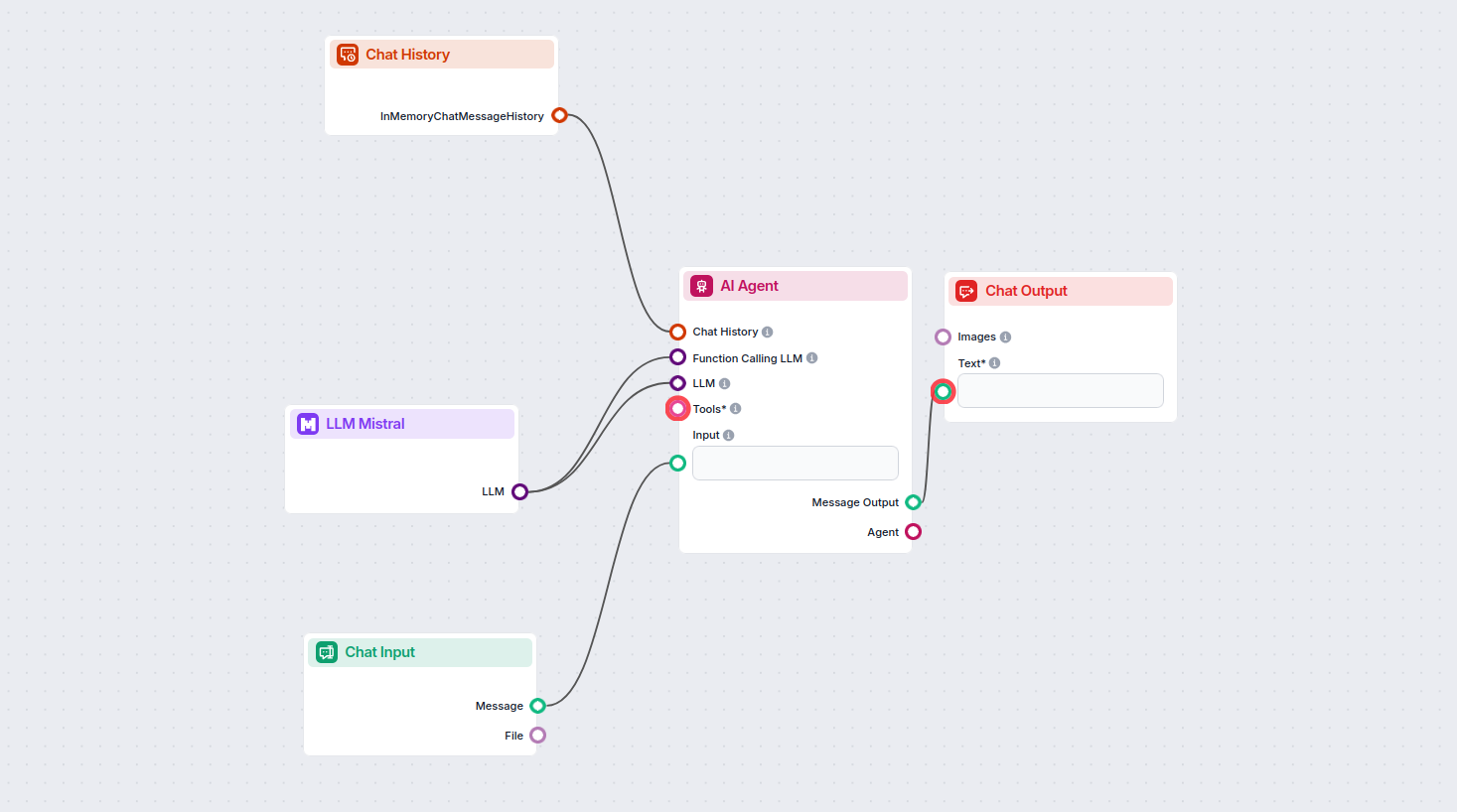

Bu sayede her türlü aracı oluşturabilirsiniz. Bileşeni çalışırken görelim. İşte Mistral 7B modelini yanıt üretmek için kullanan basit bir AI Ajanı sohbet botu Akışı. Bunu temel bir Mistral sohbet botu olarak düşünebilirsiniz.

Bu basit Sohbet Botu Akışı şunları içerir:

LLM Mistral bileşeni, Mistral AI modellerini FlowHunt projelerinize bağlamanızı sağlar ve sohbet botlarınız ile AI ajanlarınız için gelişmiş metin üretimi sunar. Modelleri değiştirmenize, ayarları kontrol etmenize ve Mistral 7B, Mixtral (8x7B) ve Mistral Large gibi modelleri entegre etmenize olanak tanır.

FlowHunt, Mistral 7B, Mixtral (8x7B) ve Mistral Large modellerini destekler; her biri farklı metin üretimi ihtiyaçları için çeşitli performans ve parametre düzeyleri sunar.

Maksimum token ve sıcaklık gibi ayarları düzenleyebilir, yanıt uzunluğunu, yaratıcılığı ve akışlarınız içindeki model davranışını kontrol etmek için desteklenen Mistral modelleri arasında seçim yapabilirsiniz.

Hayır, bir LLM Bileşenini bağlamak isteğe bağlıdır. Varsayılan olarak, FlowHunt bileşenleri ChatGPT-4o kullanır. Daha fazla kontrol istediğinizde veya belirli bir Mistral modelini kullanmak istediğinizde LLM Mistral bileşenini kullanın.

Mistral’ın güçlü dil modellerini, FlowHunt’un kodsuz platformuyla entegre ederek daha akıllı AI sohbet botları ve araçları oluşturmaya başlayın.

FlowHunt, Meta'nın Llama modelleri de dahil olmak üzere onlarca metin üretim modelini destekler. Llama'yı AI araçlarınıza ve sohbet botlarınıza nasıl entegre ed...

FlowHunt, Google Gemini de dahil olmak üzere onlarca yapay zeka modelini destekler. Gemini'yi yapay zeka araçlarınızda ve sohbet botlarınızda nasıl kullanacağın...

FlowHunt, devrim niteliğindeki DeepSeek modelleri de dahil olmak üzere onlarca yapay zeka modelini destekler. İşte DeepSeek'i yapay zeka araçlarınızda ve sohbet...