Sinir Ağları

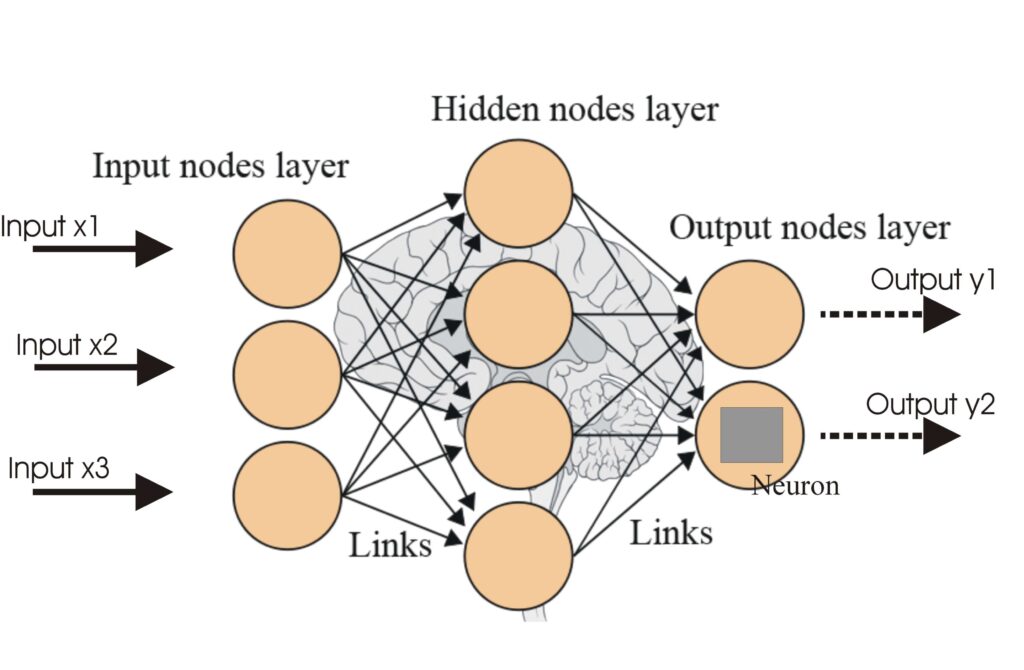

Bir sinir ağı ya da yapay sinir ağı (YSA), insan beyninden ilham alınarak oluşturulan, desen tanıma, karar verme ve derin öğrenme uygulamaları gibi görevlerde y...

Aktivasyon fonksiyonları, sinir ağlarında doğrusal olmayanlık katarak karmaşık kalıpların öğrenilmesini ve AI ile derin öğrenme uygulamaları için gerekli olan yetenekleri kazandırır.

Aktivasyon fonksiyonları, yapay sinir ağlarının (YSA) mimarisinin temelini oluşturur ve ağın karmaşık görevleri öğrenme ve yerine getirme yeteneğini büyük ölçüde etkiler. Bu sözlük makalesi, aktivasyon fonksiyonlarının amaçlarını, türlerini ve uygulamalarını; özellikle de AI, derin öğrenme ve sinir ağları alanındaki rollerini incelemektedir.

Bir sinir ağında aktivasyon fonksiyonu, bir nöronun çıktısına uygulanan matematiksel bir işlemdir. Nöronun etkin olup olmayacağını belirler ve modele doğrusal olmayanlık katarak ağın karmaşık kalıpları öğrenmesini sağlar. Bu fonksiyonlar olmadan, bir sinir ağı ne kadar derin veya kaç katmanlı olursa olsun, temelde doğrusal regresyon modeli gibi davranırdı.

Sigmoid Fonksiyonu

Tanh Fonksiyonu

ReLU (Düzeltilmiş Doğrusal Birim)

Leaky ReLU

Softmax Fonksiyonu

Swish Fonksiyonu

Aktivasyon fonksiyonları, çeşitli AI uygulamaları için vazgeçilmezdir:

Aktivasyon fonksiyonu, bir nöronun çıktısına uygulanan matematiksel bir işlemdir; doğrusal olmayanlık katar ve sinir ağlarının yalnızca doğrusal ilişkilerin ötesindeki karmaşık kalıpları öğrenmesini sağlar.

Aktivasyon fonksiyonları, sinir ağlarının karmaşık ve doğrusal olmayan problemleri çözmesini sağlar; bu da onları görüntü sınıflandırma, dil işleme ve otomasyon gibi görevler için hayati kılar.

Yaygın türler arasında Sigmoid, Tanh, ReLU, Leaky ReLU, Softmax ve Swish bulunur; her biri sinir ağlarının farklı katmanlarında kendine özgü özelliklere ve kullanım alanlarına sahiptir.

Yaygın zorluklar arasında (özellikle Sigmoid ve Tanh ile) kaybolan gradyan problemi, ölü ReLU ve Softmax gibi fonksiyonların gerçek zamanlı uygulamalarda hesaplama maliyeti yer alır.

Akıllı Chatbotlar ve AI araçları tek çatı altında. Fikirlerinizi otomatikleştirilmiş Akışlara dönüştürmek için sezgisel blokları birleştirin.

Bir sinir ağı ya da yapay sinir ağı (YSA), insan beyninden ilham alınarak oluşturulan, desen tanıma, karar verme ve derin öğrenme uygulamaları gibi görevlerde y...

Yapay Sinir Ağları (ANN'ler), insan beyninden esinlenmiş makine öğrenimi algoritmalarının bir alt kümesidir. Bu hesaplama modelleri, birlikte çalışarak karmaşık...

Yapay zekâda yakınsama, makine öğrenimi ve derin öğrenme modellerinin yinelemeli öğrenme yoluyla kararlı bir duruma ulaşma sürecini ifade eder; böylece öngörüle...