Giới thiệu

Hành trình từ việc xây dựng một nguyên mẫu AI hoạt động đến triển khai một hệ thống đạt chuẩn sản xuất từ lâu đã là một trong những thách thức lớn nhất của phát triển trí tuệ nhân tạo. Những gì có vẻ đơn giản trong các bản demo—truy xuất thông tin liên quan, bổ sung cho prompt, và tạo phản hồi—trở nên phức tạp gấp nhiều lần khi mở rộng quy mô cho môi trường sản xuất. Sự phức tạp này khiến nhiều người trong ngành gọi đây là “phép màu” thay vì kỹ thuật: một quá trình bí ẩn khi các lập trình viên thử nghiệm cấu hình, chỉnh tham số và hy vọng hệ thống tiếp tục hoạt động ổn định. Sự xuất hiện của kỹ thuật context như một chuyên ngành đã tạo nên sự chuyển dịch căn bản về cách xây dựng hệ thống AI, rời xa phương pháp thử-sai sang một lối tiếp cận kỹ thuật có hệ thống. Trong bài phân tích toàn diện này, chúng ta sẽ khám phá cách các cơ sở dữ liệu vector hiện đại cùng các nguyên lý kỹ thuật context đang thay đổi diện mạo phát triển ứng dụng AI, giúp các nhóm xây dựng hệ thống không chỉ hoạt động mà còn thực sự đáng tin cậy và dễ bảo trì ở quy mô lớn.

Kỹ Thuật Context Là Gì Và Vì Sao Nó Quan Trọng

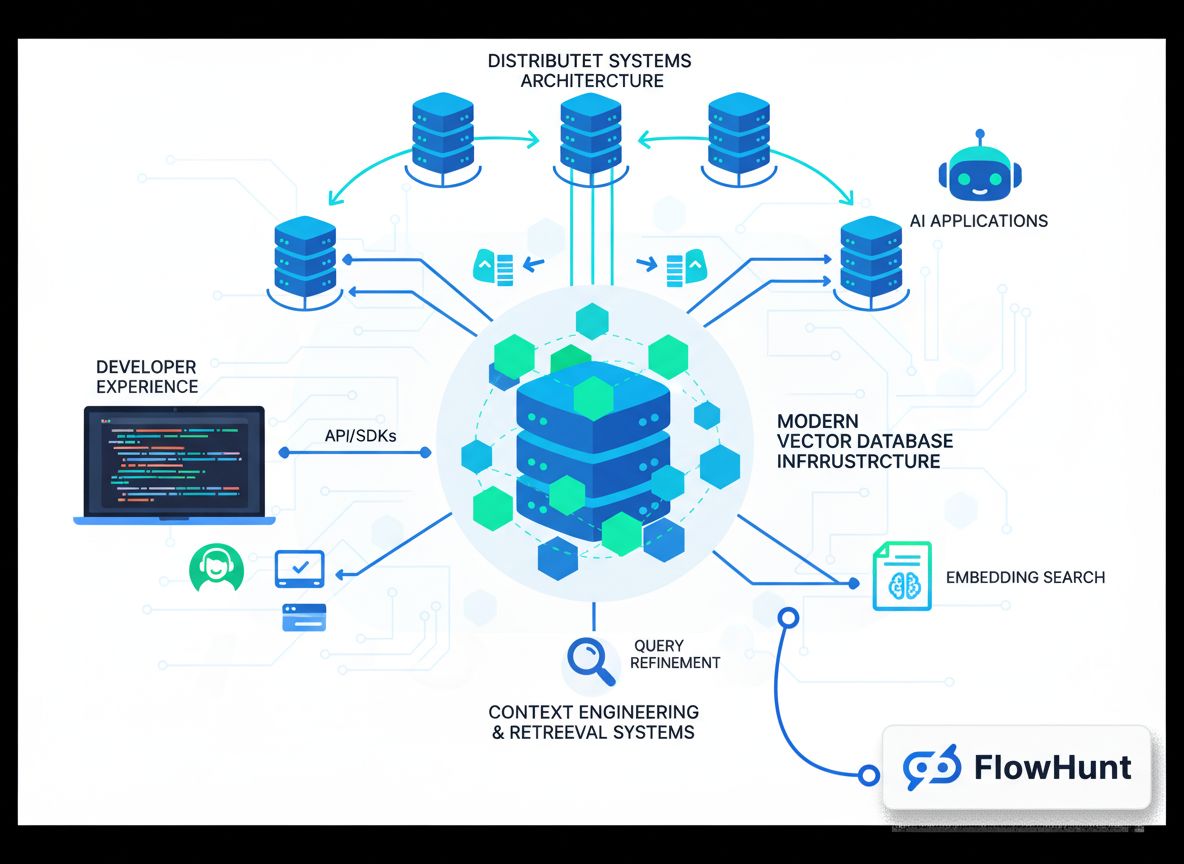

Kỹ thuật context đã nổi lên là một trong những chuyên ngành quan trọng nhất trong phát triển AI hiện đại, dù vẫn còn khá xa lạ với nhiều lập trình viên mới vào nghề. Về bản chất, kỹ thuật context là việc quản lý, tổ chức, và tối ưu hóa một cách có hệ thống thông tin ngữ cảnh mà hệ thống AI sử dụng để ra quyết định và tạo đầu ra. Khác với Truy xuất - Bổ sung Sinh (RAG) truyền thống, vốn tập trung hẹp vào truy xuất tài liệu liên quan để bổ sung vào prompt trước khi gửi tới mô hình ngôn ngữ, kỹ thuật context có cái nhìn rộng hơn về toàn bộ pipeline. Nó bao hàm cách dữ liệu luân chuyển trong hệ thống, cách lưu trữ và đánh chỉ mục, cách truy xuất, xếp hạng, lọc kết quả, và cuối cùng là cách context được trình bày cho mô hình. Góc nhìn tổng thể này nhận ra rằng chất lượng đầu ra của hệ thống AI bị giới hạn bởi chất lượng và mức độ liên quan của context mà nó nhận được. Khi context được quản lý kém—truy xuất thông tin không liên quan, bỏ sót chi tiết quan trọng, hoặc xử lý lặp lại thông tin—cả hệ thống sẽ bị suy giảm. Kỹ thuật context giải quyết các thách thức này bằng cách xem quản lý context là một vấn đề kỹ thuật hàng đầu, xứng đáng với sự kỹ lưỡng như hạ tầng trọng yếu khác.

Tầm quan trọng của kỹ thuật context trở nên rõ ràng khi bạn cân nhắc quy mô mà các hệ thống AI hiện đại vận hành. Một mô hình ngôn ngữ có thể được yêu cầu xử lý hàng trăm nghìn tài liệu, tổng hợp thông tin từ nhiều nguồn, và tạo phản hồi mạch lạc dựa trên tổng hợp đó. Nếu thiếu kỹ thuật context phù hợp, quá trình này sẽ trở nên hỗn loạn. Tài liệu không liên quan lấp đầy cửa sổ context, thông tin quan trọng bị chìm trong nhiễu, hiệu suất mô hình giảm sút. Hơn nữa, khi hệ thống AI ngày càng tinh vi và được triển khai ở các ứng dụng trọng yếu—từ chăm sóc khách hàng đến chẩn đoán y tế hay phân tích tài chính—hậu quả của việc kỹ thuật context kém sẽ nghiêm trọng hơn nhiều. Một hệ thống đôi khi trả về thông tin không liên quan có thể chấp nhận được cho mục đích giải trí, nhưng sẽ không thể chấp nhận nếu nó đưa ra quyết định ảnh hưởng tới cuộc sống, sinh kế của con người. Kỹ thuật context đảm bảo rằng thông tin chảy qua hệ thống không chỉ dồi dào mà còn thực sự liên quan, được tổ chức hợp lý và tối ưu cho nhiệm vụ cụ thể.

Sẵn sàng phát triển doanh nghiệp của bạn?

Bắt đầu dùng thử miễn phí ngay hôm nay và xem kết quả trong vài ngày.

Từ Demo Đến Sản Xuất: Bài Toán “Phép Màu”

Một trong những thách thức dai dẳng nhất của phát triển AI là cái được gọi là “khoảng cách từ demo đến sản xuất”. Xây dựng một nguyên mẫu minh họa khả năng AI khá đơn giản. Lập trình viên có thể nhanh chóng kết nối mô hình ngôn ngữ với hệ thống truy xuất đơn giản, tạo ra một sản phẩm ấn tượng trong môi trường kiểm soát. Nhưng khi hệ thống cần xử lý dữ liệu thực ở quy mô lớn, duy trì độ ổn định lâu dài, thích ứng với yêu cầu thay đổi, mọi thứ trở nên khó khăn gấp bội. Khoảng cách này lâu nay chỉ được lấp đầy bằng “phép màu”—một chuỗi thành phần bí ẩn: thử nghiệm cấu hình, chỉnh tham số và thử-sai cho đến khi hệ thống hoạt động. Vấn đề của cách này là không thể tái lập, không mở rộng được, và khó bảo trì. Khi hệ thống sản xuất gặp sự cố, thường rất khó xác định nguyên nhân và lại phải quay về vòng lặp “phép màu” cũ.

Nguyên do gốc rễ của bài toán này là phần lớn hạ tầng AI ban đầu không được thiết kế cho môi trường sản xuất. Những hệ thống truy xuất, cơ sở dữ liệu vector đầu tiên chỉ nhằm minh họa khả năng tìm kiếm ngữ nghĩa, truy xuất theo embedding. Chúng hoạt động tốt ở môi trường kiểm soát, dữ liệu nhỏ, truy vấn dự đoán trước. Nhưng khi mở rộng ra hàng triệu tài liệu, hàng nghìn người dùng đồng thời, truy vấn không đoán trước được, chúng thường sụp đổ. Tính nhất quán dữ liệu gặp vấn đề. Hiệu năng truy vấn suy giảm. Hệ thống khó debug, khó giám sát. Lập trình viên rơi vào trạng thái không còn là kỹ sư, mà là người quản lý một thực thể phức tạp, mong manh chỉ hoạt động nhờ may mắn và can thiệp liên tục. Đây chính là nơi kỹ thuật context hiện đại và hạ tầng chuyên biệt cho sản xuất phát huy vai trò. Khi xem quá trình từ demo đến sản xuất là một thách thức kỹ thuật thực sự, xây dựng hệ thống riêng cho tải sản xuất, chúng ta biến “phép màu” thành kỹ thuật đúng nghĩa.

Tìm Hiểu Hạ Tầng Tìm Kiếm Hiện Đại Cho AI

Hạ tầng tìm kiếm truyền thống—như Google và các công cụ tìm kiếm khác—được thiết kế với giả định cụ thể về cách tìm kiếm được sử dụng. Hệ thống này xử lý truy vấn dựa trên từ khóa từ người dùng, kết quả được đánh giá bởi con người và quyết định nhấp vào liên kết nào. Hạ tầng được tối ưu cho trường hợp này: so khớp từ khóa nhanh, thuật toán xếp hạng dựa trên tiêu chí con người, trình bày kết quả thành “10 liên kết xanh” dễ duyệt. Tuy nhiên, hệ thống AI có yêu cầu hoàn toàn khác. Khi một mô hình ngôn ngữ tiếp nhận kết quả tìm kiếm, nó không nhìn 10 liên kết—mà có thể xử lý lượng thông tin lớn hơn nhiều. Mô hình không cần kết quả định dạng cho con người; nó cần dữ liệu có cấu trúc để suy luận. Truy vấn không còn là từ khóa mà là ngữ nghĩa, dựa trên embedding và độ tương đồng vector. Sự khác biệt căn bản này khiến hạ tầng tìm kiếm truyền thống không còn phù hợp cho AI.

Hạ tầng tìm kiếm hiện đại phục vụ AI giải quyết các khác biệt này ở nhiều khía cạnh. Thứ nhất, công cụ và công nghệ hoàn toàn khác. Thay vì chỉ mục từ khóa và thuật toán xếp hạng cho con người, hệ thống hiện đại dùng embedding vector và đo độ tương đồng ngữ nghĩa. Thay vì dựa vào từ khóa rõ ràng, chúng hiểu ý nghĩa và mục đích của truy vấn. Thứ hai, mẫu công việc khác. Hạ tầng cũ xử lý truy vấn đơn giản, trả về ít kết quả. AI cần truy xuất hàng loạt tài liệu và xử lý tinh vi. Thứ ba, lập trình viên sử dụng cũng khác. Lập trình viên AI cần hệ thống dễ tích hợp, trải nghiệm tốt, không đòi hỏi kiến thức chuyên sâu về hạ tầng tìm kiếm. Cuối cùng, và quan trọng nhất, người tiêu dùng kết quả cũng khác. Tìm kiếm truyền thống, con người làm công đoạn cuối—chọn lọc, tổng hợp thông tin. Ở AI, mô hình ngôn ngữ đảm nhận vai trò này, có thể tiêu thụ lượng kết quả khổng lồ. Sự thay đổi căn bản này làm thay đổi toàn bộ thiết kế hạ tầng.

Tham gia bản tin của chúng tôi

Nhận các mẹo, xu hướng và ưu đãi mới nhất miễn phí.

FlowHunt Và Tương Lai Tự Động Hóa Quy Trình AI

Khi các tổ chức ngày càng nhận ra vai trò của kỹ thuật context và hạ tầng tìm kiếm hiện đại, bài toán đặt ra là tích hợp các khả năng này vào quy trình và phát triển hiện có. Đây là lúc nền tảng như FlowHunt xuất hiện, cung cấp môi trường hợp nhất để xây dựng, kiểm thử, triển khai ứng dụng AI dựa trên quản lý context và hệ thống truy xuất tinh vi. FlowHunt hiểu rằng kỹ thuật context không chỉ là chọn đúng cơ sở dữ liệu—mà là có đầy đủ công cụ, quy trình để quản lý context xuyên suốt vòng đời phát triển AI. Từ khâu tiếp nhận, đánh chỉ mục dữ liệu, tới truy xuất, xếp hạng, đến suy luận mô hình và sinh đầu ra, từng bước đều cần được sắp xếp, giám sát kỹ lưỡng. FlowHunt cung cấp khả năng tự động hóa giúp toàn bộ quy trình này liền mạch, cho phép lập trình viên tập trung xây dựng ứng dụng AI thay vì vật lộn với hạ tầng.

Cách tiếp cận tự động hóa kỹ thuật context của nền tảng đặc biệt giá trị cho nhóm xây dựng nhiều ứng dụng AI hoặc có pipeline truy xuất nhiều tầng phức tạp. Thay vì tự xây từng hạ tầng cho mỗi ứng dụng, nhóm phát triển có thể tận dụng sẵn các thành phần, quy trình của FlowHunt để tăng tốc. Nền tảng xử lý tự động các công việc tẻ nhạt như ingest dữ liệu, sinh embedding, quản lý chỉ mục, điều phối truy xuất, giúp lập trình viên tập trung vào phần đặc thù của ứng dụng. Ngoài ra, FlowHunt cung cấp khả năng quan sát, giám sát giúp dễ dàng hiểu luồng context trong hệ thống, nhận diện nút thắt, tối ưu hiệu suất. Sự kết hợp giữa tự động hóa và khả năng quan sát này biến kỹ thuật context từ một quá trình bí ẩn, nhiều thử-sai thành một chuyên ngành hệ thống, có thể đo lường.

Kiến Trúc Cơ Sở Dữ Liệu Vector Sẵn Sàng Sản Xuất

Xây dựng một cơ sở dữ liệu vector cho demo là một chuyện; xây dựng cái phục vụ tải sản xuất ổn định lại là chuyện khác. Cơ sở dữ liệu vector sản xuất phải xử lý nhiều người dùng đồng thời, đảm bảo nhất quán dữ liệu, lưu trữ bền vững và mở rộng mượt mà khi dữ liệu tăng. Nó cần dễ debug khi sự cố, dễ giám sát để hiểu hành vi hệ thống, dễ bảo trì để nhóm phát triển mở rộng dần theo thời gian. Những yêu cầu này dẫn tới các kiến trúc hiện đại kết hợp nguyên lý hệ thống phân tán đã được kiểm chứng qua nhiều thập kỷ.

Một trong các nguyên lý quan trọng nhất là tách biệt lưu trữ và tính toán. Ở cơ sở dữ liệu truyền thống, lưu trữ và tính toán gắn chặt—máy chủ vừa lưu trữ vừa xử lý truy vấn. Điều này gây nhiều vấn đề khi mở rộng. Cần tăng tính toán thì phải tăng lưu trữ, ngược lại cũng vậy—gây lãng phí tài nguyên, chi phí cao. Việc tách riêng giúp mỗi phần mở rộng độc lập: lưu trữ dùng giải pháp tiết kiệm như Amazon S3, tính toán mở rộng theo tải truy vấn. Kiến trúc này mang lại sự linh hoạt, tiết kiệm chi phí lớn. Một nguyên lý nữa là đa khách hàng (multi-tenancy), cho phép một phiên bản phục vụ nhiều ứng dụng, nhóm độc lập. Đa khách hàng đòi hỏi cách ly kỹ càng để dữ liệu, truy vấn không ảnh hưởng lẫn nhau, nhưng khi làm đúng sẽ tối ưu tài nguyên, giảm phức tạp vận hành.

Các cơ sở dữ liệu vector hiện đại còn áp dụng nguyên lý hệ thống phân tán tiêu chuẩn: tách đọc-ghi (read-write separation), sao chép không đồng bộ (asynchronous replication) để vừa bền vững dữ liệu vừa tối ưu tốc độ ghi, cơ chế đồng thuận phân tán để duy trì nhất quán trên nhiều nút. Kết hợp với các ngôn ngữ hiện đại như Rust—vừa hiệu năng vừa an toàn—giúp cơ sở dữ liệu đạt độ tin cậy và hiệu suất cần thiết cho sản xuất. Kết quả là hạ tầng không còn cảm giác “phép màu”—mà là kỹ thuật thực thụ.

Cách Tiếp Cận Trải Nghiệm Lập Trình Viên Của Chroma

Khi Chroma được thành lập, đội ngũ đã có quan điểm rõ ràng: khoảng cách giữa demo AI và triển khai sản xuất cảm giác giống “phép màu” hơn là kỹ thuật và cần được lấp đầy. Hướng tiếp cận là tập trung tối đa vào trải nghiệm lập trình viên. Thay vì xây hệ thống nhiều tính năng hay cực kỳ mở rộng, họ tập trung làm cho lập trình viên dễ dàng bắt đầu với cơ sở dữ liệu vector và tìm kiếm ngữ nghĩa nhất. Điều này tạo nên điểm đặc biệt của Chroma: cài đặt chỉ với một lệnh pip, sử dụng ngay không cần cấu hình phức tạp hay dựng hạ tầng rườm rà. Sự đơn giản này là cuộc cách mạng trong lĩnh vực cơ sở dữ liệu vector, khi hầu hết các hệ thống khác đòi hỏi thiết lập phức tạp mới có thể truy vấn cơ bản. Chroma loại bỏ rào cản này, giúp lập trình viên thử nghiệm vector và tìm kiếm ngữ nghĩa chỉ trong vài phút.

Cam kết trải nghiệm lập trình viên còn mở rộng vượt ra thiết lập ban đầu. Nhóm Chroma đầu tư mạnh để đảm bảo hệ thống hoạt động ổn định trên nhiều kiến trúc, môi trường triển khai khác nhau. Ban đầu, người dùng chạy Chroma trên đủ loại máy—từ máy chủ Linux chuẩn tới Arduino, Power PC. Thay vì bỏ qua các trường hợp này, đội ngũ Chroma nỗ lực đảm bảo hệ thống hoạt động trên tất cả. Cam kết về khả năng tương thích, ổn định này xây dựng niềm tin và thúc đẩy Chroma phát triển nhanh. Họ nhận ra rằng trải nghiệm lập trình viên không chỉ là dễ dùng—mà còn là sự ổn định, nhất quán, và khả năng hệ thống hoạt động như mong đợi trên mọi môi trường.

Khi Chroma phát triển lên Chroma Cloud, đội ngũ đối mặt với quyết định then chốt. Họ có thể tung ra bản hosted của sản phẩm đơn nút nhanh chóng, tận dụng nhu cầu thị trường về dịch vụ vector database quản lý. Nhiều công ty đã chọn con đường này, huy động được nhiều vốn và tạo tiếng vang lớn. Nhưng Chroma lại lựa chọn khác. Họ nhận ra rằng chỉ đơn giản host sản phẩm đơn nút dưới dạng dịch vụ không đáp ứng chuẩn trải nghiệm lập trình viên. Một sản phẩm cloud thực sự phải được thiết kế từ đầu với nguyên lý cloud-native, mang lại sự dễ dùng, ổn định như bản đơn nút, nhưng cũng đáp ứng khả năng mở rộng, tin cậy cho sản xuất. Quyết định này khiến họ mất nhiều thời gian hơn để phát triển Chroma Cloud, nhưng kết quả là một sản phẩm thực sự biến kỹ thuật context thành kỹ thuật đúng nghĩa, không còn là “phép màu”.

Bốn Khía Cạnh “AI” Trong Hạ Tầng Tìm Kiếm Hiện Đại

Khi nói về hạ tầng tìm kiếm cho AI, cần nhận ra “AI” mang ý nghĩa khác nhau ở từng ngữ cảnh. Có bốn khía cạnh riêng biệt mà hạ tầng tìm kiếm hiện đại khác biệt với hệ thống truyền thống, và hiểu rõ là chìa khóa để xây dựng ứng dụng AI hiệu quả. Đầu tiên là công nghệ. Công cụ, công nghệ dùng cho hạ tầng tìm kiếm mới hoàn toàn khác cũ. Thay cho chỉ mục đảo và so khớp từ khóa, hệ thống dùng embedding vector, đo độ tương đồng ngữ nghĩa. Thay vì xếp hạng dựa trên TF-IDF, dùng mạng nơ-ron và thuật toán xếp hạng học được. Khác biệt này phản ánh bản chất vấn đề và khả năng vượt trội của AI hiện đại.

Thứ hai là mẫu công việc. Hệ thống cũ thiết kế cho truy vấn đơn giản, không trạng thái, trả về ít kết quả. AI hiện đại cần pipeline truy xuất nhiều tầng, nhiều lượt xếp hạng, lọc, tái xếp hạng; có thể cần truy xuất hàng nghìn tài liệu và xử lý tinh vi. Mẫu công việc khác nhau, hạ tầng phải thiết kế lại mới đáp ứng hiệu quả. Thứ ba là lập trình viên. Hệ thống tìm kiếm truyền thống thường do kỹ sư chuyên sâu về truy xuất thông tin, hạ tầng search đảm nhiệm. Lập trình viên AI hiện đại thường là người đa năng, không có chuyên môn sâu về search nhưng vẫn cần xây dựng ứng dụng dựa vào truy xuất tinh vi. Do đó, hạ tầng mới phải dễ dùng, dễ tiếp cận, không chỉ mạnh mẽ, linh hoạt.

Khía cạnh thứ tư và có lẽ quan trọng nhất là người tiêu dùng kết quả tìm kiếm. Hệ thống cũ, con người là người dùng cuối. Con người chỉ tiếp nhận được giới hạn—thường khoảng 10 liên kết—và làm công đoạn tổng hợp, đánh giá liên quan cuối cùng. Trong AI hiện đại, mô hình ngôn ngữ là người tiêu dùng, có thể xử lý lượng kết quả lớn hơn con người rất nhiều. Mô hình dễ dàng tổng hợp hàng trăm, nghìn tài liệu cùng lúc. Khác biệt căn bản này làm thay đổi toàn bộ thiết kế hạ tầng: thuật toán xếp hạng tối ưu cho máy thay vì người; trình bày kết quả tối ưu cho máy xử lý thay vì con người đọc; cả pipeline có thể giả định AI sẽ làm công đoạn cuối cùng.

Xây Dựng Và Duy Trì Tầm Nhìn Trong Thị Trường Ồn Ào

Năm 2023, thị trường cơ sở dữ liệu vector là một trong những phân khúc nóng nhất của hạ tầng AI. Nhiều công ty gọi vốn khủng, tạo tiếng vang lớn, chạy đua xây hệ thống nhiều tính năng nhất. Trong môi trường đó, Chroma hoàn toàn có thể mất tập trung, chạy theo mọi xu hướng, cố trở thành “tất cả cho mọi người”. Thay vào đó, nhóm chọn duy trì tầm nhìn cốt lõi: xây dựng engine truy xuất cho ứng dụng AI, mang lại trải nghiệm lập trình viên vượt trội và thực sự lấp đầy khoảng cách demo-sản xuất. Sự tập trung này đòi hỏi kỷ luật, lòng tin mạnh mẽ, đặc biệt khi đối thủ gọi vốn lớn, làm truyền thông rầm rộ.

Chìa khóa để giữ vững tầm nhìn là có luận điểm rõ ràng, khác biệt về điều quan trọng. Nhóm Chroma tin rằng điều thực sự quan trọng không phải là số tính năng hay vốn huy động, mà là chất lượng trải nghiệm lập trình viên và độ tin cậy của hệ thống. Họ tin rằng chỉ cần làm một thứ thật xuất sắc—engine truy xuất—là đủ để mở rộng sang lĩnh vực khác sau này. Triết lý tập trung tối đa vào một năng lực cốt lõi này không chỉ riêng Chroma, nhưng ngày càng hiếm trong thế giới startup, nơi áp lực tăng trưởng nhanh dễ làm các công ty “ôm đồm”. Việc Chroma kiên định với triết lý này, dù khiến họ mất nhiều thời gian xây Chroma Cloud và có thể bỏ lỡ cơ hội ngắn hạn, về lâu dài lại là bước đi đúng.

Duy trì tầm nhìn còn đòi hỏi chú trọng tuyển dụng, xây dựng đội ngũ. Người bạn tuyển quyết định văn hóa tổ chức, văn hóa quyết định bạn xây dựng gì và xây dựng thế nào. Chroma nhận ra điều này, chọn tuyển chậm, sàng lọc kỹ từng thành viên mới. Thay vì tăng trưởng nhanh, họ tập trung tuyển người đồng điệu tầm nhìn, quan tâm đến chất lượng, có thể tự chủ và thực hiện công việc ở mức cao. Cách tuyển dụng này giúp đội ngũ tăng chậm hơn, nhưng đảm bảo mọi người đều thực sự cam kết với sứ mệnh và đóng góp ý nghĩa. Sự đồng thuận văn hóa này khó đạt ở startup tăng trưởng nhanh, nhưng lại là yếu tố sống còn để giữ vững tầm nhìn lâu dài.

Vai Trò Của Sự Chăm Chút Và Chất Lượng Trong Hạ Tầng

Một trong những điểm nổi bật nhất ở cách tiếp cận của Chroma là nhấn mạnh vào sự chăm chút và chất lượng. Trong lĩnh vực hạ tầng, dễ rơi vào bẫy “càng nhiều tính năng, hiệu năng, mở rộng càng tốt”. Nhưng Chroma nhận ra điều thực sự quan trọng là xây dựng hệ thống vận hành ổn định, dễ dùng, và giải quyết đúng vấn đề của lập trình viên. Sự chăm chút, chất lượng thể hiện ở nhiều khía cạnh: chọn viết Chroma bằng Rust (vừa hiệu năng vừa an toàn) thay vì ngôn ngữ tiện nhưng kém tin cậy; cam kết hệ thống hoạt động trên nhiều kiến trúc, môi trường dù kỳ lạ; quyết định đầu tư thêm thời gian xây Chroma Cloud kỹ lưỡng thay vì vội vàng ra mắt.

Sự chăm chút này còn thể hiện ở cách họ nhìn nhận vấn đề. Thay vì xem kỹ thuật context là bài toán kỹ thuật hẹp, giải bằng thuật toán khéo léo, họ coi đó là thách thức rộng lớn—bao gồm trải nghiệm lập trình viên, độ tin cậy, khả năng mở rộng, bảo trì. Góc nhìn tổng thể này giúp giải pháp tốt hơn vì nhận ra rằng hệ thống chỉ mạnh bằng mắt xích yếu nhất. Một hệ thống có thuật toán truy xuất tối tân nhất nhưng khó dùng, không ổn định ở sản xuất thì cũng không giải quyết được vấn đề thực sự. Bằng việc đặt chất lượng, sự chăm chút lên tất cả các khía cạnh, Chroma đã xây dựng được một thứ thực sự hữu ích cho lập trình viên, thực sự lấp đầy khoảng cách demo và sản xuất.

Ý Nghĩa Thực Tiễn Cho Nhóm Phát Triển AI

Đối với nhóm phát triển ứng dụng AI, các bài học từ Chroma có nhiều ý nghĩa thực tiễn. Đầu tiên, cần nhận ra kỹ thuật context không phải việc phụ—mà là trọng tâm. Chất lượng hệ thống AI bị giới hạn bởi chất lượng context nhận được, nên đầu tư vào hạ tầng context tốt là bắt buộc, không phải tùy chọn. Thứ hai, nên dè dặt với các hệ thống “làm mọi thứ”. Các hệ thống đáng tin cậy, hiệu quả nhất thường chỉ làm một việc xuất sắc trước rồi mới mở rộng. Khi cân nhắc cơ sở dữ liệu vector, hệ thống truy xuất, hãy chọn thứ có trọng tâm rõ ràng, cam kết làm tốt nhất một việc. Thứ ba, trải nghiệm lập trình viên rất quan trọng. Một hệ thống lý thuyết mạnh nhưng khó dùng cũng kém giá trị hơn hệ thống dễ dùng. Vì lập trình viên sẽ thực sự dùng hệ thống dễ, xây được nhiều thứ tuyệt vời, còn hệ thống khó dùng thì dễ bỏ cuộc.

Thứ tư, độ tin cậy, nhất quán quan trọng hơn bạn nghĩ. Giai đoạn đầu phát triển AI, dễ ưu tiên tính năng, hiệu năng hơn độ tin cậy. Nhưng khi hệ thống vào sản xuất, xử lý tải lớn, độ tin cậy là số một. Một hệ thống chỉ 95% tin cậy nghe có vẻ ổn, nhưng chạy hàng triệu truy vấn/ngày thì 5% lỗi là hàng trăm nghìn truy vấn thất bại. Đầu tư vào độ tin cậy từ đầu rẻ hơn nhiều so với sửa chữa về sau. Cuối cùng, hãy nghĩ dài hạn về lộ trình hệ thống. Hạ tầng bạn chọn hôm nay sẽ quyết định bạn xây được gì ngày mai. Chọn hạ tầng thiết kế sẵn cho sản xuất, mở rộng mượt, cung cấp khả năng quan sát tốt sẽ mang lại lợi ích lâu dài khi hệ thống phát triển.

{{ cta-dark-panel

heading=“Thúc Đẩy Quy Trình Làm Việc Với FlowHunt”

description=“Trải nghiệm FlowHunt tự động hóa toàn bộ quy trình nội dung và SEO AI—từ nghiên cứu, tạo nội dung, xuất bản đến phân tích—tất cả tại một nơi.”

ctaPrimaryText=“Đặt lịch demo”

ctaPrimaryURL=“https://calendly.com/liveagentsession/flowhunt-chatbot-demo"

ctaSecondaryText=“Dùng thử miễn phí”

ctaSecondaryURL=“https://app.flowhunt.io/sign-in"

gradientStartColor="#123456”

gradientEndColor="#654321”

gradientId=“827591b1-ce8c-4110-b064-7cb85a0b1217”

}}

Vai Trò Của Mã Nguồn Mở Trong Xây Dựng Niềm Tin Và Cộng Đồng

Một trong những quyết định quan trọng nhất của Chroma là mở mã nguồn sản phẩm lõi. Quyết định này mang lại nhiều hệ quả tích cực. Thứ nhất, nó xây dựng niềm tin với cộng đồng lập trình viên. Khi lập trình viên có thể xem code, hiểu cách hệ thống vận hành, đóng góp cải tiến, họ sẽ tin tưởng và chấp nhận hệ thống hơn. Mã nguồn mở tạo ra chu trình tích cực: cộng đồng đóng góp cải tiến sản phẩm, thu hút thêm người dùng, dẫn tới thêm đóng góp mới. Thứ hai, mã nguồn mở xây dựng cộng đồng mạnh quanh Chroma. Lập trình viên sử dụng sản phẩm sẽ gắn bó với thành công của nó, sẵn lòng đóng góp, phản hồi, giới thiệu cho người khác. Cộng đồng này trở thành tài sản quý giá mà đối thủ khó sao chép.

Thứ ba, mã nguồn mở tạo lộ trình tự nhiên để kiếm tiền qua dịch vụ hosted. Khi mở mã nguồn sản phẩm lõi, Chroma tạo điều kiện để lập trình viên tự host miễn phí, nhưng nhiều người sẽ thích sử dụng bản dịch vụ quản lý—được vận hành, mở rộng, bảo trì trọn gói. Đây chính là mô hình Chroma Cloud. Bằng cách cung cấp trải nghiệm hosted vượt trội nhưng vẫn giữ lõi mở nguồn, Chroma phục vụ cả cộng đồng tự host lẫn thị trường dịch vụ quản lý. Cách tiếp cận này bền vững, phù hợp với sở thích lập trình viên hơn là giữ sản phẩm lõi đóng.

Đo Lường Thành Công: Những Chỉ Số Đáng Giá

Khi đánh giá thành công các dự án hạ tầng như Chroma, cần tập trung vào chỉ số phản ánh giá trị thực sự. Chroma đạt được các chỉ số ấn tượng: hơn 21,000 sao GitHub, hơn 5 triệu lượt tải về mỗi tháng, trên 60-70 triệu lượt tải tổng cộng. Những con số này thể hiện mức độ phổ biến rộng rãi trong cộng đồng lập trình viên. Nhưng quan trọng hơn, là hệ thống có thực sự giải quyết vấn đề của lập trình viên không: giúp xây dựng ứng dụng AI dễ hơn? Giảm thời gian, công sức từ demo đến sản xuất? Giúp xây dựng hệ thống đáng tin cậy hơn? Câu trả lời dường như là có, nhìn từ phản hồi cộng đồng và tốc độ ứng dụng nhanh chóng.

Một chỉ số quan trọng khác là chất lượng cộng đồng và bản chất đóng góp. Chroma thu hút sự đóng góp từ lập trình viên toàn ngành, bao gồm tích hợp với các framework phổ biến như LangChain, Llama Index. Việc Chroma trở thành lựa chọn mặc định cho chức năng vector database trong nhiều framework AI là minh chứng cho chất lượng sản phẩm và sức mạnh cộng đồng. Những chỉ số định tính—mức độ chấp nhận cộng đồng, tích hợp với công cụ khác, phản hồi tích cực—nhiều khi còn ý nghĩa hơn số lượng tải về thô.

Tương Lai Của Kỹ Thuật Context Và Hạ Tầng AI

Khi hệ thống AI ngày càng tinh vi, được triển khai rộng rãi, vai trò của kỹ thuật context sẽ ngày càng lớn. Những gì xây dựng hôm nay mới chỉ là khởi đầu. Trong tương lai, chúng ta sẽ thấy các cách quản lý context tinh vi hơn: hệ thống tự điều chỉnh context theo nhiệm vụ, học hỏi từ phản hồi để nâng chất lượng truy xuất, xử lý đa phương tiện (văn bản, hình ảnh, âm thanh, video) liền mạch. Hạ tầng để hỗ trợ những hệ thống tiến bộ này sẽ còn phải hiện đại hơn nữa, nhưng các nguyên lý cơ bản vẫn giữ nguyên: tập trung trải nghiệm lập trình viên, cam kết chất lượng, độ tin cậy và duy trì tầm nhìn rõ ràng về vấn đề cần giải quyết.

Vai trò của các nền tảng như FlowHunt cũng ngày càng lớn. Khi kỹ thuật context trở thành trung tâm phát triển AI, các nhóm sẽ cần công cụ dễ dàng xây dựng, kiểm thử, triển khai pipeline quản lý context phức tạp. Cách tiếp cận của FlowHunt—tự động hóa và cung cấp khả năng quan sát toàn vòng đời phát triển AI—giúp đáp ứng tốt nhu cầu này. Bằng cách trừu tượng hóa độ phức tạp của hạ tầng context và cung cấp công cụ mức cao để xây dựng ứng dụng AI, các nền tảng như FlowHunt cho phép lập trình viên tập trung xây dựng sản phẩm ưu việt thay vì vật lộn với hạ tầng.

Kết Luận

Kỹ thuật context đại diện cho sự chuyển dịch căn bản về cách xây dựng hệ thống AI: từ thử-sai, “phép màu” sang một chuyên ngành kỹ thuật có hệ thống. Các cơ sở dữ liệu vector hiện đại như Chroma, xây dựng trên nguyên lý tách biệt lưu trữ - tính toán, đa khách hàng, kiến trúc phân tán… chính là nền móng cho sự chuyển dịch này. Kết hợp các cải tiến hạ tầng với cam kết về trải nghiệm lập trình viên, độ tin cậy, chất lượng, các nhóm phát triển có thể xây dựng hệ thống AI thực sự vận hành được ở sản xuất, mở rộng ổn định khi nhu cầu tăng. Bài học từ cách làm của Chroma—duy trì tầm nhìn cốt lõi, tuyển đúng người, đặt chất lượng lên trên số lượng, xây dựng cộng đồng qua mã nguồn mở—là lộ trình quý báu cho các dự án hạ tầng khác và cả các nhóm phát triển ứng dụng AI. Khi lĩnh vực AI tiếp tục phát triển, trưởng thành, làm đúng kỹ thuật context sẽ ngày càng quan trọng—trở thành một trong những trọng tâm cho bất kỳ ai xây dựng hệ thống AI.