Dữ Liệu Tổng Hợp

Dữ liệu tổng hợp đề cập đến thông tin được tạo ra một cách nhân tạo nhằm mô phỏng dữ liệu thực tế. Nó được tạo ra bằng các thuật toán và mô phỏng máy tính để th...

Tìm hiểu cách tích hợp và quản trị dữ liệu phi cấu trúc chuyển đổi dữ liệu doanh nghiệp thành bộ dữ liệu sẵn sàng cho AI, nâng cao độ chính xác cho hệ thống RAG và các agent thông minh ở quy mô lớn.

Thành công của các agent AI hiện đại phụ thuộc vào một yếu tố then chốt nhưng thường bị bỏ qua: chất lượng và khả năng truy cập dữ liệu làm nền tảng cho chúng. Trong khi các tổ chức đầu tư mạnh mẽ vào các mô hình ngôn ngữ tiên tiến và thuật toán phức tạp, nút thắt thực sự lại nằm ở cách họ xử lý dữ liệu doanh nghiệp. Hơn 90% dữ liệu doanh nghiệp tồn tại dưới dạng phi cấu trúc—hợp đồng, PDF, email, bản ghi, hình ảnh, âm thanh và video—nhưng chưa đến 1% trong số này thực sự được ứng dụng vào các dự án AI sinh ngữ hiện nay. Đây vừa là thách thức lớn, vừa là cơ hội phi thường. Sự khác biệt giữa hệ thống AI bị “ảo giác” và cung cấp câu trả lời thiếu chính xác với những hệ thống đưa ra phản hồi đáng tin cậy, có ngữ cảnh, thường nằm ở khả năng tích hợp, quản trị và khai thác dữ liệu phi cấu trúc. Trong hướng dẫn toàn diện này, chúng ta sẽ khám phá cách tích hợp và quản trị dữ liệu phi cấu trúc phối hợp để khai phá “mỏ vàng” dữ liệu doanh nghiệp, giúp xây dựng các AI agent và hệ thống RAG (retrieval-augmented generation) không chỉ thông minh mà còn đáng tin cậy và tuân thủ quy định.

Vấn đề cốt lõi mà các doanh nghiệp ngày nay đối mặt là phần lớn dữ liệu giá trị của họ tồn tại ở những định dạng mà hệ thống truyền thống không được thiết kế để xử lý. Khác với dữ liệu cấu trúc lưu trữ trong cơ sở dữ liệu—nơi thông tin được sắp xếp thành hàng và cột gọn gàng—dữ liệu phi cấu trúc lại phân tán trên nhiều hệ thống, không thống nhất về định dạng và thường lẫn thông tin nhạy cảm. Một hợp đồng có thể chứa thông tin nhận diện cá nhân (PII) xen lẫn các điều khoản kinh doanh quan trọng. Một chuỗi email có thể ẩn quyết định quan trọng trong những trao đổi xã giao. Bản ghi hỗ trợ khách hàng có thể tiết lộ cảm xúc và mức độ hài lòng ẩn giấu trong ngôn ngữ tự nhiên. Sự đa dạng và phức tạp này khiến dữ liệu phi cấu trúc vừa là tài sản giá trị nhất, vừa là thách thức lớn nhất cho doanh nghiệp. Khi đội ngũ kỹ thuật dữ liệu cố gắng xử lý thủ công những nội dung này, họ phải mất hàng tuần cho các công việc tẻ nhạt: rà soát tài liệu rời rạc, nhận diện và loại bỏ thông tin nhạy cảm, tự viết các script để chuẩn bị dữ liệu cho hệ thống AI. Cách làm thủ công này không chỉ tốn thời gian mà còn dễ sai sót, tạo điểm nghẽn khiến doanh nghiệp khó mở rộng sáng kiến AI. Thách thức càng tăng khi phải đáp ứng yêu cầu tuân thủ—doanh nghiệp phải đảm bảo xử lý đúng thông tin nhạy cảm, theo dõi nguồn gốc dữ liệu để kiểm toán và kiểm soát truy cập đúng quyền hạn cho người dùng cũng như agent AI.

Nhiều tổ chức cho rằng các thất bại của AI agent là do mô hình yếu hoặc thiếu tài nguyên tính toán. Thực tế, nguyên nhân chủ yếu là do hạ tầng dữ liệu chưa đạt yêu cầu. Một mô hình ngôn ngữ tiên tiến chỉ tốt khi nó truy cập và suy luận được trên nguồn thông tin chất lượng. Khi AI agent không truy cập được dữ liệu doanh nghiệp sạch, tổ chức, nó phải dựa vào tri thức chung cài sẵn trong dữ liệu huấn luyện—hoặc tệ hơn, đưa ra phỏng đoán dễ dẫn đến “ảo giác”. Dữ liệu công khai—những gì có trên internet—đã nằm trong các mô hình nền tảng, nên điểm khác biệt cạnh tranh thực sự của doanh nghiệp nằm ở khả năng khai phá, sử dụng dữ liệu riêng của mình. Hãy hình dung một AI agent dịch vụ khách hàng cần trả lời về chính sách, thông số sản phẩm hoặc lịch sử khách hàng. Nếu không được truy cập tài liệu nội bộ đã tích hợp và quản trị đúng cách, agent không thể cung cấp câu trả lời chính xác, có ngữ cảnh. Nó dễ tạo ra thông tin nghe hợp lý nhưng sai lệch, ảnh hưởng đến niềm tin khách hàng và uy tín thương hiệu. Tương tự, một hệ thống AI phân tích rủi ro tuân thủ trong hợp đồng hoặc nhận diện mô hình vận hành từ báo cáo thực địa cũng cần dữ liệu sạch, tổ chức tốt và phân loại đúng. Khoảng cách giữa “có dữ liệu” và “có dữ liệu sử dụng được” chính là nơi mà hầu hết doanh nghiệp vấp phải. Đây cũng là lý do tích hợp và quản trị dữ liệu phi cấu trúc không chỉ là tính năng bổ sung mà là thành phần thiết yếu của mọi chiến lược AI nghiêm túc.

Cơ sở dữ liệu vector đánh dấu thay đổi căn bản về cách doanh nghiệp lưu trữ và truy xuất thông tin phục vụ ứng dụng AI. Khác với cơ sở dữ liệu truyền thống dựa vào khớp từ khóa, cơ sở dữ liệu vector làm việc với embeddings—biểu diễn số học đa chiều của văn bản, hình ảnh hoặc nội dung khác, phản ánh ý nghĩa ngữ nghĩa. Khi một tài liệu được chuyển thành embedding, nó trở thành một điểm trong không gian nhiều chiều, nơi các tài liệu tương đồng sẽ gần nhau. Điều này cho phép tìm kiếm ngữ nghĩa: truy tìm thông tin dựa trên ý nghĩa thay vì từ khóa chính xác. Ví dụ, truy vấn về “phúc lợi nhân viên” có thể trả về tài liệu về “gói lương thưởng” hoặc “kế hoạch bảo hiểm y tế” vì các khái niệm này gần nhau về ý nghĩa dù không cùng từ khóa. Cơ sở dữ liệu vector là nền tảng cho hệ thống RAG—tiêu chuẩn vàng xây dựng AI agent cần truy cập tri thức doanh nghiệp. Trong hệ thống RAG, khi người dùng đặt câu hỏi, hệ thống đầu tiên tìm kiếm trong cơ sở dữ liệu vector những tài liệu hoặc đoạn liên quan, sau đó cung cấp ngữ cảnh đó cho mô hình ngôn ngữ để sinh ra đáp án chính xác, sát thực. Quy trình hai bước—truy xuất rồi sinh đáp án—giúp tăng độ chính xác vượt trội so với chỉ hỏi mô hình dựa vào dữ liệu huấn luyện. Cơ sở dữ liệu vector đóng vai trò “bộ nhớ ngoài” của tổ chức, cho phép AI agent truy cập, suy luận trên thông tin nội bộ, cập nhật mà không cần huấn luyện lại mô hình nền. Kiến trúc này đặc biệt hữu ích khi xây dựng trợ lý đặc thù lĩnh vực, chatbot hỗ trợ khách hàng, hệ thống quản lý tri thức nội bộ luôn cập nhật thông tin thay đổi liên tục.

Tích hợp dữ liệu phi cấu trúc là quá trình chuyển hóa nội dung thô, lộn xộn thành bộ dữ liệu có cấu trúc, đọc được bằng máy để phục vụ hệ thống AI. Có thể hình dung đây là mở rộng nguyên tắc pipeline ETL (Extract, Transform, Load) vốn là xương sống của kho dữ liệu truyền thống sang một dạng mới: tài liệu, email, chat, âm thanh và video. Nếu pipeline ETL truyền thống tự động hóa nhập, xử lý và chuẩn bị dữ liệu cấu trúc từ cơ sở dữ liệu, API, thì pipeline tích hợp dữ liệu phi cấu trúc xử lý được đa dạng định dạng nội dung ở quy mô lớn. Sức mạnh của phương pháp này nằm ở tự động hóa và tính lặp lại. Những gì trước đây cần hàng tuần viết code riêng lẻ và bảo trì thủ công, nay chỉ mất vài phút với các bộ kết nối và tác vụ dựng sẵn. Pipeline tích hợp dữ liệu phi cấu trúc điển hình gồm ba giai đoạn chính: lấy dữ liệu, chuyển đổi và nạp.

Lấy dữ liệu bắt đầu từ việc kết nối đến các nguồn lưu trữ nội dung phi cấu trúc. Nền tảng tích hợp hiện đại cung cấp các bộ kết nối dựng sẵn đến hệ thống doanh nghiệp như SharePoint, Box, Slack, kho file, hệ thống email, v.v. Không cần viết code tùy chỉnh cho từng nguồn, các bộ kết nối này tự động xử lý xác thực, phân trang, trích xuất dữ liệu. Nhờ vậy, kỹ sư dữ liệu tập trung vào logic nghiệp vụ thay vì xử lý hạ tầng. Giai đoạn lấy dữ liệu cũng xử lý thách thức ban đầu là phát hiện dữ liệu phi cấu trúc phân tán trong toàn doanh nghiệp—một vấn đề không nhỏ với các tổ chức lớn có tài liệu rải rác khắp nơi.

Chuyển đổi là nơi trí tuệ thực sự phát huy tác dụng. Tài liệu thô được xử lý qua chuỗi các tác vụ dựng sẵn giải quyết bài toán phổ biến. Tách văn bản giúp đọc nội dung từ PDF, ảnh và định dạng khác. Loại bỏ trùng lặp nhận diện và xóa tài liệu trùng, tránh phân tích sai lệch hoặc lãng phí lưu trữ. Gắn nhãn ngôn ngữ xác định ngôn ngữ nội dung, hỗ trợ đa ngữ. Loại bỏ thông tin nhận diện cá nhân (PII) nhằm tuân thủ quy định bảo mật. Chia nhỏ tài liệu (chunking) thành các đoạn có nghĩa, phù hợp cửa sổ ngữ cảnh của mô hình AI và tối ưu cho cơ sở dữ liệu vector. Cuối cùng, vector hóa chuyển các đoạn này thành embedding—biểu diễn số học mà cơ sở dữ liệu vector yêu cầu. Tất cả diễn ra tự động, không đòi hỏi chuyên môn machine learning chuyên sâu từ đội kỹ thuật.

Nạp dữ liệu đưa embedding đã xử lý vào cơ sở dữ liệu vector, nơi chúng sẵn sàng cho AI agent, hệ thống RAG, mô hình phân loại tài liệu, tìm kiếm thông minh và các ứng dụng AI khác. Kết quả là pipeline tự động hoàn toàn, xử lý khối lượng lớn nội dung đa dạng và cung cấp ngay cho hệ thống AI.

Một tính năng mạnh mẽ của tích hợp dữ liệu phi cấu trúc hiện đại là xử lý delta. Khi tài liệu thay đổi, hệ thống chỉ cập nhật phần thay đổi (delta) thay vì chạy lại toàn bộ pipeline, giúp tiết kiệm tài nguyên và đảm bảo pipeline luôn cập nhật dữ liệu mới ở quy mô lớn. Với các tổ chức có kho tài liệu khổng lồ và thường xuyên thay đổi, hiệu suất này mang tính cách mạng.

Bảo mật và kiểm soát truy cập được tích hợp ngay trong lớp tích hợp. Các danh sách kiểm soát truy cập (ACL) gốc được duy trì xuyên suốt pipeline, đảm bảo người dùng và AI agent chỉ truy cập được nội dung đúng quyền hạn, rất quan trọng cho tuân thủ ngành và quản trị dữ liệu trong các tổ chức có cấu trúc phân quyền phức tạp. Khi tài liệu bị giới hạn ở hệ thống nguồn, các hạn chế đó sẽ được bảo toàn suốt pipeline và trong cơ sở dữ liệu vector, đảm bảo thực thi quyền truy cập nhất quán.

Tích hợp giúp dữ liệu sử dụng được, còn quản trị giúp dữ liệu trở nên đáng tin cậy. Quản trị dữ liệu phi cấu trúc không chỉ dừng lại ở việc chuyển dữ liệu đến hệ thống AI, mà còn đảm bảo dữ liệu có thể tra cứu, tổ chức tốt, phân loại đúng và tuân thủ chính sách tổ chức cũng như quy định pháp lý. Nếu dữ liệu cấu trúc từ lâu đã có các giải pháp quản trị (catalog, theo dõi nguồn gốc, giám sát chất lượng), dữ liệu phi cấu trúc cũng cần hạ tầng quản trị riêng biệt phù hợp với đặc thù của nó.

Một hệ thống quản trị dữ liệu phi cấu trúc toàn diện thường gồm nhiều thành phần then chốt. Khám phá tài sản và kết nối bắt đầu từ việc nhận diện toàn bộ tài sản phi cấu trúc trong doanh nghiệp bằng các bộ kết nối dựng sẵn. Điều này tạo ra inventory đầy đủ vị trí của dữ liệu phi cấu trúc—bước đầu rất nhiều tổ chức gặp khó. Trích xuất và làm giàu thực thể chuyển đổi file thô thành dữ liệu có cấu trúc, có thể phân tích bằng cách nhận diện các thực thể như tên, ngày tháng, chủ đề và thông tin quan trọng khác. Pipeline enrichment phân loại nội dung, đánh giá chất lượng, bổ sung metadata ngữ cảnh. Tài liệu có thể được gắn nhãn chủ đề (ví dụ “hợp đồng”, “phản hồi khách hàng”, “đặc tả sản phẩm”), người liên quan, kết quả phân tích cảm xúc, hoặc thuộc tính khác. Metadata này giúp tổ chức, tra cứu, hiểu nội dung dễ dàng hơn.

Xác thực và đảm bảo chất lượng giúp tin cậy dữ liệu. Kết quả hiển thị ở bảng xác thực đơn giản với quy tắc và cảnh báo cấu hình được để gắn cờ metadata không chắc chắn. Nếu hệ thống phân loại hoặc trích xuất còn nghi ngờ, nó sẽ đưa thông tin cho người kiểm duyệt, ngăn dữ liệu rác lọt vào hệ thống AI. Cách tiếp cận có con người trong vòng lặp này cân bằng tự động hóa và độ chính xác.

Quy trình và catalog hóa đưa tài sản đã xác thực vào catalog trung tâm, nâng cao tổ chức và khả năng tra cứu. Với metadata kỹ thuật và bối cảnh, người dùng có thể tìm kiếm, lọc thông minh trên mọi tài sản. Một nhà phân tích dữ liệu tìm hợp đồng liên quan nhà cung cấp cụ thể, hay nhân viên tuân thủ tìm văn bản nhắc đến quy định nào đó, đều có thể truy lục nhanh chóng thay vì mò mẫm hàng nghìn file.

Theo dõi nguồn gốc và kiểm toán lưu lại toàn bộ quá trình di chuyển, chuyển đổi tài liệu từ nguồn đến đích, giúp minh bạch và truy xuất dữ liệu. Điều này đặc biệt quan trọng cho tuân thủ, giúp tổ chức chứng minh đã xử lý dữ liệu đúng quy trình và bảo vệ thông tin nhạy cảm. Trong các ngành bị kiểm soát, audit trail này có thể quyết định việc vượt qua hay không một cuộc kiểm toán.

Kết hợp các thành phần quản trị này tạo nền tảng niềm tin cho dữ liệu. Đội kỹ thuật dữ liệu có thể cung cấp bộ dữ liệu cấu trúc, đáng tin cậy, cho phép mô hình AI đưa ra đáp án chính xác mà vẫn đảm bảo tuân thủ quy định và chính sách tổ chức.

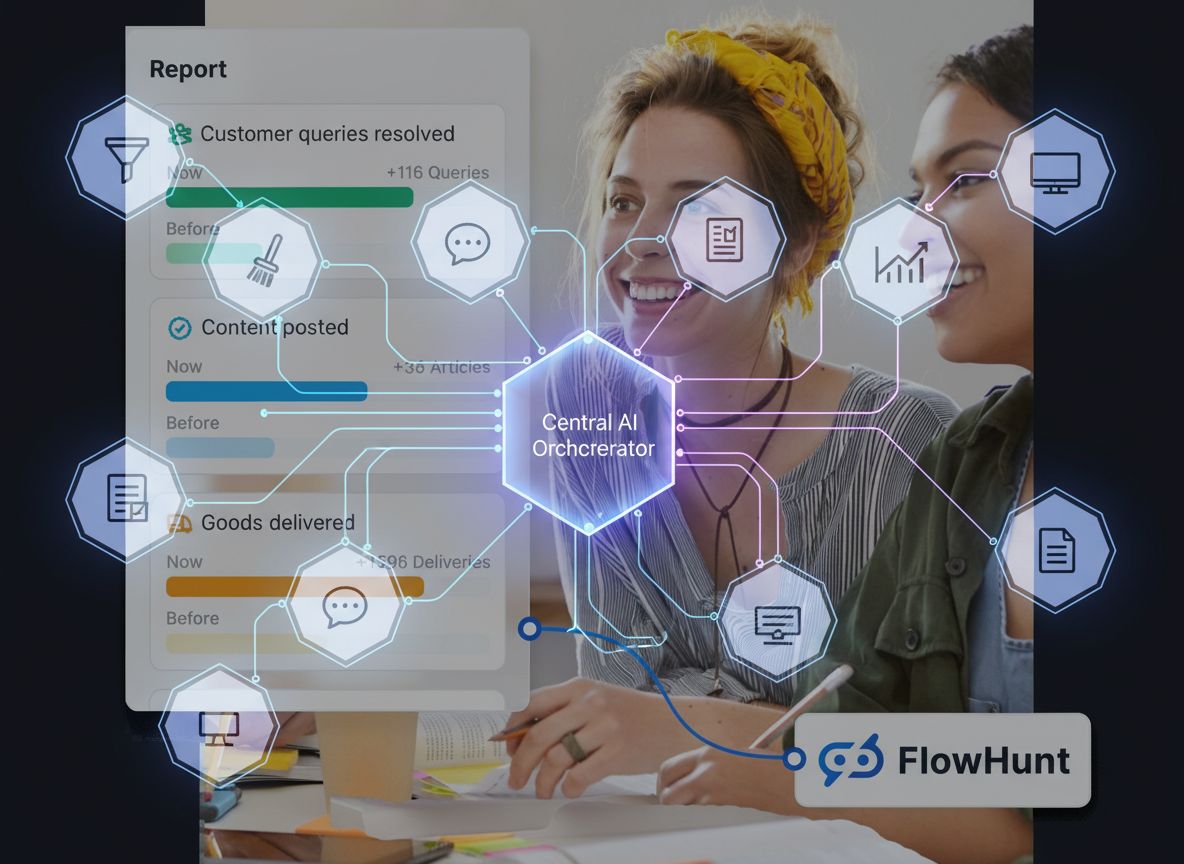

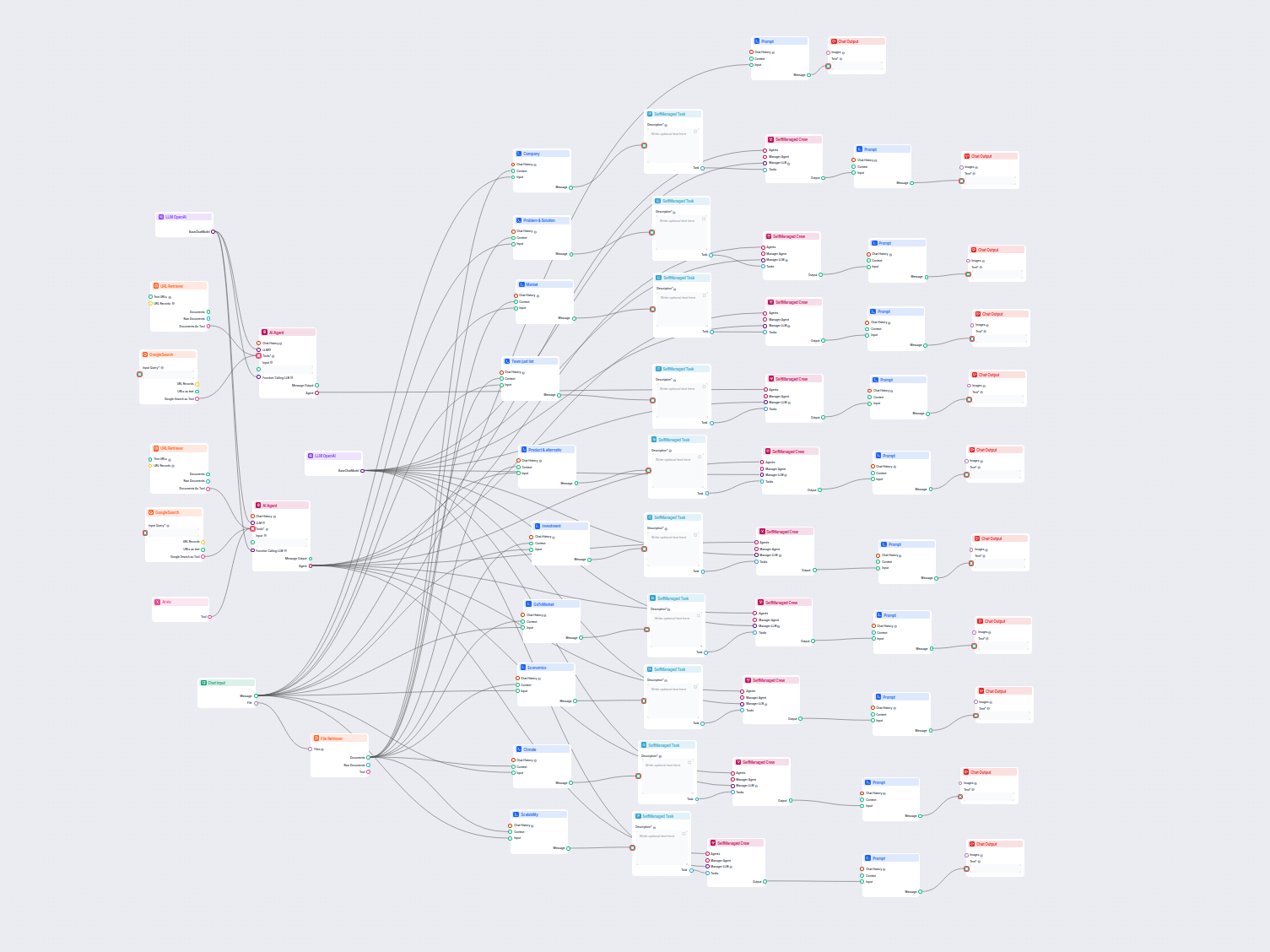

FlowHunt nhận ra điểm nghẽn lớn trong áp dụng AI doanh nghiệp nằm ở giao điểm giữa tích hợp và quản trị dữ liệu phi cấu trúc. Bằng cách tự động hóa cả khía cạnh kỹ thuật lẫn quản trị, FlowHunt giúp tổ chức xây dựng hệ thống AI cấp sản xuất mà không mất hàng tuần chuẩn bị dữ liệu thủ công như truyền thống. Cách tiếp cận của FlowHunt kết hợp tích hợp dữ liệu thông minh với quản trị toàn diện, cho phép đội dữ liệu tập trung vào giá trị kinh doanh thay vì lo vận hành hạ tầng. Nền tảng cung cấp bộ kết nối dựng sẵn tới hệ thống doanh nghiệp, tác vụ chuyển đổi tự động, quy trình quản trị cấu hình được mà không cần kiến thức kỹ thuật sâu. Việc dân chủ hóa quản lý dữ liệu phi cấu trúc này giúp mọi tổ chức, dù quy mô nào, cũng có thể tận dụng dữ liệu doanh nghiệp để “nuôi” AI agent và hệ thống RAG. Bằng cách rút ngắn thời gian từ dữ liệu thô đến bộ dữ liệu sẵn sàng cho AI từ hàng tuần xuống chỉ vài phút, FlowHunt giúp tổ chức tăng tốc sáng kiến AI và chuyển đổi từ thử nghiệm sang hệ thống sản xuất nhanh hơn bao giờ hết.

Sức mạnh thực sự xuất hiện khi tích hợp và quản trị dữ liệu phi cấu trúc phối hợp nhịp nhàng. Tích hợp giúp dữ liệu sử dụng được, quản trị giúp dữ liệu đáng tin cậy. Cùng nhau, chúng thu hẹp khoảng cách độ tin cậy từng là rào cản lớn nhất của AI doanh nghiệp. Hãy xem ví dụ thực tế: một công ty tài chính muốn xây dựng AI agent hỗ trợ nhân viên thẩm định tín dụng bằng cách phân tích tài liệu khách hàng, báo cáo tài chính và thư từ lịch sử. Nếu thiếu tích hợp và quản trị, sẽ cần hàng tháng làm thủ công: trích xuất văn bản từ PDF, loại bỏ thông tin nhạy cảm, tổ chức tài liệu theo khách hàng và thời gian, xác thực dữ liệu đầy đủ, chính xác. Với pipeline dữ liệu phi cấu trúc đã tích hợp và quản trị, mọi thứ đều tự động. Tài liệu được lấy từ nhiều nguồn, xử lý loại bỏ PII, chia nhỏ, vector hóa. Lớp quản trị đảm bảo phân loại đúng, đã loại bỏ thông tin nhạy cảm, chỉ nhân viên được phân quyền mới truy cập thông tin khách hàng cụ thể. Embedding kết quả được nạp vào cơ sở dữ liệu vector, nơi AI agent có thể truy xuất tức thì. Khi agent nhận truy vấn về khách hàng nào đó, nó tìm kiếm trong cơ sở dữ liệu vector các tài liệu phù hợp nhất về mặt ngữ nghĩa, dùng ngữ cảnh đó để sinh ra đánh giá rủi ro chính xác. Toàn bộ quy trình từng mất hàng tháng nay diễn ra trong thời gian thực, đầy đủ tuân thủ và kiểm toán.

Kiến trúc này còn mở ra nhiều ứng dụng giá trị ngoài AI agent. Nhóm phân tích và báo cáo có thể khai thác các cuộc gọi khách hàng để nhận diện xu hướng cảm xúc mà không cần nghe hàng nghìn giờ ghi âm. Nhóm tuân thủ rà soát hợp đồng, truy vết rủi ro pháp lý. Nhóm vận hành phân tích báo cáo thực địa để nhận diện mô hình, khắc phục thiếu sót. Nhóm chăm sóc khách hàng phát hiện khách hàng rủi ro bằng cách phân tích các tương tác hỗ trợ. Mọi trường hợp này đều khả thi khi dữ liệu phi cấu trúc được tích hợp và quản trị đúng.

Chuyển từ chuẩn bị dữ liệu thủ công sang pipeline tự động hóa là thay đổi căn bản trong cách tiếp cận AI doanh nghiệp. Trước đây, các dự án AI thường tuân theo một mô hình: chuyên gia dữ liệu xây dựng thử nghiệm ấn tượng trong môi trường kiểm soát, nhưng khi mở rộng ra thực tế lại cần nguồn lực lớn để xử lý độ phức tạp, tuân thủ và quy mô dữ liệu. Khoảng cách giữa thử nghiệm và sản xuất là rào cản lớn của AI, nhiều tổ chức nhận thấy chi phí, độ phức tạp khi chuyển từ proof-of-concept sang hệ thống thực tế vượt quá giá trị mong đợi.

Tích hợp và quản trị dữ liệu phi cấu trúc tự động thay đổi hẳn cán cân này. Bằng cách xử lý tự động thách thức hạ tầng dữ liệu, các nền tảng này cho phép tổ chức chuyển ngay từ thử nghiệm sang sản xuất. Pipeline dùng cho thử nghiệm có thể mở rộng thành pipeline sản xuất, chỉ cần điều chỉnh quy mô. Sự liên tục này giúp giảm rủi ro, tăng tốc thời gian thu lợi, giúp dự án AI khả thi hơn về kinh tế. Doanh nghiệp giờ có thể đầu tư AI dựa trên thời gian hoàn vốn nhanh và chi phí triển khai thấp.

Lợi thế cạnh tranh còn ở tốc độ và chi phí. Doanh nghiệp tận dụng được dữ liệu phi cấu trúc sẽ có insight và năng lực mà đối thủ thiếu hạ tầng không thể bắt kịp. Một AI agent trả lời chính xác về chính sách, sản phẩm, lịch sử khách hàng là công cụ mạnh mẽ cho dịch vụ khách hàng, bán hàng và quản lý tri thức nội bộ. Hệ thống tuân thủ tự động quét hợp đồng phát hiện rủi ro là lực lượng hỗ trợ cho pháp chế. Hệ thống phân tích khai phá insight từ tương tác khách hàng là nguồn tình báo cạnh tranh. Những năng lực này cộng dồn theo thời gian, tạo khoảng cách ngày càng lớn giữa tổ chức có hạ tầng dữ liệu bài bản và những ai không đầu tư đúng mức.

Một trong những lý do chính khiến doanh nghiệp e ngại đưa dữ liệu phi cấu trúc vào AI là nguy cơ lộ thông tin nhạy cảm. Một pipeline thiết kế kém có thể vô tình rò rỉ dữ liệu khách hàng, lộ bí mật kinh doanh, hoặc vi phạm quy định bảo mật. Vì vậy, an ninh và tuân thủ phải được tích hợp ngay từ đầu vào hạ tầng dữ liệu, không phải bổ sung sau này.

Các nền tảng tích hợp dữ liệu phi cấu trúc hiện đại giải quyết lo ngại này bằng nhiều cơ chế. Loại bỏ PII tự động nhận diện, che mờ thông tin nhạy cảm như tên, số an sinh xã hội, thẻ tín dụng, dữ liệu cá nhân khác. Danh sách kiểm soát truy cập đảm bảo quyền hạn được bảo toàn suốt pipeline, tài liệu bị giới hạn ở hệ thống nguồn vẫn bị giới hạn ở cơ sở dữ liệu vector. Theo dõi nguồn gốc dữ liệu tạo audit trail minh bạch quá trình xử lý, di chuyển dữ liệu, giúp đội tuân thủ chứng minh dữ liệu được xử lý đúng cách. Mã hóa bảo vệ dữ liệu cả khi truyền và lưu trữ. Giám sát tuân thủ có thể cảnh báo tài liệu hoặc tác vụ nào đó có nguy cơ vi phạm chính sách tổ chức hoặc quy định.

Các tính năng an ninh, tuân thủ này không chỉ là tiện ích bổ sung—chúng là bắt buộc với doanh nghiệp hoạt động trong ngành tài chính, y tế, chính phủ. Thậm chí với mọi tổ chức xử lý dữ liệu khách hàng, khi các quy định như GDPR, CCPA ngày càng nghiêm ngặt. Nhờ tích hợp tuân thủ vào hạ tầng dữ liệu, tổ chức có thể tự tin khai thác dữ liệu phi cấu trúc cho AI mà không lo vi phạm pháp lý hoặc rò rỉ dữ liệu.

Ứng dụng thực tiễn của dữ liệu phi cấu trúc được tích hợp, quản trị tốt là rất lớn, rộng khắp mọi ngành, mọi chức năng. Nhóm dịch vụ, hỗ trợ khách hàng có thể xây dựng AI agent truy cập tức thì tài liệu sản phẩm, lịch sử khách, ticket hỗ trợ—giúp phản hồi nhanh và chính xác hơn. Nhóm bán hàng dùng AI agent tra cứu nhanh tình báo đối thủ, thông tin khách hàng, mẫu đề xuất, rút ngắn quy trình bán hàng. Nhóm pháp chế, tuân thủ dùng AI quét hợp đồng, phát hiện rủi ro, đảm bảo tuân thủ quy định. Nhân sự dùng AI phân tích phản hồi nhân viên, nhận diện xu hướng, cải thiện môi trường làm việc. Vận hành dùng AI phân tích báo cáo thực địa, tìm ra bất cập, tối ưu quy trình. Nghiên cứu phát triển dùng AI tìm kiếm tài liệu kỹ thuật, bằng sáng chế, bài báo để tránh lặp lại công việc.

Ở mọi trường hợp, giá trị không đến từ bản thân mô hình AI mà từ chất lượng, khả năng truy cập dữ liệu mà mô hình tiếp cận. Một mô hình ngôn ngữ phức tạp nhưng dữ liệu kém chất lượng, thiếu truy cập vẫn cho kết quả kém. Ngược lại, mô hình đơn giản nhưng có dữ liệu chất lượng, tổ chức tốt, quản trị chuẩn sẽ tạo ra insight, năng lực giá trị.

Khi doanh nghiệp tiếp tục đầu tư AI, thành công sẽ thuộc về tổ chức nhận ra AI chỉ thành công khi dữ liệu thành công. Mô hình, thuật toán tiên tiến nhất cũng vô nghĩa nếu thiếu dữ liệu chất lượng, đáng tin cậy. Đó là lý do tích hợp và quản trị dữ liệu phi cấu trúc đã trở thành năng lực thiết yếu cho mọi tổ chức muốn đi sâu vào AI.

Lộ trình phía trước gồm nhiều bước then chốt. Đầu tiên, doanh nghiệp cần đánh giá thực trạng hiện tại: dữ liệu phi cấu trúc ở đâu, định dạng nào, rào cản lớn nhất là gì? Thứ hai, đầu tư hạ tầng: triển khai nền tảng, công cụ tự động tích hợp và quản trị dữ liệu phi cấu trúc ở quy mô lớn. Thứ ba, xây dựng năng lực tổ chức: đào tạo đội dữ liệu sử dụng công cụ mới, thiết lập quy trình quản trị đảm bảo chất lượng và tuân thủ. Thứ tư, bắt đầu với các trường hợp giá trị cao: chọn dự án AI cụ thể mang lại giá trị kinh doanh rõ ràng làm điểm chứng minh, từ đó mở rộng đầu tư. Cuối cùng, lặp lại và mở rộng quy mô: học hỏi từ từng dự án, mở rộng dần phạm vi AI khi tự tin và năng lực tăng lên.

Tổ chức đi đúng lộ trình này sẽ có lợi thế cạnh tranh lớn. Họ xây dựng hệ thống AI nhanh hơn, rủi ro thấp hơn, tin tưởng hơn về độ chính xác, tuân thủ. Họ khai phá insight từ dữ liệu mà đối thủ không tiếp cận được. Họ chuyển từ thử nghiệm AI sang hệ thống sản xuất chỉ trong vài tháng thay vì nhiều năm. Và họ làm được tất cả mà vẫn đảm bảo tiêu chuẩn an ninh, tuân thủ, quản trị dữ liệu mà doanh nghiệp hiện đại đòi hỏi.

Trải nghiệm FlowHunt tự động hóa tích hợp và quản trị dữ liệu phi cấu trúc—từ nhập, chuyển đổi đến nạp và tuân thủ—giúp bạn xây dựng AI agent và hệ thống RAG sản xuất chỉ trong vài phút thay vì hàng tuần.

Cuộc cách mạng AI doanh nghiệp sẽ không dành cho tổ chức sở hữu mô hình tinh vi nhất, mà thuộc về ai có hạ tầng dữ liệu tốt nhất. Hơn 90% dữ liệu doanh nghiệp là phi cấu trúc, nhưng hiện chưa tới 1% dữ liệu này được đưa vào hệ thống AI. Đây vừa là thách thức lớn, vừa là cơ hội phi thường. Bằng cách triển khai tự động hóa tích hợp và quản trị dữ liệu phi cấu trúc, doanh nghiệp có thể khai phá “mỏ vàng” dữ liệu tiềm ẩn này, xây dựng AI agent và hệ thống RAG không chỉ thông minh mà còn chính xác, đáng tin cậy và tuân thủ. Doanh nghiệp nào nhanh chóng xây dựng hạ tầng dữ liệu này sẽ có lợi thế cạnh tranh lớn, chuyển đổi từ AI thử nghiệm sang hệ thống sản xuất nhanh hơn đối thủ, khai thác được insight mà người khác không có và xây dựng năng lực cộng dồn theo thời gian. Tương lai thuộc về doanh nghiệp nhận ra thành công AI là thành công dữ liệu—và đầu tư đúng vào hạ tầng, công cụ, quy trình để biến dữ liệu phi cấu trúc thành lợi thế cho mình.

Dữ liệu phi cấu trúc bao gồm tài liệu, email, PDF, hình ảnh, âm thanh và video—nội dung không nằm gọn trong các hàng của cơ sở dữ liệu. Hơn 90% dữ liệu doanh nghiệp là phi cấu trúc, nhưng hiện nay dưới 1% được đưa vào các dự án AI. Đây là cơ hội lớn chưa được khai thác để các tổ chức tạo lợi thế cạnh tranh nhờ AI agents và hệ thống thông minh.

RAG kết hợp truy xuất và sinh đáp án bằng cách tìm kiếm trong cơ sở dữ liệu vector thông tin liên quan dựa trên sự tương đồng ngữ nghĩa, sau đó cung cấp ngữ cảnh đó cho mô hình AI để tạo ra câu trả lời chính xác. Cơ sở dữ liệu vector lưu trữ embeddings—biểu diễn số hóa của văn bản—giúp tìm kiếm thông minh, hiểu ý nghĩa thay vì chỉ dựa vào từ khóa.

Tích hợp chuyển đổi dữ liệu phi cấu trúc thô, lộn xộn thành bộ dữ liệu có thể đọc được bằng máy thông qua các pipeline dạng ETL, giúp dữ liệu sẵn sàng cho AI. Quản trị đảm bảo dữ liệu có thể tra cứu, được tổ chức, đáng tin cậy và tuân thủ bằng cách trích xuất metadata, phân loại nội dung và theo dõi nguồn gốc. Kết hợp hai yếu tố này tạo nên các pipeline dữ liệu đáng tin cậy, chất lượng sản xuất.

Chìa khóa là xây dựng pipeline dữ liệu thông minh kết hợp tích hợp và quản trị. Tích hợp giúp dữ liệu sử dụng được; quản trị giúp dữ liệu đáng tin cậy. Bằng cách tự động hóa quy trình chuyển đổi dữ liệu phi cấu trúc thành bộ dữ liệu chất lượng cao, có ngữ cảnh, doanh nghiệp có thể triển khai AI quy mô lớn từ thử nghiệm đến hệ thống sản xuất đáng tin cậy, tuân thủ.

Arshia là Kỹ sư Quy trình AI tại FlowHunt. Với nền tảng về khoa học máy tính và niềm đam mê AI, anh chuyên tạo ra các quy trình hiệu quả tích hợp công cụ AI vào các nhiệm vụ hàng ngày, nâng cao năng suất và sự sáng tạo.

Khám phá cách FlowHunt tự động hóa tích hợp và quản trị dữ liệu phi cấu trúc để thúc đẩy các agent AI và hệ thống RAG chính xác.

Dữ liệu tổng hợp đề cập đến thông tin được tạo ra một cách nhân tạo nhằm mô phỏng dữ liệu thực tế. Nó được tạo ra bằng các thuật toán và mô phỏng máy tính để th...

Tìm hiểu cách xây dựng hệ thống AI đa tác nhân sẵn sàng cho sản xuất bằng Strands, framework mã nguồn mở của AWS. Khám phá cách tạo các tác nhân chuyên biệt phố...

Quy trình làm việc toàn diện do AI dẫn dắt cho phân tích công ty và nghiên cứu thị trường. Tự động thu thập và phân tích dữ liệu về thông tin công ty, vị thế th...

Đồng Ý Cookie

Chúng tôi sử dụng cookie để cải thiện trải nghiệm duyệt web của bạn và phân tích lưu lượng truy cập của mình. See our privacy policy.