Làm thế nào để chuyển đổi việc tạo nội dung với tạo video Wan 2.2 & 2.5?

FlowHunt hiện hỗ trợ các mô hình tạo video Wan 2.2 và 2.5 cho chuyển văn bản thành video, chuyển ảnh thành video, thay thế nhân vật và hoạt hình. Chuyển đổi việ...

Wan 2.1 là mô hình tạo video AI mã nguồn mở mạnh mẽ của Alibaba, mang đến video chất lượng phòng thu từ văn bản hoặc hình ảnh, miễn phí cho mọi người sử dụng cục bộ.

Wan 2.1 (còn gọi là WanX 2.1) đang tạo ra bước đột phá mới với tư cách là mô hình tạo video AI hoàn toàn mã nguồn mở do Phòng thí nghiệm Tongyi của Alibaba phát triển. Khác với nhiều hệ thống tạo video độc quyền yêu cầu đăng ký đắt đỏ hoặc truy cập API, Wan 2.1 mang lại chất lượng tương đương hoặc vượt trội, đồng thời hoàn toàn miễn phí, dễ tiếp cận cho nhà phát triển, nhà nghiên cứu và chuyên gia sáng tạo.

Điều làm Wan 2.1 thực sự đặc biệt là sự kết hợp giữa tính dễ tiếp cận và hiệu suất mạnh mẽ. Phiên bản nhỏ T2V-1.3B chỉ cần ~8,2 GB bộ nhớ GPU, tương thích với hầu hết GPU phổ thông hiện nay. Trong khi đó, phiên bản lớn 14 tỷ tham số mang lại hiệu suất tiên tiến, vượt trội cả các mô hình mã nguồn mở lẫn thương mại trên các bài kiểm tra chuẩn.

Wan 2.1 không chỉ giới hạn ở tạo video từ văn bản. Kiến trúc linh hoạt của nó hỗ trợ:

Nhờ sự linh hoạt này, bạn có thể bắt đầu từ một đoạn văn bản, hình ảnh tĩnh, hoặc thậm chí là video có sẵn và biến đổi theo ý tưởng sáng tạo của riêng mình.

Là mô hình video đầu tiên có thể hiển thị văn bản tiếng Anh và tiếng Trung rõ ràng trong video được tạo ra, Wan 2.1 mở ra nhiều khả năng mới cho các nhà sáng tạo nội dung quốc tế. Tính năng này đặc biệt hữu ích khi làm phụ đề hoặc chữ cảnh trong video đa ngôn ngữ.

Trung tâm của hiệu suất Wan 2.1 là Bộ mã hóa tự động biến phân video nhân quả 3D. Đột phá công nghệ này giúp nén thông tin không-thời gian một cách hiệu quả, cho phép mô hình:

Mô hình 1.3B nhỏ chỉ cần 8,19 GB VRAM và có thể tạo video 5 giây, 480p chỉ trong khoảng 4 phút trên RTX 4090. Dù tiết kiệm tài nguyên, chất lượng hình ảnh vẫn ngang ngửa hoặc vượt nhiều mô hình lớn hơn, cân bằng tối ưu giữa tốc độ và độ trung thực hình ảnh.

Trong các bài đánh giá công khai, Wan 14B đạt điểm số tổng thể cao nhất trong bài kiểm tra Wan-Bench, vượt trội đối thủ ở:

Khác với các hệ thống mã nguồn đóng như Sora của OpenAI hay Gen-2 của Runway, Wan 2.1 hoàn toàn miễn phí và có thể chạy cục bộ. Mô hình này vượt trội các mô hình mã nguồn mở trước đây (như CogVideo, MAKE-A-VIDEO, và Pika) cũng như nhiều giải pháp thương mại về chất lượng trên các bảng đánh giá.

Một khảo sát ngành gần đây ghi nhận rằng “trong số nhiều mô hình AI tạo video, Wan 2.1 và Sora nổi bật” – Wan 2.1 nổi bật nhờ tính mở và hiệu quả, Sora nổi bật nhờ đổi mới độc quyền. Trong các thử nghiệm cộng đồng, người dùng nhận xét khả năng chuyển ảnh thành video của Wan 2.1 vượt trội đối thủ về độ nét và cảm giác điện ảnh.

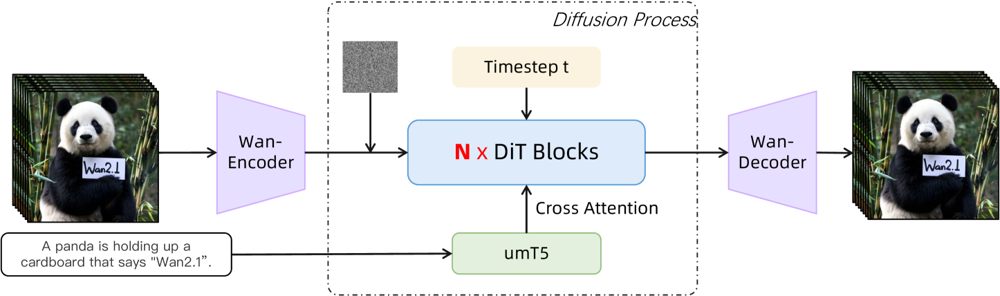

Wan 2.1 được xây dựng dựa trên nền tảng diffusion-transformer với VAE không-thời gian mới. Nguyên lý hoạt động như sau:

Hình: Kiến trúc tổng thể của Wan 2.1 (trường hợp chuyển văn bản thành video). Một video (hoặc ảnh) được bộ mã hóa Wan-VAE mã hóa trước thành biểu diễn tiềm ẩn. Biểu diễn này được đưa qua N khối diffusion transformer, các khối này chú ý tới embedding văn bản (từ umT5) thông qua cross-attention. Cuối cùng, bộ giải mã Wan-VAE dựng lại các khung hình video. Thiết kế này – với “bộ mã hóa/giải mã VAE nhân quả 3D bao quanh diffusion transformer” (ar5iv.org ) – cho phép nén hiệu quả dữ liệu không-thời gian và hỗ trợ xuất video chất lượng cao.

Kiến trúc sáng tạo này—sở hữu “bộ mã hóa/giải mã VAE nhân quả 3D bao quanh diffusion transformer”—giúp nén hiệu quả dữ liệu không-thời gian và hỗ trợ xuất video chất lượng cao.

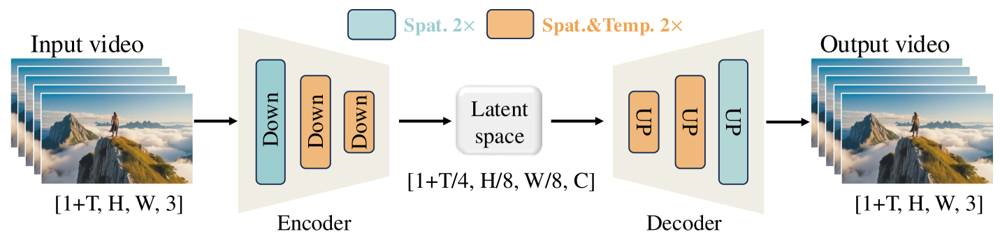

Wan-VAE được thiết kế riêng cho video, nén đầu vào theo hệ số ấn tượng (thời gian 4× và không gian 8×) thành biểu diễn tiềm ẩn nhỏ gọn trước khi giải mã về video đầy đủ. Sử dụng tích chập 3D và các lớp nhân quả (giữ trình tự thời gian) đảm bảo chuyển động mạch lạc trong toàn bộ nội dung sinh ra.

Hình: Khung Wan-VAE của Wan 2.1 (bộ mã hóa-giải mã). Bộ mã hóa Wan-VAE (bên trái) áp dụng chuỗi các lớp giảm mẫu (“Down”) lên video đầu vào (dạng [1+T, H, W, 3] khung hình) đến khi đạt biểu diễn tiềm ẩn gọn ([1+T/4, H/8, W/8, C]). Bộ giải mã Wan-VAE (bên phải) tăng mẫu đối xứng (“UP”) biểu diễn này về lại các khung hình video gốc. Khối màu xanh dương biểu thị nén không gian, khối cam là nén không gian+kết hợp thời gian (ar5iv.org

). Nhờ nén video tới 256 lần (trên thể tích không-thời gian), Wan-VAE làm cho việc mô hình hóa video độ phân giải cao trở nên khả thi cho mô hình diffusion phía sau.

Sẵn sàng thử Wan 2.1? Hãy bắt đầu như sau:

Sao chép repo và cài đặt phụ thuộc:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1

pip install -r requirements.txt

Tải trọng số mô hình:

pip install "huggingface_hub[cli]"

huggingface-cli login

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B

Tạo video đầu tiên:

python generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./Wan2.1-T2V-14B \

--prompt "A futuristic city skyline at sunset, with flying cars zooming overhead."

--offload_model True --t5_cpu để chuyển tải một phần mô hình sang CPU--size (ví dụ, 832*480 cho 16:9 480p)Tham khảo, một RTX 4090 có thể tạo video 5 giây 480p trong khoảng 4 phút. Hệ thống đa GPU và nhiều tối ưu hiệu suất (FSDP, lượng tử hóa, v.v.) được hỗ trợ cho nhu cầu quy mô lớn.

Là một “ông lớn” mã nguồn mở thách thức các gã khổng lồ trong lĩnh vực tạo video AI, Wan 2.1 đánh dấu sự thay đổi lớn về khả năng tiếp cận. Tính miễn phí và mở khiến bất kỳ ai sở hữu GPU tầm trung đều có thể khám phá công nghệ tạo video tiên tiến mà không cần trả phí đăng ký hay API.

Với nhà phát triển, giấy phép mã nguồn mở cho phép tự do tùy chỉnh và cải tiến mô hình. Nhà nghiên cứu có thể mở rộng năng lực, còn chuyên gia sáng tạo có thể nhanh chóng thử nghiệm nội dung video hiệu quả.

Trong bối cảnh các mô hình AI độc quyền ngày càng bị khóa phí hoặc hạn chế, Wan 2.1 chứng minh hiệu suất tiên tiến hoàn toàn có thể được dân chủ hóa và chia sẻ cho cộng đồng rộng lớn.

Wan 2.1 là mô hình tạo video AI hoàn toàn mã nguồn mở do Phòng thí nghiệm Tongyi của Alibaba phát triển, có khả năng tạo ra video chất lượng cao từ văn bản, hình ảnh hoặc video có sẵn. Mô hình này miễn phí sử dụng, hỗ trợ nhiều tác vụ và chạy hiệu quả trên GPU phổ thông.

Wan 2.1 hỗ trợ tạo video đa nhiệm (chuyển văn bản thành video, chuyển ảnh thành video, chỉnh sửa video, v.v.), hiển thị văn bản đa ngôn ngữ trong video, hiệu suất cao nhờ Video VAE nhân quả 3D, và vượt trội hơn nhiều mô hình thương mại cũng như mã nguồn mở khác trong các bài kiểm tra chuẩn.

Bạn cần Python 3.8+, PyTorch 2.4.0+ hỗ trợ CUDA, và GPU NVIDIA (8GB+ VRAM cho mô hình nhỏ, 16-24GB cho mô hình lớn). Sao chép repo GitHub, cài đặt phụ thuộc, tải trọng số mô hình và sử dụng script đi kèm để tạo video cục bộ.

Wan 2.1 dân chủ hóa quyền truy cập vào công nghệ tạo video tiên tiến nhờ mã nguồn mở và miễn phí, cho phép nhà phát triển, nhà nghiên cứu và sáng tạo thử nghiệm, đổi mới mà không gặp phải rào cản trả phí hay hạn chế độc quyền.

Khác với các lựa chọn mã nguồn đóng như Sora hay Runway Gen-2, Wan 2.1 hoàn toàn mã nguồn mở và có thể chạy cục bộ. Mô hình này nhìn chung vượt qua các mô hình mã nguồn mở trước đó và sánh ngang hoặc vượt nhiều giải pháp thương mại về chất lượng trên các bảng đánh giá.

Arshia là Kỹ sư Quy trình AI tại FlowHunt. Với nền tảng về khoa học máy tính và niềm đam mê AI, anh chuyên tạo ra các quy trình hiệu quả tích hợp công cụ AI vào các nhiệm vụ hàng ngày, nâng cao năng suất và sự sáng tạo.

Bắt đầu xây dựng công cụ AI và quy trình tạo video AI của riêng bạn với FlowHunt hoặc đặt lịch demo để xem nền tảng hoạt động thực tế.

FlowHunt hiện hỗ trợ các mô hình tạo video Wan 2.2 và 2.5 cho chuyển văn bản thành video, chuyển ảnh thành video, thay thế nhân vật và hoạt hình. Chuyển đổi việ...

Bản cập nhật tháng 10/2025 của FlowHunt mang đến các mô hình tạo video Wan 2.2 và 2.5 mang tính cách mạng cho chuyển văn bản thành video, hình ảnh thành video, ...

Khám phá những khả năng đột phá của Sora 2 trong lĩnh vực tạo video AI, từ tái tạo nhân vật chân thực đến mô phỏng vật lý, và tìm hiểu cách công nghệ này đang t...

Đồng Ý Cookie

Chúng tôi sử dụng cookie để cải thiện trải nghiệm duyệt web của bạn và phân tích lưu lượng truy cập của mình. See our privacy policy.