LLM xAI

FlowHunt hỗ trợ hàng chục mô hình sinh văn bản, bao gồm các mô hình của xAI. Dưới đây là cách sử dụng các mô hình xAI trong công cụ AI và chatbot của bạn....

LLM Meta AI của FlowHunt mang các mô hình Llama của Meta và hàng chục mô hình AI khác vào một bảng điều khiển duy nhất, dễ kiểm soát để sinh văn bản và hình ảnh linh hoạt.

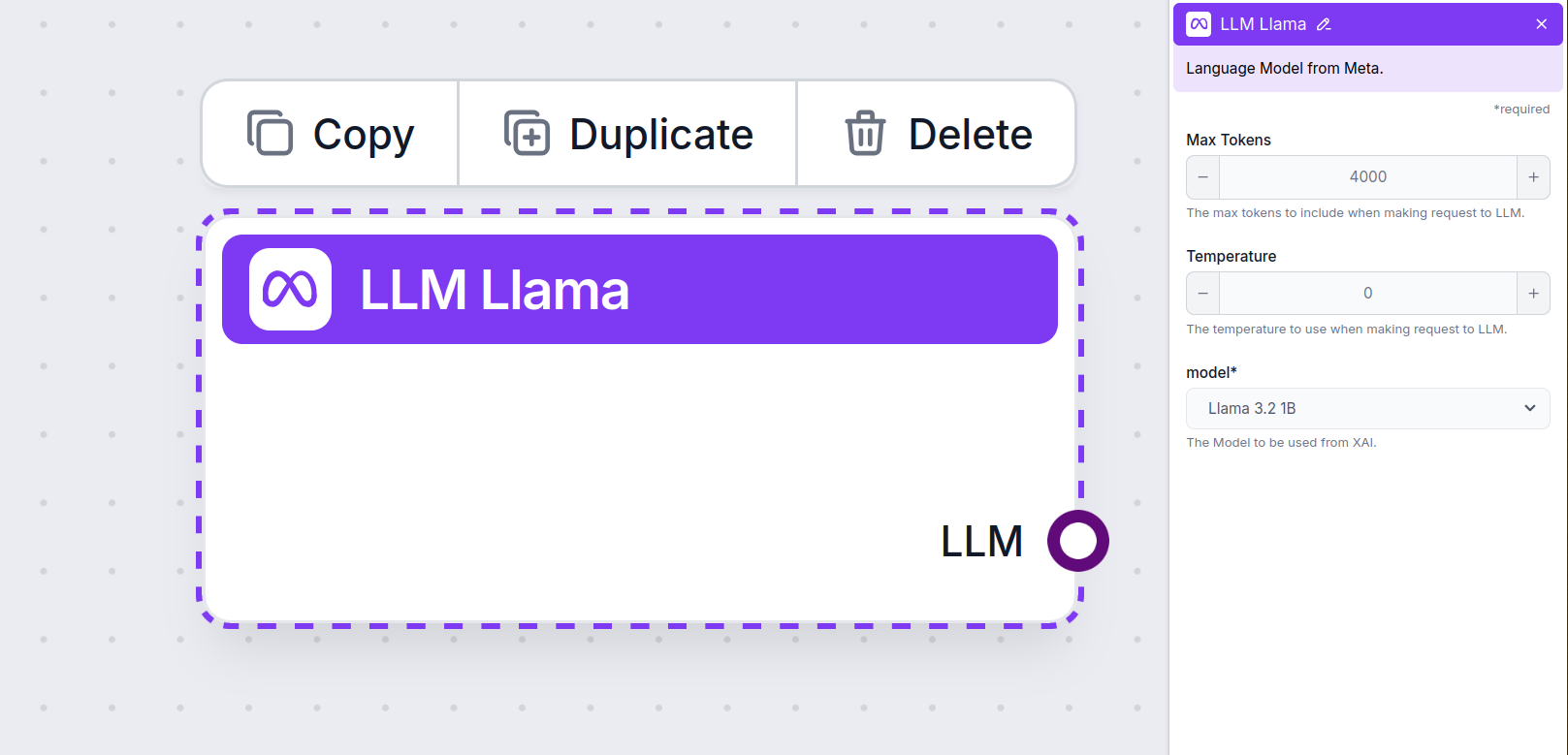

Mô tả thành phần

Thành phần LLM Meta AI kết nối dòng mô hình Claude vào Flow của bạn. Trong khi các bộ Sinh và Tác nhân là nơi phép màu thực sự diễn ra, các thành phần LLM cho phép bạn kiểm soát mô hình được sử dụng. Tất cả thành phần đều đi kèm ChatGPT-4 mặc định. Bạn có thể kết nối thành phần này nếu muốn thay đổi mô hình hoặc kiểm soát nhiều hơn.

Lưu ý rằng việc kết nối một thành phần LLM là không bắt buộc. Tất cả thành phần sử dụng LLM đều đi kèm ChatGPT-4o mặc định. Các thành phần LLM cho phép bạn thay đổi mô hình và kiểm soát các thiết lập mô hình.

Token đại diện cho những đơn vị văn bản riêng lẻ mà mô hình xử lý và sinh ra. Việc sử dụng token phụ thuộc vào từng mô hình, và một token có thể là từ, cụm từ, hoặc chỉ một ký tự. Các mô hình thường được tính phí theo hàng triệu token.

Thiết lập token tối đa sẽ giới hạn tổng số token có thể xử lý trong một phiên tương tác hoặc yêu cầu, đảm bảo phản hồi được tạo ra trong phạm vi hợp lý. Giới hạn mặc định là 4.000 token, kích thước tối ưu để tóm tắt tài liệu và nhiều nguồn nhằm tạo ra câu trả lời.

Nhiệt độ kiểm soát mức độ đa dạng của câu trả lời, dao động từ 0 đến 1.

Nhiệt độ 0.1 sẽ khiến phản hồi rất ngắn gọn nhưng có thể lặp lại và thiếu sáng tạo.

Nhiệt độ cao 1 cho phép mức sáng tạo tối đa trong câu trả lời nhưng có thể tạo ra những phản hồi không liên quan hoặc thậm chí “ảo giác”.

Ví dụ, mức nhiệt độ được khuyến nghị cho chatbot chăm sóc khách hàng là từ 0.2 đến 0.5. Mức này sẽ giữ cho câu trả lời phù hợp và sát kịch bản, đồng thời vẫn đảm bảo sự tự nhiên.

Đây là bộ chọn mô hình. Bạn sẽ tìm thấy tất cả các mô hình được hỗ trợ từ Meta AI tại đây. Chúng tôi hỗ trợ các mô hình Llama nhẹ, mã nguồn mở của Meta. Những mô hình này được thiết kế cho hiệu quả trên thiết bị và triển khai biên:

Bạn sẽ thấy rằng tất cả thành phần LLM chỉ có một đầu ra. Dữ liệu đầu vào không đi qua thành phần này, vì nó chỉ đại diện cho mô hình, còn việc sinh thực tế diễn ra ở các Tác nhân AI và Bộ sinh.

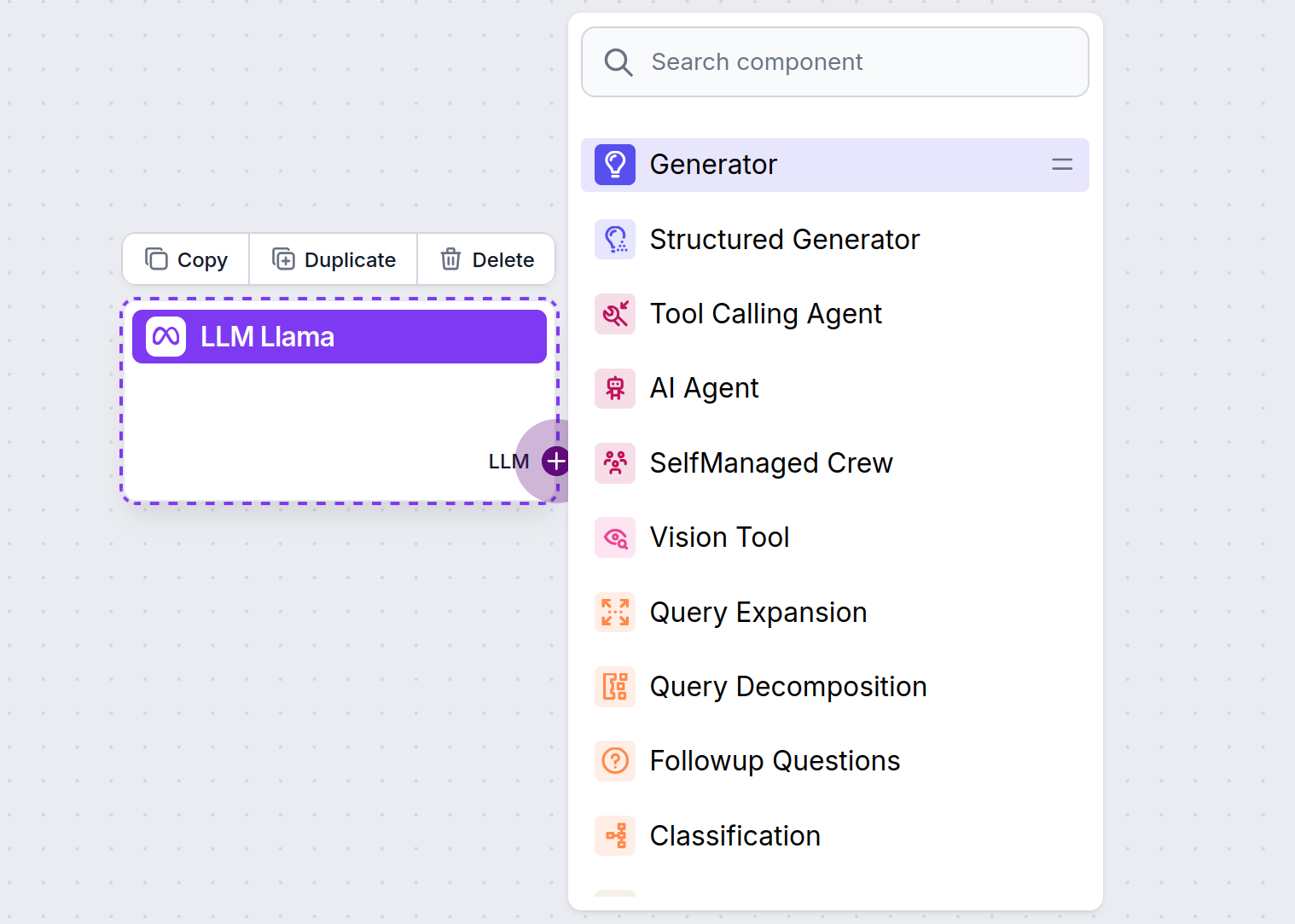

Đầu nối LLM luôn có màu tím. Đầu nối đầu vào LLM nằm trên mọi thành phần sử dụng AI để sinh văn bản hoặc xử lý dữ liệu. Bạn có thể xem các tùy chọn bằng cách nhấp vào đầu nối:

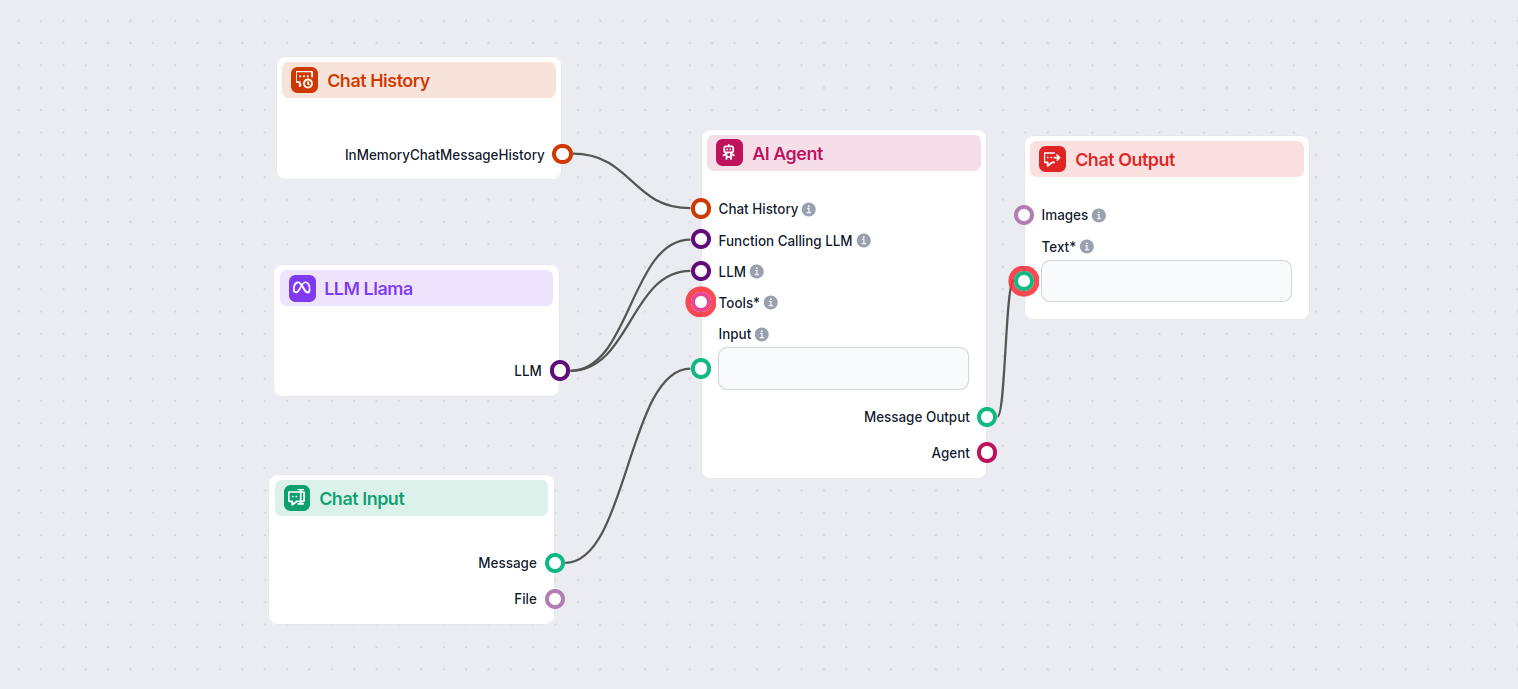

Điều này cho phép bạn tạo ra đủ loại công cụ. Hãy cùng xem thành phần này hoạt động. Đây là một Flow chatbot Tác nhân AI đơn giản sử dụng Llama 3.2 1B của Meta AI để sinh phản hồi. Bạn có thể coi nó như một chatbot Llama cơ bản.

Flow Chatbot đơn giản này bao gồm:

Thành phần LLM Meta AI cho phép bạn kết nối các mô hình Llama của Meta và các bộ sinh văn bản/hình ảnh khác vào luồng của bạn, giúp chọn mô hình dễ dàng và cấu hình nâng cao như số lượng token tối đa và nhiệt độ.

FlowHunt hỗ trợ các mô hình Llama mã nguồn mở của Meta, bao gồm Llama 3.2 1B và 3B, được tối ưu cho hiệu suất, tóm tắt và triển khai trên thiết bị.

Bạn có thể điều chỉnh các thiết lập như số lượng token tối đa (giới hạn độ dài phản hồi), nhiệt độ (điều khiển mức sáng tạo của câu trả lời) và chọn mô hình trực tiếp từ bảng điều khiển FlowHunt cho từng thành phần.

Không, thêm thành phần LLM Meta AI là tùy chọn. Mặc định, các thành phần sử dụng ChatGPT-4o, nhưng bạn có thể chuyển sang Llama hoặc mô hình khác để kiểm soát nhiều hơn hoặc phù hợp các trường hợp sử dụng cụ thể.

Bắt đầu xây dựng chatbot thông minh và công cụ AI với các mô hình Llama của Meta cùng hàng chục bộ sinh AI khác, tất cả trên một nền tảng.

FlowHunt hỗ trợ hàng chục mô hình sinh văn bản, bao gồm các mô hình của xAI. Dưới đây là cách sử dụng các mô hình xAI trong công cụ AI và chatbot của bạn....

FlowHunt hỗ trợ hàng chục mô hình AI tạo văn bản, bao gồm cả các mô hình của Mistral. Đây là cách sử dụng Mistral trong các công cụ AI và chatbot của bạn....

FlowHunt hỗ trợ hàng chục mô hình tạo văn bản, bao gồm cả các mô hình của OpenAI. Đây là cách sử dụng ChatGPT trong các công cụ AI và chatbot của bạn....