LLM Meta AI

FlowHunt hỗ trợ hàng chục mô hình sinh văn bản, bao gồm cả các mô hình Llama của Meta. Tìm hiểu cách tích hợp Llama vào công cụ AI và chatbot của bạn, tùy chỉnh...

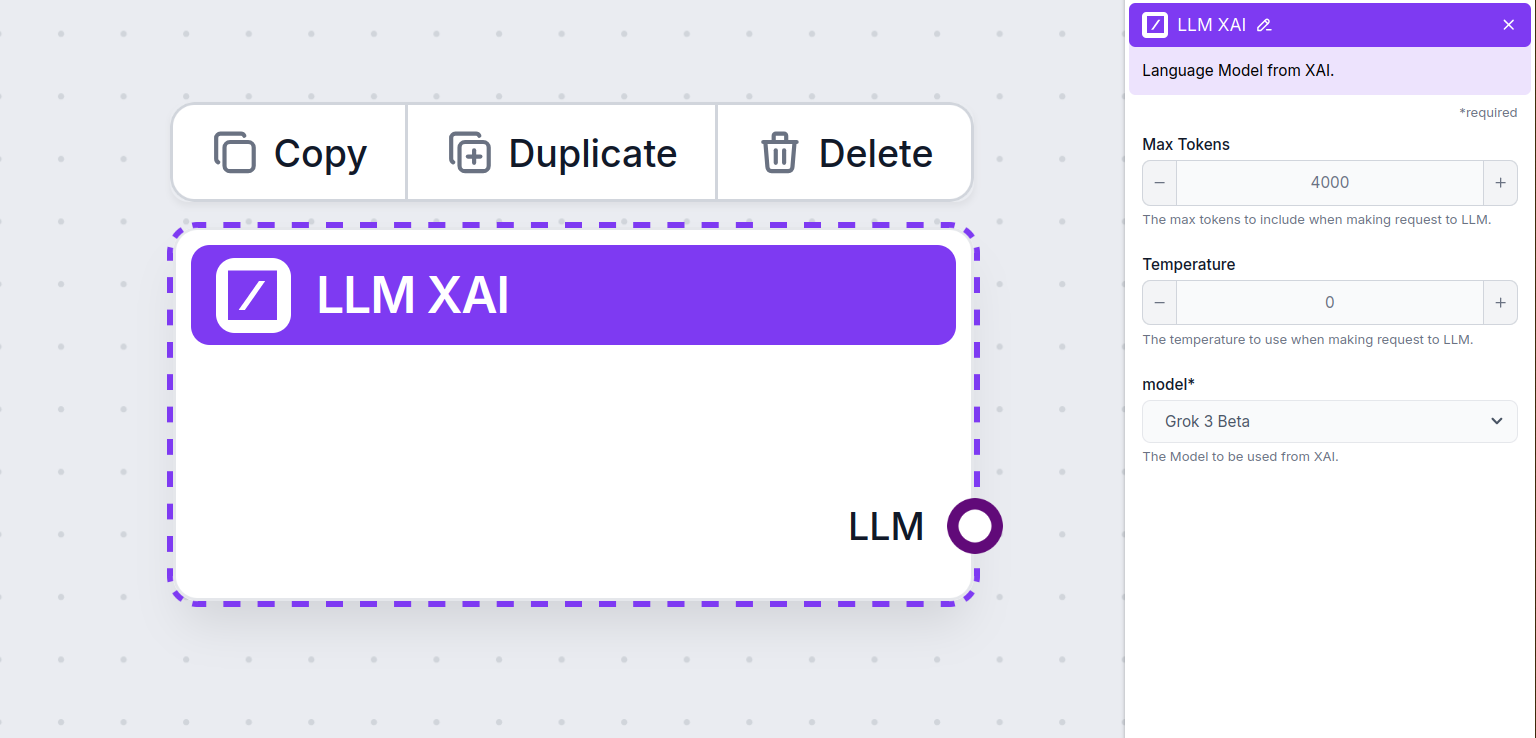

LLM xAI bởi FlowHunt cho phép bạn tích hợp các mô hình sinh văn bản của xAI như Grok-beta vào chatbot và công cụ AI, với các tuỳ chỉnh linh hoạt về token, temperature và lựa chọn mô hình.

Mô tả thành phần

Thành phần LLM xAI kết nối mô hình Grok vào flow của bạn. Trong khi Generators và Agents là nơi diễn ra các tác vụ chính, các thành phần LLM cho phép bạn kiểm soát mô hình được sử dụng. Tất cả các thành phần đều đi kèm với ChatGPT-4 theo mặc định. Bạn có thể kết nối thành phần này nếu muốn thay đổi mô hình hoặc kiểm soát nhiều hơn.

Lưu ý rằng việc kết nối một thành phần LLM là không bắt buộc. Tất cả thành phần sử dụng LLM đều đi kèm ChatGPT-4o mặc định. Thành phần LLM cho phép bạn thay đổi mô hình và kiểm soát các thiết lập của mô hình.

Token là các đơn vị văn bản riêng lẻ mà mô hình xử lý và sinh ra. Việc sử dụng token thay đổi theo từng mô hình, và một token có thể là từ, cụm từ hoặc chỉ một ký tự. Các mô hình thường được tính giá theo triệu token.

Thiết lập max tokens sẽ giới hạn tổng số token có thể được xử lý trong một lần tương tác hoặc yêu cầu, đảm bảo phản hồi được sinh ra trong khuôn khổ hợp lý. Giới hạn mặc định là 4.000 token, đây là kích thước tối ưu để tóm tắt tài liệu và nhiều nguồn khác nhau nhằm tạo ra câu trả lời.

Temperature kiểm soát mức độ biến đổi của câu trả lời, nằm từ 0 đến 1.

Temperature 0.1 sẽ khiến các phản hồi rất ngắn gọn, nhưng có thể lặp lại và thiếu sáng tạo.

Nhiệt độ cao 1 cho phép sự sáng tạo tối đa trong câu trả lời nhưng đồng thời có thể tạo ra các phản hồi lệch chủ đề hoặc thậm chí là “ảo giác”.

Ví dụ, temperature khuyến nghị cho chatbot chăm sóc khách hàng là từ 0.2 đến 0.5. Mức này giúp câu trả lời bám sát nội dung và kịch bản, đồng thời vẫn có sự biến đổi tự nhiên.

Đây là nơi chọn mô hình. Tại đây, bạn sẽ thấy tất cả các mô hình được hỗ trợ từ nhà cung cấp xAI. Mô hình sinh văn bản nổi bật của xAI có tên Grok. Hiện tại, chúng tôi chỉ hỗ trợ grok-beta model, vì đây là mô hình duy nhất đã được phát hành cho API công khai.

Muốn tìm hiểu thêm về Grok-beta và so sánh với các mô hình khác? Xem bài viết này.

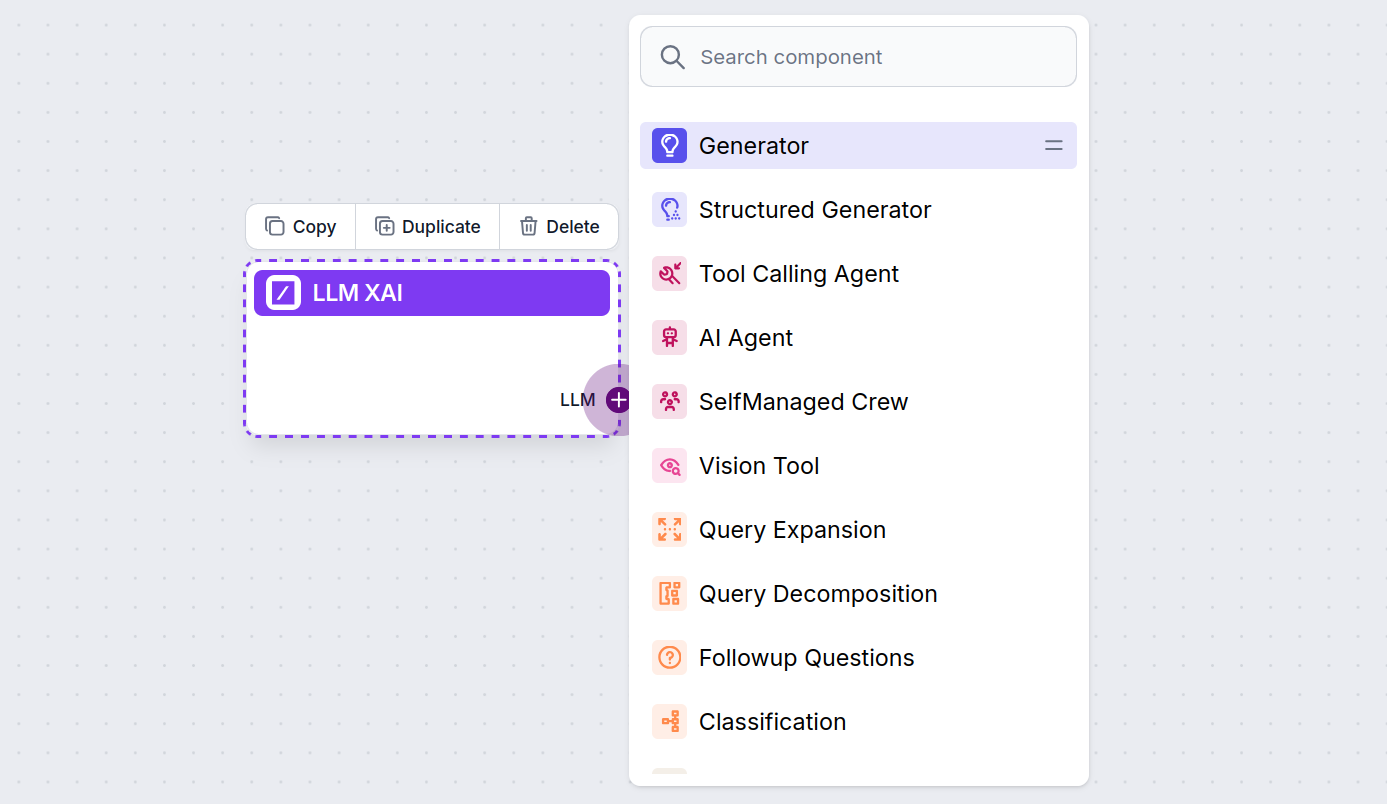

Bạn sẽ thấy tất cả các thành phần LLM chỉ có một đầu ra. Dữ liệu đầu vào không truyền qua thành phần này, vì nó chỉ đại diện cho mô hình, còn việc sinh văn bản thực tế được thực hiện bởi AI Agents và Generators.

Đầu nối của LLM luôn có màu tím. Đầu vào LLM được tìm thấy trên bất kỳ thành phần nào sử dụng AI để sinh văn bản hoặc xử lý dữ liệu. Bạn có thể xem các tuỳ chọn bằng cách nhấp vào đầu nối:

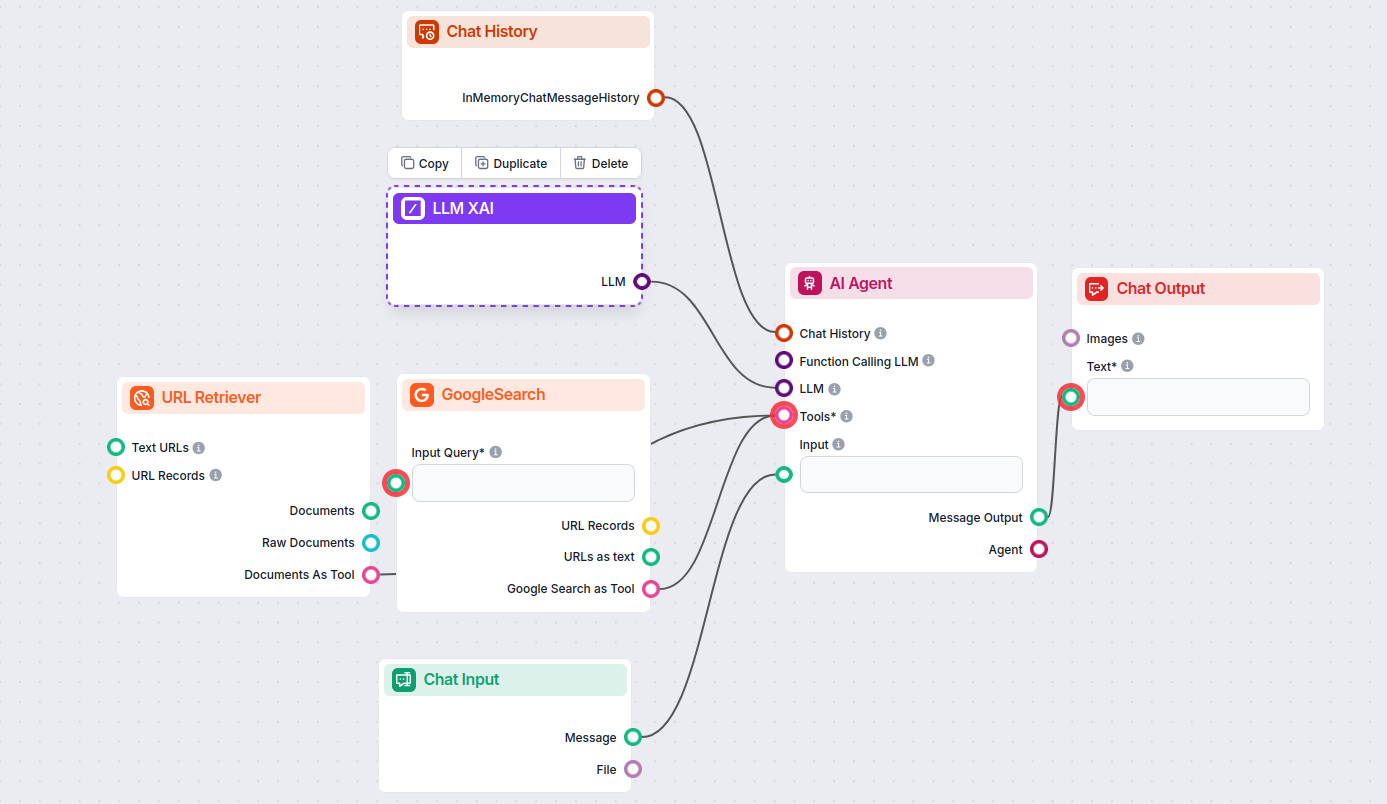

Điều này cho phép bạn tạo ra nhiều loại công cụ khác nhau. Hãy cùng xem thành phần này hoạt động như thế nào. Đây là một Flow chatbot AI Agent đơn giản đang sử dụng grok-beta của xAI để sinh phản hồi. Bạn có thể hình dung nó như một chatbot xAI cơ bản.

Flow Chatbot đơn giản này bao gồm:

LLM xAI là một thành phần của FlowHunt cho phép bạn kết nối và kiểm soát các mô hình sinh văn bản của nhà cung cấp xAI như Grok-beta trong quy trình AI và chatbot của bạn.

Hiện tại, FlowHunt hỗ trợ mô hình grok-beta từ xAI, và sẽ bổ sung thêm các mô hình khác khi chúng được phát hành API công khai.

Bạn có thể điều chỉnh số lượng token tối đa, temperature (mức biến đổi phản hồi), và lựa chọn từ các mô hình xAI có sẵn để tuỳ chỉnh hành vi của chatbot hoặc công cụ AI.

Không, đây là tuỳ chọn. Mặc định, các thành phần sử dụng ChatGPT-4o, nhưng bạn có thể kết nối LLM xAI để chuyển sang mô hình xAI hoặc kiểm soát nhiều hơn.

Chỉ cần thêm thành phần LLM vào flow của bạn; nó đóng vai trò chọn mô hình. Việc sinh văn bản thực tế diễn ra ở các AI Agents và Generators kết nối với nó.

Bắt đầu xây dựng chatbot AI thông minh hơn và công cụ với FlowHunt. Kết nối tới các mô hình xAI hàng đầu như Grok-beta trên một bảng điều khiển linh hoạt, không cần mã hóa.

FlowHunt hỗ trợ hàng chục mô hình sinh văn bản, bao gồm cả các mô hình Llama của Meta. Tìm hiểu cách tích hợp Llama vào công cụ AI và chatbot của bạn, tùy chỉnh...

FlowHunt hỗ trợ hàng chục mô hình tạo văn bản, bao gồm cả các mô hình của OpenAI. Đây là cách sử dụng ChatGPT trong các công cụ AI và chatbot của bạn....

FlowHunt hỗ trợ hàng chục mô hình AI, bao gồm các mô hình Claude của Anthropic. Tìm hiểu cách sử dụng Claude trong các công cụ AI và chatbot của bạn với các thi...