ONNX là gì?

Open Neural Network Exchange (ONNX) là một định dạng mã nguồn mở được tạo ra nhằm hỗ trợ khả năng trao đổi mô hình học máy giữa nhiều nền tảng và công cụ khác nhau. Được phát triển từ sự hợp tác giữa Facebook và Microsoft, ONNX chính thức ra mắt vào tháng 9 năm 2017. Nó đóng vai trò như một cầu nối giữa các framework học máy khác nhau, cho phép các nhà phát triển chuyển đổi mô hình mà không cần cấu trúc lại hoặc huấn luyện lại. Sự chuẩn hóa này giúp việc triển khai mô hình trên nhiều môi trường trở nên linh hoạt và hiệu quả hơn.

Những tính năng chính của ONNX

- Khả năng tương tác: ONNX được thiết kế chủ yếu để cho phép trao đổi mô hình liền mạch giữa các framework học máy lớn như TensorFlow, PyTorch, Caffe2 và Microsoft Cognitive Toolkit (CNTK). Tính tương tác này mở rộng cho cả các mô hình học sâu và học máy truyền thống, giúp nhà phát triển tận dụng thế mạnh của từng công cụ mà không bị ràng buộc vào một hệ sinh thái duy nhất.

- Chuẩn hóa: ONNX cung cấp một định dạng thống nhất bao gồm bộ phép toán và kiểu dữ liệu chung. Sự chuẩn hóa này đảm bảo mô hình luôn nhất quán và hoạt động tốt khi chuyển đổi giữa các nền tảng, giảm thiểu các vấn đề tương thích thường gặp với các định dạng độc quyền.

- Được cộng đồng phát triển: Thành công và sự phát triển của ONNX phần lớn nhờ vào cộng đồng các nhà phát triển và tổ chức sôi nổi. Sự hợp tác này đảm bảo ONNX luôn được cập nhật, cải tiến, thúc đẩy đổi mới trong triển khai mô hình AI.

- Tối ưu hóa phần cứng: ONNX hỗ trợ nhiều nền tảng phần cứng, cung cấp các tối ưu hóa giúp nâng cao hiệu suất trên nhiều thiết bị, bao gồm cả GPU và CPU. Khả năng này đặc biệt quan trọng khi triển khai mô hình ở môi trường hạn chế tài nguyên hoặc cần cải thiện thời gian suy luận trong hệ thống sản xuất.

- Quản lý phiên bản và tương thích: ONNX duy trì tính tương thích ngược, cho phép các mô hình phát triển từ phiên bản cũ vẫn hoạt động hiệu quả trên môi trường mới. Cách tiếp cận này giúp mô hình phát triển mà không làm mất đi chức năng hay hiệu suất.

ONNX Runtime

ONNX Runtime là một công cụ thực thi hiệu suất cao cho các mô hình ONNX, đảm bảo vận hành hiệu quả trên nhiều phần cứng và nền tảng khác nhau. Nó cung cấp nhiều tối ưu hóa và hỗ trợ nhiều trình thực thi, là thành phần thiết yếu khi triển khai mô hình AI trong môi trường thực tế. ONNX Runtime có thể tích hợp với các mô hình từ PyTorch, TensorFlow, scikit-learn và nhiều framework khác. Nó thực hiện tối ưu hóa đồ thị và phân bổ các nhóm phép toán cho phần cứng chuyên biệt, đảm bảo hiệu suất vượt trội so với các framework gốc.

Ứng dụng và ví dụ thực tế

- Y tế: Trong chẩn đoán hình ảnh y khoa, ONNX giúp triển khai các mô hình học sâu cho các tác vụ như phát hiện khối u trên ảnh MRI ở nhiều hệ thống chẩn đoán khác nhau.

- Ô tô: ONNX đóng vai trò quan trọng trong xe tự hành, cho phép tích hợp các mô hình nhận diện đối tượng hỗ trợ ra quyết định thời gian thực trong hệ thống lái tự động.

- Bán lẻ: ONNX giúp đơn giản hóa việc triển khai hệ thống gợi ý sản phẩm trong thương mại điện tử, nâng cao trải nghiệm mua sắm cá nhân hóa nhờ sử dụng các mô hình được huấn luyện ở nhiều framework khác nhau.

- Sản xuất: Các mô hình bảo trì dự đoán có thể được phát triển trên một framework và triển khai trong hệ thống nhà máy bằng ONNX, giúp tối ưu hóa hiệu quả vận hành.

- Tài chính: Các mô hình phát hiện gian lận được xây dựng trên một framework có thể tích hợp liền mạch vào hệ thống ngân hàng thông qua ONNX, nâng cao khả năng phòng chống gian lận.

- Nông nghiệp: ONNX hỗ trợ canh tác chính xác nhờ khả năng tích hợp các mô hình về cây trồng, đất đai vào nhiều hệ thống quản lý nông nghiệp khác nhau.

- Giáo dục: Các hệ thống học tập thích ứng tận dụng ONNX để tích hợp mô hình AI cá nhân hóa trải nghiệm học tập trên nhiều nền tảng giáo dục.

Các framework phổ biến tương thích với ONNX

- PyTorch: Nổi bật với đồ thị tính toán động và dễ sử dụng, PyTorch được ứng dụng rộng rãi trong nghiên cứu và phát triển.

- TensorFlow: Framework toàn diện do Google phát triển, cung cấp API xây dựng và triển khai mô hình học máy.

- Microsoft Cognitive Toolkit (CNTK): Hiệu quả khi huấn luyện các mô hình học sâu, đặc biệt trong nhận diện giọng nói và hình ảnh.

- Apache MXNet: Được Amazon hỗ trợ, MXNet nổi tiếng với sự linh hoạt và hiệu quả trên nền tảng đám mây và thiết bị di động.

- Scikit-Learn: Phổ biến cho các thuật toán học máy truyền thống, hỗ trợ chuyển đổi sang ONNX qua sklearn-onnx.

- Keras: API cấp cao chạy trên nền TensorFlow, tập trung vào thử nghiệm nhanh.

- Apple Core ML: Cho phép tích hợp mô hình vào ứng dụng iOS, hỗ trợ chuyển đổi từ ONNX.

Lợi ích khi sử dụng ONNX

- Linh hoạt giữa các framework: ONNX cho phép chuyển đổi giữa nhiều framework học máy khác nhau, tăng tính linh hoạt khi phát triển và triển khai mô hình.

- Hiệu quả triển khai: Cho phép triển khai mô hình trên nhiều nền tảng và thiết bị mà không cần chỉnh sửa nhiều.

- Hỗ trợ từ cộng đồng và ngành công nghiệp: Cộng đồng vững mạnh và sự hậu thuẫn từ các tổ chức lớn đảm bảo ONNX luôn được cải tiến và ứng dụng rộng rãi.

Thách thức khi áp dụng ONNX

- Phức tạp khi chuyển đổi: Quá trình chuyển đổi mô hình sang định dạng ONNX có thể phức tạp, nhất là với các mô hình chứa lớp hoặc phép toán tùy chỉnh.

- Tương thích phiên bản: Đảm bảo sự tương thích giữa các phiên bản ONNX và các framework là một thách thức không nhỏ.

- Hỗ trợ hạn chế cho các phép toán độc quyền: Một số phép toán nâng cao có thể chưa được ONNX hỗ trợ, giới hạn phạm vi ứng dụng trong một số tình huống.

Tìm hiểu về ONNX (Open Neural Network Exchange)

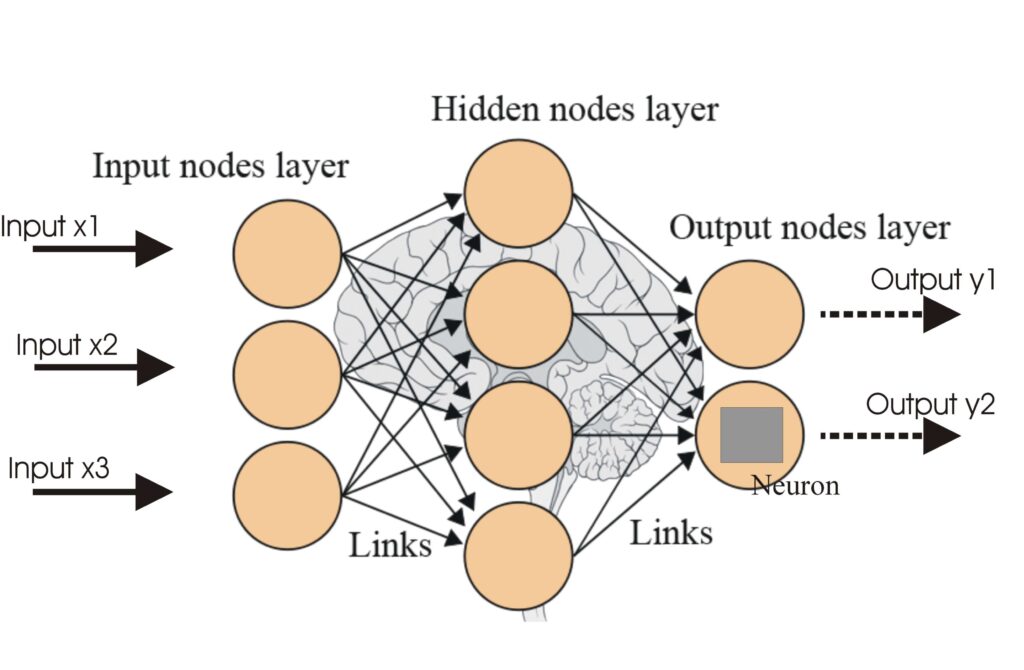

Open Neural Network Exchange (ONNX) là định dạng mã nguồn mở được thiết kế để hỗ trợ khả năng trao đổi mô hình AI giữa các framework học máy khác nhau. ONNX ngày càng được cộng đồng AI quan tâm nhờ khả năng cung cấp định dạng thống nhất và di động cho các mô hình học sâu, cho phép triển khai dễ dàng trên nhiều nền tảng. Dưới đây là tóm tắt các bài báo khoa học quan trọng liên quan đến ONNX, thể hiện ứng dụng và sự phát triển của ONNX:

1. Biên dịch mô hình mạng nơ-ron ONNX sử dụng MLIR

- Tác giả: Tian Jin, Gheorghe-Teodor Bercea, Tung D. Le, Tong Chen, Gong Su, Haruki Imai, Yasushi Negishi, Anh Leu, Kevin O’Brien, Kiyokuni Kawachiya, Alexandre E. Eichenberger

- Tóm tắt: Bài báo này trình bày về trình biên dịch onnx-mlir, chuyển đổi các mô hình ONNX thành mã thực thi bằng hạ tầng Multi-Level Intermediate Representation (MLIR). Các tác giả giới thiệu hai dialect mới trong MLIR nhằm tối ưu hóa suy luận mô hình ONNX. Công trình này đóng vai trò quan trọng trong việc tăng khả năng di động và tối ưu hóa mô hình trên nhiều môi trường tính toán khác nhau.

2. Sionnx: Công cụ sinh unit test tự động cho kiểm chuẩn ONNX

- Tác giả: Xinli Cai, Peng Zhou, Shuhan Ding, Guoyang Chen, Weifeng Zhang

- Tóm tắt: Bài báo giới thiệu Sionnx, một framework tạo unit test để kiểm tra sự tuân thủ phép toán ONNX trên các triển khai khác nhau. Bằng cách sử dụng Ngôn ngữ Đặc tả Phép toán (OSL) cấp cao, Sionnx đảm bảo phạm vi kiểm thử toàn diện, hỗ trợ xác minh chéo mạnh mẽ giữa các framework. Công cụ này rất quan trọng để duy trì tính nhất quán và độ tin cậy khi thực thi mô hình ONNX.

3. QONNX: Biểu diễn mạng nơ-ron lượng tử hóa với độ chính xác tùy ý

- Tác giả: Alessandro Pappalardo, Yaman Umuroglu, Michaela Blott, Jovan Mitrevski, Ben Hawks, Nhan Tran, Vladimir Loncar, Sioni Summers, Hendrik Borras, Jules Muhizi, Matthew Trahms, Shih-Chieh Hsu, Scott Hauck, Javier Duarte

- Tóm tắt: Bài báo này mở rộng định dạng ONNX để hỗ trợ mạng nơ-ron lượng tử hóa với độ chính xác tùy ý. Việc bổ sung các phép toán mới như Quant, BipolarQuant và Trunc trong định dạng Quantized ONNX (QONNX) giúp biểu diễn hiệu quả các mô hình lượng tử hóa thấp. Tiến bộ này thúc đẩy triển khai mạng nơ-ron hiệu quả hơn trên phần cứng với yêu cầu độ chính xác khác nhau.