Sắp Xếp Lại Tài Liệu (Document Reranking)

Sắp xếp lại tài liệu là quá trình sắp xếp lại thứ tự các tài liệu đã truy xuất dựa trên mức độ liên quan đến truy vấn của người dùng, tinh chỉnh kết quả tìm kiế...

Mở rộng truy vấn làm phong phú các truy vấn của người dùng bằng ngữ cảnh hoặc thuật ngữ bổ sung, tăng độ chính xác truy xuất và chất lượng phản hồi trong các hệ thống AI như RAG và chatbot.

Mở rộng truy vấn giúp làm phong phú truy vấn của người dùng bằng cách bổ sung thuật ngữ hoặc ngữ cảnh, cải thiện việc truy xuất tài liệu để có câu trả lời chính xác. Trong hệ thống RAG, kỹ thuật này tăng thu hồi và độ liên quan, giúp chatbot và AI cung cấp đáp án chuẩn xác bằng cách xử lý hiệu quả các truy vấn mơ hồ hoặc có từ đồng nghĩa.

Mở rộng truy vấn là quá trình nâng cao truy vấn gốc của người dùng bằng cách thêm các thuật ngữ hoặc ngữ cảnh bổ sung trước khi gửi đến cơ chế truy xuất. Việc bổ sung này giúp truy xuất được nhiều tài liệu hoặc thông tin liên quan hơn, từ đó tạo ra phản hồi chính xác và phù hợp với ngữ cảnh. Nếu tài liệu được tìm kiếm bằng các truy vấn thay thế và sau đó được xếp hạng lại, quá trình RAG sẽ cho kết quả tài liệu trong cửa sổ ngữ cảnh prompt chính xác hơn nhiều.

Tạo sinh tăng cường truy xuất (RAG) là kiến trúc AI kết hợp cơ chế truy xuất với mô hình sinh để tạo ra phản hồi chính xác và phù hợp ngữ cảnh hơn. Trong hệ thống RAG, thành phần truy xuất sẽ lấy về các tài liệu hoặc đoạn dữ liệu phù hợp từ kho tri thức dựa trên truy vấn của người dùng. Sau đó, mô hình sinh (thường là Mô hình Ngôn ngữ Lớn - LLM) sử dụng thông tin truy xuất này để tạo ra phản hồi đầy đủ, logic.

Trong hệ thống RAG, chất lượng phản hồi phụ thuộc nhiều vào độ liên quan của tài liệu truy xuất được. Nếu thành phần truy xuất không lấy được thông tin trọng yếu, mô hình sinh có thể tạo ra câu trả lời kém chính xác hoặc không liên quan. Mở rộng truy vấn giải quyết thách thức này bằng cách cải thiện truy vấn ban đầu, tăng khả năng lấy về đủ tài liệu liên quan.

Bằng cách mở rộng truy vấn gốc với các thuật ngữ liên quan, từ đồng nghĩa hoặc cách diễn đạt lại, mở rộng truy vấn giúp mở rộng phạm vi tìm kiếm. Điều này tăng độ thu hồi của hệ thống truy xuất, nghĩa là lấy được tỷ lệ cao hơn các tài liệu phù hợp từ kho tri thức. Độ thu hồi cao hơn dẫn đến ngữ cảnh đầy đủ hơn cho mô hình sinh, nâng cao chất lượng đầu ra tổng thể của hệ thống RAG.

Các LLM như GPT-4 có thể tạo ra các truy vấn diễn đạt lại hoặc đồng nghĩa với truy vấn gốc. Nhờ hiểu được ngữ cảnh và sắc thái ngôn ngữ, LLM có thể sinh ra các truy vấn mở rộng chất lượng cao, bao quát nhiều cách hỏi khác nhau.

Ví dụ:

Ở phương pháp này, hệ thống sử dụng LLM để sinh ra một câu trả lời giả định cho truy vấn của người dùng. Câu trả lời này được thêm vào truy vấn gốc để bổ sung ngữ cảnh khi truy xuất.

Quy trình:

Ví dụ:

Phương pháp này tạo nhiều truy vấn thay thế, mỗi truy vấn thể hiện một cách diễn đạt hoặc khía cạnh khác nhau của truy vấn gốc. Mỗi truy vấn được dùng độc lập để truy xuất tài liệu.

Quy trình:

Ví dụ:

Kịch bản:

Một hệ thống AI được thiết kế để trả lời câu hỏi dựa trên báo cáo thường niên của công ty. Người dùng hỏi: “Có sự thay đổi lớn nào trong ban lãnh đạo không?”

Triển khai:

Lợi ích:

Bằng cách bổ sung ngữ cảnh qua câu trả lời giả định, hệ thống truy xuất được thông tin có thể bị bỏ lỡ nếu chỉ dùng truy vấn gốc.

Kịch bản:

Một chatbot hỗ trợ khách hàng giúp người dùng xử lý sự cố. Người dùng nhập: “Mạng nhà tôi chậm.”

Triển khai:

Lợi ích:

Chatbot bao quát được nhiều vấn đề và giải pháp hơn, tăng khả năng giải quyết sự cố của người dùng nhanh chóng.

Kịch bản:

Sinh viên dùng trợ lý AI để tìm tài liệu về chủ đề: “Ảnh hưởng của thiếu ngủ tới chức năng nhận thức.”

Triển khai:

Lợi ích:

Sinh viên nhận được thông tin toàn diện, bao quát nhiều khía cạnh của chủ đề, hỗ trợ nghiên cứu sâu rộng hơn.

Thêm quá nhiều truy vấn mở rộng có thể dẫn đến việc truy xuất tài liệu không liên quan, giảm độ chính xác.

Cách khắc phục:

Từ ngữ đa nghĩa có thể dẫn đến truy vấn mở rộng không phù hợp.

Cách khắc phục:

Việc sinh và xử lý nhiều truy vấn mở rộng đòi hỏi tài nguyên tính toán lớn.

Cách khắc phục:

Đảm bảo truy vấn mở rộng hoạt động hiệu quả với thuật toán truy xuất hiện tại.

Cách khắc phục:

Gán trọng số cho các thuật ngữ trong truy vấn mở rộng để phản ánh mức độ quan trọng của chúng.

Sau truy xuất, xếp hạng lại tài liệu để ưu tiên kết quả liên quan nhất.

Ví dụ:

Sử dụng Cross-Encoder sau truy xuất để chấm điểm và xếp lại tài liệu theo mức độ liên quan với truy vấn gốc.

Kết hợp hành vi tương tác của người dùng để cải thiện mở rộng truy vấn.

Sử dụng AI và LLM để mở rộng truy vấn tận dụng khả năng hiểu ngôn ngữ nâng cao nhằm cải thiện truy xuất. Điều này giúp hệ thống AI, bao gồm chatbot và trợ lý ảo, cung cấp phản hồi chính xác và phù hợp hơn với ngữ cảnh.

Tự động hóa quá trình mở rộng truy vấn giúp người dùng không phải tạo truy vấn chính xác thủ công. Tự động hóa AI xử lý toàn bộ phức tạp phía sau, tăng hiệu quả cho hệ thống truy xuất thông tin.

Chatbot hưởng lợi từ mở rộng truy vấn bằng cách hiểu ý định người dùng tốt hơn, đặc biệt khi người dùng dùng ngôn ngữ đời thường hoặc câu không hoàn chỉnh. Điều này dẫn đến tương tác hài lòng hơn và giải quyết vấn đề hiệu quả hơn.

Ví dụ:

Chatbot hỗ trợ kỹ thuật có thể hiểu truy vấn mơ hồ như “Ứng dụng của tôi không hoạt động” bằng cách mở rộng nó thành “ứng dụng bị treo”, “phần mềm không phản hồi”, và “thông báo lỗi ứng dụng”, giúp giải quyết vấn đề nhanh hơn.

Nghiên Cứu Về Mở Rộng Truy Vấn Cho RAG

Cải thiện truy xuất cho Hỏi đáp dựa trên RAG trong các mô hình LLM trên tài liệu tài chính

Bài báo này đánh giá hiệu quả của các LLM được tăng cường bởi RAG, đặc biệt trong bối cảnh tài liệu tài chính. Nghiên cứu chỉ ra rằng, sự thiếu chính xác trong phản hồi của LLM thường xuất phát từ việc truy xuất đoạn văn bản chưa tối ưu hơn là do bản thân LLM. Nghiên cứu đề xuất cải tiến quy trình RAG, bao gồm kỹ thuật chia nhỏ văn bản, mở rộng truy vấn, bổ sung siêu dữ liệu và thuật toán xếp hạng lại. Những phương pháp này giúp tinh chỉnh truy xuất văn bản, từ đó nâng cao hiệu suất LLM trong việc sinh phản hồi chính xác. Đọc thêm

Nâng cao truy xuất và quản lý truy xuất: Bốn mô-đun phối hợp cho chất lượng và hiệu quả tốt hơn trong hệ thống RAG

Bài báo này giới thiệu cách tiếp cận theo mô-đun để nâng cao hệ thống RAG, tập trung vào mô-đun Query Rewriter, tạo truy vấn thân thiện với tìm kiếm nhằm cải thiện truy xuất tri thức. Nghiên cứu giải quyết các vấn đề về “bình nguyên thông tin” và tính mơ hồ trong truy vấn bằng cách sinh nhiều truy vấn khác nhau. Ngoài ra, Knowledge Filter và Memory Knowledge Reservoir được đề xuất để quản lý tri thức không liên quan và tối ưu hóa tài nguyên. Những cải tiến này nhằm tăng chất lượng và hiệu quả phản hồi trong hệ thống RAG, đã được kiểm nghiệm qua các bộ dữ liệu hỏi đáp. Truy cập mã nguồn và chi tiết

MultiHop-RAG: Đánh giá chuẩn cho Tạo Sinh Tăng Cường Truy Xuất với Truy Vấn Đa Bước

Nghiên cứu này chỉ ra những thách thức của hệ thống RAG hiện tại khi xử lý truy vấn đa bước, vốn đòi hỏi suy luận dựa trên nhiều bằng chứng khác nhau. Bài báo giới thiệu bộ dữ liệu mới chuyên dùng để đánh giá hệ thống RAG với loại truy vấn này, nhằm nâng cao năng lực của RAG trong các ứng dụng thực tế. Bài viết cũng thảo luận các tiến bộ cần thiết để RAG có thể xử lý hiệu quả cấu trúc truy vấn phức tạp và thúc đẩy ứng dụng LLM trong thực tiễn.

Mở rộng truy vấn là quá trình bổ sung truy vấn gốc của người dùng bằng cách thêm các thuật ngữ liên quan, từ đồng nghĩa hoặc ngữ cảnh, giúp hệ thống truy xuất lấy về các tài liệu phù hợp hơn và tạo phản hồi chính xác, đặc biệt trong các ứng dụng vận hành bởi AI.

Trong các hệ thống RAG (Tạo Sinh Tăng Cường Truy Xuất), mở rộng truy vấn tăng độ thu hồi của thành phần truy xuất bằng cách mở rộng phạm vi tìm kiếm, đảm bảo nhiều tài liệu liên quan hơn được cân nhắc để tạo ra phản hồi chính xác.

Các kỹ thuật bao gồm sử dụng Mô hình Ngôn ngữ Lớn để tạo truy vấn diễn đạt lại, tạo ra câu trả lời giả định, phương pháp đa truy vấn, gán trọng số thuật ngữ và tận dụng phản hồi người dùng để cải tiến liên tục.

Mở rộng truy vấn giúp tăng độ thu hồi, xử lý các truy vấn mơ hồ hoặc không rõ ràng, nhận diện từ đồng nghĩa và nâng cao trải nghiệm người dùng bằng cách cung cấp phản hồi chính xác, giàu thông tin mà không cần người dùng tự tinh chỉnh truy vấn.

Có, các thách thức bao gồm mở rộng quá mức (dẫn đến tài liệu không liên quan), mơ hồ về ý nghĩa thuật ngữ, yêu cầu tài nguyên tính toán lớn và đảm bảo tương thích với thuật toán truy xuất. Có thể giảm thiểu bằng cách kiểm soát quá trình sinh truy vấn, lọc độ liên quan và dùng mô hình hiệu quả.

Xem cách Mở rộng truy vấn giúp nâng cao độ chính xác cho chatbot AI và cải thiện truy xuất thông tin. Khám phá các giải pháp của FlowHunt cho xử lý truy vấn tự động, hiệu quả.

Sắp xếp lại tài liệu là quá trình sắp xếp lại thứ tự các tài liệu đã truy xuất dựa trên mức độ liên quan đến truy vấn của người dùng, tinh chỉnh kết quả tìm kiế...

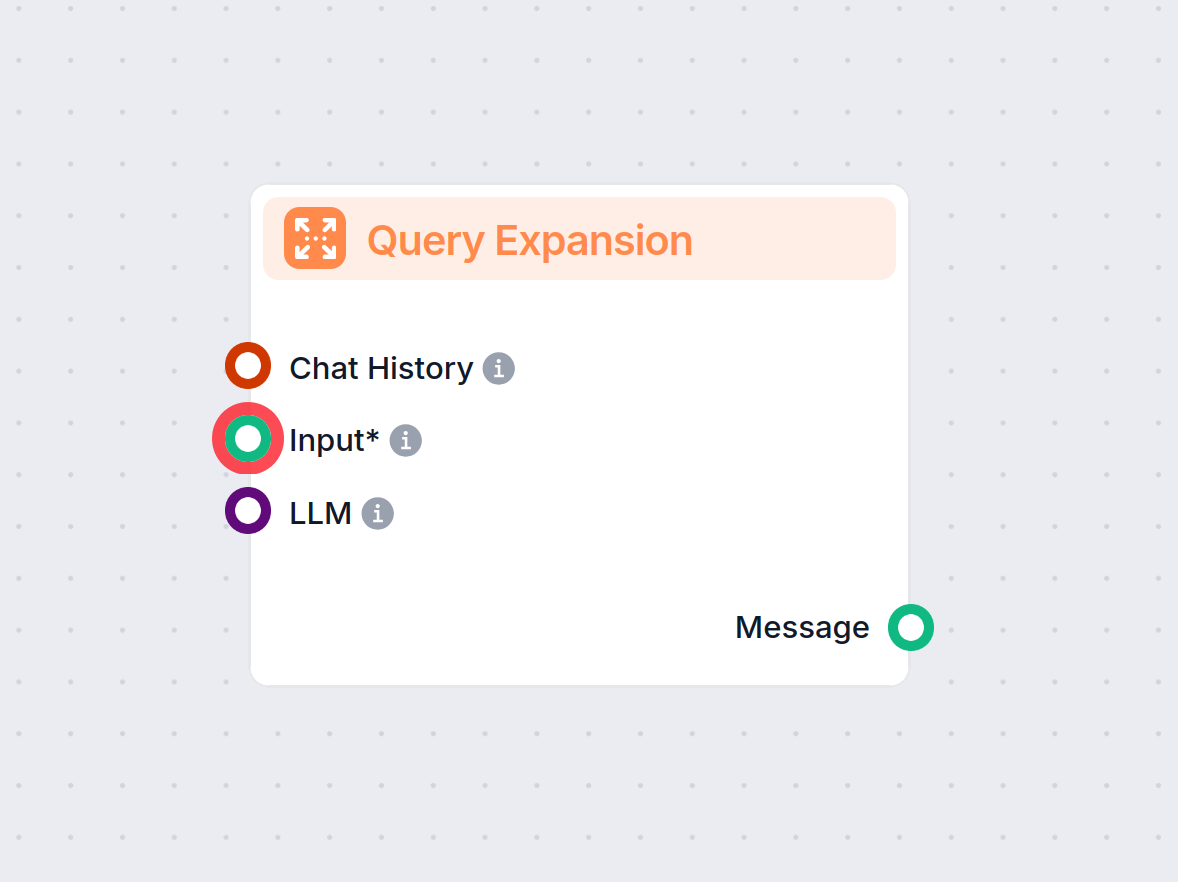

Mở Rộng Truy Vấn trong FlowHunt giúp chatbot hiểu rõ hơn bằng cách tìm từ đồng nghĩa, sửa lỗi chính tả và đảm bảo phản hồi nhất quán, chính xác cho câu hỏi của ...

Trả lời câu hỏi với Retrieval-Augmented Generation (RAG) kết hợp truy xuất thông tin và sinh ngôn ngữ tự nhiên để nâng cao các mô hình ngôn ngữ lớn (LLMs) bằng ...