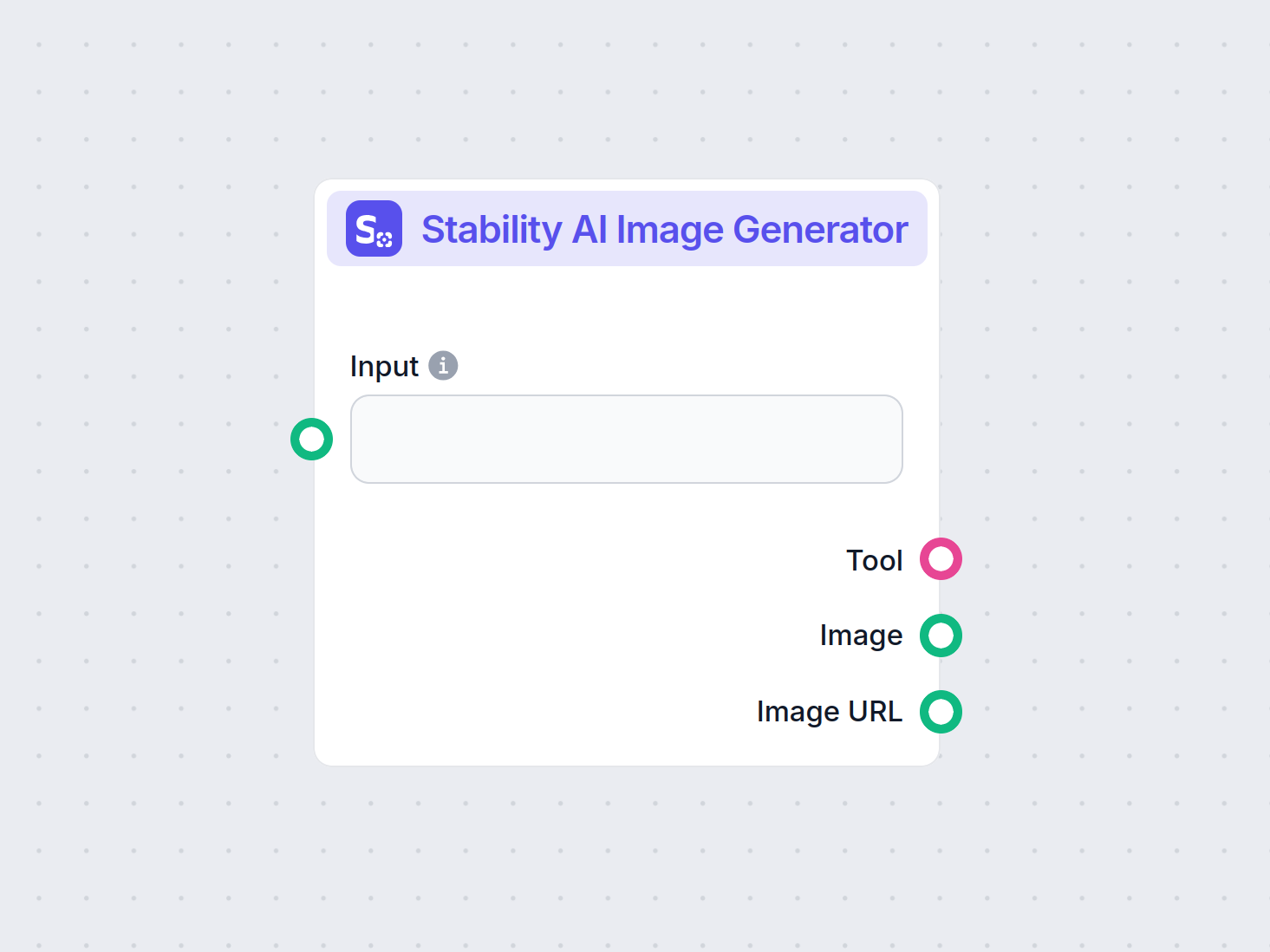

Trình tạo hình ảnh Stability AI

Tạo hình ảnh chất lượng cao từ văn bản đầu vào với thành phần Trình tạo hình ảnh Stability AI. Được hỗ trợ bởi các mô hình Stable Diffusion, công cụ này cung cấ...

Stable Diffusion là mô hình AI chuyển văn bản thành ảnh hàng đầu, cho phép người dùng tạo hình ảnh giống thật từ mô tả nhờ kỹ thuật khuếch tán tiềm ẩn và học sâu tiên tiến.

Stable Diffusion là một mô hình AI chuyển văn bản thành hình ảnh, tạo ra hình ảnh chất lượng cao từ mô tả nhờ học sâu. Nó sử dụng các kỹ thuật như prompt phủ định và ảnh tham chiếu để cải thiện kết quả, đặc biệt với các chi tiết phức tạp như bàn tay.

Stable Diffusion là một mô hình tạo ảnh từ văn bản tiên tiến, ứng dụng học sâu để tạo ra hình ảnh chất lượng cao, giống thật dựa trên mô tả bằng chữ. Được phát triển dưới dạng mô hình khuếch tán tiềm ẩn, nó là một bước tiến quan trọng trong lĩnh vực AI sinh dữ liệu, kết hợp các nguyên lý của mô hình khuếch tán và học máy để tạo ra hình ảnh sát với mô tả.

Stable Diffusion sử dụng học sâu và mô hình khuếch tán để tạo ảnh bằng cách tinh chỉnh nhiễu ngẫu nhiên thành hình hài rõ ràng. Dù được huấn luyện trên hàng triệu ảnh, nó vẫn gặp khó khăn với các chi tiết phức tạp như bàn tay. Theo thời gian, khi mô hình được huấn luyện trên tập dữ liệu lớn hơn, các vấn đề này dần giảm và chất lượng ảnh ngày càng thật hơn.

Một cách hiệu quả để giải quyết vấn đề bàn tay là dùng prompt phủ định. Thêm các cụm như (-bad anatomy) hoặc (-bad hands -unnatural hands) vào prompt sẽ hướng dẫn AI tránh tạo ra các chi tiết méo mó. Tuy nhiên, cần tránh lạm dụng prompt phủ định vì có thể hạn chế sự sáng tạo của mô hình.

Một kỹ thuật khác là dùng ảnh tham chiếu để hướng dẫn AI. Bằng cách chèn thẻ {image} kèm đường dẫn đến ảnh tham chiếu trong prompt, bạn cung cấp cho AI một khuôn mẫu trực quan để vẽ bàn tay chính xác. Điều này đặc biệt hữu ích để giữ đúng tỷ lệ và dáng tay.

Để đạt kết quả tốt nhất, hãy kết hợp cả prompt phủ định và ảnh tham chiếu. Cách tiếp cận kép này giúp AI vừa tránh lỗi thường gặp vừa bám sát ví dụ chất lượng cao.

(-bent fingers) hoặc (realistic perspectives) để tăng chất lượng vẽ tay.Thành thạo các kỹ thuật này sẽ giúp bạn cải thiện rõ rệt khả năng vẽ tay khi dùng Stable Diffusion, tạo ra tác phẩm nghệ thuật sắc sảo như một họa sĩ chuyên nghiệp. Chuẩn bị ảnh tham chiếu, viết prompt chính xác và theo dõi sự tiến bộ của AI art!

Cốt lõi, Stable Diffusion chuyển đổi văn bản thành hình ảnh thông qua chuỗi các quá trình tính toán. Để hiểu cách nó hoạt động, cần tìm hiểu về mô hình khuếch tán, không gian tiềm ẩn và mạng nơ-ron.

Mô hình khuếch tán là một lớp mô hình sinh dữ liệu trong học máy, học cách tạo ra dữ liệu bằng cách đảo ngược quá trình khuếch tán. Quá trình này là thêm nhiễu dần vào dữ liệu—như hình ảnh—cho đến khi chúng không còn nhận ra được. Mô hình sẽ học cách đảo ngược quá trình này, loại bỏ nhiễu từng bước để khôi phục dữ liệu gốc. Quá trình đảo ngược này là chìa khoá để tạo dữ liệu mới, mạch lạc từ nhiễu ngẫu nhiên.

Stable Diffusion sử dụng mô hình khuếch tán tiềm ẩn. Khác với mô hình khuếch tán truyền thống hoạt động trực tiếp trên không gian ảnh gốc, mô hình này làm việc trong không gian tiềm ẩn nén. Không gian tiềm ẩn là biểu diễn dữ liệu ở dạng thấp chiều hơn, chứa các đặc trưng chính và giảm độ phức tạp tính toán. Nhờ đó, Stable Diffusion tạo hình ảnh độ phân giải cao hiệu quả hơn.

Cơ chế chính của Stable Diffusion là quá trình khuếch tán ngược trong không gian tiềm ẩn. Bắt đầu từ một vector nhiễu ngẫu nhiên, mô hình sẽ tinh chỉnh biểu diễn này bằng cách dự đoán và loại bỏ nhiễu ở mỗi bước. Việc tinh chỉnh này được dẫn dắt bởi mô tả văn bản của người dùng. Quá trình tiếp tục cho đến khi vector tiềm ẩn hội tụ về trạng thái mà khi giải mã sẽ ra hình ảnh đúng với prompt.

Kiến trúc Stable Diffusion tích hợp nhiều thành phần chính phối hợp để chuyển prompt văn bản thành hình ảnh.

VAE là hệ mã hoá-giải mã, nén ảnh vào không gian tiềm ẩn và phục hồi lại ảnh. Bộ mã hoá chuyển ảnh thành biểu diễn tiềm ẩn, giữ các đặc trưng cơ bản ở dạng rút gọn. Bộ giải mã sẽ tái tạo lại ảnh chi tiết từ biểu diễn này.

Quy trình này rất quan trọng vì nó giúp mô hình làm việc với dữ liệu thấp chiều hơn, giảm đáng kể tài nguyên so với xử lý ảnh gốc.

U-Net là kiến trúc mạng nơ-ron chuyên biệt trong xử lý ảnh của Stable Diffusion. Nó gồm một nhánh mã hoá và một nhánh giải mã với các kết nối tắt giữa các lớp đối xứng. Trong Stable Diffusion, U-Net đảm nhiệm vai trò dự đoán nhiễu trong quá trình khuếch tán ngược.

Ở mỗi bước, U-Net dự đoán lượng nhiễu còn lại trong biểu diễn tiềm ẩn. Dự đoán này dùng để tinh chỉnh vector tiềm ẩn bằng cách trừ phần nhiễu, dần dần khử nhiễu không gian tiềm ẩn thành hình ảnh đúng với prompt.

Để tích hợp thông tin văn bản, Stable Diffusion dùng bộ mã hoá văn bản dựa trên CLIP (Contrastive Language-Image Pretraining). CLIP giúp hiểu và liên kết thông tin văn bản với hình ảnh bằng cách ánh xạ chúng vào cùng không gian tiềm ẩn.

Khi người dùng nhập prompt, bộ mã hoá văn bản sẽ chuyển nó thành các embedding—biểu diễn số của dữ liệu văn bản. Các embedding này điều kiện hoá U-Net trong quá trình khuếch tán ngược, dẫn dắt quá trình tạo ảnh phù hợp nội dung mô tả.

Stable Diffusion rất linh hoạt trong tạo ảnh và có thể ứng dụng đa dạng tuỳ nhu cầu người dùng.

Ứng dụng chính là tạo ảnh từ prompt văn bản. Người dùng nhập mô tả, mô hình sẽ tạo ra ảnh tương ứng. Ví dụ, nhập “Bãi biển yên bình lúc hoàng hôn với hàng dừa” sẽ ra hình ảnh đúng như vậy.

Khả năng này đặc biệt hữu ích trong sáng tạo, nội dung và thiết kế, nơi cần hình dung ý tưởng nhanh.

Ngoài tạo ảnh mới, Stable Diffusion có thể chỉnh sửa ảnh sẵn có dựa vào hướng dẫn văn bản. Bằng cách cung cấp ảnh đầu vào và prompt, mô hình sẽ tạo ảnh mới với các thay đổi theo mô tả.

Ví dụ, nhập ảnh thành phố ban ngày và prompt “chuyển thành ban đêm với đèn neon”, kết quả sẽ là ảnh phù hợp.

Vẽ lại (inpainting) là điền phần thiếu hoặc lỗi trên ảnh. Stable Diffusion làm rất tốt nhờ hướng dẫn bằng prompt. Người dùng có thể che đi vùng cần sửa và mô tả phần muốn thay thế.

Tính năng này hữu ích khi phục hồi ảnh cũ, xoá vật thể không mong muốn hoặc thay đổi chi tiết mà vẫn giữ sự mạch lạc.

Bằng cách tạo dãy ảnh biến đổi nhẹ, Stable Diffusion có thể mở rộng tạo hoạt hình hoặc video. Các công cụ như Deforum tăng khả năng tạo nội dung động theo prompt qua thời gian.

Điều này mở ra tiềm năng cho hoạt hình, hiệu ứng hình ảnh và nội dung động mà không cần làm hoạt hình truyền thống.

Khả năng tạo hình ảnh từ văn bản giúp Stable Diffusion trở thành công cụ mạnh trong tự động hóa AI và phát triển chatbot.

Tích hợp Stable Diffusion vào chatbot giúp tạo nội dung trực quan đáp ứng câu hỏi người dùng. Ví dụ, trong dịch vụ khách hàng, chatbot có thể cung cấp hình minh hoạ sinh động hỗ trợ người dùng.

Prompt văn bản được chuyển thành embedding nhờ bộ mã hoá CLIP. Các embedding này là điều kiện quan trọng để quá trình tạo ảnh bám sát mô tả người dùng.

Quá trình khuếch tán ngược là tinh chỉnh biểu diễn tiềm ẩn bằng cách loại bỏ nhiễu dự đoán. Ở mỗi bước, mô hình xem xét embedding văn bản và trạng thái vector tiềm ẩn để dự đoán nhiễu chính xác.

Khả năng xử lý ảnh nhiễu của mô hình đến từ việc huấn luyện trên tập dữ liệu lớn, giúp phân biệt và loại bỏ nhiễu hiệu quả. Nhờ vậy, nó tạo ra ảnh rõ nét dù bắt đầu từ nhiễu ngẫu nhiên.

Làm việc ở không gian tiềm ẩn giúp tiết kiệm tài nguyên, vì số chiều thấp hơn không gian điểm ảnh. Điều này cho phép Stable Diffusion tạo ảnh độ phân giải cao mà không tốn quá nhiều máy tính.

Họa sĩ, nhà thiết kế có thể dùng Stable Diffusion để thử nghiệm ý tưởng nhanh từ mô tả, hỗ trợ sáng tạo và rút ngắn thời gian hiện thực hóa.

Nhóm marketing có thể tạo hình ảnh riêng cho chiến dịch, mạng xã hội, quảng cáo mà không cần đội ngũ thiết kế lớn.

Nhà phát triển game tạo tài sản, môi trường, concept art từ prompt, rút ngắn thời gian sản xuất.

Nhà bán lẻ tạo hình ảnh sản phẩm trong nhiều bối cảnh, cải thiện trải nghiệm khách hàng.

Giáo viên, nhà sáng tạo nội dung có thể tạo hình minh hoạ, sơ đồ giúp giải thích khái niệm phức tạp, làm tài liệu hấp dẫn hơn.

Nhà nghiên cứu AI, thị giác máy tính dùng Stable Diffusion để khám phá thêm khả năng của mô hình khuếch tán và không gian tiềm ẩn.

Để khai thác Stable Diffusion hiệu quả, cần lưu ý một số điểm kỹ thuật:

Để sử dụng Stable Diffusion, hãy làm theo các bước:

Với lập trình viên phát triển hệ thống tự động hóa AI và chatbot, Stable Diffusion có thể tích hợp để tăng tính năng.

Khi dùng Stable Diffusion, cần chú ý đến các vấn đề đạo đức:

Stable diffusion là chủ đề đáng chú ý trong lĩnh vực mô hình sinh dữ liệu, đặc biệt với tăng cường dữ liệu và tổng hợp ảnh. Các nghiên cứu mới đây đã khám phá nhiều khía cạnh và ứng dụng của stable diffusion.

Diffusion Least Mean P-Power Algorithms for Distributed Estimation in Alpha-Stable Noise Environments của Fuxi Wen (2013):

Giới thiệu thuật toán khuếch tán Least Mean P-Power (LMP) cho ước lượng phân tán trong môi trường nhiễu alpha-stable. Nghiên cứu so sánh phương pháp LMP khuếch tán với thuật toán Least Mean Squares khuếch tán (LMS) và chứng minh hiệu quả vượt trội trong điều kiện nhiễu alpha-stable. Đây là nghiên cứu quan trọng để phát triển kỹ thuật ước lượng bền vững trong môi trường nhiễu. Đọc thêm

Stable Diffusion for Data Augmentation in COCO and Weed Datasets của Boyang Deng (2024):

Nghiên cứu ứng dụng mô hình stable diffusion để tạo ảnh tổng hợp độ phân giải cao nhằm cải thiện tập dữ liệu nhỏ. Bằng các kỹ thuật như chuyển đổi ảnh-ảnh (Image-to-image), Dreambooth, ControlNet, nghiên cứu đánh giá hiệu quả của stable diffusion trong các nhiệm vụ phân loại và phát hiện. Kết quả cho thấy tiềm năng lớn của stable diffusion ở nhiều lĩnh vực. Đọc thêm

Diffusion and Relaxation Controlled by Tempered α-stable Processes của Aleksander Stanislavsky, Karina Weron và Aleksander Weron (2011):

Xây dựng các tính chất khuếch tán bất thường và thư giãn phi hàm mũ dựa trên quá trình α-stable có điều chỉnh. Nghiên cứu giải quyết vấn đề kỳ vọng vô hạn của thời gian hoạt động ngẫu nhiên α-stable và đề xuất mô hình bao hàm cả trường hợp khuếch tán chậm (subdiffusion). Đọc thêm

Evaluating a Synthetic Image Dataset Generated with Stable Diffusion của Andreas Stöckl (2022):

Đánh giá ảnh tổng hợp tạo ra từ mô hình Stable Diffusion bằng taxonomy Wordnet. Nghiên cứu kiểm tra khả năng mô hình tạo ảnh đúng cho các khái niệm khác nhau, chỉ ra sự khác biệt về độ chính xác biểu diễn. Đây là đánh giá quan trọng để hiểu vai trò của stable diffusion trong tăng cường dữ liệu. Đọc thêm

Comparative Analysis of Generative Models: Enhancing Image Synthesis with VAEs, GANs, and Stable Diffusion của Sanchayan Vivekananthan (2024):

So sánh ba mô hình sinh dữ liệu: VAE, GAN và Stable Diffusion. Nghiên cứu nêu bật điểm mạnh và hạn chế từng mô hình, chỉ ra stable diffusion vượt trội ở một số tác vụ tổng hợp ảnh. Đọc thêm

Cùng xem cách triển khai mô hình Stable Diffusion bằng thư viện Diffusers của Hugging Face.

Cài đặt các thư viện cần thiết:

pip install torch transformers diffusers accelerate

pip install xformers # Tuỳ chọn

Thư viện Diffusers cung cấp cách tải mô hình huấn luyện sẵn tiện lợi:

from diffusers import StableDiffusionPipeline

import torch

# Tải mô hình Stable Diffusion

model_id = "stabilityai/stable-diffusion-2-1"

pipe = StableDiffusionPipeline.from_pretrained(model_id, torch_dtype=torch.float16)

pipe = pipe.to("cuda") # Đưa mô hình lên GPU để tăng tốc

Để tạo ảnh, chỉ cần cung cấp prompt văn bản:

prompt = "A serene landscape with mountains and a lake, photorealistic, 8K resolution"

image = pipe(prompt).images[0]

# Lưu hoặc hiển thị ảnh

image.save("generated_image.png")

model_id.torch.float16 giúp tiết kiệm RAM.Bạn có thể tuỳ chỉnh nhiều tham số:

image = pipe(

prompt=prompt,

num_inference_steps=50, # Số bước khử nhiễu

guidance

Stable Diffusion là một mô hình AI tiên tiến được thiết kế để tạo ra hình ảnh chất lượng cao, giống thật từ mô tả văn bản. Nó sử dụng khuếch tán tiềm ẩn và học sâu để chuyển đổi mô tả thành hình ảnh.

Stable Diffusion chuyển đổi văn bản thành nhúng hình ảnh bằng bộ mã hóa văn bản CLIP, sau đó khử nhiễu dần dần biểu diễn tiềm ẩn dựa trên yêu cầu, tạo ra hình ảnh phù hợp.

Stable Diffusion được sử dụng cho tạo nội dung sáng tạo, tài liệu marketing, làm tài sản game, hình ảnh sản phẩm thương mại điện tử, minh họa giáo dục và chatbot tích hợp AI.

Có, Stable Diffusion hỗ trợ chuyển đổi hình ảnh và vẽ lại phần thiếu, cho phép chỉnh sửa hoặc bổ sung hình ảnh dựa trên mô tả văn bản.

Nên dùng máy tính có GPU hiện đại để tạo ảnh hiệu quả với Stable Diffusion. Mô hình cũng cần Python và các thư viện như PyTorch và Diffusers.

Có, Stable Diffusion được phát hành theo giấy phép mã nguồn mở linh hoạt, khuyến khích cộng đồng đóng góp, tuỳ chỉnh và phổ biến rộng rãi.

Giải phóng sáng tạo của bạn với Stable Diffusion và xem AI có thể biến ý tưởng thành hình ảnh ấn tượng như thế nào.

Tạo hình ảnh chất lượng cao từ văn bản đầu vào với thành phần Trình tạo hình ảnh Stability AI. Được hỗ trợ bởi các mô hình Stable Diffusion, công cụ này cung cấ...

Mô hình Flux AI của Black Forest Labs là hệ thống tạo sinh hình ảnh từ văn bản tiên tiến, chuyển đổi các mô tả ngôn ngữ tự nhiên thành hình ảnh cực kỳ chi tiết,...

Khám phá DiffusionBee, trình tạo nghệ thuật AI mạnh mẽ dành cho Mac giúp biến các mô tả văn bản thành hình ảnh tuyệt đẹp. Tìm hiểu các tính năng như Chuyển Văn ...