LLM OpenAI Tùy Chỉnh

Khai phá sức mạnh của các mô hình ngôn ngữ tùy chỉnh với thành phần LLM OpenAI Tùy Chỉnh trong FlowHunt. Tích hợp liền mạch các mô hình tương thích OpenAI của r...

OpenAI Whisper là hệ thống ASR mã nguồn mở giúp chuyển đổi giọng nói thành văn bản chính xác trên 99 ngôn ngữ, hỗ trợ phiên âm, dịch thuật và nhận diện ngôn ngữ cho tự động hóa AI mạnh mẽ.

OpenAI Whisper có thể được xem là cả mô hình và hệ thống, tùy theo ngữ cảnh.

Chức năng chính của Whisper là chuyển đổi lời nói thành văn bản. Nó nổi bật ở các điểm:

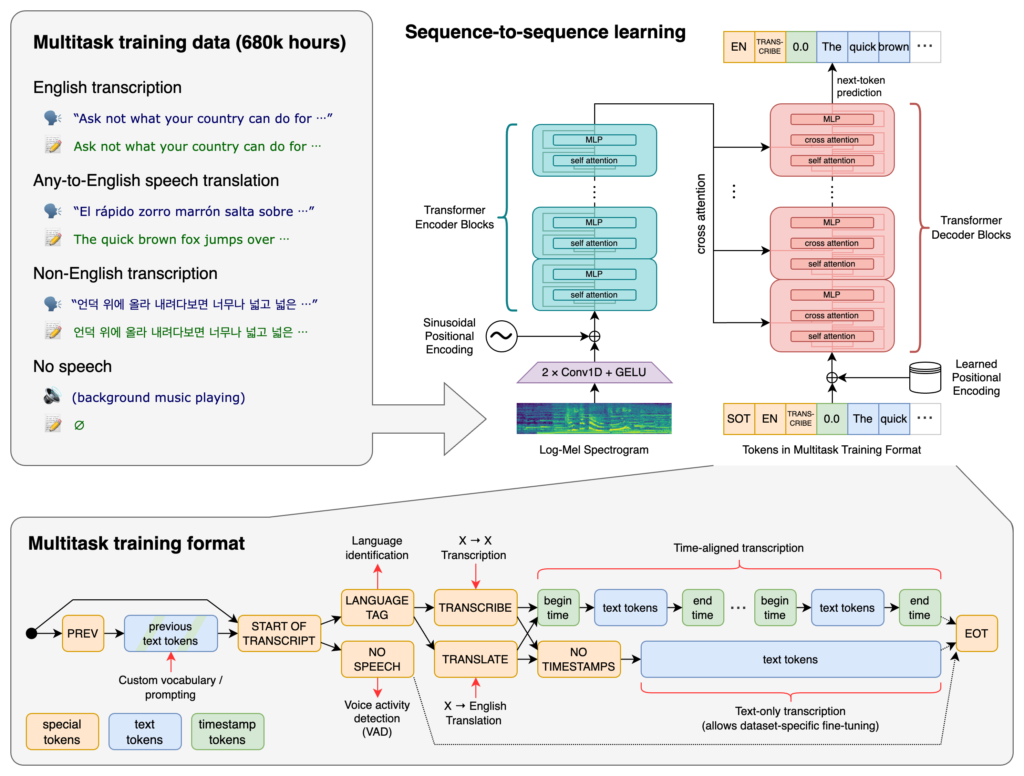

Trái tim của Whisper là kiến trúc Transformer, cụ thể là mô hình mã hóa–giải mã. Transformer là mạng nơ-ron xuất sắc trong xử lý dữ liệu tuần tự và hiểu ngữ cảnh trên các chuỗi dài. Được giới thiệu trong bài báo “Attention is All You Need” năm 2017, Transformer đã trở thành nền tảng cho nhiều nhiệm vụ NLP.

Quy trình của Whisper gồm:

Whisper được huấn luyện trên một tập dữ liệu khổng lồ gồm 680.000 giờ dữ liệu có gán nhãn thu thập từ web. Bao gồm:

Với khả năng nhận diện 99 ngôn ngữ, Whisper nổi bật ở khả năng xử lý đầu vào đa dạng. Điều này giúp nó phù hợp cho các ứng dụng, dịch vụ hướng đến khách hàng toàn cầu.

Được huấn luyện trên lượng lớn dữ liệu có gán nhãn, Whisper đạt độ chính xác cao khi phiên âm. Khả năng chịu đựng giọng, phương ngữ và tạp âm giúp nó đáng tin cậy trong nhiều tình huống thực tế.

Ngoài phiên âm, Whisper còn có thể:

Được phát hành dưới dạng mã nguồn mở, Whisper cho phép lập trình viên:

Tích hợp Whisper vào chatbot, trợ lý AI giúp:

Whisper được triển khai dưới dạng thư viện Python, cho phép tích hợp mượt mà vào các dự án Python. Sử dụng Whisper trong Python cần thiết lập môi trường, cài đặt các phụ thuộc và dùng các hàm của thư viện để phiên âm hoặc dịch âm thanh.

Trước khi sử dụng Whisper, bạn cần chuẩn bị môi trường phát triển bằng cách cài đặt Python, PyTorch, FFmpeg và thư viện Whisper.

Nếu chưa có Python, tải từ trang chủ. Để cài PyTorch, dùng pip:

pip install torch

Hoặc truy cập trang PyTorch để hướng dẫn cài đặt chi tiết theo hệ điều hành và phiên bản Python.

Whisper yêu cầu FFmpeg để xử lý tệp âm thanh. Cài FFmpeg bằng trình quản lý gói phù hợp với hệ điều hành của bạn.

Ubuntu/Debian:

sudo apt update && sudo apt install ffmpeg

MacOS (với Homebrew):

brew install ffmpeg

Windows (với Chocolatey):

choco install ffmpeg

Cài đặt gói Whisper Python bằng pip:

pip install -U openai-whisper

Để cài phiên bản mới nhất từ GitHub:

pip install git+https://github.com/openai/whisper.git

Đảm bảo đã bật Chế độ dành cho nhà phát triển:

Whisper cung cấp nhiều mô hình với kích thước và khả năng khác nhau. Các mô hình từ tiny đến large, mỗi loại cân bằng giữa tốc độ và độ chính xác.

| Kích thước | Tham số | Mô hình chỉ tiếng Anh | Mô hình đa ngôn ngữ | VRAM yêu cầu | Tốc độ tương đối |

|---|---|---|---|---|---|

| tiny | 39 M | tiny.en | tiny | ~1 GB | ~32x |

| base | 74 M | base.en | base | ~1 GB | ~16x |

| small | 244 M | small.en | small | ~2 GB | ~6x |

| medium | 769 M | medium.en | medium | ~5 GB | ~2x |

| large | 1550 M | N/A | large | ~10 GB | 1x |

.en): Tối ưu cho phiên âm tiếng Anh, hiệu năng tốt hơn với âm thanh tiếng Anh.Sau khi thiết lập môi trường và cài đặt các thành phần cần thiết, bạn có thể bắt đầu sử dụng Whisper trong dự án Python.

Bắt đầu với việc import thư viện Whisper và tải mô hình:

import whisper

# Tải mô hình phù hợp

model = whisper.load_model("base")

Thay thế "base" với tên mô hình phù hợp với ứng dụng của bạn.

Whisper cung cấp hàm transcribe đơn giản để chuyển tệp âm thanh thành văn bản.

Ví dụ: Phiên âm tệp tiếng Anh

# Phiên âm tệp âm thanh

result = model.transcribe("path/to/english_audio.mp3")

# In kết quả phiên âm

print(result["text"])

model.transcribe(): Xử lý tệp âm thanh và trả về một dictionary gồm bản phiên âm và các thông tin khác.result["text"]: Lấy văn bản phiên âm từ kết quả.Whisper có thể dịch âm thanh từ nhiều ngôn ngữ sang tiếng Anh.

Ví dụ: Dịch tệp tiếng Tây Ban Nha sang tiếng Anh

# Phiên âm và dịch tệp tiếng Tây Ban Nha sang tiếng Anh

result = model.transcribe("path/to/spanish_audio.mp3", task="translate")

# In kết quả dịch

print(result["text"])

task="translate": Yêu cầu mô hình dịch âm thanh sang tiếng Anh thay vì phiên âm nguyên bản.Dù Whisper có thể tự phát hiện ngôn ngữ, việc chỉ định sẽ tăng độ chính xác và tốc độ.

Ví dụ: Phiên âm tệp tiếng Pháp

# Phiên âm tệp tiếng Pháp bằng cách chỉ định ngôn ngữ

result = model.transcribe("path/to/french_audio.wav", language="fr")

# In kết quả phiên âm

print(result["text"])

Whisper có thể xác định ngôn ngữ trong tệp âm thanh với phương thức detect_language.

Ví dụ: Nhận diện ngôn ngữ

# Tải và tiền xử lý âm thanh

audio = whisper.load_audio("path/to/unknown_language_audio.mp3")

audio = whisper.pad_or_trim(audio)

# Chuyển thành log-Mel spectrogram

mel = whisper.log_mel_spectrogram(audio).to(model.device)

# Nhận diện ngôn ngữ

_, probs = model.detect_language(mel)

language = max(probs, key=probs.get)

print(f"Detected language: {language}")

whisper.load_audio(): Tải tệp âm thanh.whisper.pad_or_trim(): Điều chỉnh độ dài âm thanh phù hợp đầu vào mô hình.whisper.log_mel_spectrogram(): Chuyển thành định dạng mô hình yêu cầu.model.detect_language(): Trả về xác suất cho từng ngôn ngữ, xác định ngôn ngữ khả dĩ nhất.Để kiểm soát sâu hơn quá trình phiên âm, bạn có thể dùng các hàm cấp thấp và tùy chọn giải mã.

decodeHàm decode cho phép chỉ định các tùy chọn như ngôn ngữ, nhiệm vụ, có lấy dấu thời gian hay không.

Ví dụ: Tùy chọn giải mã nâng cao

# Thiết lập tùy chọn giải mã

options = whisper.DecodingOptions(language="de", without_timestamps=True)

# Giải mã âm thanh

result = whisper.decode(model, mel, options)

# In văn bản nhận diện được

print(result.text)

Bạn có thể tích hợp Whisper để phiên âm trực tiếp âm thanh từ micro.

Ví dụ: Phiên âm âm thanh micro trực tiếp

import whisper

import sounddevice as sd

# Tải mô hình

model = whisper.load_model("base")

# Ghi âm từ micro

duration = 5 # giây

fs = 16000 # Tần số mẫu

print("Recording...")

audio = sd.rec(int(duration * fs), samplerate=fs, channels=1, dtype='float32')

sd.wait

OpenAI Whisper là một hệ thống nhận diện giọng nói tự động (ASR) tiên tiến do OpenAI phát triển, được thiết kế để chuyển đổi ngôn ngữ nói thành văn bản bằng học sâu. Hệ thống này hỗ trợ 99 ngôn ngữ và nổi bật ở khả năng phiên âm, dịch thuật và nhận diện ngôn ngữ.

Whisper sử dụng kiến trúc mã hóa–giải mã dựa trên transformer, xử lý âm thanh thành log-Mel spectrogram và xuất ra văn bản thông qua mô hình ngôn ngữ. Mô hình được huấn luyện trên 680.000 giờ dữ liệu đa ngôn ngữ, đa nhiệm để đạt độ chính xác và độ ổn định cao.

Whisper hỗ trợ nhận diện giọng nói đa ngôn ngữ, dịch lời nói, tự động nhận diện ngôn ngữ, chịu được nhiều giọng và tạp âm, đồng thời cung cấp mã nguồn mở để tùy biến và tích hợp.

Yêu cầu phần cứng phụ thuộc vào kích thước mô hình: các mô hình nhỏ như 'tiny' cần khoảng 1GB VRAM, trong khi mô hình lớn nhất cần khoảng 10GB. Whisper chạy nhanh hơn trên GPU nhưng cũng có thể hoạt động trên CPU với thời gian xử lý lâu hơn.

Có, Whisper được triển khai dưới dạng thư viện Python và có thể cài đặt qua pip. Nó cho phép dễ dàng tích hợp vào các dự án Python cho phiên âm lời nói, dịch thuật và ứng dụng giọng nói thời gian thực.

Các trường hợp sử dụng phổ biến bao gồm tự động phiên âm cuộc họp, chatbot có giọng nói, dịch trực tiếp, công cụ hỗ trợ tiếp cận (phụ đề và công nghệ hỗ trợ), tự động hóa tổng đài và hệ thống điều khiển bằng giọng nói.

Có, các lựa chọn thay thế gồm các hệ mã nguồn mở như Mozilla DeepSpeech, Kaldi, Wav2vec và các API thương mại như Google Cloud Speech-to-Text, Microsoft Azure AI Speech và AWS Transcribe.

Có, OpenAI Whisper là mã nguồn mở, cho phép nhà phát triển tùy chỉnh, tinh chỉnh và tích hợp vào sản phẩm, dịch vụ của riêng họ mà không bị ràng buộc về giấy phép.

Tích hợp khả năng chuyển đổi giọng nói thành văn bản tiên tiến vào ứng dụng của bạn, tự động hóa quy trình và nâng cao trải nghiệm người dùng với OpenAI Whisper và FlowHunt.

Khai phá sức mạnh của các mô hình ngôn ngữ tùy chỉnh với thành phần LLM OpenAI Tùy Chỉnh trong FlowHunt. Tích hợp liền mạch các mô hình tương thích OpenAI của r...

Mô hình AI Nền tảng là một mô hình học máy quy mô lớn được huấn luyện trên lượng dữ liệu khổng lồ, có khả năng thích ứng với nhiều nhiệm vụ khác nhau. Các mô hì...

Sinh văn bản với các Mô hình Ngôn ngữ Lớn (LLM) đề cập đến việc sử dụng các mô hình học máy tiên tiến để tạo ra văn bản giống như con người từ các gợi ý. Khám p...