Tích hợp Máy chủ Coda MCP

Máy chủ Coda MCP cung cấp một phương thức tiêu chuẩn để trợ lý AI tương tác với nền tảng Coda, cho phép truy vấn tài liệu, tự động hóa quy trình công việc và tư...

Chạy mã Python, cài đặt phụ thuộc và quản lý các môi trường biệt lập trực tiếp trong flow của bạn với MCP Code Executor MCP Server.

FlowHunt cung cấp một lớp bảo mật bổ sung giữa các hệ thống nội bộ của bạn và các công cụ AI, mang lại cho bạn quyền kiểm soát chi tiết về những công cụ nào có thể truy cập từ các máy chủ MCP của bạn. Các máy chủ MCP được lưu trữ trong cơ sở hạ tầng của chúng tôi có thể được tích hợp liền mạch với chatbot của FlowHunt cũng như các nền tảng AI phổ biến như ChatGPT, Claude và các trình chỉnh sửa AI khác nhau.

MCP Code Executor là một máy chủ MCP (Model Context Protocol) cho phép các mô hình ngôn ngữ (LLM) thực thi mã Python trong một môi trường Python được chỉ định, như Conda, virtualenv hoặc UV virtualenv. Bằng cách kết nối trợ lý AI với các môi trường Python thực có thể thực thi, nó giúp thực hiện nhiều tác vụ phát triển cần chạy mã, quản lý thư viện và thiết lập môi trường động. Máy chủ này hỗ trợ sinh mã tăng dần để vượt qua giới hạn token, cho phép cài đặt phụ thuộc tức thì và cấu hình môi trường thực thi khi runtime. Các nhà phát triển có thể tận dụng công cụ này để tự động đánh giá mã, thử nghiệm các package mới và quản lý tính toán trong một môi trường kiểm soát, an toàn.

Không có template prompt cụ thể nào được liệt kê trong repository hoặc tài liệu.

Không có resource cụ thể nào được mô tả trong repository hoặc tài liệu.

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

},

"inputs": {

"apiKey": "${MY_SECRET_API_KEY}"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

{

"mcpServers": {

"mcp-code-executor": {

"command": "node",

"args": [

"/path/to/mcp_code_executor/build/index.js"

],

"env": {

"CODE_STORAGE_DIR": "/path/to/code/storage",

"ENV_TYPE": "conda",

"CONDA_ENV_NAME": "your-conda-env"

}

}

}

}

Lưu ý: Bạn cũng có thể sử dụng Docker. Dockerfile được cung cấp đã thử nghiệm cho kiểu môi trường

venv-uv:

{

"mcpServers": {

"mcp-code-executor": {

"command": "docker",

"args": [

"run",

"-i",

"--rm",

"mcp-code-executor"

]

}

}

}

Sử dụng MCP trong FlowHunt

Để tích hợp MCP server vào workflow FlowHunt, hãy bắt đầu bằng cách thêm thành phần MCP vào flow và kết nối nó với AI agent của bạn:

Nhấp vào thành phần MCP để mở bảng cấu hình. Trong phần cấu hình hệ thống MCP, chèn thông tin máy chủ MCP của bạn theo định dạng JSON này:

{

"mcp-code-executor": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Khi đã cấu hình, AI agent có thể sử dụng MCP này như một công cụ với đầy đủ các chức năng và khả năng. Hãy nhớ thay “mcp-code-executor” thành tên thực tế của máy chủ MCP của bạn và thay URL bằng địa chỉ máy chủ MCP của bạn.

| Mục | Khả dụng | Chi tiết/Ghi chú |

|---|---|---|

| Tổng quan | ✅ | |

| Danh sách Prompts | ⛔ | Không tìm thấy template prompt |

| Danh sách Resources | ⛔ | Không mô tả resource cụ thể |

| Danh sách Công cụ | ✅ | execute_code, install_dependencies, check_installed_packages |

| Bảo mật API Key | ✅ | Có ví dụ với input env |

| Sampling Support (ít quan trọng khi đánh giá) | ⛔ | Không đề cập |

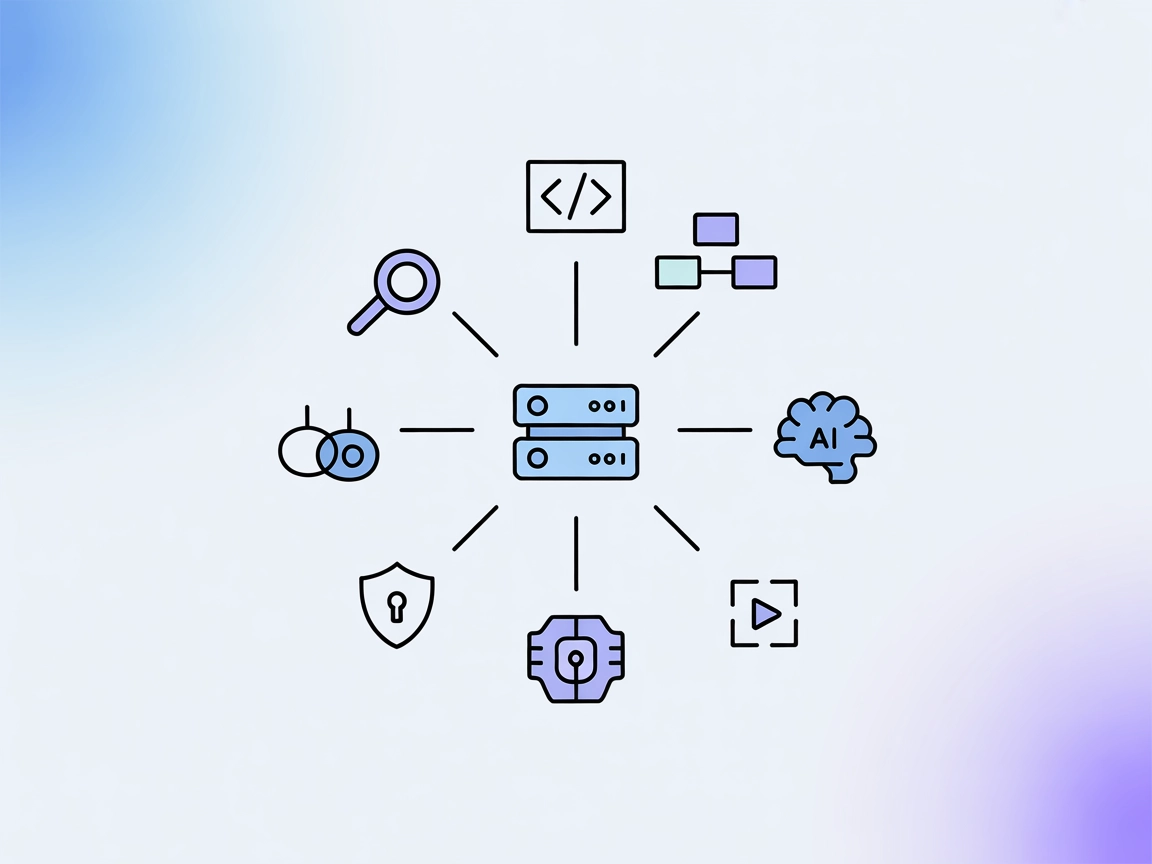

Máy chủ MCP này cung cấp các chức năng cần thiết và mạnh mẽ cho thực thi mã với tích hợp LLM, kèm hướng dẫn thiết lập và công cụ rõ ràng. Tuy nhiên, nó thiếu template prompt, resource cụ thể, và thông tin về roots hoặc sampling. Đối với MCP tập trung vào thực thi mã, đây là lựa chọn rất chắc chắn, đạt điểm cao về tiện ích thực tiễn và dễ tích hợp, nhưng mất điểm ở các tính năng MCP nâng cao và độ đầy đủ tài liệu.

| Có LICENSE | ✅ (MIT) |

|---|---|

| Có ít nhất một công cụ | ✅ |

| Số lượng Fork | 25 |

| Số lượng Star | 144 |

Đây là một máy chủ Model Context Protocol (MCP) cho phép mô hình ngôn ngữ thực thi mã Python trong các môi trường biệt lập và an toàn (như Conda hoặc venv), quản lý phụ thuộc và cấu hình môi trường runtime. Lý tưởng cho đánh giá mã, khoa học dữ liệu, tự động hóa quy trình và thiết lập môi trường động cùng FlowHunt.

Nó cung cấp các công cụ để thực thi mã Python (`execute_code`), cài đặt phụ thuộc động (`install_dependencies`) và kiểm tra các gói đã cài đặt (`check_installed_packages`).

Thêm MCP Code Executor như một thành phần MCP vào flow của bạn, sau đó cấu hình với URL và phương thức truyền của máy chủ. Điều này cho phép AI agent sử dụng khả năng thực thi mã và quản lý môi trường bên trong FlowHunt.

Có, máy chủ hỗ trợ chạy mã trong các môi trường Conda hoặc virtualenv biệt lập, đảm bảo khả năng tái lập và ngăn xung đột giữa các phụ thuộc.

Có, máy chủ có thể thực thi mã theo từng phần, hữu ích khi xử lý mã vượt quá giới hạn token của LLM.

Có, bạn có thể sử dụng Dockerfile được cung cấp và cấu hình máy chủ MCP chạy trong container Docker để tăng thêm biệt lập.

Tăng sức mạnh cho flow của bạn với thực thi mã Python an toàn, tự động. Tích hợp MCP Code Executor MCP Server và mở khóa các quy trình động cho khoa học dữ liệu, tự động hóa và nhiều hơn thế nữa.

Máy chủ Coda MCP cung cấp một phương thức tiêu chuẩn để trợ lý AI tương tác với nền tảng Coda, cho phép truy vấn tài liệu, tự động hóa quy trình công việc và tư...

Máy chủ CodeLogic MCP kết nối FlowHunt và các trợ lý lập trình AI với dữ liệu phụ thuộc phần mềm chi tiết của CodeLogic, cho phép phân tích mã nguồn nâng cao, t...

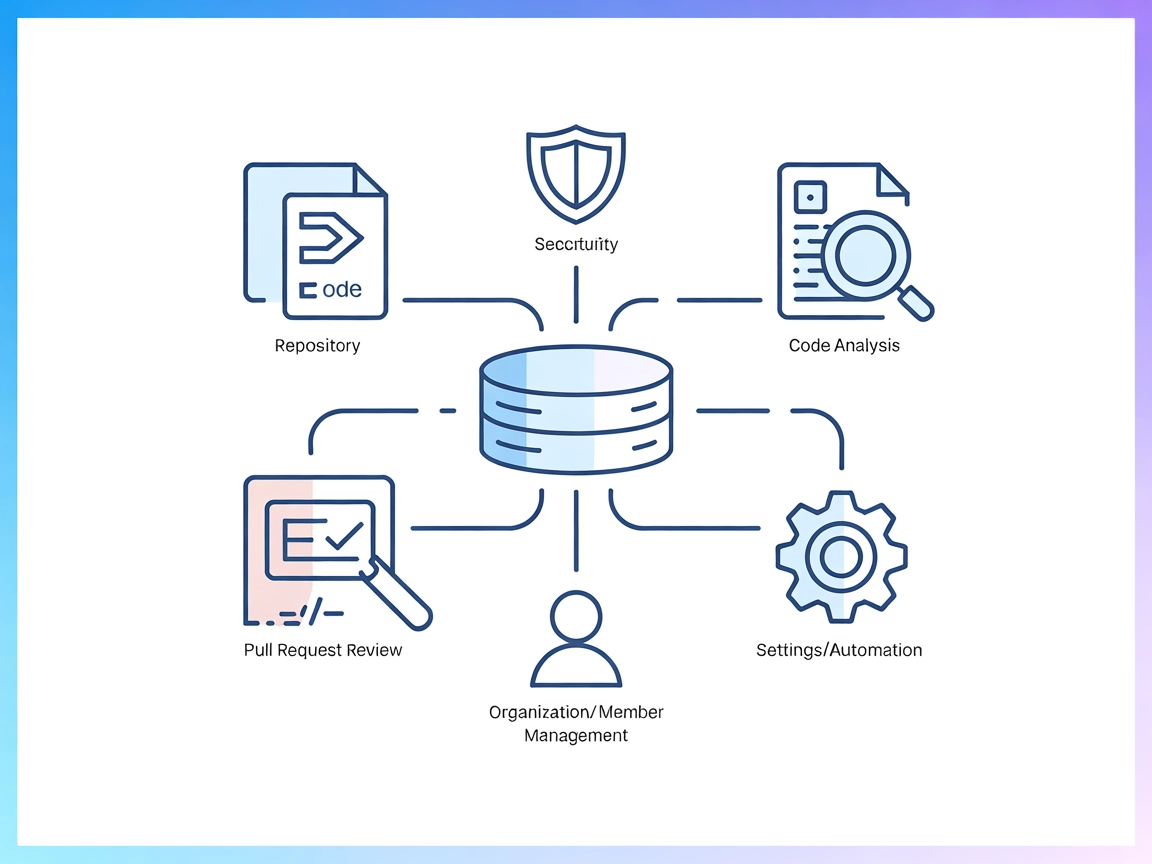

Máy chủ Codacy MCP kết nối các trợ lý AI với nền tảng Codacy, cho phép tự động kiểm tra chất lượng mã nguồn, phân tích bảo mật, quản lý kho lưu trữ và tối ưu hó...

Đồng Ý Cookie

Chúng tôi sử dụng cookie để cải thiện trải nghiệm duyệt web của bạn và phân tích lưu lượng truy cập của mình. See our privacy policy.